Heim >Technologie-Peripheriegeräte >KI >Seien Sie kein Analphabet als Maler! Google hat den „Text Encoder' auf magische Weise modifiziert: Eine kleine Operation ermöglicht es dem Bilderzeugungsmodell, „Rechtschreibung' zu lernen.

Seien Sie kein Analphabet als Maler! Google hat den „Text Encoder' auf magische Weise modifiziert: Eine kleine Operation ermöglicht es dem Bilderzeugungsmodell, „Rechtschreibung' zu lernen.

- 王林nach vorne

- 2023-04-14 15:16:03947Durchsuche

Im vergangenen Jahr wurden mit der Veröffentlichung von DALL-E 2, Stable Diffusion und anderen Bilderzeugungsmodellen die vom Text-zu-Bild-Modell generierten Bilder hinsichtlich Auflösung, Qualität, Texttreue usw. erheblich verbessert , was die Entwicklung nachgelagerter Anwendungsszenarien erheblich vorangetrieben hat und jeder zu einem KI-Maler geworden ist.

Einschlägige Untersuchungen zeigen jedoch, dass die aktuelle generative Modelltechnologie immer noch einen großen Fehler aufweist: Es gibt keine Möglichkeit, zuverlässigen visuellen Text in Bildern darzustellen.

Forschungsergebnisse zeigen, dass DALL-E 2 bei der Erzeugung kohärenter Textzeichen in Bildern sehr instabil ist, und das neu veröffentlichte Stable Diffusion-Modell listet direkt „Lesbarer Text kann nicht wiedergegeben werden“ als bekannte Grenze auf.

Rechtschreibfehler: (1) Kalifornien: All Dreams Welcome, (2) Kanada: For Glowing Hearts, (3) Colorado: It's Our Nature, (4) St. Louis: All Within Reach

Kürzlich hat Google Research ein neues Papier veröffentlicht, in dem versucht wird, die Fähigkeit von Bilderzeugungsmodellen zur Darstellung hochwertiger visueller Texte zu verstehen und zu verbessern.

Link zum Papier: https://arxiv.org/abs/2212.10562

Forscher glauben, dass der Hauptgrund für Textwiedergabefehler in aktuellen generativen Text-zu-Bild-Modellen das Fehlen von ist Eingabefunktionen auf Zeichenebene.

Um die Auswirkung dieser Eingabefunktion auf die Modellgenerierung zu quantifizieren, wurde in dem Artikel eine Reihe kontrollierter Experimente entworfen, um Textkodierer (zeichenbewusst und zeichenblind) mit oder ohne Texteingabefunktionen zu vergleichen.

Forscher fanden heraus, dass das zeichenbewusste Modell im Bereich des Klartextes bei einer neuen Rechtschreibaufgabe (WikiSpell) große Leistungssteigerungen erzielte.

Nachdem die Forscher diese Erfahrung auf den visuellen Bereich übertragen hatten, trainierten sie eine Reihe von Bilderzeugungsmodellen. Experimentelle Ergebnisse zeigen, dass das zeichenbewusste Modell bei einer Reihe neuer Textrendering-Aufgaben besser ist als das zeichenblinde Modell (DrawText-Benchmark).

Und das zeichenbewusste Modell erreicht einen höheren Stand der Technik in der visuellen Rechtschreibung. Seine Genauigkeit bei ungewöhnlichen Wörtern ist immer noch mehr als 30 % höher als bei Konkurrenzmodellen, obwohl das Training mit einer viel geringeren Anzahl von Beispielprozentpunkten durchgeführt wurde.

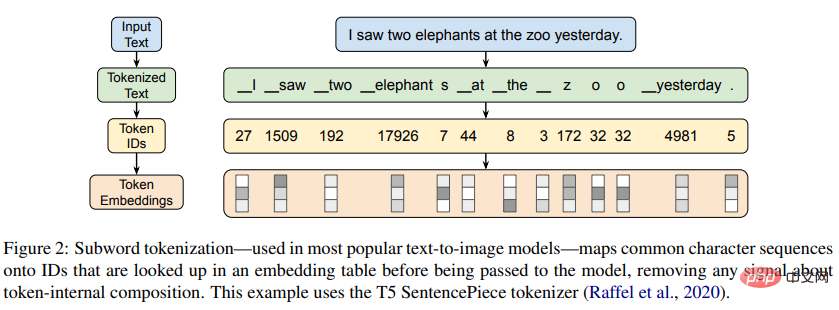

Zeichenbewusstes ModellSprachmodelle können in zeichenbewusste Modelle unterteilt werden, die direkten Zugriff auf die Zeichen haben, aus denen ihre Texteingabe besteht, und zeichenblinde Modelle, die keinen Zugriff haben.

Viele frühe neuronale Sprachmodelle arbeiteten direkt mit Zeichen, ohne Mehrzeichen-Token als Markierungen zu verwenden.

Spätere Modelle wechselten nach und nach zur wortschatzbasierten Tokenisierung, wobei einige Modelle wie ELMo immer noch charakterbewusst blieben, andere Modelle wie BERT jedoch Charakterfunktionen zugunsten eines effektiveren Vortrainings aufgaben.

Derzeit sind die am weitesten verbreiteten Sprachmodelle zeichenblind und basieren auf datengesteuerten Unterwortsegmentierungsalgorithmen wie Byte Pair Encoding (BPE), um Unterwortteile als Vokabular zu generieren.

Während diese Methoden für ungewöhnliche Sequenzen auf die Darstellung auf Zeichenebene zurückgreifen können, sind sie dennoch darauf ausgelegt, häufige Zeichenfolgen in unteilbare Einheiten zu komprimieren.

Der Hauptzweck dieses Artikels besteht darin, die Fähigkeit von Bilderzeugungsmodellen zu verstehen und zu verbessern, hochwertigen visuellen Text wiederzugeben.

Zu diesem Zweck untersuchten die Forscher zunächst isoliert die Rechtschreibfähigkeiten aktueller Textkodierer. Aus den experimentellen Ergebnissen geht hervor, dass zeichenblinde Textkodierer zwar beliebt sind, aber keine Informationen auf Zeichenebene erhalten Ihre Eingabe stellt ein direktes Signal dar, was zu eingeschränkten Rechtschreibfähigkeiten führt.

Die Forscher testeten auch die Rechtschreibfähigkeiten von Textkodierern unterschiedlicher Größe, Architektur, Eingabedarstellung, Sprache und Optimierungsmethode.

In diesem Artikel wird zum ersten Mal die wundersame Fähigkeit des charakterblinden Modells dokumentiert, durch Netzwerk-Vortraining starke Rechtschreibkenntnisse (Genauigkeit >99 %) hervorzurufen, aber experimentelle Ergebnisse zeigen, dass diese Fähigkeit in Sprachen nicht verfügbar ist Anders als Englisch lässt es sich nicht gut verallgemeinern und ist nur bei Maßstäben über 100B-Parametern erreichbar, sodass es für die meisten Anwendungsszenarien nicht durchführbar ist.

Andererseits ermöglichen zeichenbasierte Textkodierer leistungsstarke Rechtschreibfunktionen in kleineren Maßstäben.

Bei der Anwendung dieser Erkenntnisse auf Bildgenerierungsszenarien trainierten die Forscher eine Reihe zeichenbewusster Text-zu-Bild-Modelle und zeigten, dass sie Zeichen bei der Bewertung bestehender und neuer Blind-Modelle deutlich übertrafen.

Bei reinen Modellen auf Zeichenebene verringert sich jedoch die Bild-Text-Ausrichtung, obwohl sich die Leistung der Textwiedergabe verbessert hat.

Um dieses Problem zu lindern, schlagen Forscher vor, Eingabedarstellungen auf Zeichenebene und Token-Ebene zu kombinieren, um die beste Leistung zu erzielen.

WikiSpell-Benchmark

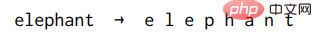

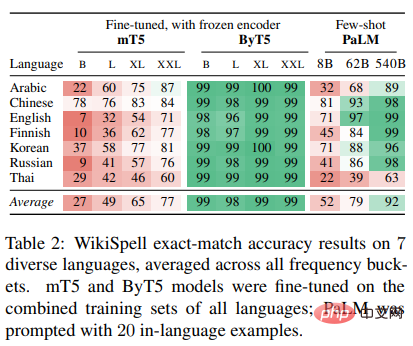

Da generative Text-zu-Bild-Modelle auf Text-Encodern angewiesen sind, um Darstellungen für die Dekodierung zu erzeugen, haben die Forscher zunächst den WikiSpell-Benchmark erstellt, indem sie einige Wörter aus Wiktionary abgetastet haben, und dann auf der Grundlage dieses Datensatzes in einem reinen A Aufgabe zur Beurteilung der Rechtschreibung von Texten, um die Fähigkeiten von Textkodierern zu erkunden.

Für jedes Beispiel in WikiSpell ist die Eingabe in das Modell ein Wort und die erwartete Ausgabe ist seine spezifische Schreibweise (erzeugt durch Einfügen von Leerzeichen zwischen den einzelnen Unicode-Zeichen).

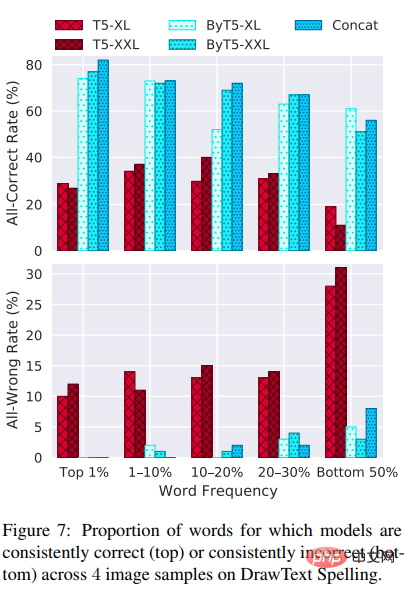

Da es in dem Artikel nur darum geht, den Zusammenhang zwischen der Häufigkeit eines Wortes und der Rechtschreibfähigkeit des Modells zu untersuchen, haben die Forscher die Wörter im Wiktionary entsprechend der Häufigkeit des Vorkommens des Wortes in fünf unterteilt Der mC4-Korpus Nicht überlappende Buckets: obere 1 % der häufigsten Wörter, obere 1–10 % der häufigsten Wörter, 10–20 % der Wörter, 20–30 % der Wörter und untere 50 % der Wörter (im enthalten). Korpuswörter, die niemals in vorkommen).

Probieren Sie dann gleichmäßig 1000 Wörter aus jedem Eimer aus, um einen Testsatz (und einen ähnlichen Entwicklungssatz) zu erstellen.

Schließlich wurde ein Trainingssatz von 10.000 Wörtern erstellt, indem zwei Teile kombiniert wurden: 5.000 wurden einheitlich aus dem unteren 50-Prozent-Bereich (die am wenigsten verbreiteten Wörter) abgetastet, und die anderen 5.000 wurden basierend auf ihrer Anwesenheit in mC4-Frequenzen proportional abgetastet (dadurch Ausrichtung dieser Hälfte des Trainingssatzes auf häufige Wörter).

Die Forscher schließen alle im Entwicklungssatz oder Testsatz ausgewählten Wörter aus dem Trainingssatz aus, sodass sich die Bewertungsergebnisse immer auf die ausgeschlossenen Wörter beziehen.

Neben Englisch bewerteten die Forscher auch sechs weitere Sprachen (Arabisch, Chinesisch, Finnisch, Koreanisch, Russisch, Thailändisch), die ausgewählt wurden, um verschiedene Funktionen abzudecken, die sich auf die Fähigkeit des Modells zum Erlernen der Rechtschreibung auswirken Der oben beschriebene Vorgang wurde für jede Sprachbewertung wiederholt.

Experiment zur Textgenerierung

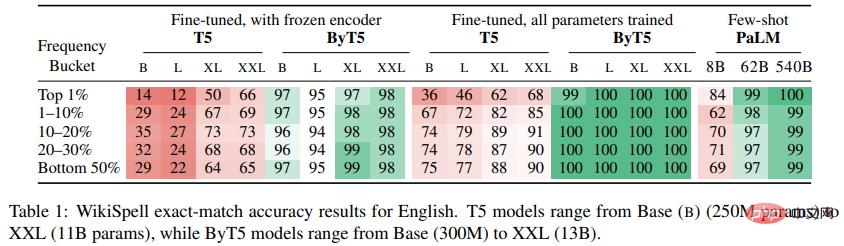

Forscher verwendeten den WikiSpell-Benchmark, um die Leistung mehrerer vorab trainierter Nur-Text-Modelle in verschiedenen Maßstäben zu bewerten, darunter T5 (ein auf englischen Daten vorab trainiertes zeichenblindes Codec-Modell); ähnlich wie T5, aber vorab auf über 100 Sprachen trainiert; und PaLM (ein größeres Dekodierungsmodell, hauptsächlich auf Englisch vorab trainiert);

In den experimentellen Ergebnissen von reinem Englisch und mehrsprachig kann festgestellt werden, dass die Leistung der zeichenblinden Modelle T5 und mT5 in den Buckets, die die Top-1 % der häufigsten Wörter enthalten, viel schlechter ist.

Dieses Ergebnis mag kontraintuitiv erscheinen, da Modelle normalerweise bei Beispielen, die in den Daten häufig vorkommen, am besten abschneiden, aber aufgrund der Art und Weise, wie Unterwortvokabulare trainiert werden, werden häufig vorkommende Wörter normalerweise als ein einzelnes atomares Token (oder ein kleines A) dargestellt Anzahl der Token), und das stimmt tatsächlich: 87 % der Wörter im oberen 1 %-Bereich des Englischen werden durch das Vokabular von T5 als Unterwort-Token repräsentiert.

Ein niedriger Rechtschreibgenauigkeitswert weist also darauf hin, dass der Encoder von T5 nicht genügend Rechtschreibinformationen zu den Unterwörtern in seinem Wortschatz speichert.

Zweitens ist bei charakterblinden Modellen der Maßstab ein wichtiger Faktor, der sich auf die Rechtschreibfähigkeit auswirkt. Sowohl T5 als auch mT5 werden mit zunehmendem Maßstab allmählich besser, aber selbst im XXL-Maßstab zeigen diese Modelle keine besonders starken Rechtschreibfähigkeiten.

Erst wenn zeichenblinde Modelle die Skala von PaLM erreichen, sehen wir nahezu perfekte Rechtschreibfähigkeiten: Das PaLM-Modell mit 540B-Parametern erreicht eine Genauigkeit von >99 % in allen Häufigkeitsklassen des Englischen, obwohl ich nur 20 Beispiele sehe in der Eingabeaufforderung (während der T5 1000 fein abgestimmte Beispiele anzeigt).

Allerdings schneidet PaLM bei anderen Sprachen schlechter ab, wahrscheinlich aufgrund der viel geringeren Vortrainingsdaten für diese Sprachen.

Experimente mit ByT5 zeigen, dass das zeichenbewusste Modell leistungsfähigere Rechtschreibfähigkeiten aufweist. Die Leistung von ByT5 in den Größen „Basis“ und „Groß“ blieb nur geringfügig hinter XL und XXL zurück (wenn auch immer noch im Bereich von mindestens 90 %), und die Häufigkeit eines Wortes schien keinen großen Einfluss auf die Rechtschreibfähigkeiten von ByT5 zu haben. Die Rechtschreibleistung von

ByT5 übertrifft die Ergebnisse von (m)T5 bei weitem, ist sogar mit der englischen Leistung von PaLM mit 100-mal mehr Parametern vergleichbar und übertrifft die Leistung von PaLM in anderen Sprachen.

Es ist ersichtlich, dass der ByT5-Encoder beträchtliche Informationen auf Zeichenebene speichert und diese Informationen entsprechend den Anforderungen der Decodierungsaufgabe aus diesen eingefrorenen Parametern abgerufen werden können.

DrawText Benchmark

Vom COCO-Datensatz im Jahr 2014 bis zum DrawBench-Benchmark im Jahr 2022, von FID, CLIP-Scores bis hin zu menschlichen Vorlieben und anderen Indikatoren war die Bewertung von Text-zu-Bild-Modellen ein wichtiges Forschungsthema.

Aber es mangelt an entsprechenden Arbeiten zur Textwiedergabe und Rechtschreibbewertung.

Zu diesem Zweck schlagen Forscher einen neuen Benchmark vor, DrawText, der darauf abzielt, die Textwiedergabequalität von Text-zu-Bild-Modellen umfassend zu messen. Der

DrawText-Benchmark besteht aus zwei Teilen, die unterschiedliche Dimensionen der Modellfähigkeiten messen:

1) DrawText Spell, bewertet durch gewöhnliche Wortwiedergabe an einer großen Sammlung englischer Wörter;

Die Forscher begannen Indem jeweils 100 Wörter aus den englischen WikiSpell-Häufigkeitsbereichen genommen und in eine Standardvorlage eingefügt wurden, wurden insgesamt 500 Eingabeaufforderungen erstellt.

Für jede Eingabeaufforderung werden 4 Bilder aus den Kandidatenmodellen extrahiert und anhand menschlicher Bewertungen und auf der optischen Zeichenerkennung (OCR) basierender Metriken bewertet.

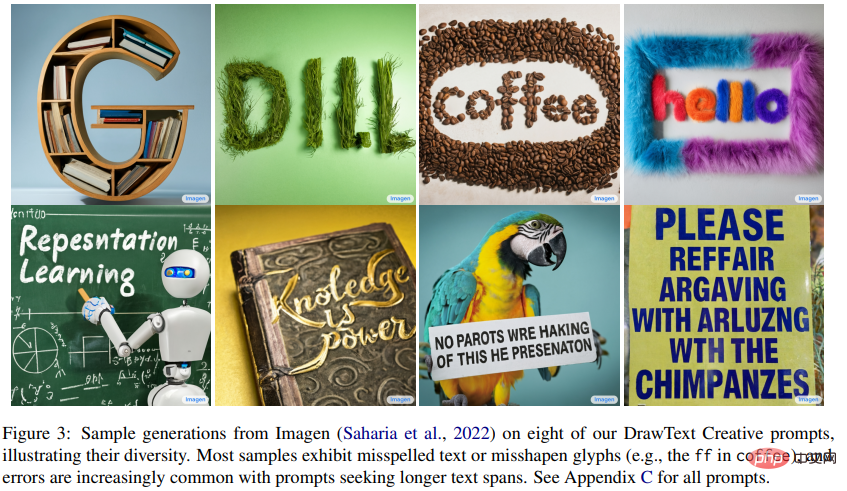

2) DrawText Creative, bewertet durch Textwiedergabe visueller Effekte.

Visueller Text ist nicht auf alltägliche Szenen wie Straßenschilder beschränkt, Text kann in vielen Formen erscheinen, wie z. B. als Gekritzel, als Malerei, als Schnitzerei, als Skulptur usw.

Wenn Bildgenerierungsmodelle eine flexible und genaue Textwiedergabe unterstützen, können Designer diese Modelle verwenden, um kreative Schriftarten, Logos, Layouts und mehr zu entwickeln.

Um die Fähigkeit des Bildgenerierungsmodells zur Unterstützung dieser Anwendungsfälle zu testen, arbeiteten die Forscher mit einem professionellen Grafikdesigner zusammen, um 175 verschiedene Eingabeaufforderungen zu erstellen, bei denen Text in verschiedenen kreativen Stilen und Einstellungen gerendert werden muss.

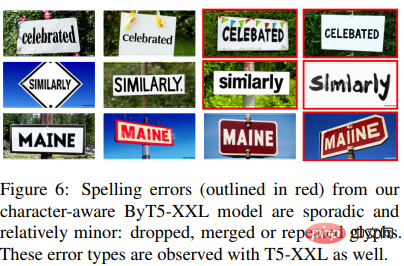

Viele Hinweise übersteigen die Fähigkeiten aktueller Modelle, wobei hochmoderne Modelle falsch geschriebene, weggelassene oder wiederholte Wörter aufweisen.

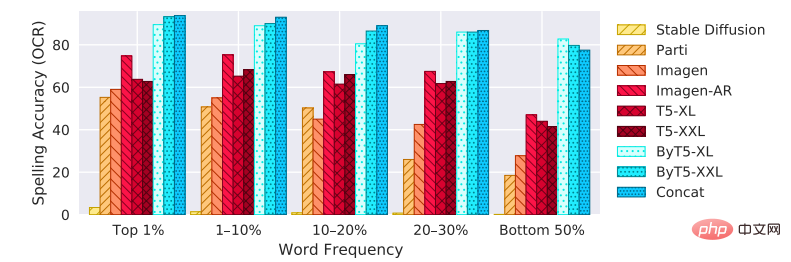

Experiment zur Bildgenerierung

Die experimentellen Ergebnisse zeigen, dass unter den 9 Bildgenerierungsmodellen, die zum Vergleich in Bezug auf die Genauigkeit des DrawText Spell-Benchmarks verwendet wurden, die zeichenbewussten Modelle (ByT5 und Concat) unabhängig davon besser sind als die anderen Modellgröße. Modell, insbesondere bei ungewöhnlichen Wörtern.

Imagen-AR zeigt den Vorteil der Vermeidung von Zuschnitten und trotz der 6,6-mal längeren Trainingszeit ist die Leistung immer noch schlechter als das charakterbewusste Modell.

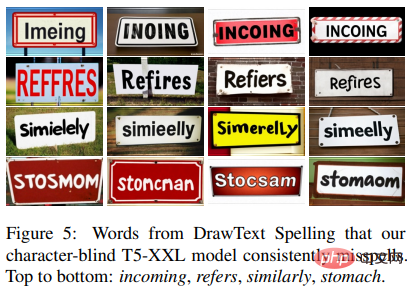

Ein weiterer deutlicher Unterschied zwischen den Modellen besteht darin, ob sie ein bestimmtes Wort über mehrere Stichproben hinweg immer wieder falsch schreiben.

Aus den experimentellen Ergebnissen geht hervor, dass das T5-Modell unabhängig von der Anzahl der gezogenen Stichproben viele falsch geschriebene Wörter aufweist, was nach Ansicht der Forscher auf einen Mangel an Zeichenkenntnissen im Textencoder hinweist.

Im Gegensatz dazu weist das ByT5-Modell grundsätzlich nur sporadische Fehler auf.

Diese Beobachtung kann quantifiziert werden, indem die Rate gemessen wird, mit der das Modell über alle vier Bildbeispiele hinweg durchweg richtig (4/4) oder durchweg falsch (0/4) ist.

Vor allem bei gebräuchlichen Wörtern (oberstes 1 %) ist ein starker Kontrast zu erkennen, d. h. das ByT5-Modell macht nie durchgängig Fehler, während das T5-Modell bei 10 % oder mehr der Wörter immer wieder Fehler macht .

Das obige ist der detaillierte Inhalt vonSeien Sie kein Analphabet als Maler! Google hat den „Text Encoder' auf magische Weise modifiziert: Eine kleine Operation ermöglicht es dem Bilderzeugungsmodell, „Rechtschreibung' zu lernen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr