Heim >Technologie-Peripheriegeräte >KI >ChatGPT und andere Missbräuche, die vorgeben, ein menschlicher Autor zu sein, geben Anlass zur Sorge, ein Artikel fasst KI-generierte Texterkennungsmethoden zusammen

ChatGPT und andere Missbräuche, die vorgeben, ein menschlicher Autor zu sein, geben Anlass zur Sorge, ein Artikel fasst KI-generierte Texterkennungsmethoden zusammen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-14 14:10:031265Durchsuche

Die jüngsten Fortschritte in der NLG-Technologie (Natural Language Generation) haben die Vielfalt, Kontrolle und Qualität von Texten, die von großen Sprachmodellen generiert werden, erheblich verbessert. Ein bemerkenswertes Beispiel ist ChatGPT von OpenAI, das eine überlegene Leistung bei Aufgaben wie der Beantwortung von Fragen, dem Schreiben von E-Mails, Aufsätzen und Code gezeigt hat. Diese neu entdeckte Fähigkeit zur effizienten Textgenerierung wirft jedoch auch Bedenken hinsichtlich der Erkennung und Verhinderung des Missbrauchs großer Sprachmodelle für Aufgaben wie Phishing, Desinformation und akademische Unehrlichkeit auf. Aufgrund der Besorgnis darüber, dass Schüler ChatGPT zum Schreiben von Hausaufgaben verwenden könnten, verboten öffentliche Schulen in New York beispielsweise die Verwendung von ChatGPT, und die Medien gaben auch Warnungen vor gefälschten Nachrichten heraus, die von großen Sprachmodellen generiert wurden. Diese Bedenken hinsichtlich des Missbrauchs großer Sprachmodelle haben die Anwendung der Erzeugung natürlicher Sprache in wichtigen Bereichen wie Medien und Bildung ernsthaft behindert.

In letzter Zeit wird zunehmend darüber diskutiert, ob und wie von großen Sprachmodellen generierter Text korrekt erkannt werden kann. Dieser Artikel bietet eine umfassende technische Einführung in bestehende Erkennungsmethoden.

- Papieradresse: https://github.com/datamllab/The-Science-of-LLM-generated-Text-Detection

- Rechercheadresse: https:/ /github.com/datamllab/The-Science-of-LLM-generated-Text-Detection

/github.com/datamllab/awsome-LLM-generated-text-detection/tree/main

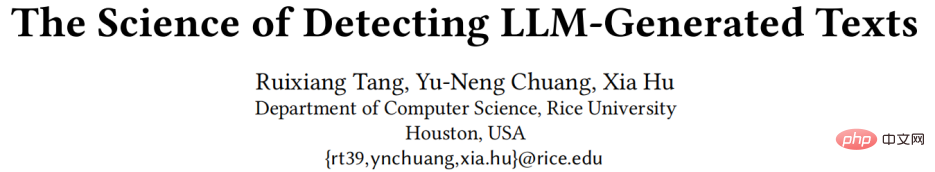

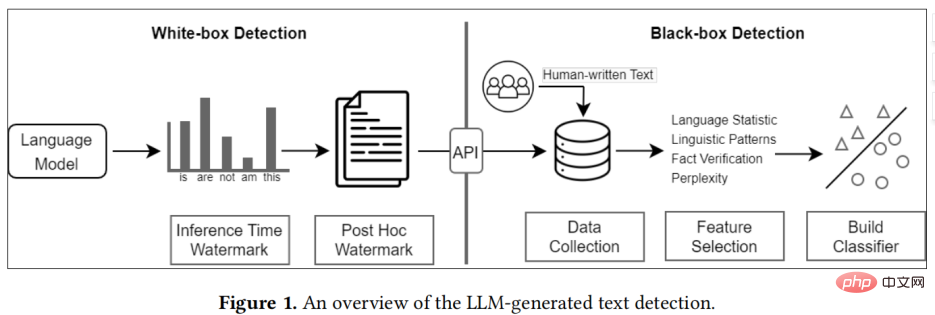

Bestehende Methoden lassen sich grob in zwei Kategorien einteilen:Black-Box-Erkennung und White-Box-Erkennung

- Überblick über die Erkennung von durch große Sprachmodelle generierten Texten

- Black-Box-Erkennungsmethoden haben normalerweise nur Zugriff auf API-Ebene auf große Sprachmodelle. Daher basiert diese Art von Methode auf dem Sammeln von Textproben von Menschen und Maschinen, um Klassifizierungsmodelle zu trainieren.

White-Box-Erkennung, diese Art von Methode hat Zugriff auf große Sprachmodelle und kann das Generierungsverhalten des Modells steuern oder Fügen Sie dem generierten Text ein Wasserzeichen hinzu, um den generierten Text zu verfolgen und zu erkennen.

In der Praxis werden Black-Box-Detektoren normalerweise von Dritten wie GPTZero erstellt, während White-Box-Detektoren normalerweise von Entwicklern großer Sprachmodelle erstellt werden.

Taxonomie der durch ein großes Sprachmodell generierten TexterkennungBlack-Box-Erkennung

Die Black-Box-Erkennung besteht im Allgemeinen aus drei Schritten, nämlich Datenerfassung, Funktionsauswahl und Modellbildung.

Für die Erfassung menschlicher Texte besteht eine Methode darin, Fachkräfte für die Datenerfassung zu rekrutieren. Diese Methode ist jedoch zeitaufwändig und arbeitsintensiv und eignet sich nicht für die Erfassung großer Datensätze Nutzen Sie vorhandene menschliche Textdaten, z. B. Sammeln Sie von verschiedenen Experten bearbeitete Einträge aus Wikipedia, oder sammeln Sie Daten aus Medien, z. B. Reddit. Die Merkmalsauswahl wird im Allgemeinen in statistische Merkmale, sprachliche Merkmale und sachliche Merkmale unterteilt. Statistische Merkmale werden im Allgemeinen verwendet, um zu überprüfen, ob sich der von einem großen Sprachmodell generierte Text von menschlichem Text unterscheidet. Zu den häufig verwendeten statistischen Indikatoren für Text gehören TFIDF, Zipfs Gesetz usw. Sprachmerkmale suchen im Allgemeinen nach einigen sprachlichen Merkmalen, wie z. B. Wortarten, Abhängigkeitsanalyse

, Stimmungsanalyse usw. Schließlich generieren große Sprachmodelle häufig kontrafaktische Aussagen, sodass dieFaktenüberprüfung auch einige Informationen liefern kann, die von großen Sprachmodellen generierte Texte unterscheiden.

🎜🎜Bestehende Klassifizierungsmodelle sind im Allgemeinen in traditionelle Modelle für maschinelles Lernen wie SVM usw. unterteilt. Die neueste Forschung verwendet tendenziell Sprachmodelle wie BERT und RoBERTa als Rückgrat und hat eine höhere Erkennungsleistung erzielt. 🎜🎜

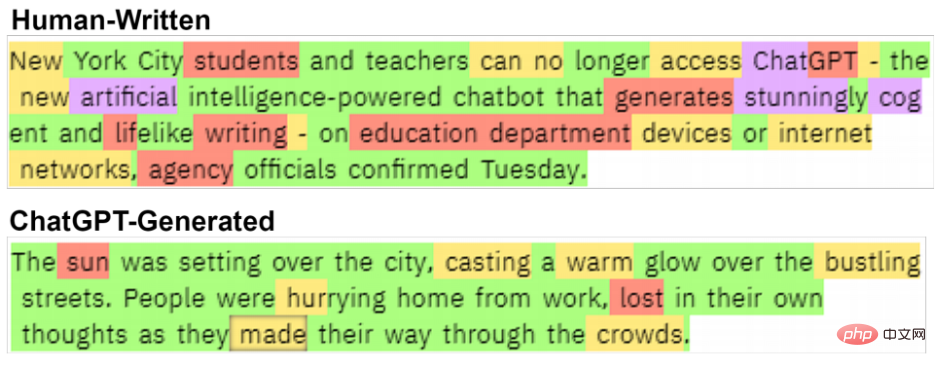

Es gibt einen deutlichen Unterschied zwischen diesen beiden Texten. Von Menschen geschriebener Text von Chalkbeat New York.

White-Box-Erkennung

Die White-Box-Erkennung verwendet im Allgemeinen standardmäßig die Erkennung, die von großen Sprachmodellentwicklern bereitgestellt wird. Im Gegensatz zur Black-Box-Erkennung verfügt die White-Box-Erkennung über vollständigen Zugriff auf das Modell, sodass Wasserzeichen eingebettet werden können, indem die Ausgabe des Modells geändert wird, um den Zweck der Erkennung zu erreichen.

Die aktuellen Erkennungsmethoden können unterteilt werden in Post-hoc-Wasserzeichen und Inferenzzeit-Wasserzeichen :

- Unter diesen werden dem Text Post-hoc-Wasserzeichen hinzugefügt, nachdem der Text von der großen Gruppe generiert wurde Sprachmodell. Die verborgenen Informationen werden für die anschließende Erkennung verwendet.

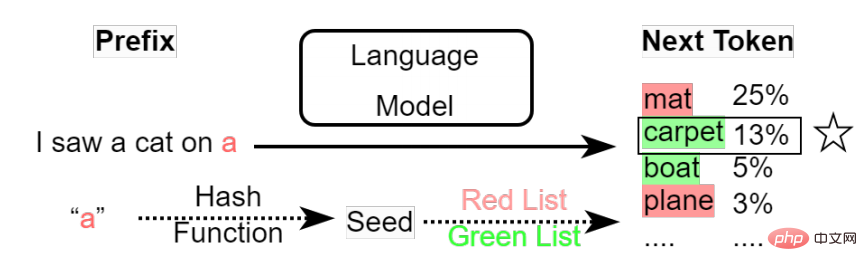

- Inferenzzeit-Wasserzeichen ändern den Sampling-Mechanismus großer Sprachmodelle, um beim Generieren jedes Tokens auf dem großen Sprachmodell zu basieren Auf der Wahrscheinlichkeit aller Token wird die voreingestellte Stichprobenstrategie verwendet, um das nächste generierte Wort auszuwählen, und diesem Auswahlprozess können Wasserzeichen hinzugefügt werden. Inferenzzeitwasserzeichen Dieser Prozess ist sehr einfach, Verzerrungen einzuführen. Beispielsweise konzentrieren sich vorhandene Datensätze hauptsächlich auf verschiedene Aufgaben wie die Beantwortung von Fragen und die Generierung von Geschichten, was zu einer Verzerrung des Themas führt. Darüber hinaus hat Text, der von großen Modellen generiert wird, oft einen festen Stil oder ein festes Format. Diese Verzerrungen werden von Black-Box-Klassifikatoren häufig als Hauptmerkmale für die Klassifizierung verwendet und verringern die Robustheit der Erkennung.

Da sich die Fähigkeiten großer Sprachmodelle verbessern, wird die Lücke zwischen dem von großen Sprachmodellen generierten Text und dem Menschen immer kleiner, was dazu führt, dass die Erkennungsgenauigkeit von Black-Box-Modellen immer geringer wird. Daher wird die White-Box-Erkennung in Zukunft wichtiger.

(2)

Die vorhandene Erkennungsmethode verwendet standardmäßig ein großes Sprachmodell, das dem Unternehmen gehört, sodass alle Benutzer den großen Sprachmodelldienst des Unternehmens über die API erhalten. Dies sind sehr viele-zu-eins-Beziehungen nützlich, um den Einsatz von Erkennungssystemen zu nutzen. Wenn das Unternehmen jedoch ein großes Sprachmodell als Open-Source-Lösung bereitstellen würde, würde dies dazu führen, dass fast alle vorhandenen Erkennungsmethoden unwirksam würden.Da Benutzer bei der Black-Box-Erkennung ihre Modelle verfeinern und den Stil oder das Format der Modellausgabe ändern können, kann die Black-Box-Erkennung keine allgemeinen Erkennungsfunktionen finden. White-Box-Erkennung kann eine Lösung sein. Unternehmen können dem Modell vor Open Source ein Wasserzeichen hinzufügen. Benutzer können das Modell jedoch auch verfeinern und den Sampling-Mechanismus des Modell-Tokens ändern, um das Wasserzeichen zu entfernen. Derzeit gibt es keine Wasserzeichentechnologie, die Benutzer vor diesen potenziellen Bedrohungen schützen kann.

Das obige ist der detaillierte Inhalt vonChatGPT und andere Missbräuche, die vorgeben, ein menschlicher Autor zu sein, geben Anlass zur Sorge, ein Artikel fasst KI-generierte Texterkennungsmethoden zusammen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr