Heim >Technologie-Peripheriegeräte >KI >IBM entwickelt den Cloud-nativen KI-Supercomputer Vela, um zig Milliarden Parametermodelle flexibel einzusetzen und zu trainieren

IBM entwickelt den Cloud-nativen KI-Supercomputer Vela, um zig Milliarden Parametermodelle flexibel einzusetzen und zu trainieren

- 王林nach vorne

- 2023-04-14 13:46:031696Durchsuche

ChatGPT ist im Internet beliebt und auch das dahinter stehende KI-Modelltraining hat große Aufmerksamkeit erregt. IBM Research gab kürzlich bekannt, dass der von ihm entwickelte cloudnative Supercomputer Vela schnell bereitgestellt und zum Trainieren grundlegender KI-Modelle verwendet werden kann. Seit Mai 2022 nutzen Dutzende Forscher des Unternehmens diesen Supercomputer, um KI-Modelle mit zig Milliarden Parametern zu trainieren.

Basismodelle sind KI-Modelle, die auf großen Mengen unbeschrifteter Daten trainiert werden, und ihre Vielseitigkeit bedeutet, dass sie mit nur einer Feinabstimmung für eine Reihe verschiedener Aufgaben verwendet werden können. Ihr Ausmaß ist enorm und erfordert enorme und kostspielige Rechenleistung. Experten sagen daher, dass die Rechenleistung der größte Engpass bei der Entwicklung der nächsten Generation groß angelegter Basismodelle sein wird und deren Training viel Rechenleistung und Zeit erfordert.

Trainingsmodelle, die Dutzende oder Hunderte von Milliarden Parametern ausführen können, erfordern den Einsatz leistungsstarker Computerhardware, einschließlich Netzwerken, parallelen Dateisystemen und Bare-Metal-Knoten. Diese Hardware ist schwierig bereitzustellen und teuer im Betrieb. Microsoft hat im Mai 2020 einen KI-Supercomputer für OpenAI gebaut und ihn auf der Azure-Cloud-Plattform gehostet. Laut IBM sind sie jedoch hardwaregesteuert, was die Kosten erhöht und die Flexibilität einschränkt.

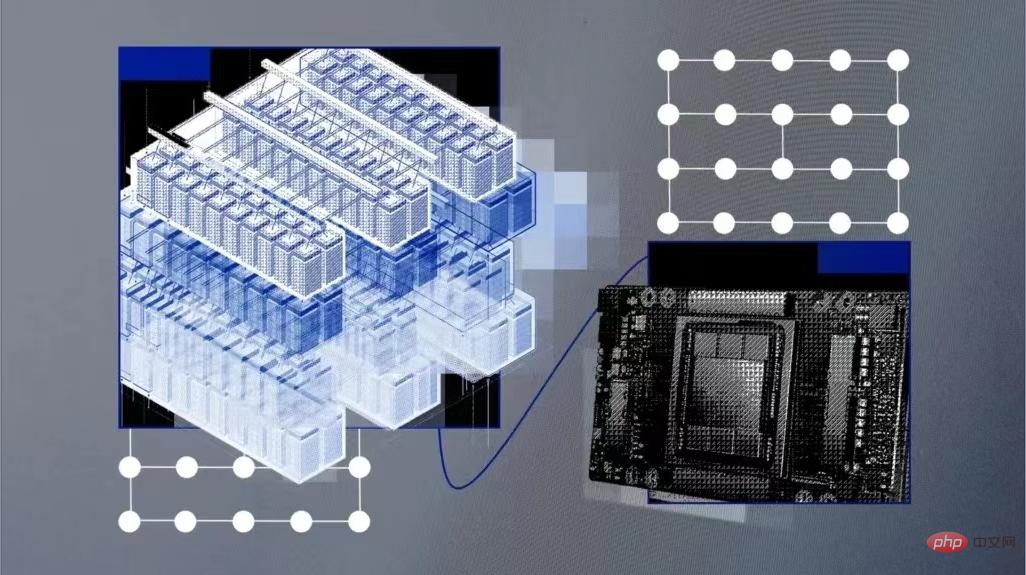

Cloud AI Supercomputer

Daher hat IBM ein System namens Vela entwickelt, das „speziell auf groß angelegte KI ausgerichtet ist“.

Vela kann je nach Bedarf in jedem Cloud-Rechenzentrum von IBM bereitgestellt werden und ist selbst eine „virtuelle Cloud“. Dieser Ansatz reduziert zwar die Rechenleistung im Vergleich zu bauphysikalischen Supercomputern, schafft aber eine flexiblere Lösung. Cloud-Computing-Lösungen bieten Ingenieuren Ressourcen über API-Schnittstellen, einfacheren Zugriff auf das breite IBM Cloud-Ökosystem für eine tiefere Integration und die Möglichkeit, die Leistung nach Bedarf zu skalieren.

IBM-Ingenieure erklärten, dass Vela auf Datensätze im IBM Cloud Object Storage zugreifen kann, anstatt ein benutzerdefiniertes Speicher-Backend zu erstellen. Bisher musste diese Infrastruktur separat in Supercomputern aufgebaut werden.

Die Schlüsselkomponente jedes KI-Supercomputers ist eine große Anzahl von GPUs und die sie verbindenden Knoten. Vela konfiguriert tatsächlich jeden Knoten als virtuelle Maschine (und nicht als Bare-Metal-Maschine). Dies ist die gebräuchlichste Methode und wird allgemein als die idealste Methode für das KI-Training angesehen.

Wie ist Vela aufgebaut?

Einer der Nachteile virtueller Cloud-Computer besteht darin, dass die Leistung nicht garantiert werden kann. Um Leistungseinbußen entgegenzuwirken und Bare-Metal-Leistung innerhalb virtueller Maschinen bereitzustellen, haben IBM-Ingenieure einen Weg gefunden, die Leistung des gesamten Knotens (einschließlich GPU, CPU, Netzwerk und Speicher) freizuschalten und Lastverluste auf weniger als 5 % zu reduzieren.

Dazu gehört die Konfiguration eines Bare-Metal-Hosts für die Virtualisierung, die Unterstützung der VM-Skalierung, der Large-Page- und Single-Root-IO-Virtualisierung sowie die realistische Darstellung aller Geräte und Verbindungen innerhalb der VM. Dazu gehört auch die Anpassung von Netzwerkkarten an CPUs und GPUs und deren Wie man einander überbrückt. Nach Abschluss dieser Arbeit stellten sie fest, dass die Leistung der virtuellen Maschinenknoten „nahezu Bare-Metal“ war.

Darüber hinaus engagieren sie sich auch für die Entwicklung von KI-Knoten mit großem GPU-Speicher und großen Mengen an lokalem Speicher zum Zwischenspeichern von KI-Trainingsdaten, Modellen und fertigen Produkten. Bei Tests mit PyTorch stellten sie fest, dass sie durch die Optimierung der Workload-Kommunikationsmuster auch den Engpass relativ langsamer Ethernet-Netzwerke im Vergleich zu schnelleren Netzwerken wie Infiniband, die im Supercomputing verwendet werden, überbrücken konnten.

In Bezug auf die Konfiguration verwendet jeder Vela acht 80-GB-A100-GPUs, zwei skalierbare Intel Xeon-Prozessoren der zweiten Generation, 1,5 TB Speicher und vier 3,2-TB-NVMe-Festplatten und kann in jedem Cloud-Rechenzentrum von IBM bereitgestellt werden auf der ganzen Welt.

IBM-Ingenieure sagten: „Die richtigen Werkzeuge und die richtige Infrastruktur sind ein Schlüsselfaktor für die Verbesserung der F&E-Effizienz. Viele Teams entscheiden sich für den bewährten Weg, traditionelle Supercomputer für KI zu bauen … Wir arbeiten immer an einer Verbesserung.“ Lösung, um die doppelten Vorteile von Hochleistungsrechnen und High-End-Benutzerproduktivität zu bieten“

Das obige ist der detaillierte Inhalt vonIBM entwickelt den Cloud-nativen KI-Supercomputer Vela, um zig Milliarden Parametermodelle flexibel einzusetzen und zu trainieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr