Heim >Technologie-Peripheriegeräte >KI >Zusammenfassung zum Google AI-Jahresende Nr. 6: Wie verläuft die Entwicklung der Google-Roboter ohne Boston Dynamics?

Zusammenfassung zum Google AI-Jahresende Nr. 6: Wie verläuft die Entwicklung der Google-Roboter ohne Boston Dynamics?

- 王林nach vorne

- 2023-04-14 13:16:031648Durchsuche

Ein Backflip von Boston Dynamics zeigt uns die unendlichen Möglichkeiten, die von Menschenhand geschaffene Roboter bieten.

Obwohl Google Boston Dynamics im Jahr 2017 verkauft hat, setzt Google seinen Weg der Roboterentwicklung fort und nähert sich nicht nur „physisch“ dem Menschen, In Begriffe von „ Intelligenz“ verfolgen wir auch ein besseres Verständnis menschlicher Anweisungen.

Die von Jeff Dean geleitete Zusammenfassungsreihe zum Jahresende von Google Research wurde auf die sechste Ausgabe aktualisiert. Das Thema dieser Ausgabe lautet . „Roboter“ , geschrieben von Senior Product Manager Kendra Byrne und Google Robotics Research Scientist Jie Tan

In unserem Leben werden wir auf jeden Fall Robotertechnologie im täglichen Leben des Menschen sehen, die zur Verbesserung der menschlichen Produktivität beiträgt und Lebensqualität. Bevor Robotertechnologien in großem Umfang für die tägliche praktische Arbeit in menschzentrierten Räumen (d. h. Räumen, die für Menschen und nicht für Maschinen konzipiert sind) eingesetzt werden können, muss sichergestellt werden, dass sie Menschen sicher unterstützen können.

Im Jahr 2022 konzentriert sich Google auf die Herausforderung, Roboter hilfreicher für den Menschen zu machen:

Roboter und Menschen effektiver und natürlicher kommunizieren zu lassen;- Roboter in die Lage zu versetzen, gesundes Menschenverstandswissen in der realen Welt zu verstehen und anzuwenden; Erweitern Sie die Anzahl der einfachen Fähigkeiten, die Roboter benötigen, um Aufgaben in unstrukturierten Umgebungen effektiv auszuführen.

- Wenn LLM auf Roboter trifft

- Ein Merkmal großer Sprachmodelle (LLM) ist die Fähigkeit, Beschreibungen und Kontext in ein Format zu kodieren, das „für Menschen und Maschinen verständlich“ ist.

Wenn LLM auf die Robotik angewendet wird, ermöglicht es Benutzern, Robotern Aufgaben nur durch Anweisungen in natürlicher Sprache zuzuweisen. In Kombination mit visuellen Modellen und Roboterlernmethoden bietet LLM den Robotern die Möglichkeit, Benutzeranforderungen zu verstehen Planen Sie Maßnahmen, die zur Bearbeitung der Anfrage ergriffen werden sollen.

Eine der grundlegenden Methoden besteht darin, LLM zu verwenden, um andere vorab trainierte Modelle dazu zu veranlassen, Informationen zu erhalten, um einen Kontext für das Geschehen in der Szene zu erstellen und Vorhersagen für multimodale Aufgaben zu treffen. Der gesamte Prozess ähnelt der sokratischen Lehrmethode. Der Lehrer stellt den Schülern Fragen und leitet sie durch einen rationalen Denkprozess an, diese zu beantworten.

Im „Sokrates-Modell“ haben Forscher gezeigt, dass diese Methode bei Zero-Shot-Bildbeschreibungs- und Videotext-Retrieval-Aufgaben eine hochmoderne Leistung erzielen kann und auch neue Funktionen wie die kostenlose Beantwortung von Fragen zu Videos unterstützen kann -Formularfragen und Vorhersage zukünftiger Aktivitäten, multimodaler unterstützter Dialog sowie robotergestützte Wahrnehmung und Planung.

Link zum Papier: https://arxiv.org/abs/2204.00598 Im Artikel „Auf dem Weg zu hilfreichen Robotern: Eine grundlegende Sprache für die Benutzerfreundlichkeit von Robotern“ arbeiteten Forscher mit Everyday Robots zusammen, um ein langes Roboter-Benutzerfreundlichkeitsmodell zu erstellen -Term-Aufgaben basierend auf dem PaLM-Sprachmodell.

Im Artikel „Auf dem Weg zu hilfreichen Robotern: Eine grundlegende Sprache für die Benutzerfreundlichkeit von Robotern“ arbeiteten Forscher mit Everyday Robots zusammen, um ein langes Roboter-Benutzerfreundlichkeitsmodell zu erstellen -Term-Aufgaben basierend auf dem PaLM-Sprachmodell.

In früheren Methoden des maschinellen Lernens konnten Roboter nur Aufgaben wie „Aufheben“ annehmen „Schwamm““ und andere kurze, hartcodierte Befehle, und es ist schwierig, über die Schritte nachzudenken, die zum Abschließen der Aufgabe erforderlich sind, und es ist noch schwieriger, sie zu handhaben, wenn es sich bei der Aufgabe um ein abstraktes Ziel handelt, wie zum Beispiel „Können Sie dabei helfen, diese zu bereinigen?“. verschüttet?“

In früheren Methoden des maschinellen Lernens konnten Roboter nur Aufgaben wie „Aufheben“ annehmen „Schwamm““ und andere kurze, hartcodierte Befehle, und es ist schwierig, über die Schritte nachzudenken, die zum Abschließen der Aufgabe erforderlich sind, und es ist noch schwieriger, sie zu handhaben, wenn es sich bei der Aufgabe um ein abstraktes Ziel handelt, wie zum Beispiel „Können Sie dabei helfen, diese zu bereinigen?“. verschüttet?“

Die Wertfunktion im Reinforcement-Learning-Modell kann verwendet werden, um ein Affordance-Modell zu erstellen, das eine abstrakte Darstellung der Aktionen ist, die ein Roboter in verschiedenen Zuständen ausführen kann, und so langfristige Aufgaben in der realen Welt, wie zum Beispiel „Aufräumen“, integrieren „Schlafzimmer“ mit der für die Erledigung der Aufgabe benötigten Zeit. Kurzfristige Fähigkeiten wie das richtige Auswählen, Platzieren und Anordnen von Gegenständen sind verknüpft.

Papierlink: https://arxiv.org/abs/2111.03189

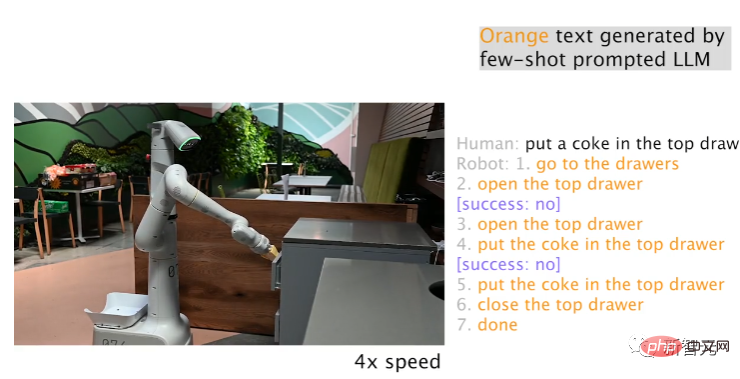

Dass sowohl LLM- als auch Affordance-Modelle vorhanden sind, bedeutet nicht, dass der Roboter die Aufgabe erfolgreich abschließen kann Basierend auf LLM-Schleifen in der Missionsplanung; durch die Nutzung anderer Informationsquellen, wie z. B. menschliches Feedback oder Szenenverständnis, kann erkannt werden, wenn ein Roboter eine Aufgabe nicht korrekt ausführen kann.

Link zum Papier: https://arxiv.org/abs/2207.05608

Mit einem Roboter von Everyday Robots fanden Forscher heraus, dass LLM die aktuellen oder zuvor fehlgeschlagenen Planschritte effektiv neu planen kann und der Roboter sich erholen kann Nach einem Ausfall können Sie komplexe Aufgaben wie „Legen Sie eine Cola in die oberste Schublade“ wiederherstellen und erledigen.

Bei der LLM-basierten Missionsplanung besteht eine der herausragenden Fähigkeiten darin, dass der Roboter auf Änderungen bei übergeordneten Zielen und Zwischenaufgaben reagieren kann: Beispielsweise kann der Benutzer dem Roboter durch schnelle Bereitstellung mitteilen, was gerade passiert Korrekturen oder das Umleiten des Roboters zu einer anderen Aufgabe, wodurch bereits geplante Aktionen geändert werden, und ist besonders nützlich, um Benutzern die interaktive Steuerung und Anpassung von Roboteraufgaben zu ermöglichen.

Während natürliche Sprache es Menschen erleichtert, Roboteraufgaben zu spezifizieren und zu modifizieren, besteht auch die Herausforderung, in Echtzeit auf menschliche Beschreibungen zu reagieren.

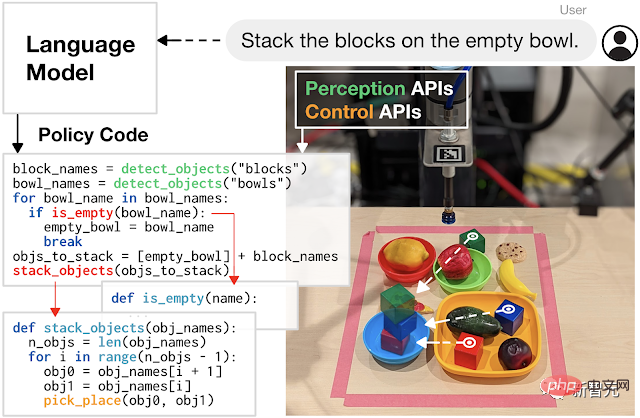

Forscher schlagen im Rahmen des Projekts ein groß angelegtes Imitationslernrahmen zur Herstellung von Echtzeit-Robotern mit offenem Wortschatz vor, die in der Lage sind, mehr als 87.000 einzigartige Anweisungen mit einer geschätzten durchschnittlichen Erfolgsquote von 93,5 % zu verarbeiten Google hat außerdem Language-Table veröffentlicht, den derzeit größten Datensatz für Sprachannotationsroboter. Link zum Papier: https://arxiv.org/pdf/2210.06407.pdf. Und verwenden Sie LLM, um Code zu schreiben, der den Roboter steuert Bewegungen sind ebenfalls eine vielversprechende Forschungsrichtung.

Die von den Forschern entwickelte Codierungsmethode zeigt das Potenzial zur Erhöhung der Aufgabenkomplexität, indem sie es Robotern ermöglicht, API-Aufrufe neu zu kombinieren, neue Funktionen zu synthetisieren und Feedbackschleifen auszudrücken, um zur Laufzeit neues Verhalten zu synthetisieren, indem sie autonom neuen Code generieren.

Link zum Papier: https://arxiv.org/abs/2209.07753

Link zum Papier: https://arxiv.org/abs/2209.07753

Transformation des Roboterlernens in ein skalierbares Datenproblem

Große Sprach- und multimodale Modelle können Robotern helfen, die Umgebung zu verstehen, in der sie arbeiten, z. B. was Was in der Szene passiert und was der Roboter tun soll; Roboter benötigen jedoch auch geringe physikalische Fähigkeiten, um Aufgaben in der physischen Welt zu erledigen, wie zum Beispiel das genaue Aufnehmen und Platzieren von Objekten.

Papierlink: https://robotics-transformer.github.io/assets/rt1.pdf

Die Forscher schlugen das Robot Transformer-1 (RT-1)-Modell vor und trainierten eine Roboterbetriebsstrategie. Die verwendeten Trainingsdaten waren ein umfangreicher realer Roboterdatensatz von 130.000 Episoden, der 13 Roboter von Everyday Robots Robotics abdeckte mehr als 700 Aufgaben und zeigt den gleichen Trend in der Robotik, nämlich dass eine Erhöhung der Größe und Vielfalt der Daten die Modellgeneralisierung für neue Aufgaben, Umgebungen und Objekte verbessert.

Hinter dem Sprachmodell und Roboterlernmethoden (wie RT-1) wird das Transformer-Modell auf der Grundlage von Daten im Internetmaßstab trainiert. Im Gegensatz zu LLM ist die Robotik jedoch mit sich ändernden Umgebungen und Herausforderungen der multimodalen Darstellung mit begrenzter Berechnung konfrontiert.

Im Jahr 2020 schlug Google Performers vor, eine Methode, die die Recheneffizienz von Transformer verbessern kann und sich auf mehrere Anwendungsszenarien einschließlich Robotik auswirkt.

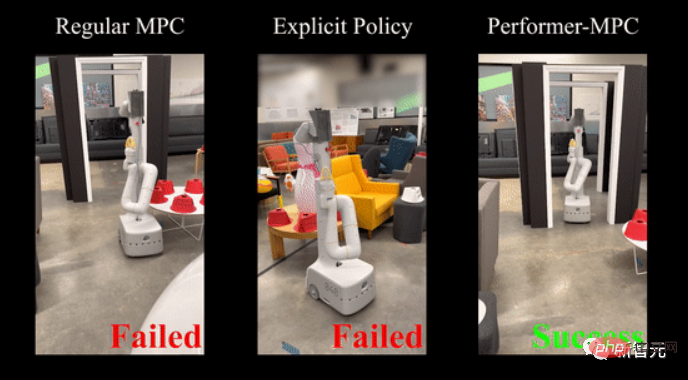

Kürzlich haben Forscher diese Methode erweitert und eine neue Klasse impliziter Kontrollstrategien eingeführt, die die Vorteile des Simulationslernens und der robusten Handhabung von Systembeschränkungen (vorab geschätzte Kontrollbeschränkungen des Modells) kombinieren.

Link zum Papier: https://performermpc.github.io/

Verglichen mit der Standard-MPC-Strategie zeigen die experimentellen Ergebnisse, dass der Roboter beim Navigieren um Menschen und soziale Netzwerke eine um mehr als 40 % bessere Zielerreichung erzielt Es gibt eine Verbesserung von mehr als 65 % bei den Indikatoren; Performance-MPC beträgt 8,3 M. Die Verzögerung des Parametermodells beträgt nur 8 Millisekunden, was den Einsatz von Transformer auf Robotern möglich macht.

Das Forschungsteam von Google hat außerdem gezeigt, dass datengesteuerte Methoden häufig auf verschiedene Roboterplattformen in unterschiedlichen Umgebungen anwendbar sind, um ein breites Spektrum an Aufgaben zu erlernen, darunter mobile Manipulation, Navigation, Fortbewegung und Tischtennis usw Für das Erlernen von Robotikkenntnissen auf niedrigem Niveau weisen sie einen klaren Weg: skalierbare Datenerfassung.

Im Gegensatz zu den umfangreichen Video- und Textdaten im Internet sind Robotikdaten äußerst selten und schwer zu erhalten, und Methoden zur Sammlung und effektiven Nutzung umfangreicher Datensätze, die reale Interaktionen darstellen, sind der Schlüssel zu einem datengesteuerten Ansatz.

Simulation ist eine schnelle, sichere und einfach zu parallelisierende Option, es ist jedoch schwierig, die gesamte Umgebung in der Simulation nachzubilden, insbesondere die physische Umgebung und die Umgebung der Mensch-Computer-Interaktion.

Link zum Papier: https://arxiv.org/abs/2207.06572

In i-Sim2Real demonstrieren Forscher eine Methode, indem sie von einem einfachen menschlichen Verhaltensmodell ausgehen und in Simulationen trainieren. Zur Lösung wechseln sie zwischen realen Einsätzen ab Diskrepanzen zwischen Simulation und Realität und das Lernen, Tischtennis gegen menschliche Gegner zu spielen, menschliche Verhaltensmodelle und Richtlinien werden mit jeder Iteration verfeinert.

Während Simulationen beim Sammeln von Daten hilfreich sein können, ist das Sammeln von Daten in der realen Welt von entscheidender Bedeutung für die Feinabstimmung von Simulationsstrategien oder die Anpassung bestehender Strategien in neuen Umgebungen.

Während des Lernprozesses kann ein Roboter leicht versagen und möglicherweise sich selbst und seiner Umgebung Schaden zufügen. Insbesondere in den frühen Lernphasen der Erforschung der Interaktion mit der Welt müssen Trainingsdaten sicher erfasst werden, damit der Roboter dies nicht tut Es erlernt nur Fähigkeiten und kann sich auch nach Fehlern selbstständig erholen.

Link zum Papier: https://arxiv.org/abs/2110.05457

Die Forscher schlugen ein sicheres RL-Framework vor, das zwischen „Lernstrategie“ und „sicherer Wiederherstellungsstrategie“ wechselt, wobei ersteres für die Leistung optimiert ist Letzteres verhindert, dass sich der Roboter in unsicheren Zuständen befindet; es trainiert eine Reset-Strategie, damit der Roboter sich von Fehlern erholen kann, beispielsweise indem er lernt, nach einem Sturz selbstständig aufzustehen.

Obwohl es nur sehr wenige Daten zu Robotern gibt, gibt es viele Videos von Menschen, die unterschiedliche Aufgaben ausführen. Natürlich sind die Strukturen von Robotern und Menschen unterschiedlich, daher löste die Idee, Roboter von Menschen lernen zu lassen, einen „Transfer“ aus Problem des Lernens über verschiedene Einheiten hinweg.

Link zum Papier: https://arxiv.org/pdf/2106.03911.pdf

Forscher haben Cross-Embodiment Inverse Reinforcement Learning entwickelt, um neue Aufgaben durch Beobachtung von Menschen zu erlernen, anstatt zu versuchen, eine Aufgabe so genau wie ein Mensch zu reproduzieren Statt Aufgabenziele auf hoher Ebene zu erlernen und dieses Wissen in Form einer Belohnungsfunktion zusammenzufassen, können Roboter durch Demonstrationslernen Fähigkeiten erlernen, indem sie sich Videos ansehen, die im Internet verfügbar sind.

Eine andere Richtung besteht darin, die Dateneffizienz von Lernalgorithmen zu verbessern, sodass sie nicht mehr ausschließlich auf eine erweiterte Datenerfassung angewiesen sind: Die Effizienz von RL-Methoden wird durch die Einbeziehung von Vorinformationen, einschließlich Vorhersageinformationen, gegnerischen Aktionsprioritäten und Leitstrategien, verbessert.

Link zum Papier: https://arxiv.org/abs/2210.10865

Durch die Verwendung einer neuen strukturierten dynamischen Systemarchitektur zur Kombination von RL und Trajektorienoptimierung mit der Unterstützung eines neuen Lösers erhalten wir weitere Verbesserungen, vorab Informationen tragen dazu bei, Explorationsherausforderungen zu lindern, Daten besser zu normalisieren und die erforderliche Datenmenge erheblich zu reduzieren.

Darüber hinaus hat das Robotik-Team viel Geld in ein effektiveres Datensimulationslernen investiert. Experimente haben gezeigt, dass eine einfache Nachahmungslernmethode BC-Z eine Null-Schuss-Verallgemeinerung bei neuen Aufgaben durchführen kann, die im Training nicht zu sehen sind. 🔜 Geschwindigkeit Präzisions-Tischtennisspiel.

Link zum Papier: https://sites.google.com/view/goals-eye

Auf der theoretischen Seite untersuchten die Forscher die dynamische Systemstabilität, die die Komplexität simulierter Lernbeispiele charakterisiert, und erfassten Demonstrationsdaten Scheitern und Wiederherstellung, um die Rolle des Offline-Lernens mit kleinen Datensätzen besser zu regulieren.

Link zum Papier: https://proceedings.mlr.press/v168/tu22a.html

Zusammenfassung

Die Weiterentwicklung groß angelegter Modelle im Bereich der künstlichen Intelligenz hat zu einem Sprung in den Lernfähigkeiten von Robotern geführt.

Das obige ist der detaillierte Inhalt vonZusammenfassung zum Google AI-Jahresende Nr. 6: Wie verläuft die Entwicklung der Google-Roboter ohne Boston Dynamics?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr