Heim >Technologie-Peripheriegeräte >KI >Neue Arbeit von Jeff Dean und anderen: Wenn man Sprachmodelle aus einem anderen Blickwinkel betrachtet, ist der Maßstab nicht groß genug und kann nicht entdeckt werden

Neue Arbeit von Jeff Dean und anderen: Wenn man Sprachmodelle aus einem anderen Blickwinkel betrachtet, ist der Maßstab nicht groß genug und kann nicht entdeckt werden

- 王林nach vorne

- 2023-04-14 12:52:031453Durchsuche

In den letzten Jahren hatten Sprachmodelle einen revolutionären Einfluss auf die Verarbeitung natürlicher Sprache (NLP). Es ist bekannt, dass die Erweiterung von Sprachmodellen, wie z. B. Parametern, zu einer besseren Leistung und Stichprobeneffizienz bei einer Reihe nachgelagerter NLP-Aufgaben führen kann. In vielen Fällen lässt sich der Einfluss der Skalierung auf die Leistung oft durch Skalierungsgesetze vorhersagen, und die meisten Forscher haben vorhersehbare Phänomene untersucht.

Im Gegenteil, 16 Forscher, darunter Jeff Dean, Percy Liang usw., arbeiteten an der Arbeit „Emergent Abilities of Large Language Models“ zusammen. Sie diskutierten das Phänomen der Unvorhersehbarkeit großer Sprachmodelle und nannten es die Entstehung großer Sprachmodelle . Neue Fähigkeiten. Die sogenannte Emergenz bedeutet, dass einige Phänomene im kleineren Modell nicht existieren, aber im größeren Modell. Sie glauben, dass diese Fähigkeit des Modells emergent ist.

Emergenz als Idee wird seit langem in Bereichen wie Physik, Biologie und Informatik diskutiert. Dieser Artikel beginnt mit einer allgemeinen Definition von Emergenz, die auf der Forschung von Steinhardt basiert und auf den Artikel „Mehr“ aus dem Jahr 1972 zurückgeht Is Different vom Nobelpreisträger und Physiker Philip Anderson.

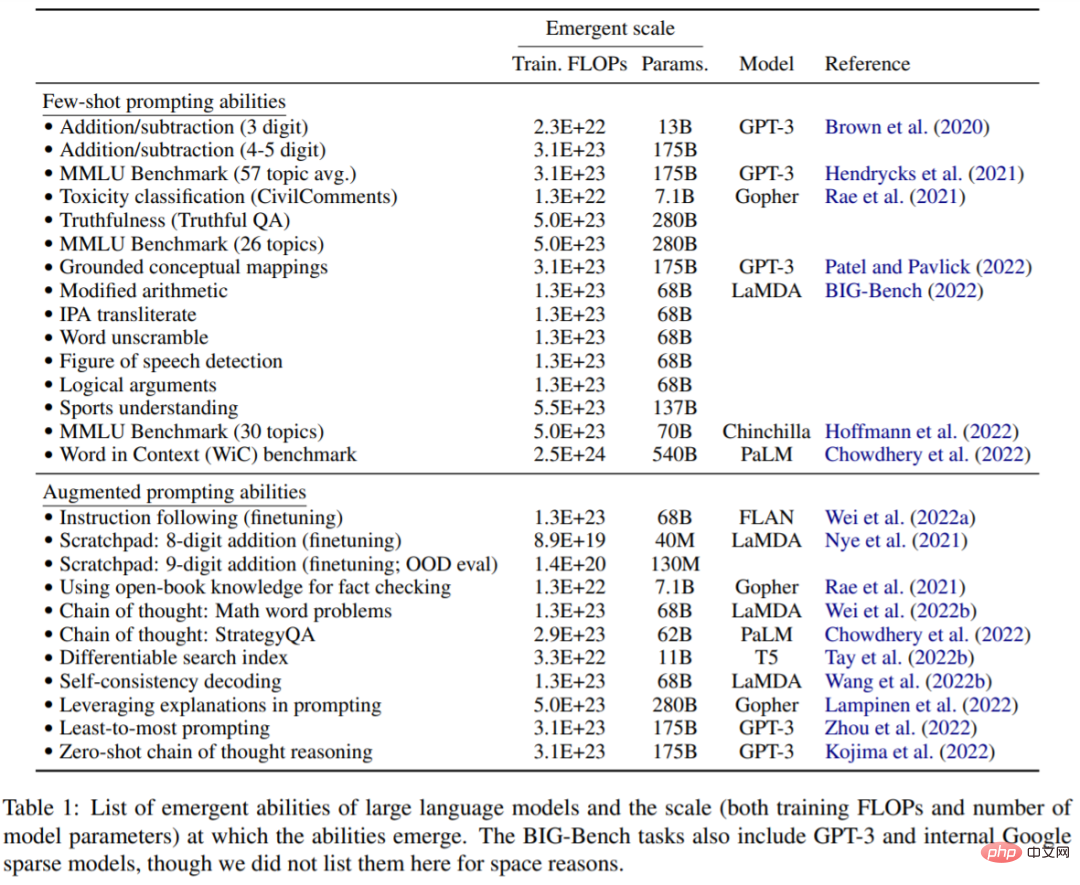

Dieser Artikel untersucht die Entstehung der Modellgröße, gemessen durch Trainingsberechnungen und Modellparameter. Konkret definiert dieser Artikel die entstehenden Fähigkeiten großer Sprachmodelle als Fähigkeiten, die in kleinen Modellen nicht vorhanden sind, aber in großen Modellen vorhanden sind. Daher können große Modelle nicht durch einfache Extrapolation der Leistungsverbesserungen kleiner Modelle vorhergesagt werden. maßstabsgetreue Modelle. Diese Studie untersucht die neuen Fähigkeiten von Modellen, die in einer Reihe früherer Arbeiten beobachtet wurden, und klassifiziert sie in Umgebungen wie Small-Shot-Cueing und Boosted-Cueing.

Diese neu entstehende Fähigkeit des Modells inspiriert zukünftige Forschungen darüber, warum diese Fähigkeiten erworben werden und ob größere Maßstäbe mehr neu entstehende Fähigkeiten erwerben, und unterstreicht die Bedeutung dieser Forschung.

Papieradresse: https://arxiv.org/pdf/2206.07682.pdf

Kleine Beispiel-Prompting-Aufgabe

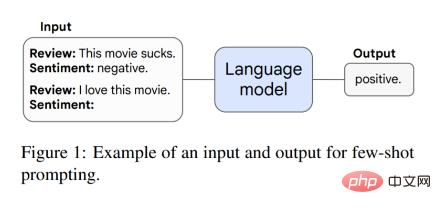

Dieses Papier diskutiert zunächst die Emergenzfähigkeit im Prompt-Paradigma. Beispielsweise kann das Modell in der GPT-3-Eingabeaufforderung bei einer vorab trainierten Sprachmodell-Aufgabenaufforderung die Antwort ohne weiteres Training oder Gradientenaktualisierungen der Parameter abschließen. Darüber hinaus schlugen Brown et al. eine Eingabeaufforderung für kleine Stichproben vor, bei der sie einige Eingabe- und Ausgabebeispiele im Modellkontext (Eingabe) als Eingabeaufforderungen (Präambel) verwendeten und das Modell dann aufforderten, unsichtbare Inferenzaufgaben auszuführen. Abbildung 1 zeigt eine Beispielaufforderung.

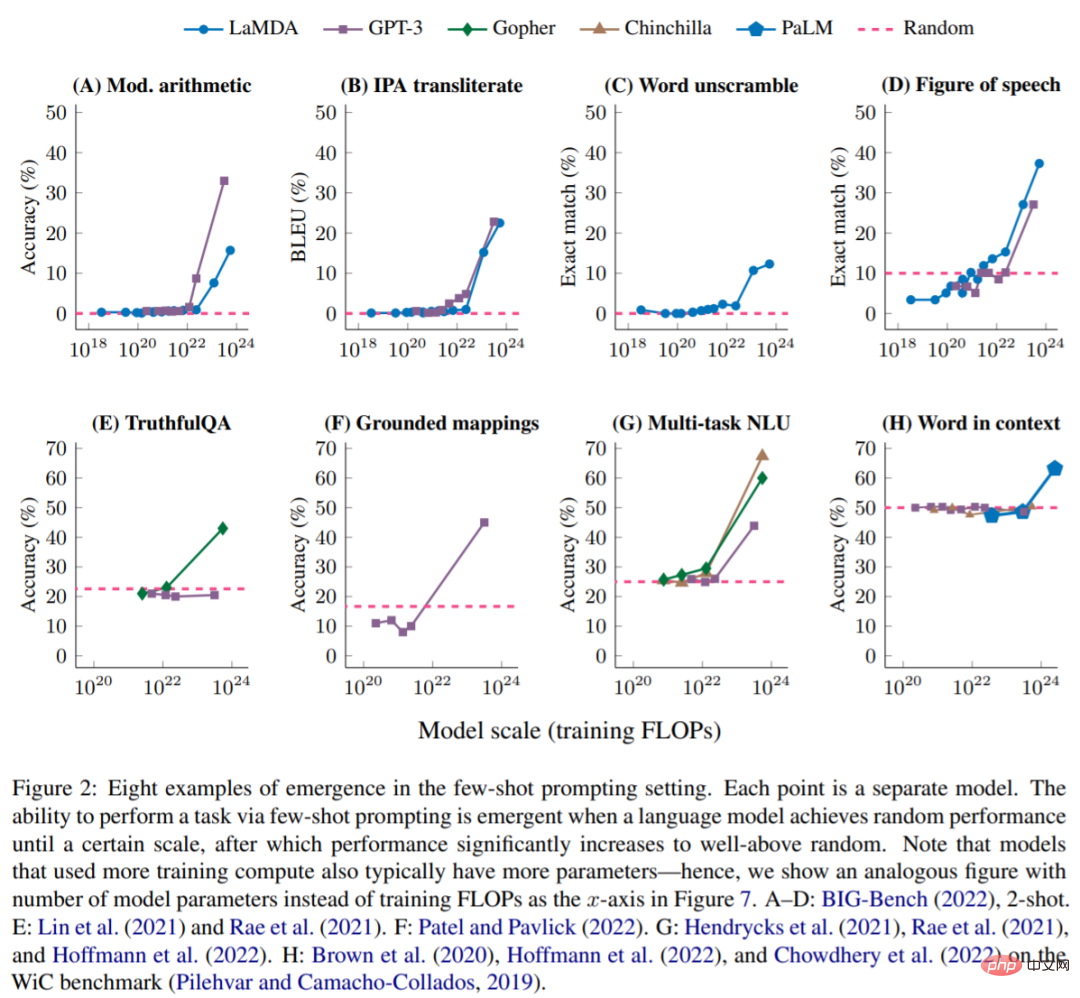

Wenn das Modell eine stochastische Leistung und einen bestimmten Maßstab aufweist, kann es Aufgaben durch kleine Beispielaufforderungen ausführen. Zu diesem Zeitpunkt werden neue Fähigkeiten angezeigt, und dann ist die Modellleistung viel höher zufällige Leistung. Die folgende Abbildung zeigt die 8 neuen Funktionen von 5 Sprachmodellreihen (LaMDA, GPT-3, Gopher, Chinchilla und PaLM).

BIG-Bench: Abbildung 2A-D zeigt vier aufkommende Aufgaben zur Eingabeaufforderung mit wenigen Schüssen aus BIG-Bench, einer Suite von mehr als 200 Benchmarks zur Sprachmodellbewertung. Abbildung 2A zeigt einen arithmetischen Benchmark, der die Addition und Subtraktion dreistelliger Zahlen sowie die Multiplikation zweistelliger Zahlen testet. Tabelle 1 enthält weitere neue Funktionen von BIG-Bench.

Erweiterte Trinkgeldstrategie

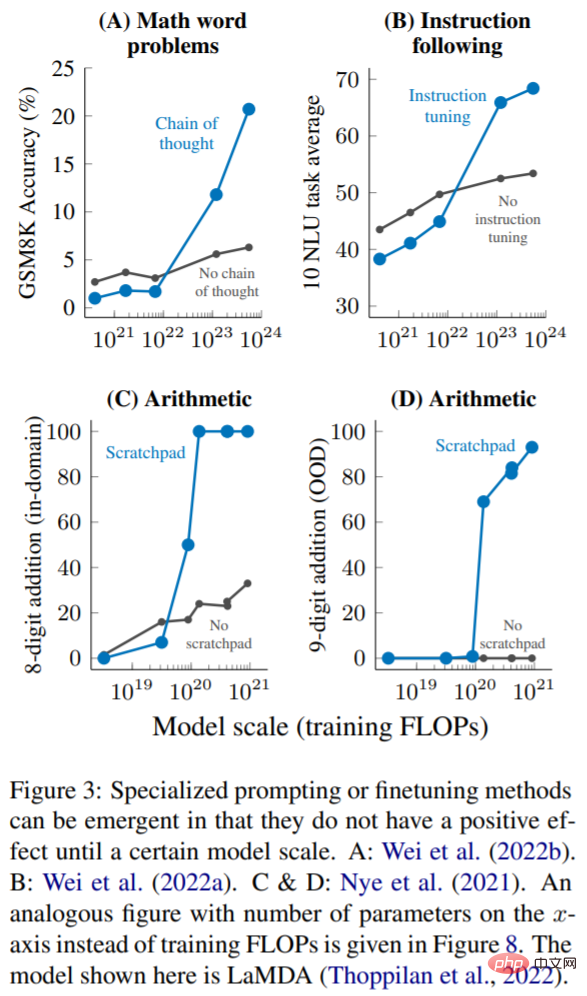

Obwohl Hinweise für kleine Stichproben derzeit die gebräuchlichste Art der Interaktion mit großen Sprachmodellen sind, wurden in neueren Arbeiten mehrere andere Hinweise und Strategien zur Feinabstimmung vorgeschlagen, um die Fähigkeiten von Sprachmodellen weiter zu verbessern. In diesem Artikel wird eine Technologie auch dann als neue Fähigkeit betrachtet, wenn sie keine Verbesserung zeigt oder schädlich ist, bevor sie auf ein ausreichend großes Modell angewendet wird.

Mehrstufiges Denken: Für Sprachmodelle und NLP-Modelle waren Argumentationsaufgaben, insbesondere solche, die mehrstufiges Denken beinhalten, schon immer eine große Herausforderung. Eine neue Aufforderungsstrategie namens Chain-of-Thinking ermöglicht es Sprachmodellen, diese Art von Problem zu lösen, indem sie sie anleitet, eine Reihe von Zwischenschritten zu generieren, bevor sie eine endgültige Antwort geben. Wie in Abbildung 3A dargestellt, übertraf die Gedankenketten-Eingabeaufforderung bei der Skalierung auf 1023 Trainings-FLOPs (~100 Milliarden Parameter) nur die Standard-Eingabeaufforderung ohne Zwischenschritte.

Anweisung folgt): Wie in Abbildung 3B gezeigt, stellten Wei et al. fest, dass Anweisung -Feinabstimmungstechniken beeinträchtigen die Modellleistung und können die Leistung nur verbessern, wenn die Trainings-FLOPs auf 10^23 (~100B Parameter) erweitert werden.

Programmausführung: Wie in Abbildung 3C gezeigt, hilft die Verwendung des Scratchpads bei der domäneninternen Auswertung der 8-Bit-Addition nur ∼9·10 ^19 Trainings-FLOPs ( 40M Parameter) oder größere Modelle. Abbildung 3D zeigt, dass diese Modelle auch auf eine 9-Bit-Addition außerhalb der Domäne verallgemeinert werden können, die in ∼1,3 · 10^20 Trainings-FLOPs (100 Millionen Parameter) auftritt.

Dieser Artikel befasst sich nur mit der aufkommenden Macht von Sprachmodellen Eine sinnvolle Leistung kann nur in einem bestimmten Rechenmaßstab beobachtet werden. Diese neue Fähigkeit von Modellen kann eine Vielzahl von Sprachmodellen, Aufgabentypen und experimentellen Szenarien umfassen. Die Existenz dieses Aufkommens bedeutet, dass eine zusätzliche Skalierung die Fähigkeiten von Sprachmodellen weiter erweitern kann. Diese Fähigkeit ist das Ergebnis kürzlich entdeckter Sprachmodellerweiterungen und ob weitere Erweiterungen zu weiteren neuen Fähigkeiten führen werden, könnten wichtige zukünftige Forschungsrichtungen im Bereich NLP sein.

Weitere Informationen finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonNeue Arbeit von Jeff Dean und anderen: Wenn man Sprachmodelle aus einem anderen Blickwinkel betrachtet, ist der Maßstab nicht groß genug und kann nicht entdeckt werden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr