Heim >Technologie-Peripheriegeräte >KI >3 Milliarden übertrafen die 175 Milliarden von GPT-3. Das neue Modell von Google sorgte für hitzige Diskussionen, aber es verstand Hintons Alter.

3 Milliarden übertrafen die 175 Milliarden von GPT-3. Das neue Modell von Google sorgte für hitzige Diskussionen, aber es verstand Hintons Alter.

- PHPznach vorne

- 2023-04-14 11:49:02922Durchsuche

Ein wichtiges Ziel der künstlichen Intelligenz ist die Entwicklung von Modellen mit starken Generalisierungsfähigkeiten. Im Bereich der Verarbeitung natürlicher Sprache (NLP) haben vorab trainierte Sprachmodelle diesbezüglich erhebliche Fortschritte gemacht. Solche Modelle werden oft feinabgestimmt, um sich an neue Aufgaben anzupassen.

Kürzlich haben Forscher von Google verschiedene Methoden zur Feinabstimmung von Anweisungen analysiert, einschließlich der Auswirkungen von Erweiterungen auf die Feinabstimmung von Anweisungen. Experimente zeigen, dass die Feinabstimmung von Anweisungen tatsächlich gut an die Anzahl der Aufgaben und die Modellgröße angepasst werden kann. Modelle mit bis zu 540 Milliarden Parametern können die Anzahl der Aufgaben und die Modellgröße erheblich steigern. Darüber hinaus analysierte die Studie auch die Auswirkungen der Feinabstimmung auf die Fähigkeit des Modells, Inferenzen durchzuführen, und die Ergebnisse sind sehr attraktiv.

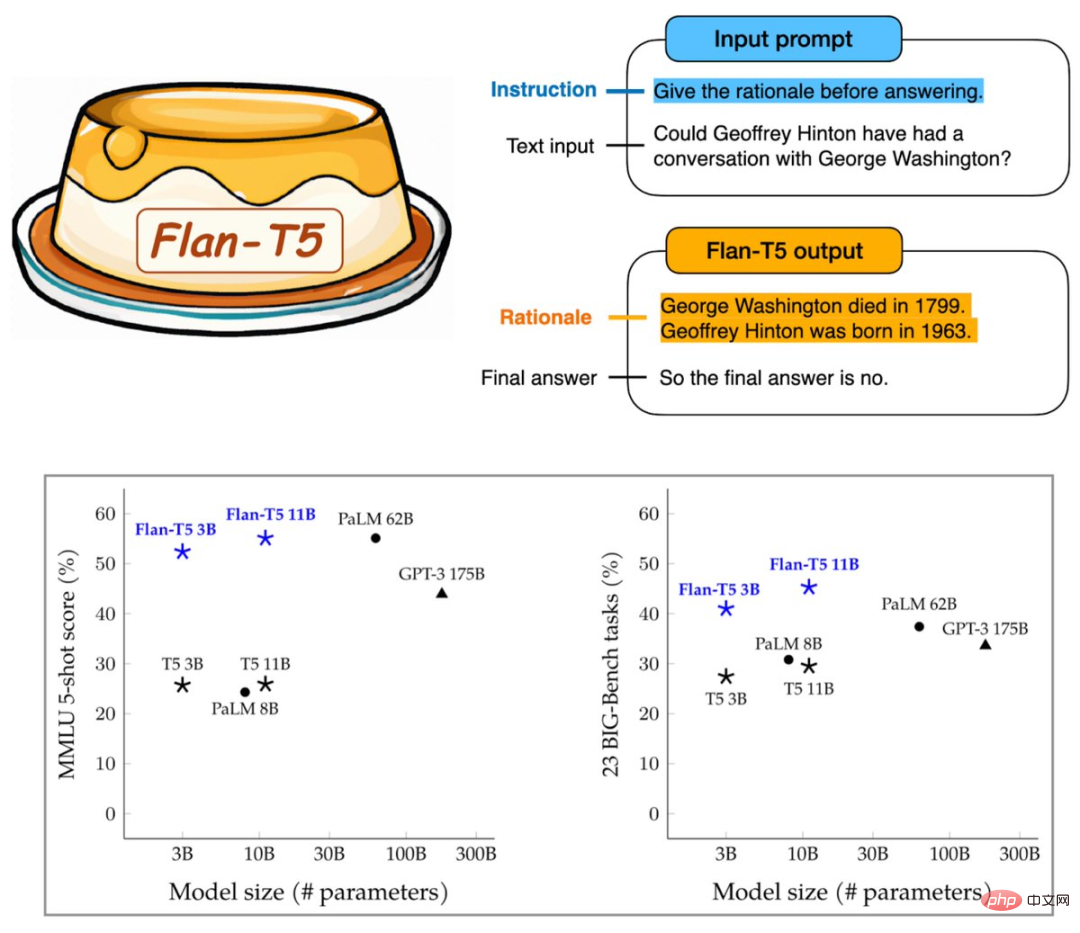

Der resultierende Flan-T5 verfügt über fein abgestimmte Anweisungen für mehr als 1.800 Sprachaufgaben, wodurch die Fähigkeit zum schnellen und mehrstufigen Denken erheblich verbessert wird. Die Ausführung des Benchmarks mit 3 Milliarden Parametern kann die 175 Milliarden Parameter von GPT-3 übertreffen.

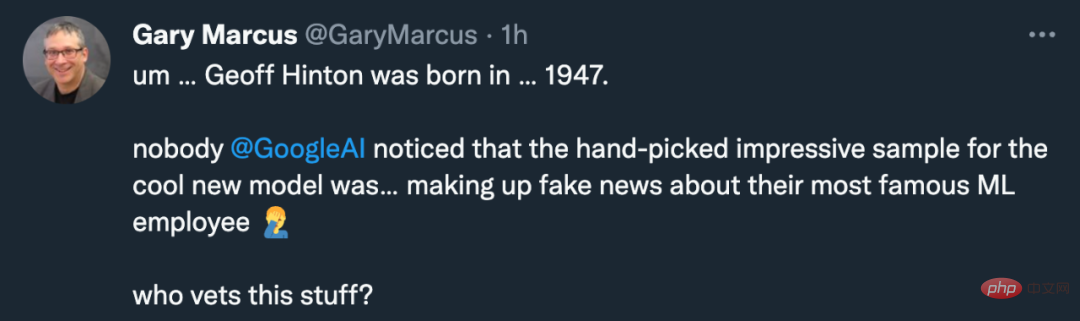

Es scheint, dass Google eine Richtung gefunden hat, um die Fähigkeiten großer Modelle zu verbessern. Diese Forschung stieß jedoch nicht nur auf die Zustimmung der Community für maschinelles Lernen, sondern auch auf die Beschwerden von Gary Marcus:

Warum hat Googles Modell das Geburtsdatum von Googles berühmtem Wissenschaftler Geoffrey Hinton falsch angegeben? Er war offensichtlich ein Oldtimer, Jahrgang 1947.

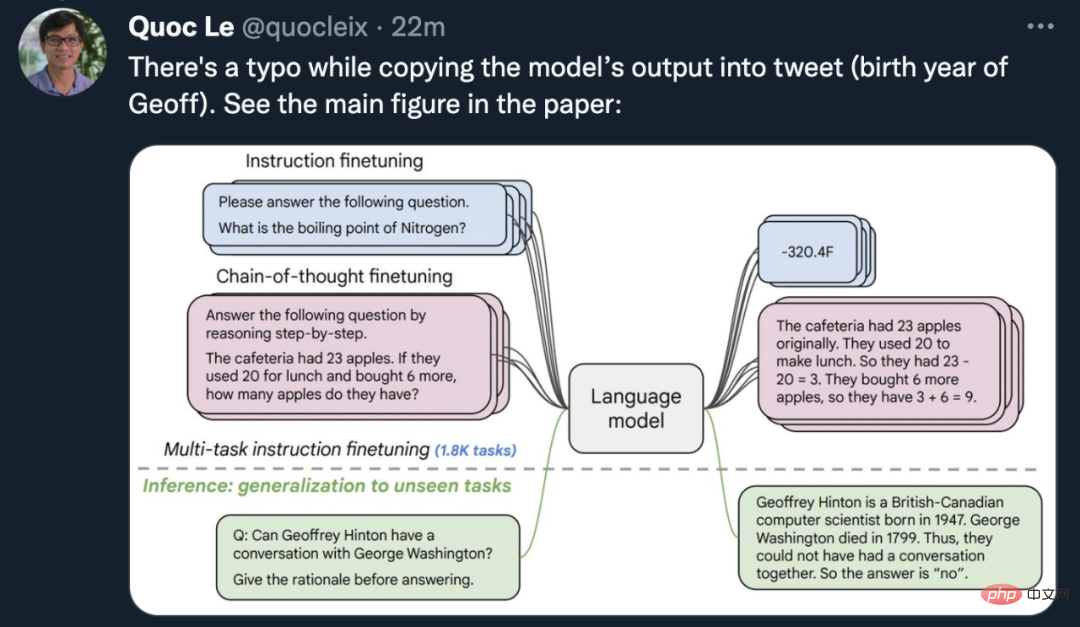

Quoc Le, Chefwissenschaftler von Google Brain und einer der Autoren des Papiers, korrigierte schnell die Situation: Das Bild des Zeitarbeiters war in dem Papier falsch, das Flan-T5-Modell war tatsächlich nicht korrekt Verstehen Sie Geoffs Geburtsjahr falsch. Es gibt ein Bild der Urkunde.

Der berühmte KI-Gelehrte Jahrgang 1963 ist übrigens Jürgen Schmidhuber.

Da es nicht das KI-Modell ist, das falsch ist, wollen wir sehen, welche Änderungen Googles neue Methode an vorab trainierten Modellen bewirken kann.

Papier: Scaling Instruction-Finetuned Language Models

- Papieradresse: https://arxiv.org/abs/2210.11416

- Öffentliches Modell: https ://github.com/google-research/t5x/blob/main/docs/models.md#flan-t5-checkpoints

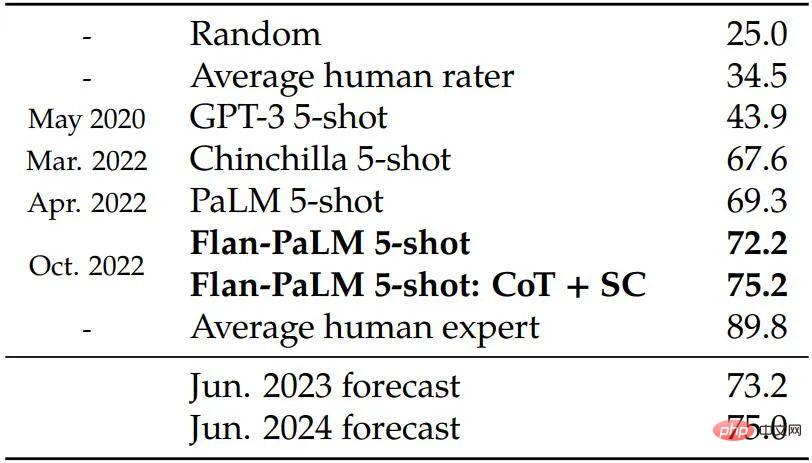

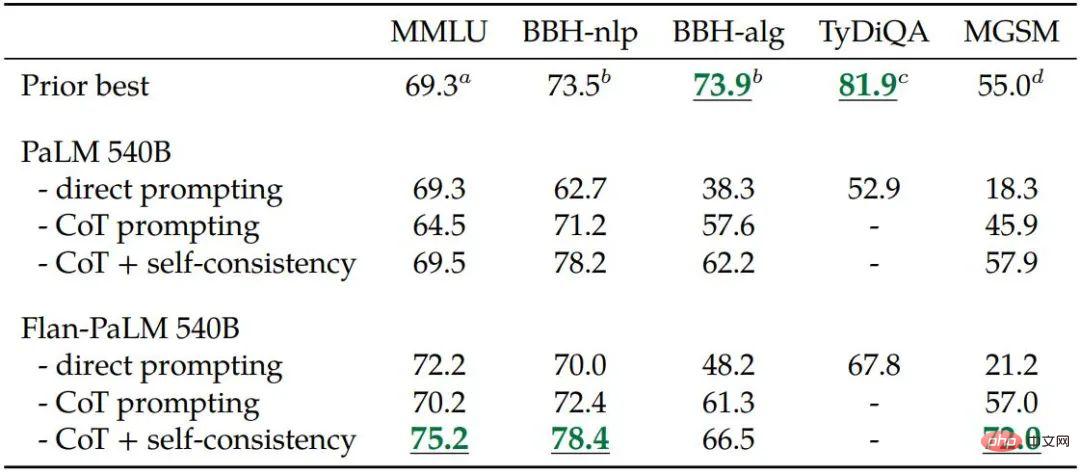

Diese Studie verwendet ein 540B-Parametermodell, um Flan-PaLM zu trainieren, was gut funktioniert -Optimierung der Anzahl der Aufgaben auf über 1800 erhöht und Daten der Gedankenkette (CoT; Wei et al., 2022b) umfasst. Das trainierte Flan-PaLM übertrifft PaLM und erreicht bei mehreren Benchmarks neue SOTA. In Bezug auf die Argumentationsfähigkeiten ist Flan-PaLM in der Lage, CoT und Selbstkonsistenz zu nutzen (Wang et al., 2022c), um eine Genauigkeit von 75,2 % beim umfassenden Sprachverständnis für mehrere Aufgaben zu erreichen (MMLU; Hendrycks et al., 2020). Rate.

Darüber hinaus schneidet Flan-PaLM bei einer Reihe anspruchsvoller generativer Probleme mit offenem Ende deutlich besser ab als PaLM und seine Benutzerfreundlichkeit ist erheblich verbessert.

Insgesamt beleuchtet diese Google-Studie spezifische Möglichkeiten, wie die Feinabstimmung von Anweisungen zur Verbesserung der Modellleistung eingesetzt werden kann.

Methode

Konkret konzentriert sich diese Forschung hauptsächlich auf mehrere Aspekte, die sich auf die Feinabstimmung des Unterrichts auswirken, darunter: (1) Erweiterung der Anzahl der Aufgaben, (2) Erweiterung der Modellgröße und (3) Feinabstimmung der Gedankenkettendaten.

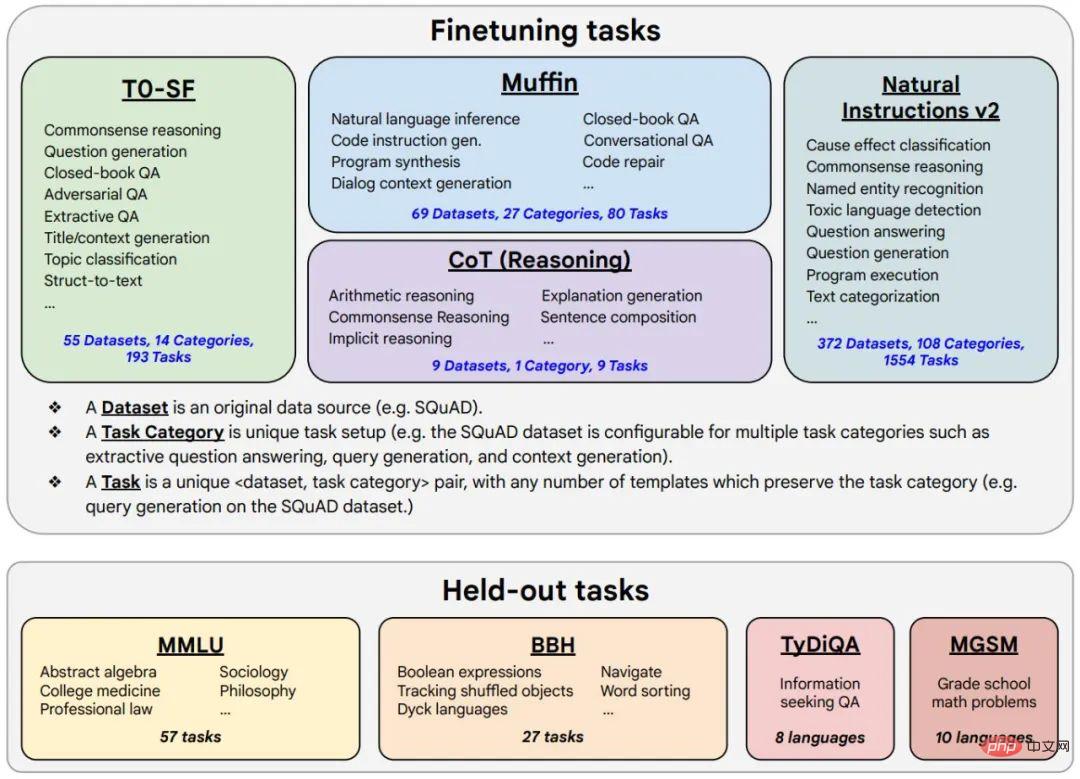

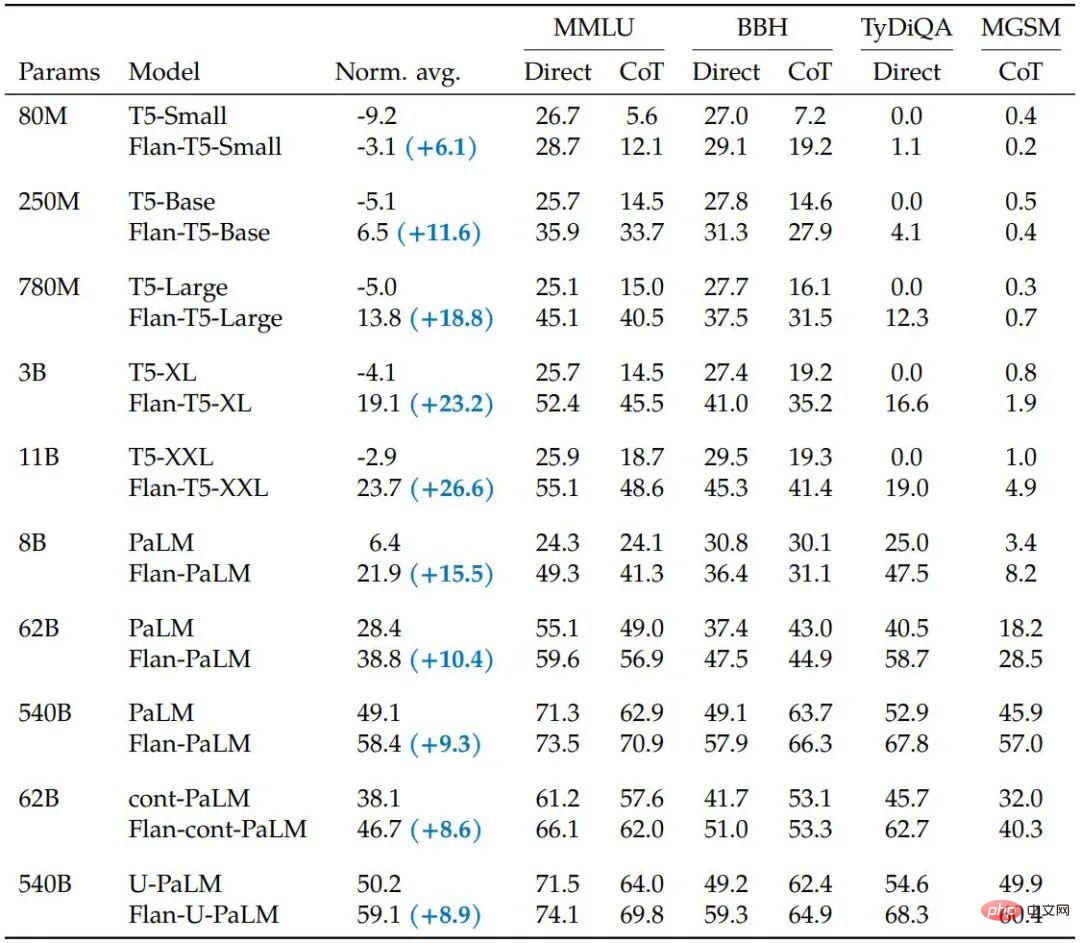

Die Studie ergab, dass die Feinabstimmung der Anweisungen mit den oben genannten Aspekten verschiedene Modellklassen (PaLM, T5, U-PaLM), Eingabeaufforderungseinstellungen (Zero-Shot, Few-Shot, CoT) und Bewertungsbenchmarks (MMLU, BBH, TyDiQA, MGSM, offene Generation). Beispielsweise übertrifft Flan-PaLM 540B mit Befehlsfeinabstimmung PALM 540B bei 1,8K-Aufgaben deutlich (+9,4 % im Durchschnitt). Flan-PaLM 540B erreicht bei mehreren Benchmarks eine Spitzenleistung, beispielsweise 75,2 % bei fünf MMLUs.

Die Forscher enthüllten auch den Flan-T5-Checkpoint, der selbst im Vergleich zu größeren Modellen wie dem PaLM 62B eine starke Leistung bei wenigen Schüssen erzielt. Insgesamt ist die Feinabstimmung von Anweisungen ein allgemeiner Ansatz zur Verbesserung der Leistung und Benutzerfreundlichkeit vorab trainierter Sprachmodelle.

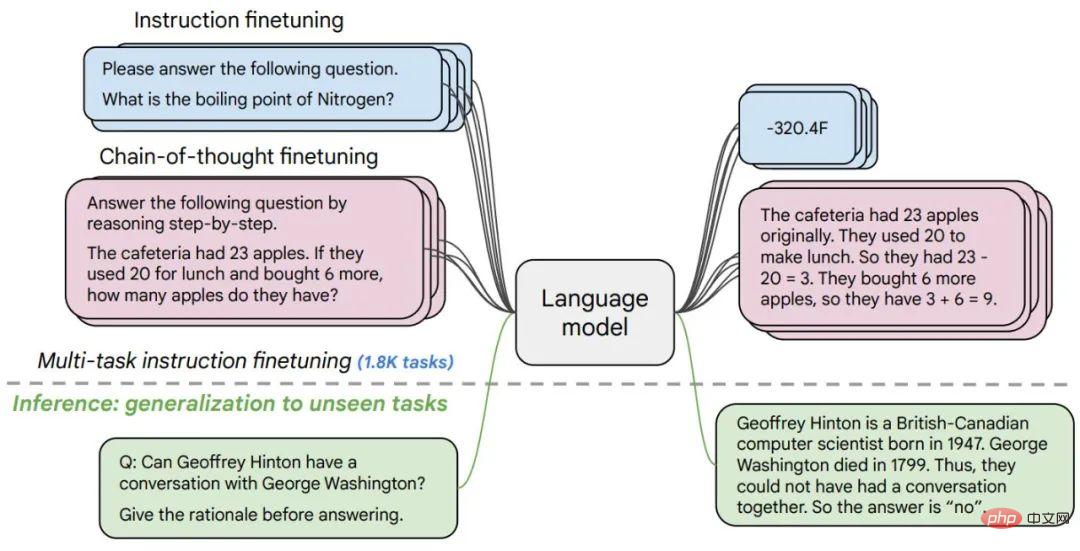

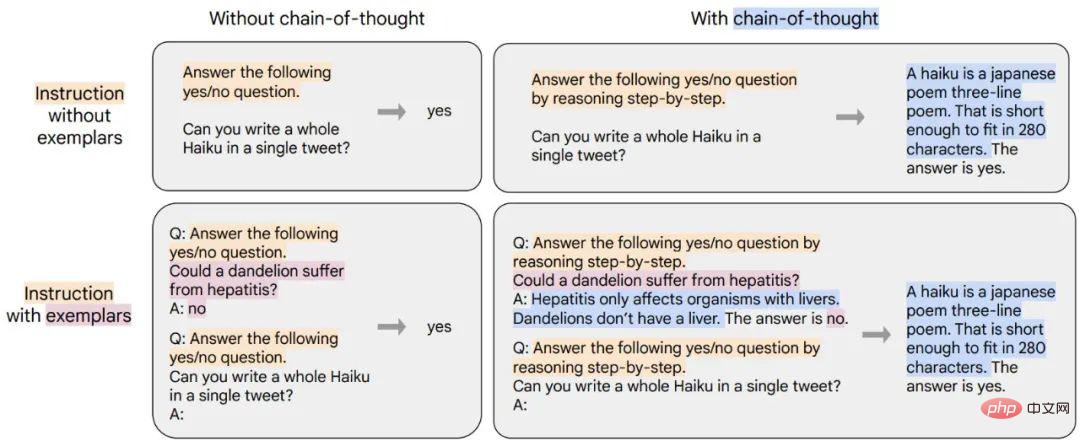

Abbildung 1. Forscher haben verschiedene Sprachmodelle für mehr als 1800 Aufgaben verfeinert, mit/ohne Stichproben (null Stichproben und wenige Stichproben) und mit/ohne Gedankenketten. Die Feinabstimmung ermöglicht die Verallgemeinerung über einen Bereich hinweg von Bewertungsszenarien.

Abbildung 2. Die Feinabstimmungsdaten umfassen 473 Datensätze, 146 Aufgabenkategorien und insgesamt 1836 Aufgaben.

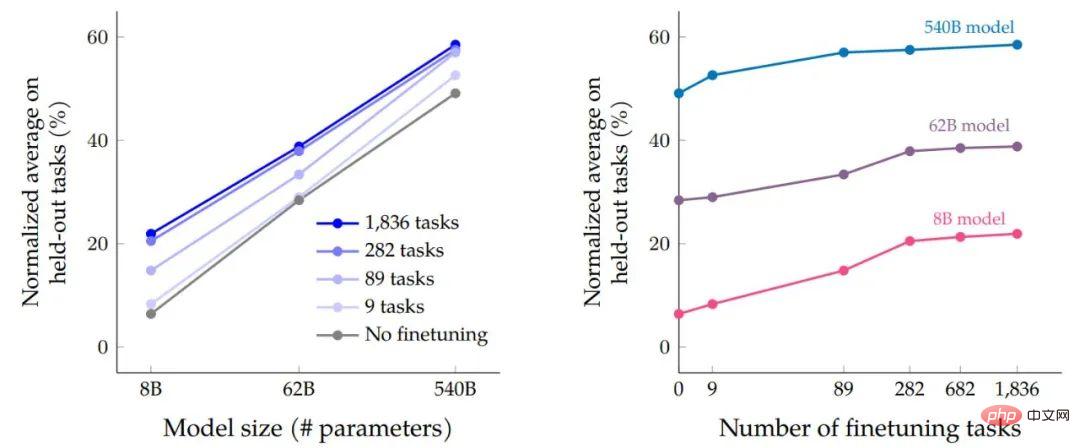

Nach Abschluss der Datenfeinabstimmungs- und Programmfeinabstimmungsprozesse verglichen die Forscher die Auswirkungen der Skalenerweiterung basierend auf der Modellgröße auf die Leistung der Aufgabe. Erstens führt die Feinabstimmung der Multitasking-Anweisungen bei allen drei Modellgrößen zu erheblichen Leistungsverbesserungen im Vergleich zu keiner Feinabstimmung, wobei die Zuwächse zwischen 9,4 % und 15,5 % liegen. Zweitens kann eine Erhöhung der Anzahl der Feinabstimmungsaufgaben die Leistung verbessern.

Schließlich können wir sehen, dass eine Vergrößerung der Modellgröße um eine Größenordnung (8B → 62B oder 62B → 540B) die Leistung sowohl fein abgestimmter als auch nicht fein abgestimmter Modelle erheblich verbessern kann.

Der Einfluss der Feinabstimmung von Multitask-Anweisungen auf die Genauigkeit im Verhältnis zur Modellgröße (Anzahl der Parameter) und die Anzahl und Skalierungserweiterung von Feinabstimmungsaufgaben.

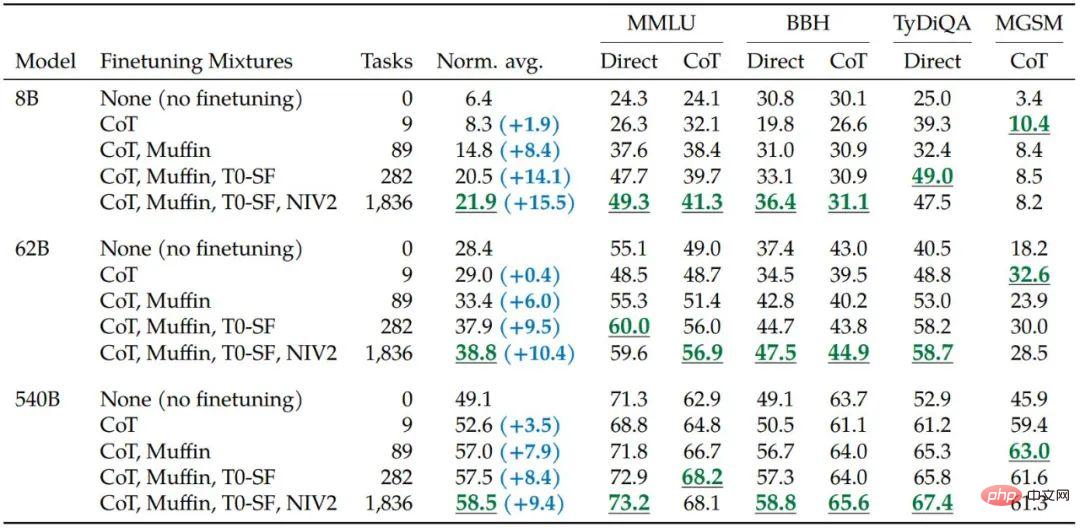

Eine Erhöhung der Anzahl der Aufgaben in den Feinabstimmungsdaten verbessert die Leistung von Flan-PaLM bei den meisten Bewertungsbenchmarks.

Forscher zeigen, dass die Einbeziehung von neun mit Chains of Thoughts (CoT) annotierten Datensätzen in einen Feinabstimmungsmix die Inferenzfähigkeiten verbessert. Die folgende Tabelle zeigt, dass die CoT-Eingabefunktionen von Flan-PaLM PaLM bei den vier beibehaltenen Bewertungsbenchmarks übertreffen.

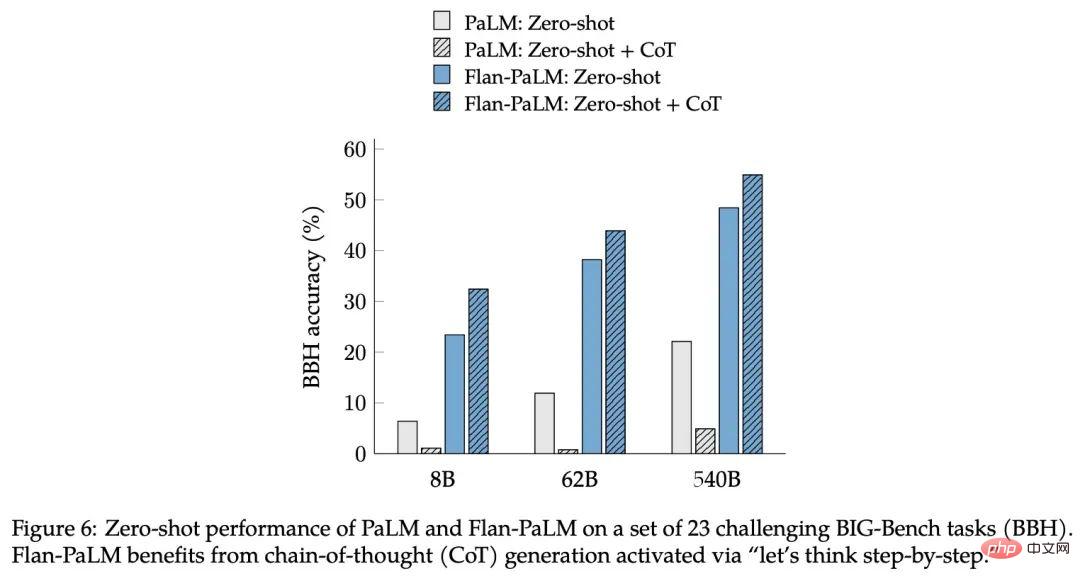

Diese Studie ergab, dass ein weiterer Vorteil der Feinabstimmung von Anweisungen für CoT-Daten darin besteht, dass das Modell selbst Inferenzfunktionen ohne eine kleine Anzahl von Stichproben für CoT generieren kann Es sind viele technische Optimierungen erforderlich, um es richtig zu machen.

Abbildung 6: Zero-Shot-Leistung von PaLM und Flan-PaLM bei einem Satz von 23 anspruchsvollen BIG-Bench-Aufgaben (BBH). Flan-PaLM erfordert die Generierung einer Gedankenkette (CoT), die durch den Befehl „Lass uns Schritt für Schritt denken“ aktiviert wird.

Um die Vielseitigkeit der neuen Methode zu demonstrieren, hat Google T5, PaLM und U-PaLM trainiert, die einen Bereich von Modellgrößen von 80 Millionen bis 540 Milliarden Parametern abdecken, und festgestellt, dass alle Modelle die Leistung erheblich verbessern können .

Tabelle 5. Feinabstimmung der Anweisung (Flan) in anderen kontinuierlichen Vorgängen -Trainingsmethoden Verbesserte Leistung oben.

Nach dem Testen verbesserte die Feinabstimmung der Anweisungen die normalisierte Durchschnittsleistung aller Modelltypen im Vergleich zu nicht feinabgestimmten Modellen erheblich T5-Modelle profitieren am meisten von der Feinabstimmung der Anweisungen. Diese Ergebnisse sind für einige Benchmarks recht stark – Flan-T5-XL erreichte beispielsweise einen MMLU-Score von 47,6 % mit nur 3 Milliarden Parametern und übertraf damit den 43,9 %-Score von GPT-3 mit 175 Milliarden Parametern.

Neben NLP-Benchmarks sind Sprachmodelle auch in der Lage, lange Antworten auf offene Fragen zu generieren. In dieser Hinsicht reichen Standard-NLP-Benchmarks und die zu ihrer Auswertung verwendeten automatisierten Metriken nicht aus, um menschliche Präferenzen zu messen. Die Forscher werteten dies aus und erstellten einen Bewertungssatz von 190 Beispielen. Der Bewertungssatz besteht aus Fragen, die dem Modell in fünf anspruchsvollen Kategorien mit jeweils 20 Fragen im Null-Schuss-Verfahren gestellt werden: Kreativität, kontextbezogenes Denken, komplexes Denken, Planung und Erklärung.

Für 60 dieser Beispiele (aus den Kategorien „Komplexes Denken“, „Planung“ und „Erklärung“) erstellte die Studie einen Text mit einer Denkketten-Triggerphrase (z. B. „Lass Eine Variante von „Lass uns Schritt für Schritt darüber nachdenken“) als weitere Bewertung, ob die Feinabstimmung Zero-Shot auf CoT ermöglicht. Zusätzlich zu den oben erwähnten 160 Null-Schuss-Eingaben umfasste die Studie auch 30 Eingaben, um die Wenig-Schuss-Fähigkeiten zu testen, bei denen starke Sprachmodelle ohne instruktive Feinabstimmung nachweislich eine gute Leistung erbringen.

Forscher glauben, dass sowohl die Feinabstimmung der Anweisungen als auch die Skalenerweiterung die Leistung großer Sprachmodelle kontinuierlich verbessern können, und die Feinabstimmung ist entscheidend für die Denkfähigkeit und kann auch verallgemeinern Modellfähigkeiten. Durch die Kombination der Feinabstimmung von Anweisungen mit anderen Modellanpassungstechniken wie UL2R schlägt Google in dieser Arbeit das stärkste Modell Flan-U-PaLM vor.

Wichtig ist, dass die Feinabstimmung der Anweisungen die Rechenkosten nicht wesentlich erhöht, wie z. B. bei der Erweiterung des Modellmaßstabs. Für die Feinabstimmung der Anweisungen sind beispielsweise nur 0,2 % der Vorgabe erforderlich -Trainingsberechnungen, können aber den normalisierten Durchschnitt aller Bewertungsbenchmarks um 9,4 % verbessern. Kleine Modelle, die direktive Nudges verwenden, können manchmal größere Modelle ohne Nudges übertreffen.

Aus diesen Gründen empfehlen Forscher eine Feinabstimmung des Unterrichts für fast alle vorab trainierten Sprachmodelle.

Das obige ist der detaillierte Inhalt von3 Milliarden übertrafen die 175 Milliarden von GPT-3. Das neue Modell von Google sorgte für hitzige Diskussionen, aber es verstand Hintons Alter.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr