Heim >Technologie-Peripheriegeräte >KI >Wie man das „gesunde Menschenverstand'-Problem der künstlichen Intelligenz löst

Wie man das „gesunde Menschenverstand'-Problem der künstlichen Intelligenz löst

- PHPznach vorne

- 2023-04-14 11:19:021539Durchsuche

Übersetzer |. Li Rui

Rezensent |.In den letzten Jahren hat Deep Learning in einigen der anspruchsvollsten Bereiche der künstlichen Intelligenz große Fortschritte gemacht, darunter Computer Vision, Spracherkennung und Verarbeitung natürlicher Sprache.

Allerdings haben Deep-Learning-Systeme einige Probleme immer noch nicht gelöst. Da Deep-Learning-Systeme nicht gut im Umgang mit neuen Situationen sind, benötigen sie zum Trainieren große Datenmengen und machen manchmal bizarre Fehler, die selbst ihre Entwickler verwirren.

Allerdings haben Deep-Learning-Systeme einige Probleme immer noch nicht gelöst. Da Deep-Learning-Systeme nicht gut im Umgang mit neuen Situationen sind, benötigen sie zum Trainieren große Datenmengen und machen manchmal bizarre Fehler, die selbst ihre Entwickler verwirren.

Einige Wissenschaftler glauben, dass diese Probleme gelöst werden können, indem immer größere neuronale Netze geschaffen und auf immer größeren Datensätzen trainiert werden. Manche Leute glauben auch, dass der Bereich der künstlichen Intelligenz etwas „gesunden Menschenverstand“ von Seiten der Menschen braucht.

In ihrem neuen Buch „Machines Like Us“ äußern die Informatiker Ronald J. Brachman und Hector J. Levesque ihre Gedanken und mögliche Lösungen zu diesem fehlenden Teil des Puzzles der künstlichen Intelligenz, dem „gesunden Menschenverstand“. Ein Problem, das Forschern Rätsel aufgibt seit Jahrzehnten. In einem Interview mit Branchenmedien diskutierte Brachman, was gesunder Menschenverstand ist und was nicht, warum Maschinen keinen gesunden Menschenverstand haben und wie das Konzept der „Wissensrepräsentation“ die Gemeinschaft der künstlichen Intelligenz in die richtige Richtung führen kann. Das Konzept der „Wissensrepräsentation“ gibt es schon seit Jahrzehnten, wurde aber während des Deep-Learning-Trends auf Eis gelegt.

Obwohl das Buch „Machines Like Us“ immer noch im Bereich der Hypothesen steckt, bietet es eine neue Perspektive auf potenzielle Forschungsbereiche, dank zweier Personen, die sich seit den 1970er-Jahren intensiv mit künstlicher Intelligenz beschäftigen.

Gute KI-Systeme machen seltsame Fehler

Brachman sagte: „In den letzten 10 bis 12 Jahren, als die Menschen eine außergewöhnliche Begeisterung für Deep Learning zeigten, wurde viel über Deep-Learning-basierte Systeme geforscht, die das können, was wir können.“ Ursprünglich hoffte man, dass künstliche Intelligenz es schaffen würde unter bestimmten Umständen wenig oder gar kein menschliches Eingreifen.

Brachman sagte: „Heutzutage sind viele Menschen davon begeistert, was Deep Learning bewirken kann, und der Umfang der Forschung ist stark eingeschränkt. Vor allem im industriellen Bereich wurde die erfahrungsbasierte Forschung durch große Mittel und die Rekrutierung von Talenten gefördert.“ oder an Beispielen geschult. Da den Systemen so viel Aufmerksamkeit geschenkt wird, dass viele behaupten, sie seien der allgemeinen künstlichen Intelligenz oder der „guten altmodischen künstlichen Intelligenz“ (GOFAI) nahe, oder symbolische Ansätze seien völlig veraltet oder unnötig.“

Das ist offensichtlich Obwohl beeindruckend, stehen Deep-Learning-Systeme vor rätselhaften Problemen, die noch gelöst werden müssen. Neuronale Netze sind anfällig für gegnerische Angriffe, bei denen speziell gestaltete Änderungen an Eingabewerten dazu führen, dass das Modell des maschinellen Lernens plötzliche, fehlerhafte Änderungen an seinen Ausgaben vornimmt. Deep Learning hat auch Schwierigkeiten, einfache Ursache-Wirkungs-Beziehungen zu verstehen, und ist schlecht darin, Konzepte zu konzipieren und sie zusammenzusetzen. Große Sprachmodelle waren in letzter Zeit ein Bereich von besonderem Interesse, machen aber manchmal sehr dumme Fehler bei der Generierung kohärenter und eindrucksvoller Texte.

Brachman sagte: „Die Menschen nehmen diese Fehler, die durch künstliche Intelligenz gemacht werden, so wahr, dass sie dumm und unwissend aussehen, und Menschen machen solche Fehler selten. Aber das Wichtigste ist, dass die Gründe für diese Fehler etwas schwer zu erklären sind.“ Diese Fehler veranlassten Brachman und Levesque dazu, darüber nachzudenken, was der heutigen KI-Technologie fehlt und was erforderlich ist, um beispielgesteuerte Trainingssysteme für neuronale Netzwerke zu ergänzen oder zu ersetzen.

Brachman sagte: „Wenn Sie darüber nachdenken, fehlt diesen Systemen eindeutig das, was Menschen gesunden Menschenverstand nennen, also die Fähigkeit, Dinge zu sehen, die für viele Menschen offensichtlich sind, und schnell zu einfachen und offensichtlichen Schlussfolgerungen zu gelangen.“ in der Lage, Entscheidungen zu treffen, wenn Sie sich davon abhalten, etwas zu tun, von dem Sie sofort erkennen, dass es lächerlich oder die falsche Wahl ist.“

Was ist gesunder Menschenverstand?

Die KI-Community spricht seit ihren Anfängen über gesunden Menschenverstand. Tatsächlich trug einer der frühesten Artikel über künstliche Intelligenz von John McCarthy aus dem Jahr 1958 den Titel „Programme mit gesundem Menschenverstand“.

Brachman sagte: „Das ist nichts Neues und es ist kein Name, den wir erfunden haben, aber das Fachgebiet hat die Kernbedeutung dessen, was die Pioniere der künstlichen Intelligenz gesagt haben, aus den Augen verloren, wenn wir besser verstehen, was gesunder Menschenverstand ist und was er bedeutet.“ Um es zu haben, wird es für uns von Nutzen sein. Noch wichtiger ist, wie es funktioniert und wie es umgesetzt werden würde. In dem Buch „Machines Like Us“ greifen Brachman und Levesque auf den gesunden Menschenverstand zurück. Beschrieben als „die Fähigkeit, gewöhnliches, alltägliches Erfahrungswissen effektiv zu nutzen, um gewöhnliche, routinemäßige, praktische Ziele zu erreichen.“

Der gesunde Menschenverstand ist überlebenswichtig. Menschen und höhere Tiere haben sich so entwickelt, dass sie durch Erfahrung lernen und Routine- und Autopilotfähigkeiten entwickeln, mit denen sie die meisten Situationen, mit denen sie täglich konfrontiert werden, meistern können. Aber das tägliche Leben ist mehr als nur die Routine, die Menschen immer wieder sehen. Menschen werden oft mit neuen Situationen konfrontiert, die sie noch nie zuvor gesehen haben. Manche davon unterscheiden sich vielleicht stark vom Normalzustand, aber meistens sehen die Menschen die Dinge etwas anders, als sie es gewohnt sind. In KI-Diskussionen wird dies manchmal als „Long Tail“ bezeichnet.

Brachman sagte: „Wenn diese Routinen unterbrochen werden, wird unserer Meinung nach als Erstes der gesunde Menschenverstand aktiviert, der es den Menschen ermöglicht, neue Situationen schnell zu verstehen, sich an das zu erinnern, was sie zuvor getan haben, und ihr Gedächtnis schnell anzupassen und es darauf anzuwenden.“

In gewisser Weise unterscheidet sich der gesunde Menschenverstand etwas von dem vom Psychologen und Nobelpreisträger Daniel Kahneman populären Denkparadigma des dualen Systems. Der gesunde Menschenverstand ist nicht das schnelle Autopilot-System-1-Denken, das die meisten alltäglichen Aufgaben erledigt, die Menschen ohne besondere Konzentration erledigen können (z. B. Zähne putzen, Schuhe binden, Knöpfe zuknöpfen, in einem vertrauten Bereich fahren). Es erfordert positives Denken, um aus der aktuellen Routine auszubrechen.

Gleichzeitig ist gesunder Menschenverstand kein System-2-Denken. System-2-Denken ist ein langsamer Denkmodus, der volle Konzentration und schrittweises Denken erfordert (zum Beispiel die Planung einer sechswöchigen Reise, das Entwerfen von Software, das Lösen komplexer Probleme). mathematische Gleichungen).

Brachman sagt: „Diese Art des Denkens ermüdet das Gehirn und macht es langsam.“ darüber, was als nächstes zu tun ist.“

In ihrer veröffentlichten Arbeit betonen Brachman und Levesque, dass der gesunde Menschenverstand ein „oberflächliches kognitives Phänomen“ ist, das schneller funktioniert als eine durchdachte, methodische Analyse.

„Wenn es viel Nachdenken erfordert, um es herauszufinden, ist das kein gesunder Menschenverstand. Wir können es uns als ‚reflexives Denken‘ vorstellen, und ‚reflexiv‘ ist genauso wichtig wie ‚Denken‘“,

KI ohne Common Sinn Die Gefahren, denen man ausgesetzt ist

Gesunder Menschenverstand erfordert Vorhersehbarkeit, Vertrauen, Erklärbarkeit und Verantwortlichkeit.

Brachman sagte: „Die meisten Menschen machen keine seltsamen Fehler. Obwohl Menschen einige dumme Dinge tun, können sie solche Fehler nach Überlegung vermeiden. Obwohl Menschen nicht perfekt sind, werden einige Fehler bis zu einem gewissen Grad gemacht. Die Herausforderung mit KI.“ Systeme ohne gesunden Menschenverstand können Fehler machen, wenn sie an die Grenzen ihrer Ausbildung stoßen. Brachman sagte, die Fehler seien völlig unvorhersehbar und unerklärlich gewesen.

Brachman sagte: „KI-Systeme ohne gesunden Menschenverstand haben diese Perspektive nicht, keinen Ausweg, der sie davon abhält, seltsame Dinge zu tun, und sie werden zerbrechlich. Wenn sie Fehler machen, bedeuten ihnen die Fehler überhaupt nichts.“ Diese Fehler können harmlos sein, wie z. B. die falsche Beschriftung eines Bildes, bis hin zu äußerst schädlichen Fehlern, wie z. B. wenn ein selbstfahrendes Auto auf die falsche Spur fährt.

Brachman und Levesque schreiben in dem Buch: „Wenn das Problem, auf das ein KI-System stößt, darin besteht, Schach zu spielen, und es ihm darum geht, das Spiel zu gewinnen, dann kommt für sie der gesunde Menschenverstand nicht ins Spiel, und wenn Menschen Schach spielen, ist das üblich.“ Der gesunde Menschenverstand wird ins Spiel kommen.“ In diesen Bereichen passiert immer etwas Neues und Spannendes.

Brachman und Levesque schreiben in ihrem Buch Machines Like Us: „Wenn wir wollen, dass Systeme der künstlichen Intelligenz in der Lage sind, mit alltäglichen Vorkommnissen in der realen Welt vernünftig umzugehen, müssen wir mehr tun, als nur zu verstehen, was bereits passiert ist.“ Die Vorhersage der Zukunft allein auf der Grundlage des Sehens und Verinnerlichens dessen, was in der Vergangenheit passiert ist, wird nicht funktionieren. Allerdings gibt es oft Uneinigkeit, wenn es um Lösungen geht. Ein beliebter Trend besteht weiterhin darin, neuronale Netze immer größer zu machen. Es gibt Hinweise darauf, dass größere neuronale Netze weiterhin schrittweise Verbesserungen erzielen. In einigen Fällen weisen große neuronale Netze Zero-Shot-Lernfähigkeiten auf und führen Aufgaben aus, für die sie nicht trainiert wurden.

Allerdings gibt es auch viele Studien und Experimente, die zeigen, dass mehr Daten und Berechnungen das Problem künstlicher Intelligenzsysteme ohne gesunden Menschenverstand nicht lösen, sondern sie nur in größeren und verwirrenderen numerischen Gewichten und Matrixoperationen verbergen.

Brachman sagte: „Diese Systeme bemerken und verinnerlichen Korrelationen oder Muster. Sie bilden keine ‚Konzepte‘. Selbst wenn diese Systeme mit der Sprache interagieren, ahmen sie einfach menschliches Verhalten nach, ohne die zugrunde liegende Psychologie und Konzepte, von denen die Menschen glauben, dass sie einen Mechanismus besitzen.“

Brachman und Levesque befürworten die Schaffung eines Systems, das gesundes Menschenverstandswissen und ein vernünftiges Verständnis der Welt kodiert.

Sie schreiben in dem Buch: „Beim gesunden Menschenverstand geht es um Dinge in der Welt und die Eigenschaften, die sie haben, vermittelt durch das, was wir konzeptionelle Strukturen nennen. Es geht um die verschiedenen Dinge, die existieren können, und die verschiedenen Eigenschaften, die sie haben können.“ Das Wissen wird durch symbolische Darstellungen und die Durchführung rechnerischer Operationen an diesen symbolischen Strukturen genutzt. Es kommt darauf hinaus, dass dieses repräsentative Wissen genutzt wird, um zu überlegen, wie man auf beobachtete Situationen reagiert.

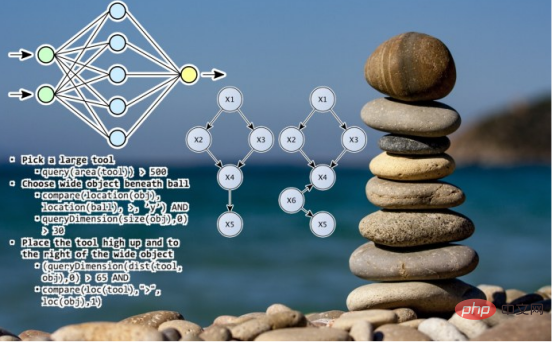

Brachman und Levesque glauben, dass das Fachgebiet zurückblicken und einige seiner früheren Arbeiten zur symbolischen künstlichen Intelligenz überdenken muss, um Computern gesunden Menschenverstand zu verleihen. Sie nennen dies die „Wissensrepräsentations“-Hypothese. In diesem Buch wird detailliert beschrieben, wie man Systeme zur Wissensrepräsentation (Knowledge Representation, KR) aufbaut und wie man verschiedene Wissensteile kombiniert, um komplexere Wissens- und Argumentationsformen zu bilden.

Gemäß der Knowledge Representation (KR)-Hypothese wird die Darstellung von Common Sense-Wissen in zwei Teile unterteilt: „Der eine ist ein Weltmodell, das den Zustand der Welt darstellt, und der andere ist ein konzeptionelles Modell, das das Konzeptuelle darstellt.“ Struktur, und dies ist ein Modell, das verwendet werden kann, um die Welt darzustellen.“ und Symbolmanipulationsprogramme (was die Leute früher Inferenzmaschinen nannten) können codiert und verwendet werden. Das grundlegende Wissen über die Welt, das die Leute gesunden Menschenverstand nennen: intuitive oder naive Physik, ein grundlegendes Verständnis dafür, wie sich Menschen und andere Agenten verhalten und Absichten haben Überzeugungen, wie Zeit und Ereignisse funktionieren, Ursache und Wirkung usw. Das ist es, was wir am Anfang lernen. Das formal dargestellte Wissen über die Welt kann tatsächlich einen kausalen Einfluss auf das Verhalten der Maschine haben. und auch all die Dinge wie Kompositionalität tun und bekannte Dinge auf neue Weise präsentieren.“

Brachman betonte, dass die Annahmen, die sie in dem Buch vorbringen, in Zukunft widerlegt werden können.

Brachman sagte: „Auf lange Sicht weiß ich nicht, ob es darum geht, all dieses Wissen vorab aufzubauen, vorzucodieren oder das KI-System auf andere Weise lernen zu lassen Experiment, ich denke, der nächste Schritt für KI. Ein erster Schritt sollte darin bestehen, zu versuchen, diese Wissensbasen aufzubauen und das System damit zu veranlassen, mit den unerwarteten Ereignissen des täglichen Lebens umzugehen und grobe Vermutungen darüber anzustellen, wie mit vertrauten und unbekannten Situationen umzugehen ist.

Die Hypothese von Brachman und Levesque baut auf früheren Bemühungen auf, groß angelegte Systeme wie Cyc zu schaffen. Das Projekt reicht bis in die 1980er Jahre zurück und hat Millionen von Regeln und Konzepten über die Welt gesammelt.

Brachman sagte: „Ich denke, wir müssen uns darauf konzentrieren, wie autonome Entscheidungsmaschinen diese Dinge in alltäglichen Entscheidungskontexten nutzen. Es ist eine Sache, Faktenwissen zu sammeln und in der Lage zu sein, auf gefährliche Arten zu antworten.“ von Fragen; aber in dieser lauten Welt zu arbeiten und auf unvorhergesehene Überraschungen rational und schnell reagieren zu können, ist eine ganz andere Sache. „

Spielt maschinelles Lernen eine Rolle? Brachman sagte, dass auf maschinellem Lernen basierende Systeme weiterhin eine Schlüsselrolle bei der Wahrnehmung künstlicher Intelligenz spielen werden.

Er sagte: „Ich würde nicht darauf drängen, Prädikatenrechnungen erster Ordnung zur Verarbeitung von Pixeln auf einer künstlichen Netzhaut oder symbolische Betriebssysteme zur Verarbeitung von Geschwindigkeitssignalen zu verwenden. Diese maschinellen Lernsysteme eignen sich sehr gut für Erkennungsaufgaben auf niedriger sensorischer Ebene.“ , die noch nicht verstanden werden Wie hoch die Dinge in der kognitiven Kette stehen, aber sie schaffen es nicht bis zum Ende, weil sie keine Konzepte und Verbindungen zwischen dem, was die Menschen in der Szene sehen, und der natürlichen Sprache herstellen.

Neuronale Netze und Symbolsysteme sind eine Idee, die in den letzten Jahren immer mehr an Bedeutung gewonnen hat. Gary Marcus, Luis Lamb und Joshua Tenenbaum schlagen unter anderem die Entwicklung „neurosymbolischer“ Systeme vor, die das Beste aus symbolischen und lernbasierten Systemen kombinieren würden, um aktuelle Herausforderungen in der künstlichen Intelligenz anzugehen.

, von Ben Dickson

Das obige ist der detaillierte Inhalt vonWie man das „gesunde Menschenverstand'-Problem der künstlichen Intelligenz löst. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr