Heim >Technologie-Peripheriegeräte >KI >Ist ChatGPT wirklich ein „Generalist'? Yang Di und andere haben es einem gründlichen Test unterzogen.

Ist ChatGPT wirklich ein „Generalist'? Yang Di und andere haben es einem gründlichen Test unterzogen.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-13 21:25:01955Durchsuche

Link zum Papier: https://arxiv.org/pdf/2302.06476.pdf

Große Sprachmodelle (LLM) sind nachweislich in der Lage, verschiedene natürliche Sprachverarbeitung (NLP) zu lösen. Aufgaben, und für eine bestimmte nachgelagerte Aufgabe sind sie nicht auf Trainingsdaten angewiesen, und die Modellanpassung kann mithilfe geeigneter Eingabeaufforderungen erreicht werden. Diese Fähigkeit, auf Befehl neue Aufgaben auszuführen, kann als wichtiger Schritt hin zur allgemeinen künstlichen Intelligenz angesehen werden.

Obwohl das aktuelle LLM in einigen Fällen eine gute Leistung erzielt, ist es beim Zero-Shot-Lernen immer noch anfällig für verschiedene Fehler. Darüber hinaus kann das Format der Eingabeaufforderung erhebliche Auswirkungen haben. Durch das Hinzufügen von „Lasst uns Schritt für Schritt denken“ zur Eingabeaufforderung hinzugefügt werden, kann die Modellleistung deutlich verbessert werden. Diese Einschränkungen verdeutlichen, dass aktuelle LLMs keine wirklich universellen Sprachsysteme sind.

Kürzlich hat das von OpenAI veröffentlichte ChatGPT LLM große Aufmerksamkeit in der NLP-Community erregt. ChatGPT wurde durch das Training des Modells der GPT-3.5-Serie durch „Reinforcement Learning with Human Feedback (RLHF)“ erstellt. RLHF besteht im Wesentlichen aus drei Schritten: Verwendung von überwachtem Lernen zum Trainieren eines Sprachmodells; Sammeln von Vergleichsdaten und Trainieren eines Belohnungsmodells basierend auf menschlichen Präferenzen und Verwenden von Verstärkungslernen zum Optimieren des Sprachmodells für das Belohnungsmodell; Beim RLHF-Training wurde beobachtet, dass ChatGPT in verschiedenen Aspekten über beeindruckende Fähigkeiten verfügt, darunter die Generierung hochwertiger Antworten auf menschliche Eingaben, das Zurückweisen unangemessener Fragen und die Selbstkorrektur früherer Fehler auf der Grundlage nachfolgender Gespräche.

Obwohl ChatGPT starke Konversationsfähigkeiten aufweist, ist sich die NLP-Community immer noch unklar, ob ChatGPT im Vergleich zu bestehenden LLMs bessere Zero-Shot-Generalisierungsfähigkeiten erreicht. Um diese Forschungslücke zu schließen, untersuchten die Forscher systematisch die Zero-Shot-Lernfähigkeiten von ChatGPT, indem sie sie anhand einer großen Anzahl von NLP-Datensätzen auswerteten, die sieben repräsentative Aufgabenkategorien abdeckten. Zu diesen Aufgaben gehören Argumentation, Rückschluss auf natürliche Sprache, Beantwortung von Fragen (Leseverständnis), Dialog, Zusammenfassung, Erkennung benannter Entitäten und Stimmungsanalyse. Mithilfe umfangreicher Experimente wollten die Forscher die folgenden Fragen beantworten:

- Ist ChatGPT ein Allzwecklöser für NLP-Aufgaben? Bei welchen Arten von Aufgaben schneidet ChatGPT gut ab?

- Wenn ChatGPT bei einigen Aufgaben hinter anderen Modellen zurückbleibt, warum?

Um diese Fragen zu beantworten, verglichen die Autoren die Leistung von ChatGPT und dem hochmodernen GPT-3.5-Modell (text-davinci-003) basierend auf experimentellen Ergebnissen. Darüber hinaus berichten sie über Null-Schuss-, Feinabstimmungs- oder Wenig-Schuss-Feinabstimmungsergebnisse neuerer Arbeiten wie FLAN, T0 und PaLM.

Hauptschlussfolgerungen

Die Autoren erklärten, dass dies ihres Wissens nach das erste Mal sei, dass jemand die Zero-Shot-Fähigkeiten von ChatGPT bei verschiedenen NLP-Aufgaben untersucht habe, mit dem Ziel, einen vorläufigen Überblick über ChatGPT zu geben. . Ihre wichtigsten Erkenntnisse lauten wie folgt:

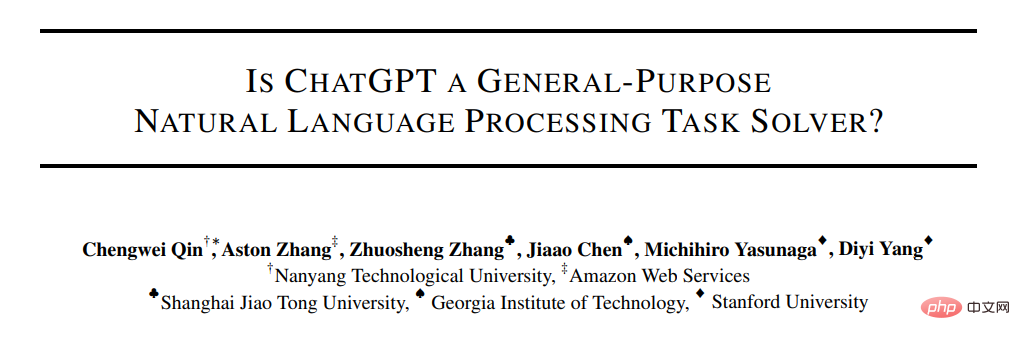

- Während ChatGPT als generalistisches Modell eine gewisse Fähigkeit zeigt, mehrere Aufgaben auszuführen, schneidet es im Allgemeinen schlechter ab als Modelle, die für eine bestimmte Aufgabe fein abgestimmt sind (siehe Abbildung 1 und Abschnitt 4.3).

- Die überlegene Denkfähigkeit von ChatGPT wurde experimentell in arithmetischen Denkaufgaben bestätigt (Abschnitt 4.2.1). Allerdings schneidet ChatGPT bei Aufgaben des gesunden Menschenverstands, des symbolischen und logischen Denkens im Allgemeinen schlechter ab als GPT-3.5, was sich beispielsweise daran zeigt, dass unsichere Antworten generiert werden (Abschnitt 4.2.2).

- ChatGPT übertrifft GPT-3.5 bei Inferenzaufgaben in natürlicher Sprache (Abschnitt 4.2.3) und Fragen-Antwort-Aufgaben (Leseverständnis) (Abschnitt 4.2.4), die Argumentationsfähigkeiten fördern, wie z. B. die Bestimmung der Logik in Textpaarbeziehungen. Insbesondere ist ChatGPT besser darin, Text zu verarbeiten, der mit Fakten übereinstimmt (d. h. Implikationen besser klassifizieren als Nichtimplikationen).

- ChatGPT übertrifft GPT-3.5 bei Konversationsaufgaben (Abschnitt 4.2.5).

- In Bezug auf Zusammenfassungsaufgaben generiert ChatGPT längere Zusammenfassungen und schneidet schlechter ab als GPT-3.5. Allerdings beeinträchtigt die explizite Begrenzung der Digest-Länge in Zero-Shot-Anweisungen die Digest-Qualität, was zu einer verringerten Leistung führt (Abschnitt 4.2.6).

- Während sie als generalistische Modelle vielversprechend sind, stehen sowohl ChatGPT als auch GPT-3.5 bei bestimmten Aufgaben vor Herausforderungen, wie etwa der Sequenzannotation (Abschnitt 4.2.7).

- Die Stimmungsanalysefunktion von ChatGPT kommt GPT-3.5 nahe (Abschnitt 4.2.8).

Methode

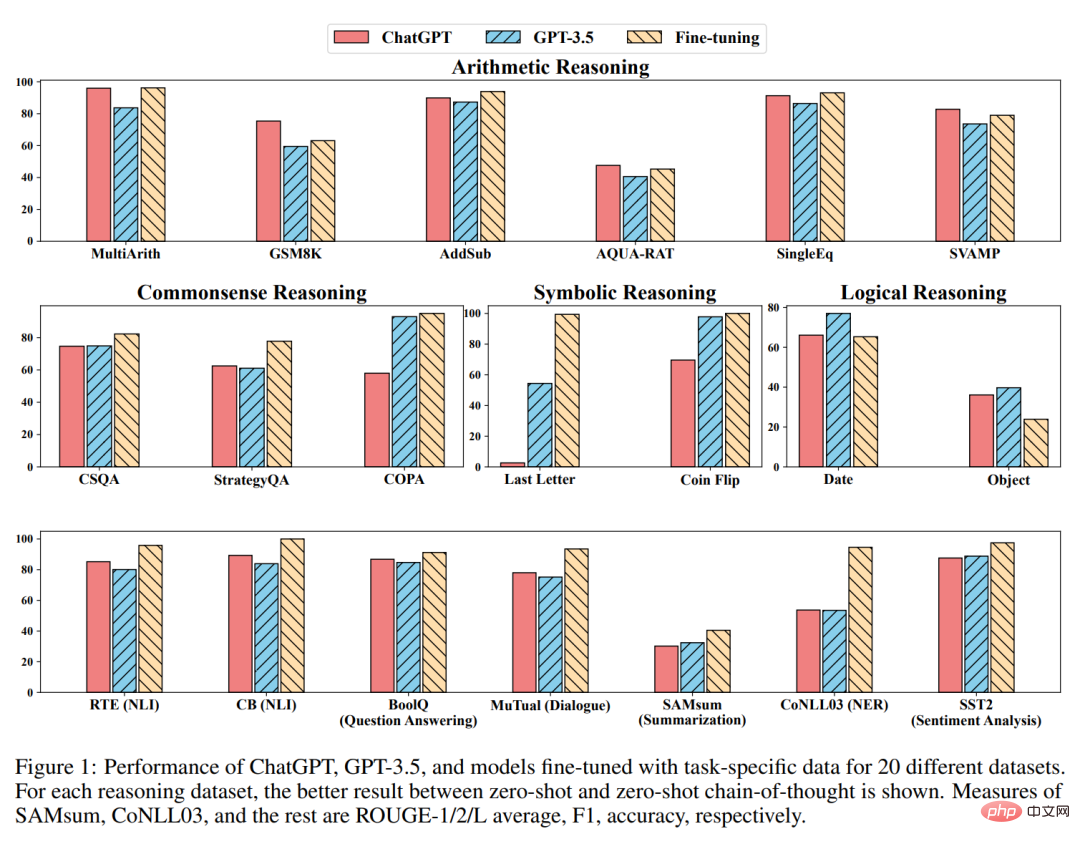

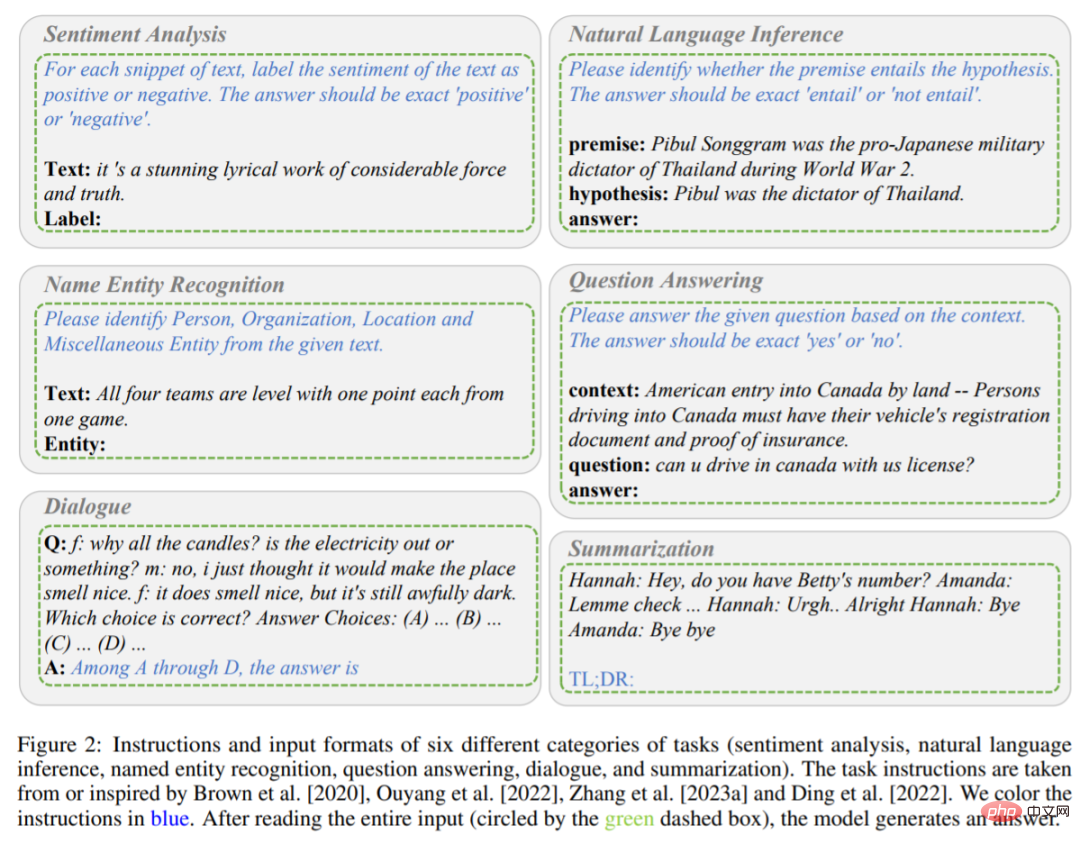

Wie oben erwähnt, vergleicht diese Studie hauptsächlich die Zero-Shot-Lernleistung von ChatGPT und GPT-3.5 (textdavinci-003) unter verschiedenen Aufgaben. Konkret nehmen sie Aufgabenanweisungen P und Testfragen X als Eingaben, stellen das Modell durch f dar und generieren dann den Zieltext Y = f (P, X), um die Testfragen zu lösen. Die Anweisungen und Eingabeformate für verschiedene Aufgaben sind in den Abbildungen 2 und 3 dargestellt.

Enthält Anweisungen und Eingabeformate für sechs Aufgaben (Stimmungsanalyse, Argumentation in natürlicher Sprache, Erkennung benannter Entitäten, Beantwortung von Fragen, Dialog und Zusammenfassung). Die Anweisungen sind in blauer Schrift.

Beschreibung der Inferenzaufgabe.

Wenn das Modell beispielsweise eine Stimmungsanalyseaufgabe ausführt, markiert die Aufgabenanweisung P die im Text enthaltene Stimmung als positiv oder negativ, und die Ausgabeantwort ist positiv oder negativ. Wenn das Modell die Anweisung P und den Eingabeinhalt

Im Gegensatz zu der oben erwähnten einstufigen Aufforderungsmethode verwendet diese Studie eine zweistufige Aufforderung (vorgeschlagen von Kojima et al.), um den Zero-Shot-CoT abzuschließen.

Die erste Stufe übernimmt „Lasst uns Schritt für Schritt denken“ und die Anweisung P_1 induziert das Grundprinzip R der Modellgenerierung.

Die zweite Stufe verwendet das im ersten Schritt generierte Grundprinzip R sowie die ursprüngliche Eingabe X und die Anweisung P_1 als neue Eingaben, um das Modell bei der Generierung der endgültigen Antwort zu unterstützen.

Danach wird eine neue Anweisung P_2 als Triggeranweisung zum Extrahieren der Antwort verwendet. Alle Aufgabenanweisungen wurden der Forschung von Brown, Ouyang, Zhang et al. entnommen oder von dieser inspiriert. Eine letzte Sache, die Sie beachten sollten, ist, dass Sie jedes Mal, wenn Sie eine neue Anfrage an ChatGPT stellen, die Konversation vorher löschen müssen, um die Auswirkungen des vorherigen Beispiels zu vermeiden.

Experiment

Das Experiment verwendet 20 verschiedene Datensätze zur Auswertung von ChatGPT und GPT-3.5 und deckt 7 Arten von Aufgaben ab.

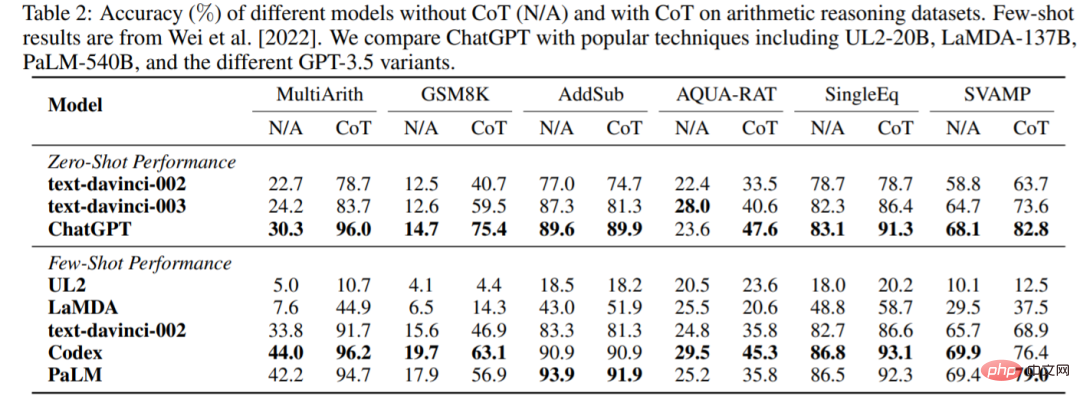

Arithmetisches Denken

Die Genauigkeit von ChatGPT und GPT-3.5 ohne oder mit CoT für sechs Datensätze zum arithmetischen Denken ist in Tabelle 2 dargestellt. In Experimenten ohne CoT übertraf ChatGPT GPT-3.5 bei fünf der Datensätze und demonstrierte damit seine starken Fähigkeiten zum arithmetischen Denken.

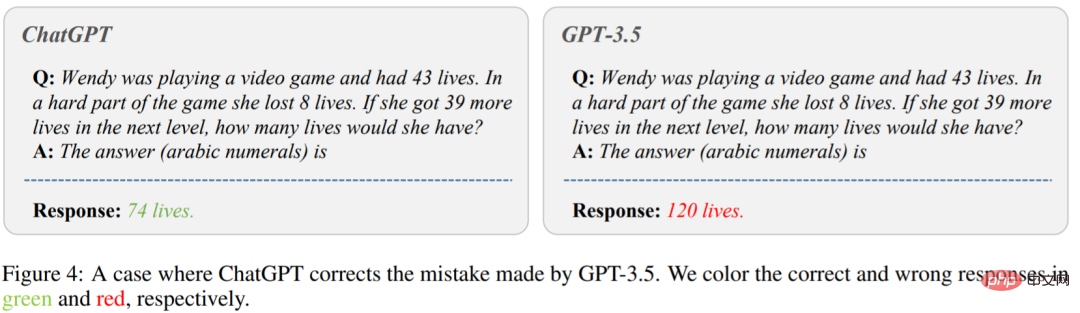

Abbildung 4 zeigt den Fall, in dem GPT-3.5 die falsche Antwort gibt. Fragen Sie auf der linken Seite des Bildes: „Wendy spielt ein Videospiel und hat 43 Leben. Während des schwierigen Teils des Spiels hat sie 8 Leben verloren. Wenn sie im nächsten Level 39 weitere Leben bekommt, wie viele Leben wird sie haben?“ haben?“ ChatGPT gab die richtige Antwort. Allerdings hat GPT-3.5 eine falsche Antwort generiert. Es zeigt sich, dass ChatGPT bei der Verwendung von CoT deutlich besser abschneidet als GPT-3.5.

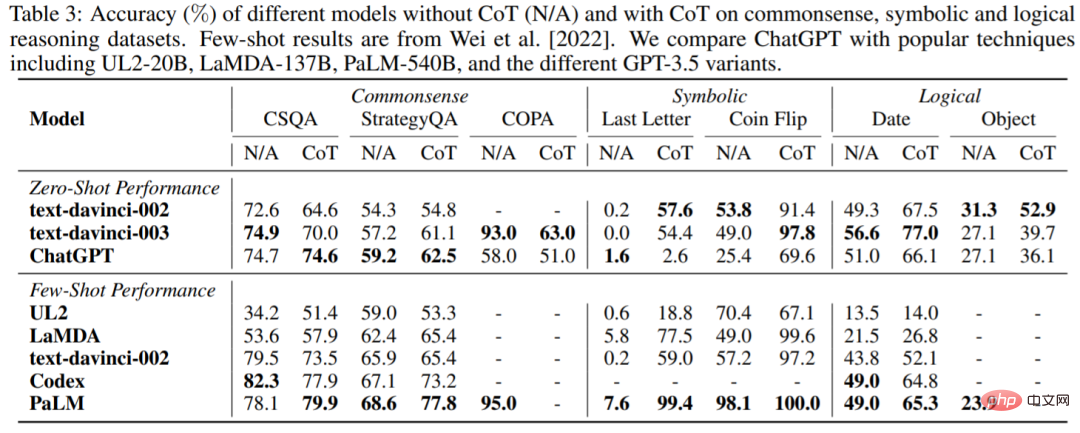

Gesunder Menschenverstand, symbolisches und logisches Denken

Tabelle 3 zeigt die Genauigkeit von ChatGPT im Vergleich zum beliebten LLM in Bezug auf Datensätze mit gesundem Menschenverstand, symbolischem und logischem Denken. Die folgenden Beobachtungen können gemacht werden: Erstens liefert die Verwendung von CoT möglicherweise nicht immer eine bessere Leistung bei Aufgaben zum gesunden Menschenverstand, die möglicherweise detaillierteres Hintergrundwissen erfordern. Zweitens schneidet ChatGPT im Gegensatz zum arithmetischen Denken in vielen Fällen schlechter ab als GPT-3.5, was darauf hindeutet, dass GPT-3.5 über stärkere entsprechende Fähigkeiten verfügt.

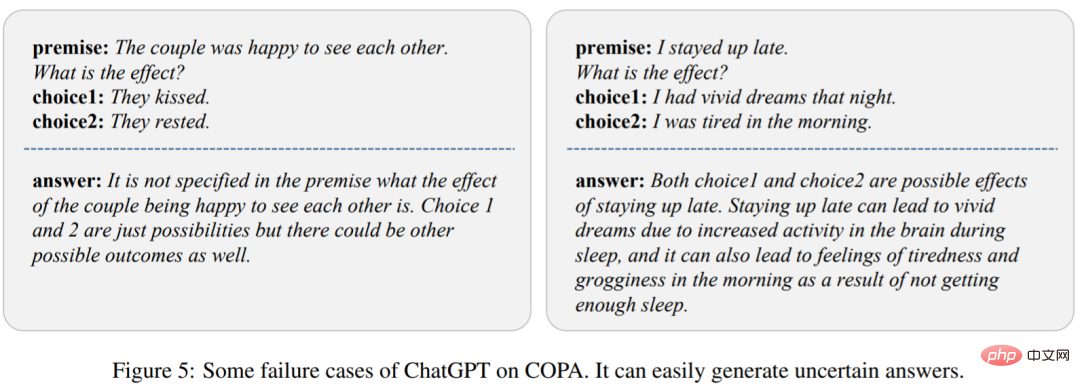

Um die Gründe zu analysieren, zeigt die Studie in Abbildung 5 mehrere Fehlerfälle von ChatGPT. Wir können beobachten, dass ChatGPT leicht undefinierte Antworten erzeugen kann, was zu einer schlechten Leistung führt.

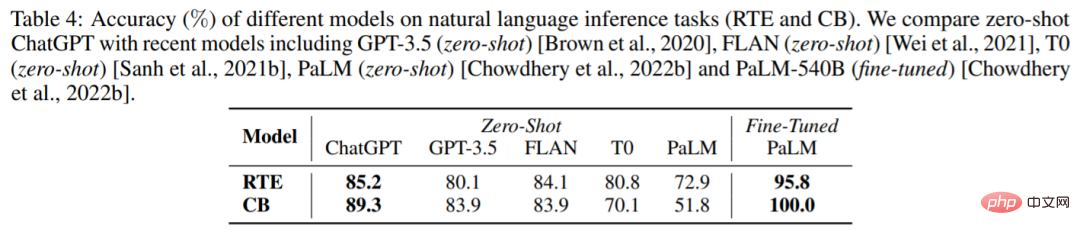

Natürliches Denken in natürlicher Sprache

Tabelle 4 zeigt die Ergebnisse verschiedener Modelle für zwei Aufgaben zum Denken in natürlicher Sprache: RTE und CB. Wir können sehen, dass ChatGPT unter Zero-Shot-Einstellungen eine bessere Leistung erzielen kann als GPT-3.5, FLAN, T0 und PaLM. Dies beweist, dass ChatGPT bei NLP-Argumentationsaufgaben eine bessere Zero-Shot-Leistung aufweist.

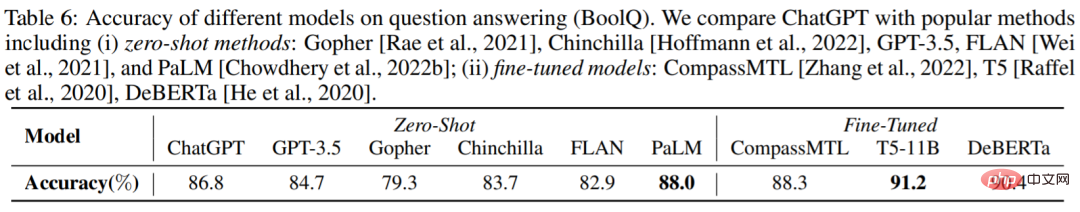

Fragen und Antworten

Tabelle 6 zeigt die Genauigkeit verschiedener Modelle im BoolQ-Datensatz, und ChatGPT ist besser als GPT-3.5. Dies zeigt, dass ChatGPT Argumentationsaufgaben besser bewältigen kann.

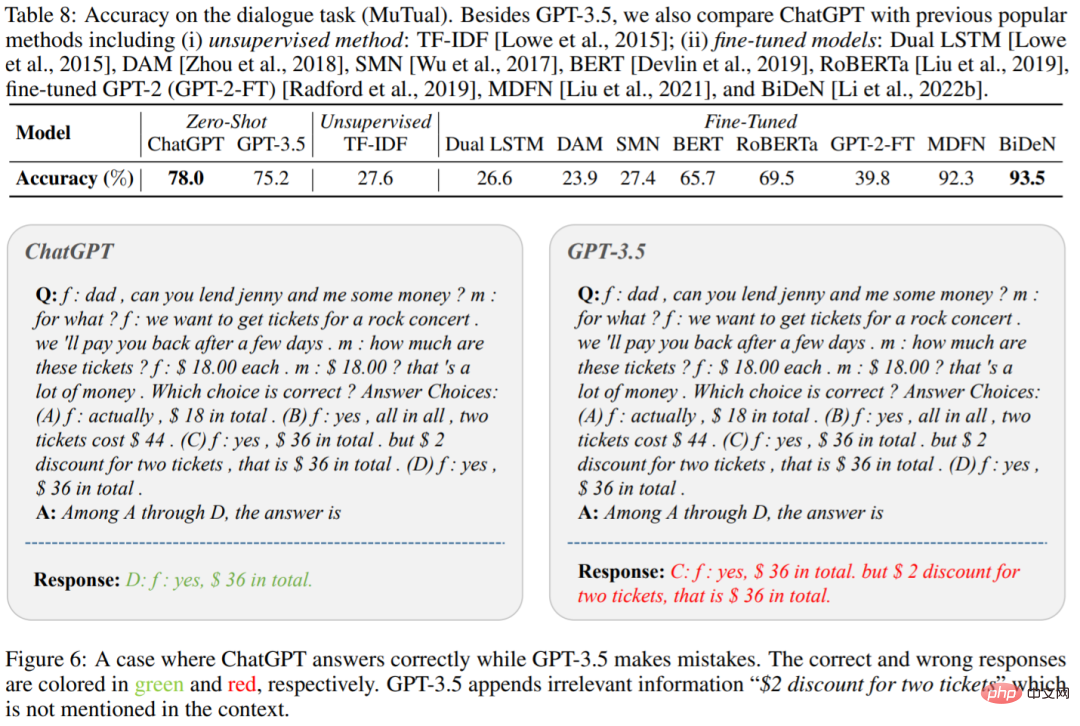

Konversation

Tabelle 8 zeigt die Genauigkeit von ChatGPT und GPT-3.5 für den MuTual-Datensatz (Mehrrunden-Konversationsinferenz). Wie erwartet übertrifft ChatGPT GPT-3.5 deutlich.

Abbildung 6 ist ein konkretes Beispiel. Wir können sehen, dass ChatGPT für einen bestimmten Kontext effektiver argumentieren kann. Dies bestätigt einmal mehr die hervorragenden Denkfähigkeiten von ChatGPT.

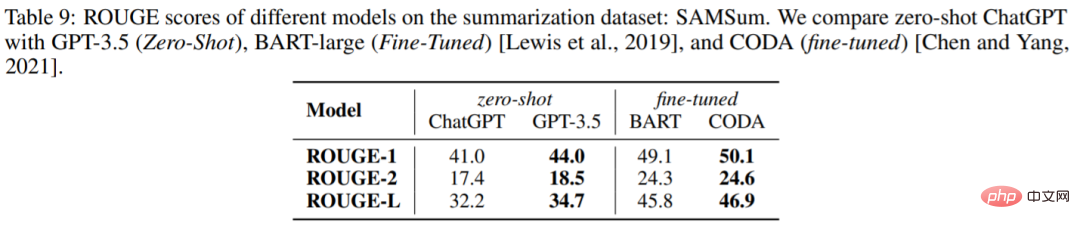

Zusammenfassung erstellen

Tabelle 9 zeigt die ROUGE-Werte von ChatGPT und GPT-3.5 im SAMSum-Datensatz. Überraschenderweise ist ChatGPT in allen Metriken schlechter als GPT-3.5.

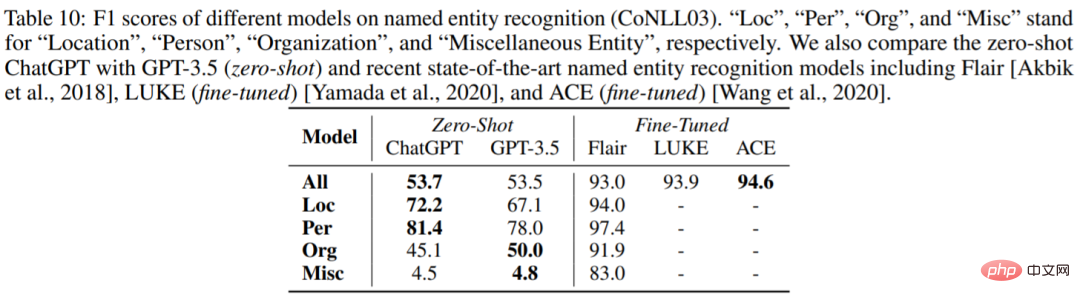

Erkennung benannter Entitäten

Tabelle 10 zeigt die Zero-Shot-Leistung von ChatGPT und GPT-3.5 auf CoNLL03. Wir können sehen, dass die Gesamtleistung von ChatGPT und GPT-3.5 sehr ähnlich ist.

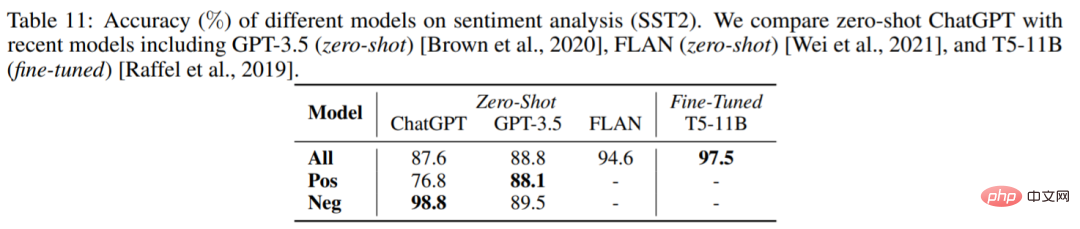

Stimmungsanalyse

Tabelle 11 vergleicht die Genauigkeit verschiedener Modelle des Stimmungsanalysedatensatzes SST2. Überraschenderweise schneidet ChatGPT etwa 1 % schlechter ab als GPT-3.5.

Weitere Informationen finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonIst ChatGPT wirklich ein „Generalist'? Yang Di und andere haben es einem gründlichen Test unterzogen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr