Heim >Technologie-Peripheriegeräte >KI >KI weiß, was Sie denken, und zeichnet es für Sie. Der Projektcode ist Open Source

KI weiß, was Sie denken, und zeichnet es für Sie. Der Projektcode ist Open Source

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-13 19:10:011941Durchsuche

Im Science-Fiction-Roman „Das Drei-Körper-Problem“ erhalten die Trisolaraner, die versuchen, die Erde zu besetzen, eine ganz einzigartige Kulisse: Sie teilen Informationen über Gehirnwellen, mit transparentem Denken und bösen Absichten untereinander. Denken und Sprechen sind für sie dasselbe Wort. Die Menschen hingegen nutzten die Undurchsichtigkeit ihres Denkens aus, um den „Wall-Facing-Plan“ zu entwickeln, und schafften es schließlich, die Trisolaraner zu täuschen und einen inszenierten Sieg zu erringen.

Dann stellt sich die Frage: Ist das menschliche Denken wirklich völlig undurchsichtig? Mit dem Aufkommen einiger technischer Mittel scheint die Antwort auf diese Frage nicht mehr so eindeutig zu sein. Viele Forscher versuchen, die Geheimnisse des menschlichen Denkens zu entschlüsseln und einige Gehirnsignale in Text, Bilder und andere Informationen umzuwandeln.

Kürzlich haben zwei Forschungsteams gleichzeitig wichtige Fortschritte in Richtung Bilddekodierung gemacht und entsprechende Arbeiten wurden vom CVPR 2023 angenommen.

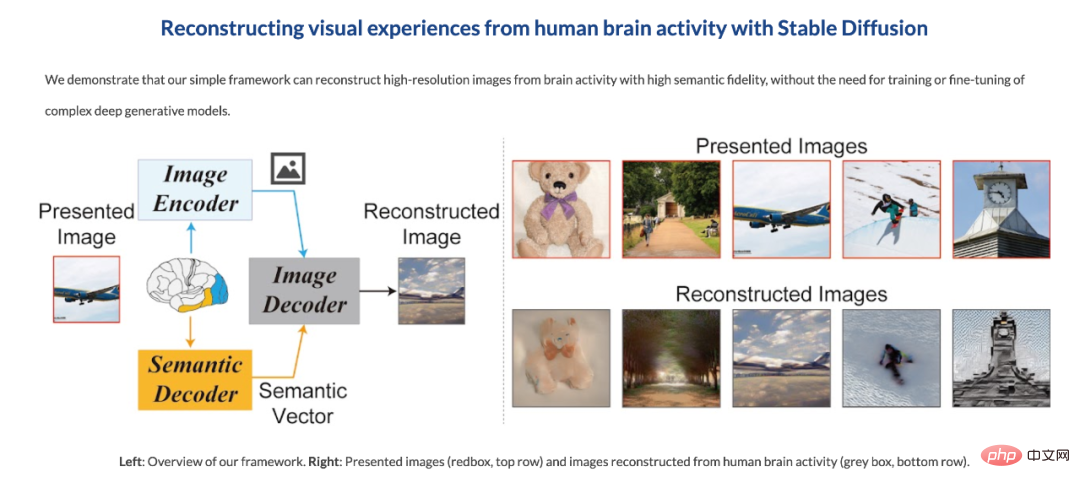

Das erste Team kommt von der Universität Osaka. Sie nutzen die kürzlich sehr beliebte Stable Diffusion, um hochauflösende und hochpräzise Bilder der Gehirnaktivität aus Bildern der menschlichen Gehirnaktivität zu rekonstruieren, die durch funktionelle Magnetresonanztomographie (fMRT) gewonnen wurden (siehe „ „Stable Diffusion liest Ihre Gehirnsignale, um Bilder zu reproduzieren, und die Forschung wurde vom CVPR akzeptiert“).

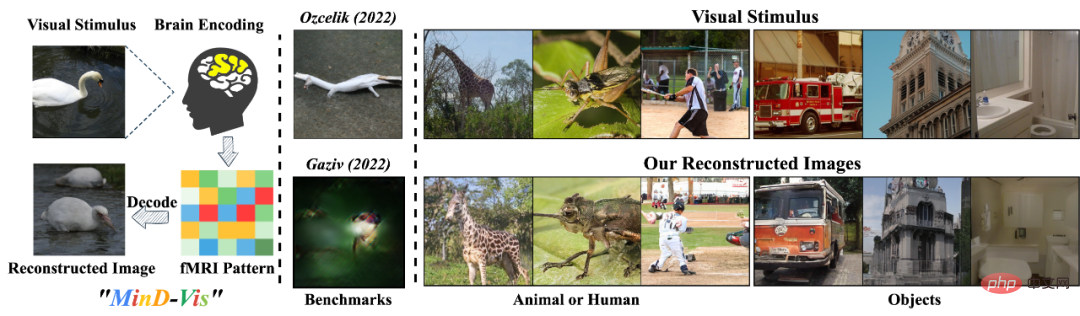

Zufälligerweise erzielten fast zeitgleich auch chinesische Teams der National University of Singapore, der Chinese University of Hong Kong und der Stanford University ähnliche Ergebnisse. Sie entwickelten einen menschlichen visuellen Decoder namens „MinD-Vis“, der menschliche visuelle Reize direkt aus fMRT-Daten durch eine vorab trainierte Maskenmodellierung und ein latentes Diffusionsmodell dekodieren kann. Es generiert diese Bilder, die nicht nur einigermaßen detailliert sind, sondern auch die Semantik und Merkmale des Bildes (wie Textur und Form) genau wiedergeben. Derzeit ist der Code für diese Forschung Open Source.

Papiertitel: Seeing Beyond the Brain: Conditional Diffusion Model with Sparse Masked Modeling for Vision Decoding

- Link zum Papier: http:// ar xiv. org /abs/2211.06956

- Code-Link: https://github.com/zjc062/mind-vis

- Projekt-Link: https://mind-vis.github.io/

Als nächstes werden wir dieses Papier im Detail vorstellen.

Forschungsübersicht

„Was Sie sehen, ist, was Sie denken.“

Menschliche Wahrnehmung und Vorwissen hängen im Gehirn eng zusammen. Unsere Wahrnehmung der Welt wird nicht nur durch objektive Reize beeinflusst, sondern auch durch unsere Erfahrung. Diese Effekte bilden komplexe Gehirnaktivitäten. Das Verständnis dieser Gehirnaktivitäten und die Dekodierung der Informationen ist eines der wichtigen Ziele der kognitiven Neurowissenschaften, wo die Dekodierung visueller Informationen eine große Herausforderung darstellt.

Funktionelle Magnetresonanztomographie (fMRT) ist eine häufig verwendete nicht-invasive und effektive Methode, mit der visuelle Informationen wie Bildkategorien wiederhergestellt werden können.

MinD-Vis zielt darauf ab, die Möglichkeit zu untersuchen, mithilfe von Deep-Learning-Modellen visuelle Reize direkt aus fMRT-Daten zu dekodieren.

Bisherige Methoden, die komplexe neuronale Aktivitäten direkt aus fMRT-Daten dekodieren, leiden unter einem Mangel an {fMRI-Bild}-Paarung und effektiver biologischer Führung, sodass die rekonstruierten Bilder oft verschwommen und semantisch bedeutungslos sind. Daher ist es eine wichtige Herausforderung, fMRT-Darstellungen effektiv zu erlernen, die dabei helfen, Zusammenhänge zwischen Gehirnaktivität und visuellen Reizen herzustellen.

Darüber hinaus verkompliziert die individuelle Variabilität das Problem noch weiter, und wir müssen Darstellungen aus großen Datensätzen lernen und die Einschränkungen bei der Generierung bedingter Synthese aus fMRT lockern.

Daher Der Autor glaubt, dass die Verwendung von selbstüberwachtem Lernen (selbstüberwachtes Lernen mit Vortextaufgabe) und groß angelegten generativen Modellen zu einer besseren Modellleistung führen kann auf relativ kleinen Datenmengen, am Set mit Kontextwissen und erstaunlichen Generierungsfähigkeiten verfeinert .

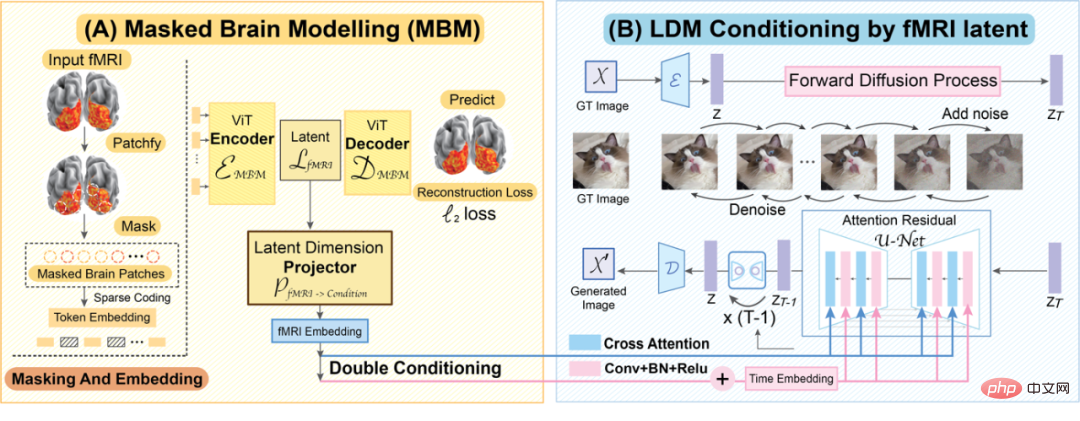

Basierend auf der obigen Analyse schlug MinD-Vis die Maskensignalmodellierung und das bi-bedingte latente Diffusionsmodell der menschlichen visuellen Dekodierung vor. Die spezifischen Beiträge sind wie folgt: # 🎜 🎜#

- schlägt Sparse Coded-Masked Brain Modeling (SC-MBM) als biologisch geführten, vortrainierten Lerner für die effektive visuelle Dekodierung von Gehirnmerkmalen vor.

- Durch das Hinzufügen eines bikonditionalen latenten Diffusionsmodells (DC-LDM) wird die Dekodierungskonsistenz bei gleicher Semantik gestärkt und ermöglicht gleichzeitig die Generierung von Varianz.

- Durch die Kombination der Darstellungsfunktionen von SC-MBM und der Generierungsfunktionen von DC-LDM sind die von MinD-Vis generierten Bilder sinnvoller und behalten gleichzeitig semantische Informationen bei.

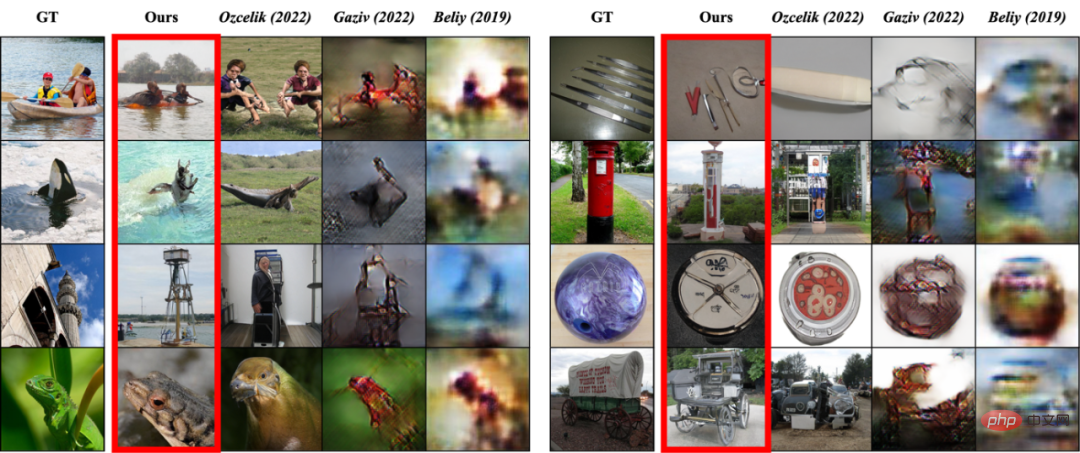

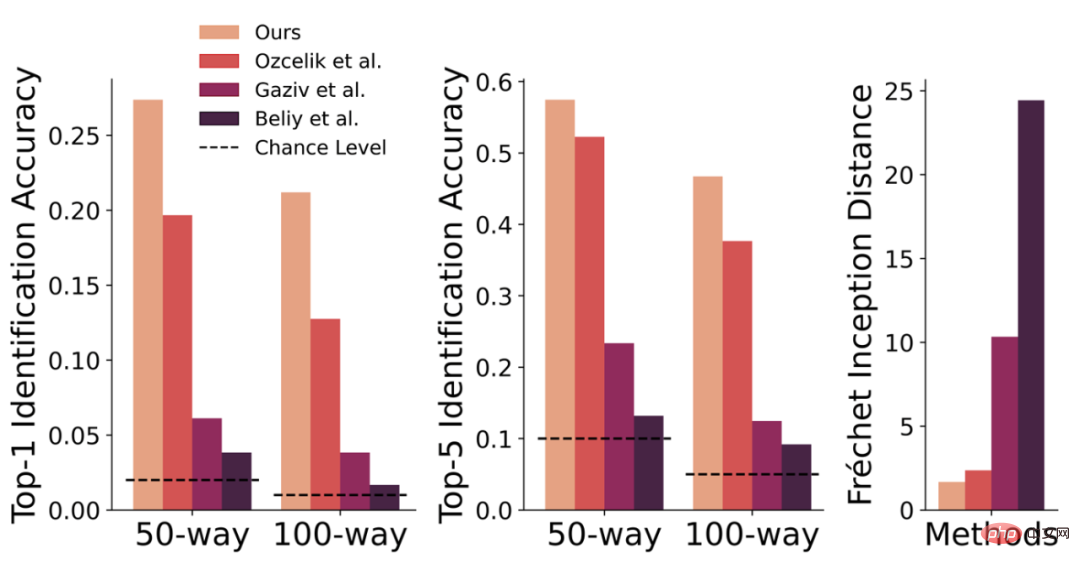

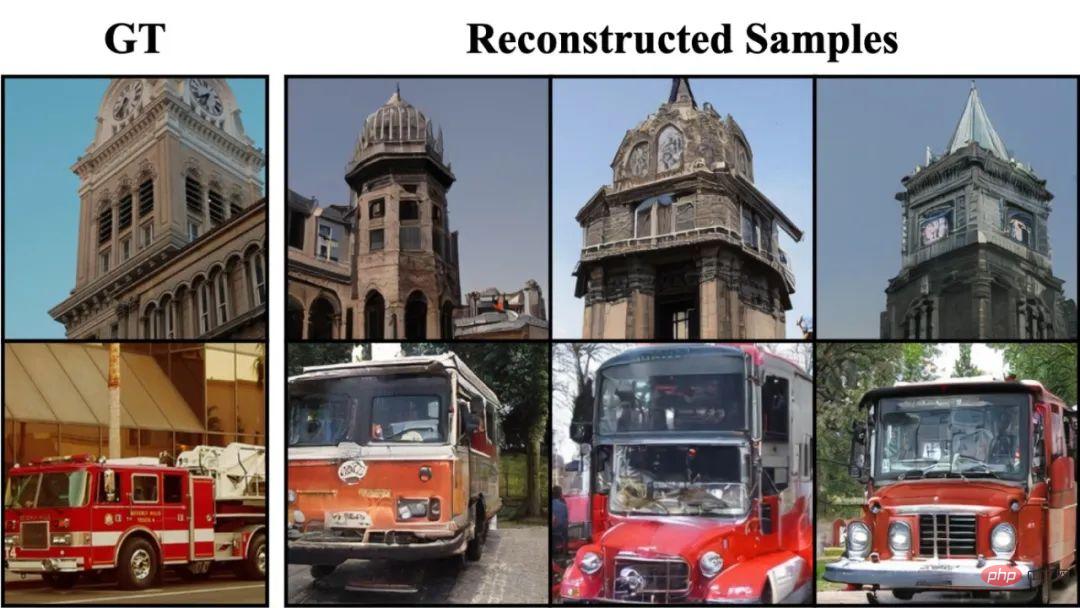

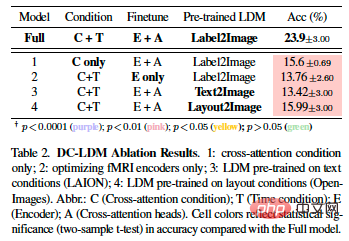

- Quantitative und qualitative Tests wurden an mehreren Datensätzen durchgeführt. Vergleich mit bisherigen Methoden – Qualität generieren 🎜 #Vergleich mit bisherigen Methoden – quantitativer Vergleich von Bewertungsindikatoren

Selbstüberwachtes Lernen + groß angelegtes generatives Modell# 🎜🎜#

# 🎜🎜#Da das Sammeln von {fMRT-Bild}-Paaren sehr teuer und zeitaufwändig ist, litt diese Aufgabe immer unter einem Mangel an Datenannotationen. Darüber hinaus weist jeder Datensatz und die Daten jedes Einzelnen einen bestimmten Domänenoffset auf.

Bei dieser Aufgabe wollen die Forscher einen Zusammenhang zwischen Gehirnaktivität und visuellen Reizen herstellen und dadurch entsprechende Bildinformationen generieren. Dazu nutzten sie selbstüberwachtes Lernen und groß angelegte generative Modelle. Sie glauben, dass dieser Ansatz eine Feinabstimmung von Modellen auf relativ kleinen Datensätzen ermöglicht und kontextbezogenes Wissen sowie beeindruckende generative Fähigkeiten erlangt.

MinD-Vis Framework

Bei der Berechnung von fMRT-Daten wird normalerweise die Region of Interest (ROI) extrahiert und die Daten in einen 1D-Vektor umgewandelt. Bei dieser Aufgabe wird nur das Signal aus dem visuellen Kortex des Gehirns extrahiert. Daher ist die Anzahl der Voxel (ca. 4000) viel geringer als die Anzahl der Pixel im Bild (256*256*3). werden im gleichen Spielraum wie üblich verarbeitet. Es besteht eine erhebliche Lücke in der Art und Weise, wie Bilddaten verwendet werden.

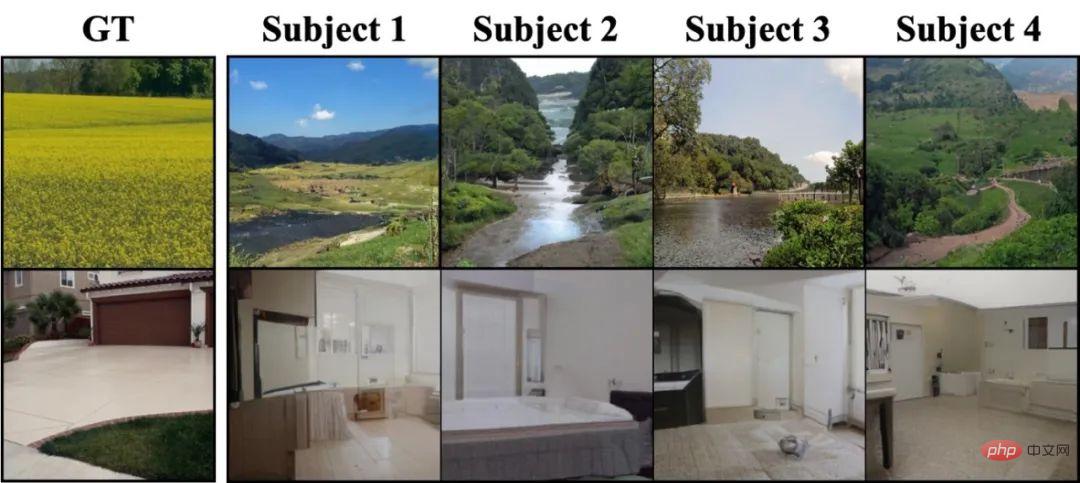

Aufgrund individueller Unterschiede, Unterschiede im experimentellen Design und der Komplexität der Gehirnsignale wird jeder Datensatz und die Daten jedes Einzelnen eine bestimmte Domänenverschiebung aufweisen.Für einen festen visuellen Reiz hoffen die Forscher, dass das vom Modell wiederhergestellte Bild semantisch konsistent ist; aufgrund individueller Unterschiede wird jedoch jeder anders darauf reagieren Durch den visuellen Reiz erhoffen sich die Forscher zudem eine gewisse Varianz und Flexibilität.

Um diese Probleme zu lösen, besteht MinD-Vis aus zwei Phasen: 🎜🎜#Verwenden Sie große fMRI-Datensätze, um Masked Autoencoder zu trainieren, fMRI zu lernen Darstellung.

Integrieren Sie den vorab trainierten fMRI-Encoder mit LDM durch Kreuzaufmerksamkeitskonditionierung und Zeitschrittkonditionierung für doppelte Konditionierung, um eine bedingte Synthese durchzuführen. Anschließend optimieren wir gemeinsam den Queraufmerksamkeitskopf in LDM mithilfe von gepaarten {fMRI, Image}.

Diese beiden Schritte werden hier im Detail vorgestellt.

MinD-Vis-Übersicht

(A) Sparse-Coded Masked Brain Modeling (SC-MBM) (MinD-Vis-Übersicht links)

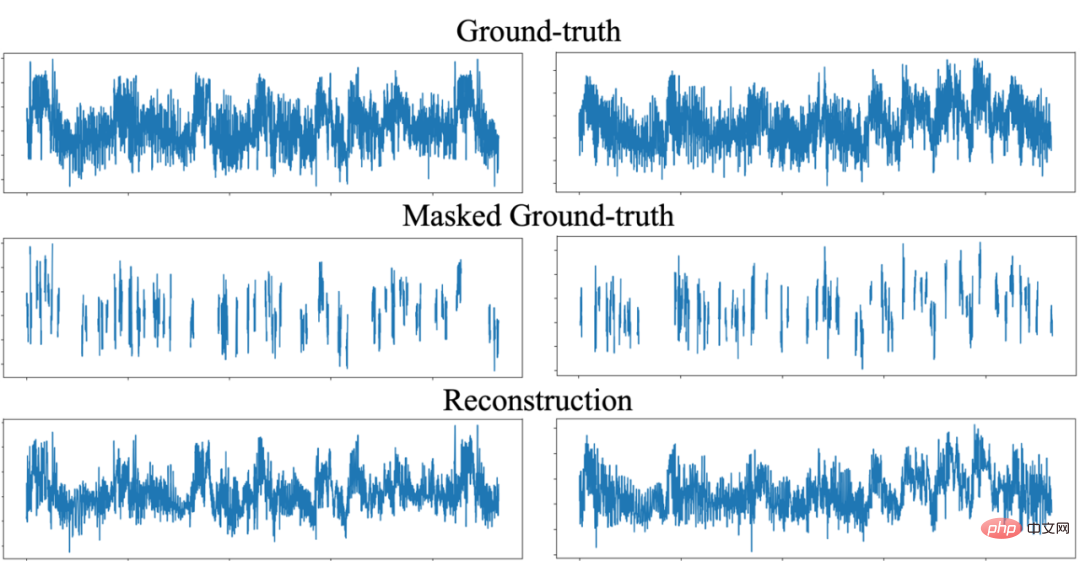

Dank fMRT Platzinformationen sind redundant und fMRT-Daten können auch dann noch wiederhergestellt werden, wenn sie weitgehend verdeckt sind. Daher werden in der ersten Stufe von MinD-Vis die meisten fMRT-Daten maskiert, um Rechenzeit zu sparen. Hier verwendet der Autor einen ähnlichen Ansatz wie Masked Autoencoder:

- Teilen Sie fMRI-Voxel in Patches auf

- Verwenden Sie eine 1D-Faltungsschicht mit einem Schritt, der der Patchgröße entspricht, um sie in Einbettung umzuwandeln

- Der Rest Der fMRI-Patch wird mit Positionseinbettung hinzugefügt und als Eingabe des Vision-Transformators verwendet.

- Dekodieren Sie, um die rekonstruierten Daten zu erhalten. Berechnen Sie den Verlust zwischen den rekonstruierten Daten und den Originaldaten um die rekonstruierten Daten möglichst ähnlich wie die Originaldaten zu machen

- Wiederholen Sie die Schritte 2-6, um das endgültige Modell zu trainieren

- SC-MBM kann die maskierten fMRT-Informationen effektiv wiederherstellen

Was ist der Unterschied zwischen Design und Mask

ed Autoencoder?Wenn die Maskenmodellierung auf natürliche Bilder angewendet wird, verwendet das Modell im Allgemeinen ein Verhältnis von Einbettung zu Patchgröße, das gleich oder etwas größer als 1 ist. In dieser Aufgabe verwendete der Autor ein relativ großes Einbettungs-zu-Patch-Größenverhältnis, was die Informationskapazität erheblich erhöhen und einen großen Darstellungsraum für fMRT schaffen kann. Dieses Design entspricht auch der Informationsverteilung im Gehirn . Sparse-Kodierung*.

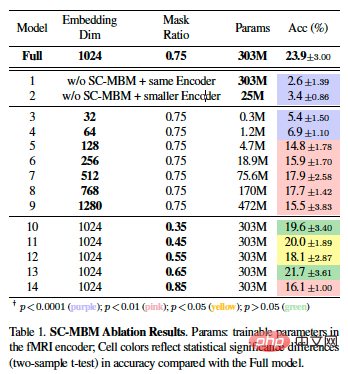

- Ablationsexperiment von SC-MBM

Auf Stufe A Nach der Durchführung eines umfassenden Kontextlernens kann der fMRI-Encoder die fMRI-Daten in eine spärliche Darstellung mit Lokalitätsbeschränkungen umwandeln. Hier formulieren die Autoren die Dekodierungsaufgabe als bedingtes Generierungsproblem und verwenden vorab trainiertes LDM, um dieses Problem zu lösen.

LDM arbeitet mit dem latenten Raum des Bildes, wobei die fMRT-Daten z als bedingte Informationen dienen, und das Ziel besteht darin, zu lernen, das Bild durch einen Rückdiffusionsprozess zu erzeugen.

Bei Bilderzeugungsaufgaben sind Diversität und Konsistenz gegensätzliche Ziele, und fMRT bei Bildern basiert mehr auf der Erzeugung von Konsistenz.

- Um die Konsistenz der Generation sicherzustellen, kombiniert der Autor Queraufmerksamkeitskonditionierung und Zeitschrittkonditionierung und verwendet einen bedingten Mechanismus mit Zeiteinbettung in der mittleren Schicht von UNet.

- Sie haben die Optimierungszielformel weiter in eine alternierende Formel mit doppelter Anpassung umformuliert.

- Wir demonstrieren die Stabilität unserer Methode, indem wir Bilder in verschiedenen Zufallszuständen mehrfach dekodieren.

Feinabstimmung

Feinabstimmung

Nachdem der fMRI-Encoder durch SC-MBM vorab trainiert wurde, wird er durch doppelte Konditionierung in das vorab trainierte LDM integriert. Hier, von:

- Verwenden Sie eine Faltungsschicht, um die Ausgabe des Encoders mit der latenten Dimension zusammenzuführen.

- Optimieren Sie gemeinsam den fMRI-Encoder, die Kreuzaufmerksamkeitsköpfe und die anderen Teile werden fixiert.

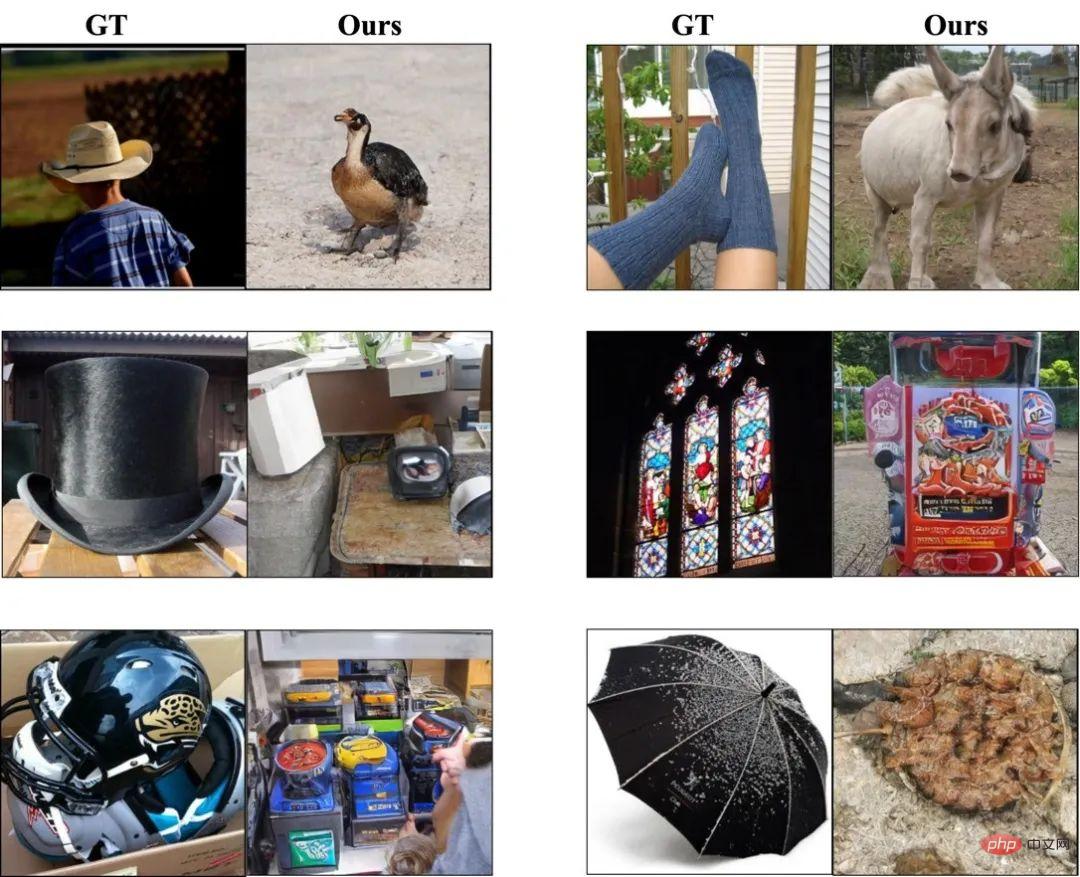

- Fein abgestimmtes Kreuz Aufmerksamkeitsköpfe sind vorab trainiert. Der Schlüssel zur Konditionierung des Raums und des fMRT-Latentraums. Kapazitäts-fMRT-Darstellungen. DC-LDM-Ablationsexperiment die für den Inhalt des Bildes sehr relevant sind. Wenn es sich bei dem Bild beispielsweise um eine natürliche Landschaft handelt, dekodiert MinD-Vis einen Fluss und einen blauen Himmel; wenn es sich um ein Haus handelt, dekodiert MinD-Vis eine ähnliche Innendekoration. Dies hat sowohl Vor- als auch Nachteile. Das Gute ist, dass dies zeigt, dass wir entschlüsseln können, was wir uns vorgestellt haben; das Schlechte ist, dass dies die Auswertung der Dekodierungsergebnisse beeinflussen kann. Der Autor ist der Ansicht, dass die Schwierigkeit bei der Dekodierung des Reizes unterschiedlich sein wird, wenn die Anzahl der Trainingsproben gering ist. Beispielsweise enthält der GOD-Datensatz mehr Tiertrainingsproben als Kleidung. Dies bedeutet, dass ein Wort, das semantisch „pelzig“ ähnelt, eher als Tier als als Kleidungsstück dekodiert wird, wie im Bild oben gezeigt, wo eine Socke als Schaf dekodiert wird.

- Experimenteller Aufbau

Die erste Stufe des Vortrainings: Verwendung des Human Connectome Project, das 136.000 fMRT-Datensegmente bereitstellt, keine Bilder, nur fMRT.

Der Encoder und das Generationsmodell der zweiten Stufe wurden verfeinert: Es wurden die Datensätze Generic Object Decoding Dataset (GOD) und Brain, Object, Landscape Dataset (BOLD5000) verwendet. Diese beiden Datensätze liefern 1250 bzw. 5254 {fMRI, Image}-Paare, von denen 50 bzw. 113 als Testsätze verwendet wurden.

Modellstruktur

Bewertungsindex

Wie in der vorherigen Literatur verwendete der Autor auch die n-Wege-Top-1- und Top-5-Klassifizierungsgenauigkeit, um die semantische Korrektheit der Ergebnisse zu bewerten. Hierbei handelt es sich um eine Methode, die Ergebnisse auswertet, indem die Genauigkeit der Top-1- und Top-5-Klassifizierung für n-1 zufällig ausgewählte Kategorien und die richtige Kategorie über mehrere Versuche hinweg berechnet wird. Im Gegensatz zu früheren Ansätzen verwenden sie hier eine direktere und reproduzierbarere Bewertungsmethode und verwenden einen vorab trainierten ImageNet1K-Klassifikator, um die semantische Korrektheit der generierten Bilder zu beurteilen, anstatt handgefertigte Funktionen zu verwenden. Darüber hinaus verwendeten sie die Fréchet-Inzeptionsdistanz (FID) als Referenz, um die Qualität der erzeugten Bilder zu bewerten. Aufgrund der begrenzten Anzahl von Bildern im Datensatz kann FID die Bildverteilung jedoch möglicherweise nicht perfekt beurteilen.

Wie in der vorherigen Literatur verwendete der Autor auch die n-Wege-Top-1- und Top-5-Klassifizierungsgenauigkeit, um die semantische Korrektheit der Ergebnisse zu bewerten. Hierbei handelt es sich um eine Methode, die Ergebnisse auswertet, indem die Genauigkeit der Top-1- und Top-5-Klassifizierung für n-1 zufällig ausgewählte Kategorien und die richtige Kategorie über mehrere Versuche hinweg berechnet wird. Im Gegensatz zu früheren Ansätzen verwenden sie hier eine direktere und reproduzierbarere Bewertungsmethode und verwenden einen vorab trainierten ImageNet1K-Klassifikator, um die semantische Korrektheit der generierten Bilder zu beurteilen, anstatt handgefertigte Funktionen zu verwenden. Darüber hinaus verwendeten sie die Fréchet-Inzeptionsdistanz (FID) als Referenz, um die Qualität der erzeugten Bilder zu bewerten. Aufgrund der begrenzten Anzahl von Bildern im Datensatz kann FID die Bildverteilung jedoch möglicherweise nicht perfekt beurteilen.

Effekt

Die Experimente in diesem Artikel wurden auf individueller Ebene durchgeführt, das heißt, das Modell wurde an derselben Person trainiert und getestet. Zum Vergleich mit früherer Literatur werden hier die Ergebnisse für das dritte Subjekt des GOD-Datensatzes angegeben, und die Ergebnisse für die anderen Subjekte sind im Anhang aufgeführt.

Am Ende geschrieben

Durch dieses Projekt demonstrierte der Autor die Machbarkeit der Wiederherstellung visueller Informationen des menschlichen Gehirns durch fMRT. Allerdings gibt es in diesem Bereich viele Fragen, die angegangen werden müssen, beispielsweise wie man besser mit interindividueller Variabilität umgeht, wie man die Auswirkungen von Rauschen und Interferenzen auf die Dekodierung reduziert und wie man die fMRT-Dekodierung mit anderen neurowissenschaftlichen Techniken kombiniert, um dies zu erreichen ein umfassenderes Verständnis der Mechanismen und Funktionen des menschlichen Gehirns. Gleichzeitig müssen wir auch die ethischen und rechtlichen Fragen rund um das menschliche Gehirn und die Privatsphäre des Einzelnen besser verstehen und respektieren.

Darüber hinaus müssen wir auch umfassendere Anwendungsszenarien wie die Medizin und die Mensch-Computer-Interaktion erforschen, um diese Technologie in praktische Anwendungen umzusetzen. Im medizinischen Bereich könnte die fMRT-Dekodierungstechnologie in Zukunft eingesetzt werden, um speziellen Gruppen wie Sehbehinderten, Hörgeschädigten und sogar Patienten mit allgemeiner Lähmung dabei zu helfen, ihre Gedanken zu entschlüsseln. Aufgrund körperlicher Behinderungen sind diese Menschen nicht in der Lage, ihre Gedanken und Wünsche über traditionelle Kommunikationsmethoden auszudrücken. Mithilfe der fMRT-Technologie können Wissenschaftler ihre Gehirnaktivität entschlüsseln, um auf ihre Gedanken und Wünsche zuzugreifen und so natürlicher und effizienter mit ihnen zu kommunizieren. Im Bereich der Mensch-Computer-Interaktion kann die fMRI-Dekodierungstechnologie zur Entwicklung intelligenterer und anpassungsfähigerer Mensch-Computer-Schnittstellen und Steuerungssysteme eingesetzt werden, beispielsweise zur Dekodierung der Gehirnaktivität des Benutzers, um ein natürlicheres und effizienteres Mensch-Computer-Interaktionserlebnis zu erreichen.

Wir glauben, dass die fMRI-Dekodierung mit der Unterstützung großer Datensätze + großer Modelle + Rechenleistung eine breitere und weitreichende Wirkung haben und die Entwicklung der kognitiven Neurowissenschaften und der künstlichen Intelligenz fördern wird.

Hinweis: *Die biologische Grundlage des Lernens visueller Reizdarstellungen im Gehirn mithilfe von Sparse-Codierung: Sparse-Codierung wurde als Strategie für die Darstellung sensorischer Informationen vorgeschlagen. Untersuchungen zeigen, dass visuelle Reize im visuellen Kortex nur spärlich kodiert sind, was die Effizienz der Informationsübertragung erhöht und die Redundanz im Gehirn verringert. Mithilfe der fMRT kann der visuelle Inhalt natürlicher Szenen aus kleinen Datenmengen, die im visuellen Kortex gesammelt werden, rekonstruiert werden. Sparse Coding kann eine effiziente Art der Codierung in der Computer Vision sein. In dem Artikel wurde die SC-MBM-Methode erwähnt, die fMRI-Daten in kleine Blöcke unterteilt, um Lokalitätsbeschränkungen einzuführen, und dann jeden kleinen Block spärlich in einen hochdimensionalen Vektorraum kodiert, der als biologisch wirksamer und effizienter Lerner für Gehirnmerkmale verwendet werden kann. , wird zur visuellen Kodierung und Dekodierung verwendet.

Das obige ist der detaillierte Inhalt vonKI weiß, was Sie denken, und zeichnet es für Sie. Der Projektcode ist Open Source. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr