Heim >Technologie-Peripheriegeräte >KI >Herausforderung „Eine Karte pro Tag': RTX2080Ti bewältigt das Training großer Modelle und spart das 136-fache an Rechenleistung, und die akademische Gemeinschaft jubelt

Herausforderung „Eine Karte pro Tag': RTX2080Ti bewältigt das Training großer Modelle und spart das 136-fache an Rechenleistung, und die akademische Gemeinschaft jubelt

- PHPznach vorne

- 2023-04-13 18:58:011600Durchsuche

Welche Art von BERT-Modell kann durch Training auf einer Consumer-GPU in nur einem Tag erhalten werden?

In jüngster Zeit haben Sprachmodelle das Feld der KI erneut in Aufruhr versetzt. Das unüberwachte Trainingsmerkmal des vorab trainierten Sprachmodells ermöglicht es, es auf der Grundlage umfangreicher Stichproben zu trainieren und eine große Menge an semantischem und grammatikalischem Wissen zu erhalten. Unabhängig davon, ob es sich um Klassifizierung oder Fragen und Antworten handelt, scheint es für die KI kein Problem zu geben nicht lösen kann.

Große Modelle bringen jedoch nicht nur technologische Durchbrüche, sondern stellen auch endlose Anforderungen an die Rechenleistung.

Kürzlich diskutierten Jonas Geiping und Tom Goldstein von der University of Maryland die gesamte Forschung zur Skalierung von Berechnungen und befassten sich intensiv mit den Richtungen für Verbesserungen bei der Skalierung von Berechnungen. Ihre Forschung hat die Aufmerksamkeit der Machine-Learning-Community auf sich gezogen.

In einer neuen Forschung diskutierte der Autor, welche Art von Sprachmodell mit einer einzigen Consumer-GPU (RTX 2080Ti) trainiert werden kann, und erzielte spannende Ergebnisse. Schauen wir uns an, wie es umgesetzt wird:

Erweiterung der Modellgröße

Im Bereich der Verarbeitung natürlicher Sprache (NLP) haben sich vorab trainierte Modelle auf Basis der Transformer-Architektur durchgesetzt und viele Durchbrüche gebracht. Der Grund für die starke Leistung dieser Modelle liegt zum großen Teil in ihrem großen Maßstab. Mit zunehmender Menge an Modellparametern und Daten wird sich die Leistung des Modells weiter verbessern. Infolgedessen gibt es im NLP-Bereich einen Wettlauf um die Vergrößerung der Modellgröße.

Allerdings glauben nur wenige Forscher oder Praktiker, dass sie in der Lage sind, große Sprachmodelle (LLMs) zu trainieren, und normalerweise verfügen nur die Technologiegiganten der Branche über die Ressourcen, LLMs zu trainieren.

Um diesen Trend umzukehren, führten Forscher der University of Maryland einige Untersuchungen durch.

Paper „Cramming: Training eines Sprachmodells auf einer einzelnen GPU an einem Tag“:

Paper-Link: https://arxiv.org/abs/2212.14034

Diese Frage ist für die meisten Forscher und Praktiker Dies ist von großer Bedeutung, da es zu einer Referenz für die Modellschulungskosten werden wird und voraussichtlich den Engpass der extrem hohen LLM-Schulungskosten überwinden wird. Der Forschungsbericht erregte schnell Aufmerksamkeit und Diskussion auf Twitter.

Leshem Choshen, ein NLP-Forschungsexperte bei IBM, kommentierte auf Twitter: „Dieses Papier fasst alle großen Modelltrainingstricks zusammen, die Sie sich vorstellen können.“

Forscher an der University of Maryland glauben: Wenn Sie Presse Wenn ein verkleinertes Modell-Vortraining eine realisierbare Simulation eines groß angelegten Vortrainings ist, wird dies weitere akademische Forschung zu einer Reihe von groß angelegten Modellen eröffnen, die derzeit schwer zu erreichen sind.

Darüber hinaus versucht diese Studie, den Gesamtfortschritt im NLP-Bereich in den letzten Jahren zu bewerten, nicht nur den Einfluss der Modellgröße.

Die Studie hat eine Herausforderung namens „Cramming“ geschaffen – das Erlernen des gesamten Sprachmodells einen Tag vor dem Test. Die Forscher analysierten zunächst Aspekte der Trainingspipeline, um zu verstehen, welche Modifikationen die Leistung kleiner Simulationsmodelle tatsächlich verbessern könnten. Und die Studie zeigt, dass die Modellleistung selbst in dieser eingeschränkten Umgebung strikt den Skalierungsgesetzen folgt, die in großen Computerumgebungen beobachtet werden.

Während kleinere Modellarchitekturen die Gradientenberechnungen beschleunigen, bleibt die Gesamtrate der Modellverbesserung im Laufe der Zeit nahezu gleich. Diese Forschung versucht, das Expansionsgesetz zu nutzen, um Leistungsverbesserungen zu erzielen, indem die Effizienz von Gradientenberechnungen verbessert wird, ohne die Modellgröße zu beeinträchtigen. Am Ende trainierte die Studie erfolgreich ein Modell mit einer respektablen Leistung – die BERT bei der GLUE-Aufgabe nahe kam oder sogar übertraf – und das bei geringen Trainingskosten.

Begrenzte Ressourcen

Um die Ressourcenumgebung gewöhnlicher Praktiker und Forscher zu simulieren, wurde in dieser Studie zunächst eine ressourcenbeschränkte Forschungsumgebung erstellt:

- Ein transformatorbasiertes Sprachmodell jeder Größe, das vollständig mithilfe maskierter Sprachmodellierung trainiert wird;

- Die Pipeline kann keine vorhandenen vorab trainierten Modelle enthalten; Jeder Rohtext (ausgenommen Downstream-Daten) kann in das Training einbezogen werden, was bedeutet, dass durch kluge Auswahl, wie und wann die Daten abgetastet werden sollen, eine Beschleunigung erzielt werden kann. Der Stichprobenmechanismus erfordert keine vorab trainierten Modelle. 🎜🎜#Das Herunterladen und die Vorverarbeitung der Originaldaten sind nicht im Gesamtbudget enthalten. Die Vorverarbeitung umfasst hier die CPU-basierte Tokenisierungskonstruktion, Tokenisierung und Filterung, jedoch nicht das Repräsentationslernen Wird 24 Stunden lang nur auf einer einzelnen GPU ausgeführt weniger) erfordert die Verwendung globaler Hyperparameter, die für alle GLUE-Aufgaben festgelegt sind, und nachgelagerte Feinabstimmungen werden nicht im Gesamtbudget berücksichtigt.

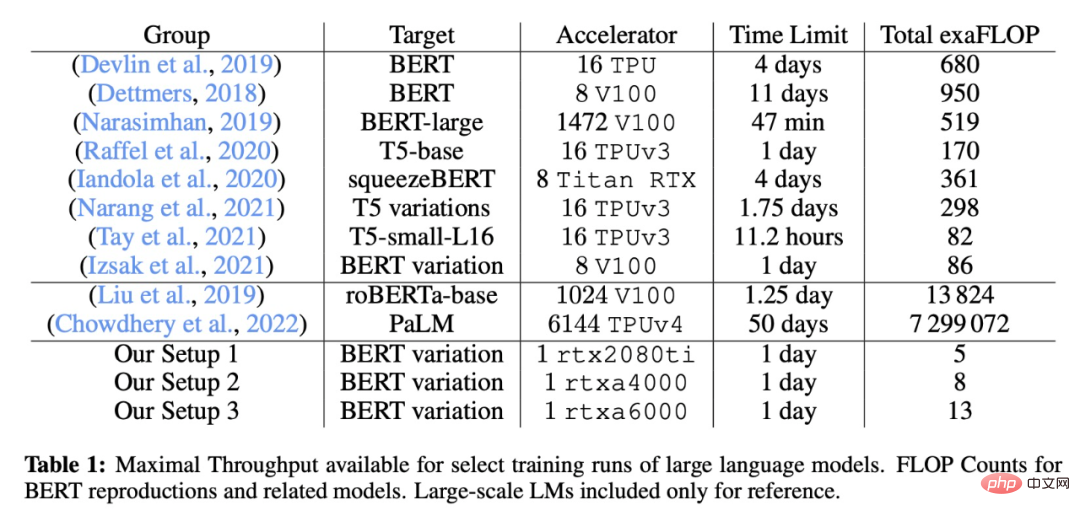

- Die spezifischen Trainingseinstellungen dieser Studie im Vergleich zu einigen klassischen großen Modellen sind in der folgenden Tabelle dargestellt:

- #🎜 🎜#Verbesserungsmethode

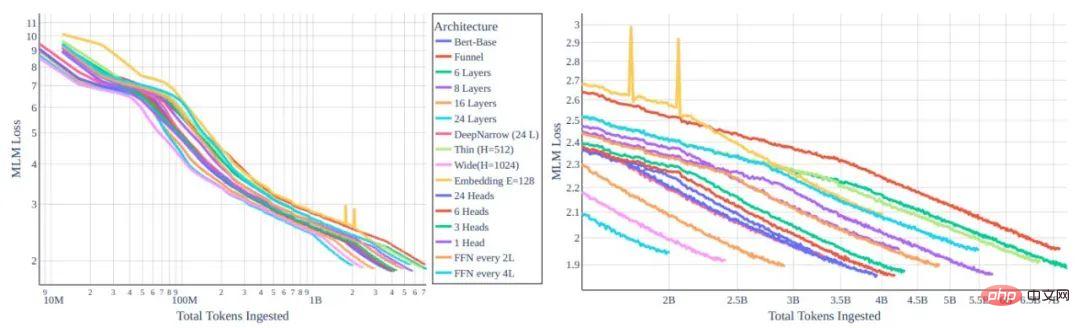

Was die Verbesserung der Leistung angeht, denken wir als Erstes definitiv daran, die Modellarchitektur zu ändern. Intuitiv scheinen Modelle mit kleinerer/geringerer Kapazität für das Training mit einer Karte pro Tag optimal zu sein. Nachdem die Forscher jedoch den Zusammenhang zwischen Modelltyp und Trainingseffizienz untersucht hatten, stellten sie fest, dass die Skalierungsgesetze ein großes Hindernis für das Downsizing darstellten. Die Trainingseffizienz jedes Tokens hängt stark von der Modellgröße und nicht vom Transformatortyp ab.

Was die Verbesserung der Leistung angeht, denken wir als Erstes definitiv daran, die Modellarchitektur zu ändern. Intuitiv scheinen Modelle mit kleinerer/geringerer Kapazität für das Training mit einer Karte pro Tag optimal zu sein. Nachdem die Forscher jedoch den Zusammenhang zwischen Modelltyp und Trainingseffizienz untersucht hatten, stellten sie fest, dass die Skalierungsgesetze ein großes Hindernis für das Downsizing darstellten. Die Trainingseffizienz jedes Tokens hängt stark von der Modellgröße und nicht vom Transformatortyp ab.

Darüber hinaus lernen kleinere Modelle weniger effizient, was die Durchsatzsteigerung erheblich verlangsamt. Glücklicherweise bedeutet die Tatsache, dass die Trainingseffizienz in Modellen gleicher Größe nahezu gleich bleibt, dass wir nach geeigneten Architekturen mit ähnlichen Parameterzahlen suchen und Entwurfsentscheidungen hauptsächlich auf der Grundlage der Rechenzeit treffen können, die einen einzelnen Gradientenschritt beeinflusst. Abbildung 2: Lernratenplan Sehen Sie, dass der Unterschied besteht.

In dieser Arbeit untersuchten die Autoren die Auswirkungen des Trainings von Hyperparametern auf die BERT-basierte Architektur. Verständlicherweise funktionierten Modelle der ursprünglichen BERT-Trainingsmethode nicht gut mit den Trainingsanforderungen im Cramming-Stil, weshalb die Forscher einige Standardoptionen noch einmal überprüften.

Der Autor untersuchte auch die Idee, den Datensatz zu optimieren. Das Skalierungsgesetz verhindert erhebliche Gewinne (über die Recheneffizienz hinaus) durch Architekturänderungen, aber das Skalierungsgesetz hindert uns nicht daran, mit besseren Daten zu trainieren. Wenn wir mehr Token pro Sekunde trainieren möchten, sollten wir versuchen, mit besseren Token zu trainieren. Abbildung 3: Vokabulargröße im Vergleich zu GLUE-Score und MNLI-Genauigkeit für ein Modell, das mit Cramming-Training auf Bookcorpus-Wikipedia-Daten trainiert wurde.

Leistung bei GLUE

Die Forscher bewerteten systematisch die Leistung des GLUE-Benchmarks und des WNLI und stellten fest, dass im vorherigen Abschnitt nur MNLI (m) verwendet wurde und keine Hyperparameter auf der Grundlage des vollständigen GLUE-Scores optimiert wurden. In der neuen Studie haben die Autoren alle Datensätze für 5 Epochen auf BERT-Basis mit einer Stapelgröße von 32 und einer Lernrate von 2 × 10-5 verfeinert. Dies ist für durch Cramming trainierte Modelle nicht optimal, da diese bei einer Stapelgröße von 16 und einer Lernrate von 4 × 10−5 mit Kosinuszerfall kleine Verbesserungen erzielen können (diese Einstellung verbessert den vorab trainierten BERT-Prüfpunkt nicht).

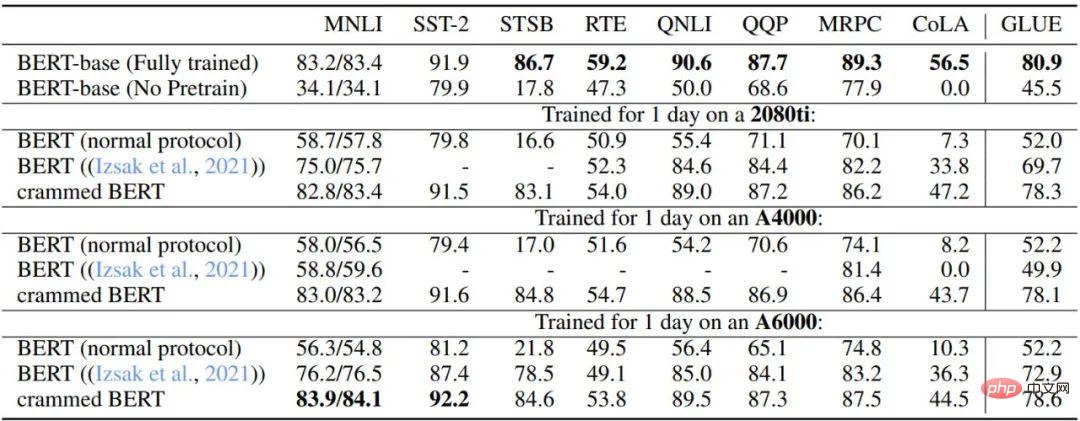

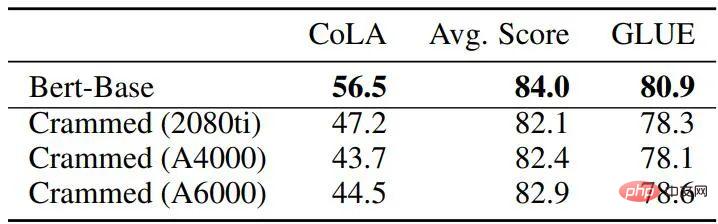

Tabelle 3 und Tabelle 4 beschreiben die Leistung dieses Setups bei GLUE-Downstream-Aufgaben. Die Autoren verglichen den ursprünglichen BERT-Basisprüfpunkt, eine BERT-Vortrainingseinstellung, die nach Erreichen der Rechenleistungsgrenze stoppt, die in der Studie von Izsak et al. aus dem Jahr 2021 beschriebene Einstellung und eine modifizierte Einstellung, die einen Tag pro GPU trainierte Einstellung. Insgesamt ist die Leistung überraschend gut, insbesondere bei größeren Datensätzen wie MNLI, QQP, QNLI und SST-2, und eine nachgelagerte Feinabstimmung kann die verbleibenden Unterschiede zwischen dem vollständigen BERT-Modell und der Cramming-Einstellungsvariante glätten.

Darüber hinaus stellten die Autoren fest, dass die neue Methode im Vergleich zum gewöhnlichen BERT-Training mit begrenzter Rechenleistung und der von Izsak et al. beschriebenen Methode deutlich verbessert ist. Für die Studie von Izsak et al. war die beschriebene Methode ursprünglich für einen vollständigen 8-GPU-Blade-Server konzipiert, und im neuen Szenario war die Komprimierung des BERT-großen Modells auf die kleinere GPU für die meisten Leistungsgründe verantwortlich Abfall.

Tabelle 3: GLUE-dev-Leistungsvergleich der Baseline-BERT- und Cramming-Versionsmodelle

Die Hyperparameter aller Aufgaben sind festgelegt, die Epochengrenze beträgt 5 und der fehlende Wert ist NaN. Es wurde für einen 8-GPU-Blade-Server entwickelt und hier ist die gesamte Rechenleistung in einer einzigen GPU untergebracht.

Tabelle 4: Vergleich der GLUE-Entwicklungsleistung zwischen Basis-BERT und Padding-Modell

Im Allgemeinen liegen die Trainingsergebnisse bei Verwendung der in der Arbeit beschriebenen Methode sehr nahe am ursprünglichen BERT, aber es ist wichtig, das zu wissen Die von letzterer verwendeten gesamten FLOPS sind mit der neuen Methode 45-136-mal schneller (dauert vier Tage bei 16 TPUs). Und wenn die Trainingszeit um das 16-fache verlängert wird (zwei Trainingstage auf 8 GPUs), verbessert sich die Leistung der neuen Methode tatsächlich erheblich im Vergleich zum ursprünglichen BERT und erreicht das Niveau von RoBERTa.

Zusammenfassung

In dieser Arbeit wurde diskutiert, wie viel Leistung transformatorbasierte Sprachmodelle in sehr rechenintensiven Umgebungen erreichen können. Glücklicherweise können wir durch verschiedene Modifikationsrichtungen eine gute Downstream-Leistung erzielen. Die Forscher hoffen, dass diese Arbeit eine Grundlage für weitere Verbesserungen liefern und die zahlreichen Verbesserungen und Techniken, die in den letzten Jahren für die Transformatorarchitektur vorgeschlagen wurden, theoretisch unterstützen kann.

Das obige ist der detaillierte Inhalt vonHerausforderung „Eine Karte pro Tag': RTX2080Ti bewältigt das Training großer Modelle und spart das 136-fache an Rechenleistung, und die akademische Gemeinschaft jubelt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr