Heim >Technologie-Peripheriegeräte >KI >Grundlagen des maschinellen Lernens: Wie kann eine Überanpassung verhindert werden?

Grundlagen des maschinellen Lernens: Wie kann eine Überanpassung verhindert werden?

- PHPznach vorne

- 2023-04-13 18:37:032116Durchsuche

Tatsächlich ist das Wesen der Regularisierung sehr einfach. Es handelt sich um ein Mittel oder eine Operation, die einem bestimmten Problem a priori Einschränkungen oder Einschränkungen auferlegt, um einen bestimmten Zweck zu erreichen. Der Zweck der Verwendung der Regularisierung in einem Algorithmus besteht darin, eine Überanpassung des Modells zu verhindern. Wenn es um die Regularisierung geht, denken viele Schüler möglicherweise sofort an die häufig verwendete L1-Norm und die L2-Norm. Bevor wir zusammenfassen, werfen wir zunächst einen Blick auf die LP-Norm.

LP-Norm

Norm kann einfach so verstanden werden, dass sie zur Darstellung des Abstands im Vektorraum verwendet wird, und die Definition des Abstands ist sehr abstrakt, solange sie nicht negativ erfüllt, reflexiv und trigonometrisch Die Ungleichung kann als Distanz bezeichnet werden.

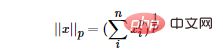

LP-Norm ist keine Norm, sondern eine Reihe von Normen, die wie folgt definiert ist:

Der Bereich von p ist [1,∞). p ist im Bereich von (0,1) nicht als Norm definiert, da es die Dreiecksungleichung verletzt.

Entsprechend der Änderung von pp weist die Norm auch unterschiedliche Änderungen auf. Ein klassisches Änderungsdiagramm der P-Norm wie folgt:

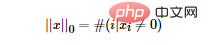

Dann stellt sich die Frage: Was ist die L0-Norm? Die L0-Norm stellt die Anzahl der Nicht-Null-Elemente im Vektor dar und wird wie folgt ausgedrückt:

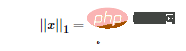

#🎜 🎜# Wie Sie der obigen Formel entnehmen können, ist die L1-Norm die Summe der Absolutwerte jedes Elements des Vektors, auch bekannt als „Sparse-Regeloperator“ (Lasso-Regularisierung). Die Frage ist also: Warum wollen wir eine Sparsifizierung? Die Sparsifizierung hat viele Vorteile, die beiden direktesten sind:

Wie Sie der obigen Formel entnehmen können, ist die L1-Norm die Summe der Absolutwerte jedes Elements des Vektors, auch bekannt als „Sparse-Regeloperator“ (Lasso-Regularisierung). Die Frage ist also: Warum wollen wir eine Sparsifizierung? Die Sparsifizierung hat viele Vorteile, die beiden direktesten sind:

- Interpretierbarkeit

- L2 Die Norm

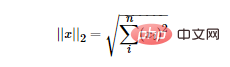

Die L2-Norm ist die euklidische Distanz. Die Formel lautet wie folgt:

Die L2-Norm hat viele Namen. Manche nennen ihre Regression „Ridge-Regression“, während andere sie „Weight Decay“ nennen. Durch die Verwendung der L2-Norm als Regularisierungsterm kann eine dichte Lösung erhalten werden, d Die Berücksichtigung des Trainingssatzes führt zu einer Überanpassung und verbessert dadurch die Generalisierungsfähigkeit des Modells.

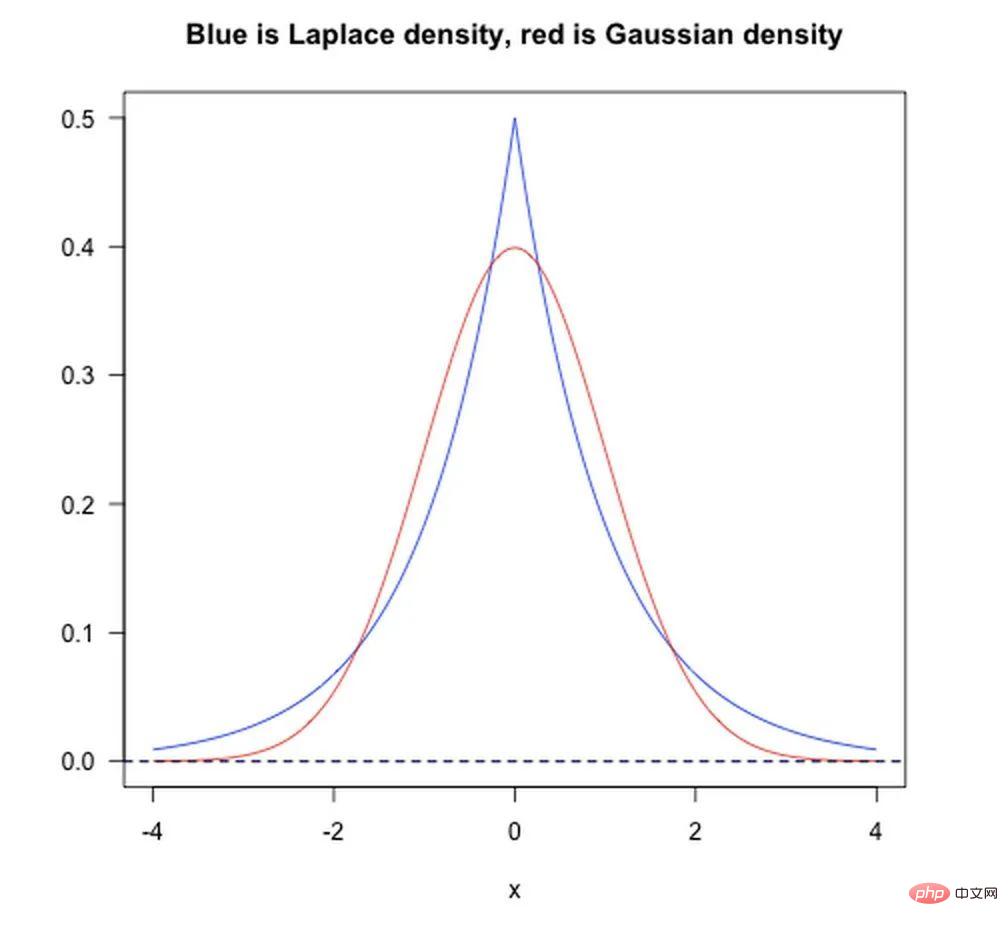

Aus bayesianischer Sicht reicht es beim Training eines Modells nicht aus, sich ausschließlich auf den aktuellen Trainingsdatensatz zu verlassen. Um bessere Generalisierungsfähigkeiten zu erreichen, ist es häufig erforderlich, vorherige Terme hinzuzufügen, und das Hinzufügen regulärer Terme ist gleichbedeutend mit A priori wurde hinzugefügt.

- L1-Norm entspricht dem Hinzufügen eines Laplaceschen Priors.

- L2-Norm entspricht dem Hinzufügen eines Gaußschen Priors.

Wie in der folgenden Abbildung gezeigt:

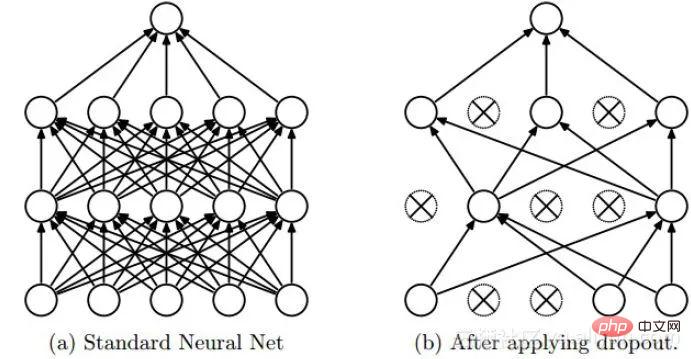

Dropout

Dropout ist eine Regularisierungsmethode, die häufig beim Deep Learning verwendet wird. Sein Ansatz kann einfach so verstanden werden, dass während des Trainingsprozesses von DNNs einige Neuronen mit der Wahrscheinlichkeit p verworfen werden, was bedeutet, dass die Ausgabe der verworfenen Neuronen 0 ist. Dropout kann wie in der folgenden Abbildung gezeigt instanziiert werden:

Wir können den Regularisierungseffekt von Dropout aus zwei Aspekten intuitiv verstehen:

- Der Vorgang des zufälligen Verlusts von Neuronen während jeder Runde des Dropout-Trainings entspricht mehreren DNNs gemittelt, so dass sie den Effekt einer Abstimmung haben, wenn sie zur Vorhersage verwendet werden.

- Reduzieren Sie die komplexe Koadaption zwischen Neuronen. Wenn die Neuronen der verborgenen Schicht zufällig gelöscht werden, wird das vollständig verbundene Netzwerk bis zu einem gewissen Grad spärlich, wodurch die Synergieeffekte verschiedener Funktionen effektiv verringert werden. Mit anderen Worten: Einige Funktionen basieren möglicherweise auf der gemeinsamen Aktion versteckter Knoten mit festen Beziehungen. Durch Dropout wird die Situation effektiv organisiert, in der einige Funktionen nur in Gegenwart anderer Funktionen wirksam sind, wodurch die Robustheit des neuronalen Netzwerks erheblich erhöht wird Sex.

Batch-Normalisierung

Batch-Normalisierung ist eine reine Normalisierungsmethode, die hauptsächlich zur Beschleunigung der Konvergenz des Netzwerks verwendet wird, aber auch einen gewissen Regularisierungseffekt hat.

Hier ist ein Verweis auf die Erklärung der Kovariatenverschiebung in der Zhihu-Antwort von Dr. Wei Xushen.

Hinweis: Der folgende Inhalt stammt aus der Zhihu-Antwort von Dr. ist konsistent“. Wenn sie inkonsistent sind, entstehen neue Probleme beim maschinellen Lernen, wie z. B. Transferlernen/Domänenanpassung usw. Die Kovariatenverschiebung ist ein Zweigproblem unter der Annahme einer inkonsistenten Verteilung. Dies bedeutet, dass die bedingten Wahrscheinlichkeiten des Quellraums und des Zielraums konsistent sind, ihre Grenzwahrscheinlichkeiten jedoch unterschiedlich sind. Wenn Sie sorgfältig darüber nachdenken, werden Sie feststellen, dass sich die Verteilung der Ausgabe jeder Schicht des neuronalen Netzwerks offensichtlich von der Verteilung der jeder Schicht entsprechenden Eingangssignale unterscheidet, da sie Operationen innerhalb der Schicht durchlaufen haben. und der Unterschied wird mit zunehmender Tiefe des Netzwerks größer, aber die Stichprobenbezeichnungen, die sie „angeben“ können, bleiben unverändert, was der Definition der Kovariatenverschiebung entspricht.

Die Grundidee von BN ist eigentlich recht intuitiv, da sich der Aktivierungseingabewert des neuronalen Netzwerks vor der nichtlinearen Transformation (X = WU + B, U ist die Eingabe) mit zunehmender Tiefe des Netzwerks allmählich verschiebt oder Änderungen (d. h. die oben erwähnte Kovariatenverschiebung). Der Grund für die langsame Konvergenz des Trainings liegt im Allgemeinen darin, dass sich die Gesamtverteilung allmählich der Ober- und Untergrenze des Wertebereichs der nichtlinearen Funktion nähert (für die Sigmoidfunktion bedeutet dies, dass der Aktivierungseingabewert X = WU + B ein großer negativer oder negativer Wert ist). positiver Wert ), was dazu führt, dass der Gradient des neuronalen Netzwerks auf niedriger Ebene während der Backpropagation verschwindet, was der wesentliche Grund dafür ist, dass das Training tiefer neuronaler Netzwerke immer langsamer konvergiert. BN verwendet eine bestimmte Standardisierungsmethode, um die Verteilung des Eingabewerts eines beliebigen Neurons in jeder Schicht des neuronalen Netzwerks mit einem Mittelwert von 0 und einer Varianz von 1 auf die Standardnormalverteilung zurückzusetzen, um das dadurch verursachte Problem der Gradientendispersion zu vermeiden Aktivierungsfunktion. Anstatt also zu sagen, dass die Rolle von BN darin besteht, Kovariatenverschiebungen zu mildern, ist es besser zu sagen, dass BN das Problem der Gradientendispersion lindern kann.

Normalisierung, Standardisierung und Regularisierung

Wir haben die Regularisierung bereits erwähnt, hier erwähnen wir kurz die Normalisierung und Standardisierung. Normalisierung: Das Ziel der Normalisierung besteht darin, eine bestimmte Zuordnungsbeziehung zu finden, um die Originaldaten dem Intervall [a, b] zuzuordnen. Im Allgemeinen nehmen a und b Kombinationen von [−1,1], [0,1] an. Im Allgemeinen gibt es zwei Anwendungsszenarien:

- Konvertieren Sie die Zahl in eine Dezimalzahl zwischen (0, 1)

- Konvertieren Sie die Dimensionszahl in eine dimensionslose Zahl.

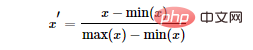

Häufig verwendete Min-Max-Normalisierung:

Standardisierung: Verwendung der Satz großer Zahlen zur Umwandlung der Daten in eine Standardnormalverteilung. Die Standardisierungsformel lautet:

Der Unterschied zwischen Normalisierung und Standardisierung:

Wir können es einfach so erklären: Die normalisierte Skalierung wird gleichmäßig auf das Intervall (nur durch Extremwerte bestimmt) „abgeflacht“, während die normalisierte Skalierung „elastischer“ und „dynamischer“ ist hat einen guten Zusammenhang mit der Verteilung der Gesamtstichprobe. Hinweis:

- Normalisierung: Die Skalierung bezieht sich nur auf die Differenz zwischen den Maximal- und Minimalwerten.

- Standardisierung: Die Skalierung bezieht sich auf jeden Punkt und spiegelt sich in der Varianz wider. Vergleichen Sie dies mit der Normalisierung, bei der alle Datenpunkte einen Beitrag leisten (über den Mittelwert und die Standardabweichung).

Warum Standardisierung und Normalisierung?

- Modellgenauigkeit verbessern: Nach der Normalisierung sind die Merkmale zwischen verschiedenen Dimensionen numerisch vergleichbar, was die Genauigkeit des Klassifikators erheblich verbessern kann.

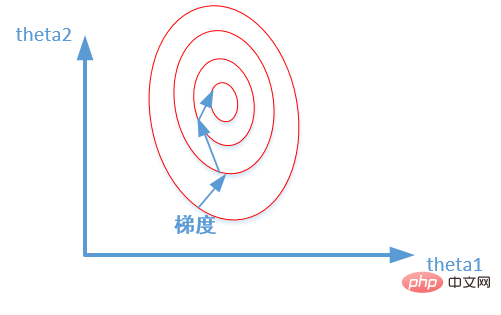

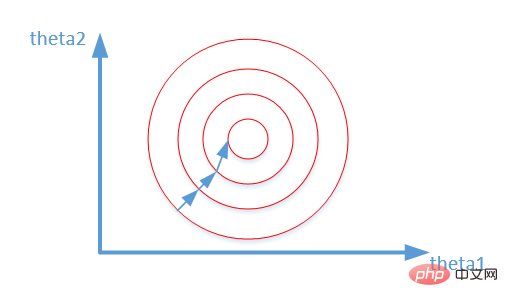

- Modellkonvergenz beschleunigen: Nach der Standardisierung wird der Optimierungsprozess der optimalen Lösung offensichtlich reibungsloser, was die korrekte Konvergenz zur optimalen Lösung erleichtert. Wie im Bild unten gezeigt:

Das obige ist der detaillierte Inhalt vonGrundlagen des maschinellen Lernens: Wie kann eine Überanpassung verhindert werden?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr