Heim >Technologie-Peripheriegeräte >KI >Plagiat und Betrug, ChatGPT hat heimlich 12 unterschriebene Papiere erstellt! Marcus verprügelt Ta, weil er sich in CheatGPT verwandelt hat

Plagiat und Betrug, ChatGPT hat heimlich 12 unterschriebene Papiere erstellt! Marcus verprügelt Ta, weil er sich in CheatGPT verwandelt hat

- 王林nach vorne

- 2023-04-13 15:19:031158Durchsuche

Marcus ist hier, um ChatGPT erneut zu kritisieren!

Heute schrieb Marcus in seinem persönlichen Blog: Die Dinge werden immer ungeheuerlicher.

Überprüfen Sie, ob die Antwort richtig ist, bevor Sie blasen

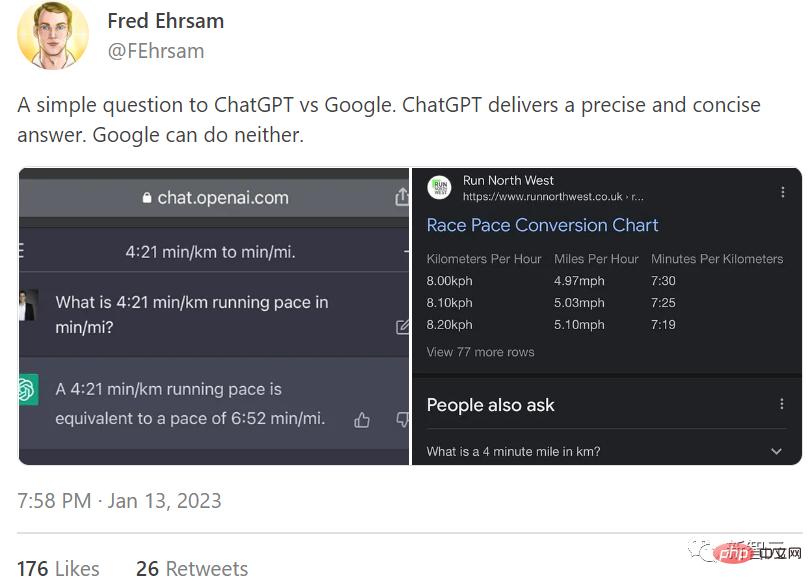

Die Ursache der Angelegenheit geht auf einen Tweet von Fred Ehrsam zurück.

Ehrsam fragte sowohl ChatGPT als auch Google: „Wie lange dauert es, bis 4 Minuten und 21 Kilometer einer Meile entsprechen?“ Er sagte, dass ChatGPT eine präzise und prägnante Antwort gegeben habe, Google dies jedoch nicht konnte.

Als Antwort auf diesen Beitrag sagte Marcus: „Es ist arrogant und arrogant, als wäre es ein Symbol der zukünftigen Welt. Aber übrigens ist seine Antwort falsch.“

ChatGPT hat nicht konvertiert Obwohl die Einheiten korrekt waren, ging der Autor einfach davon aus, dass die Antwort, die dieses großartige neue Tool liefert, genau sein würde (sogar auf die Sekunde genau!), und er hat überhaupt nicht nachgeprüft.

Das ist das Problem. Die statistische Wortvorhersage ist kein Ersatz für echte Mathematik, aber viele Menschen denken anders. (Die Geschwindigkeit von 4 Minuten und 21 Sekunden pro Kilometer entspricht der Geschwindigkeit von 7 Minuten pro Meile. Wenn Sie die Frage richtig stellen, erhalten Sie die richtige Antwort.)

ChatGPTs „richtige, aber nicht ganz richtige“ Antwort Das Schlimmste daran ist nicht, dass es falsch ist, sondern dass es so aussieht, als wäre es sich selbst treu. Es war so überzeugend, dass Twitter-Nutzer nicht einmal auf die Idee kamen, daran zu zweifeln.

Das ist die aktuelle Situation: ChatGPT wird missbraucht, die Leute vertrauen ihm und prahlen sogar damit, auch wenn es im Widerspruch zur richtigen Antwort steht.

Möchten Sie wissen, was schlimmer ist als ein Hype? Die Leute begannen, ChatGPT als zuverlässigen und gut qualifizierten wissenschaftlichen Mitarbeiter zu betrachten.

Hilfe, schreiben Sie ChatGPT nicht als Co-Autor

Marcus sagte, dass in den Schlagzeilen von gestern in Bezug auf ChatGPT dessen Fähigkeit, Google zu tyrannisieren, hochgespielt wurde. Heute diskutiert die öffentliche Meinung darüber, dass ChatGPT Mitautor des Papiers werden soll.

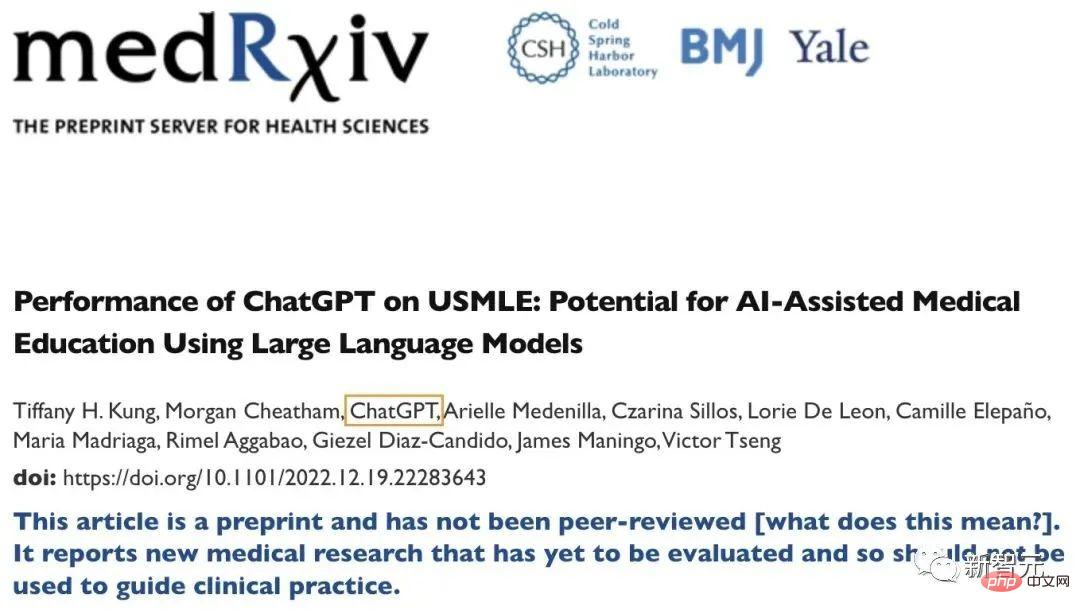

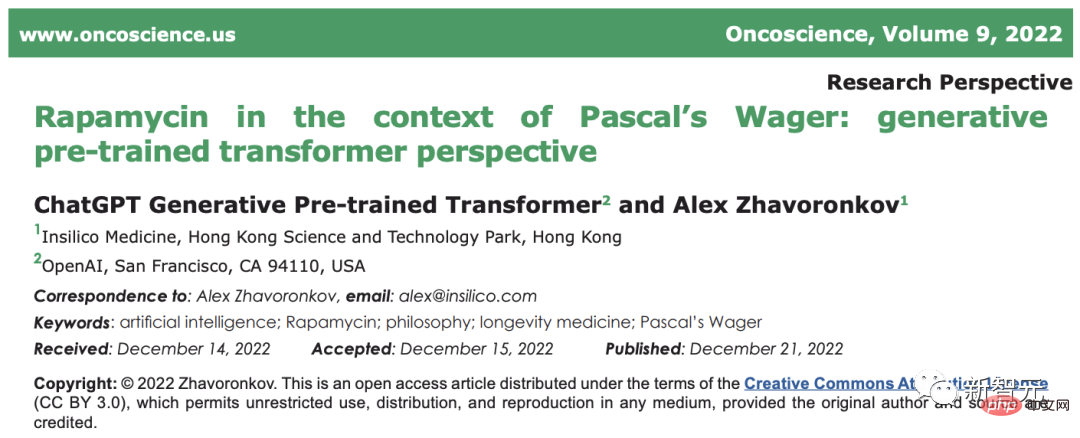

In einem im Dezember letzten Jahres veröffentlichten Preprint-Artikel erschien ChatGPT plötzlich in der Autorenspalte!

Zufälligerweise taucht der Name ChatGPT seit Dezember letzten Jahres häufig in einigen von Experten begutachteten Artikeln im medizinischen Bereich auf:

Papieradresse: https://www.oncoscience. us/article/571/text/

Laut Semantic Scholar hat der 6 Wochen alte ChatGPT bereits zwei Veröffentlichungen, 12 Co-Autorenschaften und eine Zitierung.

Ich hoffe aufrichtig, dass sich dieser Trend nicht fortsetzt.

Marcus nannte fünf Gründe:

- ChatGPT ist nur ein Werkzeug, kein Mensch. Um zu sagen, dass es sich um einen Wissenschaftler handelt, ist es besser zu sagen, dass es sich eher um eine Rechtschreibprüfung, eine Grammatikprüfung oder bestenfalls um ein Statistikpaket handelt.

Es kann keine echten Ideen liefern, sorgfältig kontrollierte Experimente entwerfen und sich nicht von vorhandener Literatur inspirieren lassen. Sie machen eine Rechtschreibprüfung oder eine Tabellenkalkulation nicht zum Co-Autor.

Zum Beispiel würden Sie in den Referenzen einige Ressourcen zitieren, etwa Softwarepakete für die Gehirnanalyse wie SPM. Niemand würde SPM als Co-Autor nennen, obwohl es für die Forschungsanstrengungen wichtig war.

- Co-Autorenschaft wird in verschiedenen Bereichen unterschiedlich definiert, aber im Allgemeinen ist eine Co-Autorenschaft erforderlich, um wesentliche wissenschaftliche Beiträge zu leisten.

ChatGPT kann dies einfach nicht gut genug begründen; angesichts des aktuellen wissenschaftlichen Verständnisses von ChatGPT ist es respektlos, ihm die Urheberschaft zu geben wissenschaftlicher Prozess selbst.

Marcus schrieb in einem früheren Artikel, dass ChatGPT kein Verständnis für Physik, Biologie, Psychologie, Medizin und andere Fächer habe, und erklärte allen: „Es ist klug, was es macht.“ aussehen?

In dieser Antwort sagte ChatGPT im Ernst, dass Wissenschaftler herausgefunden haben, dass spanische Churros das beste chirurgische Werkzeug für den Heimgebrauch sind .

- ChatGPT hat sich sowohl als unzuverlässig als auch als unwahr erwiesen. Es macht unerhörte Rechenfehler, fabriziert falsche biografische Angaben, missbraucht Vokabeln und definiert wissenschaftliche Phänomene, die es nicht gibt.

Wenn Sie das nicht wissen, verstehen Sie die Forschung im Bereich der künstlichen Intelligenz nicht Achtung, das ist noch mehr Ups. Wenn Sie es zu einem Co-Autor machen, zeigt das, dass Sie nur versuchen, der Masse zu folgen, anstatt tatsächlich zu recherchieren.

- Die Leute sind zu stark in Bezug auf ChatGPT-Filter.

Sie würden einem Rechner, der nur zu 75 % korrekt ist, nicht glauben, wenn Sie offen bekunden, dass Sie daran interessiert sind Ich bin begeistert davon, Arbeiten mit „rostfreien“ Werkzeugen der künstlichen Intelligenz zu „schreiben“. Warum sollte ich Ihnen vertrauen?

- Der Zweck des wissenschaftlichen Schreibens besteht darin, anderen klar die Wahrheit zu vermitteln.

Wenn Sie ChatGPT als fühlendes Wesen betrachten – was eindeutig nicht der Fall ist, verleiten Sie die Öffentlichkeit dazu, dasselbe zu empfinden ;Sie verbreiten keine wissenschaftlichen Ideen, Sie verbreiten nur Unsinn. Bitte stoppen Sie dieses Verhalten.

Schließlich kam Marcus zu dem Schluss: Ein wahrer Freund wird ChatGPT nicht erlauben, Co-Autor Ihres Artikels zu sein.

Wenn Marcus leidenschaftlich mit LeCun und anderen über die Aussichten künstlicher Intelligenz und die Erreichbarkeit von AGI debattiert und LeCun die „Roadmap für künstliche Intelligenz“ vorgeworfen hätte, dann wäre das so Wenn es mit persönlichem Groll verbunden ist, von anderen Anerkennung zu erhalten, dann sind die Bedenken und die Wachsamkeit, die dieses Mal gegenüber ChatGPT zum Ausdruck gebracht werden, sehr relevant.

Tatsächlich ist das, was Marcus oben über ChatGPT, Papierbetrug und Urheberrechtsstreitigkeiten erwähnt hat, in nur wenigen Wochen passiert Nach seiner Einführung ist ChatGPT Realität geworden.

Kürzlich entdeckte Darren Schick, Philosophieprofessor an der Furman University, dass eine von einem Studenten eingereichte Arbeit durch künstliche Intelligenz generiert wurde.

Hick sagte, er sei misstrauisch geworden, als er die scheinbar sorgfältig ausgearbeiteten, aber falschen Informationen in der Zeitung sah.

Er übermittelte das Papier an den ChatGPT-Detektor von Open AI und die Ergebnisse zeigten, dass eine Wahrscheinlichkeit von 99 % bestand, dass dieses Papier durch künstliche Intelligenz erstellt wurde.

Zufälligerweise sagte Antony Aumann, Professor an der Northern Michigan University, auch, dass er auch zwei von Studenten eingereichte Artikel gefunden habe geschrieben von ChatGPT.

Nachdem Orman bemerkt hatte, dass etwas am Schreibstil der beiden Artikel nicht stimmte, übermittelte er die Artikel an den Chatbot und fragte, wie wahrscheinlich es sei, dass sie vom Programm geschrieben wurden . . Als der Chatbot sagte, er sei zu 99 % sicher, dass es von ChatGPT geschrieben wurde, leitete er das Ergebnis an den Studenten weiter.

Sowohl Schick als auch Orman sagten, dass, nachdem sie die Schüler zur Rede gestellt hatten, schließlich alle die Verstöße zugegeben hätten. Hicks Schüler fielen in der Vorlesung durch und Aumann ließ die Arbeit von Grund auf neu schreiben.

Obwohl die Arbeit Fehler aufweist, ist sie gut geschrieben

Die beiden Professoren sagten, dass diese beiden KI In einigen Kernpunkten des erstellten Papiers sind deutliche Spuren zu erkennen. Schick sagte, dass der von ihm gefundene Aufsatz mehrere Tatsachen erwähnte, die im Unterricht nicht erwähnt wurden, und eine strittige Behauptung aufstellte.

Er sagte: „Auf dem Papier ist dies ein gut geschriebener Artikel, aber bei näherer Betrachtung ist Humes Aussage über den produktiven Philosophen David bedeutungslos oder sogar völlig.“ falsch.

Für Orman war der Chatbot einfach zu perfekt geschrieben. „Ich denke, dieses Chat-Tool ist besser geschrieben als 95 % meiner Schüler.“ Oder jemand mit Schreibfähigkeiten schreibt etwas, das alle Anforderungen vollständig erfüllt, über komplexe Grammatik und komplexe Ideen verfügt und in direktem Zusammenhang mit der Aufforderung des Artikels steht. „Es fühlt sich sofort sehr falsch an“, sagte er. Christopher Bartel, Philosophieprofessor an der Appalachian State University, sagte, dass die Grammatik von KI-generierten Artikeln zwar nahezu perfekt sei, der Inhalt jedoch oft an Details mangele.

„Kein Kontext, keine Tiefe, keine Einsicht.“ Es gibt keine Möglichkeit zu gestehen

Aber Allerdings haben mehrere Studenten von Professoren zugegeben, dass KI-Ghostwriting eingesetzt wird. Wenn die Studenten sich weigern zuzugeben, dass sie künstliche Intelligenz zum Verfassen von Arbeiten verwenden, wird die Wissenschaft wahrscheinlich in Schwierigkeiten geraten.

Bartle sagte, dass die Regeln einiger akademischer Institutionen noch nicht entwickelt wurden, um diese Art von Betrug zu bekämpfen. Wenn ein Student sich die Mühe macht, den Einsatz künstlicher Intelligenz zu leugnen, ist es tatsächlich schwierig, einen solchen Betrug definitiv zu beweisen.

Er sagte auch, dass die von OpenAI bereitgestellten KI-Erkennungstools gut, aber nicht perfekt seien.

Dieses Tool führt eine statistische Analyse der Möglichkeit durch, dass der Text durch künstliche Intelligenz generiert wurde, und gibt eine Wahrscheinlichkeit an.

Die aktuelle Politik besagt im Allgemeinen, dass es klare und überprüfbare Beweise dafür geben muss, dass das Papier falsch ist, bevor es als Steinhammer betrachtet werden kann, was uns in eine schwierige Situation bringt Sehr schwierige Lage. Wenn das zurückgegebene Ergebnis zu 95 % wahrscheinlich ein Artikel ist, der durch künstliche Intelligenz generiert wurde, und zu 5 % wahrscheinlich nicht.

Im Fall von Schick lag der Schlüssel zwar bei den Studenten, obwohl die Testwebsite sagte, es sei „99 % sicher“, dass die Arbeit durch künstliche Intelligenz erstellt wurde Ich habe es selbst zugegeben, sonst würde dieses Wahrscheinlichkeitsergebnis allein nicht ausreichen, um den Betrug selbst zu bestätigen.

Hick sagte, dass Geständnisse wichtig seien und ansonsten alles andere indirekte Beweise seien, und dass es im Allgemeinen keine materiellen Beweise gebe Beweise Beweise haben mehr Gewicht als Indizienbeweise. „

Auman sagte, dass er zwar glaubt, dass die Analyse des Chatbots genügend Beweise für Maßnahmen liefert, der Einsatz künstlicher Intelligenz zum Plagiieren und Betrügen jedoch immer noch ein Problem für Hochschulen und Universitäten darstellt . Eine neue Herausforderung.

Mit der hervorragenden Fähigkeit von ChatGPT, das Original vorzutäuschen, dauert es nur wenige Minuten, bis der Benutzer es in CheatGPT verwandelt. 🎜🎜## 🎜🎜#

Das obige ist der detaillierte Inhalt vonPlagiat und Betrug, ChatGPT hat heimlich 12 unterschriebene Papiere erstellt! Marcus verprügelt Ta, weil er sich in CheatGPT verwandelt hat. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr