Heim >Technologie-Peripheriegeräte >KI >Kann das Modell direkt an AGI angeschlossen werden, solange es „größer wird'? Marcus bombardiert erneut: Drei Krisen sind entstanden!

Kann das Modell direkt an AGI angeschlossen werden, solange es „größer wird'? Marcus bombardiert erneut: Drei Krisen sind entstanden!

- 王林nach vorne

- 2023-04-13 14:58:031695Durchsuche

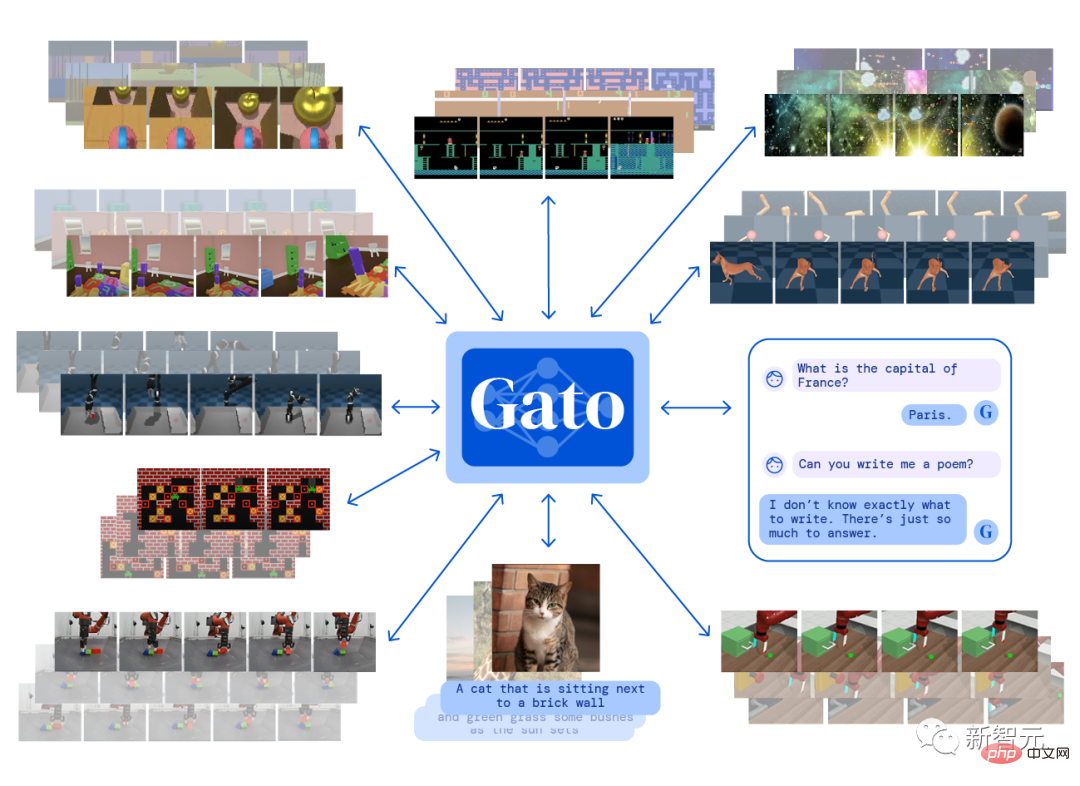

Im Mai dieses Jahres veröffentlichte DeepMind Gato, ein multimodales künstliches Intelligenzsystem, das mit nur einem Satz von Modellparametern mehr als 600 verschiedene Aufgaben gleichzeitig ausführen kann, was hitzige Diskussionen über allgemeine künstliche Intelligenz (AGI) in der Welt auslöste Industrie.

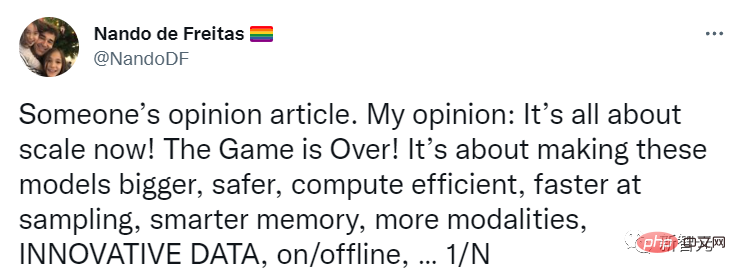

Auch Nando de Freitas, der Forschungsdirektor bei DeepMind, twitterte damals, dass KI verabschiedet werden kann, solange der Umfang weiter zunimmt!

Alles, was wir tun müssen, ist, das Modell größer, sicherer, recheneffizienter, schnellere Probenahme, intelligentere Speicherung, mehr Modalitäten, Innovationen bei Daten, online/offline usw. zu machen.

AGI kann durch die Lösung von Skalenproblemen erreicht werden. Die Branche muss diesen Problemen mehr Aufmerksamkeit schenken!

Kürzlich veröffentlichte Gary Marcus, ein bekannter KI-Wissenschaftler, Gründer und CEO von Robust.AI und emeritierter Professor an der New York University, einen weiteren Blog und argumentierte, dass diese Aussage „zu früh“ sei und eine Krise begonnen habe!

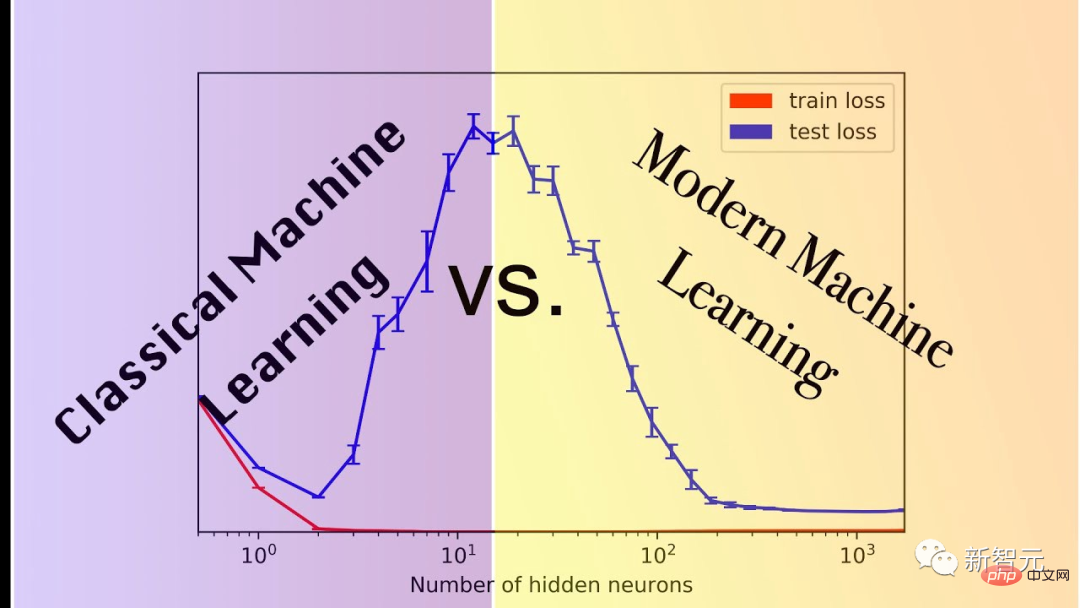

Marcus beobachtet weiterhin die Entwicklung der KI-Branche, steht dem KI-Hype jedoch kritisch gegenüber. Er hat Einwände geäußert wie „Deep Learning stößt an eine Wand“ und „GPT-3 ist völlig bedeutungslos“.

Was soll ich tun, wenn ich mit dem großen Modell nicht spielen kann?

Nando glaubt, dass künstliche Intelligenz keinen Paradigmenwechsel erfordert, sondern lediglich mehr Daten, höhere Effizienz und größere Server.

Marcus umschrieb diese Hypothese folgendermaßen: Ohne grundlegende neue Innovation könnte AGI aus größeren Modellen entstehen. Diese Annahme kann man auch Skalierung-über-alles nennen.

Seine Hypothese, die heute oft als Skalierungsmaximalismus bezeichnet wird, ist immer noch sehr beliebt, vor allem weil immer größere Modelle tatsächlich sehr leistungsfähig sind und Aufgaben wie die Bilderzeugung die Hilfe großer Modelle erfordern.

Aber das ist nur so weit.

Das Problem ist, dass einige der Technologien, die über Monate oder sogar Jahre verbessert wurden, tatsächlich bei weitem nicht den Umfang erreichen, den wir brauchen.

Es gibt immer mehr Ponzi-Systeme. Der durch die Skalierung erzielte Leistungsvorteil ist nur das Ergebnis empirischer Beobachtungen und kann nicht garantiert werden.

Marcus nennt drei aktuelle Anzeichen, die auf das Ende der Skalenmaximierungshypothese hinweisen könnten.

1. Es ist möglicherweise nicht genügend Datenvolumen auf der Welt vorhanden, um die maximale Skalierung zu unterstützen.

Viele Menschen machen sich darüber Sorgen.

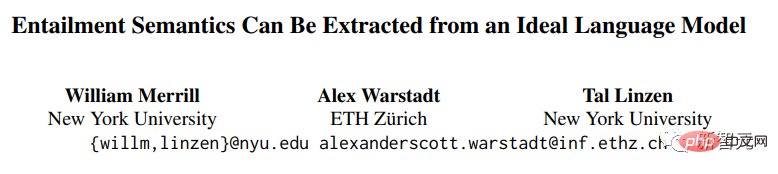

Die Forscher William Merrill, Alex Warstadt und Tal Linzen von der New York University und der ETH Zürich haben kürzlich einen Beweis dafür vorgelegt, dass „aktuelle neuronale Sprachmodelle nicht gut geeignet sind, die Semantik natürlicher Sprache ohne große Datenmengen zu extrahieren.“

Link zum Papier: https://arxiv.org/pdf/2209.12407.pdf

Dieser Beweis enthält zwar zu viele Voraussetzungen, um als Widerlegungsbeweis verwendet zu werden, aber wenn man dieser Annahme nahe kommt, könnte es welche geben sehr schnell echtes Problem im großen Maßstab.

2. Möglicherweise stehen weltweit nicht genügend Rechenressourcen zur Verfügung, um eine maximale Skalierung zu ermöglichen.

Miguel Solano hat Marcus kürzlich ein mitverfasstes Manuskript geschickt. Der Autor glaubt, dass das Erreichen aktueller Super-Benchmarks wie BIG-Bench im Jahr 2022 ein Viertel des Stromverbrauchs in den Vereinigten Staaten erfordern wird. 🔜 die mehr als 200 Missionen umfassen.

3. Einige wichtige Aufgaben sind möglicherweise einfach nicht skalierbar.

3. Einige wichtige Aufgaben sind möglicherweise einfach nicht skalierbar.

Der Maßstab spielt bei dieser Art von Aufgabe grundsätzlich keine Rolle. Selbst das beste Modell hat nur eine Genauigkeit von 80,6 %. Bei den meisten Modellen ist der Einfluss des Maßstabs bestenfalls vernachlässigbar.

Und Sie können sich leicht eine komplexere Version dieser Aufgabe vorstellen, bei der die Leistung des Modells weiter beeinträchtigt wird.

Was Marcus noch mehr traf, ist, dass selbst bei einer einzelnen wichtigen Aufgabe wie dieser eine Leistung von etwa 80 % bedeuten kann, dass ein großes Spiel nicht weiter gespielt werden kann.

Wenn das Modell nur Syntax und Semantik lernt, aber beim pragmatischen oder vernünftigen Denken versagt, erhalten Sie möglicherweise überhaupt keine vertrauenswürdige AGI.

„Moores Gesetz“ bringt uns nicht so weit wie ursprünglich erwartet. Bisher, so schnell , weil es nicht das Gesetz von Ursache und Wirkung im Universum ist und immer gelten wird.

Die Maximierung der Skalierung ist nur eine interessante Annahme. Sie wird es uns beispielsweise nicht ermöglichen, die oben genannten drei Probleme zu lösen, was uns zu einem Paradigmenwechsel zwingen wird.

Netizen Frank van der Velde sagte, dass Follower, die die Größe maximieren, dazu neigen, vage Begriffe wie „groß“ und „mehr“ zu verwenden.

Die von Deep-Learning-Modellen verwendeten Trainingsdaten sind im Vergleich zu den Trainingsdaten, die Menschen beim Erlernen von Sprachen verwenden, zu groß.

Aber im Vergleich zur realen semantischen Sammlung menschlicher Sprache sind diese sogenannten Massendaten immer noch unbedeutend. Um einen Satz pro Sekunde zu generieren, würde es 300 Jahre dauern Trainingsset.

Netizen Rebel Science hat sogar unverblümt gesagt, dass die Maximierung der Skalierung keine interessante, sondern eine dumme Hypothese ist. Sie wird nicht nur auf der KI-Strecke verlieren, sondern auch auf hässliche Weise sterben.

Maßstabsmaximierung ist zu extrem

Raphaël Millière, Dozent am Institut für Philosophie der Columbia University und Ph.D. an der Universität Oxford, äußerte auch einige seiner eigenen Meinungen, als der Kampf um die „Maßstabsmaximierung“ am heftigsten war.

Die Maximierung der Skalierung galt einst als Schwerpunkt von Deep-Learning-Kritikern (wie Gary Marcus), und als sich Brancheninsider wie Nando de Freitas und Alex Dimakis an der Debatte beteiligten, gerieten die beiden Seiten in Konflikt.

Die Reaktionen der Praktiker sind überwiegend gemischt, aber nicht zu negativ. Gleichzeitig wurde der Prognosetermin für die AGI-Implementierung auf der Prognoseplattform Metaculus auf einen historischen Tiefstand (Mai 2028) vorverlegt, was die Glaubwürdigkeit der Maximierung ebenfalls erhöhen könnte Maßstab.

Das wachsende Vertrauen der Menschen in „Maßstab“ könnte auf die Veröffentlichung neuer Modelle zurückzuführen sein, wie zum Beispiel auf den Erfolg von PaLM, DALL-E 2, Flamingo und Gato, der das Feuer der Maximierung des Maßstabs weiter angeheizt hat.

Suttons „Bitter Lesson“ verwirft viele Punkte in der Diskussion über die Maximierung der Skalierung, aber sie sind nicht völlig gleichwertig. Er glaubt, dass die Integration menschlichen Wissens in Modelle der künstlichen Intelligenz (z. B. Feature Engineering) weniger effizient ist als die Nutzung von Daten und Berechnungen effizient lernen.

Link zum Artikel: http://www.incompleteideas.net/IncIdeas/BitterLesson.html

Obwohl nicht ohne Kontroversen, scheint Suttons Ansicht deutlich weniger radikal zu sein als die Skalenmaximierung.

Es betont zwar die Bedeutung des Maßstabs, reduziert aber nicht jedes Problem in der KI-Forschung auf eine bloße Herausforderung des Maßstabs.

Tatsächlich ist es schwierig, die spezifische Bedeutung der Skalierungsmaximierung zu bestimmen. Wörtlich bedeutet „Skalierung ist alles, was Sie brauchen“, dass wir AGI ohne Algorithmusinnovation oder Architekturänderungen implementieren und bestehende Modelle erweitern und mehr Daten erzwingen können eingegeben werden.

Diese wörtliche Erklärung erscheint lächerlich: Selbst Modelle wie Palm, DALL-E 2, Flamingo oder Gato erfordern immer noch architektonische Änderungen gegenüber früheren Ansätzen.

Es wäre wirklich überraschend, wenn jemand tatsächlich denken würde, wir könnten einen serienmäßigen autoregressiven Transformator auf AGI erweitern.

Es ist unklar, wie viel algorithmische Innovation Menschen, die an die Maximierung der Skalierung glauben, der Meinung sind, dass AGI erforderlich ist, was es aus dieser Perspektive auch schwierig macht, falsifizierbare Vorhersagen zu generieren.

Skalierung mag eine notwendige Voraussetzung für den Aufbau eines Systems sein, das die Bezeichnung „allgemeine künstliche Intelligenz“ verdient, aber wir sollten Notwendigkeit nicht mit einer hinreichenden Bedingung verwechseln.

Das obige ist der detaillierte Inhalt vonKann das Modell direkt an AGI angeschlossen werden, solange es „größer wird'? Marcus bombardiert erneut: Drei Krisen sind entstanden!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr