Heim >Technologie-Peripheriegeräte >KI >Gemeinsam produziert von Qingbei! Eine Umfrage zum Verständnis der Besonderheiten des „Transformer+Reinforcement Learning'

Gemeinsam produziert von Qingbei! Eine Umfrage zum Verständnis der Besonderheiten des „Transformer+Reinforcement Learning'

- PHPznach vorne

- 2023-04-13 14:01:031182Durchsuche

Seit seiner Veröffentlichung hat sich das Transformer-Modell schnell zu einer gängigen neuronalen Architektur im Bereich der Verarbeitung natürlicher Sprache und Computer Vision in überwachten Lernumgebungen entwickelt.

Obwohl die Begeisterung für Transformer aufgrund der Eigenschaften von RL selbst begonnen hat, sich über den Bereich Reinforcement Learning auszubreiten B. die Notwendigkeit eindeutiger Merkmale, Architekturdesign usw., die aktuelle Kombination aus Transformer und Verstärkungslernen ist nicht reibungslos und es fehlen relevante Papiere für eine umfassende Zusammenfassung auf dem Entwicklungsweg.

Kürzlich veröffentlichten Forscher der Tsinghua-Universität, der Peking-Universität und Tencent gemeinsam einen Forschungsbericht über die Kombination von Transformer und Reinforcement Learning, in dem sie die Anwendung von Reinforcement Learning systematisch überprüften. Die Motivation und Entwicklungsgeschichte des Einsatzes von Transformer beim Lernen.

Papierlink: https://arxiv.org/pdf/2301.03044.pdf#🎜 🎜#

Der Artikel ordnet bestehende verwandte Arbeitsergebnisse ein, führt ausführliche Diskussionen zu jedem Teilgebiet und fasst abschließend die Zukunftsaussichten dieser Forschungsrichtung zusammen.

Transformer mit RLReinforcement Learning (RL) bietet eine mathematische Form für sequentielle Entscheidungsfindung, die das Modell automatisch intelligent werden lassen kann Verhalten.

RL bietet einen allgemeinen Rahmen für lernbasierte Steuerung. Mit der Einführung tiefer neuronaler Netze wurde in jüngster Zeit auch die Vielseitigkeit des tiefen Verstärkungslernens (DRL) erreicht Jahrelang wurden enorme Fortschritte erzielt, aber Probleme mit der Probeneffizienz behindern die weitverbreitete Anwendung von DRL in der realen Welt.

Um dieses Problem zu lösen, besteht ein wirksamer Mechanismus darin, eine induktive Vorspannung in das DRL-Framework einzuführen. Der wichtigere ist die Wahl der Funktions-Approximator-Architektur ), wie etwa die Parametrisierung neuronaler Netze für DRL-Agenten.

Das Problem der Auswahl des Architekturdesigns in DRL im Vergleich zu dem im überwachten Lernen (SL) ist jedoch immer noch nicht vollständig erforscht, und die meisten vorhandenen Arbeiten zu RL-Architekturen waren es motiviert durch den Erfolg der (halb-)überwachten Lerngemeinschaft.

Eine gängige Praxis zum Umgang mit hochdimensionalen bildbasierten Eingaben in DRL ist beispielsweise die Einführung von Convolutional Neural Networks (CNN); Teilweise Beobachtbarkeit Der Ansatz besteht in der Einführung wiederkehrender neuronaler Netze (RNN).

In den letzten Jahren hat die Transformer-Architektur das Lernparadigma in einer Vielzahl von SL-Aufgaben revolutioniert und eine überlegene Leistung gegenüber CNN und RNN gezeigt Architektur kann längere Abhängigkeiten mit hervorragender Skalierbarkeit modellieren.

Inspiriert durch den Erfolg von SL ist das Interesse der Branche an der Anwendung von Transformer beim verstärkenden Lernen stark gestiegen. Dies lässt sich auf einen Artikel aus dem Jahr 2018 zurückführen, in dem das Selbst -Aufmerksamkeitsmechanismus war relationales Denken für strukturierte Zustandsdarstellungen.

Danach begannen viele Forscher, Selbstaufmerksamkeit auf das Repräsentationslernen anzuwenden, um Beziehungen zwischen Entitäten zu extrahieren, was zu einem besseren politischen Lernen führen kann.

Zusätzlich zum Lernen der Zustandsdarstellung wurde in früheren Arbeiten auch Transformer verwendet, um die zeitliche Abhängigkeit mehrerer Schritte zur Adressierung zu erfassen einige Probleme mit der Beobachtbarkeit.

In letzter Zeit hat Offline-RL aufgrund seiner Fähigkeit, große Offline-Datensätze zu nutzen, auch Aufmerksamkeit erregt. Verwandte Forschungsergebnisse zeigen auch, dass die Transformer-Architektur direkt als verwendet werden kann ein Modell zur Reihenfolgeentscheidung und kann auf mehrere Aufgaben und Domänen verallgemeinert werden.

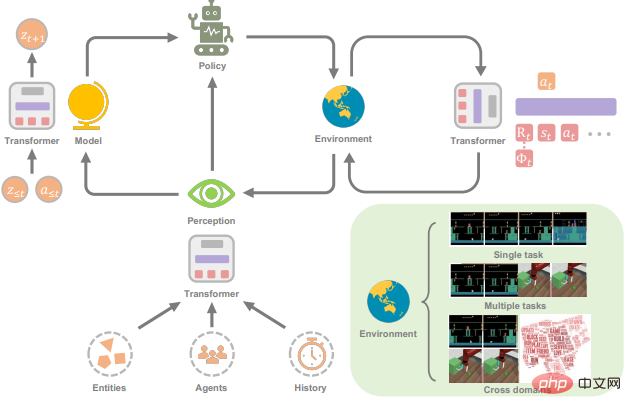

Der Zweck dieser Forschungsarbeit besteht darin, das Gebiet der Transformers in Reinforcement Learning (TransformRL) vorzustellen.

Obwohl Transformer als Basismodell für die meisten aktuellen SL-Forschungen gilt, wird es in der RL-Community noch weniger erforscht. Im Vergleich zum SL-Feld erfordert die Verwendung von Transformer als Funktionsnäherung in RL tatsächlich die Lösung einiger anderer Probleme:

1 Die Trainingsdaten von RL-Agenten sind normalerweise a Funktion der aktuellen Richtlinie, die zu Nichtstationarität (Nichtstationarität) im Transformer-Lernprozess führt.

2 Bestehende RL-Algorithmen reagieren normalerweise sehr empfindlich auf Designentscheidungen während des Trainingsprozesses, einschließlich Netzwerkarchitektur und -kapazität.

3 Transformer-basierte Architekturen leiden oft unter hohen Rechen- und Speicherkosten, was bedeutet, dass Training und Inferenz langsam und teuer sind.

Beispielsweise wirkt sich in einigen Fällen künstlicher Intelligenz in Spielen die Effizienz der Probengenerierung stark auf die Trainingsleistung aus, abhängig vom Netzwerk und Wert der RL-Richtlinie Berechnen Sie die Kosten.

Die Zukunft von TransformRL

Der Fortschritt von Transformers für RL wird im Artikel kurz besprochen. Zu seinen Vorteilen gehören hauptsächlich: #🎜 🎜#

1 Transformers können als leistungsstarkes Modul in RL verwendet werden, beispielsweise als Darstellungsmodul oder Weltmodell; 2. Transformer Kann als Sequenzentscheider verwendet werden;

3. Transformer kann die Generalisierungsleistung über Aufgaben und Domänen hinweg verbessern.

Angesichts der Tatsache, dass Transformer in der breiteren Gemeinschaft der künstlichen Intelligenz eine starke Leistung gezeigt hat, glauben die Forscher, dass die Kombination von Transformer und RL eine vielversprechende Forschungsrichtung ist, wie im Folgenden einige Zukunftsaussichten aufgeführt und offene Fragen in diese Richtung.

Kombination von Reinforcement Learning und (selbst-)überwachtem Lernen

Nachverfolgung Mit der Entwicklung von TransformRL kann festgestellt werden, dass seine Trainingsmethode sowohl RL als auch (selbst-)überwachtes Lernen abdeckt.

Bei Verwendung als Darstellungsmodul, das unter einem herkömmlichen RL-Framework trainiert wird, ist die Optimierung der Transformer-Architektur normalerweise instabil. Das Paradigma des (selbst)überwachten Lernens kann das tödliche Triadenproblem beseitigen, wenn Transformer zur Lösung von Entscheidungsproblemen durch Sequenzmodellierung verwendet werden.

Im Rahmen des (selbst)überwachten Lernens wird die Leistung der Strategie stark durch die Qualität der Offline-Daten eingeschränkt, und es gibt eine klare Unterscheidung zwischen Ausbeutung und Erkundung Der Kompromiss besteht nicht mehr, sodass bessere Richtlinien erlernt werden können, wenn RL und (selbst)überwachtes Lernen beim Transformer-Lernen kombiniert werden.

Einige Arbeiten haben beaufsichtigte Vortrainings- und Feinabstimmungslösungen für die RL-Teilnahme ausprobiert, aber bei relativ festen Strategien wird die Erkundung begrenzt sein, was ebenfalls einen Engpass darstellt gelöst werden Eine der Fragen.

Außerdem sind die zur Leistungsbewertung verwendeten Aufgaben relativ einfach. Transfomer kann dieses (selbst)überwachte Lernen auf größere Datensätze und komplexere Umgebungen skalieren Auch reale Anwendungen verdienen eine weitere Erforschung.

Darüber hinaus hoffen die Forscher, dass zukünftige Arbeiten mehr theoretische und empirische Einblicke in die Bedingungen liefern werden, unter denen solches (selbst-)überwachtes Lernen voraussichtlich gute Leistungen erbringen wird.

Verbinden Sie Online- und Offline-Lernen durch Transformer

Der Einstieg in Offline-RL ist ein Meilenstein für TransformRL, aber tatsächlich ist die Nutzung von Transformer zur Erfassung von Abhängigkeiten in Entscheidungssequenzen und zur Abstraktion von Strategien hauptsächlich mit der beträchtlichen Menge der verwendeten Offline-Daten verbunden .

Für einige Entscheidungsaufgaben ist es jedoch nicht möglich, in praktischen Anwendungen auf das Online-Framework zu verzichten.Einerseits ist es bei manchen Aufgaben nicht so einfach, an Expertendaten zu kommen, andererseits sind manche Umgebungen offen (wie Minecraft), Das bedeutet, dass Strategien kontinuierlich angepasst werden müssen, um Aufgaben zu bewältigen, die bei Online-Interaktionen nicht auftreten.

Forscher glauben daher, dass es notwendig ist, Online-Lernen und Offline-Lernen zu verbinden. Die meisten Forschungsfortschritte nach Decision Transformer konzentrieren sich auf Offline-Lernrahmen und einige Arbeitsversuche, das Paradigma des Offline-Vortrainings und der Online-Feinabstimmung zu übernehmen. Die Verteilungsverschiebung bei der Online-Feinabstimmung besteht jedoch immer noch bei Offline-RL-Algorithmen, und Forscher erwarten, dieses Problem durch einige spezielle Designs des Entscheidungstransformators zu lösen. Darüber hinaus ist es eine interessante offene Frage, wie man einen Online-Entscheidungstransformator von Grund auf trainiert. Auf Entscheidungsprobleme zugeschnittene Transformer-Struktur Die aktuelle Transformer-Struktur in der Methodenreihe Decision Transformer ist hauptsächlich Vanilla Transformer, der ursprünglich für Textsequenzen entwickelt wurde und möglicherweise einige Funktionen aufweist, die nicht geeignet sind für die Entscheidungsfindung Art des Problems. Ist es beispielsweise angemessen, einen Vanilla-Selbstaufmerksamkeitsmechanismus für Trajektoriensequenzen zu verwenden? Müssen verschiedene Elemente in einer Entscheidungssequenz oder verschiedene Teile desselben Elements bei der Positionseinbettung unterschieden werden? Da es darüber hinaus viele Varianten der Darstellung von Trajektorien als Sequenzen in verschiedenen Decision Transformer-Algorithmen gibt, mangelt es immer noch an systematischer Forschung, wie daraus ausgewählt werden kann. Wie wählt man beispielsweise robuste Hintsight-Informationen aus, wenn man solche Algorithmen in der Industrie einsetzt? Und der Vanilla-Transformer ist auch eine rechenintensive Struktur, was ihn sowohl in der Trainings- als auch in der Inferenzphase teuer macht und einen hohen Speicherbedarf hat, was auch die Länge der Abhängigkeiten begrenzt, die er erfassen kann. Um diese Probleme zu lindern, haben einige NLP-Arbeiten die Struktur von Transformer verbessert, es lohnt sich jedoch auch zu untersuchen, ob eine ähnliche Struktur für Entscheidungsprobleme verwendet werden kann. Verwenden Sie Transformers, um allgemeinere Agenten zu implementieren Die Überprüfung von Transformers für generalistische Agenten im Artikel hat das Potenzial von Transformers als allgemeine Strategie gezeigt. Tatsächlich ermöglicht das Design von Transformer die Verarbeitung mehrerer Modalitäten (wie Bilder, Videos, Text und Sprache) unter Verwendung eines ähnlichen Ansatzes zur Verarbeitung von Blöcken und zeigt eine hervorragende Skalierbarkeit für Netzwerke mit extrem großer Kapazität und große Datenmengen. Jüngste Arbeiten haben auch erhebliche Fortschritte bei der Schulung von Agenten gemacht, die in der Lage sind, multimodale und domänenübergreifende Aufgaben auszuführen. Angesichts der Tatsache, dass diese Agenten auf große Datensätze trainiert werden, ist noch nicht sicher, ob sie sich den Datensatz einfach merken und ob sie effektiv verallgemeinern können. Daher ist es immer noch eine Frage, die es wert ist, untersucht zu werden, wie man einen Agenten lernt, der ohne starke Annahmen auf ungesehene Aufgaben verallgemeinern kann. Darüber hinaus sind Forscher auch neugierig, ob Transformer leistungsstark genug ist, um ein allgemeines Weltmodell zu erlernen, das für verschiedene Aufgaben und Szenarien verwendet werden kann. RL für Transformers Obwohl in dem Artikel erläutert wurde, wie RL vom Transformer-Modell profitieren kann, ist die Verwendung von RL zur Verbesserung des Transformer-Trainings immer noch ein interessantes offenes Problem, das noch nicht gut erforscht ist . Wie Sie sehen können, kann das aktuelle Reinforcement Learning from Human Feedback (RLHF) ein Belohnungsmodell lernen und den RL-Algorithmus verwenden, um den Transformer zu optimieren, um das Sprachmodell mit menschlichen Absichten in Einklang zu bringen. In Zukunft glauben Forscher, dass RL ein nützliches Werkzeug sein kann, um die Leistung von Transformer in anderen Bereichen weiter zu verbessern.

Das obige ist der detaillierte Inhalt vonGemeinsam produziert von Qingbei! Eine Umfrage zum Verständnis der Besonderheiten des „Transformer+Reinforcement Learning'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr