Heim >Technologie-Peripheriegeräte >KI >Der Single-View-NeRF-Algorithmus S^3-NeRF verwendet Multi-Beleuchtungsinformationen, um Szenengeometrie und Materialinformationen wiederherzustellen.

Der Single-View-NeRF-Algorithmus S^3-NeRF verwendet Multi-Beleuchtungsinformationen, um Szenengeometrie und Materialinformationen wiederherzustellen.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-13 10:58:021529Durchsuche

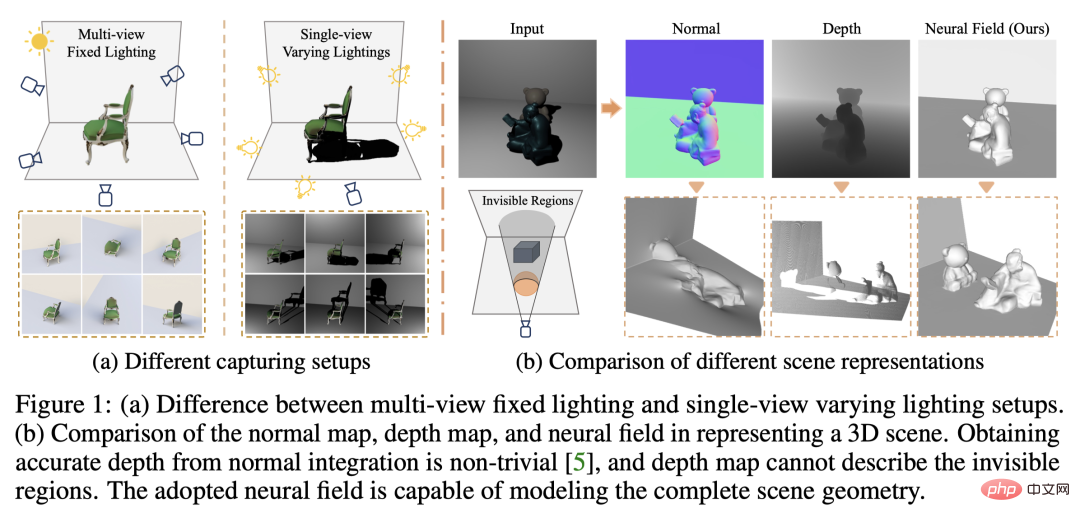

Aktuelle Bild-3D-Rekonstruktionsarbeiten verwenden normalerweise eine Multi-View-Stereo-Rekonstruktionsmethode (Multi-View-Stereo), die die Zielszene aus mehreren Blickwinkeln (Multi-View) unter konstanten natürlichen Lichtbedingungen erfasst. Diese Methoden gehen jedoch normalerweise von Lambertschen Oberflächen aus und haben Schwierigkeiten, hochfrequente Details wiederherzustellen.

Eine andere Methode der Szenenrekonstruktion besteht darin, Bilder zu verwenden, die unter einem festen Blickwinkel, aber unterschiedlichen Punktlichtquellen aufgenommen wurden. Photometrische Stereomethoden nutzen beispielsweise diesen Aufbau und nutzen seine Schattierungsinformationen, um die Oberflächendetails von Nicht-Lambertschen Objekten zu rekonstruieren. Bestehende Einzelansichtsmethoden verwenden jedoch normalerweise Normalkarten oder Tiefenkarten zur Darstellung sichtbarer Oberflächen, wodurch sie nicht in der Lage sind, die Rückseite von Objekten und verdeckten Bereichen zu beschreiben und nur die 2,5D-Szenengeometrie zu rekonstruieren. Darüber hinaus können Normalkarten keine Tiefendiskontinuitäten verarbeiten.

In einer aktuellen Studie schlugen Forscher der University of Hong Kong, der Chinese University of Hong Kong (Shenzhen), der Nanyang Technological University und des MIT-IBM Watson AI Lab vor, mehrere Lichtquellen (Single-View) zu verwenden. (Ansicht, Mehrfachbeleuchtung) von Bildern, um eine vollständige 3D-Szene zu rekonstruieren.

- Papier-Link: https://arxiv.org/abs/2210.08936

- Papier-Homepage: https://ywq.github.io/s3nerf/

- Code-Link : https://github.com/ywq/s3nerf

Im Gegensatz zu bestehenden Single-View-Methoden, die auf Normalkarten oder Tiefenkarten basieren, basiert S3-NeRF auf neuronalen Szenen Neuronale Szenendarstellung unter Verwendung von Schattierungs- und Schatteninformationen in der Szene, um die gesamte 3D-Szene (einschließlich sichtbarer/unsichtbarer Bereiche) zu rekonstruieren. Methoden zur Darstellung neuronaler Szenen verwenden mehrschichtige Perzeptrone (MLPs), um einen kontinuierlichen 3D-Raum zu modellieren und 3D-Punkte Szenenattributen wie Dichte, Farbe usw. zuzuordnen. Obwohl die Darstellung neuronaler Szenen bei der Rekonstruktion mehrerer Ansichten und der Synthese neuer Ansichten erhebliche Fortschritte gemacht hat, wurde sie bei der Modellierung von Einzelansichtsszenen weniger erforscht. Im Gegensatz zu bestehenden, auf der Darstellung neuronaler Szenen basierenden Methoden, die auf der Konsistenz von Fotos mit mehreren Ansichten basieren, optimiert S3-NeRF hauptsächlich das neuronale Feld durch die Verwendung von Schattierungs- und Schatteninformationen unter einer einzigen Ansicht.

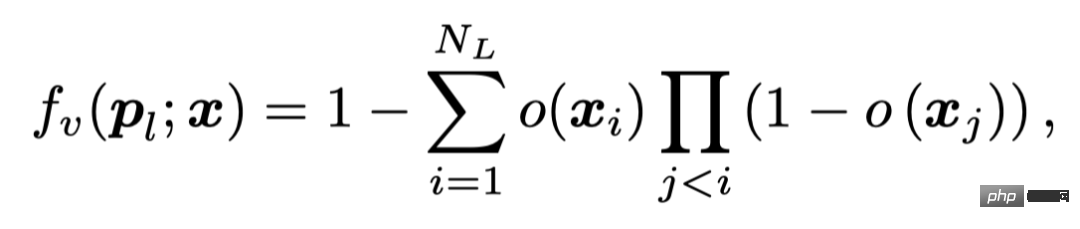

Wir haben festgestellt, dass die einfache Eingabe von Informationen zur Lichtquellenposition direkt in NeRF als Eingabe die Geometrie und das Erscheinungsbild der Szene nicht rekonstruieren kann. Um die aufgenommenen fotometrischen Stereobilder besser zu nutzen, modellieren wir explizit die Oberflächengeometrie und BRDF mithilfe eines Reflexionsfelds und berechnen die Farbe der 3D-Punkte der Szene mithilfe eines physikalisch basierten Renderings zweidimensionales Pixel, das dem Strahl entspricht. Gleichzeitig führen wir eine differenzierbare Modellierung der Sichtbarkeit der Szene durch und berechnen die Sichtbarkeit des Punktes, indem wir die Strahlen zwischen dem 3D-Punkt und der Lichtquelle verfolgen. Die Berücksichtigung der Sichtbarkeit aller Abtastpunkte auf einem Strahl ist jedoch rechenintensiv. Deshalb optimieren wir die Schattenmodellierung, indem wir die Sichtbarkeit von Oberflächenpunkten berechnen, die wir durch Strahlverfolgung erhalten.

Szenendarstellung basierend auf neuronalem Reflexionsfeld

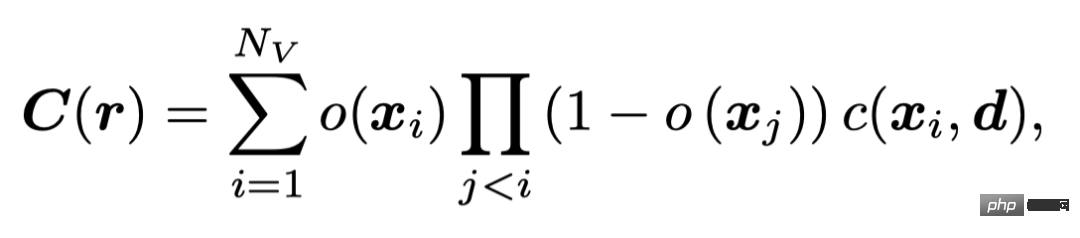

Wir verwenden ein Belegungsfeld ähnlich wie UNISURF, um die Szenengeometrie zu charakterisieren. UNISURF ordnet die 3D-Punktkoordinaten und die Sichtlinienrichtung über MLP dem Belegungswert und der Farbe des Punkts zu und erhält die Farbe des Pixels durch Stereo-Rendering,

Nv Upsampling jeder Strahl Die Anzahl der Punkte.

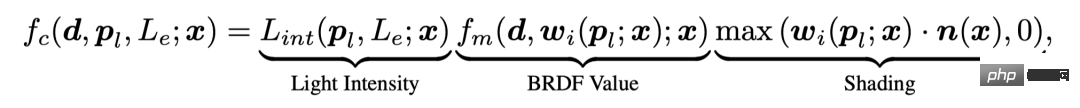

Um die Schattierungsinformationen in fotometrischen Stereobildern effektiv zu nutzen, modelliert S3-NeRF explizit das BRDF der Szene und verwendet physikalisch basiertes Rendering, um die Farbe von 3D-Punkten zu erhalten. Gleichzeitig modellieren wir die Lichtsichtbarkeit von 3D-Punkten in der Szene, um die reichhaltigen Schattenhinweise im Bild zu nutzen, und erhalten den endgültigen Pixelwert durch die folgende Gleichung.

Physikalisch basiertes Rendering-Modell

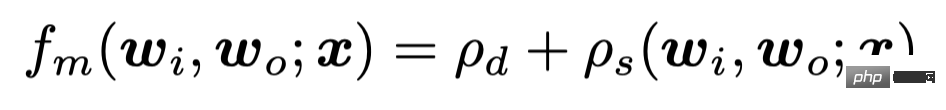

Unser Ansatz berücksichtigt nicht-Lambertsche Oberflächen und räumlich variierende BRDFs. Der Wert des Punktes x, der aus der Sichtlinienrichtung d unter der Nahfeld-Punktlichtquelle (pl, Le) beobachtet wird, kann ausgedrückt werden als

Unter anderem betrachten wir das Lichtdämpfungsproblem des Punktes Lichtquelle, durch den Lichtquellenpunkt. Die Entfernung berechnet die Intensität des auf diesen Punkt einfallenden Lichts. Wir verwenden ein BRDF-Modell, das diffuse und spiegelnde Reflexion berücksichtigt

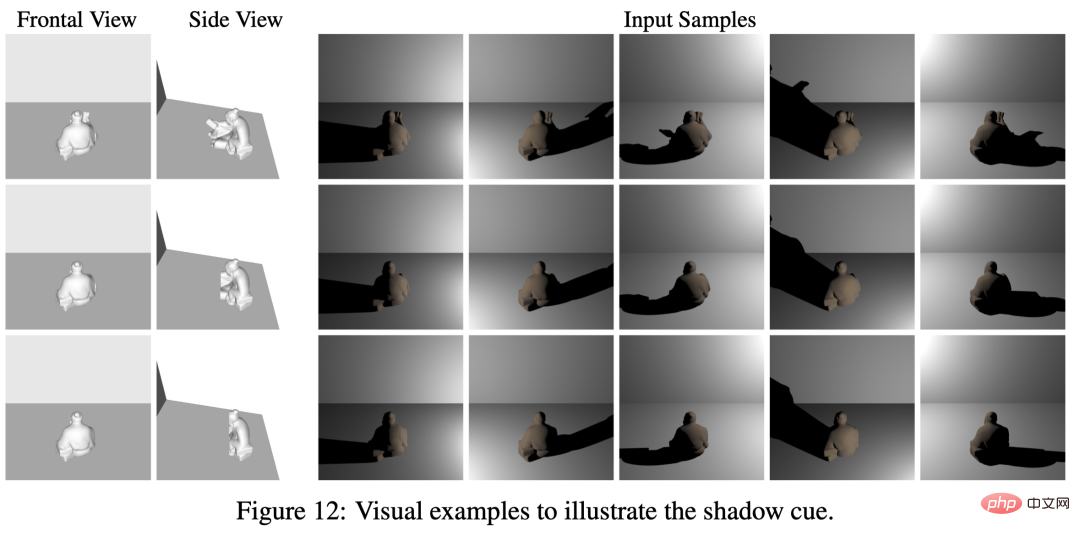

, um spiegelnde Reflexion durch eine gewichtete Kombination von Sphären-Gauß-Basis darzustellen. Schattenmodellierung. Schatten in der Szenengeometrie. Einer der entscheidenden Hinweise im Wiederaufbau. Die drei Objekte auf dem Bild haben in der Vorderansicht die gleiche Form und das gleiche Aussehen, auf der Rückseite jedoch unterschiedliche Formen. Durch die bei unterschiedlicher Beleuchtung erzeugten Schatten können wir beobachten, dass die Formen der Schatten unterschiedlich sind, was die geometrischen Informationen der unsichtbaren Bereiche in der Vorderansicht widerspiegelt. Das Licht erzeugt durch die im Hintergrund reflektierten Schatten bestimmte Einschränkungen auf der Rückseite des Objekts.

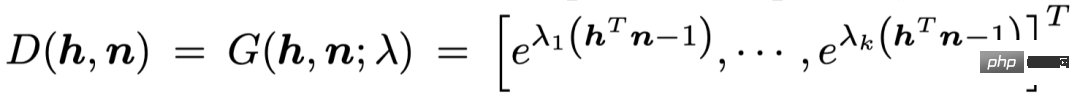

Aufgrund des hohen Rechenaufwands für die Berechnung der Sichtbarkeit aller N

v

v

-Punkte, die durch Pixelpunkte entlang des Lichts (O (Nv

N

)) abgetastet werden, ist das Vorhandene Methoden sind: Verwenden Sie MLP, um die Sichtbarkeit von Punkten direkt zu regressieren (O (Nv)) oder extrahieren Sie Oberflächenpunkte vorab, nachdem Sie die Szenengeometrie erhalten haben (O (NL

)). S3-NeRF berechnet online die Lichtsichtbarkeit des Pixels anhand der durch Wurzelfindung ermittelten Oberflächenpunkte und drückt den Pixelwert durch die folgende Formel aus. Szenenoptimierung Unsere Methode erfordert keine Überwachung von Schatten, sondern verlässt sich zur Optimierung auf den Rekonstruktionsverlust des Bildes. Wenn man bedenkt, dass andere Perspektiven in einer einzelnen Perspektive keine zusätzlichen Einschränkungen mit sich bringen, führt die Einführung einer Stichprobenstrategie wie UNISURF zur schrittweisen Reduzierung des Stichprobenbereichs dazu, dass sich das Modell nach der Reduzierung des Stichprobenintervalls zu verschlechtern beginnt. Daher wenden wir eine Strategie des gemeinsamen Stereo-Renderings und Oberflächen-Renderings an, wobei wir mithilfe der Wurzelfindung die Oberflächenpunkte lokalisieren, um die Farbe zu rendern und den L1-Verlust zu berechnen. Experimentelle ErgebnisseVergleich mit der Neuralstrahlungsfeldmethode

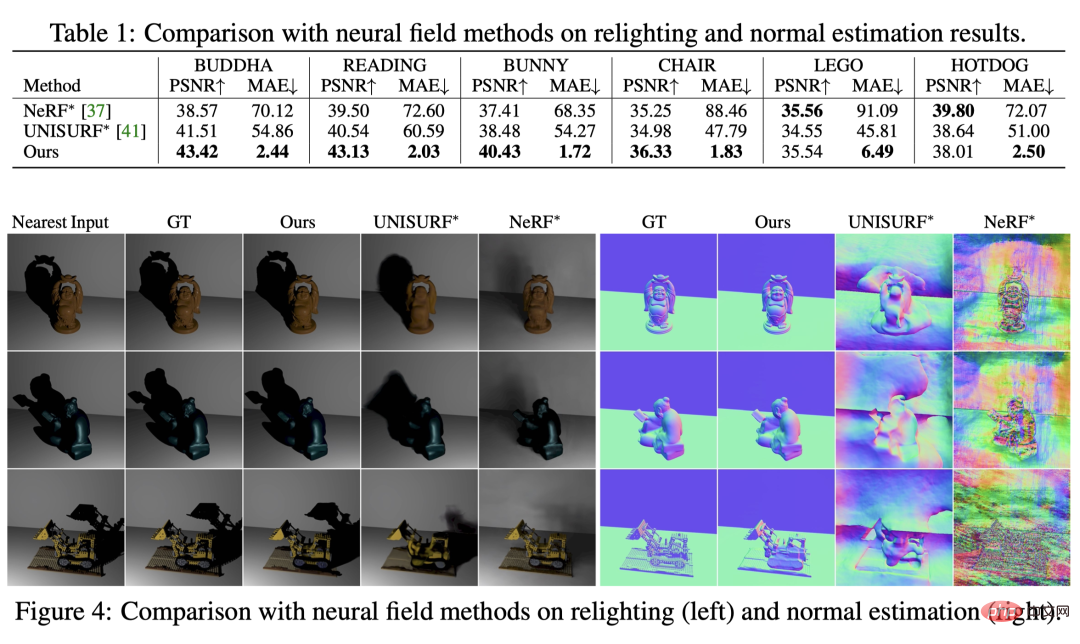

Wir vergleichen zunächst zwei Basismethoden, die auf neuronalen Strahlungsfeldern basieren (aufgrund unterschiedlicher Aufgaben führen wir Lichtquelleninformationen in deren Farb-MLP ein). Sie sehen, dass sie bei neuer Beleuchtung nicht in der Lage sind, die Szenengeometrie zu rekonstruieren oder Schatten präzise zu erzeugen.

Vergleich mit Einzelansicht-Formschätzungsmethoden

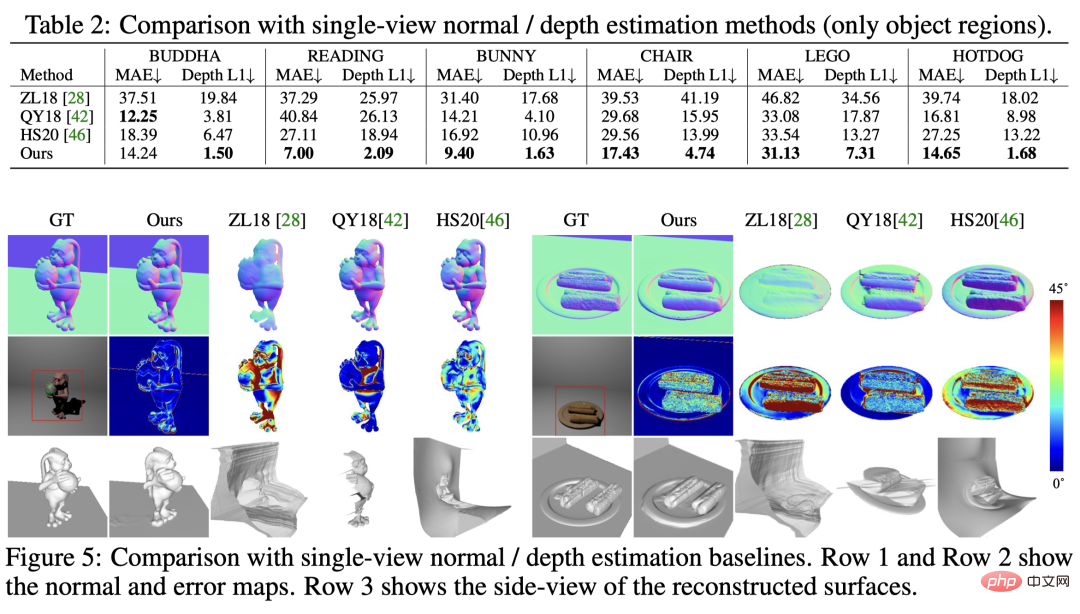

Im Vergleich mit vorhandenen Einzelansicht-Normal-/Tiefenschätzungsmethoden zeigt sich, dass unsere Methode eine bessere Leistung bei Normalschätzung und Tiefe aufweist Beide erzielten die besten Ergebnisse und konnten gleichzeitig sichtbare und unsichtbare Bereiche der Szene rekonstruieren.

Szenenrekonstruktion mit unterschiedlichen Hintergründen

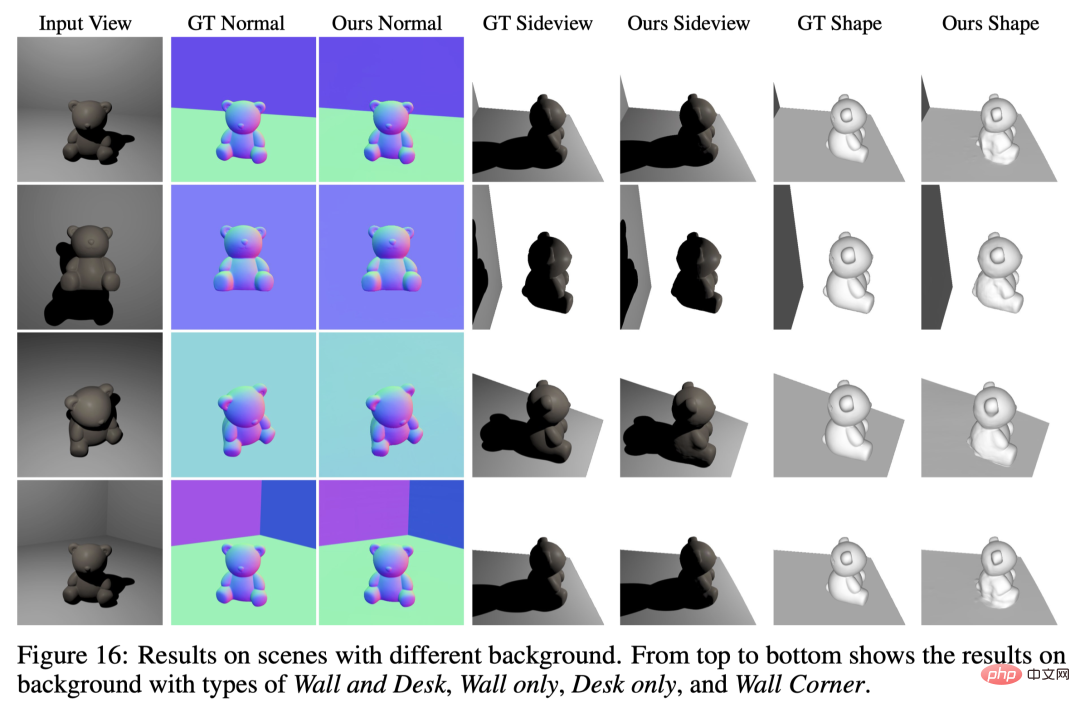

Unsere Methode eignet sich für eine Vielzahl von Szenen mit unterschiedlichen Hintergrundbedingungen.

Neues Ansichtsrendering, wechselnde Beleuchtung und Materialbearbeitung

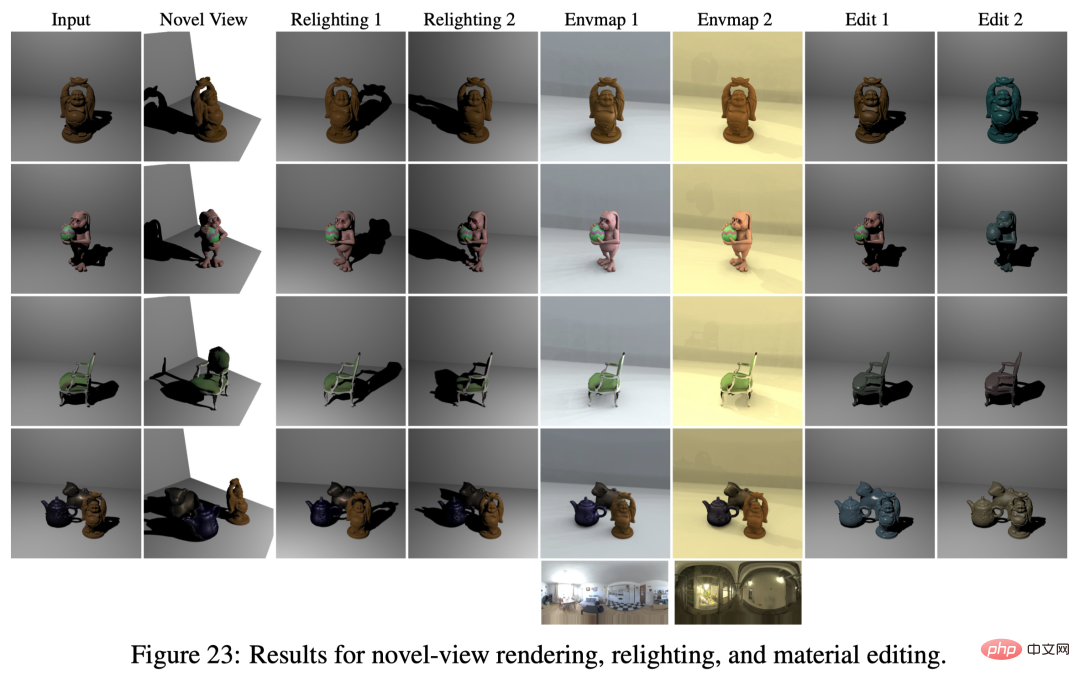

Basierend auf der Szenenmodellierung mit neuronalen Reflexionsfeldern haben wir die Geometrie/das Material/die Beleuchtung der Szene usw. erfolgreich entkoppelt, sodass dies möglich ist kann auf das Rendern neuer Ansichten, das Ändern der Szenenbeleuchtung, die Materialbearbeitung und andere Anwendungen angewendet werden.

Rekonstruktion echter Drehszenen

Wir haben drei reale Szenen gedreht, um die Praktikabilität zu untersuchen. Wir haben die Kameraposition festgelegt, die Taschenlampe des Mobiltelefons als Punktlichtquelle verwendet (die Umgebungslichtquelle war ausgeschaltet) und die Handtaschenlampe nach dem Zufallsprinzip bewegt, um Bilder unter verschiedenen Lichtquellen aufzunehmen. Dieses Setup erfordert keine Lichtquellenkalibrierung. Wir verwenden SDPS-Net, um eine grobe Schätzung der Lichtquellenrichtung zu erhalten, und initialisieren die Lichtquellenposition durch grobe Schätzung der relativen Abstände zwischen Kamera und Objekt sowie zwischen Lichtquelle und Objekt. Die Positionen der Lichtquellen werden während des Trainings gemeinsam mit der Geometrie der Szene und BRDF optimiert. Es ist ersichtlich, dass unsere Methode auch bei einer lockereren Datenerfassungseinstellung (ohne Kalibrierung der Lichtquelle) die 3D-Szenengeometrie immer noch gut rekonstruieren kann.

Zusammenfassung

- S3-NeRF optimiert neuronale Reflexionsfelder, um 3D-Szenengeometrie und Materialinformationen zu rekonstruieren, indem Bilder, die unter mehreren Punktlichtern aufgenommen wurden, in einer einzigen Ansicht verwendet werden.

- Durch die Verwendung von Schattierungen und Schattenhinweisen kann S3-NeRF die Geometrie sichtbarer/unsichtbarer Bereiche in der Szene effektiv wiederherstellen und so eine Rekonstruktion der vollständigen Szenengeometrie/BRDF aus einer monokularen Perspektive erreichen.

- Verschiedene Experimente zeigen, dass unsere Methode Szenen mit verschiedenen komplexen Geometrien/Materialien rekonstruieren kann und mit Hintergründen verschiedener Geometrien/Materialien und unterschiedlichen Lichtmengen/Lichtquellenverteilungen zurechtkommt.

Das obige ist der detaillierte Inhalt vonDer Single-View-NeRF-Algorithmus S^3-NeRF verwendet Multi-Beleuchtungsinformationen, um Szenengeometrie und Materialinformationen wiederherzustellen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr