Heim >Technologie-Peripheriegeräte >KI >Das erste binäre neuronale Netzwerk BNext mit einer Genauigkeit von mehr als 80 % auf ImageNet wurde veröffentlicht, eine fünfjährige Reise von -1 und +1

Das erste binäre neuronale Netzwerk BNext mit einer Genauigkeit von mehr als 80 % auf ImageNet wurde veröffentlicht, eine fünfjährige Reise von -1 und +1

- WBOYnach vorne

- 2023-04-13 10:31:021114Durchsuche

Vor zwei Jahren, als MeliusNet herauskam, veröffentlichte Heart of the Machine einen technischen Artikel „Binäres neuronales Netzwerk, das MobileNet zum ersten Mal schlägt, -1 und +1 drei Jahre mühsamer Reise 》, überprüfte die Entwicklungsgeschichte von BNN. Damals wurde XNOR.AI, das mit der frühen BNN-Arbeit XNOR-Net begann, von Apple übernommen. Jeder hatte sich vorgestellt, ob diese energieeffiziente, leistungsstarke binäre neuronale Netzwerktechnologie bald breite Anwendungsperspektiven eröffnen würde.

Allerdings war es für uns in den letzten zwei Jahren schwierig, mehr Informationen über die Anwendung der BNN-Technologie von Apple zu erhalten, das seine Technologie streng vertraulich behandelt, und es gab keine weiteren besonders auffälligen Anwendungsfälle entweder in der Wissenschaft oder in der Industrie. Andererseits wachsen Edge-KI-Anwendungen und -Märkte mit der rasant steigenden Zahl an Endgeräten rasant: Es wird erwartet, dass bis 2030 500 bis 125 Milliarden Edge-Geräte produziert werden und der Edge-Computing-Markt auf 60 Milliarden US-Dollar ansteigen wird. Derzeit gibt es mehrere beliebte Anwendungsbereiche: AIoT, Metaverse und Roboter-Endgeräte. Relevante Branchen beschleunigen die Implementierung von Technologie. Gleichzeitig wurden KI-Funktionen in viele wichtige technische Verbindungen in den oben genannten Bereichen eingebettet, beispielsweise in die weit verbreitete Anwendung von KI-Technologie in der dreidimensionalen Rekonstruktion, Videokomprimierung und Echtzeit Wahrnehmung von Roboterszenen. Vor diesem Hintergrund wird die Nachfrage der Branche nach Edge-basierter KI-Technologie mit hoher Energieeffizienz und geringem Stromverbrauch, Softwaretools und Hardwarebeschleunigung immer dringlicher.

Derzeit gibt es zwei Hauptengpässe, die die Anwendung von BNN einschränken: erstens die Unfähigkeit, die Genauigkeitslücke mit herkömmlichen 32-Bit-Deep-Learning-Modellen effektiv zu schließen; zweitens das Fehlen einer leistungsstarken Algorithmusimplementierung auf unterschiedlicher Hardware . Beschleunigungen in maschinellen Lernpapieren lassen sich oft nicht auf die von Ihnen verwendete GPU oder CPU übertragen. Der zweite Grund kann aus dem ersten Grund resultieren. BNN kann keine zufriedenstellende Genauigkeit erreichen und daher keine breite Aufmerksamkeit von Praktikern auf dem Gebiet der System- und Hardwarebeschleunigung und -optimierung auf sich ziehen. Die Community für maschinelle Lernalgorithmen kann häufig nicht selbst Hochleistungs-Hardwarecode entwickeln. Um sowohl eine hohe Genauigkeit als auch eine starke Beschleunigung zu erreichen, erfordern BNN-Anwendungen oder -Beschleuniger daher zweifellos die Zusammenarbeit von Entwicklern aus diesen beiden unterschiedlichen Bereichen.

Warum BNN rechen- und speichereffizient ist

Zum Beispiel verwendet das Meta-Empfehlungssystemmodell DLRM 32-Bit-Gleitkommazahlen zum Speichern von Gewichten und Aktivierungsparametern, und seine Modellgröße beträgt etwa 2,2 GB. Eine binäre Version des Modells mit einer geringen Genauigkeitsreduzierung (

Der zweite wesentliche Vorteil von BNN besteht darin, dass die Berechnungsmethode äußerst effizient ist. Es verwendet nur 1 Bit, also zwei Zustände, um Variablen darzustellen. Dies bedeutet, dass alle Operationen nur durch Bitoperationen abgeschlossen werden können. Mithilfe von UND-Gattern, XOR-Gattern und anderen Operationen können herkömmliche Multiplikations- und Additionsoperationen ersetzt werden. Bitoperationen sind die Grundeinheit in der Schaltung. Studenten, die mit dem Schaltungsdesign vertraut sind, sollten verstehen, dass eine effektive Reduzierung der Fläche der Multiplikations- und Additionsberechnungseinheit und eine Reduzierung des Speicherzugriffs außerhalb des Chips die effektivsten Möglichkeiten zur Reduzierung des Stromverbrauchs sind. BNN konzentriert sich sowohl auf den Speicher als auch auf die Berechnung. WRPN [1] hat gezeigt, dass BNN im Vergleich zu voller Präzision eine 1000-fache Energieeinsparung erzielen kann. Die neuere Arbeit BoolNet [2] demonstrierte ein BNN-Strukturdesign, das nahezu keine Gleitkommaoperationen verwenden und einen reinen binären Informationsfluss aufrechterhalten kann, wodurch hervorragende Kompromisse bei Stromverbrauch und Genauigkeit bei der ASIC-Simulation erzielt werden.

Wie sieht das erste BNN mit 80 % Genauigkeit aus?

Forscher wie Nianhui Guo und Haojin Yang vom Hasso-Plattner-Institut für Computersystemtechnik in Deutschland schlugen das BNext-Modell vor und erreichten damit als erstes BNN eine Top1-Klassifizierungsgenauigkeit von über 80 % im ImageNet-Datensatz:

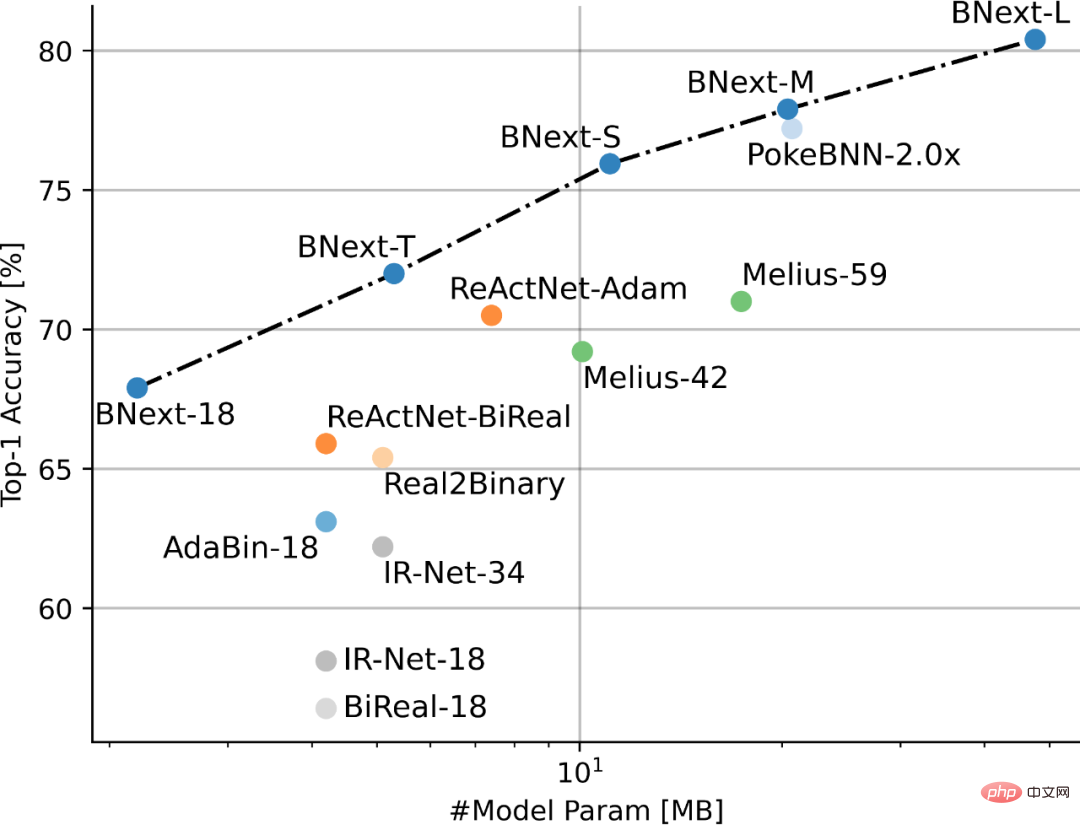

Abbildung 1 Leistungsvergleich von SOTA BNN basierend auf ImageNet

Papieradresse: https://arxiv.org/pdf/2211.12933.pdf

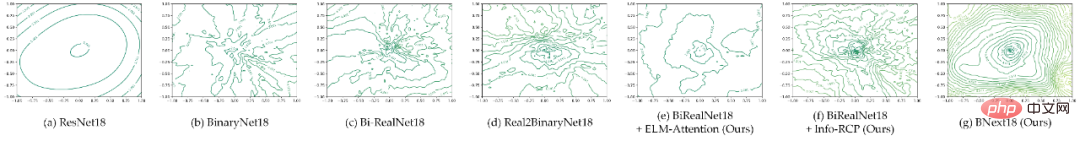

Der Autor führte zunächst einen ausführlichen Vergleich der Optimierungsfreundlichkeit des aktuellen Mainstream-BNN-Modells und des 32- Der große Gradunterschied (Abbildung 2) legt nahe, dass die grobe Verlustlandschaft von BNN einer der Hauptgründe ist, die die aktuelle Forschungsgemeinschaft daran hindert, die Leistungsgrenzen von BNN weiter zu erkunden.

Basierend auf dieser Annahme versuchte der Autor, mithilfe eines neuartigen Strukturdesigns die Optimierungsfreundlichkeit des BNN-Modells zu verbessern, und verringerte die Schwierigkeit der Optimierung des hochpräzisen BNN-Modells durch den Aufbau einer binären neuronalen Netzwerkarchitektur mit einem glatteren Verlust Landschaft. Insbesondere betont der Autor, dass die Modellbinarisierung die Merkmalsmuster, die für die Vorwärtsausbreitung verwendet werden können, stark einschränkt und die binäre Faltung dazu zwingt, nur Informationen in einem begrenzten Merkmalsraum zu extrahieren und zu verarbeiten. Dieser eingeschränkte Feed-Forward-Ausbreitungsmodus kann zu Optimierungsschwierigkeiten führen durch zwei Ebenen des Strukturdesigns effektiv gemildert werden: (1) Aufbau eines flexiblen Moduls zur Kalibrierung zusammenhängender Faltungsmerkmale, um die Anpassungsfähigkeit des Modells an die binäre Darstellung zu verbessern; (2) Erforschung effizienter Bypass-Strukturen, um das Informationsengpassproblem zu lindern, das durch die Merkmalsbinarisierung bei der Feedforward-Ausbreitung verursacht wird; .

Abbildung 2 Vergleich der Verlustlandschaftsvisualisierung (2D-Konturperspektive) für die beliebte BNN-Architektur

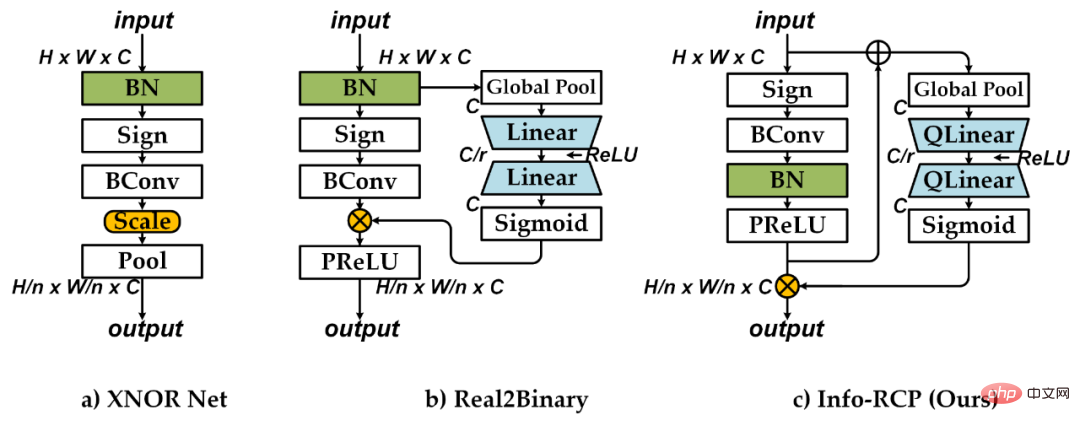

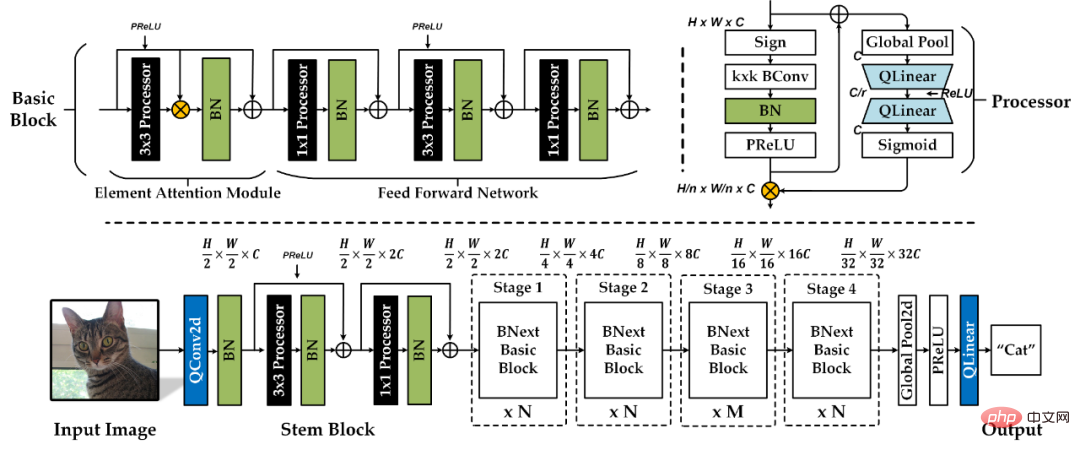

Basierend auf der obigen Analyse schlug der Autor BNext vor, das als erstes Unternehmen dies erreichte ImageNe-Bildklassifizierungsaufgabe > Binäre neuronale Netzwerkarchitektur mit 80 % Genauigkeit Das spezifische Netzwerkarchitekturdesign ist in Abbildung 4 dargestellt. Der Autor entwarf zunächst eine grundlegende binäre Verarbeitungseinheit basierend auf dem Info-Recoupling-Modul (Info-RCP). Um das Informationsengpassproblem zwischen benachbarten Faltungen anzugehen, wird der vorläufige Kalibrierungsentwurf der Ausgabeverteilung der binären Faltung durch die Einführung zusätzlicher Batch-Normalisierungsschichten und PReLU-Schichten vervollständigt. Anschließend konstruierte der Autor ein quadratisches dynamisches Verteilungskalibrierungsdesign basierend auf der inversen Reststruktur und der Squeeze-And-Expand-Zweigstruktur. Wie in Abbildung 3 dargestellt, berücksichtigt die zusätzliche inverse Reststruktur im Vergleich zur herkömmlichen Real2Binary-Kalibrierungsstruktur die Merkmalslücke zwischen der Eingabe und der Ausgabe der Binäreinheit vollständig und vermeidet so eine suboptimale Verteilungskalibrierung, die ausschließlich auf Eingabeinformationen basiert. Diese zweistufige dynamische Verteilungskalibrierung kann die Schwierigkeit der Merkmalsextraktion in nachfolgenden benachbarten binären Faltungsschichten wirksam verringern. Abbildung 3: Vergleichstabelle zum Design des Faltungsmoduls Der Autor vervollständigte den Grundaufbau von Basic Block durch Stapeln mehrerer Info-RCP-Module und führte zusätzliche Batch-Normalisierung und kontinuierliche Restverbindungen für jedes Info-RCP-Modul ein, um das Informationsengpassproblem zwischen verschiedenen Info-RCP-Modulen weiter zu lindern. Basierend auf der Analyse der Auswirkungen der Bypass-Struktur auf die Optimierung des Binärmodells schlägt der Autor vor, den Zweig der elementweisen Matrixmultiplikation zu verwenden, um eine Verteilungskalibrierung am Ausgang des ersten 3x3-Info-RCP-Moduls jedes Basisblocks durchzuführen . Der zusätzliche Luftraum-Aufmerksamkeitsgewichtungsmechanismus kann Basic Block dabei helfen, eine Vorwärtsinformationsfusion und -verteilung mit einem flexibleren Mechanismus durchzuführen und so die Glätte der Modellverlustlandschaft zu verbessern. Wie in Abbildung 2.e und Abbildung 2.f dargestellt, kann das vorgeschlagene Moduldesign die Glätte der Verlustlandschaft des Modells erheblich verbessern.

Abbildung 4 BNächster Architekturentwurf. „Prozessor repräsentiert das Info-RCP-Modul, „BN“ repräsentiert die Batch-Normalisierungsschicht, „C“ repräsentiert die Grundbreite des Modells, „N“ und „M“ repräsentieren die Tiefenskalenparameter verschiedener Stufen des Modells.

Der Autor kombinierte das obige Strukturdesign mit dem beliebten MoboleNetv1-Benchmark-Modell und konstruierte vier BNext-Modellreihen (Tabelle 1) unterschiedlicher Komplexität, indem er den Proportionalkoeffizienten von Modelltiefe und -breite änderte: BNex-Tiny, BNext-Small, BNext - Mittel, BWeiter-Groß.

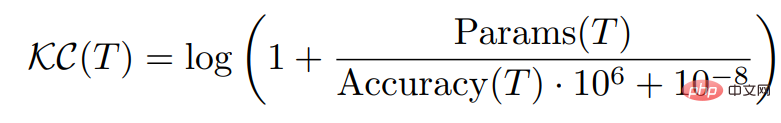

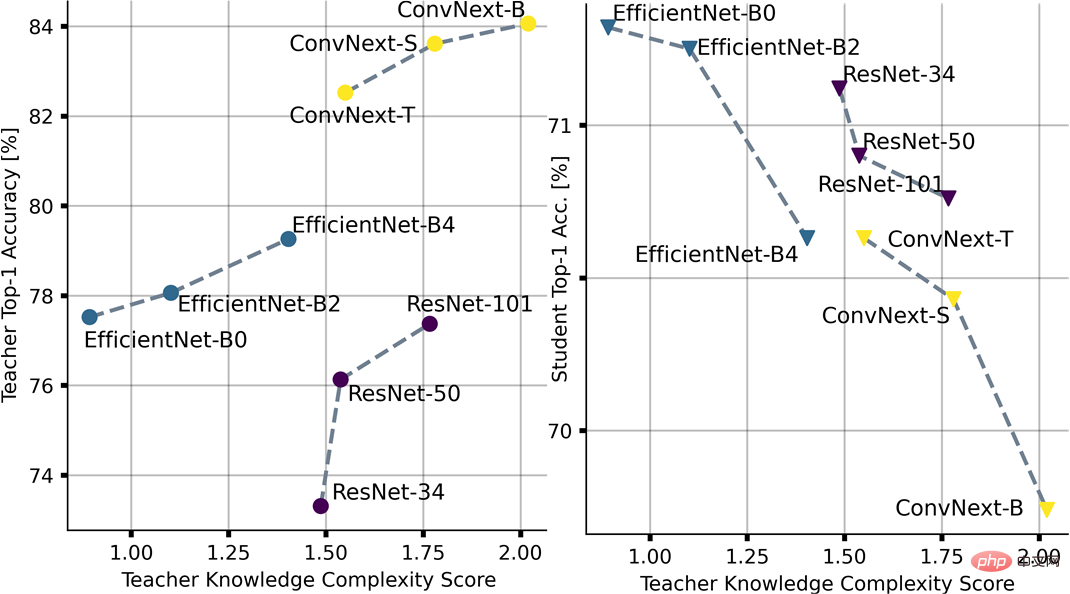

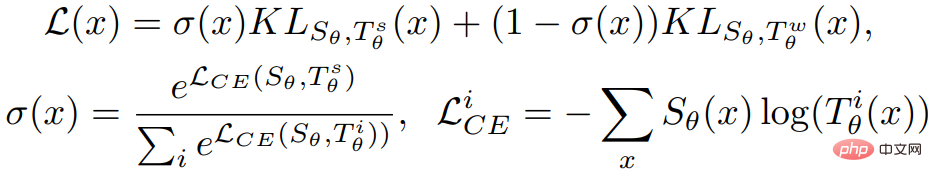

Aufgrund der relativ rauen Verlustlandschaft stützt sich die aktuelle binäre Modelloptimierung im Allgemeinen auf feinere Überwachungsinformationen, die durch Methoden wie Wissensdestillation bereitgestellt werden, um weit verbreitete suboptimale Konvergenz zu beseitigen. Zum ersten Mal berücksichtigte der Autor von BNext die möglichen Auswirkungen der großen Lücke in der Vorhersageverteilung zwischen dem Lehrermodell und dem binären Schülermodell während des Optimierungsprozesses und wies darauf hin, dass die Lehrerauswahl ausschließlich auf der Grundlage der Modellgenauigkeit zu Gegenmaßnahmen führen wird - Intuitive Überanpassungsergebnisse für Schüler. Um dieses Problem zu lösen, schlägt der Autor die Wissenskomplexität (KC) als neue Metrik für die Lehrerauswahl vor und berücksichtigt dabei die Korrelation zwischen der Wirksamkeit der Ausgabe-Softlabels des Lehrermodells und der Komplexität der Parameter des Lehrermodells.

Wie in Abbildung 5 gezeigt, hat der Autor basierend auf der Wissenskomplexität die Komplexität beliebter Modellreihen mit voller Präzision wie ResNet, EfficientNet und ConvNext gemessen und bewertet und BNext-T als Studentenmodell kombiniert um zunächst die Gültigkeit der Kriterien zu überprüfen und die Ergebnisse der Rangfolge für die Auswahl des Wissensdestillationsmodells in nachfolgenden Experimenten zu verwenden. Abbildung 5: Kontraintuitiver Überanpassungseffekt und die Auswirkung der Wissenskomplexität bei verschiedenen Lehrerauswahlen Diversified Consecutive KD wird vorgeschlagen, um das Optimierungsproblem zu lösen, das durch die frühe Vorhersageverteilungslücke verursacht wird. Wie unten gezeigt, moduliert der Autor die Zielfunktion im Optimierungsprozess durch die Wissensintegrationsmethode der Kombination starker und schwacher Lehrer. Auf dieser Grundlage wird die Strategie zur Wissenssteigerung weiter eingeführt, bei der mehrere vordefinierte Lehrkräfte eingesetzt werden, um schwache Lehrkräfte während des Ausbildungsprozesses gleichmäßig zu wechseln, die kombinierte Wissenskomplexität lehrplanmäßig von schwach nach stark zu lenken und die Vorhersageoptimierungsinterferenz zu reduzieren durch Unterschiede verursacht.

In Bezug auf Optimierungstechniken berücksichtigen die BNext-Autoren vollständig die möglichen Gewinne, die die Datenerweiterung bei der modernen hochpräzisen Modelloptimierung mit sich bringt, und bieten die erste mögliche Anwendung bestehender beliebter Datenerweiterungsstrategien bei der binären Modelloptimierung Experimentelle Ergebnisse zeigen, dass die vorhandenen Datenverbesserungsmethoden nicht vollständig für die binäre Modelloptimierung geeignet sind, was Anregungen für die Gestaltung von Datenverbesserungsstrategien speziell für die binäre Modelloptimierung in späteren Forschungen liefert. Basierend auf dem vorgeschlagenen Architekturdesign und der Optimierungsmethode führte der Autor eine Methodenüberprüfung für die groß angelegte Bildklassifizierungsaufgabe ImageNet-1k durch. Die experimentellen Ergebnisse sind in Abbildung 6 dargestellt.

Abbildung 6 Vergleich der SOTA-BNN-Methoden basierend auf ImageNet-1k.

Im Vergleich zu vorhandenen Methoden hat BNext-L die Leistungsgrenze binärer Modelle auf ImageNet-1k erstmals auf 80,57 % verschoben und damit eine Genauigkeit von mehr als 10 % für die meisten vorhandenen Methoden erreicht. Im Vergleich zu PokeBNN von Google ist BNext-M bei ähnlichen Parametern um 0,7 % höher. Der Autor betont auch, dass die Optimierung von PokeBNN auf höheren Rechenressourcen wie einer Bacth-Größe von bis zu 8192 und einer TPU von 720 Epochen beruht , während BNext-L nur 512 Epochen mit einer herkömmlichen Batch-Größe von 512 iterierte, was die Wirksamkeit der Strukturdesign- und Optimierungsmethode von BNext widerspiegelt. Bei Vergleichen, die auf demselben Basismodell basieren, weisen sowohl BNext-T als auch BNext-18 eine deutlich verbesserte Genauigkeit auf. Im Vergleich zu Modellen mit voller Präzision wie RegNetY-4G (80,0 %) weist BNext-L Lernfähigkeiten für die passende visuelle Darstellung auf und nutzt dabei nur einen begrenzten Parameterraum und eine begrenzte Rechenkomplexität, was es ideal für die nachgelagerte, auf visuellen Aufgaben basierende Bereitstellung macht Der Feature-Extraktor im Binärmodell bietet reichhaltigen Fantasieraum. BNext Die Autoren erwähnten in dem Papier, dass sie und ihre Mitarbeiter die Betriebseffizienz dieser hochpräzisen BNN-Architektur aktiv auf GPU-Hardware implementieren und überprüfen und eine Ausweitung auf andere breitere Hardware planen Zukunft auf der Plattform. Nach Ansicht des Herausgebers hat die Community jedoch wieder Vertrauen in BNN gewonnen und die Aufmerksamkeit von mehr Geeks im System- und Hardwarebereich auf sich gezogen. Die vielleicht wichtigere Bedeutung dieser Arbeit besteht darin, die Vorstellung vom Anwendungspotenzial von BNN neu zu gestalten. Da immer mehr Anwendungen von Cloud-zentrierten Computing-Paradigmen auf dezentrales Edge-Computing migrieren, wird die enorme Anzahl an Edge-Geräten in der Zukunft effizientere KI-Technologie, Software-Frameworks und Hardware-Computing-Plattformen erfordern. Allerdings sind die derzeit gängigsten KI-Modelle und Computerarchitekturen nicht für Edge-Szenarien konzipiert und optimiert. Daher glaube ich, dass BNN immer eine wichtige Option voller technischer Herausforderungen und großem Potenzial sein wird, bis die Antwort auf Edge AI gefunden ist. Was kommt als Nächstes?

Das obige ist der detaillierte Inhalt vonDas erste binäre neuronale Netzwerk BNext mit einer Genauigkeit von mehr als 80 % auf ImageNet wurde veröffentlicht, eine fünfjährige Reise von -1 und +1. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr