Heim >Technologie-Peripheriegeräte >KI >300 Jahre künstliche Intelligenz! Der Vater von LSTM schreibt einen 10.000 Wörter langen Artikel: Ausführliche Erläuterung der Entwicklungsgeschichte moderner KI und Deep Learning

300 Jahre künstliche Intelligenz! Der Vater von LSTM schreibt einen 10.000 Wörter langen Artikel: Ausführliche Erläuterung der Entwicklungsgeschichte moderner KI und Deep Learning

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-13 08:16:021601Durchsuche

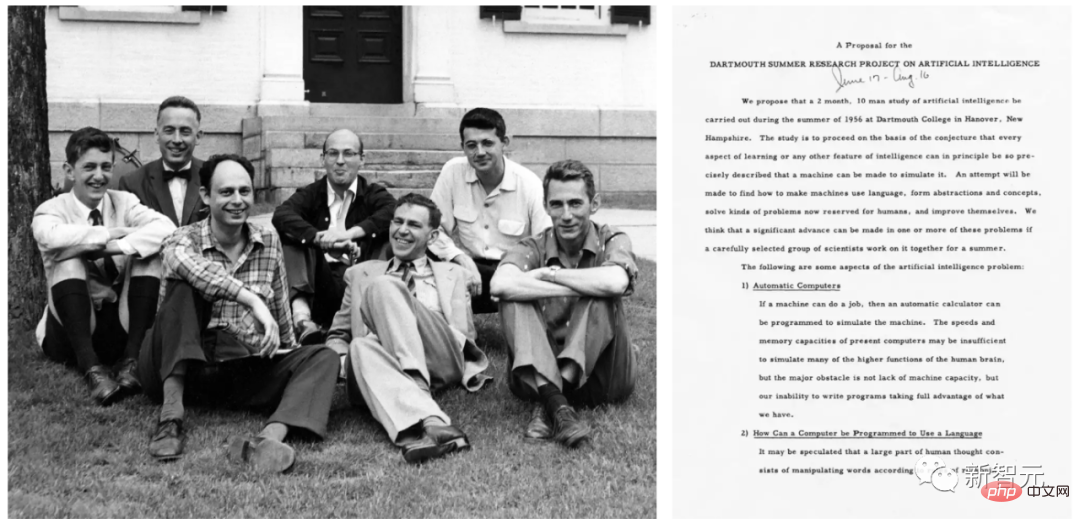

Der Begriff „künstliche Intelligenz“ wurde erstmals 1956 auf der Dartmouth-Konferenz von John McCarthy und anderen offiziell vorgeschlagen.

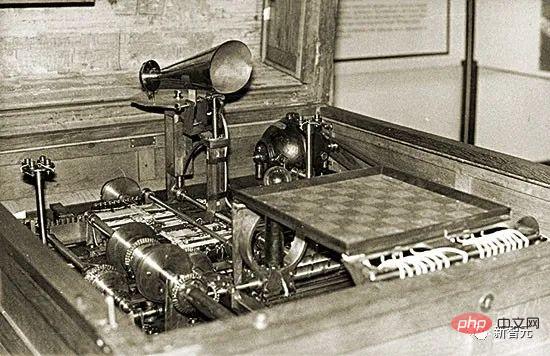

Praktische KI wurde bereits 1914 vorgeschlagen. Zu dieser Zeit baute Leonardo Torres y Quevedo den ersten funktionierenden Schachautomaten-Terminalspieler. Zu dieser Zeit galt Schach als eine Aktivität, die auf den Bereich intelligenter Kreaturen beschränkt war.

Die Theorie der künstlichen Intelligenz lässt sich bis in die Jahre 1931-34 zurückverfolgen. Kurt Gödel erkannte damals die grundlegenden Grenzen jeder Art rechnerbasierter künstlicher Intelligenz.

Die Zeit kommt in die 1980er Jahre und die Geschichte der KI wird sich zu dieser Zeit auf Themen wie Theorembeweis, Logikprogrammierung, Expertensysteme und heuristische Suche konzentrieren.

Die Geschichte der KI in den frühen 2000er Jahren hätte einen größeren Schwerpunkt auf Themen wie Support-Vektor-Maschinen und Kernel-Methoden gelegt. Bayesianisches Denken und andere probabilistische und statistische Konzepte, Entscheidungsbäume, Ensemble-Methoden, Schwarmintelligenz und evolutionäre Berechnungen sind Techniken, die viele erfolgreiche KI-Anwendungen vorantreiben.

Die KI-Forschung in den 2020er Jahren ist beispielsweise eher „retro“ und betont Konzepte wie die Kettenregel und tiefe nichtlineare künstliche neuronale Netze, die durch Gradientenabstieg trainiert werden, insbesondere rückkopplungsbasierte wiederkehrende Netze.

Schmidhuber sagte, dass dieser Artikel die bisherige irreführende „Geschichte des Deep Learning“ korrigiert. Seiner Ansicht nach wurde in der bisherigen Geschichte des Deep Learning ein Großteil der im Artikel erwähnten bahnbrechenden Arbeit ignoriert.

Darüber hinaus widerlegte Schmidhuber ein weit verbreitetes Missverständnis, dass neuronale Netze „in den 1980er Jahren als Werkzeug eingeführt wurden, um Computern zu helfen, Muster zu erkennen und menschliche Intelligenz zu simulieren“. Denn tatsächlich sind neuronale Netze schon vor den 1980er Jahren aufgetaucht.

1. 1676: Die Kettenregel der umgekehrten Kreditzuweisung

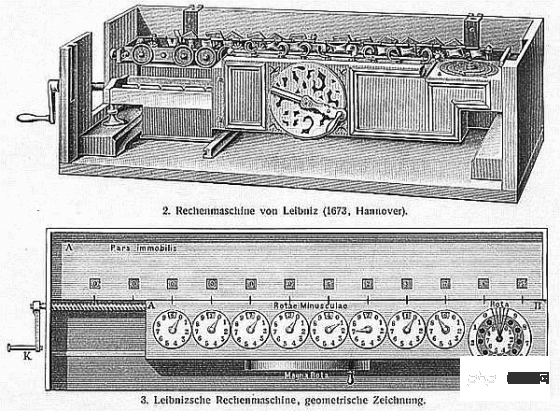

Im Jahr 1676 veröffentlichte Gottfried Wilhelm Leibniz in seinen Memoiren die Kettenregel der Analysis. Heute steht diese Regel im Mittelpunkt der Kreditvergabe in tiefen neuronalen Netzen und ist die Grundlage des modernen Deep Learning.

Gottfried Wilhelm Leibniz

Ein neuronales Netzwerk verfügt über Knoten oder Neuronen, die differenzierbare Funktionen von Eingaben anderer Neuronen berechnen. Wenn Sie die Änderungen in der endgültigen Funktionsausgabe nach der Änderung der Parameter oder Gewichte der früheren Funktionen wissen möchten, müssen Sie die Kettenregel verwenden.

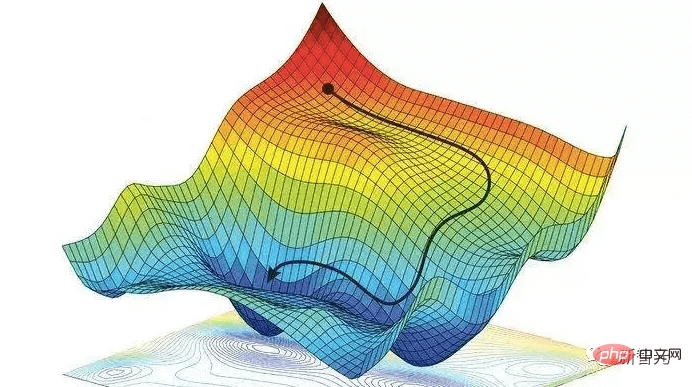

Diese Antwort wird auch für die Gradientenabstiegstechnik verwendet. Um dem neuronalen Netzwerk beizubringen, das Eingabemuster aus dem Trainingssatz in das gewünschte Ausgabemuster umzuwandeln, werden alle Gewichte des neuronalen Netzwerks iterativ ein wenig in Richtung maximaler lokaler Verbesserung geändert, um ein etwas besseres neuronales Netzwerk zu erstellen, und so weiter. schrittweise Nahe an der optimalen Kombination von Gewichten und Vorspannungen, um die Verlustfunktion zu minimieren.

Es ist erwähnenswert, dass Leibniz auch der erste Mathematiker war, der die Analysis entdeckte. Er und Isaac Newton entdeckten unabhängig voneinander die Infinitesimalrechnung, und die von ihm verwendeten mathematischen Symbole der Infinitesimalrechnung werden häufiger verwendet. Die von Leibniz erfundenen Symbole gelten allgemein als umfassender und haben ein breiteres Anwendungsspektrum.

Außerdem war Leibniz „der erste Informatiker der Welt“. Er entwarf 1673 die erste Maschine, die alle vier Rechenoperationen ausführen konnte, und legte damit den Grundstein für die moderne Informatik.

2. Anfang des 19. Jahrhunderts: Neuronale Netze, lineare Regression und flaches Lernen

Im Jahr 1805 veröffentlichte Adrien-Marie Legendre einen Inhalt, der heute allgemein als linearer neuronaler Netzinhalt bezeichnet wird.

Adrien Marie Legendre

Später wurde auch Johann Carl Friedrich Gauß für ähnliche Forschungen berühmt und erhielt Lob.

Dieses neuronale Netzwerk von vor über zwei Jahrhunderten hat zwei Schichten: eine Eingabeschicht mit mehreren Eingabeeinheiten und eine Ausgabeschicht. Jede Eingabezelle kann einen reellen Wert enthalten und ist über eine Verbindung mit reellen Gewichten mit der Ausgabe verbunden.

Die Ausgabe eines neuronalen Netzwerks ist die Summe der Produkte der Eingaben und ihrer Gewichte. Passen Sie bei einem Trainingssatz von Eingabevektoren und einem erwarteten Zielwert für jeden Vektor die Gewichte an, um die Summe der quadratischen Fehler zwischen der Ausgabe des neuronalen Netzwerks und dem entsprechenden Ziel zu minimieren.

Natürlich wurde dies damals noch nicht als neuronales Netzwerk bezeichnet. Man spricht von der Methode der kleinsten Quadrate, allgemein auch als lineare Regression bekannt. Aber mathematisch gesehen ist es dasselbe wie die heutigen linearen neuronalen Netze: der gleiche Grundalgorithmus, die gleiche Fehlerfunktion, die gleichen adaptiven Parameter/Gewichte.

Johann Carl Friedrich Gauss

Dieses einfache neuronale Netzwerk führt „flaches Lernen“ durch, im Gegensatz zu „tiefem Lernen“ mit vielen nichtlinearen Schichten. Tatsächlich beginnen viele Kurse zu neuronalen Netzen mit einer Einführung in diesen Ansatz und gehen dann zu komplexeren und tiefergehenden neuronalen Netzen über.

Heutzutage ist es für Studierende aller technischen Fächer Pflicht, Mathematikunterricht zu belegen, insbesondere Analysis, lineare Algebra und Statistik. In all diesen Bereichen werden Gauß viele wichtige Ergebnisse und Methoden zugeschrieben: der Grundsatz der Algebra, die Gaußsche Eliminationsmethode, die Gaußsche Verteilung der Statistik usw.

Der Mann, der als „der größte Mathematiker seit der Antike“ bekannt ist, leistete auch Pionierarbeit in der Differentialgeometrie, der Zahlentheorie (seinem Lieblingsfach) und der nichteuklidischen Geometrie. Ohne seine Leistungen wäre moderne Technik, einschließlich KI, undenkbar.

III. 1920-1925: Das erste rekurrente neuronale Netzwerk

Ähnlich wie das menschliche Gehirn verfügt ein rekurrentes neuronales Netzwerk (RNN) über Rückkopplungsverbindungen, sodass es gerichteten Verbindungen von bestimmten internen Knoten zu anderen Knoten folgen kann, und endet schließlich am Ausgangspunkt. Dies ist wichtig, um während der Sequenzverarbeitung Speicher für vergangene Ereignisse zu ermöglichen.

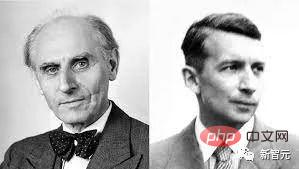

Wilhelm Lenz (links); Ernst Ising (rechts)

Die Physiker Ernst Ising und Wilhelm Lenz führten in den 1920er Jahren die erste nicht-lernende RNN-Architektur ein und analysierten sie: das Ising-Modell. Es gelangt basierend auf den Eingabebedingungen in einen Gleichgewichtszustand und ist die Grundlage des ersten RNN-Lernmodells.

Im Jahr 1972 machte Shun-Ichi Amari die Schleifenarchitektur des Ising-Modells adaptiv und lernte, Eingabemuster mit Ausgabemustern zu verknüpfen, indem er ihre Verbindungsgewichte änderte. Dies ist das weltweit erste lernende RNN.

Shunichi Amari

Das derzeit beliebteste RNN ist das von Schmidhuber vorgeschlagene Langzeit-Kurzzeitgedächtnisnetzwerk LSTM. Es ist zum am häufigsten zitierten neuronalen Netzwerk des 20. Jahrhunderts geworden.

4. 1958: Mehrschichtiges Feedforward-Neuronales Netzwerk

1958 kombinierte Frank Rosenblatt ein lineares neuronales Netzwerk und eine Schwellenwertfunktion, um ein tieferes mehrschichtiges Perzeptron (MLP) zu entwerfen.

Frank Rosenblatt

Das mehrschichtige Perzeptron folgt den Prinzipien des menschlichen Nervensystems, lernt und trifft Datenvorhersagen. Es lernt zuerst, speichert die Daten dann mithilfe von Gewichten und verwendet Algorithmen, um die Gewichte anzupassen und die Verzerrung während des Trainings, dh den Fehler zwischen tatsächlichen Werten und vorhergesagten Werten, zu verringern.

Da beim Training mehrschichtiger Feedforward-Netzwerke häufig der Fehler-Rückausbreitungsalgorithmus verwendet wird, gilt er als Standardalgorithmus für überwachtes Lernen im Bereich der Mustererkennung und wird weiterhin in den Bereichen Computational Neurology und Parallel untersucht Verteilte Verarbeitung.

5. 1965: Das erste Deep Learning

Das erfolgreiche Lernen von Deep-Feedforward-Netzwerkarchitekturen begann 1965 in der Ukraine, als Alexey Ivakhnenko und Valentin Lapa das erste Deep-MLP mit einer beliebigen Anzahl versteckter Schichten einführten Lernalgorithmus. „Alexey Ivakhnenko“ wobei die Regularisierung zum Entfernen redundanter Einheiten verwendet wird. Die Anzahl der Schichten und Einheiten pro Schicht werden problemabhängig gelernt.

Wie spätere tiefe neuronale Netze lernte Ivakhnenkos Netzwerk, hierarchische, verteilte, interne Darstellungen eingehender Daten zu erstellen.

Wie spätere tiefe neuronale Netze lernte Ivakhnenkos Netzwerk, hierarchische, verteilte, interne Darstellungen eingehender Daten zu erstellen.

Er nannte sie nicht Deep-Learning-Neuronale Netze, aber genau das sind sie. Tatsächlich wurde der Begriff „Deep Learning“ erstmals 1986 von Dechter in das maschinelle Lernen eingeführt, und Aizenberg et al. führten im Jahr 2000 das Konzept des „neuronalen Netzwerks“ ein.

VI. 1967-68: Stochastischer GradientenabstiegIm Jahr 1967 schlug Junichi Amari erstmals vor, neuronale Netze durch stochastischen Gradientenabstieg (SGD) zu trainieren.

Shunichi Amari und sein Schüler Saito lernten interne Darstellungen in einem fünfschichtigen MLP mit zwei modifizierbaren Schichten, die darauf trainiert wurden, nichtlinear trennbare Musterklassen zu klassifizieren.

Rumelhart und Hinton et al. führten 1986 eine ähnliche Arbeit durch und nannten sie den Backpropagation-Algorithmus.

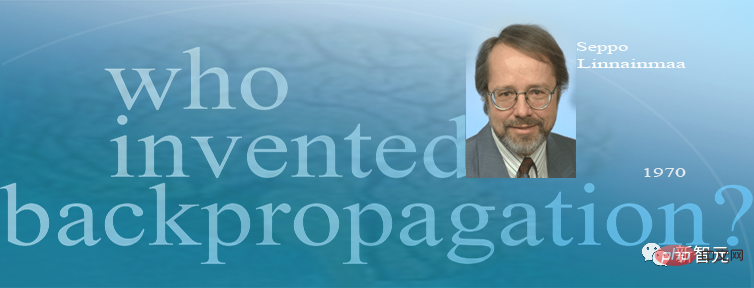

7. 1970: Backpropagation-Algorithmus1970 veröffentlichte Seppo Linnainmaa als erster den Backpropagation-Algorithmus, einen berühmten Algorithmus zur Kreditzuweisung für differenzierbare Knotennetzwerke, der auch als „automatischer Differential-Reverse-Modus“ bekannt ist.

Seppo Linnainmaa

Linnainmaa beschreibt erstmals eine effiziente Fehler-Backpropagation-Methode für neuronale Netze bei beliebigen, diskreten spärlichen Verbindungen. Es ist heute die Grundlage für weit verbreitete Softwarepakete für neuronale Netzwerke wie PyTorch und Googles Tensorflow.

Backpropagation ist im Wesentlichen eine effiziente Möglichkeit, die Kettenregel von Leibniz für tiefe Netzwerke umzusetzen. Der von Cauchy vorgeschlagene Gradientenabstieg wird im Verlauf vieler Experimente verwendet, um bestimmte neuronale Netzwerkverbindungen schrittweise zu schwächen und andere zu stärken.

Backpropagation ist im Wesentlichen eine effiziente Möglichkeit, die Kettenregel von Leibniz für tiefe Netzwerke umzusetzen. Der von Cauchy vorgeschlagene Gradientenabstieg wird im Verlauf vieler Experimente verwendet, um bestimmte neuronale Netzwerkverbindungen schrittweise zu schwächen und andere zu stärken.

Im Jahr 1985, als die Rechenkosten etwa 1.000-mal niedriger waren als 1970, als Desktop-Computer in wohlhabenden akademischen Labors gerade erst alltäglich wurden, führten David Rumelhart und andere experimentelle Analysen bekannter Methoden durch.

David Rumelhart

Durch Experimente haben Rumelhart et al. gezeigt, dass Backpropagation nützliche interne Darstellungen in den verborgenen Schichten neuronaler Netze erzeugen kann. Zumindest für überwachtes Lernen ist Backpropagation oft effektiver als das oben erwähnte Deep Learning von Amari Shunichi durch die SGD-Methode.

Vor 2010 glaubten viele Menschen, dass das Training mehrschichtiger neuronaler Netze ein unbeaufsichtigtes Vortraining erforderte. Im Jahr 2010 zeigte Schmidhubers Team zusammen mit Dan Ciresan, dass tiefe FNNs mit einfacher Backpropagation trainiert werden können und für wichtige Anwendungen überhaupt kein unbeaufsichtigtes Vortraining erfordern.

8. 1979: Das erste Faltungs-Neuronale Netzwerk

1979 entwickelte Kunihiko Fukushima bei STRL ein neuronales Netzwerkmodell zur Mustererkennung: Neocognitron.

Kunihiko Fukushima

Aber in der heutigen Sprache wird dieses Neocognitron als Convolutional Neural Network (CNN) bezeichnet. Es ist eine der größten Erfindungen der Grundstruktur tiefer neuronaler Netze und des Stroms Künstliche Intelligenz-Technologie. Intelligente Kerntechnologie.

Das von Dr. Fukushima eingeführte Neocognitron ist das erste neuronale Netzwerk, das Faltung und Downsampling verwendet, und auch der Prototyp eines Faltungs-Neuronalen Netzwerks.

Das von Fukushima Kunihiko entwickelte künstliche mehrschichtige neuronale Netzwerk mit Lernfähigkeiten kann das visuelle Netzwerk des Gehirns nachahmen. Diese „Einsicht“ ist zur Grundlage der modernen Technologie der künstlichen Intelligenz geworden. Die Arbeit von Dr. Fukushima hat zu einer Reihe praktischer Anwendungen geführt, von selbstfahrenden Autos bis zur Gesichtserkennung, von der Krebserkennung bis zur Vorhersage von Überschwemmungen und noch mehr.

1987 kombinierte Alex Waibel das neuronale Netzwerk mit Faltung, Gewichtsteilung und Backpropagation und schlug das Konzept des verzögerten neuronalen Netzwerks (TDNN) vor.

Seit 1989 trägt das Team von Yann LeCun zur Verbesserung von CNN bei, insbesondere im Bildbereich.

Yann LeCun

Ende 2011 beschleunigte Schmidhubers Team das Training tiefer CNNs erheblich und machte sie in der Community des maschinellen Lernens immer beliebter. Das Team startete ein GPU-basiertes CNN: DanNet, das tiefer und schneller ist als frühe CNNs. Im selben Jahr gewann DanNet als erstes reines Deep-CNN einen Computer-Vision-Wettbewerb.

Das von vier Wissenschaftlern von Microsoft Research vorgeschlagene Residual Neural Network (ResNet) gewann den ersten Platz im groß angelegten ImageNet-Wettbewerb zur visuellen Erkennung 2015.

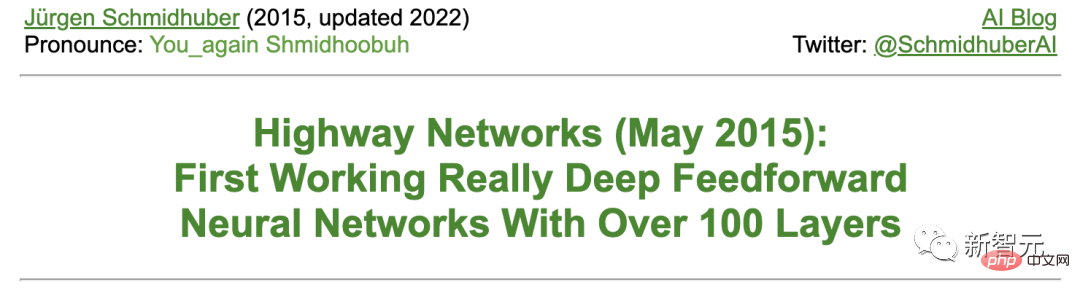

Schmidhuber sagte, dass ResNet eine frühe Version des von seinem Team entwickelten Hochgeschwindigkeits-Neuronalen Netzwerks (Highway Net) ist. Dies ist das erste wirklich effektive Deep-Feedforward-Neuronale Netzwerk mit Hunderten von Schichten im Vergleich zu früheren Neuronalen Netzwerken, die höchstens Dutzende von Schichten hatten.

9. 1987-1990er Jahre: Graphisches neuronales Netzwerk und stochastische Delta-Regel

Die Deep-Learning-Architektur, die strukturierte Daten (z. B. Grafiken) manipulieren kann, wurde 1987 von Pollack vorgeschlagen und in den frühen 1990er Jahren von Sperduti, Goller, entwickelt und Küchler für Erweiterungen und Verbesserungen. Heutzutage werden graphische neuronale Netze in vielen Anwendungen eingesetzt.

Paul Werbes und R. J. Williams et al. analysierten die Methode zur Implementierung des Gradientenabstiegs in RNN. Auch die selbstorganisierende Karte von Teuvo Kohonen erfreut sich großer Beliebtheit.

Teuvo Kohonen

Im Jahr 1990 führte Stephen Hanson die stochastische Delta-Regel ein, eine stochastische Methode zum Training neuronaler Netze durch Backpropagation. Jahrzehnte später wurde diese Methode unter dem Spitznamen „Dropout“ populär.

10. Februar 1990: Generative Adversarial Network/Curiosity

Generative Adversarial Network (GAN) wurde erstmals 1990 unter dem Namen „Artificial Intelligence Curiosity“ veröffentlicht.

Zwei gegnerische NNs (ein Wahrscheinlichkeitsgenerator und ein Prädiktor) versuchen, den Verlust des anderen in einem Spiel mit minimalem Limit zu maximieren. Wobei:

- Der Generator (Controller genannt) generiert probabilistische Ausgaben (unter Verwendung stochastischer Einheiten, wie später StyleGAN).

- Der Prädiktor (Weltmodell genannt) sieht die Ausgänge des Controllers und sagt voraus, wie die Umgebung darauf reagieren wird. Mithilfe des Gradientenabstiegs minimiert der Prädiktor NN seinen Fehler, während der Generator NN versucht, diesen Fehler zu maximieren – der Verlust des einen Netzwerks ist der Gewinn des anderen Netzwerks.

4 Jahre vor der Arbeit über GAN aus dem Jahr 2014 fasste Schmidhuber das generative kontradiktorische NN von 1990 in der berühmten Umfrage von 2010 wie folgt zusammen: „Neuronale Netze werden als prädiktive Weltmodelle verwendet, um die Kontrolle zu maximieren. Die intrinsische Belohnung der Maschine ist proportional zu.“ Vorhersagefehler des Modells.“

Das später veröffentlichte GAN ist nur ein Beispiel. Wenn die Experimente sehr kurz sind, gibt die Umgebung einfach 1 oder 0 zurück, je nachdem, ob die Ausgabe des Controllers (oder Generators) in einem bestimmten Satz liegt.

Die Prinzipien von 1990 werden häufig bei der Erforschung des verstärkenden Lernens und der Synthese realistischer Bilder verwendet, obwohl letzteres Feld kürzlich von Latent Diffusion von Rombach et al. übernommen wurde.

Im Jahr 1991 veröffentlichte Schmidhuber eine weitere ML-Methode basierend auf zwei kontradiktorischen NNs, genannt Vorhersagbarkeitsminimierung, zur Erstellung separater Darstellungen teilweise redundanter Daten, die 1996 auf Bilder angewendet wurde.

November, April 1990: Unterziele generieren/Anweisungen befolgen

In den letzten Jahrhunderten haben sich die meisten NNs eher der einfachen Mustererkennung als dem fortgeschrittenen Denken verschrieben.

Allerdings gab es Anfang der 1990er Jahre erstmals Ausnahmen. Diese Arbeit fügt das Konzept der traditionellen „symbolischen“ hierarchischen künstlichen Intelligenz in ein durchgängig unterscheidbares „subsymbolisches“ NN ein.

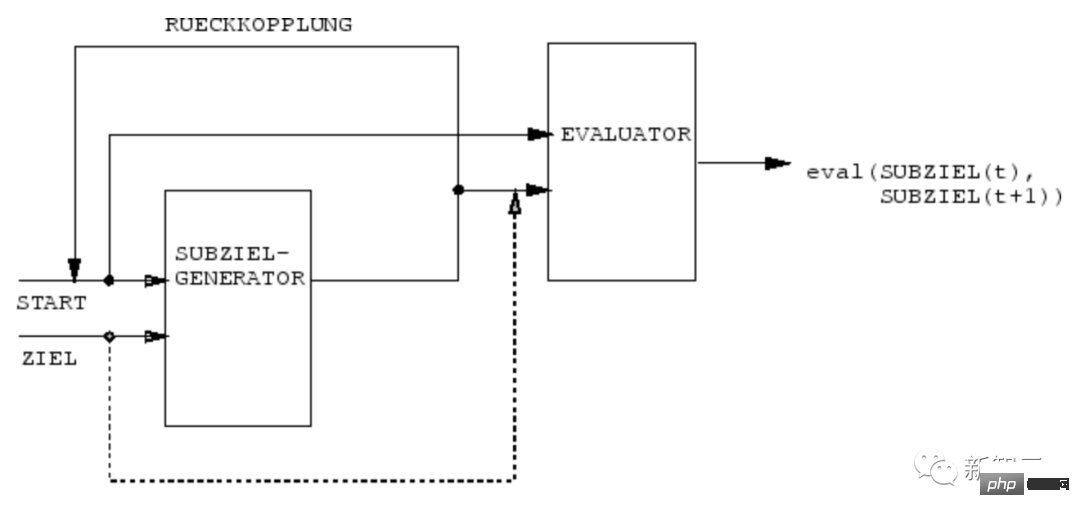

Im Jahr 1990 lernte das NN des Schmidhuber-Teams, den Unterzielgenerator des durchgängig differenzierbaren NN zu nutzen, um hierarchische Aktionspläne für hierarchisches Reinforcement Learning (HRL) zu generieren.

Eine RL-Maschine erhält zusätzliche Befehlseingaben in der Form (Start, Ziel). Ein Schätzer NN lernt, die aktuelle Belohnung/Kosten vom Start bis zum Ziel vorherzusagen. Ein (R)NN-basierter Unterzielgenerator sieht auch (Start, Ziel) und lernt eine Folge von Zwischenzielen mit den niedrigsten Kosten über einen Gradientenabstieg unter Verwendung einer (Kopie) des Evaluator-NN. Die RL-Maschine versucht, diese Folge von Unterzielen zu nutzen, um das Endziel zu erreichen.

Das System lernt Aktionspläne auf mehreren Abstraktionsebenen und mehreren Zeitskalen und löst im Prinzip das, was neuerdings als „offene Probleme“ bezeichnet wird.

Zwölf, März 1991: Transformer mit linearer Selbstaufmerksamkeit

Transformer mit „linearer Selbstaufmerksamkeit“ wurde erstmals im März 1991 veröffentlicht.

Diese sogenannten „Fast Weight Programmer“ oder „Fast Weight Controller“ trennen Speicherung und Steuerung genau wie herkömmliche Computer, jedoch in einem End-to-End-Differenzierungs-, adaptiven und neuronalen Netzwerkansatz.

Darüber hinaus nutzen die heutigen Transformers in großem Umfang unbeaufsichtigtes Vortraining, eine Deep-Learning-Methode, die erstmals 1990–1991 von Schmidhuber veröffentlicht wurde.

13. April 1991: Deep Learning durch selbstüberwachtes Vortraining

Die leistungsstärksten NNs von heute neigen dazu, sehr tief zu sein, das heißt, sie haben viele Neuronenschichten oder viele nachfolgende Berechnungsphasen.

Allerdings funktionierte das auf Gradienten basierende Training vor den 1990er Jahren nicht für tiefe NNs (nur für flache NNs).

Im Gegensatz zu Feedforward NN (FNN) verfügt RNN über Rückkopplungsverbindungen. Dies macht RNN zu einem leistungsstarken Allzweck-Parallelsequenzcomputer, der Eingabesequenzen beliebiger Länge (z. B. Sprache oder Video) verarbeiten kann.

Vor den 1990er Jahren gelang es RNN jedoch nicht, tiefgreifende Probleme in der Praxis zu erlernen.

Zu diesem Zweck etablierte Schmidhuber eine selbstüberwachte RNN-Hierarchie, um zu versuchen, „universelles Deep Learning“ zu erreichen. April 1991: Destillieren eines NN in ein anderes NN ).

Hier wird das Wissen des Lehrers NN in den Schüler NN „destilliert“, indem der Schüler NN darin trainiert wird, das Verhalten des Lehrers NN nachzuahmen (während gleichzeitig der Schüler NN umgeschult wird, um sicherzustellen, dass die zuvor erlernten Fähigkeiten nicht beeinträchtigt werden). vergessen). Auch die NN-Destillationsmethode wurde viele Jahre später neu veröffentlicht und ist heute weit verbreitet.

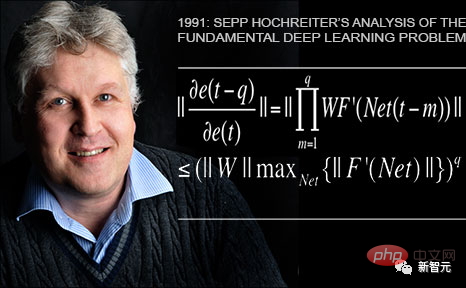

14. Juni 1991: Grundproblem – Verschwinden des Gradienten

Schmidhubers erster Schüler Sepp Hochreiter entdeckte und analysierte in seiner Abschlussarbeit 1991 grundlegende Deep-Learning-Probleme.Tiefe NNs leiden unter dem mittlerweile berühmten Problem des verschwindenden Gradienten: In typischen tiefen oder wiederkehrenden Netzwerken nimmt das rückwärts propagierte Fehlersignal entweder schnell ab oder wächst außerhalb der Grenzen. In beiden Fällen scheitert das Lernen. Fünfzehnter Juni 1991: Die Basis von LSTM/Highway Net/ResNet Lernprobleme bei Abschlussarbeiten.

Nach der Veröffentlichung eines von Experten begutachteten Artikels im Jahr 1997 (heute der am häufigsten zitierte NN-Artikel im 20. Jahrhundert) verbesserten unter anderem Schmidhubers Studenten Felix Gers und Alex Graves LSTM und seine Trainingsverfahren weiter.

Die 1999-2000 veröffentlichte LSTM-Variante – die „Vanilla LSTM-Architektur“ mit Forgeting Gates – wird auch heute noch in Googles Tensorflow verwendet.

Im Jahr 2005 veröffentlichte Schmidhuber erstmals einen Artikel über die vollständige Backpropagation und die bidirektionale Ausbreitung von LSTM in der Zeit (ebenfalls weit verbreitet).

Im Jahr 2005 veröffentlichte Schmidhuber erstmals einen Artikel über die vollständige Backpropagation und die bidirektionale Ausbreitung von LSTM in der Zeit (ebenfalls weit verbreitet).

Eine bahnbrechende Trainingsmethode im Jahr 2006 ist die „Connectionist Temporal Classification“ (CTC), mit der Sequenzen gleichzeitig ausgerichtet und identifiziert werden.

Schmidhubers Team hat CTC-trainiertes LSTM 2007 erfolgreich auf Sprache angewendet (es gibt auch geschichtete LSTM-Stacks) und dabei erstmals hervorragende End-to-End-Ergebnisse bei der neuronalen Spracherkennung erzielt.

Im Jahr 2009 gewann LSTM, das von CTC trainiert wurde, durch Alex‘ Bemühungen als erster RNN internationale Wettbewerbe, nämlich drei ICDAR 2009-Handschriftwettbewerbe (Französisch, Farsi, Arabisch). Dies hat großes Interesse in der Branche geweckt. LSTM wurde schnell in allen Situationen eingesetzt, in denen es um Sequenzdaten wie Sprache und Video ging.

Im Jahr 2015 verbesserte die CTC-LSTM-Kombination die Spracherkennungsleistung von Google auf Android-Smartphones erheblich. Bis 2019 basierte Googles Spracherkennung auf dem mobilen Endgerät noch auf LSTM.

1995: Neuronales probabilistisches Sprachmodell

1995 schlug Schmidhuber ein hervorragendes neuronales probabilistisches Textmodell vor, dessen Grundkonzepte 2003 wiederverwendet wurden.

Im Jahr 2001 zeigte Schmidhuber, dass LSTM Sprachen lernen kann, die traditionelle Modelle wie HMM nicht können.

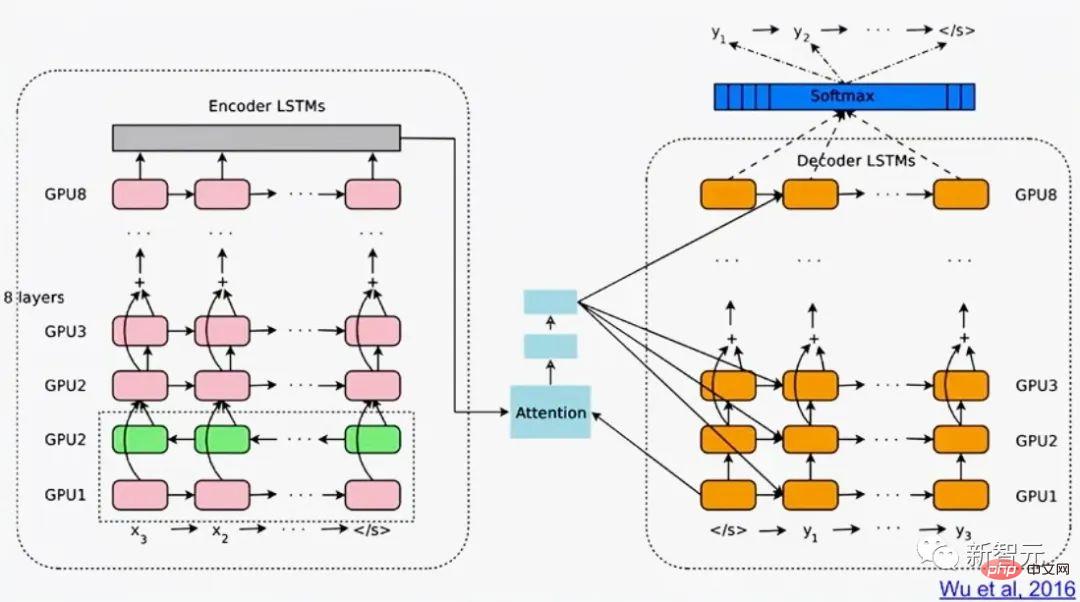

Google Translate im Jahr 2016 basiert auf zwei verbundenen LSTMs (das Whitepaper erwähnt LSTM mehr als 50 Mal), eines für eingehenden Text und eines für ausgehende Übersetzungen.

Im selben Jahr wurde mehr als ein Viertel der enormen Rechenleistung, die in Google-Rechenzentren für Inferenzen verwendet wird, für LSTM verwendet (und 5 % wurden für eine andere beliebte Deep-Learning-Technologie, CNN, verwendet).

Bis 2017 unterstützte LSTM auch die maschinelle Übersetzung für Facebook (mehr als 30 Milliarden Übersetzungen pro Woche), Apple Powered von Quicktype auf rund 1 Milliarde iPhones, Amazons Alexa-Sprache, Googles Bildunterschriftengenerierung und automatisierten E-Mail-Antworten, unter anderem.

Natürlich wird Schmidhubers LSTM auch im Gesundheitswesen und in der medizinischen Diagnose häufig verwendet – eine einfache Google Scholar-Suche kann unzählige solche mit „LSTM“ im Titel Medizinische Artikel finden .

Im Mai 2015 schlug das Schmidhuber-Team das Highway Network auf Basis des LSTM-Prinzips vor, das erste mit Hunderten von Schichten Sehr tiefes FNN (frühere NNs hatten höchstens Dutzende von Schichten). Microsofts ResNet (das den ImageNet 2015-Wettbewerb gewann) ist eine Version davon.

Die Leistung des frühen Highway Net auf ImageNet war ungefähr die gleiche wie die von ResNet. Varianten von Highway Net werden auch für bestimmte algorithmische Aufgaben verwendet, bei denen reine Restschichten nicht gut funktionieren.

Das LSTM/Highway Net-Prinzip ist der Kern des modernen Deep Learning.

Der Kern des Deep Learning ist NN-Tiefe.

In den 1990er Jahren brachte LSTM überwachten rekursiven NNs im Wesentlichen unbegrenzte Tiefe; im Jahr 2000 brachte das LSTM-inspirierte Highway Net Feedforward-NN.

Jetzt ist LSTM das am häufigsten zitierte NN im 20. Jahrhundert. und eine Version von Highway Net, ResNet, ist das am häufigsten zitierte NN im 21. Jahrhundert.

Sechzehn, 1980 bis heute: NNN lernt, ohne Lehrer zu handeln

Darüber hinaus steht NN auch im Zusammenhang mit Reinforcement Learning (RL) verwandt.

Obwohl einige der Probleme durch nicht-neurologische Technologien gelöst werden können, die bereits in den 1980er Jahren erfunden wurden. Zum Beispiel Monte-Carlo-Baumsuche (MC), dynamische Programmierung (DP), künstliche Evolution, α-β-Beschneidung, Kontrolltheorie und Systemidentifikation, stochastischer Gradientenabstieg und allgemeine Suchtechniken. Aber tiefes FNN und RNN können bei bestimmten Arten von RL-Aufgaben bessere Ergebnisse bringen.

Im Allgemeinen muss ein Reinforcement-Learning-Agent lernen, mit einer dynamischen, zunächst unbekannten und teilweise beobachtbaren Umgebung ohne die Hilfe eines Lehrers zu interagieren und so das Erwartete zu maximieren kumulatives Belohnungssignal. Es kann zu willkürlichen, a priori unbekannten Verzögerungen zwischen Handlungen und wahrgenommenen Konsequenzen kommen. Dynamische Programmierung (RL mit DP)/Zeitdifferenz (TD)/Monte-Carlo-Baumsuche (MC) wird sehr erfolgreich sein.

Für komplexere Situationen ohne Markov-Schnittstelle muss der Agent nicht nur die aktuelle Eingabe, sondern auch den Verlauf früherer Eingaben berücksichtigen. In dieser Hinsicht ist die Kombination von RL-Algorithmen und LSTM zu einer Standardlösung geworden, insbesondere LSTM, das durch Richtliniengradienten trainiert wird.

Zum Beispiel lernte 2018 ein PG-trainierter LSTM im Herzen von OpenAIs berühmtem Dactyl, einen geschickten Roboter ohne eine Roboterhand eines Lehrers zu steuern. Das Gleiche gilt für Videospiele.

Im Jahr 2019 schlug DeepMind (von einem Studenten aus Schmidhubers Labor mitbegründet) professionelle Spieler im Spiel StarCraft mit Alphastar. Es gibt einen tiefen LSTM-Kern, der von trainiert wird PG.

Gleichzeitig ist RL LSTM (das 84 % der Gesamtzahl der Parameter im Modell ausmacht) auch der Kern der berühmten OpenAI Five, die professionelle menschliche Spieler in Dota 2 besiegten.

In der Zukunft von RL geht es um das Lernen/Kombinieren/Planen mit kompakten räumlich-zeitlichen Abstraktionen komplexer Eingabeströme, wobei es um gesundes Denken und das Erlernen des Denkens geht.

Schmidhuber schlug in einem 1990-91 veröffentlichten Artikel vor, dass ein selbstüberwachter neuronaler Geschichtskompressor Darstellungskonzepte auf mehreren Abstraktionsebenen und auf mehreren Zeitskalen lernen kann Der Unterzielgenerator basiert auf durchgängig unterscheidbarem NN und kann durch Gradientenabstieg hierarchische Aktionspläne lernen.

Später in den Jahren 1997 und 2015–18 wurden ausgefeiltere Methoden zum Erlernen des abstrakten Denkens veröffentlicht.

Siebzehn, es ist ein Hardwareproblem, Idiot!

Wenn es in den letzten tausend Jahren keine kontinuierlichen Verbesserungen und beschleunigten Upgrades von Computern gegeben hätte Es ist unwahrscheinlich, dass Hardware und Deep-Learning-Algorithmen zu großen Durchbrüchen führen werden.

Unser erstes bekanntes Computergerät mit Zahnrädern war der Antikythera-Mechanismus aus dem antiken Griechenland vor über 2.000 Jahren. Es ist der älteste heute bekannte komplexe wissenschaftliche Computer und der erste analoge Computer der Welt.

Antikythera Machinery

#🎜 🎜#Die weltweit erste praktische programmierbare Maschine wurde im 1. Jahrhundert n. Chr. von der antiken griechischen Mechanikerin Helena erfunden.

Maschinen wurden im 17. Jahrhundert flexibler und konnten Antworten auf der Grundlage von Eingabedaten berechnen.

Der erste mechanische Rechner für einfache Arithmetik wurde 1623 von Wilhelm Schickard erfunden und hergestellt.

Im Jahr 1673 konstruierte Leibniz die erste Maschine, die alle vier Rechenoperationen ausführen konnte und über ein Gedächtnis verfügte. Er beschrieb auch die Prinzipien eines binären Computers, der durch eine Lochkarte gesteuert wird, und schlug die Kettenregel vor, die einen wichtigen Bestandteil des Deep Learning und der modernen künstlichen Intelligenz darstellt.

Leibniz-Multiplikator #🎜 🎜#

Um 1800 bauten Joseph Marie Jacquard und andere den ersten gestaltbaren Webstuhl in Frankreich – die Jacquard-Maschine. Diese Erfindung war entscheidend für die zukünftige Entwicklung anderer programmierbarer Maschinen, beispielsweise Computer.

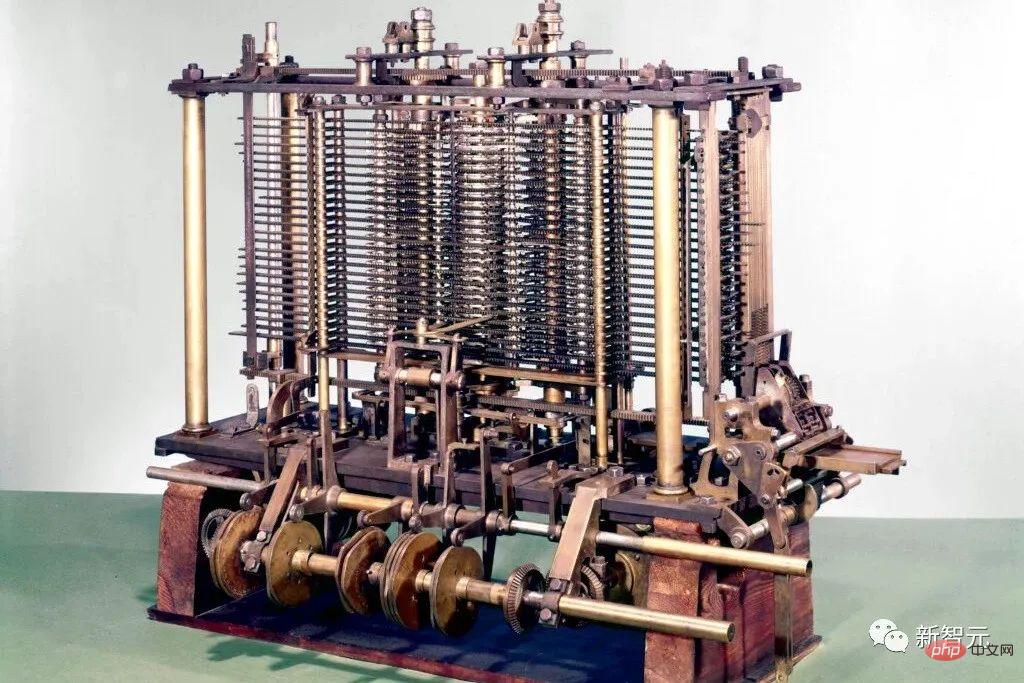

Jacquard Loom# 🎜 🎜# Sie inspirierten Ada Lovelace und ihren Mentor Charles Babbage, einen Vorläufer des modernen elektronischen Computers zu erfinden: Babbages Difference Engine.

Im folgenden Jahr 1843 veröffentlichte Lovelace den weltweit ersten Satz von Computeralgorithmen.

# 🎜 🎜 # Im Jahr 1914 wurde der Spanier Leonardo Torres y Quevedo der erste Pionier der künstlichen Intelligenz des 20. Jahrhunderts, als er den ersten Schachterminal-Automatenspieler entwickelte.

Zwischen 1935 und 1941 erfand Konrad Zuse den ersten funktionsfähigen programmierbaren Allzweckcomputer der Welt: den Z3.

Conrad Zuse

Im Gegensatz zu Babbages Analytical Engine verwendete Zuse die binären Berechnungsprinzipien von Leibniz anstelle traditioneller Dezimalrechnungen. Dies vereinfacht die Belastung der Hardware erheblich.

Im Jahr 1944 leitete Howard Aiken ein Team, das den ersten großen automatischen Digitalcomputer der Welt erfand, Mark I (Mark I).

1948 erfanden Frederic Williams, Tom Kilburn und Geoff Tootill den weltweit ersten elektronischen Computer mit gespeicherten Programmen: Small Experimental Machine (SSEM), auch bekannt als „Manchester Baby“.

Replik „Manchester Baby“

Seitdem sind Computeroperationen mithilfe integrierter Schaltkreise (ICs) schneller geworden. Im Jahr 1949 meldete Werner Jacobi von Siemens ein Patent für einen integrierten Halbleiterschaltkreis an, der mehrere Transistoren auf einem gemeinsamen Substrat ermöglichen würde.

Im Jahr 1958 demonstrierte Jack Kilby einen integrierten Schaltkreis mit externen Drähten. 1959 schlug Robert Noyce den monolithischen integrierten Schaltkreis vor. Seit den 1970er Jahren werden Grafikprozessoren (GPUs) verwendet, um die Rechenleistung durch Parallelverarbeitung zu beschleunigen. Heutzutage enthält die GPU eines Computers Milliarden von Transistoren.

Wo liegen die körperlichen Grenzen?

Nach der von Hans Joachim Bremermann vorgeschlagenen Bremermann-Grenze kann ein Computer mit einer Masse von 1 Kilogramm und einem Volumen von 1 Liter in der 32. Richtung bis zu 10 bis zu 10 hoch 51 Operationen pro ausführen zweite.

Hans Joachim Bremermann

Da die Masse des Sonnensystems jedoch nur 2x10^30 Kilogramm beträgt, wird dieser Trend innerhalb weniger Jahrhunderte zwangsläufig brechen, da die Lichtgeschwindigkeit ansteigt Zusätzliche Masse in Form anderer Sonnensysteme ist stark begrenzt.

Daher erfordern die Beschränkungen der Physik, dass zukünftige effiziente Computerhardware wie ein Gehirn sein muss, mit vielen kompakt platzierten Prozessoren im dreidimensionalen Raum, um die Gesamtverbindungskosten zu minimieren, und ihre Grundarchitektur im Wesentlichen eine tiefe, spärlich verbundene Architektur ist dreidimensionales RNN.

Schmidhuber spekuliert, dass Deep-Learning-Methoden wie RNN an Bedeutung gewinnen werden.

18. Theorie der künstlichen Intelligenz seit 1931

Der Kern der modernen künstlichen Intelligenz und des Deep Learning basiert hauptsächlich auf der Mathematik der letzten Jahrhunderte: Analysis, lineare Algebra und Statistik.

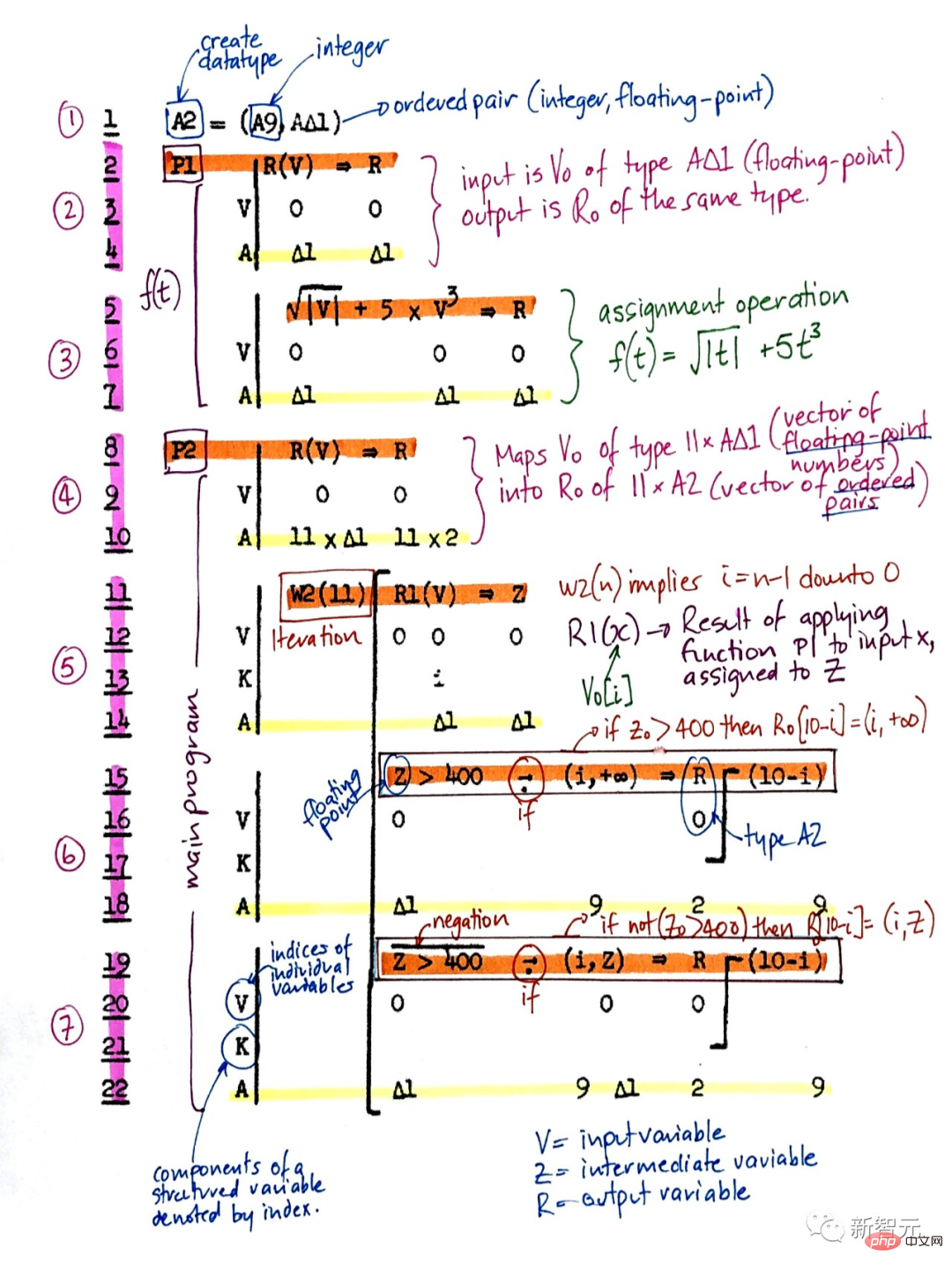

In den frühen 1930er Jahren begründete Gödel die moderne theoretische Informatik. Er führte eine universelle, auf ganzen Zahlen basierende Programmiersprache ein, die es ermöglichte, die Operationen jedes digitalen Computers in axiomatischer Form zu formalisieren.

Gleichzeitig konstruierte Gödel auch die berühmte formale Aussage, alle möglichen Theoreme aus einem aufzählbaren Satz von Axiomen systematisch aufzuzählen, wenn ein rechnerischer Theoremtester gegeben wurde. So identifizierte er grundlegende Einschränkungen des algorithmischen Theorembeweises, der Berechnung und jeder Art von rechnerbasierter künstlicher Intelligenz.

Darüber hinaus identifizierte Gödel in seinem berühmten Brief an John von Neumann das berühmteste offene Problem der Informatik: „P=NP?“

Im Jahr 1935 leitete Alonzo Church eine Konsequenz aus Gödels Ergebnis ab, indem er bewies, dass es keine allgemeine Lösung für das Entscheidungsproblem von Hilbert und Ackermann gibt. Zu diesem Zweck verwendete er eine andere seiner Allzweck-Codierungssprachen namens Untyped Lambda Calculus, die die Grundlage der äußerst einflussreichen Programmiersprache LISP bildete.

Im Jahr 1936 führte Alan Turing ein weiteres allgemeines Modell ein: die Turing-Maschine, und erzielte erneut die oben genannten Ergebnisse. Im selben Jahr veröffentlichte Emil Post ein weiteres unabhängiges allgemeines Rechenmodell.

Konrad Zuse schuf nicht nur den weltweit ersten nutzbaren programmierbaren Allzweckcomputer, sondern entwarf auch die erste höhere Programmiersprache – Plankalkül. Er wandte es 1945 auf das Schachspiel und 1948 auf den Satzbeweis an.

Plankalkül

Bei einem großen Teil der frühen KI in den 1940er- und 70er-Jahren ging es in Wirklichkeit um die Beweisführung von Theoremen und die Gödelsche Ableitung durch Expertensysteme und Logikprogrammierung.

Im Jahr 1964 kombinierte Ray Solomonoff Bayes'sches (eigentlich Laplacesches) Wahrscheinlichkeitsdenken und theoretische Informatik, um zu einer mathematisch optimalen (aber rechnerisch nicht durchführbaren) Lernmethode zu gelangen, die zukünftige Daten aus vergangenen Beobachtungen vorhersagt.

Zusammen mit Andrej Kolmogorov gründete er die Theorie der Korotkoff-Komplexität oder Algorithmischen Informationstheorie (AIT), die das Konzept von Occams Rasiermesser durch das Konzept des kürzesten Programms zur Datenberechnung formalisiert und damit über die traditionelle Informationstheorie hinausgeht.

Coriolis-Komplexität

Die allgemeinere Optimalität selbstreferenzierender Gödel-Maschinen ist nicht auf die asymptotische Optimalität beschränkt.

Dennoch ist eine solche mathematisch optimale künstliche Intelligenz aus verschiedenen Gründen noch nicht in der Praxis umsetzbar. Stattdessen basiert die praktische moderne künstliche Intelligenz auf suboptimalen, begrenzten, aber nicht vollständig verstandenen Technologien, wie beispielsweise NN und Deep Learning.

Aber wer weiß, wie die Geschichte der künstlichen Intelligenz in 20 Jahren aussehen wird?

Das obige ist der detaillierte Inhalt von300 Jahre künstliche Intelligenz! Der Vater von LSTM schreibt einen 10.000 Wörter langen Artikel: Ausführliche Erläuterung der Entwicklungsgeschichte moderner KI und Deep Learning. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr