Heim >Technologie-Peripheriegeräte >KI >Das neue Werk des Reinforcement-Learning-Guru Sergey Levine: Drei große Modelle bringen Robotern bei, ihren Weg zu erkennen

Das neue Werk des Reinforcement-Learning-Guru Sergey Levine: Drei große Modelle bringen Robotern bei, ihren Weg zu erkennen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 23:55:091512Durchsuche

Ein Roboter mit einem großen eingebauten Modell hat gelernt, Sprachanweisungen zu befolgen, um sein Ziel zu erreichen, ohne auf eine Karte zu schauen. Diese Errungenschaft stammt aus der neuen Arbeit des Reinforcement-Learning-Gurus Sergey Levine.

Wie schwierig ist es, angesichts eines Ziels ohne Navigationsspuren erfolgreich anzukommen?

Diese Aufgabe ist auch für Menschen mit schlechtem Orientierungssinn eine große Herausforderung. Doch in einer aktuellen Studie „lernten“ mehrere Wissenschaftler den Roboter mit nur drei vorab trainierten Modellen.

Wir alle wissen, dass eine der zentralen Herausforderungen des Roboterlernens darin besteht, Roboter in die Lage zu versetzen, eine Vielzahl von Aufgaben gemäß anspruchsvollen menschlichen Anweisungen auszuführen. Dafür sind Roboter erforderlich, die menschliche Anweisungen verstehen können und über eine Vielzahl verschiedener Aktionen verfügen, um diese Anweisungen in der realen Welt auszuführen.

Für Anweisungen zur Verfolgung von Navigationsaufgaben konzentrierten sich frühere Arbeiten hauptsächlich auf das Lernen aus Flugbahnen, die mit Textanweisungen kommentiert wurden. Dies erleichtert möglicherweise das Verständnis von Textanweisungen, die Kosten für die Datenanmerkung haben jedoch eine weitverbreitete Verwendung dieser Technik verhindert. Andererseits haben neuere Arbeiten gezeigt, dass durch selbstüberwachtes Training zielkonditionierter Richtlinien eine robuste Navigation erlernt werden kann. Diese Methoden schulen visionsbasierte Controller an großen, unbeschrifteten Datensätzen durch Post-hoc-Neubeschriftung. Diese Methoden sind skalierbar, allgemein und robust, erfordern jedoch häufig die Verwendung umständlicher orts- oder bildbasierter Zielspezifikationsmechanismen.

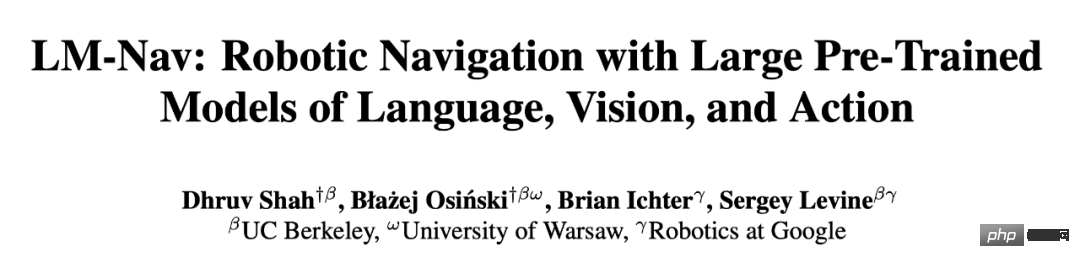

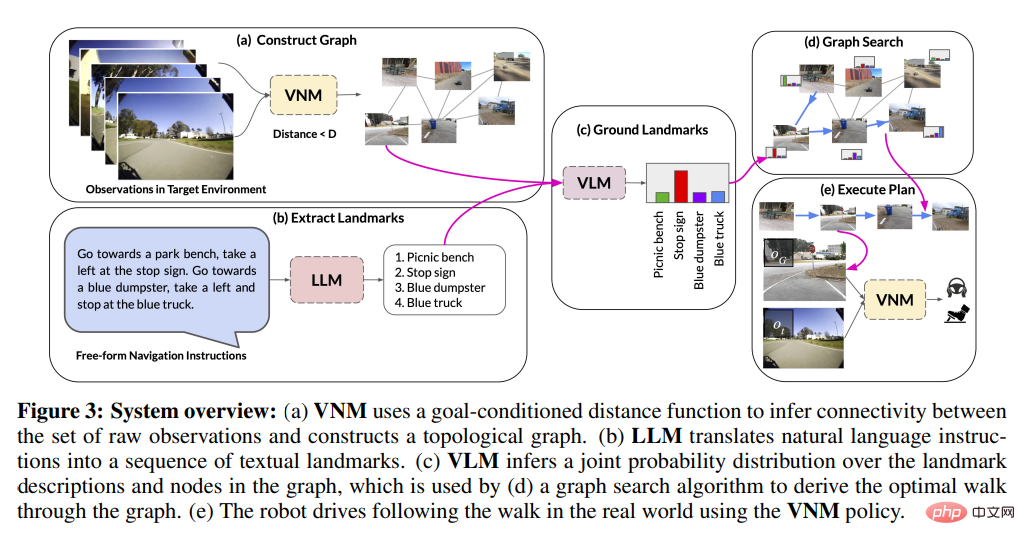

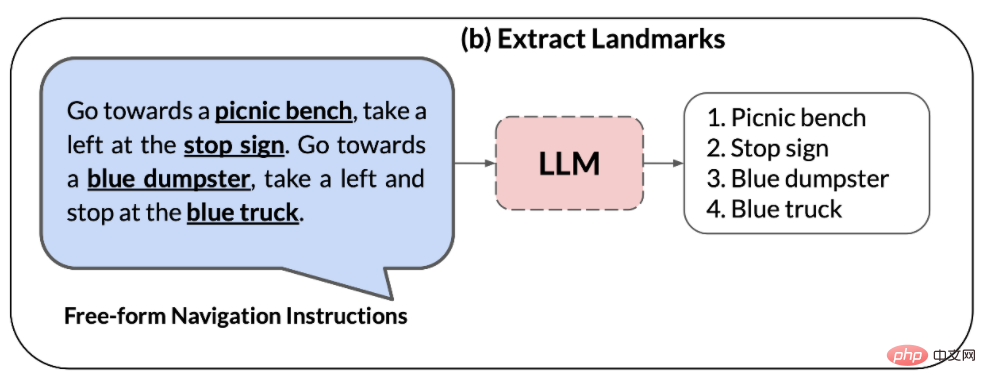

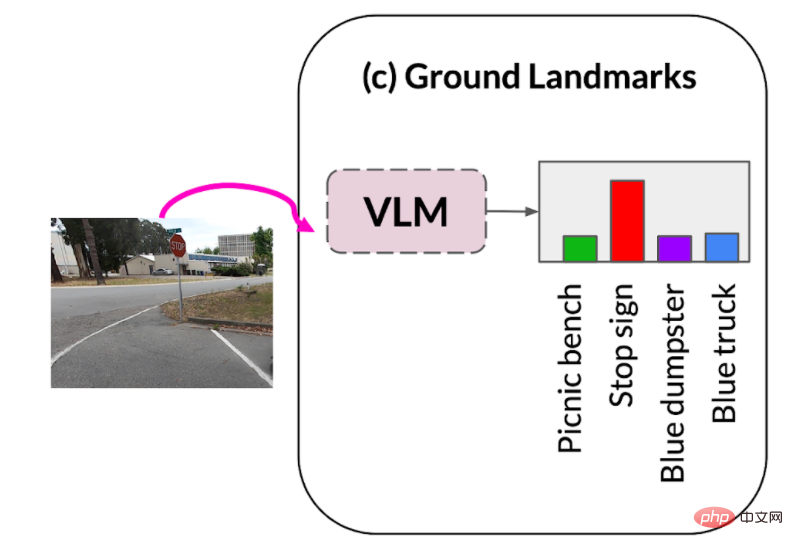

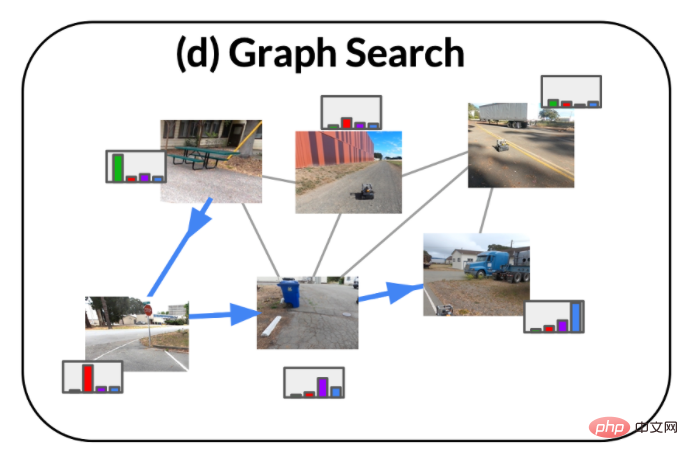

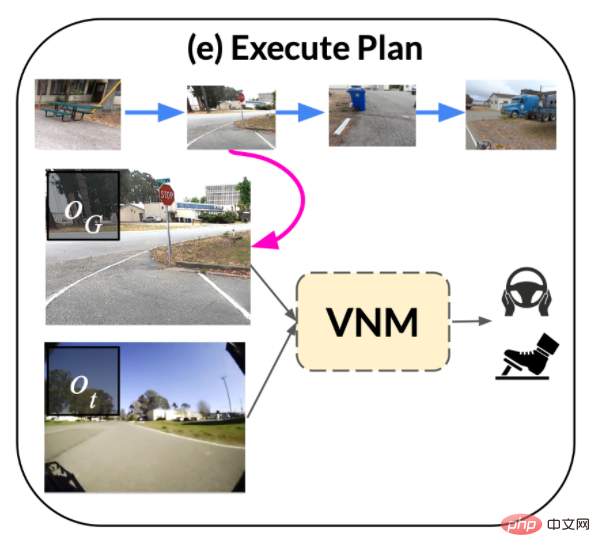

In einem aktuellen Artikel wollen Forscher der UC Berkeley, von Google und anderen Institutionen die Vorteile dieser beiden Methoden kombinieren, um mithilfe vorab trainierter Fähigkeiten ein selbstüberwachtes System für die Roboternavigation auf Navigationsdaten ohne Benutzeranmerkungen anwendbar zu machen des Modells, um Anweisungen in natürlicher Sprache auszuführen. Forscher nutzen diese Modelle, um eine „Schnittstelle“ zu bauen, die dem Roboter Aufgaben mitteilt. Dieses System nutzt die Generalisierungsfähigkeiten vorab trainierter Sprach- und Vision-Sprachmodelle, um es Robotersystemen zu ermöglichen, komplexe Anweisungen auf hoher Ebene zu akzeptieren. Der Forscher beobachtete: Schnittstellen können erstellt werden, indem handelsübliche, vorab trainierte Modelle genutzt werden, die auf großen Korpora visueller und sprachlicher Datensätze trainiert wurden, die weithin verfügbar sind und Zero-Shot-Generalisierungsfähigkeiten gezeigt haben, um eine spezifische Befehlsverfolgung zu ermöglichen. Um dies zu erreichen, kombinierten die Forscher die Vorteile von vorab trainierten Vision- und Sprachroboter-agnostischen Modellen sowie vorab trainierten Navigationsmodellen. Konkret verwendeten sie ein visuelles Navigationsmodell (VNM:ViNG), um die visuelle Ausgabe eines Roboters in eine topologische „mentale Karte“ der Umgebung umzuwandeln. Bei einer Freiform-Textanweisung wird ein vorab trainiertes großes Sprachmodell (LLM: GPT-3) verwendet, um die Anweisung in eine Reihe von Merkmalspunkten in Textform zu dekodieren. Anschließend wird ein visuelles Sprachmodell (VLM: CLIP) verwendet, um diese Textmerkmalspunkte in der topologischen Karte festzulegen, indem die gemeinsame Wahrscheinlichkeit von Merkmalspunkten und Knoten abgeleitet wird. Anschließend wird ein neuer Suchalgorithmus verwendet, um die probabilistische Zielfunktion zu maximieren und den Befehlspfad des Roboters zu finden, der dann vom VNM ausgeführt wird. Der Hauptbeitrag der Forschung ist die Navigationsmethode unter Großmodellen (LM Nav), ein spezifisches System zur Befehlsverfolgung. Es kombiniert drei große unabhängige vorab trainierte Modelle – ein selbstüberwachtes Robotersteuerungsmodell, das visuelle Beobachtungen und physische Aktionen nutzt (VNM), ein visuelles Sprachmodell, das Bilder in Text platziert, jedoch ohne konkrete Implementierungsumgebung (VLM), und ein großes Sprachmodell, das Text analysiert und übersetzt, aber keine visuelle Grundlage oder verkörperten Sinn (LLM) hat, um eine langfristige Befehlsverfolgung in komplexen realen Umgebungen zu ermöglichen. Zum ersten Mal instanziierten Forscher die Idee, vorab trainierte Seh- und Sprachmodelle mit zielbedingten Controllern zu kombinieren, um ohne Feinabstimmung umsetzbare Befehlspfade in der Zielumgebung abzuleiten. Bemerkenswert ist, dass alle drei Modelle auf großen Datensätzen trainiert werden, über selbstüberwachte Zielfunktionen verfügen und ohne Feinabstimmung sofort verwendet werden können – für das Training von LM Nav ist keine menschliche Annotation der Roboternavigationsdaten erforderlich.

-

Übersicht über das LM-Nav-Modell

Wie nutzen Forscher also vorab trainierte Bild- und Sprachmodelle, um Textschnittstellen für visuelle Navigationsmodelle bereitzustellen?

1. Bei einer Reihe von Beobachtungen in der Zielumgebung verwendet die zielbedingte Distanzfunktion, die Teil des visuellen Navigationsmodells (VNM) ist, um die Konnektivität zwischen ihnen abzuleiten und die Umgebungstopologie zu erstellen Diagramm der Konnektivität.

2. Das Large Language Model (LLM) wird verwendet, um Anweisungen in natürlicher Sprache in eine Reihe von Feature-Punkten zu zerlegen. Diese Feature-Punkte können als Zwischenziele für die Navigation verwendet werden.

3. Das Visual-Language Model (VLM) wird verwendet, um visuelle Beobachtungen basierend auf Feature-Point-Phrasen zu erstellen. Das visuelle Sprachmodell leitet eine gemeinsame Wahrscheinlichkeitsverteilung über die Merkmalspunktbeschreibungen und Bilder ab (die die Knoten in der obigen Grafik bilden).

4. Unter Verwendung der Wahrscheinlichkeitsverteilung von VLM und der von VNM abgeleiteten Graphenkonnektivität verwendet einen neuartigen Suchalgorithmus, um einen optimalen Befehlspfad in der Umgebung abzurufen, der (i) dem Original entspricht Anweisung, (ii) ist der kürzeste Weg im Diagramm, der das Ziel erreichen kann.

5. Dann Der Anweisungspfad wird von der Zielbedingungsrichtlinie ausgeführt, die Teil des VNM ist.

Experimentelle Ergebnisse

Qualitative Bewertung

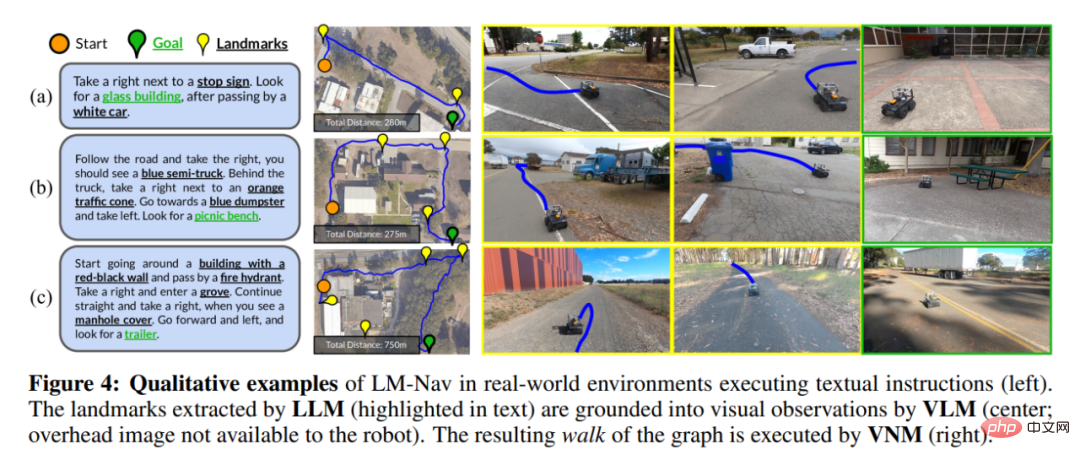

Abbildung 4 zeigt einige Beispiele für den vom Roboter zurückgelegten Weg (beachten Sie, dass der Roboter das Bild über dem Kopf und die räumliche Positionierung der Merkmalspunkte nicht erhalten kann). was gezeigt wird, ist nur ein visueller Effekt).

In Abbildung 4(a) ist LM-Nav in der Lage, einfache Feature-Punkte aus seinen vorherigen Durchquerungen erfolgreich zu lokalisieren und einen kurzen Weg zum Ziel zu finden. Obwohl es in der Umgebung mehrere Parkmerkmalspunkte gibt, ermöglicht die Zielfunktion in Gleichung 3 dem Roboter, den richtigen Parkmerkmalspunkt im Kontext auszuwählen, wodurch die Gesamtfahrstrecke minimiert wird.

Abbildung 4(b) verdeutlicht die Fähigkeit von LM-Nav, bestimmte Routen mit mehreren Feature-Punkten zu analysieren – auch wenn das direkte Erreichen des letzten Feature-Punkts die kürzeste Route ist, wenn der Anweisungspfad ignoriert wird, kann der Roboter dennoch einen A-Pfad finden besucht alle Feature-Punkte in der richtigen Reihenfolge.

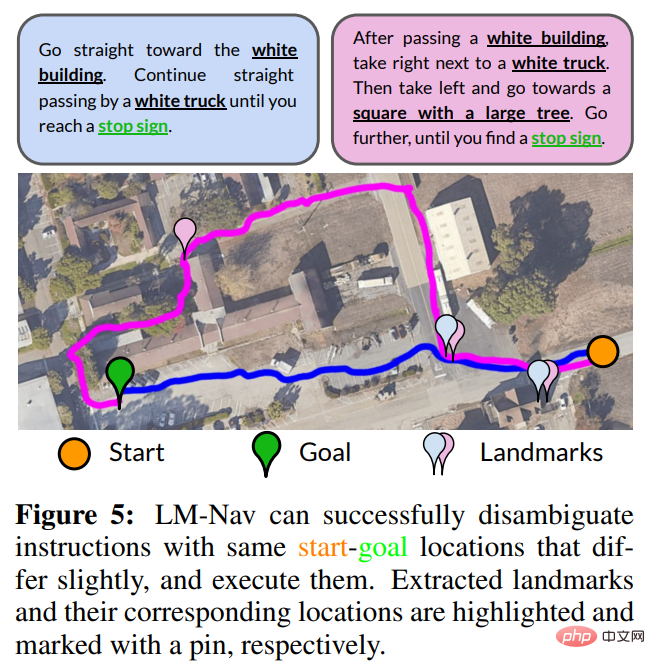

Verwenden Sie Direktiven zur Eindeutigkeit. Da das Ziel von LM Nav darin besteht, Anweisungen zu befolgen und nicht nur das Endziel zu erreichen, können unterschiedliche Anweisungen zu unterschiedlichen Durchquerungen führen. Abbildung 5 zeigt ein Beispiel, bei dem das Ändern von Anweisungen mehrere Pfade zu einem Ziel eindeutig machen kann. Für kürzere Eingabeaufforderungen (blau) bevorzugt LM Nav den direkteren Pfad. Wenn Sie eine detailliertere Route (Magenta) angeben, wählt LM Nav alternative Pfade durch verschiedene Sätze von Feature-Punkten.

Die Situation fehlender Feature-Punkte. Obwohl LM-Nav Feature-Punkte in Anweisungen effektiv analysieren, sie im Diagramm lokalisieren und den Weg zum Ziel finden kann, beruht dieser Prozess auf der Annahme, dass Feature-Punkte (i) in der realen Umgebung vorhanden sind und (ii) vorhanden sein können Von VLM anerkannt. Abbildung 4(c) zeigt eine Situation, in der der ausführbare Pfad einen der Feature-Punkte – einen Hydranten – nicht erreicht und einen Pfad um die Oberseite des Gebäudes statt um den Boden nimmt. Dieser Fehlerfall war darauf zurückzuführen, dass das VLM die Hydranten anhand der Beobachtungen des Roboters nicht erkennen konnte.

In einer unabhängigen Bewertung der Wirksamkeit von VLM beim Abrufen von Feature-Punkten stellten die Forscher fest, dass CLIP zwar das beste Standardmodell für diese Art von Aufgabe ist, eine kleine Anzahl „harter“ Feature-Punkte jedoch nicht abrufen kann , einschließlich Hydranten und Betonmischer. Aber in vielen realen Situationen kann der Roboter immer noch erfolgreich einen Weg finden, um die verbleibenden Feature-Punkte zu besuchen.

Quantitative Bewertung

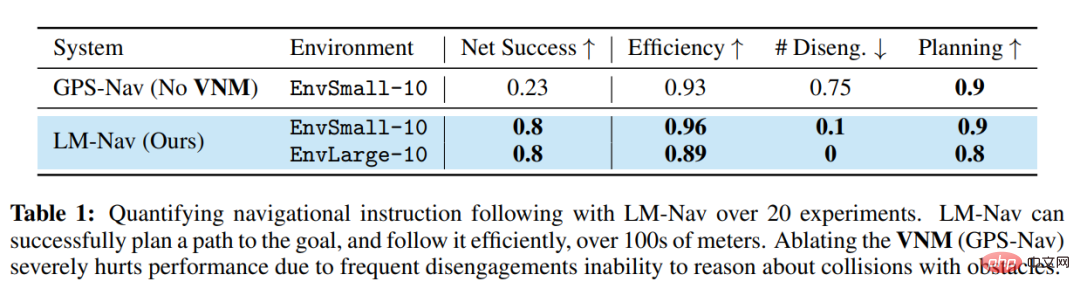

Tabelle 1 fasst die quantitative Leistung dieses Systems in 20 Anweisungen zusammen. In 85 % der Experimente war LM-Nav in der Lage, Anweisungen konsequent ohne Kollisionen oder Ablösungen zu befolgen (durchschnittlich ein Eingriff alle 6,4 Kilometer Fahrt). Im Vergleich zum Basismodell ohne Navigation schneidet LM-Nav durchweg besser bei der Ausführung effizienter, kollisionsfreier Zielpfade ab. Bei allen erfolglosen Experimenten kann der Fehler auf unzureichende Fähigkeiten in der Planungsphase zurückgeführt werden – die Unfähigkeit des Suchalgorithmus, bestimmte „harte“ Merkmalspunkte im Diagramm intuitiv zu lokalisieren – was zu einer unvollständigen Ausführung von Anweisungen führt. Eine Untersuchung dieser Fehlermodi ergab, dass der kritischste Teil des Systems die Fähigkeit des VLM ist, unbekannte Merkmalspunkte wie Hydranten und Szenen unter schwierigen Lichtverhältnissen wie unterbelichtete Bilder zu erkennen.

Das obige ist der detaillierte Inhalt vonDas neue Werk des Reinforcement-Learning-Guru Sergey Levine: Drei große Modelle bringen Robotern bei, ihren Weg zu erkennen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr