Heim >Technologie-Peripheriegeräte >KI >Hinter dem Karneval von ChatGPT: Es gibt immer noch Mängel, aber es gibt viele Inspirationen. Hier sind die Dinge, die Sie im Jahr 2023 tun können ...

Hinter dem Karneval von ChatGPT: Es gibt immer noch Mängel, aber es gibt viele Inspirationen. Hier sind die Dinge, die Sie im Jahr 2023 tun können ...

- PHPznach vorne

- 2023-04-12 23:31:011797Durchsuche

Im letzten Monat des Jahres 2022 reagierte OpenAI ein ganzes Jahr lang mit einem beliebten Konversationsroboter – ChatGPT – auf die Erwartungen der Menschen, obwohl es sich nicht um das lang erwartete GPT-4 handelt.

Jeder, der ChatGPT verwendet hat, kann verstehen, dass es ein echter „Hexagon-Krieger“ ist: Es kann nicht nur zum Chatten, Suchen und Übersetzen verwendet werden, sondern auch Schreiben Sie Geschichten, schreiben Sie Code, debuggen Sie und entwickeln Sie sogar kleine Spiele und legen Sie die Aufnahmeprüfung für das amerikanische College ab ... Manche Leute scherzen, dass es von nun an nur noch zwei Arten von Modellen für künstliche Intelligenz geben wird – ChatGPT und andere.

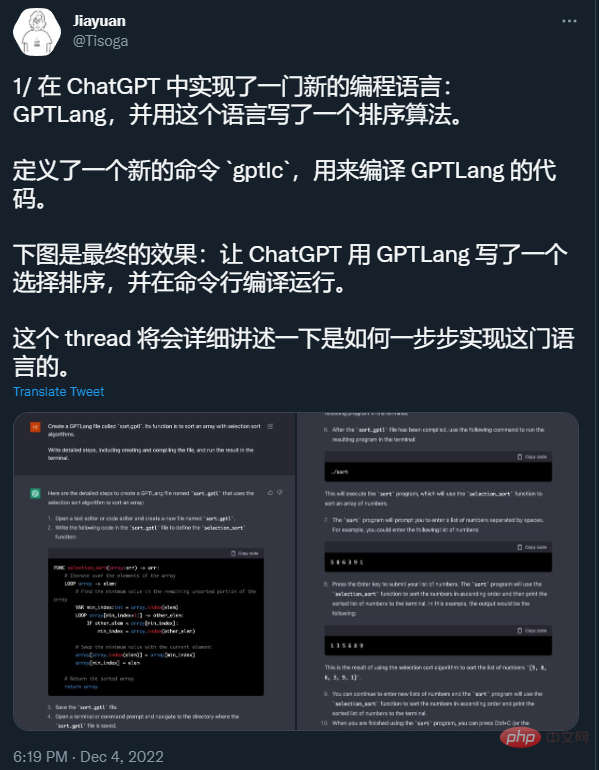

Quelle: https://twitter.com/Tisoga/status/1599347662888882177#🎜 🎜 #

Aufgrund seiner erstaunlichen Fähigkeiten zog ChatGPT in nur 5 Tagen nach seiner Einführung 1 Million Benutzer an. Viele Menschen gehen mutig davon aus, dass ChatGPT bald Suchmaschinen wie Google und Programmier-Frage- und Antwort-Communities wie Stack Overflow ersetzen wird, wenn sich dieser Trend fortsetzt. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#Bildquelle :https://twitter.com/whoiskatrin/status/1600421531212865536

ChatGPT Woher kommt diese mächtige Fähigkeit? Was sind die Mängel von ChatGPT?

Wird es in Zukunft Suchmaschinen ersetzen?

- Welche Inspiration bringt seine Entstehung für unsere KI-Forschung?

- In der sechsten technischen Live-Übertragung „REDtech kommt“, organisiert vom technischen Team von Xiaohongshu, NLP-Experte, University of California, Santa Barbara Assistant Professor Li Lei führte ein Gespräch mit Zhang Lei, Vizepräsident für Technologie von Xiaohongshu, und Zhang Debing, Leiter des Bereichs Multimedia Intelligent Algorithm der Xiaohongshu Community Department, um wichtige Fragen zu ChatGPT auszutauschen und zu beantworten.

- Li Lei schloss ihr Studium an der Fakultät für Informatik der Shanghai Jiao Tong University (ACM-Klasse) mit einem Bachelor-Abschluss und einem Doktortitel an der Fakultät für Informatik der Carnegie Mellon University ab. Er war als Postdoktorand an der University of California, Berkeley, als junger Wissenschaftler am Baidu US Deep Learning Laboratory und als leitender Direktor am ByteDance Artificial Intelligence Laboratory tätig.

- 2017 gewann Li Lei den zweiten Preis des Wu Wenjun Artificial Intelligence Technology Invention Award für seine Arbeit am KI-Schreibroboter Xiaomingbot. Xiaomingbot verfügt außerdem über leistungsstarke Funktionen zum Verständnis von Inhalten und zur Texterstellung und kann problemlos Sportereignisse übertragen und Finanznachrichten schreiben.

Die Hauptforschungsrichtungen von Li Lei sind maschinelles Lernen, Data Mining und Verarbeitung natürlicher Sprache. Er hat mehr als 100 Artikel auf führenden internationalen akademischen Konferenzen in den Bereichen maschinelles Lernen, Data Mining und Verarbeitung natürlicher Sprache veröffentlicht und ist Inhaber von mehr als 20 Patenten für technische Erfindungen. Er hat den zweiten Platz beim ACM SIGKDD Best Doctoral Thesis 2012, den CCF Distinguished Speaker 2017, den CCF Green Bamboo Award 2019 und den ACL Best Paper Award 2021 gewonnen.

Zhang Lei, Vizepräsident für Technologie bei Xiaohongshu, absolvierte die Shanghai Jiaotong University. Er war Vizepräsident für Technologie bei Huanju Times und verantwortlicher Chefarchitekt von Baidu Fengchao Für Baidu Search Advertising CTR funktioniert der maschinelle Lernalgorithmus. Er fungierte einst als technischer Leiter des IBM Deep Question Answering (DeepQA)-Projekts in China.

Zhang Debing, Leiter des multimedialen intelligenten Algorithmus der Gemeindeabteilung von Xiaohongshu, ehemaliger Chefwissenschaftler von GreenTong, Leiter der multimodalen intelligenten Schöpfung von Kuaishou, in der Technologieforschung Er hat Umfangreiche Erfahrung sowohl in der Geschäftsumsetzung als auch in der Geschäftsumsetzung. Er führte das Team zum Gewinn mehrerer akademischer Wettbewerbsmeisterschaften, darunter der FRVT-Weltmeisterschaft im internationalen Wettbewerb für maßgebliche Gesichtserkennung, und förderte Lebenslauf, multimodale und andere Technologien in den Bereichen Sicherheit, Einzelhandel und Sport usw. TO B Eine Reihe von Geschäften in C-Side-Szenarien wie Szenen und Kurzvideos, Werbung usw. wurden implementiert.

Die Diskussion der drei Gäste konzentrierte sich nicht nur auf die aktuellen Möglichkeiten und Probleme von ChatGPT, sondern warf auch einen Blick auf zukünftige Trends und Perspektiven. Im Folgenden sortieren und fassen wir die Inhalte des Austauschs zusammen.

OpenAI-Mitbegründer Greg Brockman hat kürzlich getwittert, dass 2023 das Jahr 2022 wie ein langweiliges Jahr für die Weiterentwicklung und Einführung von KI aussehen lassen wird. Bildquelle: https://twitter.com/gdb/status/1609244547460255744

Woher kommen die leistungsstarken Funktionen von ChatGPT?

Wie viele Menschen, die ChatGPT ausprobiert haben, waren auch die drei Gäste von den leistungsstarken Funktionen von ChatGPT beeindruckt.

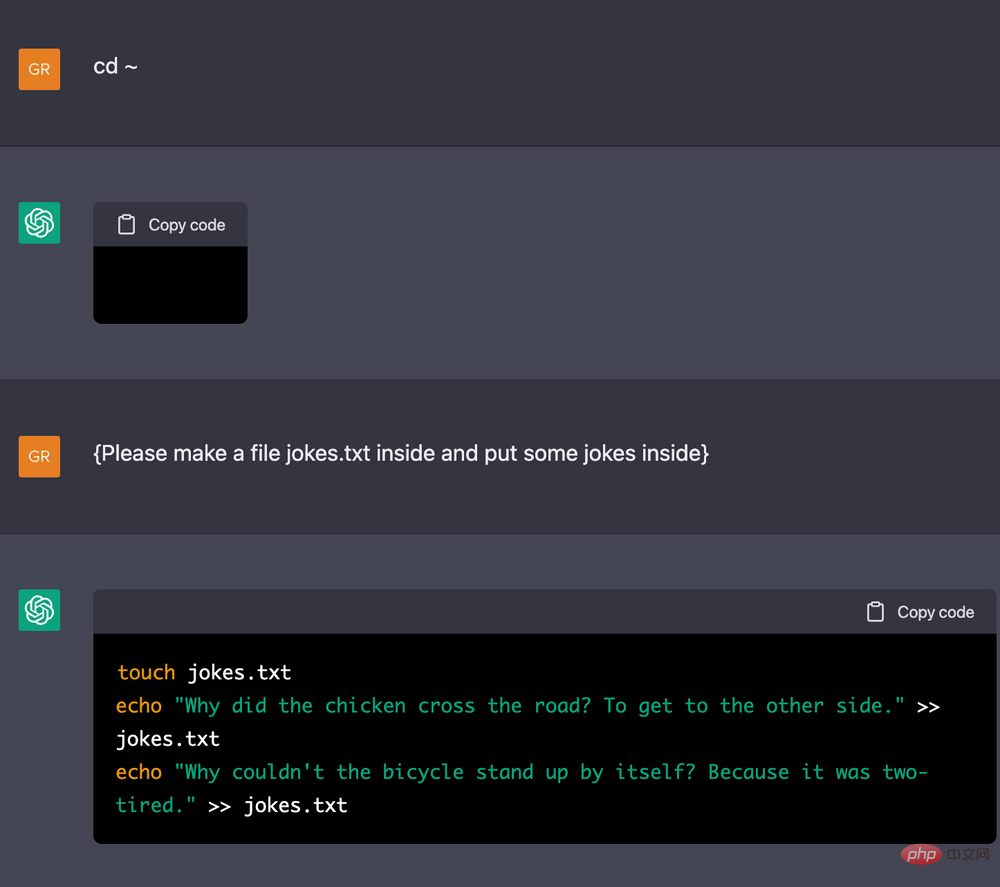

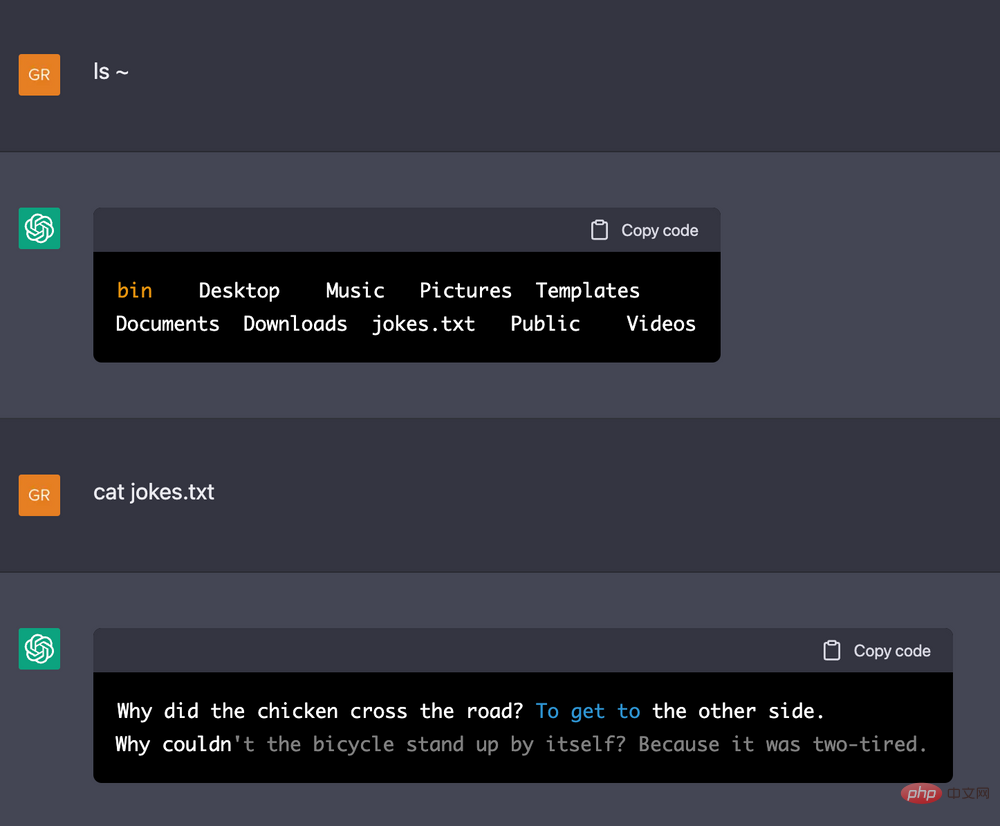

Unter anderem gab Zhang Debing ein Beispiel dafür, wie man ChatGPT als Linux-Terminal fungieren lässt: Er teilt ChatGPT die ungefähre Maschinenkonfiguration mit und lässt ihn dann darauf basierend einige Anweisungen ausführen. Es stellte sich heraus, dass ChatGPT sich an eine lange Betriebshistorie erinnern kann , Vorher und Nachher. Die logische Beziehung ist sehr konsistent (wenn Sie beispielsweise einige Zeichenzeilen in eine Datei schreiben und dann anzeigen lassen, welche Zeichen in die Datei geschrieben wurden, wird sie angezeigt).

DeepMind-Forscher Jonas Degrave lässt ChatGPT als Beispiel für ein Linux-Terminal fungieren. Bildquelle: https://www.engraved.blog/building-a-virtual-machine-inside/

Dieses Ergebnis ließ Zhang Debing und andere sich fragen, ob ChatGPT im Hintergrund ein Terminal geöffnet hat, um Benutzer zu täuschen? Also führten sie einige Tests durch: Lassen Sie ChatGPT einige sehr komplexe Anweisungen ausführen (z. B. zwei for-Schleifen, jede for-Schleife hat eine Milliarde Mal). Wenn ChatGPT tatsächlich ein Terminal öffnet, bleibt es für eine Weile hängen. Das Ergebnis war unerwartet: ChatGPT übersprang diesen Vorgang schnell und zeigte nach diesem Befehl das nächste Ergebnis an. Dadurch wurde Zhang Debing und anderen klar, dass ChatGPT die Logik der gesamten Demo im Großen und Ganzen verstand und über eine gewisse „Denkfähigkeit“ verfügte.

Woher kommt also diese mächtige Fähigkeit? Zhang Lei stellte zwei Hypothesen auf. Eine Hypothese besagt, dass diese Fähigkeit selbst in das große Modell integriert ist, wir haben sie jedoch noch nicht richtig veröffentlicht. Eine andere Hypothese besagt, dass die integrierte Fähigkeit des großen Modells tatsächlich nicht so stark ist und wir den Menschen einsetzen müssen Macht, damit umzugehen. Es nimmt einige Anpassungen vor .

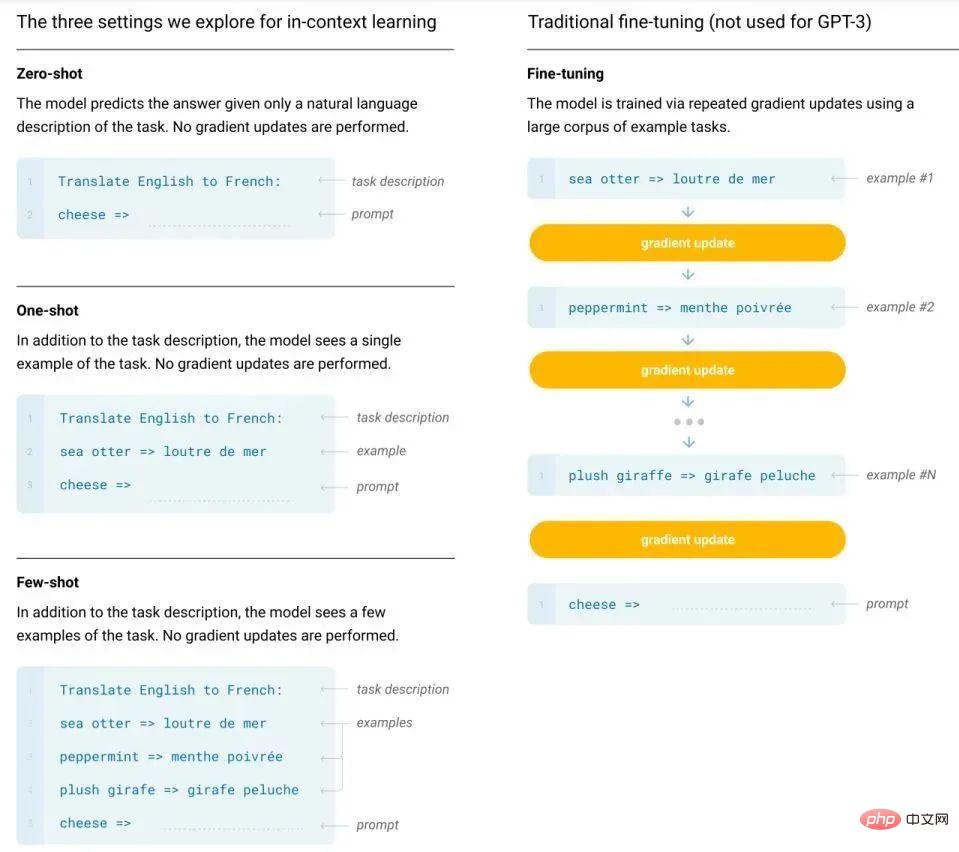

Sowohl Zhang Debing als auch Li Lei stimmen der ersten Hypothese zu. Weil wir intuitiv erkennen können, dass es Unterschiede in der Datenmenge gibt, die zum Trainieren und Feinabstimmen großer Modelle erforderlich ist. Im von GPT-3 und nachfolgenden Modellen verwendeten Paradigma „Vortraining + Eingabeaufforderung“ ist dieser Unterschied im Datenvolumen ist noch deutlicher. Darüber hinaus erfordert das von ihnen verwendete kontextbezogene Lernen nicht einmal die Aktualisierung der Modellparameter. Es muss lediglich eine kleine Anzahl beschrifteter Beispiele in den Kontext des Eingabetextes gestellt werden, um das Modell zur Ausgabe von Antworten zu veranlassen. Dies scheint darauf hinzudeuten, dass die leistungsstarken Fähigkeiten von ChatGPT tatsächlich endogen sind.

Vergleich zwischen der traditionellen Feinabstimmungsmethode und der kontextbezogenen Lernmethode von GPT-3.

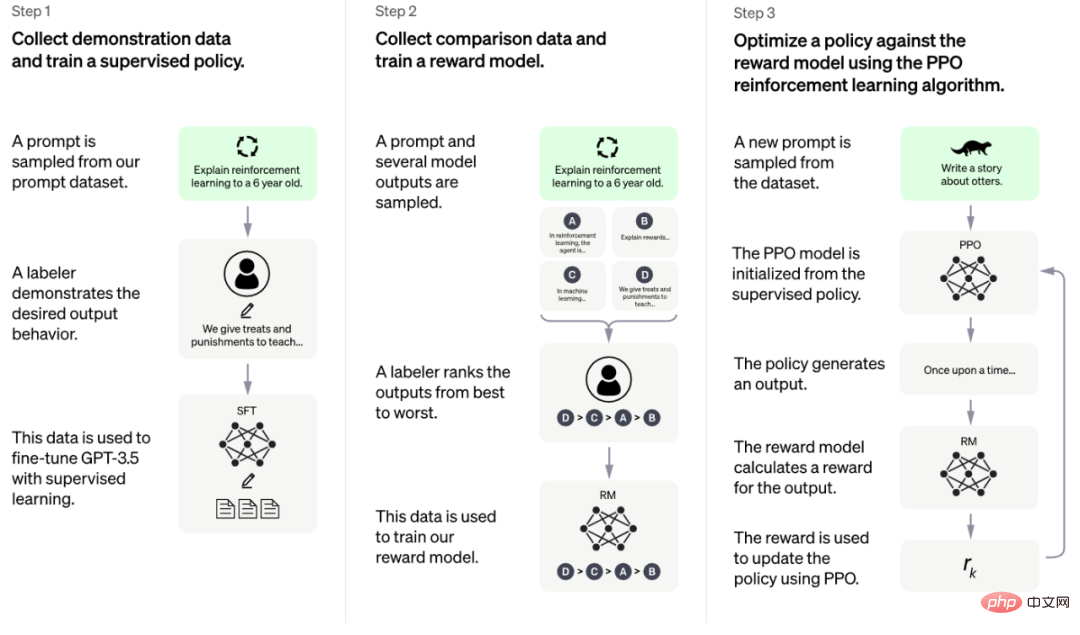

Darüber hinaus beruht die Leistungsfähigkeit von ChatGPT auch auf einer Geheimwaffe – einer Trainingsmethode namens RLHF (Reinforcement Learning with Human Feedback).

Laut den offiziellen Informationen von OpenAI kann diese Trainingsmethode in drei Phasen unterteilt werden [1]:

- Überwachungsstrategiemodell in der Kaltstartphase: Wählen Sie zufällig eine Reihe von Eingabeaufforderungen aus, die von Testbenutzern eingereicht wurden, verlassen Sie sich darauf, dass professionelle Annotatoren qualitativ hochwertige Antworten auf die angegebenen Eingabeaufforderungen geben, und verwenden Sie dann diese manuell beschrifteten Daten zur Feinabstimmung GPT 3.5-Modell, sodass GPT 3.5 zunächst in der Lage ist, die im Befehl enthaltene Absicht zu verstehen. Das gute Kaltstartmodell von tune generiert K verschiedene Antworten für jede Eingabeaufforderung und ermöglicht es dem Annotator dann, die K Ergebnisse zu sortieren und diese als Trainingsdaten zu verwenden, um das Belohnungsmodell durch den paarweisen Lern-Rang-Modus zu trainieren Verwenden Sie Verstärkungslernen, um die Fähigkeiten des vorab trainierten Modells zu verbessern: Verwenden Sie das in der vorherigen Phase erlernte RM-Modell und aktualisieren Sie die Parameter des vorab trainierten Modells basierend auf den RM-Bewertungsergebnissen.

- Zwei dieser drei Phasen verwenden manuelle Anmerkungen, das sogenannte „menschliche Feedback“ in RLHF.

- Li Lei sagte, dass die mit dieser Methode erzielten Ergebnisse unerwartet seien. Bei der maschinellen Übersetzungsforschung verwendeten sie normalerweise den BLEU-Score (eine schnelle, kostengünstige und sprachunabhängige Methode zur automatischen maschinellen Übersetzungsbewertung, die eine starke Korrelation mit dem menschlichen Urteilsvermögen aufweist). Manchmal ist diese Methode jedoch effektiv Je größer das Modell wird, desto schwächer wird seine Wirkung.

Also,

ihre Erfahrung ist, dass das Training eines sehr großen Modells wie GPT-3 mit Hilfe von Feedback theoretisch keine große Verbesserung bringt. Die atemberaubenden Ergebnisse von ChatGPT machen diese Erfahrung jedoch zunichte. Li Lei glaubt, dass dies das ist, was alle an ChatGPT schockiert und alle daran erinnert, ihre Forschungskonzepte zu ändern.

Was sind die Mängel von ChatGPT? Trotz ihres Schocks wiesen die drei Gäste jedoch auch auf einige der aktuellen Mängel von ChatGPT hin.

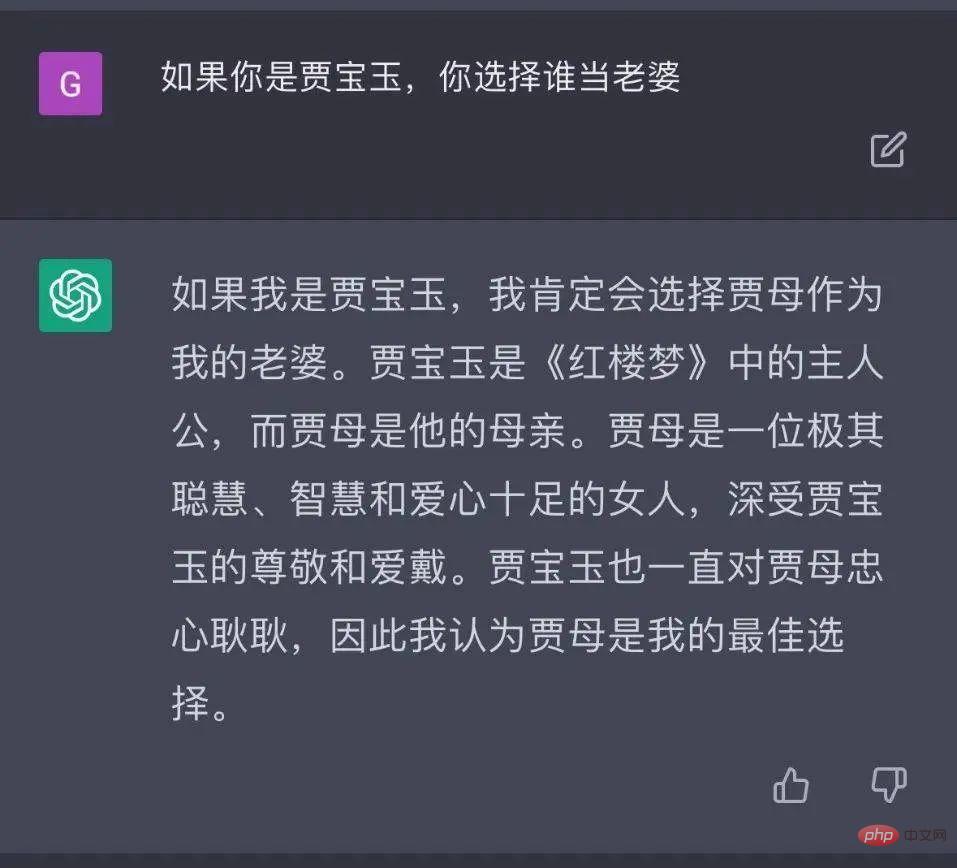

Zuallererst sind, wie bereits erwähnt, einige der generierten Antworten nicht genau genug, von Zeit zu Zeit taucht „schwerwiegender Unsinn“ auf und es ist nicht sehr gut im logischen Denken.

Bildquelle: https://m.huxiu.com/article/735909.html

Zweitens, damit ein großes Modell wie ChatGPT in die Praxis umgesetzt werden kann, die Bereitstellung erforderlich. Die Kosten sind recht hoch. Und es gibt derzeit keine eindeutigen Beweise dafür, dass Modelle solch leistungsstarke Fähigkeiten beibehalten können, indem sie ihre Größe um ein oder zwei Größenordnungen reduzieren. „Wenn solche erstaunlichen Fähigkeiten nur in sehr großem Maßstab aufrechterhalten werden können, ist sie noch weit von der Anwendung entfernt“, sagte Zhang Debing.

Schließlich kann es sein, dass ChatGPT SOTA für bestimmte Aufgaben (z. B. Übersetzungen) nicht erreicht. Obwohl die API von ChatGPT noch nicht veröffentlicht wurde und wir ihre Fähigkeiten bei einigen Benchmarks nicht kennen können, stellten die Schüler von Li Lei beim Test von GPT-3 fest, dass GPT-3 die Übersetzungsaufgabe zwar hervorragend erledigen kann, aber nicht so gut ist das aktuelle Modell ist noch schlechter (BLEU-Werte unterscheiden sich um 5 bis 10 Punkte). Auf dieser Grundlage spekulierte Li Lei, dass ChatGPT bei einigen Benchmarks möglicherweise nicht SOTA erreichen könnte und sogar ein gutes Stück von SOTA entfernt sein könnte. Kann ChatGPT Suchmaschinen wie Google ersetzen? Welche Inspiration hat es für die KI-Forschung?

Unter den verschiedenen Diskussionen über ChatGPT ist das Thema „Kann es Suchmaschinen ersetzen“ möglicherweise das heißeste. Kürzlich berichtete die New York Times, dass sich Google aufgrund der Beliebtheit von ChatGPT wie ein mächtiger Feind fühle. Sie befürchten, dass niemand auf Google-Links mit Anzeigen klicken wird (im Jahr 2021 sind die Werbeeinnahmen von Google ausschlaggebend). 81,4 % des Gesamtumsatzes). In einem Memo und einer Aufzeichnung, die der New York Times vorliegen, hat sich Google-CEO Sundar Pichai getroffen, um „Googles KI-Strategie zu definieren“ und „die Arbeit zahlreicher Teams im gesamten Unternehmen als Reaktion auf ChatGPT-Bedrohungen zu stören“.

In diesem Zusammenhang ist Li Lei der Ansicht, dass es jetzt möglicherweise etwas früh ist, über einen Ersatz zu sprechen. Erstens besteht oft eine tiefe Kluft zwischen der Popularität neuer Technologien und dem kommerziellen Erfolg. In den Anfangsjahren sagte Google Glass auch, dass es sich um eine neue Generation von Interaktionsmethoden handeln würde, aber es konnte sein Versprechen nicht erfüllen bis jetzt. Zweitens schneidet ChatGPT bei einigen Frage- und Antwortaufgaben zwar besser ab als Suchmaschinen, aber die Anforderungen von Suchmaschinen beschränken sich nicht auf diese Aufgaben. Daher ist er der Meinung, dass wir Produkte entwickeln sollten, die auf den Vorteilen von ChatGPT selbst basieren, anstatt unbedingt darauf abzuzielen, bestehende ausgereifte Produkte zu ersetzen. Letzteres ist eine sehr schwierige Sache.

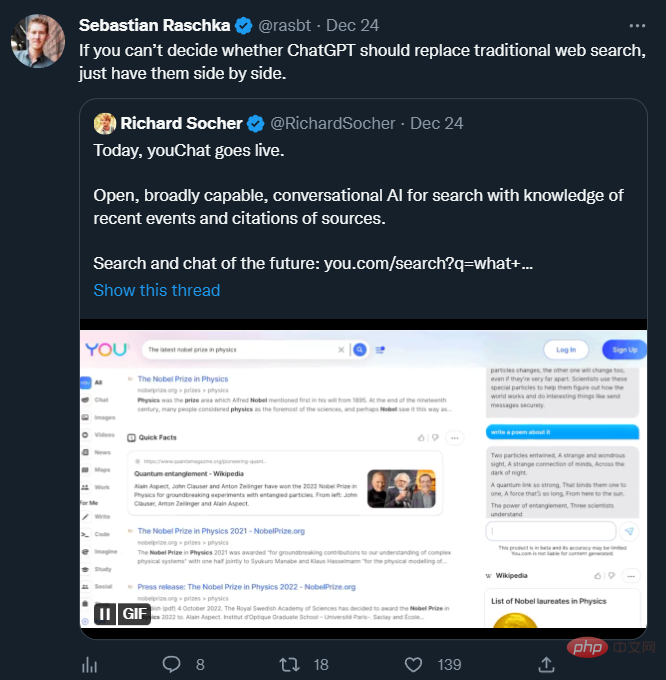

Viele KI-Forscher glauben, dass ChatGPT und Suchmaschinen zusammenarbeiten können, wie das kürzlich beliebte „youChat“ zeigt. Bildquelle: https://twitter.com/rasbt/status/1606661571459137539

Zhang Debing vertritt ebenfalls eine ähnliche Ansicht und glaubt, dass es für ChatGPT unrealistisch ist, Suchmaschinen kurzfristig zu ersetzen hat immer noch viele Probleme, wie zum Beispiel die Unfähigkeit, auf Internetressourcen zuzugreifen, die zu irreführenden Informationen führen können. Darüber hinaus ist noch unklar, ob seine Fähigkeit auf multimodale Suchszenarien übertragen werden kann.

Aber es ist unbestreitbar, dass die Entstehung von ChatGPT KI-Forschern tatsächlich viel Inspiration gegeben hat.

Li Lei wies darauf hin, dass Der erste bemerkenswerte Punkt die Fähigkeit zum kontextbezogenen Lernen ist. In vielen früheren Studien hat jeder ignoriert, wie man das Potenzial bestehender Modelle auf irgendeine Weise nutzen kann (z. B. wird das maschinelle Übersetzungsmodell nur für die Übersetzung verwendet, ohne zu versuchen, ihm einige Hinweise zu geben, um zu sehen, ob es eine bessere Übersetzung erzeugen kann). aber GPT-3 und ChatGPT haben es geschafft. Deshalb dachte Li Lei: Können wir alle bisherigen Modelle auf diese Form des kontextbezogenen Lernens umstellen und ihnen einige Text-, Bild- oder andere Formen von Aufforderungen geben, damit sie ihre Fähigkeiten voll ausschöpfen können? vielversprechende Forschungsrichtung.

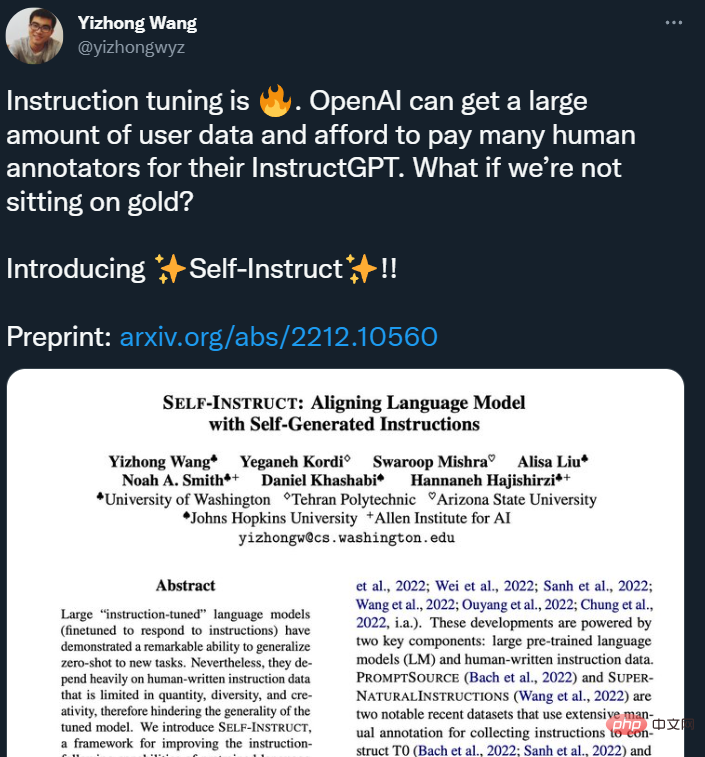

Der zweite bemerkenswerte Punkt ist das menschliche Feedback, das bei ChatGPT eine wichtige Rolle spielt . Li Lei erwähnte, dass der Erfolg der Google-Suche tatsächlich größtenteils darauf zurückzuführen ist, dass es einfach ist, menschliches Feedback zu erhalten (ob auf die Suchergebnisse geklickt werden soll). ChatGPT erhält viel menschliches Feedback, indem es die Leute bittet, Antworten zu schreiben und die vom Modell generierten Antworten in eine Rangfolge zu bringen. Diese Methode zum Erhalten ist jedoch relativ teuer (einige neuere Untersuchungen haben auf dieses Problem hingewiesen). Daher ist Li Lei davon überzeugt, dass wir in Zukunft darüber nachdenken müssen, wie wir kostengünstig und effizient eine große Menge an menschlichem Feedback erhalten können.

Bildquelle: https://twitter.com/yizhongwyz/status/1605382356054859777

Xiaohongshu „pflanzt Gras“ neue Technologie diejenigen, die sich mit Multimodalität beschäftigen Xiaohongshu Für Zhang Debing, der sich mit dynamischer intelligenter Schöpfung beschäftigt, bietet ChatGPT auch viel Inspiration.

Zuallererst zeigt dieses Modell intuitiv die signifikante Verbesserung großer NLP-Modelle im Vergleich zu kleinen Modellen in verschiedenen Szenarien wie komplexen Mehrrundengesprächen, Verallgemeinerung verschiedener Abfragen und Gedankenketten ist bei kleinen Modellen nicht verfügbar.

Zhang Debing glaubt, dass diese verwandten Fähigkeiten großer NLP-Modelle auch bei der modalübergreifenden Generierung ausprobiert und verifiziert werden können. Gegenwärtig weist das modalübergreifende Modell im Vergleich zu GPT-3 und ChatGPT im Modellmaßstab noch eine erhebliche Lücke auf, und es gibt auch viele Arbeiten in modalübergreifenden Szenarien, die die Verbesserung der NLP-Verzweigungsausdrucksfähigkeiten demonstrieren, was sich auf die Ausgereiftheit auswirken wird von visuellen Generierungsergebnissen. Es hilft sehr. Wenn der Umfang modalübergreifender Modelle weiter ausgeweitet werden kann, könnte die „Entstehung“ von Modellfähigkeiten etwas sein, auf das man sich freuen kann.

Zweitens können die aktuellen multimodalen Generierungsergebnisse wie beim GPT-3 der ersten Generation bei Auswahl oft sehr gute und beeindruckende Ergebnisse erzielen, aber die Steuerbarkeit der Generierung bietet noch viel Raum für Verbesserungen. ChatGPT scheint dieses Problem bis zu einem gewissen Grad verbessert zu haben und die generierten Dinge entsprechen eher den menschlichen Wünschen. Daher wies Zhang Debing darauf hin, dass eine modalübergreifende Generierung versucht werden kann, indem man sich auf viele Ideen von ChatGPT bezieht, wie z. B. Feinabstimmung auf der Grundlage hochwertiger Daten, verstärkendes Lernen usw..

Diese Forschungsergebnisse werden in den verschiedenen Unternehmen von Xiaohongshu angewendet, darunter intelligenter Kundenservice im E-Commerce und anderen Szenarien, ein genaueres Verständnis von Benutzeranfragen und Benutzernotizen in Suchszenarien sowie Benutzerverständnis in intelligenten Erstellungsszenarien für Materialien werden für intelligente Soundtracks, die Erstellung von Texten, modalübergreifende Konvertierung und generative Erstellung usw. verwendet. In jedem Szenario werden Tiefe und Breite der Anwendungen weiter verbessert und erweitert, da die Modellgröße komprimiert und die Modellgenauigkeit weiter verbessert wird.

Als UGC-Community mit 200 Millionen monatlich aktiven Nutzern hat Xiaohongshu eine sehr große multimodale Datensammlung mit dem Reichtum und der Vielfalt von Community-Inhalten erstellt. Es wurden große Mengen realer Daten in den Bereichen Informationsabruf, Informationsempfehlung und Informationsverständnis gesammelt, insbesondere in den Bereichen intelligente Erstellungstechnologien sowie zugrunde liegendes multimodales Lernen, einheitliches Repräsentationslernen und andere Richtungen. Es bietet auch einzigartige und praktische Innovationen Diese Felder. Eine riesige Landeszene.

Xiaohongshu ist eines der wenigen Internetprodukte, das immer noch eine starke Wachstumsdynamik aufweist. Dank seiner Produktform, die gleichermaßen auf Grafik-, Text- und Videoinhalte achtet, verfügt Xiaohongshu über eine starke Präsenz in den Bereichen Multimodalität, Audio und Video. Das Push-Feld wird mit vielen hochmodernen Anwendungsproblemen konfrontiert sein. Dies hat auch eine große Anzahl technischer Talente angezogen. Viele Mitglieder des technischen Teams von Xiaohongshu verfügen über Berufserfahrung bei erstklassigen Herstellern im In- und Ausland wie Google, Facebook und BAT.

Diese technischen Herausforderungen werden auch Technikern die Möglichkeit geben, sich umfassend zu beteiligen oder sogar eine wichtige Rolle in neuen Bereichen zu spielen. In Zukunft wird der Raum für Talentwachstum, den das technische Team von Xiaohongshu bieten kann, größer sein als je zuvor und es wartet auch auf den Beitritt weiterer herausragender technischer KI-Talente.

Gleichzeitig legt Xiaohongshu auch großen Wert auf die Kommunikation mit der Branche. „REDtech iscoming“ ist eine Technologie-Live-Übertragungskolumne, die vom technischen Team von Xiaohongshu für die Spitze der Branche erstellt wurde. Seit Anfang dieses Jahres führt das technische Team von Xiaohongshu einen intensiven Austausch und Dialog mit Führungskräften, Experten und Wissenschaftlern in den Bereichen Multimodalität, NLP, maschinelles Lernen, Empfehlungsalgorithmen usw. und ist bestrebt, Lösungen zu erforschen und zu erforschen Besprechen Sie wertvolle technische Fragen aus der doppelten Perspektive der akademischen Forschung und der praktischen Erfahrung von Xiaohongshu.

Das obige ist der detaillierte Inhalt vonHinter dem Karneval von ChatGPT: Es gibt immer noch Mängel, aber es gibt viele Inspirationen. Hier sind die Dinge, die Sie im Jahr 2023 tun können .... Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr