Heim >Technologie-Peripheriegeräte >KI >Was passiert nach der Veröffentlichung von GPT-4 mit anderen großen Modellen? Yann LeCun: Erweiterte Sprachmodelle könnten der richtige Weg sein

Was passiert nach der Veröffentlichung von GPT-4 mit anderen großen Modellen? Yann LeCun: Erweiterte Sprachmodelle könnten der richtige Weg sein

- 王林nach vorne

- 2023-04-12 23:28:011068Durchsuche

Die Popularität von ChatGPT und GPT-4 hat groß angelegte Sprachmodelle zu ihrem bisherigen Höhepunkt gebracht. Aber wohin soll es als nächstes gehen?

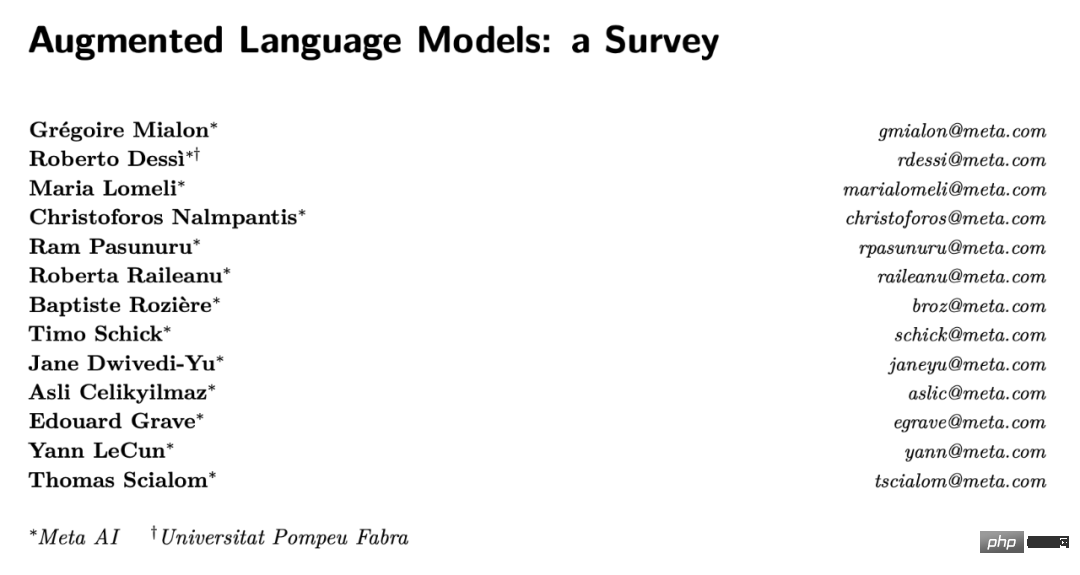

Yann LeCun nahm kürzlich an einer Studie teil, die darauf hinwies, dass die Verbesserung von Sprachmodellen eine vielversprechende Richtung sein könnte.

Dies ist ein Übersichtsartikel. In diesem Artikel wird der Hauptinhalt des Artikels kurz vorgestellt.

Forschungshintergrund

Groß angelegte Sprachmodelle haben den Fortschritt der Verarbeitung natürlicher Sprache erheblich vorangetrieben und mehrere Produkte mit Millionen von Benutzern hervorgebracht, darunter den Codierungsassistenten Copilot, die Google-Suchmaschine und das kürzlich beliebte ChatGPT. Durch die Kombination von Gedächtnis und Kompositionsfähigkeiten können große Sprachmodelle Aufgaben wie Sprachverständnis oder bedingte und bedingungslose Textgenerierung mit beispielloser Leistung ausführen und so eine Mensch-Computer-Interaktion mit höherer Bandbreite Wirklichkeit werden lassen.

Allerdings weisen große Sprachmodelle immer noch einige Einschränkungen auf, die ihren breiteren Einsatz verhindern. Große Sprachmodelle liefern oft nicht sachliche, aber plausible Vorhersagen, die oft als Halluzinationen bezeichnet werden. Dies führt zu vielen vermeidbaren Fehlern, beispielsweise in arithmetischen Zusammenhängen oder in Argumentationsketten. Darüber hinaus scheinen die bahnbrechenden Fähigkeiten vieler großer Sprachmodelle, gemessen an der Anzahl der trainierbaren Parameter, mit zunehmendem Maßstab zu erscheinen. Einige Forscher haben beispielsweise gezeigt, dass ein großes Sprachmodell dazu in der Lage ist Führen Sie einige Aufgaben durch BIG-Bench-Aufgaben aus. Obwohl eine Reihe neuerer Arbeiten kleine Sprachmodelle hervorgebracht haben, die noch einige Merkmale großer Modelle beibehalten, sind die Trainings- und Wartungskosten großer Sprachmodelle aufgrund ihrer Größe und Datenanforderungen immer noch hoch. Kontinuierliches Lernen großer Modelle bleibt ein offenes Forschungsproblem, und Goldberg diskutierte zuvor andere Einschränkungen großer Sprachmodelle im Kontext des GPT-3-basierten Chatbots ChatGPT.

In einer aktuellen Studie analysierten Forscher von Meta und anderen Institutionen, dass die oben genannten Probleme auf einen wesentlichen Fehler großer Sprachmodelle zurückzuführen sind: Sie werden normalerweise darauf trainiert, Aufgaben auszuführen, wenn (i) ein einzelnes Parametermodell und (ii) gegeben sind Statistische Sprachmodellierung mit begrenztem Kontext (normalerweise n vorherige oder umgebende Token). Obwohl n in den letzten Jahren aufgrund von Innovationen in der Software und Hardware zugenommen hat, verwenden die meisten Modelle immer noch relativ kleine Kontexte im Vergleich zu den potenziell großen Kontexten, die für eine konsistente korrekte Durchführung der Sprachmodellierung erforderlich sind. Daher erfordern Modelle einen großen Umfang, um Wissen zu speichern, das nicht im Kontext vorhanden ist, aber zur Ausführung der jeweiligen Aufgabe erforderlich ist.

Link zum Papier: https://arxiv.org/pdf/2302.07842v1.pdf

Daher zielen immer mehr Forschungen darauf ab, diese Probleme zu lösen, und eine leichte Abweichung davon das oben beschriebene rein statistische Sprachmodellierungsparadigma.

Zum Beispiel gibt es eine Arbeit zur Umgehung der begrenzten Kontextgröße, indem die Relevanz großer Sprachmodelle erhöht wird, indem Informationen hinzugefügt werden, die aus relevanten externen Dokumenten extrahiert werden. Durch die Ausstattung großer Sprachmodelle mit Modulen, die solche Dokumente für einen bestimmten Kontext aus einer Datenbank abrufen, ist es möglich, einige der Fähigkeiten einiger der größten Sprachmodelle mit weniger Parametern abzugleichen. Beachten Sie, dass das resultierende Modell jetzt nichtparametrisch ist, da es externe Datenquellen abfragen kann. Im Allgemeinen können Sprachmodelle ihren Kontext auch durch Inferenzstrategien verbessern, um relevanteren Kontext zu generieren und mehr Rechenaufwand zu sparen, bevor eine Antwort generiert wird.

Eine andere Strategie besteht darin, dem Sprachmodell die Nutzung externer Tools zu ermöglichen, um den aktuellen Kontext mit wichtigen fehlenden Informationen zu ergänzen, die nicht in den Gewichtungen des Sprachmodells enthalten sind. Während ein Großteil dieser Arbeit darauf abzielt, die oben genannten Mängel des Sprachmodells zu mildern, zeigt sie auch direkt, dass ein systematischerer Einsatz von Inferenz und Werkzeugen zur Verbesserung von Sprachmodellen zu leistungsfähigeren Agenten führen kann. Diese Modelle werden Augmented Language Models (ALM) genannt. Als sich dieser Trend beschleunigte, nahm die Zahl verwandter Studien dramatisch zu, was die Klassifizierung von Werken und die Definition von Fachbegriffen für verschiedene Verwendungszwecke erforderte.

Die in diesem Dokument verwendeten Begriffe sind wie folgt definiert:

Begründung. Im Zusammenhang mit erweiterten Sprachmodellen ist Inferenz die Zerlegung einer potenziell komplexen Aufgabe in einfachere Teilaufgaben, die das Sprachmodell selbst oder mithilfe von Werkzeugen leichter lösen kann. Es gibt verschiedene Möglichkeiten, Teilaufgaben zu zerlegen, beispielsweise rekursiv oder iterativ. In diesem Sinne ähnelt das Denken dem „Planen“, wie es in LeCuns Papier „A Path Towards Autonomous Machine Intelligence“ aus dem Jahr 2022 definiert wird. In diesem Artikel umfasst die Inferenz häufig verschiedene Strategien zur Verbesserung der Fähigkeiten zur Inferenz von Sprachmodellen, beispielsweise eine schrittweise Inferenz anhand weniger Beispiele. Es ist nicht ganz klar, ob das Sprachmodell tatsächlich schlussfolgert oder lediglich einen größeren Kontext generiert, der die Wahrscheinlichkeit einer korrekten Vorhersage des fehlenden Tokens erhöht. Es kann hilfreich sein, auf die Diskussion anderer Forscher zu diesem Thema zu verweisen (Huang und Chang (2022)): Obwohl Argumentation auf der Grundlage der aktuellen SOTA-Ergebnisse ein Sprachmissbrauch sein kann, wird der Begriff bereits in der Community verwendet. Eine praktischere Definition des kontextuellen Denkens in erweiterten Sprachmodellen besteht darin, dem Modell mehr Rechenschritte zu geben, bevor eine Antwort auf eine Eingabeaufforderung generiert wird.

Werkzeuge. Bei erweiterten Sprachmodellen ist ein Tool ein externes Modul, das normalerweise mithilfe von Regeln oder speziellen Tokens aufgerufen wird und dessen Ausgabe in den Kontext des erweiterten Sprachmodells einbezogen wird. Das Tool kann externe Informationen sammeln oder Auswirkungen auf die virtuelle oder physische Welt haben (häufig wahrgenommen durch ein erweitertes Sprachmodell). Ein Beispiel für ein Werkzeug, das externe Informationen erhält, ist ein Dokumentenabrufgerät, während ein Werkzeug, das externe Effekte hat, ein Roboterarm ist. Tools können während der Trainings- oder Inferenzzeit aufgerufen werden. Im Allgemeinen kann das Erlernen der Interaktion mit einem Tool das Erlernen des Aufrufs seiner API umfassen.

Verhalten. Bei erweiterten Sprachmodellen besteht eine Aktion darin, ein Werkzeug aufzurufen, das Auswirkungen auf die virtuelle oder physische Welt hat, und die Ergebnisse zu beobachten, typischerweise durch Einbindung in den aktuellen Kontext des erweiterten Sprachmodells. Einige der in diesem Artikel erwähnten Arbeiten befassen sich beispielsweise mit der Websuche oder der Manipulation von Roboterarmen durch Sprachmodelle. Um die Terminologie ein wenig zu überstrapazieren, bezeichnen Forscher den Aufruf von Werkzeugen durch ein erweitertes Sprachmodell manchmal als Verhalten, auch wenn es keine externen Auswirkungen hat.

Warum sollten Argumentation und Tools gemeinsam besprochen werden? Die Kombination aus Argumentation und Werkzeugen in Sprachmodellen wird verwendet, um eine große Anzahl komplexer Aufgaben ohne die Notwendigkeit von Heuristiken zu lösen und verfügt daher über bessere Generalisierungsfähigkeiten. In der Regel erleichtert die Inferenz Sprachmodelle, die ein gegebenes Problem in potenziell einfachere Teilaufgaben zerlegen, während Tools dabei helfen, jeden Schritt richtig zu machen, beispielsweise Ergebnisse aus mathematischen Operationen zu erhalten. Mit anderen Worten: Inferenz ist eine Möglichkeit für Sprachmodelle, verschiedene Tools zu kombinieren, um komplexe Aufgaben zu lösen, und Tools sind eine Möglichkeit, Inferenzfehler durch effiziente Zerlegung zu vermeiden. Beide sollen voneinander profitieren. Darüber hinaus können Inferenz und Werkzeuge unter derselben „Haube“ platziert werden, da beide den Kontext des Sprachmodells verbessern, um fehlende Token besser vorherzusagen, wenn auch auf unterschiedliche Weise.

Warum werden Tools und Maßnahmen gemeinsam besprochen? Sprachmodelle können auf die gleiche Weise aufgerufen werden wie Tools, die zusätzliche Informationen sammeln und Auswirkungen auf die virtuelle oder physische Welt haben. Beispielsweise scheint es keinen Unterschied zu geben zwischen einem Sprachmodell, das Python-Code zum Lösen einer mathematischen Operation ausgibt, und einem Sprachmodell, das Python-Code zum Betreiben eines Roboterarms ausgibt. Einige der in der Arbeit diskutierten Arbeiten verwendeten Sprachmodelle mit Auswirkungen auf virtuelle oder physische Welten. Unter diesem Gesichtspunkt lässt sich sagen, dass Sprachmodelle Verhaltenspotenzial haben, und es lohnt sich auch, auf die wichtigen Fortschritte zu blicken, die sie als Richtung für automatisierte Agenten gemacht haben.

Dieser Artikel unterteilt die in der Umfrage enthaltene Forschung in drei Teile. Abschnitt 2 untersucht Arbeiten zur Verbesserung der Inferenzfähigkeiten von Sprachmodellen wie oben definiert. Abschnitt 3 konzentriert sich auf Arbeiten, die es Sprachmodellen ermöglichen, mit externen Tools zu interagieren und Maßnahmen zu ergreifen. Abschließend wird in Abschnitt 4 untersucht, ob Argumentation und Werkzeuggebrauch durch Heuristiken oder durch Lernen erreicht werden, beispielsweise durch Supervision oder Verstärkung. Die Umfrage umfasst auch weitere Komponenten, auf die die Autoren in Abschnitt V eingehen. Der Kürze halber konzentriert sich die Umfrage auf Arbeiten, die Inferenz oder Werkzeuge mit Sprachmodellen kombinieren. Obwohl der Schwerpunkt dieses Artikels auf großen Sprachmodellen liegt, verwendeten nicht alle betrachteten Studien große Modelle. Um die Genauigkeit sicherzustellen, werden daher auch in den verbleibenden Untersuchungen Sprachmodelle berücksichtigt.

Inferenz

Frühere Arbeiten haben gezeigt, dass große Sprachmodelle einfache Inferenzprobleme, aber keine komplexen Inferenzprobleme lösen können: Daher konzentriert sich dieser Abschnitt auf verschiedene Strategien zur Verbesserung der Inferenzfähigkeiten von Sprachmodellen. Eine der Herausforderungen komplexer Inferenzprobleme für lineare Modelle besteht darin, die Lösung korrekt zu erhalten, indem die vorhergesagten korrekten Antworten zu Teilproblemen kombiniert werden. Beispielsweise kann ein Sprachmodell die Geburts- und Sterbedaten berühmter Personen genau vorhersagen, das Alter jedoch möglicherweise nicht genau. Einige Forscher bezeichnen diesen Unterschied als Kompositionalitätslücke von Sprachmodellen. Im Rest dieses Abschnitts werden Arbeiten im Zusammenhang mit drei gängigen Paradigmen der induzierten Folgerung in Sprachmodellen besprochen. Da sich die aktuelle Arbeit auf Inferenz in Kombination mit Werkzeugen konzentriert, wird der Leser hier auf eine ausführlichere Diskussion der Arbeit anderer Forscher zur Inferenz großer Sprachmodelle verwiesen.

Verwendung von Werkzeugen und Verhaltensweisen

Neuere Ansätze der Sprachmodellforschung ermöglichen es Modellen, auf Wissen zuzugreifen, das nicht unbedingt in ihren Gewichten gespeichert ist, wie zum Beispiel Faktenwissen. Genauer gesagt können Aufgaben wie präzise Berechnungen oder das Abrufen von Informationen auf externe Module ausgelagert werden, beispielsweise auf einen Python-Interpreter oder ein Suchmaschinenmodul, das vom Modell abgefragt wird. In diesem Fall nutzen diese Module Tools. Wenn ein Werkzeug außerdem Auswirkungen auf die Außenwelt hat, können wir sagen, dass das Sprachmodell eine Aktion ausgeführt hat. Fügen Sie ganz einfach Tools und Verhaltensweisen in Form von speziellen Tokens ein, eine praktische Funktion in Kombination mit der Transformer-Sprachmodellierung.

Nachdem wir untersucht haben, wie Sprachmodelle verbessert werden können, um ihre Fähigkeit zum Denken und zur Anwendung von Werkzeugen zu trainieren, wird in dieser Umfrage auch beschrieben, wie man Modellen beibringt, diese Fähigkeiten anzuwenden.

Weitere Forschungsdetails finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonWas passiert nach der Veröffentlichung von GPT-4 mit anderen großen Modellen? Yann LeCun: Erweiterte Sprachmodelle könnten der richtige Weg sein. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr