Heim >Technologie-Peripheriegeräte >KI >Hier erfahren Sie, wie Sie ChatGPT das Lesen von Bildern beibringen

Hier erfahren Sie, wie Sie ChatGPT das Lesen von Bildern beibringen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 22:58:051831Durchsuche

Das Modell „Wen Sheng Tu“ wird 2022 beliebt sein, was wird 2023 beliebt sein?

Die Antwort des Machine-Learning-Ingenieurs Daniel Bourke lautet: Umgekehrt!

Nein, ein neu veröffentlichtes „bildbasiertes Text“-Modell ist im Internet explodiert, und seine hervorragenden Effekte haben viele Internetnutzer dazu veranlasst, es erneut zu veröffentlichen und zu mögen.

ist nicht nur eine grundlegende Funktion zum Ansehen von Bildern und Sprechen, sondern auch zum Schreiben von Liebesgedichten und zum Erklären von Handlungen , und Designobjekte in Bildern usw., diese KI kann alles problemlos bewältigen!

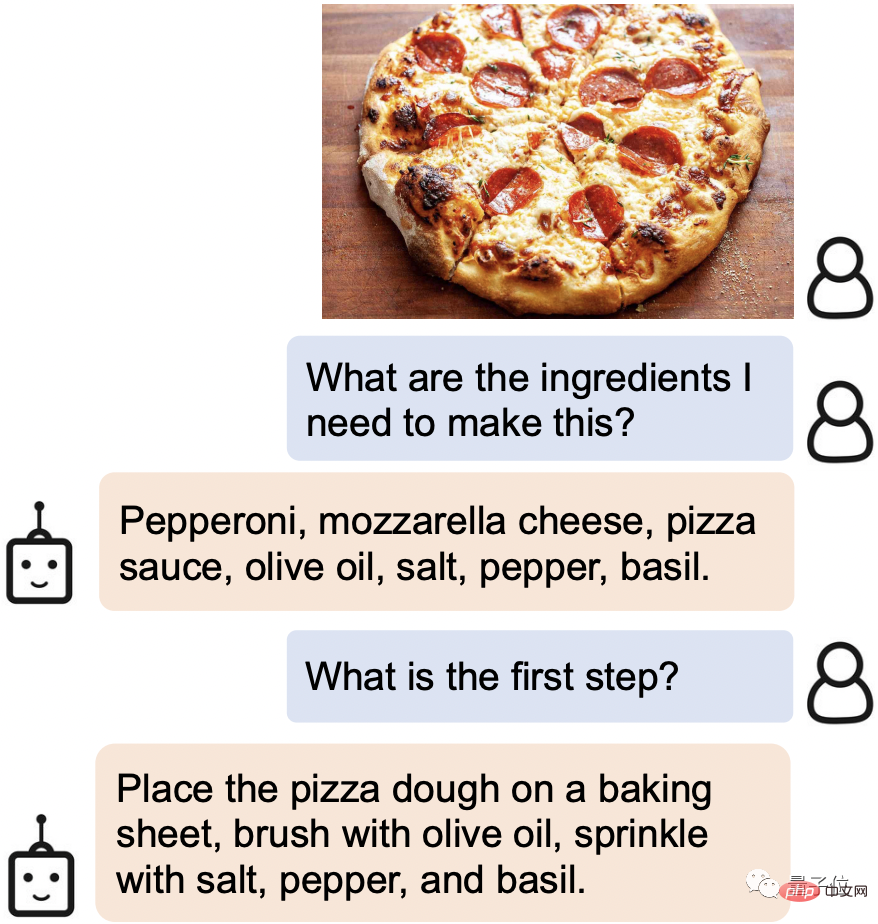

Wenn Sie beispielsweise online ein verlockendes Essen finden, senden Sie ihm einfach das Bild und es werden sofort die erforderlichen Zutaten und Kochschritte angezeigt:

#🎜 🎜##🎜 🎜#

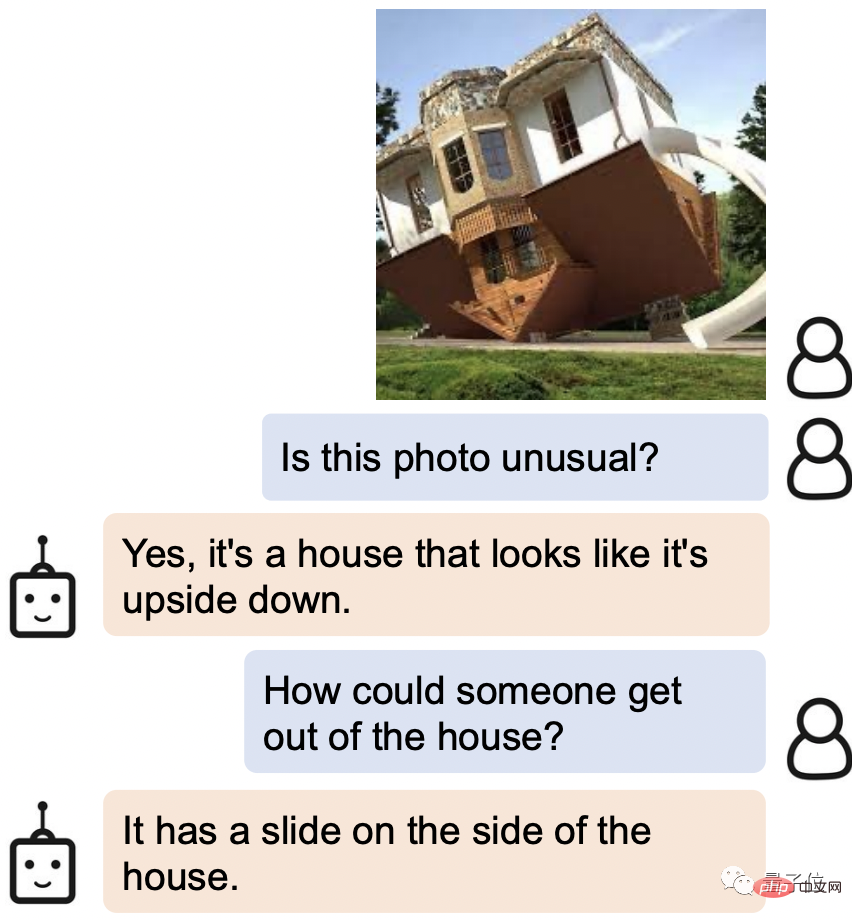

Auf die Frage, wie man aus dem auf dem Kopf stehenden Haus auf dem Bild herauskommt, antwortete AI: Gibt es an der Seite nicht eine Rutsche?

Das Wichtigste ist, dass BLIP-2 im Gegensatz zu früheren Untersuchungen ein universelles Pre-Training-Framework verwendet, sodass es beliebig mit Ihrem eigenen Sprachmodell verbunden werden kann.

Einige Internetnutzer denken bereits über die leistungsstarke Kombination nach, nachdem sie die Benutzeroberfläche auf ChatGPT umgestellt haben.

Erstklassige Verständnisfähigkeit

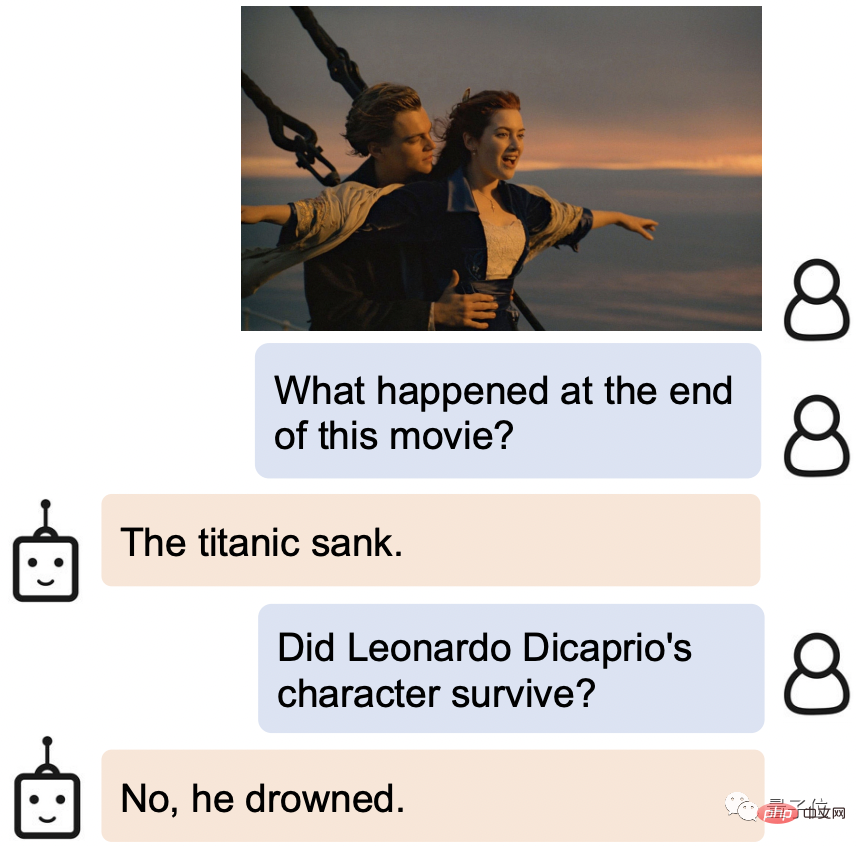

Das Gameplay von BLIP-2 kann als sehr abwechslungsreich bezeichnet werden.

Sie müssen nur ein Bild bereitstellen und können mit ihm sprechen. Es kann verschiedene Anforderungen erfüllen, z. B. das Erzählen von Geschichten, das Argumentieren und das Generieren personalisierter Texte durch Betrachten des Bildes.

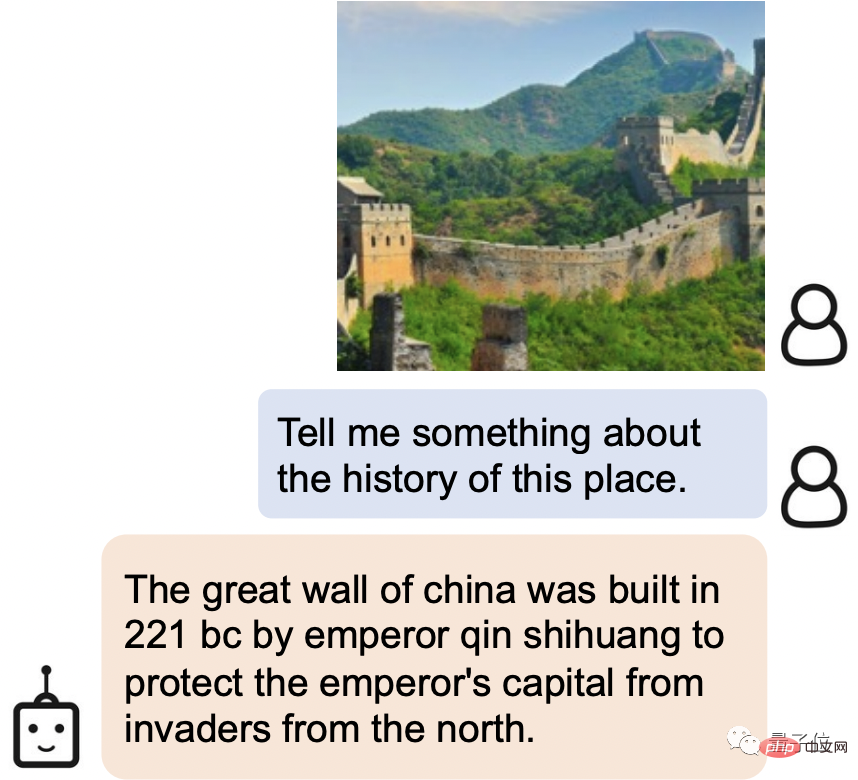

Zum Beispiel kann BLIP-2 nicht nur den malerischen Ort im Bild leicht als die Chinesische Mauer identifizieren, sondern auch die Geschichte der Chinesischen Mauer vorstellen:

Die Große Die Chinesische Mauer wurde 221 v. Chr. errichtet. Sie wurde von Qin Shihuang errichtet, um die kaiserliche Hauptstadt vor einer Invasion aus dem Norden zu schützen.

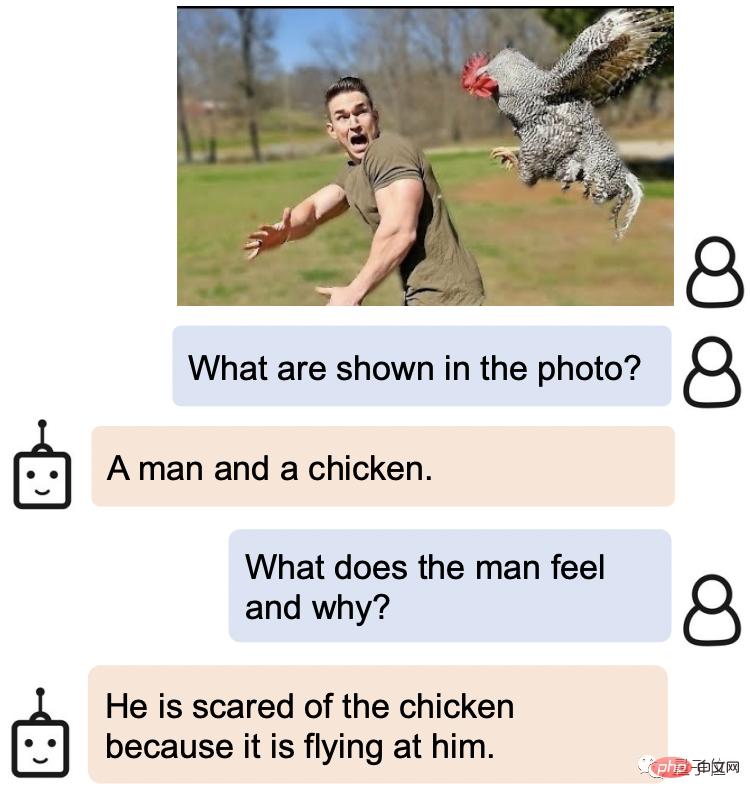

Auf die Frage, was der Gesichtsausdruck des Mannes auf diesem Bild sei und warum er so sei, antwortete BLIP-2: Er hatte Angst vor dem Huhn, weil es auf ihn zuflog.

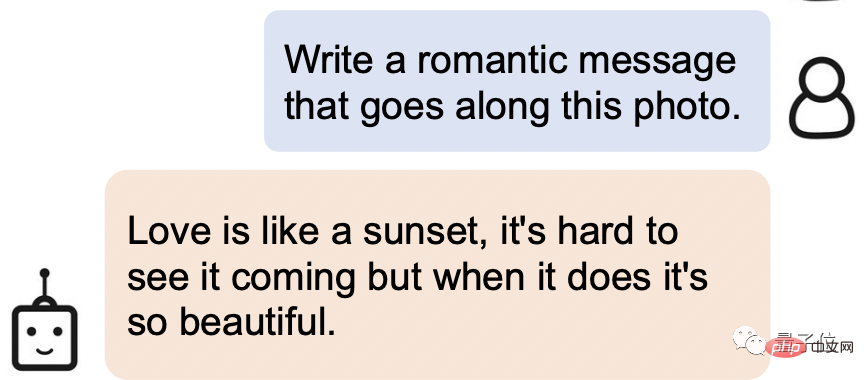

Lassen Sie es einen romantischen Satz basierend auf dem Bild unten schreiben:

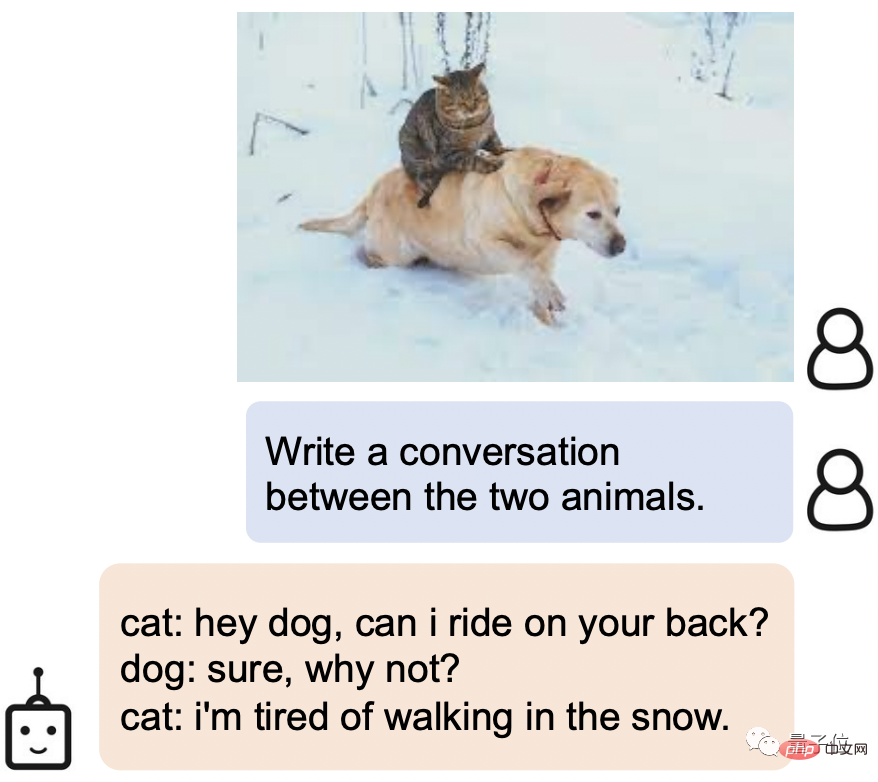

Katze: Hey, Hund, kann ich auf deinem Rücken reiten?

Hund: Natürlich, warum nicht?

Katze: Ich habe es satt, im Schnee zu laufen.

Wie erreicht BLIP-2 also eine so starke Verständnisfähigkeit?

Implementierung neuer SOTA für mehrere visuelle Sprachaufgaben

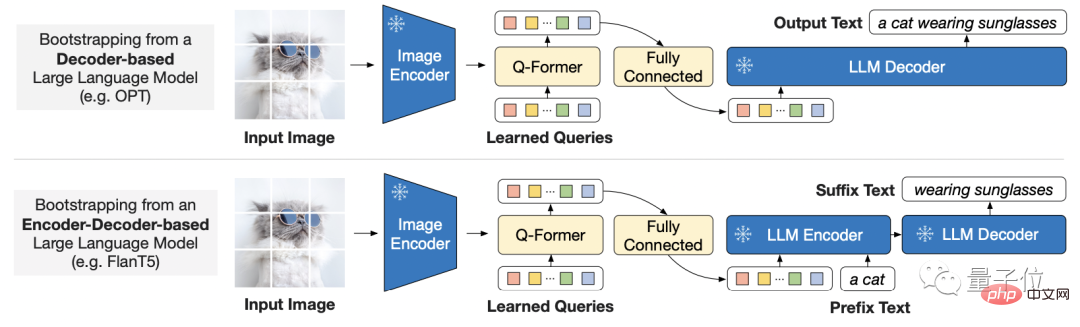

Angesichts der Tatsache, dass die End-to-End-Schulungskosten für große Modelle immer höher werden, verwendet BLIP-2 a Allgemeine und effiziente Pre-Training-Strategien:

Bootstrap-Vortraining für visuelle Sprache aus handelsüblichen, eingefrorenen, vorab trainierten Bildcodierern und eingefrorenen großen Sprachmodellen.

Das bedeutet auch, dass sich jeder das Modell aussuchen kann, das er nutzen möchte.

Um die Lücke zwischen den Modi zu schließen, schlug der Forscher einen leichten Abfragetransformator vor.

Der Transformer wird in zwei Stufen vorab trainiert:

Die erste Stufe leitet das Lernen der visuellen Sprachdarstellung aus dem Encoder für eingefrorene Bilder, und die zweite Stufe leitet das Lernen der visuellen Sprachdarstellung Das eingefrorene Sprachmodell. Leitfaden zum generativen Sprachenlernen.

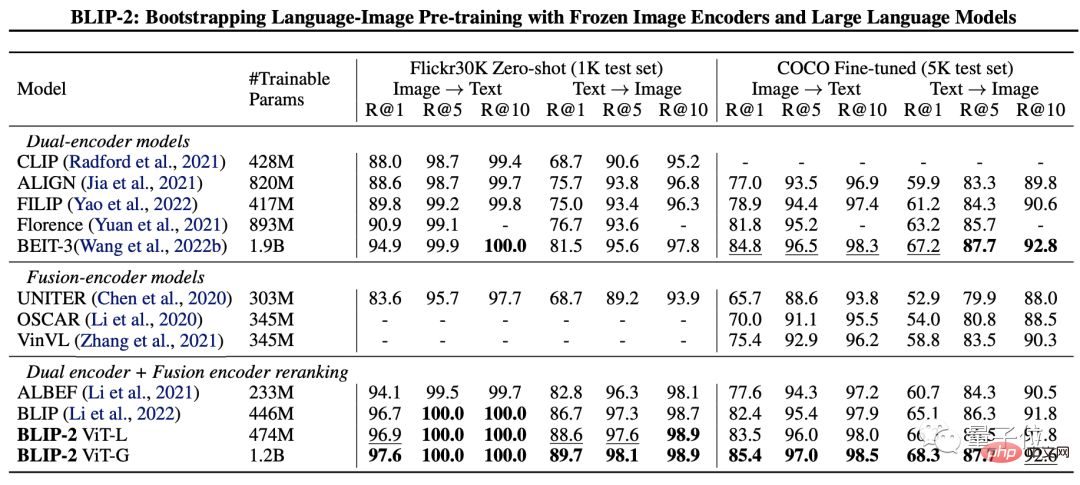

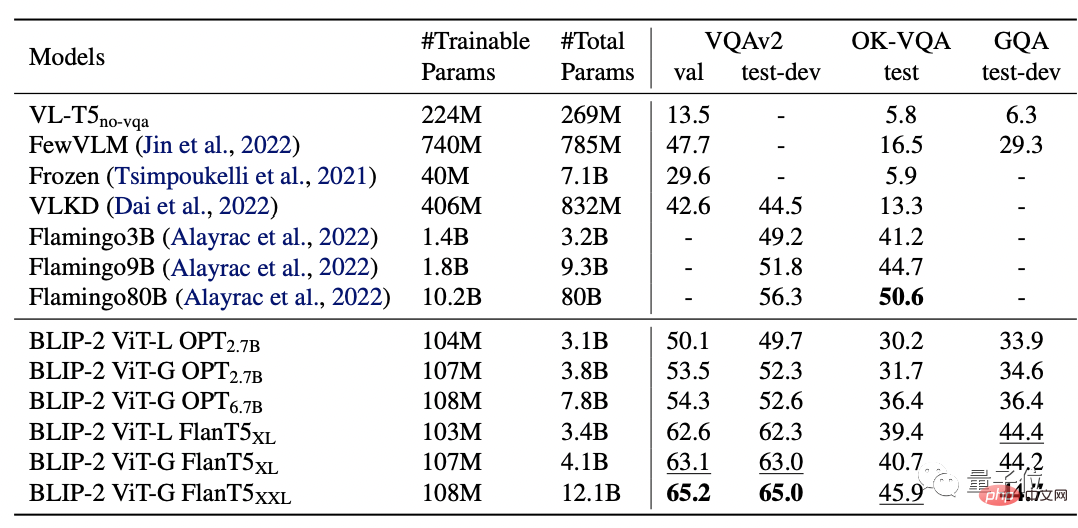

Um die Leistung von BLIP-2 zu testen, begannen die Forscher mit der Bildtextgenerierung ohne Stichprobe , visuelle Beantwortung von Fragen. Es wird anhand von Aufgaben zum Abrufen von Bildtexten und Bildunterschriften bewertet.

Die Endergebnisse zeigen, dass BLIP-2 SOTA bei mehreren visuellen Sprachaufgaben erreicht hat.

Unter diesen ist BLIP-2 8,7 % höher als Flamingo 80B auf Zero-Shot VQAv2 und dem Training Parameter werden immer noch um das 54-fache reduziert.

Und es ist offensichtlich, dass ein stärkerer Bildencoder oder ein stärkeres Sprachmodell eine bessere Leistung bringt.

Es ist erwähnenswert, dass der Forscher am Ende des Papiers auch erwähnte, dass BLIP-2 immer noch eine hat Das Manko ist die mangelnde Fähigkeit zum Kontextlernen:

Jede Probe enthält nur ein Bild-Text-Paar, und es ist derzeit unmöglich, die Korrelation zwischen mehreren Bild-Text-Paaren in einer einzigen Sequenz zu lernen.

Forschungsteam

Das Forschungsteam von BLIP-2 stammt von Salesforce Research.

Der erste Autor ist Junnan Li, der auch der Autor von BLIP ist, das vor einem Jahr gestartet wurde.

ist derzeit leitender Forschungswissenschaftler am Salesforce Asia Research Institute. Absolvent der University of Hong Kong mit einem Bachelor-Abschluss und einem Ph.D. von der National University of Singapore.

Das Forschungsfeld ist sehr breit und umfasst selbstüberwachtes Lernen, halbüberwachtes Lernen, schwach überwachtes Lernen und visuelle Sprache.

Das Folgende ist der Papierlink und der GitHub-Link von BLIP-2. Interessierte Freunde können ihn abholen~

Papierlink: https://arxiv.org/ pdf /2301.12597.pdf

GitHub-Link: https://github.com/salesforce/LAVIS/tree/main/projects/blip2

Referenzlink: [1] https: //twitter.com/mrdbourke/status/1620353263651688448

[2]https://twitter.com/LiJunnan0409/status/1620259379223343107

Das obige ist der detaillierte Inhalt vonHier erfahren Sie, wie Sie ChatGPT das Lesen von Bildern beibringen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr