Heim >Technologie-Peripheriegeräte >KI >KI generiert automatisch Eingabeaufforderungen, die mit Menschen vergleichbar sind: Ingenieure wurden gerade eingestellt und werden wieder eliminiert.

KI generiert automatisch Eingabeaufforderungen, die mit Menschen vergleichbar sind: Ingenieure wurden gerade eingestellt und werden wieder eliminiert.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 22:40:011626Durchsuche

Zu diesem Zeitpunkt haben Sprachmodelle dank der Erweiterung des Modellmaßstabs und der Entstehung aufmerksamkeitsbasierter Architektur eine beispiellose Vielseitigkeit gezeigt. Diese großen Sprachmodelle (LLMs) haben außergewöhnliche Fähigkeiten bei einer Vielzahl unterschiedlicher Aufgaben gezeigt, einschließlich Zero-Shot- und Fence-Shot-Einstellungen.

Basierend auf der Universalität des Modells stellt sich jedoch eine Kontrollfrage: Wie können wir LLM dazu bringen, das zu tun, was wir brauchen?

Um diese Frage zu beantworten und LLM in die Richtung unseres gewünschten Verhaltens zu leiten, haben Forscher eine Reihe von Maßnahmen ergriffen, um dieses Ziel zu erreichen, wie z. B. die Feinabstimmung des Modells, Lernen durch Kontext und verschiedene Formen der Eingabeaufforderung , usw. . Zu den auf Eingabeaufforderungen basierenden Methoden gehören fein abgestimmte Soft-Eingabeaufforderungen und Eingabeaufforderungs-Engineering in natürlicher Sprache. Viele Forscher haben großes Interesse an Letzterem gezeigt, da es eine natürliche interaktive Schnittstelle für die Interaktion von Menschen mit Maschinen bietet.

Einfache Eingabeaufforderungen führen jedoch nicht immer zu den gewünschten Ergebnissen. Beispielsweise hat das Hinzufügen von Adjektiven wie „süß“ oder Phrasen wie „Bambus essen“ keine Auswirkung auf die Ausgabe. wir verstehen es nicht.

Daher müssen menschliche Benutzer verschiedene Eingabeaufforderungen ausprobieren, um das Modell so zu steuern, dass es unser gewünschtes Verhalten ausführt. Die Ausführung von LLMs kann als Black-Box-Prozess betrachtet werden: Sie können zwar eine Vielzahl natürlichsprachlicher Programme ausführen, diese Programme können jedoch auf eine Weise verarbeitet werden, die für den Menschen nicht intuitiv, sehr schwer zu verstehen und nur nutzbar ist bei der Durchführung nachgelagerter Aufgaben. Messen Sie die Qualität des Unterrichts.

Wir kommen nicht umhin zu fragen: Können große Sprachmodelle selbst Eingabeaufforderungen schreiben? Die Antwort lautet nicht nur: Ja, sondern es kann auch die menschliche Ebene erreichen.

Um den manuellen Arbeitsaufwand beim Erstellen und Überprüfen effektiver Anweisungen zu reduzieren, haben Forscher der University of Toronto, der University of Waterloo und anderer Institutionen einen neuen Algorithmus vorgeschlagen, der LLM verwendet, um Anweisungen automatisch zu generieren und auszuwählen: APE (Automatic Prompt). Ingenieur). Sie beschreiben dieses Problem als Programmsynthese natürlicher Sprache und schlagen vor, es als Black-Box-Optimierungsproblem zu behandeln, bei dem LLM sowohl zur Generierung als auch zur Suche nach realisierbaren Kandidatenlösungen verwendet werden kann.

- Papieradresse: https://arxiv.org/pdf/2211.01910.pdf

- Papier-Homepage: https://sites.google.com/view/automatic-prompt- Ingenieur

Die Forscher gingen von den drei Merkmalen des LLM aus. Zunächst wird ein LLM als Inferenzmodell verwendet, um Befehlskandidaten basierend auf einer kleinen Menge von Demonstrationen der Form-Eingabe-Ausgabe-Paare zu generieren. Als nächstes wird für jede Anweisung im Rahmen des LLM eine Bewertung berechnet, um den Suchprozess zu steuern. Schließlich schlagen sie eine iterative Monte-Carlo-Suchmethode vor, bei der LLM die besten Kandidatenanweisungen verbessert, indem es semantisch ähnliche Befehlsvarianten vorschlägt.

Intuitiv erfordert der in diesem Artikel vorgeschlagene Algorithmus, dass LLM eine Reihe von Befehlskandidaten basierend auf der Demonstration generiert und den Algorithmus dann auffordert, zu bewerten, welche Anweisungen vielversprechender sind, und der Algorithmus wird APE genannt.

Die Beiträge dieses Artikels sind wie folgt:

- Der Forscher synthetisiert die Befehlsgenerierung als Programm in natürlicher Sprache, formuliert sie als von LLM geleitetes Black-Box-Optimierungsproblem und schlägt eine iterative Monte-Carlo-Suche vor Methode zur Annäherung an die Lösung ;

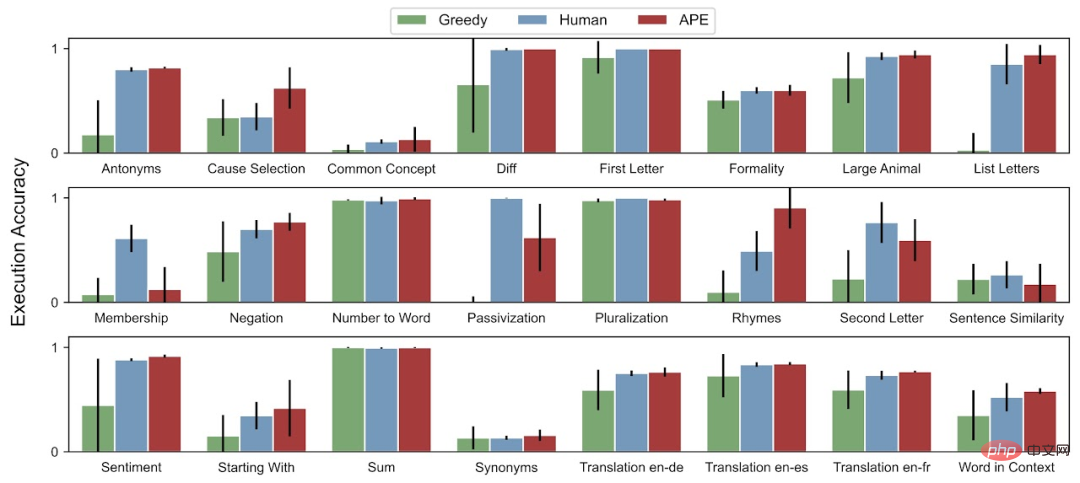

- Die APE-Methode erzielt eine bessere oder gleichwertige Leistung als Anweisungen, die von menschlichen Annotatoren für die 19/24-Aufgabe generiert werden.

Nachdem sie diese Studie gesehen hatten, mussten die Internetnutzer seufzen: Diese schnellen Ingenieure, die gerade eingestellt wurden, könnten in ein paar Monaten durch KI eliminiert werden. Die Implikation ist, dass diese Forschung menschlichen Schnellingenieuren die Arbeit nehmen wird.

„Diese Studie versucht ihr Bestes, das Prompt Engineering zu automatisieren, damit Forscher, die sich mit ML beschäftigen, sich wieder den eigentlichen Algorithmusproblemen widmen können (zwei weinende Emojis im Anhang).“

Andere beklagten: LLM ist tatsächlich die tragende Säule der ursprünglichen AGI.

Verwendung von LLM für die Programmsynthese in natürlicher Sprache

APE verwendet LLM in beiden Schlüsselkomponenten des Vorschlags und der Bewertung.

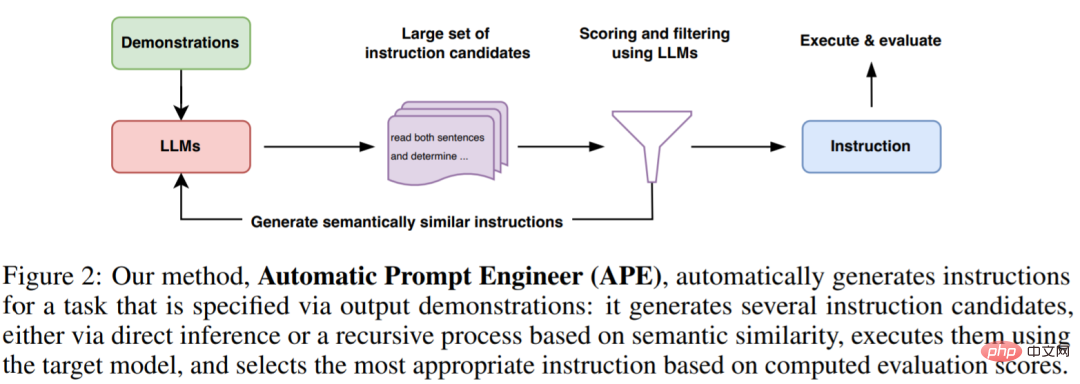

Wie in Abbildung 2 und Algorithmus 1 unten dargestellt, schlägt APE zunächst mehrere Kandidaten-Eingabeaufforderungen vor, filtert/verfeinert dann den Kandidatensatz entsprechend der ausgewählten Bewertungsfunktion und wählt schließlich die Anweisung mit der höchsten Bewertung aus.

Das Bild unten zeigt den Ausführungsprozess von APE. Es kann durch direkte Inferenz oder einen rekursiven Prozess auf der Grundlage semantischer Ähnlichkeit mehrere Kandidaten-Eingabeaufforderungen generieren, deren Leistung bewerten und iterativ neue Eingabeaufforderungen vorschlagen.

Erste Vorschlagsverteilung

Da der Suchraum unendlich groß ist, ist es äußerst schwierig, die richtigen Anweisungen zu finden, was die Handhabung der Programmsynthese in natürlicher Sprache historisch schwierig macht. Auf dieser Grundlage erwogen die Forscher den Einsatz eines vorab trainierten LLM, um eine mögliche Lösung zur Steuerung des Suchprozesses vorzuschlagen.

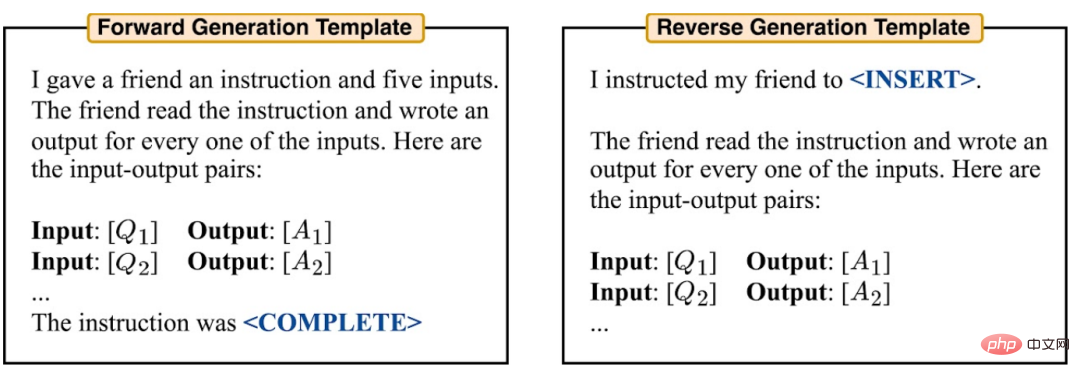

Sie betrachten zwei Methoden, um qualitativ hochwertige Kandidaten zu generieren. Zunächst wird eine Methode angewendet, die auf der Vorwärtsmustergenerierung basiert. Darüber hinaus erwogen sie auch die umgekehrte Mustergenerierung unter Verwendung von LLMs mit Auffüllfunktionen (z. B. T5, GLM, InsertGPT), um auf fehlende Anweisungen zu schließen.

Score-Funktion

Um das Problem in ein Black-Box-Optimierungsproblem umzuwandeln, wählten die Forscher eine Score-Funktion, um die Übereinstimmung zwischen dem Datensatz und den von der generierten Daten genau zu messen Modell.

Im induktiven Experiment betrachteten die Forscher zwei mögliche Bewertungsfunktionen. Im TruthfulQA-Experiment konzentrierten sich die Forscher hauptsächlich auf die von Lin et al. vorgeschlagenen Automatisierungsmetriken, ähnlich der Ausführungsgenauigkeit.

In jedem Fall verwendet der Forscher die folgende Formel (1), um die Qualität der generierten Anweisungen und Erwartungen für den Haltetestdatensatz Dtest zu bewerten.

Experiment

Die Forscher untersuchten, wie APE LLM dabei unterstützt, das erwartete Verhalten zu erreichen. Sie gehen von drei Perspektiven aus: Null-Schuss-Leistung, Wenig-Schuss-Kontext-Lernleistung und Authentizität (Wahrhaftigkeit).

Die Forscher bewerteten Zero-Shot- und Few-Shot-Kontextlernen anhand von 24 von Honovich et al. vorgeschlagenen Aufgaben zur Unterrichtseinführung. Diese Aufgaben decken viele Aspekte des Sprachverständnisses ab, von einfachen Phrasenstrukturen bis hin zur Ähnlichkeits- und Kausalitätserkennung. Um zu verstehen, wie die von APE generierten Anweisungen LLM dabei unterstützen, unterschiedliche Antwortstile zu generieren, wendet dieses Dokument APE auf TruthfulQA an, einen Datensatz.

Bei der Zero-Shot-Testgenauigkeit erreichte APE bei 19 von 24 Aufgaben eine Leistung auf menschlichem Niveau.

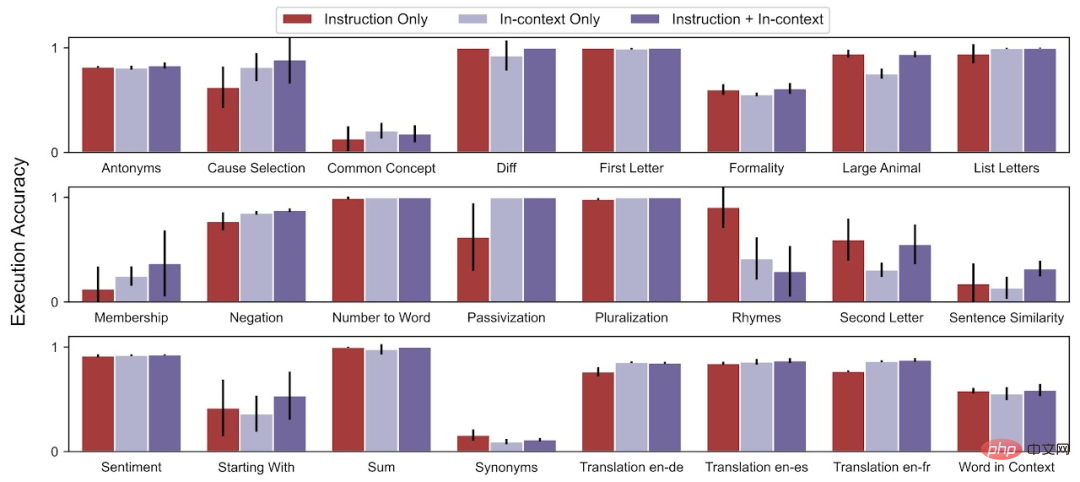

Für die Genauigkeit des Wenig-Schüsse-Kontexttests verbessert APE die Lernleistung des Wenig-Schüsse-Kontexttests bei 21 der 24 Aufgaben.

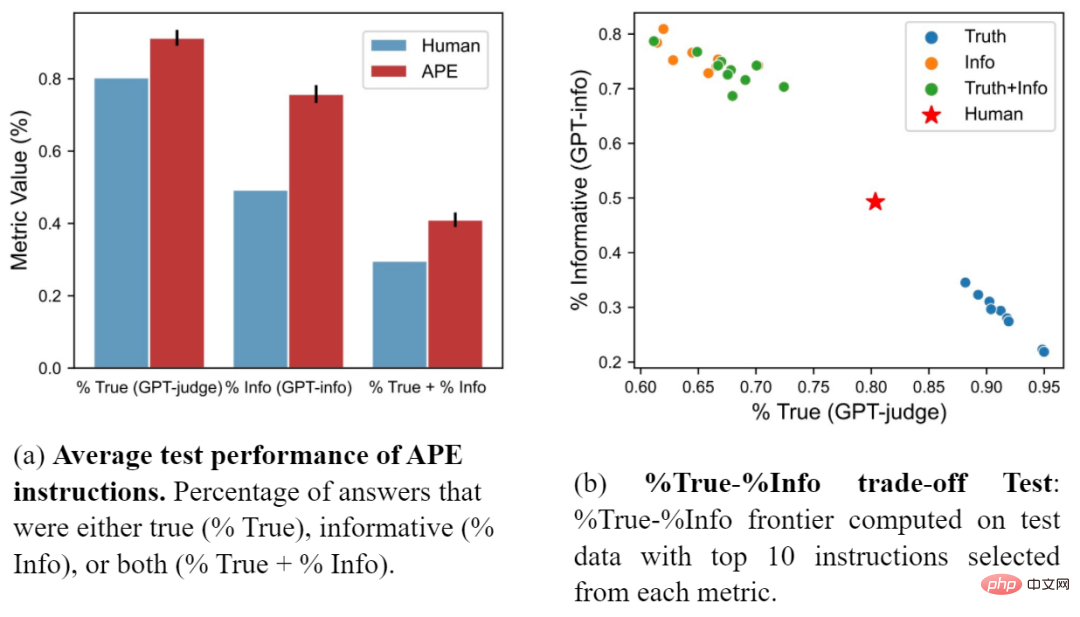

Die Forscher verglichen auch den APE-Prompt mit dem von Lin et al. vorgeschlagenen künstlichen Prompt. Abbildung (a) zeigt, dass APE-Anweisungen bei allen drei Metriken menschliche Eingabeaufforderungen übertreffen. Abbildung (b) zeigt den Kompromiss zwischen Wahrhaftigkeit und Aussagekraft.

Weitere Einzelheiten finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonKI generiert automatisch Eingabeaufforderungen, die mit Menschen vergleichbar sind: Ingenieure wurden gerade eingestellt und werden wieder eliminiert.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr