Heim >Backend-Entwicklung >Python-Tutorial >Um ein Haus in Shanghai zu mieten, habe ich mit Python über Nacht mehr als 20.000 Wohnungsinformationen durchsucht.

Um ein Haus in Shanghai zu mieten, habe ich mit Python über Nacht mehr als 20.000 Wohnungsinformationen durchsucht.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 22:19:201266Durchsuche

Aufgrund eines plötzlichen Arbeitswechsels liegt der neue Bürostandort weit entfernt von meinem jetzigen Wohnort, sodass ich ein neues Haus mieten muss.

Ich bin auf das E-Mule der Agentur gestiegen und habe angefangen, seltsame Ecken der Stadt zu erkunden.

Beim Wechsel zwischen verschiedenen Miet-Apps machte ich mir große Sorgen, weil die Effizienz sehr gering war:

Da ich mit meiner Freundin zusammen lebe, muss ich zunächst einmal die Arbeitsentfernung beider berücksichtigen Gleichzeitig sind die Funktionen zur Suche nach einem Haus basierend auf der Pendelzeit auf den Bahnsteigen relativ nutzlos. Einige Plattformen unterstützen nicht die gleichzeitige Auswahl mehrerer Standorte und einige Plattformen können nur Punkte mit derselben Pendelzeit automatisch auswählen von jedem Standort aus, was den Bedürfnissen der Benutzer nicht gerecht werden kann.

Zweitens gibt es aus Sicht eines Mieters zu viele Vermietungsplattformen und die Filter- und Sortierlogik jeder Plattform ist inkonsistent, was es schwierig macht, Informationen zu ähnlichen Immobilien horizontal zu vergleichen.

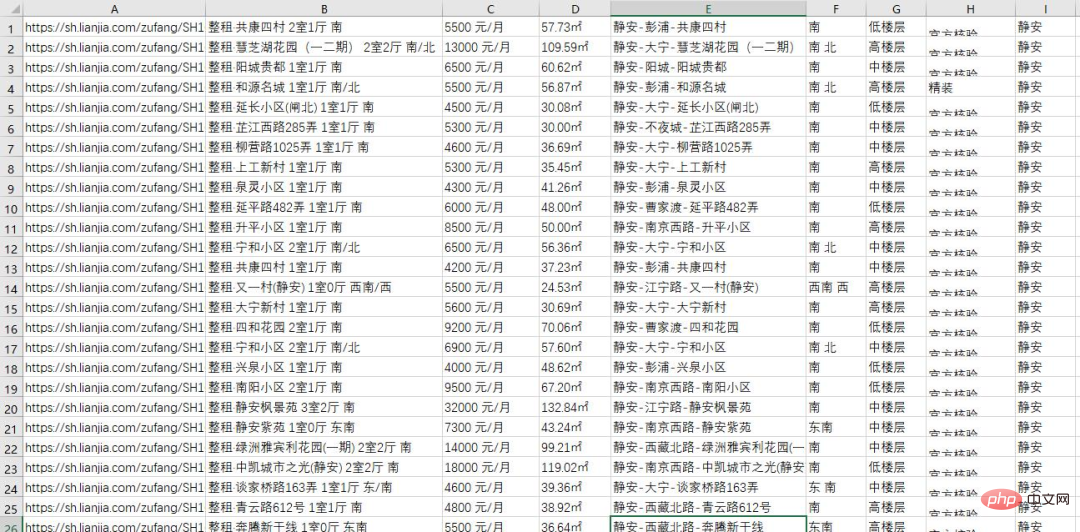

Aber das spielt keine Rolle. Als Programmierer muss man natürlich die Methoden der Programmierer nutzen, um Probleme zu lösen. Also habe ich gestern Abend ein Python-Skript verwendet, um alle Wohnungsinformationen einer Mietplattform im Raum Shanghai abzurufen, insgesamt mehr als 20.000 Stück:

Jetzt werde ich den gesamten Prozess des Crawlens der Daten mit Ihnen teilen.

Analysieren Sie die Seite und finden Sie den Einstiegspunkt.

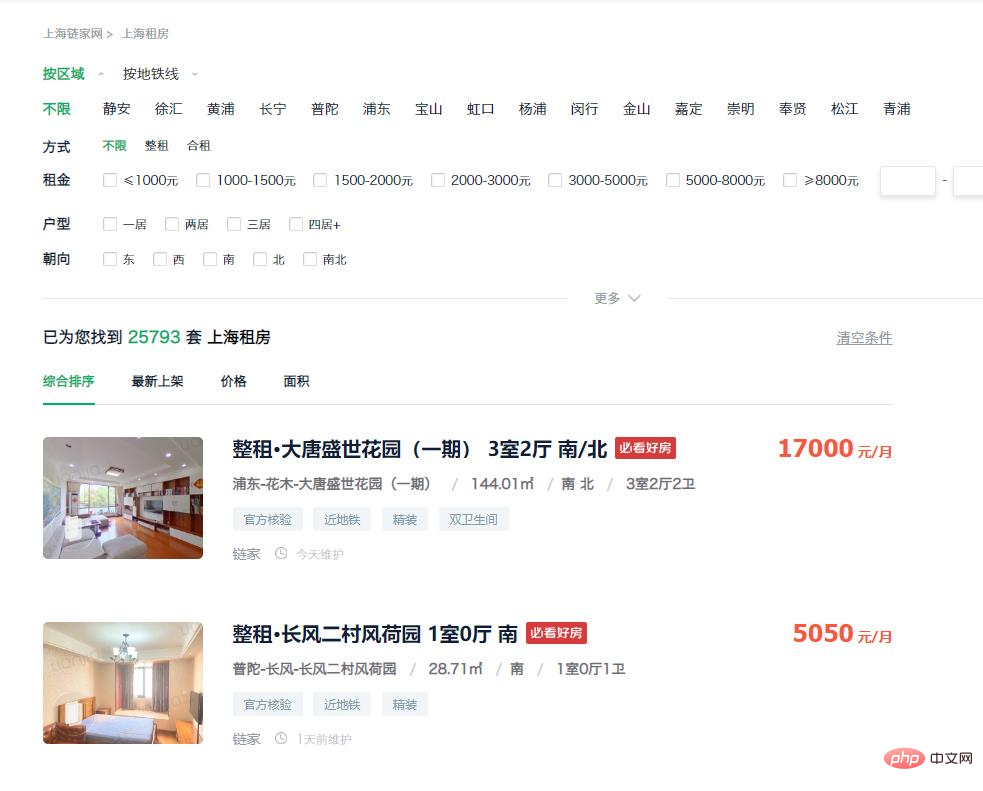

Betreten Sie zunächst die Vermietungsseite der Plattform. Sie können sehen, dass die Hausliste auf der Homepage bereits die meisten Informationen enthält, die wir benötigen, und diese Informationen können direkt vom Dom eingeholt werden Erwägen Sie daher, Webseitendaten direkt durch die Simulation von Anfragen zu sammeln.

https://sh.lianjia.com/zufang/

Als nächstes müssen wir uns überlegen, wie wir an die URL kommen. Durch Beobachtung haben wir herausgefunden, dass es in der Gegend mehr als 20.000 Häuser gibt, aber nur auf die ersten 100 Seiten mit Daten kann über die Webseite zugegriffen werden. Die Obergrenze der auf jeder Seite angezeigten Zahl liegt bei 30, was einem entspricht Insgesamt 3k. Es ist unmöglich, alle Informationen zu erhalten.

Aber wir können dieses Problem lösen, indem wir Filterbedingungen hinzufügen. Wählen Sie im Filterelement „Jing'an“ aus und geben Sie die folgende URL ein:

https://sh.lianjia.com/zufang/jingan/

Sie können sehen, dass es in der Gegend mehr als 2.000 Häuser mit 75 Datenseiten und 30 Elementen pro Seite gibt Alle Daten sind abrufbar. Daher können alle Daten in der Stadt erhalten werden, indem die Wohnungsdaten jedes Bezirks separat erfasst werden.

https://sh.lianjia.com/zufang/jingan/pg2/

Nachdem Sie auf die Schaltfläche für die zweite Seite geklickt haben, geben Sie die obige URL ein. Sie können feststellen, dass Sie die entsprechende Seitennummer eingeben können, solange Sie die Nummer nach pg ändern.

Hier besteht jedoch ein Problem: Die bei jedem Besuch derselben Anzahl von Seiten erfassten Daten sind unterschiedlich, was zu einer Duplizierung der erfassten Daten führt. Also klicken wir in den Sortierbedingungen auf „Neueste Version“ und geben den folgenden Link ein:

https://sh.lianjia.com/zufang/jingan/pg2rco11/

Die Reihenfolge der durch diese Sortiermethode erhaltenen Daten ist stabil. An diesem Punkt lautet unsere Idee: Besuchen Sie zuerst den ersten jedes kleinen Bereichs . Eine Seite, dann die maximale Anzahl von Seiten in der aktuellen Region über die erste Seite abrufen und dann auf die simulierte Anforderung zugreifen, um auf jede Seite zuzugreifen und alle Daten abzurufen.

Crawling-Daten

Nachdem Sie eine Idee haben, müssen Sie mit dem Schreiben des Codes beginnen. Der Code lautet wie folgt:

# 所有小地区对应的标识

list=['jingan','xuhui','huangpu','changning','putuo','pudong','baoshan','hongkou','yangpu','minhang','jinshan','jiading','chongming','fengxian','songjiang','qingpu']

# 存放所有链接

urls = []

for a in list:

urls.append('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a))

# 设置请求头,避免ip被ban

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.9 Safari/537.36'}

# 获取当前小地区第1页的dom信息

res = requests.get('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a), headers=headers)

content = res.text

soup = BeautifulSoup(content, 'html.parser')

# 获取当前页面的最大页数

page_num = int(soup.find('div', attrs={'class': 'content__pg'}).attrs['data-totalpage'])

for i in range(2,page_num+1):

# 将所有链接保存到urls中

urls.append('https://sh.lianjia.com/zufang/{}/pg{}rco11/'.format(a,i))Danach müssen wir die erhaltenen URLs verarbeiten Der Code lautet wie folgt:

num=1

for url in urls:

print("正在处理第{}页数据...".format(str(num)))

res1 = requests.get(url, headers=headers)

content1 = res1.text

soup1 = BeautifulSoup(content1, 'html.parser')

infos = soup1.find('div', {'class': 'content__list'}).find_all('div', {'class': 'content__list--item'})Organisieren Sie die Daten und exportieren Sie die Datei.

Durch Beobachtung der Seitenstruktur können wir den Speicherort jedes Elements ermitteln entsprechendes Seitenelement und erhalten die Informationen, die wir benötigen.

Der vollständige Code ist hier beigefügt. Interessierte Freunde können die Regionalkennung und die kleine Regionalkennung im Link entsprechend ihren eigenen Bedürfnissen ersetzen und dann die Informationen ihrer eigenen Region erhalten. Die Crawling-Methoden anderer Mietplattformen sind größtenteils ähnlich, daher werde ich nicht näher darauf eingehen.

import time, re, csv, requests

import codecs

from bs4 import BeautifulSoup

print("****处理开始****")

with open(r'..sh.csv', 'wb+')as fp:

fp.write(codecs.BOM_UTF8)

f = open(r'..sh.csv','w+',newline='', encoding='utf-8')

writer = csv.writer(f)

urls = []

# 所有小地区对应的标识

list=['jingan','xuhui','huangpu','changning','putuo','pudong','baoshan','hongkou','yangpu','minhang','jinshan','jiading','chongming','fengxian','songjiang','qingpu']

# 存放所有链接

urls = []

for a in list:

urls.append('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a))

# 设置请求头,避免ip被ban

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.9 Safari/537.36'}

# 获取当前小地区第1页的dom信息

res = requests.get('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a), headers=headers)

content = res.text

soup = BeautifulSoup(content, 'html.parser')

# 获取当前页面的最大页数

page_num = int(soup.find('div', attrs={'class': 'content__pg'}).attrs['data-totalpage'])

for i in range(2,page_num+1):

# 将所有链接保存到urls中

urls.append('https://sh.lianjia.com/zufang/{}/pg{}rco11/'.format(a,i))

num=1

for url in urls:

# 模拟请求

print("正在处理第{}页数据...".format(str(num)))

res1 = requests.get(url, headers=headers)

content1 = res1.text

soup1 = BeautifulSoup(content1, 'html.parser')

# 读取页面中数据

infos = soup1.find('div', {'class': 'content__list'}).find_all('div', {'class': 'content__list--item'})

# 数据处理

for info in infos:

house_url = 'https://sh.lianjia.com' + info.a['href']

title = info.find('p', {'class': 'content__list--item--title'}).find('a').get_text().strip()

group = title.split()[0][3:]

price = info.find('span', {'class': 'content__list--item-price'}).get_text()

tag = info.find('p', {'class': 'content__list--item--bottom oneline'}).get_text()

mixed = info.find('p', {'class': 'content__list--item--des'}).get_text()

mix = re.split(r'/', mixed)

address = mix[0].strip()

area = mix[1].strip()

door_orientation = mix[2].strip()

style = mix[-1].strip()

region = re.split(r'-', address)[0]

writer.writerow((house_url, title, group, price, area, address, door_orientation, style, tag, region))

time.sleep(0)

print("第{}页数据处理完毕,共{}条数据。".format(str(num), len(infos)))

num+=1

f.close()

print("****全部完成****")Nach einigen Operationen haben wir vollständige Wohnungsinformationen von verschiedenen lokalen Vermietungsplattformen eingeholt. Zu diesem Zeitpunkt können wir bereits durch einige grundlegende Filtermethoden die benötigten Daten erhalten.

Das obige ist der detaillierte Inhalt vonUm ein Haus in Shanghai zu mieten, habe ich mit Python über Nacht mehr als 20.000 Wohnungsinformationen durchsucht.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!