Heim >Technologie-Peripheriegeräte >KI >Wird es voraussichtlich Deepfake ersetzen? Zeigt, wie großartig die beliebteste NeRF-Technologie dieses Jahres ist

Wird es voraussichtlich Deepfake ersetzen? Zeigt, wie großartig die beliebteste NeRF-Technologie dieses Jahres ist

- PHPznach vorne

- 2023-04-12 21:37:011670Durchsuche

Was, du kennst NeRF noch nicht?

NeRF ist die heißeste KI-Technologie im Bereich Computer Vision in diesem Jahr und hat eine vielversprechende Zukunft.

Die Freunde von Standort B haben diese Technologie auf neue Weise umgesetzt.

Einführung

Also, was genau ist NeRF?

NeRF (Neural Radiance Fields) ist ein Konzept, das erstmals im besten Beitrag der ECCV-Konferenz 2020 vorgeschlagen wurde. Es hebt den impliziten Ausdruck auf eine neue Ebene und kann nur mithilfe von 2D-gestellten Bildern als Aufsicht ausgedrückt werden.

Ein Stein löste tausend Wellen aus. Seitdem hat sich NeRF rasant weiterentwickelt und auf viele technische Richtungen angewendet, wie z. B. „neue Sichtweisensynthese, dreidimensionale Rekonstruktion“ usw.

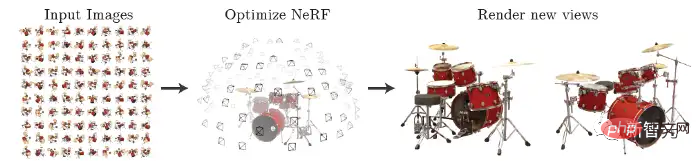

NeRF gibt spärliche Mehrwinkelbilder mit zu trainierenden Posen ein und erhält ein neuronales Strahlungsfeldmodell. Gemäß diesem Modell können klare Fotos aus jedem Betrachtungswinkel gerendert werden, wie in der folgenden Abbildung dargestellt. Es kann auch kurz zusammengefasst werden, indem man ein MLP verwendet, um implizit eine dreidimensionale Szene zu lernen.

Netizens werden NeRF natürlich mit dem ebenso beliebten Deepfake vergleichen.

Ein kürzlich von MetaPhysics veröffentlichter Artikel zog eine Bestandsaufnahme der Evolutionsgeschichte, Herausforderungen und Vorteile von NeRF und sagte voraus, dass NeRF Deepfake irgendwann ersetzen wird.

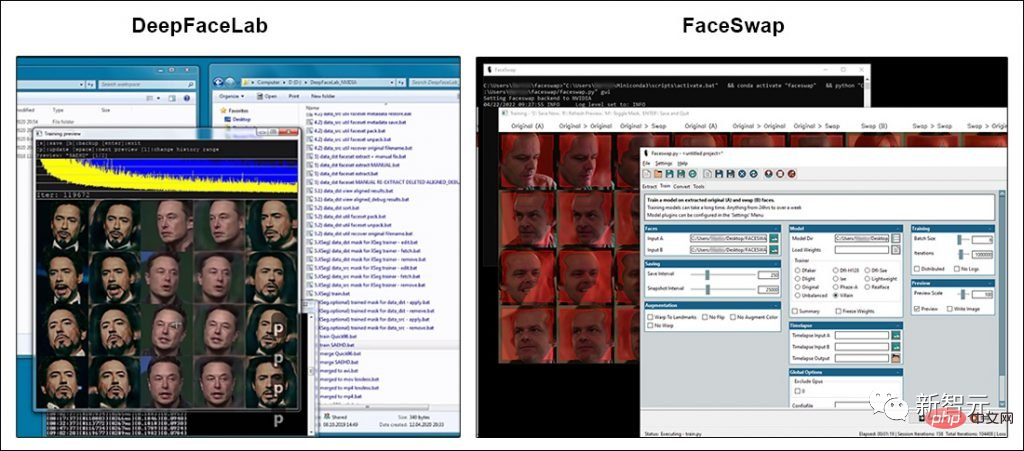

Die meisten auffälligen Themen zur Deepfake-Technologie beziehen sich auf die beiden Open-Source-Softwarepakete, die populär geworden sind, seit Deepfakes im Jahr 2017 ins öffentliche Bewusstsein gelangt sind: DeepFaceLab (DFL) und FaceSwap.

Während beide Pakete über eine umfangreiche Benutzerbasis und aktive Entwicklergemeinschaften verfügen, weicht keines der Projekte wesentlich vom GitHub-Code ab.

Natürlich waren die Entwickler von DFL und FaceSwap nicht untätig: Es ist jetzt möglich, Deepfake-Modelle mit größeren Eingabebildern zu trainieren, allerdings erfordert dies teurere GPUs.

Aber tatsächlich ist die von den Medien geförderte Verbesserung der Deepfake-Bildqualität in den letzten drei Jahren hauptsächlich auf Endbenutzer zurückzuführen.

Sie haben zeitsparende und seltene Erfahrungen in der Datenerfassung, der besten Methode zum Trainieren von Modellen (manchmal kann ein einzelnes Experiment Wochen dauern) gesammelt und gelernt, wie man die äußersten Einschränkungen des ursprünglichen Codes von 2017 ausnutzt und erweitert.

Einige in der VFX- und ML-Forschungsgemeinschaft versuchen, die „harten Einschränkungen“ des beliebten Deepfake-Pakets zu durchbrechen, indem sie die Architektur erweitern, sodass Modelle für maschinelles Lernen auf Bildern mit bis zu 1024×1024 trainiert werden können.

Seine Pixel sind doppelt so groß wie die aktuelle tatsächliche Reichweite von DeepFaceLab oder FaceSwap und liegen näher an den Auflösungen, die in der Film- und Fernsehproduktion nützlich sind. Als nächstes lernen wir NeRF kennen.

Es erzielt die besten Ergebnisse für die Synthese komplexer Szenenansichten, indem es die zugrunde liegende kontinuierliche volumetrische Szenenfunktion mithilfe eines spärlichen Satzes von Eingabeansichten optimiert.

Der Algorithmus verwendet außerdem ein vollständig verbundenes tiefes Netzwerk zur Darstellung einer Szene, dessen Eingabe eine einzelne kontinuierliche 5D-Koordinate (räumliche Position (x, y, z) und Blickrichtung (θ, φ)) ist und deren Ausgabe das Volumen von ist die räumliche Positionsdichte und die zugehörige Emissionsamplitudenhelligkeit.

Synthesieren Sie die Ansicht, indem Sie 5D-Koordinaten entlang des Kamerastrahls abfragen und die Ausgabefarbe und -dichte mithilfe klassischer Volumenrendering-Techniken in das Bild projizieren.

Implementierungsprozess:

Zuerst wird eine kontinuierliche Szene als 5D-Vektorwertfunktion dargestellt, deren Eingabe eine 3D-Position und 2D-Blickrichtung ist und deren entsprechende Ausgabe eine Emissionsfarbe c und eine Volumendichte σ ist. In der Praxis wird der 3D-kartesische Einheitsvektor d zur Darstellung der Richtung verwendet. Diese kontinuierliche 5D-Szenendarstellung wird mit einem MLP-Netzwerk angenähert und ihre Gewichte werden optimiert.Darüber hinaus wird die Konsistenz der Darstellung über mehrere Ansichten hinweg gefördert, indem das Netzwerk auf die Vorhersage der volumetrischen Dichte σ als Funktion der Position x beschränkt wird und gleichzeitig die Vorhersage der RGB-Farbe c als Funktion der Position und Blickrichtung ermöglicht wird.

Um dies zu erreichen, verarbeitet der MLP zunächst die eingegebenen 3D-Koordinaten x mit 8 vollständig verbundenen Schichten (unter Verwendung von ReLU-Aktivierung und 256 Kanälen pro Schicht) und gibt σ und 256-dimensionale Merkmalsvektoren aus.

Dieser Merkmalsvektor wird dann mit der Blickrichtung des Kamerastrahls verkettet und an eine zusätzliche vollständig verbundene Ebene übergeben, die die der Ansicht zugeordnete RGB-Farbe ausgibt.

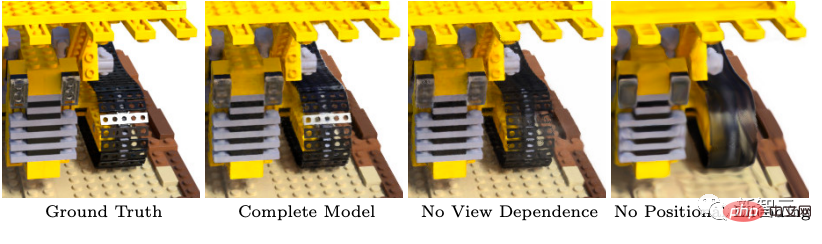

Darüber hinaus führt NeRF zwei Verbesserungen ein, um die Darstellung komplexer Szenen mit hoher Auflösung zu erreichen. Das erste ist die Positionskodierung, um MLP bei der Darstellung von Hochfrequenzfunktionen zu unterstützen, und das zweite ist ein geschichteter Abtastprozess, der es ihm ermöglicht, Hochfrequenzdarstellungen effizient abzutasten.

Wie wir alle wissen, kann die Positionscodierung in der Transformer-Architektur die diskrete Position des Markers in der Sequenz als Eingabe für die gesamte Architektur bereitstellen. NeRF verwendet Positionscodierung, um kontinuierliche Eingabekoordinaten einem höherdimensionalen Raum zuzuordnen, was es für MLP einfacher macht, Funktionen mit höherer Frequenz anzunähern.

Wie aus der Abbildung ersichtlich ist, wird das Entfernen der Positionskodierung die Fähigkeit des Modells, Hochfrequenzgeometrie und -textur darzustellen, erheblich verringern, was letztendlich zu einem zu glatten Erscheinungsbild führt.

Da die Rendering-Strategie der dichten Auswertung des neuronalen Strahlungsfeldnetzwerks an N Abfragepunkten entlang jedes Kamerastrahls sehr ineffizient ist, übernimmt NeRF schließlich eine hierarchische Darstellung, die die Rendering-Effizienz verbessert, indem Proben proportional zum erwarteten Effekt des endgültigen Renderings zugewiesen werden.

Kurz gesagt: NeRF verwendet nicht mehr nur ein Netzwerk zur Darstellung der Szene, sondern optimiert gleichzeitig zwei Netzwerke, ein „grobkörniges“ Netzwerk und ein „feinkörniges“ Netzwerk.

Die Zukunft ist vielversprechend

NeRF löst die Mängel der Vergangenheit, indem es MLP verwendet, um Objekte und Szenen als kontinuierliche Funktionen darzustellen. Im Vergleich zu früheren Methoden kann NeRF bessere Rendering-Effekte erzielen.

Allerdings ist NeRF auch mit vielen technischen Engpässen konfrontiert. Beispielsweise wird der NeRF-Beschleuniger andere relativ nützliche Funktionen (z. B. Flexibilität) opfern, um eine geringe Latenz, interaktivere Umgebungen und weniger Trainingszeit zu erreichen.

Obwohl NeRF ein entscheidender Durchbruch ist, dauert es dennoch eine gewisse Zeit, bis perfekte Ergebnisse erzielt werden.

Die Technologie schreitet voran und die Zukunft ist immer noch vielversprechend!

Das obige ist der detaillierte Inhalt vonWird es voraussichtlich Deepfake ersetzen? Zeigt, wie großartig die beliebteste NeRF-Technologie dieses Jahres ist. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr