Heim >Technologie-Peripheriegeräte >KI >Wie kann man der KI universelle Fähigkeiten verleihen? Neue Studie: Schlafen Sie ein

Wie kann man der KI universelle Fähigkeiten verleihen? Neue Studie: Schlafen Sie ein

- 王林nach vorne

- 2023-04-12 21:19:041476Durchsuche

Neuronale Netze können Menschen bei vielen Aufgaben übertreffen, aber wenn man ein KI-System auffordert, neue Erinnerungen zu absorbieren, vergisst es möglicherweise sofort, was es zuvor gelernt hat. Jetzt enthüllt eine neue Studie einen neuen Weg für neuronale Netze, sich durch Schlafphasen zu bewegen und dabei zu helfen, diese Amnesie zu verhindern.

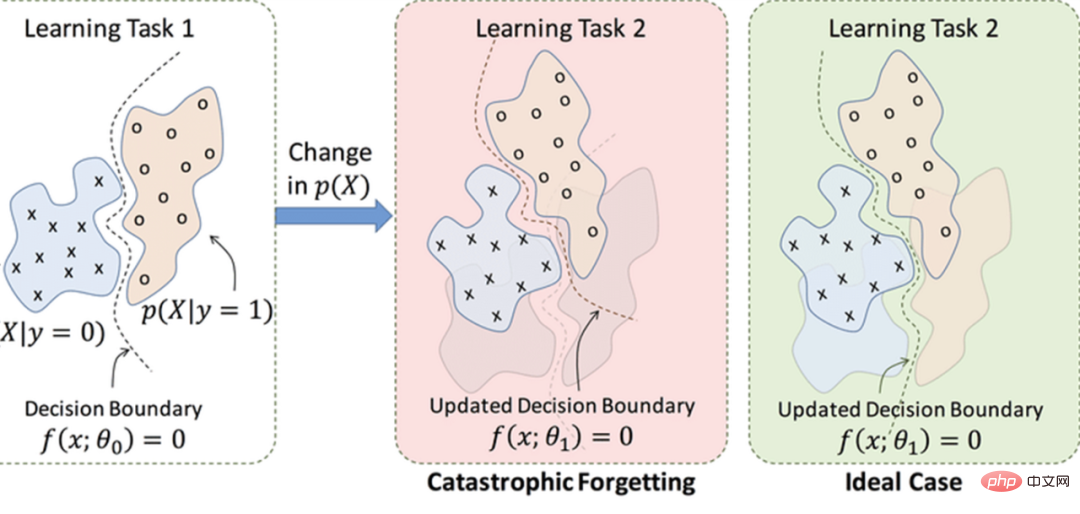

Eine große Herausforderung für künstliche neuronale Netze ist das „katastrophale Vergessen“. Wenn sie eine neue Aufgabe lernen, neigen sie leider dazu, plötzlich völlig zu vergessen, was sie zuvor gelernt haben.

Im Wesentlichen handelt es sich bei der Darstellung von Daten durch neuronale Netze um eine aufgabenorientierte Datenkomprimierung der Originaldaten, wobei das neu erlernte Wissen die vergangenen Daten überschreibt.

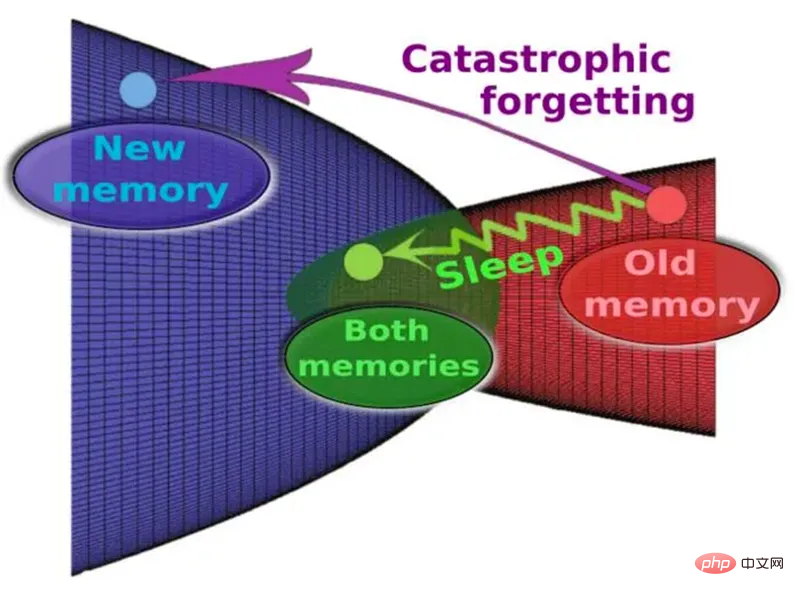

Dies ist einer der größten Mängel der aktuellen Technologie im Vergleich zu menschlichen neuronalen Netzen: Im Gegensatz dazu ist das menschliche Gehirn in der Lage, ein Leben lang neue Aufgaben zu lernen, ohne dass seine Fähigkeit, zuvor gespeicherte Aufgaben auszuführen, beeinträchtigt wird. Wir wissen nicht genau, warum, aber Studien belegen schon lange, dass das menschliche Gehirn am besten lernt, wenn Lernrunden mit Schlaf unterbrochen werden. Schlaf hilft offenbar dabei, aktuelle Erfahrungen in Langzeitgedächtnisbanken zu integrieren.

„Die Reorganisation von Erinnerungen könnte tatsächlich einer der Hauptgründe dafür sein, dass Organismen Schlafphasen durchlaufen müssen“, sagt Erik Delanois, Computerneurowissenschaftler an der University of California in San Diego.

Kann KI auch schlafen lernen? Einige frühere Forschungen haben versucht, der katastrophalen Amnesie entgegenzuwirken, indem KI den Schlaf simulieren ließ. Wenn beispielsweise ein neuronales Netzwerk eine neue Aufgabe lernt, füttert eine Strategie namens „Interleaved Training“ die Maschinen gleichzeitig mit alten Daten, die sie zuvor gelernt haben, um ihnen zu helfen, früheres Wissen zu behalten. Früher ging man davon aus, dass dieser Ansatz die Arbeitsweise des Gehirns im Schlaf nachahmt – das ständige Abspielen alter Erinnerungen.

Allerdings hatten Wissenschaftler die Hypothese aufgestellt, dass beim Interleaved-Training jedes Mal, wenn es etwas Neues lernen wollte, einem neuronalen Netzwerk alle Daten zugeführt werden müssten, die es ursprünglich zum Erlernen einer alten Fähigkeit verwendet hatte. Dies erfordert nicht nur viel Zeit und Daten, sondern es scheint auch nicht das zu sein, was biologische Gehirne im wahren Schlaf tun – Organismen haben weder die Fähigkeit, alle Daten zu speichern, die zum Erlernen alter Aufgaben erforderlich sind, noch verfügen sie über die Fähigkeit Zeit, alles im Schlaf noch einmal durchzugehen.

In einer neuen Studie analysieren Forscher die Mechanismen hinter katastrophalem Vergessen und die Wirksamkeit des Schlafs bei der Vorbeugung des Problems. Die Forscher verwendeten keine herkömmlichen neuronalen Netze, sondern ein „Spiking-Neuronales Netz“, das näher am menschlichen Gehirn liegt.

In einem künstlichen neuronalen Netzwerk werden Komponenten, sogenannte Neuronen, mit Daten gefüttert und arbeiten zusammen, um ein Problem zu lösen, beispielsweise beim Erkennen von Gesichtern. Das neuronale Netzwerk optimiert wiederholt seine Synapsen – die Verbindungen zwischen seinen Neuronen – und prüft, ob die daraus resultierenden Verhaltensmuster besser zu Lösungen führen. Mit der Zeit (kontinuierliches Training) findet das Netzwerk heraus, welche Muster sich am besten für die Berechnung des richtigen Ergebnisses eignen. Schließlich übernimmt es diese Modi als Standardmodus, von dem angenommen wird, dass er den Lernprozess des menschlichen Gehirns teilweise nachahmt.

Dieses Diagramm stellt das Gedächtnis im abstrakten synaptischen Raum und seine Entwicklung während und ohne Schlaf dar.

In einem künstlichen neuronalen Netzwerk ändert sich der Output eines Neurons kontinuierlich, wenn sich der Input ändert. Im Gegensatz dazu erzeugt ein Neuron in einem Spiking Neural Network (SNN) ein Ausgangssignal erst nach einer bestimmten Anzahl von Eingangssignalen, ein Prozess, der das Verhalten echter biologischer Neuronen originalgetreu nachbildet. Da Spike-Neuronale Netze selten Impulse aussenden, übertragen sie weniger Daten als typische künstliche Neuronale Netze und benötigen grundsätzlich weniger Strom und Kommunikationsbandbreite.

Wie erwartet weist das Spike-Neuronale Netzwerk eine solche Eigenschaft auf: Während des anfänglichen Lernprozesses kommt es zu katastrophalem Vergessen. Nach einer gewissen Zeit nimmt jedoch die Anzahl der Personen ab, die am Lernen der ersten Aufgabe beteiligt sind der Neuronen werden reaktiviert. Dies entspricht eher dem, was Neurowissenschaftler derzeit über den Schlafprozess denken.

Einfach ausgedrückt: SNN ermöglicht die automatische Reaktivierung zuvor erlernter Gedächtnisspuren während der Offline-Verarbeitung des Schlafs und die störungsfreie Änderung synaptischer Gewichte.

Diese Studie verwendet mehrschichtiges SNN mit verstärkendem Lernen, um zu untersuchen, ob katastrophales Vergessen vermieden werden kann, indem Perioden des Trainings für neue Aufgaben mit Perioden schlafähnlicher autonomer Aktivität verschachtelt werden. Die Studie zeigte insbesondere, dass katastrophales Vergessen verhindert werden kann, indem das Verstärkungslernen bei neuen Aufgaben regelmäßig unterbrochen wird, ähnlich wie in Schlafphasen.

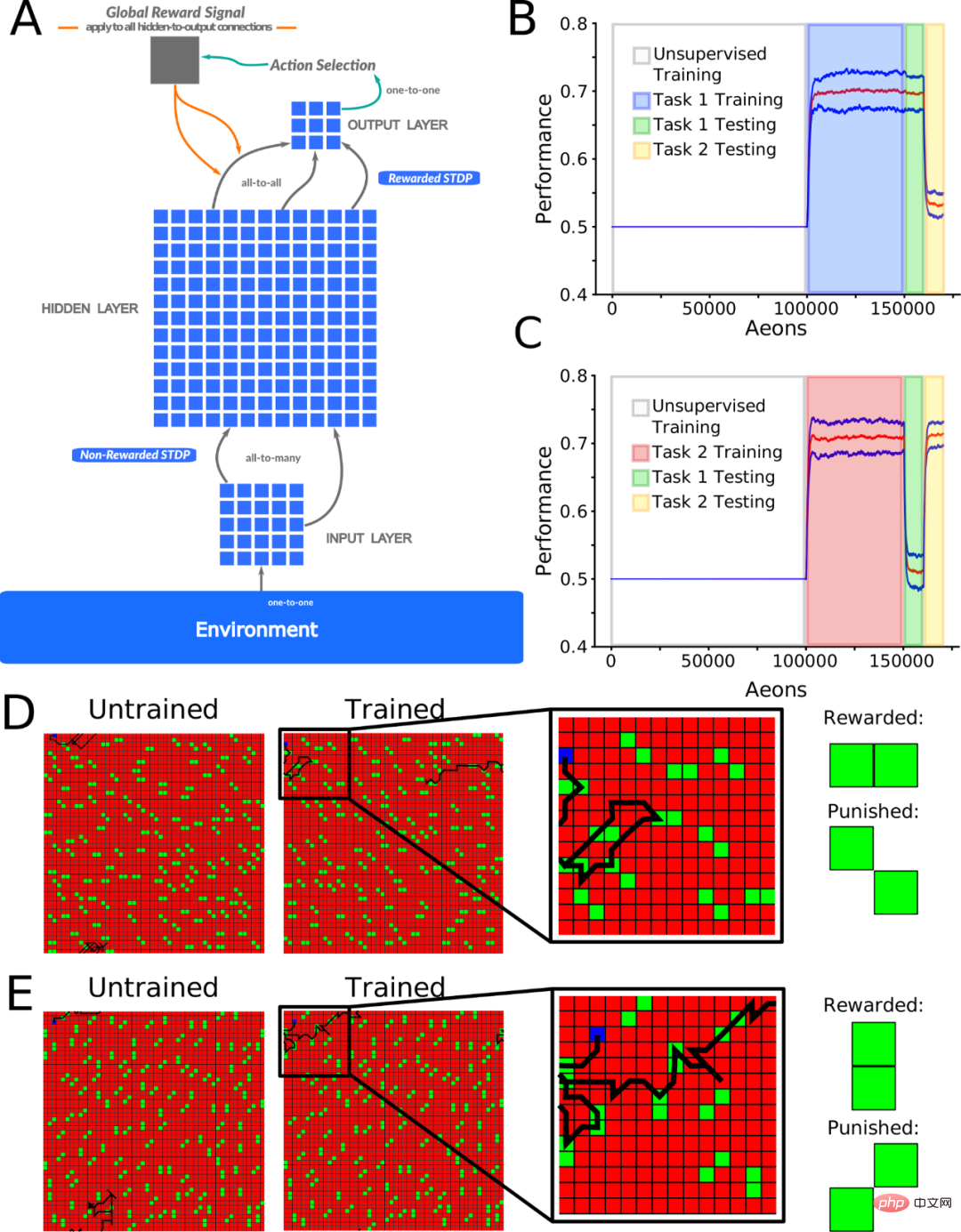

Abbildung 1A zeigt ein Feedforward-Spike-Neuronales Netzwerk, das ein Signal vom Eingang zum Ausgang modelliert. Die Neuronen, die sich zwischen der Eingabeschicht (I) und der verborgenen Schicht (H) befinden, durchlaufen unüberwachtes Lernen (implementiert mit nicht belohntem STDP), und die Neuronen zwischen der H-Schicht und der Ausgabeschicht (O) durchlaufen verstärktes Lernen (implementiert mit belohntem STDP). STDP).

Unüberwachtes Lernen ermöglicht es Neuronen der verborgenen Schicht, verschiedene Partikelmuster von verschiedenen räumlichen Orten in der Eingabeschicht zu lernen, während Belohnungs-STDP es Neuronen der Ausgabeschicht ermöglicht, Bewegungsentscheidungen basierend auf der Art der von der Eingabeschicht erkannten Partikelmuster zu lernen.

Die Forscher trainierten das Netzwerk auf zwei sich ergänzende Arten. Bei beiden Aufgaben lernt das Netzwerk, zwischen Belohnungs- und Bestrafungspartikelmustern zu unterscheiden, mit dem Ziel, so viel Belohnung wie möglich zu erhalten. Die Aufgabe berücksichtigt die Musterunterscheidbarkeit (Verhältnis der ausgegebenen Belohnungs- zu den Strafpartikeln) als Leistungsmaß mit einer Wahrscheinlichkeit von 0,5. Alle gemeldeten Ergebnisse basieren auf mindestens 10 Experimenten mit unterschiedlichen zufälligen Netzwerkinitialisierungen.

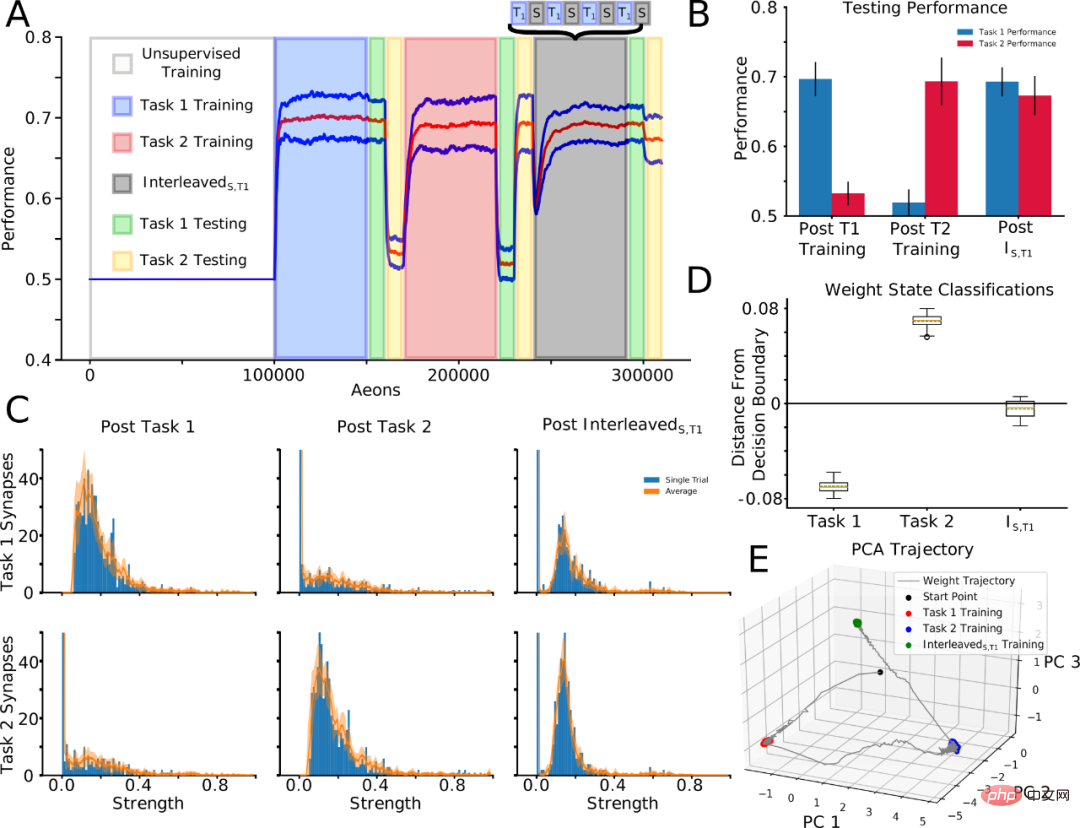

Um die synaptische Gewichtsdynamik während Training und Schlaf aufzudecken, verfolgten die Forscher als nächstes „aufgabenbezogene“ Synapsen, d. h. Synapsen, die nach dem Training für eine bestimmte Aufgabe in den oberen 10 % der Verteilung identifiziert wurden. Zuerst wurde Aufgabe 1 trainiert, dann Aufgabe 2, und nach jedem Aufgabentraining wurden aufgabenrelevante Synapsen identifiziert. Fahren Sie als Nächstes mit dem Training von Aufgabe 1 erneut fort, verschachteln Sie es jedoch mit der Ruhezeit (verschachteltes Training): T1→T2→InterleavedS,T1. Das sequentielle Training von Aufgabe 1 – Aufgabe 2 führte dazu, dass Aufgabe 1 vergessen wurde, aber nach InterleavedS wurde Aufgabe 1 neu gelernt und Aufgabe 2 wurde ebenfalls beibehalten (Abbildungen 4A und 4B).

Wichtig ist, dass diese Strategie es uns ermöglichte, synaptische Gewichte nach dem InterleavedS,T1-Training mit synaptischen Gewichten zu vergleichen, die nach separatem Training für Aufgabe 1 und Aufgabe 2 als aufgabenrelevant identifiziert wurden (Abbildung 4C). Die Verteilungsstruktur der mit Aufgabe 1 verbundenen Synapsen, die nach dem Training mit Aufgabe 1 gebildet wurden (Abb. 4C; oben links), wurde nach dem Training mit Aufgabe 2 (oben in der Mitte) gestört, nach dem Training mit InterleavedS, T1 (oben rechts) jedoch teilweise wiederhergestellt. Die Verteilungsstruktur von Task-2-bezogenen Synapsen nach Task-2-Training (unten in der Mitte) fehlt nach Task-1-Training (unten links) und bleibt nach InterleavedS, T1-Training (unten rechts) teilweise erhalten.

Es ist zu beachten, dass dieses qualitative Muster deutlich innerhalb eines einzelnen Versuchs beobachtet werden kann (Abbildung 4C; blauer Balken) und sich auch über Versuche hinweg verallgemeinern lässt (Abbildung 4C; orange Linie). Daher kann Schlaf wichtige Synapsen bewahren und gleichzeitig neue Synapsen zusammenführen.

Abbildung 4. Verschachtelte Trainings- und Schlafphasen für neue Aufgaben ermöglichen die Integration synaptischer Informationen, die für die neue Aufgabe relevant sind, während alte Aufgabeninformationen erhalten bleiben.

„Interessanterweise haben wir Daten im Zusammenhang mit frühen Erinnerungen nicht explizit gespeichert, um sie im Schlaf künstlich wiederzugeben, um ein Vergessen zu verhindern“, sagte Co-Autor der Studie, Informatik am Institut für Informatik der Tschechischen Akademie der Wissenschaften sagt der Neurowissenschaftler Pavel Sanda.

Neue Strategie gefunden, um katastrophales Vergessen zu verhindern. Das Spike-Neuronale Netzwerk war in der Lage, beide Aufgaben auszuführen, nachdem es schlafähnliche Phasen durchlaufen hatte, und die Forscher glauben, dass ihre Strategie dazu beigetragen hat, synaptische Muster beizubehalten, die mit den alten und neuen Aufgaben verbunden sind.

„Unsere Arbeit zeigt, wie praktisch die Entwicklung biologisch inspirierter Lösungen ist“, sagte Delanois.

Die Forscher stellen fest, dass sich ihre Erkenntnisse nicht auf das Spiken neuronaler Netze beschränken. Sanda sagte, dass bevorstehende Arbeiten zeigen, dass schlafähnliche Phasen dazu beitragen könnten, „das katastrophale Vergessen in herkömmlichen künstlichen neuronalen Netzen zu überwinden“.

Die Studie wurde am 18. November in der Zeitschrift PLOS Computational Biology veröffentlicht.

Artikel: „Schlaf verhindert katastrophales Vergessen in spikenden neuronalen Netzen, indem er eine gemeinsame synaptische Gewichtsdarstellung bildet“

Papieradresse: https://journals.plos.org/ploscompbiol /article ?id=10.1371/journal.pcbi.1010628

Das obige ist der detaillierte Inhalt vonWie kann man der KI universelle Fähigkeiten verleihen? Neue Studie: Schlafen Sie ein. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr