Heim >Technologie-Peripheriegeräte >KI >Denken Sie nicht Schritt für Schritt! Googles neuester Natural Language Reasoning-Algorithmus LAMBADA: „Reverse Chain Reasoning' ist die Antwort

Denken Sie nicht Schritt für Schritt! Googles neuester Natural Language Reasoning-Algorithmus LAMBADA: „Reverse Chain Reasoning' ist die Antwort

- 王林nach vorne

- 2023-04-12 21:16:201810Durchsuche

Automatisches Denken ist definitiv ein großes Problem im Bereich der Verarbeitung natürlicher Sprache. Das Modell muss effektive und korrekte Schlussfolgerungen auf der Grundlage gegebener Prämissen und Kenntnisse ableiten.

Obwohl der Bereich NLP in den letzten Jahren durch umfangreiche vorab trainierte Sprachmodelle bei verschiedenen Aufgaben des „Verstehens natürlicher Sprache“ wie Leseverständnis und Beantwortung von Fragen extrem hohe Leistungen erzielt hat, ist die Leistung dieser Modelle beim logischen Denken gestiegen ist immer noch sehr im Rückstand.

Chain of Thought (CoT) kam im Mai letzten Jahres heraus. Einige Forscher fanden heraus, dass allein das Hinzufügen von „Lass uns Schritt für Schritt denken“ die Inferenzleistung von GPT-3 erheblich verbessern kann Bei MultiArith ist die Inferenzgenauigkeit von zuvor 17,7 % auf 78,7 % gestiegen

Aber Methoden wie CoT und Selection Inference suchen alle in der Vorwärtsrichtung nach Axiomen Das Problem der kombinatorischen Explosion des Suchraums ist daher bei längeren Argumentationsketten höher.

Kürzlich hat Google Research einen Rückwärtsverkettungsalgorithmus LAMBADA (LAnguage Model augmented BackwarD chaining) entwickelt, der die aus der klassischen Argumentationsliteratur abgeleitete Schlussfolgerung „Rückwärtsschlussfolgerung ist deutlich höher als Vorwärtsschlussfolgerung“ auf das Sprachmodell anwendet (LM).

Link zum Papier: https://arxiv.org/abs/2212.13894

LAMBADA zerlegt den Argumentationsprozess in vier Untermodule. Jedes Modul wird durch gestütztes Sprachmodellargumentieren mit wenigen Schüssen implementiert.

Am Ende erzielte LAMBADA im Vergleich zur aktuellen Vorwärtsbeweismethode von Sota erhebliche Leistungsverbesserungen bei den beiden logischen Argumentationsdatensätzen. Insbesondere wenn das Problem eine tiefe und genaue Beweiskette erfordert, ist die Leistungsverbesserung von LAMBADA noch offensichtlicher. .

„Umgekehrtes Denken“ wird die Antwort?

Logisches Denken, insbesondere logisches Denken in Bezug auf unstrukturierten natürlichen Text, ist der Grundbaustein für die automatische Wissensentdeckung und der Schlüssel für zukünftige Fortschritte in verschiedenen wissenschaftlichen Bereichen.

Obwohl die Entwicklung vieler NLP-Aufgaben von der zunehmenden Größe vorab trainierter Sprachmodelle profitiert hat, wurde beobachtet, dass eine Vergrößerung des Modells nur sehr begrenzte Verbesserungen bei der Lösung komplexer Argumentationsprobleme mit sich bringt.

In der klassischen Literatur gibt es zwei Hauptmethoden für das logische Denken:

1. Forward Chaining (FC), das heißt, ausgehend von Fakten und Regeln neue Schlussfolgerungen zu ziehen und diese zwischen Theorien zu addieren und bis zum Ziel zu iterieren Aussage kann bewiesen oder widerlegt werden;

2. Rückwärtsverkettung (BC), d. h. ausgehend vom Ziel, rekursiv in Unterziele zerlegen, bis Unterziele anhand von Fakten bewiesen oder widerlegt werden können.

Frühere Argumentationsmethoden unter Verwendung von Sprachmodellen verwendeten meist die Idee des Vorwärtskettenschlusses, bei dem eine Teilmenge von Fakten und Regeln aus der gesamten Menge ausgewählt werden musste. Dies kann für LM schwierig sein, da eine kombinatorische Suche erforderlich ist ein großer Raum.

Darüber hinaus ist es in FC auch sehr schwierig zu entscheiden, wann die Suche beendet und der Beweis für fehlgeschlagen erklärt werden soll, und erfordert manchmal sogar ein speziell auf Zwischenetiketten geschultes Modul.

Tatsächlich konzentriert sich die klassische Literatur zum automatischen Denken größtenteils auf Rückwärtskettenschlussfolgerungen oder zielorientierte Verifizierungsstrategien.

LAMBADA

LAMBADA bedeutet „Sprachmodell erweitert durch Reverse-Chain-Technologie“. Forscher haben experimentell bewiesen, dass BC besser für textbasiertes deduktives logisches Denken geeignet ist.

BC erfordert keine große Anzahl kombinatorischer Suchen zur Auswahl von Teilmengen und verfügt über natürlichere Stoppkriterien.

LAMBADA konzentriert sich hauptsächlich auf automatisches Denken über Fakten, also auf Behauptungen in natürlicher Sprache, wie zum Beispiel „Gute Menschen sind rot“. Diese Behauptungen sind kohärent, basieren aber nicht unbedingt auf der wahren Situation.

Eine Regel wird durch eine Aussage in natürlicher Sprache geschrieben, die in der Form „Wenn P, dann Q“ umgeschrieben werden kann. Beispielsweise kann „Rau, nette Leute sind rot“ umgeschrieben werden als „Wenn eine Person rau ist.“ „Wenn ein Mensch rau und nett ist, dann ist er rot.“

wobei P als Antezedens der Regel und Q als Konsequenz der Regel bezeichnet wird.

Eine Theorie Theorie C besteht aus Fakten F={f1, , rm} und Regeln R={r1, r2, Fakten und Regeln Ziel.

Beispiel 1, ein theoretisches Beispiel C mit fiktiven Charakteren und Regeln

F={"Fiona ist eine gute Person", "Fiona ist eine raue Person"}

R={"Wenn jemand Wenn eine Person ist schlau, dann ist er ein guter Mensch“, „Ein rauer guter Mensch ist rot“, „Ein guter Mensch zu sein und rot bedeutet, dass er rund ist“}.

Basierend auf der oben genannten Theorie möchte man vielleicht ein Ziel beweisen oder widerlegen, wie zum Beispiel „Fiona ist rot?“

Rückwärtsverkettendes Denken

Ob eine Regel auf ein Ziel zutrifft, wird durch eine Operation bestimmt, die in der Logik Vereinheitlichung genannt wird.

Für das Ziel „Fiona ist rot?“ in Beispiel 1 hat die zweite Regel die gleichen Konsequenzen wie das Ziel, die anderen beiden Regeln haben jedoch unterschiedliche Konsequenzen. Es trifft nicht zu.

Unter Berücksichtigung der Theorie und Ziele in Beispiel 1 beginnt BC mit der Argumentation vom Ziel „Fiona ist rot?“

Zunächst prüft BC, ob das Ziel anhand irgendwelcher Fakten bewiesen oder widerlegt werden kann. Da es keine Fakten gibt, die dieses Ziel beweisen oder widerlegen, prüfen wir als nächstes, ob dieses Ziel mit den Ergebnissen irgendwelcher Regeln übereinstimmt, und wir stellen fest, dass es mit der zweiten Regel „Rohe und gute Menschen sind rot“ übereinstimmt.

Dieses Ziel kann also in zwei Unterziele unterteilt werden: 1) Ist Fiona grob? und 2) Ist Fiona ein guter Mensch? .

Da sich beide Teilziele anhand von Fakten belegen lassen, kommt BC zu dem Schluss, dass das ursprüngliche Ziel beweisbar ist.

Bei einem Ziel ist das Ergebnis von BC entweder Beweis, Ablehnung oder Unbekannt (z. B. das Ziel „Fiona ist schlau?“).

Sprachmodell in LAMBADA

Um BC für textbasiertes Denken zu nutzen, führten Forscher vier LM-basierte Module ein: Faktenprüfung, Regelauswahl, Zielzerlegung und Unterzeichnungsvereinbarung.

Faktenprüfung

Gegeben eine Reihe von Fakten F und ein Ziel G in der Theorie, überprüft das Faktenprüfungsmodul, ob es eine Tatsache f∈F gibt, so dass f G enthält ( hier ist das Ziel bewiesen) oder f enthält die Negation von G (in diesem Fall ist das Ziel verneint).

Wenn eine solche Tatsache nicht gefunden werden kann, bleibt die Wahrheit von G unbekannt.

Die Implementierung der Faktenprüfung umfasst zwei Untermodule: Das erste Untermodul wählt einen Fakt aus der Menge der für das Ziel relevantesten Fakten aus und das zweite Untermodul überprüft, ob das Ziel anhand dessen bewiesen oder widerlegt werden kann auf dieser Tatsache.

Da das Faktenauswahl-Untermodul beim ersten Versuch möglicherweise nicht die besten Fakten ermittelt, können die ausgewählten Fakten gelöscht und das Untermodul gelöscht werden, wenn die Wahrheit des Ziels nach einer Aufrufrunde des Untermoduls immer noch unbekannt ist -module wird erneut aufgerufen; Dieser Vorgang kann mehrmals wiederholt werden.

Regelauswahl

Bei einem Regelsatz R und einem Ziel G in der Theorie bestimmt das Regelauswahlmodul die Regel r∈R, um das Ergebnis von r mit G konsistent zu machen, und verwendet diese dann Regeln zum Festlegen des Ziels. Unterteilen Sie es in Unterziele.

Wenn solche Regeln nicht bestimmt werden können, bleibt die Wahrheit von G unbekannt.

Die Regelauswahl umfasst außerdem zwei Untermodule: Das erste Untermodul bestimmt das Ergebnis jeder Regel (unabhängig vom Ziel), und das zweite Untermodul verwendet das Ergebnis und das Ziel der Regel als Eingabe und bestimmt, welche man steht im Einklang mit dem Ziel.

Es ist zu beachten, dass das Regelauswahlmodul aufgrund der rekursiven Natur von BC im Prozess des Zielnachweises möglicherweise mehrmals aufgerufen wird. Da das Ergebnis der Identifizierung jeder Regel unabhängig vom Ziel ist, muss dieses Submodul nur einmal aufgerufen werden.

Zielzerlegung

Gegeben eine Regel r und ein Ziel G, so dass das Ergebnis von r mit G vereint ist, bestimmt das Zielzerlegungsmodul die Unterziele, die bewiesen werden müssen, damit G bewiesen ist oder widerlegt.

Im Falle eines erfolgreichen Nachweises des Antezedens von r hängt die Frage, ob das Ziel bewiesen oder widerlegt wird, davon ab, ob das Vorzeichen des Ziels mit dem Vorzeichen des Ergebnisses von r übereinstimmt. Für das Ziel „Fiona ist rot? ist bewiesen.

Symbolische KonsistenzBei einer gegebenen Regel r und einem Ziel G überprüft das Modul für symbolische Konsistenz, ob das resultierende Vorzeichen von r mit dem Vorzeichen des Ziels übereinstimmt oder nicht.

Experimenteller Teil

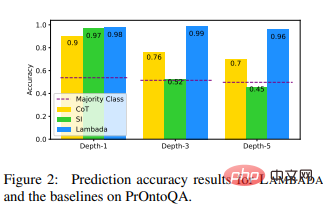

Die Forscher wählten Chain of Thought (CoT), die auf explizitem Denken basierende Sota-Neuronale-Schlussfolgerungsmethode und die Sota-Modul-Schlussfolgerungsmethode Selection Inference (SI) als Basismodell für den Vergleich.

Die experimentellen Datensätze verwenden ProofWriter und PrOntoQA. Diese Datensätze stellen eine Herausforderung für die LM-Inferenz dar und enthalten Beispiele, bei denen Kettenlängen von bis zu 5 Hops nachgewiesen werden müssen, sowie Beispiele, bei denen das Ziel weder bewiesen noch widerlegt werden kann die bereitgestellte Theorie.

Experimentelle Ergebnisse zeigen, dass LAMBADA die beiden anderen Basislinien deutlich übertrifft, insbesondere beim ProofWriter-PUD-Datensatz mit UNBEKANNTEN Labels (44 % relative Verbesserung im Vergleich zu CoT und 56 % im Vergleich zu SI in der Tiefe – 5 % Verbesserung) und in den höheren Tiefen von PrOntoQA (37 % relative Verbesserung im Vergleich zu CoT und 113 % relative Verbesserung im Vergleich zu SI bei Tiefe -5).

Diese Ergebnisse zeigen die Vorteile von LAMBADA beim logischen Denken und zeigen auch, dass eine Rückwärtsverkettung (die das Rückgrat des Denkens in LAMBADA darstellt) im Vergleich zu einer Vorwärtsverkettung (die das Rückgrat in SI darstellt) möglich ist eine bessere Wahl.

Diese Ergebnisse offenbaren auch einen Fehler in der CoT-Methode beim Umgang mit UNBEKANNTEN Bezeichnungen: Im Gegensatz zu Beispielen mit der Bezeichnung BEWIESEN oder WIDERLEGT gibt es für Beispiele mit der Bezeichnung UNBEKANNT keine natürliche Denkkette.

Für tiefere (3+) Beweiskettenprobleme erzeugt SI Vorhersagen, die den Mehrheitsklassenvorhersagen für drei Datensätze nahekommen.

Es kann festgestellt werden, dass es im binären Fall dazu neigt, WIDERGELEGT zu prognostizieren; im ternären Klassifizierungsfall neigt es dazu, UNBEKANNT vorherzusagen, was dazu führt, dass es sogar besser abschneidet als die Mehrheitsklasse in Tiefe-5 von PrOntoQA. Schlecht, weil In dieser Tiefe gibt es mehr BEWÄHRTE als WIDERGELEGTE Tags.

Allerdings waren die Forscher auch überrascht, als sie feststellten, dass die Leistung von CoT im ProofWriterPD-Datensatz immer noch relativ hoch war und die Genauigkeitsrate nicht abnahm.

Zusammenfassend lässt sich sagen, dass LAMBADA bei diesen Datensätzen eine höhere Inferenzgenauigkeit aufweist als andere Techniken, die mit falschen Beweisspuren korrekte Schlussfolgerungen ziehen, als andere auf LM basierende Techniken ist bei der Abfrage effizienter.

Die Ergebnisse dieses Experiments deuten stark darauf hin, dass zukünftige Arbeiten zum Denken mit LM Rückwärtsverkettungen oder zielgerichtete Strategien umfassen sollten, sagten die Forscher.

Referenz:

https://arxiv.org/abs/2212.13894

Das obige ist der detaillierte Inhalt vonDenken Sie nicht Schritt für Schritt! Googles neuester Natural Language Reasoning-Algorithmus LAMBADA: „Reverse Chain Reasoning' ist die Antwort. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr