Heim >Technologie-Peripheriegeräte >KI >NVIDIA nutzt KI, um GPU-Rechenschaltungen zu entwerfen, die die Fläche im Vergleich zum fortschrittlichsten EDA um 25 % reduzieren und ihn so schneller und effizienter machen

NVIDIA nutzt KI, um GPU-Rechenschaltungen zu entwerfen, die die Fläche im Vergleich zum fortschrittlichsten EDA um 25 % reduzieren und ihn so schneller und effizienter machen

- 王林nach vorne

- 2023-04-12 21:13:072151Durchsuche

Eine riesige Auswahl an Rechenschaltungen treibt NVIDIA-GPUs an, um eine beispiellose Beschleunigung von KI, Hochleistungsrechnen und Computergrafik zu ermöglichen. Daher ist die Verbesserung des Designs dieser Rechenschaltungen von entscheidender Bedeutung für die Verbesserung der GPU-Leistung und -Effizienz. Was wäre, wenn die KI lernen würde, diese Schaltkreise zu entwerfen? In einem aktuellen NVIDIA-Artikel mit dem Titel „PrefixRL: Optimization of Parallel Prefix Circuits using Deep Reinforcement Learning“ haben Forscher gezeigt, dass KI diese Schaltkreise nicht nur von Grund auf entwerfen kann, sondern auch, dass von KI entworfene Schaltkreise besser sind als solche, die von hochmodernen Schaltkreisen entworfen wurden. Modernste EDA-Tools (Electronic Design Automation) sind kleiner und schneller.

Papieradresse: https://arxiv.org/pdf/2205.07000.pdf#🎜 🎜#

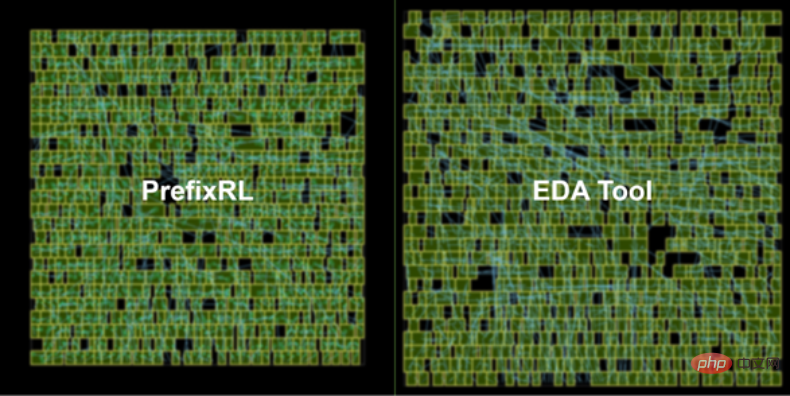

Die neueste NVIDIA Hopper GPU-Architektur verfügt über fast 13.000 von KI entworfene Schaltungsbeispiele. Abbildung 1 unten: Die von PrefixRL AI entworfene 64b-Addiererschaltung auf der linken Seite ist 25 % kleiner als die vom fortschrittlichsten EDA-Tool entworfene Schaltung auf der rechten Seite von Abbildung 1.

Computerchip Arithmetische Schaltkreise in Computern bestehen aus Netzwerken von Logikgattern (wie NAND, NOR und XOR) und Drähten. Ein idealer Schaltkreis sollte die folgenden Eigenschaften haben:

- Klein: kleinere Fläche, mehr Schaltkreise können auf dem Chip untergebracht werden; #Schnell: geringere Latenz, verbesserte Chipleistung;

- geringerer Stromverbrauch.

- In dieser NVIDIA-Studie konzentrierten sich die Forscher auf die Schaltungsfläche und die Latenz. Sie fanden heraus, dass der Stromverbrauch eng mit dem Bereich der interessierenden Schaltung zusammenhängt. Schaltungsfläche und Verzögerung sind oft konkurrierende Eigenschaften, daher ist es wünschenswert, die Pareto-Grenze für einen Entwurf zu finden, der diese Eigenschaften effektiv ausgleicht. Kurz gesagt hoffen die Forscher, dass die Schaltungsfläche für jede Verzögerung minimiert wird.

Deshalb konzentrieren sich Forscher in PrefixRL auf eine beliebte Klasse von Rechenschaltungen – parallele Präfixschaltungen. Verschiedene wichtige Schaltkreise in der GPU, wie Beschleuniger, Inkremente und Encoder, sind Präfixschaltkreise und können auf einer höheren Ebene als Präfixgraphen bezeichnet werden.

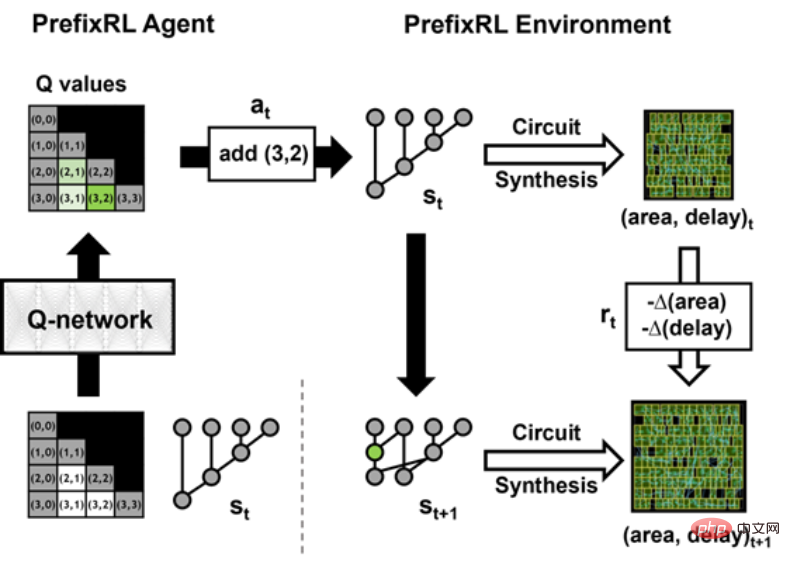

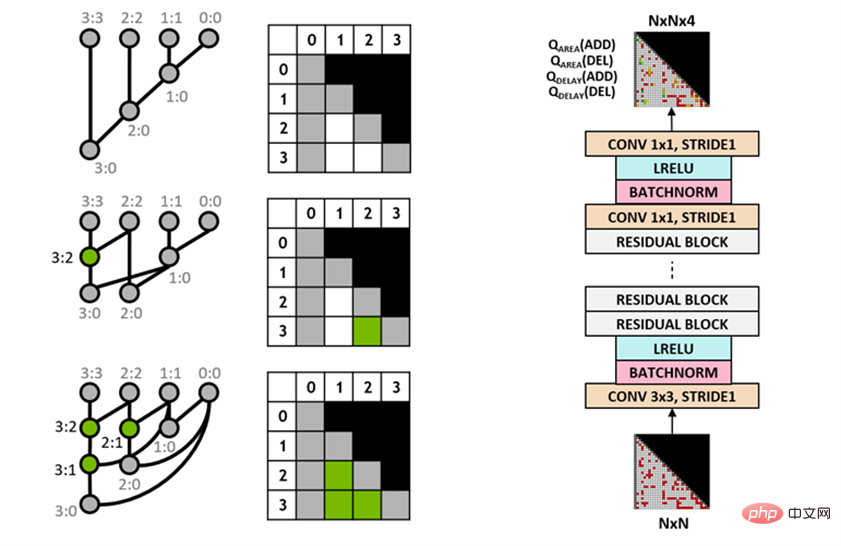

Dann stellt sich die Frage: Können KI-Agenten gute Präfixkarten entwerfen? Der Zustandsraum aller Präfixgraphen ist sehr groß O(2^n^n) und kann nicht mit Brute-Force-Methoden untersucht werden. Abbildung 2 unten zeigt eine Iteration von PrefixRL mit einer 4b-Schaltungsinstanz. Die Forscher verwendeten den Circuit Generator, um das Präfixdiagramm in einen Schaltkreis mit Drähten und Logikgattern umzuwandeln. Als nächstes werden diese generierten Schaltkreise durch ein physikalisches Synthesetool optimiert, das physikalische Syntheseoptimierungen wie Gate-Größe, Duplizierung und Puffereinfügung nutzt.

Aufgrund dieser Optimierungen der physikalischen Synthese werden die endgültigen Schaltungseigenschaften (Verzögerung, Fläche und Leistung) nicht direkt aus den ursprünglichen Eigenschaften des Präfixdiagramms (wie Pegel und) konvertiert Anzahl der Knoten) Komm. Aus diesem Grund lernt der KI-Agent, Präfixdiagramme zu entwerfen, optimiert jedoch die Eigenschaften der endgültigen Schaltung, die aus den Präfixdiagrammen generiert wird.

Arithmetik Schaltungsdesign als Reinforcement Learning (RL)-Aufgabe, bei der ein Agent trainiert wird, #🎜🎜 # zu optimieren Arithmetik Flächen- und Verzögerungseigenschaften von Schaltkreisen. Für die Präfixschaltung haben sie eine Umgebung entworfen, in der der RL-Agent Knoten im Präfixdiagramm hinzufügen oder entfernen und dann die folgenden Schritte ausführen kann: Diagramme werden normalisiert, um stets das korrekte Präfix und die korrekte Berechnung beizubehalten Syntheseoptimierung der Schaltung;

Messen Sie die Fläche und Verzögerungseigenschaften der Schaltung.

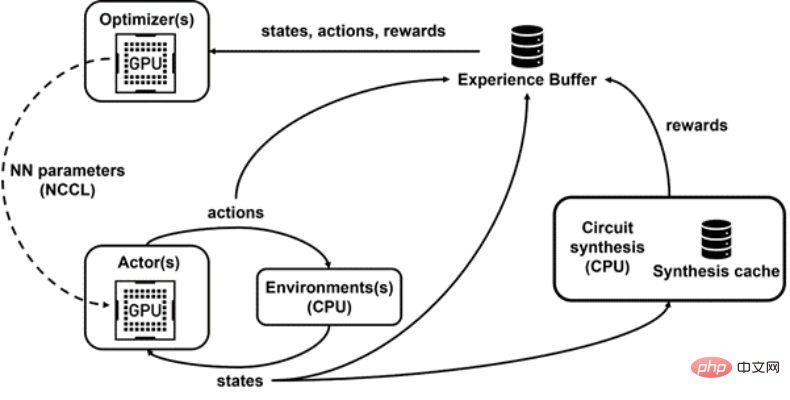

In der folgenden Animation baut der RL-Agent Schritt für Schritt den Präfixgraphen auf, indem er Knoten hinzufügt oder löscht. Bei jedem Schritt wird der Agent mit Verbesserungen bei der Leitungsfläche und der Latenz belohnt. Das Originalbild ist eine interaktive Version. Forscher verwenden Q-Learning-Algorithmus (Q-Learning), um das Design der Agentenschaltung zu trainieren. Wie in Abbildung 3 unten dargestellt, zerlegen sie das Präfixdiagramm in eine Rasterdarstellung, wobei jedes Element im Raster eindeutig einem Präfixknoten zugeordnet ist. Dieses Raster stellt die Ein- und Ausgänge dar, die für das Q-Netzwerk verwendet werden. Jedes Element im Eingaberaster stellt dar, ob der Knoten vorhanden ist oder nicht. Jedes Element im Ausgaberaster stellt den Q-Wert beim Hinzufügen oder Entfernen eines Knotens dar. Abbildung 3: 4b-Präfixdiagrammdarstellung (links) und vollständig faltende Q-Learning-Agentenarchitektur (rechts). PrefixRL ist rechenintensiv, erfordert in einer Physiksimulation 256 CPUs pro GPU und das Training einer 64b-Aufgabe erforderte über 32.000 GPU-Stunden. Dieses Mal hat NVIDIA mit Raptor eine interne verteilte Reinforcement-Learning-Plattform entwickelt, die die Hardwarevorteile von NVIDIA voll ausnutzt, um diese Art von Reinforcement-Learning auf industrieller Ebene durchzuführen (Abbildung 4 unten). Schließlich stellt Raptor GPU-fähige Datenstrukturen wie Wiedergabepuffer mit Multithread-Diensten bereit, um Erfahrungen von mehreren Arbeitern zu empfangen, Daten parallel zu stapeln und sie vorab auf die GPU zu laden. Abbildung 4: Forscher verwenden Raptor, um paralleles Training und Belohnungsberechnung zu entkoppeln, um Verzögerungen bei der Schaltkreissynthese zu überwinden. Die Forscher verwendeten ein Kompromissgewicht w (Bereich [0,1]), um die Flächen- und Verzögerungsziele zu kombinieren. Sie trainieren verschiedene Agenten mit unterschiedlichen Gewichten, um Pareto-Grenzen zu erhalten und so den Kompromiss zwischen Fläche und Latenz auszugleichen. Allerdings ist die Durchführung der physikalischen Synthese ein langsamer Prozess (~35 Sekunden für den 64b-Addierer), der das RL-Training und die Erkundung erheblich verlangsamen kann. Abbildung 5 unten zeigt die Fläche und Verzögerung der 64b-Addiererschaltung, die mit PrefixRL und der Pareto-dominierten Addiererschaltung der fortschrittlichsten EDA-Tools entwickelt wurde. Abbildung 5: Von PrefixRL entworfene Rechenschaltungen sind kleiner und schneller als von hochmodernen EDA-Tools entworfene Schaltungen. (links) Schaltungsarchitektur; (rechts) entsprechendes 64b-Addierer-Schaltkreis-Merkmalsdiagramm Es versteht sich, dass dies die erste Methode ist, bei der Deep Reinforcement Learning-Agenten zum Entwerfen arithmetischer Schaltkreise verwendet werden. NVIDIA stellt sich einen Entwurf für die Anwendung von KI auf reale Schaltungsdesignprobleme, den Aufbau von Aktionsräumen, Zustandsdarstellungen und RL-Agentenmodellen, die Optimierung für mehrere konkurrierende Ziele und die Überwindung langsamer Belohnungsberechnungen vor.

Vollständig faltender Q-Learning-Agent

Die Forscher haben eine vollständig faltende neuronale Netzwerkarchitektur übernommen, da die Eingabe und Ausgabe des Q-Learning-Agenten Gitterdarstellungen sind. Der Agent sagt Q-Werte für die Flächen- und Verzögerungsattribute getrennt voraus, da die Belohnungen für Fläche und Verzögerung während des Trainings separat beobachtbar sind.

Raptor für verteiltes Training

Raptor kann die Skalierbarkeit und Trainingsgeschwindigkeit von Trainingsmodellen verbessern, z. B. Jobplanung, benutzerdefinierte Netzwerke und GPU-fähige Datenstrukturen. Im Kontext von PrefixRL ermöglicht Raptor die hybride Zuweisung zwischen CPUs, GPUs und Spot-Instances. Die Netzwerke in dieser Reinforcement-Learning-Anwendung sind vielfältig und profitieren von Folgendem:

Abbildung 4 unten zeigt, dass das PrefixRL-Framework gleichzeitiges Training und Datenerfassung unterstützt und NCCL nutzt, um die neuesten Parameter effizient an die Teilnehmer (Akteure in der Abbildung unten) zu senden.

Belohnungsberechnung

Physisch synthetisierte Optimierung in einer RL-Umgebung kann verschiedene Lösungen generieren, die einen Kompromiss zwischen Fläche und Latenz eingehen. Forscher steuern physikalische Synthesewerkzeuge unter Verwendung der gleichen Kompromissgewichte, die auch zum Trainieren spezifischer Agenten verwendet werden.

Die Durchführung der physikalischen Syntheseoptimierung in der Schleife der Belohnungsberechnung hat die folgenden Vorteile:

Forscher entkoppeln die Belohnungsberechnung von Statusaktualisierungen, da der Agent nur den aktuellen Status des Präfixdiagramms benötigt, um Maßnahmen zu ergreifen, ohne Schaltkreissynthese oder vorherige Belohnungen. Dank Raptor können sie langwierige Belohnungsberechnungen auf einen Pool von CPU-Workern verlagern, um parallel physikalische Synthesen durchzuführen, während Akteuragenten die Ausführung in der Umgebung ohne Wartezeiten durchführen können.

Wenn der CPU-Worker die Belohnung zurückgibt, kann die Transformation in den Wiedergabepuffer eingebettet werden. Umfassende Belohnungen werden zwischengespeichert, um redundante Berechnungen zu vermeiden, wenn ein Zustand erneut auftritt. Ergebnisse und Ausblick

Die besten PrefixRL-Addierer erreichen bei gleicher Latenz 25 % weniger Fläche als EDA-Tool-Addierer. Diese Präfixgraphen, die nach der Optimierung der physikalischen Synthese auf Pareto-optimale Addiererschaltungen abgebildet werden, weisen unregelmäßige Strukturen auf.

Das obige ist der detaillierte Inhalt vonNVIDIA nutzt KI, um GPU-Rechenschaltungen zu entwerfen, die die Fläche im Vergleich zum fortschrittlichsten EDA um 25 % reduzieren und ihn so schneller und effizienter machen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr