Heim >Technologie-Peripheriegeräte >KI >Wer hat die einflussreichste KI-Forschung veröffentlicht? Google liegt weit vorne, die Erfolgskonversionsrate von OpenAI übertrifft DeepMind

Wer hat die einflussreichste KI-Forschung veröffentlicht? Google liegt weit vorne, die Erfolgskonversionsrate von OpenAI übertrifft DeepMind

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 20:55:011096Durchsuche

Wer veröffentlicht die wirkungsvollste KI-Forschung? In der heutigen Zeit, in der man „hundert Blumen blühen lässt“, bietet dieses Thema ein großes Forschungspotenzial.

Sie haben vielleicht einige Schlussfolgerungen erraten: Top-Institutionen wie Google, Microsoft, OpenAI und DeepMind haben mit Schlussfolgerungen wie dieser nur halb Recht. Es gibt auch andere Informationen, die uns Schlussfolgerungen offenbaren, die ursprünglich unbekannt waren.

Angesichts der rasanten Entwicklung der KI-Innovation ist es entscheidend, so schnell wie möglich an „Intelligenz“ zu gelangen. Schließlich haben nur wenige Menschen die Zeit, alles zu lesen, aber sicher ist, dass die in diesem Artikel zusammengestellten Artikel das Potenzial haben, die Richtung der Technologie der künstlichen Intelligenz zu ändern.

Der eigentliche Test für den Einfluss des F&E-Teams ist natürlich, wie die Technologie Ende November 2022 in Produkten implementiert wird, was die gesamte Branche schockiert „Human Feedback“ Ein weiterer Durchbruch nach „Training von Sprachmodellen, um Anweisungen mit menschlichem Feedback zu befolgen“.

Es kommt selten vor, dass ein Produkt so schnell auf den Markt kommt. Um Einblick in weitere Informationen zu gewinnen, haben die Statistiken von Zeta Alpha daher kürzlich einen klassischen akademischen Indikator eingeführt: Citation Count.

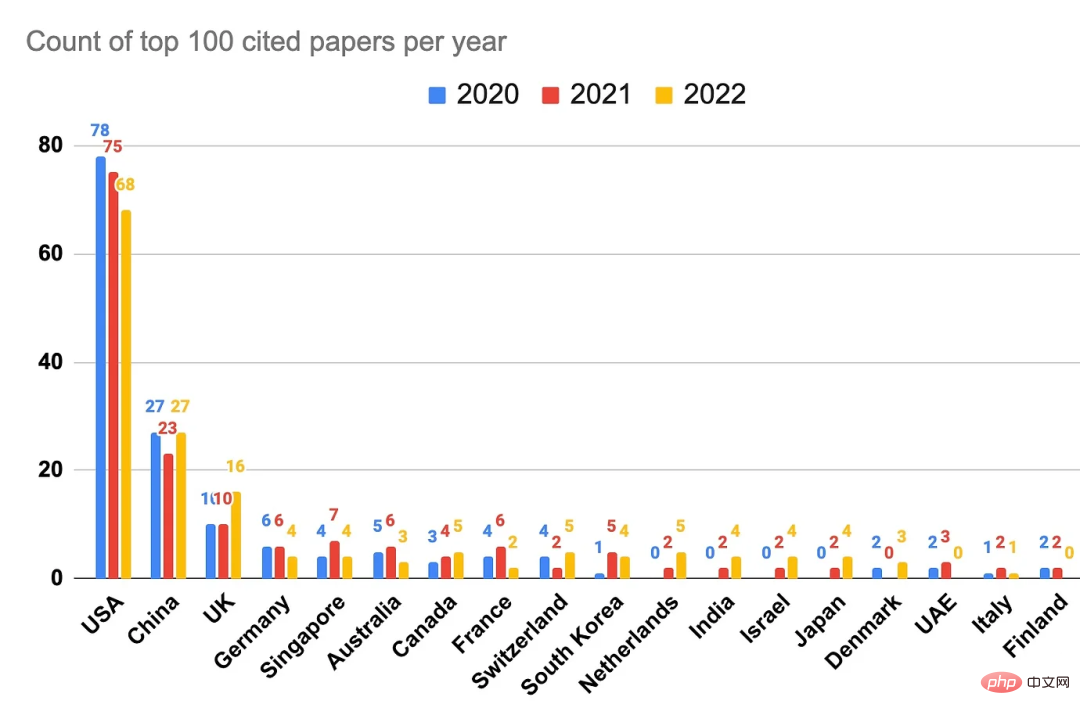

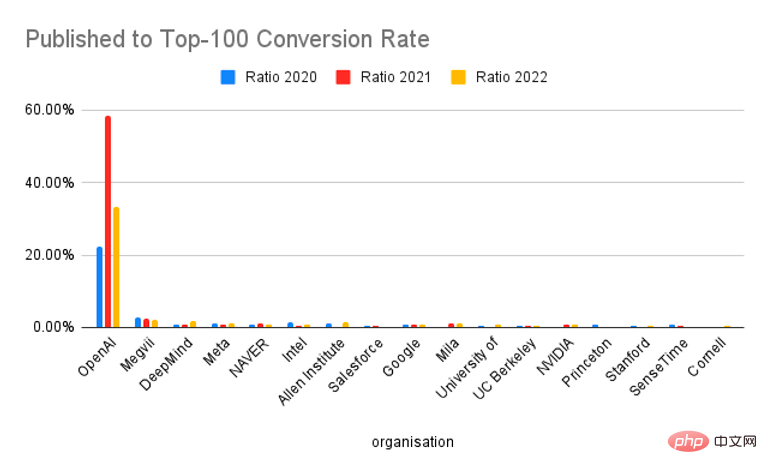

Eine detaillierte Analyse der 100 am häufigsten zitierten Arbeiten in den Jahren 2022, 2021 und 2020 bietet Einblicke in die Institutionen und Länder, die derzeit die einflussreichste KI-Forschung veröffentlichen. Einige vorläufige Schlussfolgerungen lauten: Die Vereinigten Staaten und Google dominieren immer noch, und DeepMind hatte ebenfalls ein großartiges Jahr, aber angesichts der Ergebnisse ist OpenAI in Bezug auf Produktwirkung und Forschung wirklich an der Spitze und kann schnell und umfassend übernommen werden.

Quelle: Zeta Alpha.

Wie in der Abbildung oben gezeigt, ist eine weitere wichtige Schlussfolgerung, dass China hinsichtlich des Einflusses bei Forschungszitaten an zweiter Stelle steht, aber im Vergleich zu den Vereinigten Staaten immer noch ein Abstand besteht und nicht so „gleichauf“ ist wie beschrieben in vielen Berichten sogar darüber hinaus.“

Anhand von Daten der Zeta Alpha-Plattform und anschließender Kombination mit manueller Kuratierung sammelt dieser Artikel die am häufigsten zitierten Artikel im Bereich der künstlichen Intelligenz in den Jahren 2022, 2021 und 2020 und analysiert die Zugehörigkeit der Autoren und Länder/Regionen . Dies ermöglicht eine Einstufung dieser Arbeiten nach F&E-Auswirkungen und nicht nach reinen Veröffentlichungsdaten.

Um die Analyse zu erstellen, haben wir zunächst die am häufigsten zitierten Artikel für jedes Jahr auf der Zeta Alpha-Plattform gesammelt und dann manuell das Datum der ersten Veröffentlichung (normalerweise ein arXiv-Preprint) überprüft, um den Artikel im richtigen Jahr zu platzieren. Diese Liste wurde dann durch die Suche nach häufig zitierten KI-Artikeln auf Semantic Scholar ergänzt, das eine breitere Abdeckung bietet und die Möglichkeit bietet, nach der Anzahl der Zitate zu sortieren. Dies deckt in erster Linie Artikel von externen Verlagen wie Nature, Elsevier, Springer und anderen Zeitschriften auf. Anschließend wurde die Anzahl der Zitate für jeden Aufsatz bei Google Scholar als repräsentative Kennzahl verwendet und die Aufsätze nach dieser Zahl sortiert, um zu den Top 100 des Jahres zu gelangen. Für diese Arbeiten haben wir GPT-3 verwendet, um Autoren, Zugehörigkeiten und Länder zu extrahieren und diese Ergebnisse manuell überprüft (wenn das Land in der Veröffentlichung nicht offensichtlich war, wurde das Land verwendet, in dem die Organisation ihren Hauptsitz hatte). Wenn eine Arbeit Autoren aus mehreren Institutionen hat, wird jede Institution einmal gezählt.

Nach der Lektüre dieses Rankings zeigte sich Chef Yann LeCun sehr zufrieden: „Bei Meta AI neigen wir dazu, Qualität statt Quantität zu veröffentlichen. Aus diesem Grund ist Meta AI unter den 100 am häufigsten zitierten Artikeln über künstliche Intelligenz im Jahr 2022 verfasst.“ (oder Co-Autor) 16 Artikel, die nur auf dem zweiten Platz hinter den 22 Artikeln von Google liegen (außerdem ist das Ranking der New York University auch sehr gut). Was sind die Top-Papiere, über die wir gerade gesprochen haben?

Bevor wir uns mit den Zahlen befassen, werfen wir einen Blick auf die Top-Papiere der letzten drei Jahre. Ich bin mir sicher, dass Sie einige davon wiedererkennen werden.

2022 Hot Papers

1. AlphaFold Protein Structure Database: Erweitert die strukturelle Abdeckung des Proteinsequenzraums massiv mit hoher -Genauigkeitsmodelle

- Papierlink: https://academic.oup.com/nar/article/50/D1/ D439 /6430488

- Institution: DeepMind

- Anzahl der Zitate: 1372#🎜. 🎜#

- Thema: Verwendung von AlphaFold zur Erweiterung der für alle zugänglichen Proteinstrukturdatenbank

Papierlink: https://www.nature.com/articles/s41592-022-01488-1

Anzahl der Zitate: 1162- #🎜 🎜#Thema: Ein Open-Source- und effizientes Proteinfaltungsmodell.#🎜 🎜#

- 3、Hierarchische textbedingte Bildgenerierung mit CLIP-Latenten

- Papierlink: https://arxiv.org/abs/2204.06125

#🎜 🎜## 🎜🎜#Anzahl der Zitate: 718

Thema: DALL・E 2, komplex gesteuerte Bilderzeugung, die die meisten in Erstaunen versetzte#🎜🎜 ##🎜🎜 #- 4、Ein ConvNet für die 2020er Jahre Link: https://arxiv.org/abs/2201.03545

- # 🎜🎜#Institution: Meta, UC Berkeley

- #🎜🎜 #Anzahl der Zitate: 690

- Thema: Eine erfolgreiche Modernisierung von CNNs in einer Zeit des Booms für Transformers in Computer Vision

5, PaLM: Scaling Language Modeling with Pathways

- Papierlink: https://arxiv.org/abs/2204.02311#🎜🎜 # Institution: Google

- Anzahl der Zitate: 452# 🎜🎜#

- Thema: Googles Mammut 540B Großes Sprachmodell, eine neue MLOps-Infrastruktur und wie sie funktioniert #1, „Hochpräzise Proteinstrukturvorhersage mit AlphaFold“

- #🎜🎜 # Papierlink: https://www.nature.com/ Articles/s41586-021-03819-2

Institution: DeepMind

- Anzahl der Zitate: 8965# 🎜🎜#

- Thema: AlphaFold, ein Durchbruch in der Proteinstrukturvorhersage mithilfe von Deep Learning # 🎜🎜#

- #🎜 🎜#2. 《Swin Transformer: Hierarchischer Vision Transformer mit verschobenen Fenstern》

- # 🎜🎜# Papierlink: https://arxiv.org /abs/2103.14030

- Institution: Microsoft

#🎜 🎜#

Anzahl der Zitate: 4810# 🎜 🎜#Thema: Eine robuste Variante von Transformers for Vision

#🎜🎜 #- 3, „Lernen übertragbarer visueller Modelle.“ From Natural Language Supervision“

- Papierlink: https://arxiv.org/abs/2103.00020 #🎜🎜 #

- Institution: OpenAI

- Anzahl der Zitate: 3204#🎜 🎜#

#🎜 🎜#4.《Ein die Gefahren stochastischer Papageien: Können Sprachmodelle zu groß sein?》

-

- Papierlink: https://dl.acm.org/doi/10.1145/3442188.3445922

- Institution: U. Washington, Black in AI, The Aether

- Anzahl der Zitate: 1266

- Thema: Berühmtes Positionspapier, das den Trend ständig wachsender Sprachmodelle sehr kritisch betrachtet und deren Grenzen und Gefahren hervorhebt.

5 https://arxiv.org/pdf/2104.14294.pdf

- Institution: Meta

- Zitate: 1219

- Betreff: DINO, zeigt, wie die Selbstüberwachung von Bildern zur Entstehung einer Art von Meta führte Proto-Objekt-Segmentierung in Transformers

- Hot Papers im Jahr 2020

- 1, „An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale“

Link zum Papier: https://arxiv „Sprachmodelle sind Few-Shot-Lernende》

- Papierlink: https://arxiv.org/abs/2005.14165

- Institution: OpenAI

- Anzahl der Zitate: 8070

- Thema: Dieses Papier bedarf zum jetzigen Zeitpunkt keiner weiteren Erläuterung

Institution: Academia Sinica, TaiwanAnzahl der Zitate: 8014

- Thema: Robuste und schnelle Objekterkennung verkauft sich wie warme Semmeln

- 4. „Erkundung der Grenzen des Transferlernens mit einem einheitlichen Text-zu-Text-Transformer“

- Anzahl der Zitate: 5906

- Thema: Eine gründliche Studie zum Transferlernen mit Transformers, die zum berühmten T5 führte

5、《Bootstrap your own latent: Ein neuer Ansatz für selbstüberwachtes Lernen 》

- Link zum Beitrag: https://arxiv.org/abs/2006.07733 Institution: DeepMind, Imperial College

- Werfen wir einen Blick darauf, wie einige der führenden Institutionen in Bezug auf die Anzahl der eingereichten Beiträge abschneiden die Top 100:

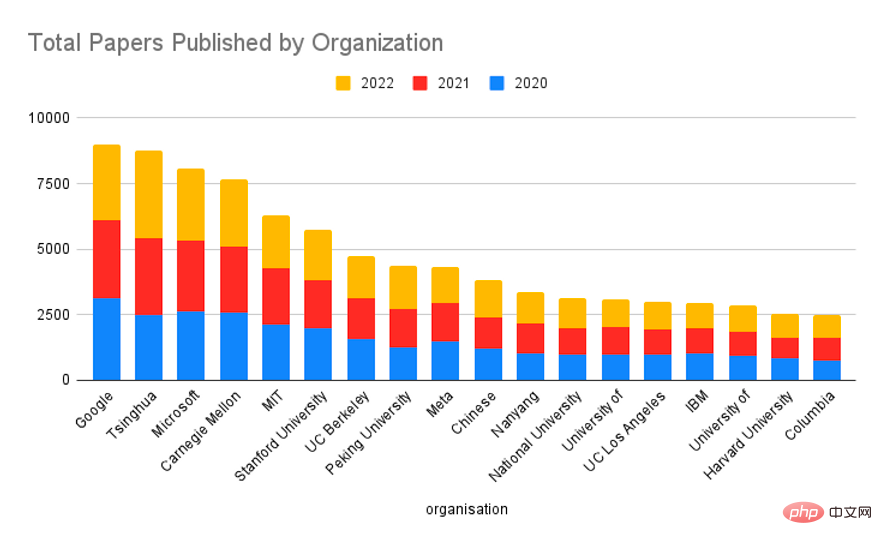

- Google war der stärkste Player, gefolgt von Meta, Microsoft, California Berkeley, DeepMind und Stanford

. Während die Industrie heute die dominierende Kraft in der KI-Forschung ist, wird eine einzelne akademische Institution keinen so großen Einfluss haben, aber der Schwanz dieser Institutionen ist viel länger, sodass wir bei der Aggregation nach Organisationstyp ein Gleichgewicht erreichen.

-

In Bezug auf das gesamte Forschungsvolumen belegte Google in den letzten drei Jahren den ersten Platz, die Tsinghua University, die Carnegie Mellon University, das MIT, die Stanford University und andere Universitäten rangierten weit oben, während Microsoft den dritten Platz belegte. Insgesamt produzieren akademische Einrichtungen mehr Forschung als Technologieunternehmen der Branche und auch die beiden Technologieriesen Google und Microsoft haben in den letzten drei Jahren eine hohe Anzahl an Studien veröffentlicht.

Tatsächlich war Googles wissenschaftliche Forschungsstärke schon immer sehr stark. Im Jahr 2017 veröffentlichte Google das Papier „Attention Is All You Need“ und markierte damit das Aufkommen von Transformer. Bis heute sind Transformer die architektonische Grundlage der meisten NLP- und CV-Modelle, einschließlich ChatGPT.

Letzten Monat, anlässlich der Veröffentlichung von Bard, erklärte auch Google-CEO Sundar Pichai in einem offenen Brief: „Google AI und DeepMind fördern die Entwicklung modernster Technologie. Unser Transformer-Forschungsprojekt und Unser Artikel aus dem Jahr 2017 sowie unsere wichtigen Fortschritte bei Diffusionsmodellen bilden die Grundlage für viele aktuelle generative KI-Anwendungen. Als Unternehmen hinter dem neuen Top-ChatGPT ist die Konvertierungsrate von OpenAI in den letzten drei Jahren natürlich hoch (Konvertierung). Rate) hat einen absoluten Vorteil. In den letzten Jahren haben die meisten Forschungsergebnisse von OpenAI große Aufmerksamkeit erregt, insbesondere bei groß angelegten Sprachmodellen.

Im Jahr 2020 veröffentlichte OpenAI GPT-3, ein groß angelegtes Sprachmodell mit 175 Milliarden Parametern, das die Spielregeln im Bereich der Sprachmodelle gewissermaßen unterwandert, weil es viele löste Probleme mit groß angelegten Sprachmodellen in. GPT-3 löste eine Begeisterung für groß angelegte Sprachmodelle aus. Seit mehreren Jahren wird die Parameterskala von Sprachmodellen kontinuierlich durchbrochen, und die Menschen erforschen immer mehr Potenziale groß angelegter Sprachmodelle.

Im Jahr 2020 veröffentlichte OpenAI GPT-3, ein groß angelegtes Sprachmodell mit 175 Milliarden Parametern, das die Spielregeln im Bereich der Sprachmodelle gewissermaßen unterwandert, weil es viele löste Probleme mit groß angelegten Sprachmodellen in. GPT-3 löste eine Begeisterung für groß angelegte Sprachmodelle aus. Seit mehreren Jahren wird die Parameterskala von Sprachmodellen kontinuierlich durchbrochen, und die Menschen erforschen immer mehr Potenziale groß angelegter Sprachmodelle. Ende 2022 kam ChatGPT heraus, das große Aufmerksamkeit auf Textgenerierung und KI-Dialogsysteme lenkte. Insbesondere hat ChatGPT sehr hohe Fähigkeiten bei der Generierung wissensbasierter Inhalte und der Generierung von Code gezeigt. Nachdem Google und Microsoft nacheinander die Integration von ChatGPT-ähnlichen Funktionen in die Suchmaschine der nächsten Generation angekündigt haben, geht man davon aus, dass ChatGPT eine neue Revolution im Bereich AIGC und intelligenter Tools anführen wird.

Abschließend werfen wir einen Blick auf die 100 am häufigsten zitierten Artikel im Jahr 2022: Empfehlungen hier besondere Anzahl der Erwähnungen, die manchmal berücksichtigt werden ein Frühindikator für die Wirkung. Bisher scheint die Korrelation jedoch schwach zu sein. Weitere Arbeiten sind erforderlich.

Das obige ist der detaillierte Inhalt vonWer hat die einflussreichste KI-Forschung veröffentlicht? Google liegt weit vorne, die Erfolgskonversionsrate von OpenAI übertrifft DeepMind. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr

Im Jahr 2020 veröffentlichte OpenAI GPT-3, ein groß angelegtes Sprachmodell mit 175 Milliarden Parametern, das die Spielregeln im Bereich der Sprachmodelle gewissermaßen unterwandert, weil es viele löste Probleme mit groß angelegten Sprachmodellen in. GPT-3 löste eine Begeisterung für groß angelegte Sprachmodelle aus. Seit mehreren Jahren wird die Parameterskala von Sprachmodellen kontinuierlich durchbrochen, und die Menschen erforschen immer mehr Potenziale groß angelegter Sprachmodelle.

Im Jahr 2020 veröffentlichte OpenAI GPT-3, ein groß angelegtes Sprachmodell mit 175 Milliarden Parametern, das die Spielregeln im Bereich der Sprachmodelle gewissermaßen unterwandert, weil es viele löste Probleme mit groß angelegten Sprachmodellen in. GPT-3 löste eine Begeisterung für groß angelegte Sprachmodelle aus. Seit mehreren Jahren wird die Parameterskala von Sprachmodellen kontinuierlich durchbrochen, und die Menschen erforschen immer mehr Potenziale groß angelegter Sprachmodelle.