Heim >Technologie-Peripheriegeräte >KI >Meta führt das MoDem-Weltmodell ein: Lösung dreier großer Herausforderungen im visuellen Bereich, weitergeleitet von LeCun

Meta führt das MoDem-Weltmodell ein: Lösung dreier großer Herausforderungen im visuellen Bereich, weitergeleitet von LeCun

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 20:22:011595Durchsuche

Am 27. Dezember ist MetaAI für A

im Bereich Vision und Reinforcement Learning verantwortlich. Am Abend des 27. hat die Anzahl der Lesevorgänge dieses Tweets 73,9.000 erreicht.

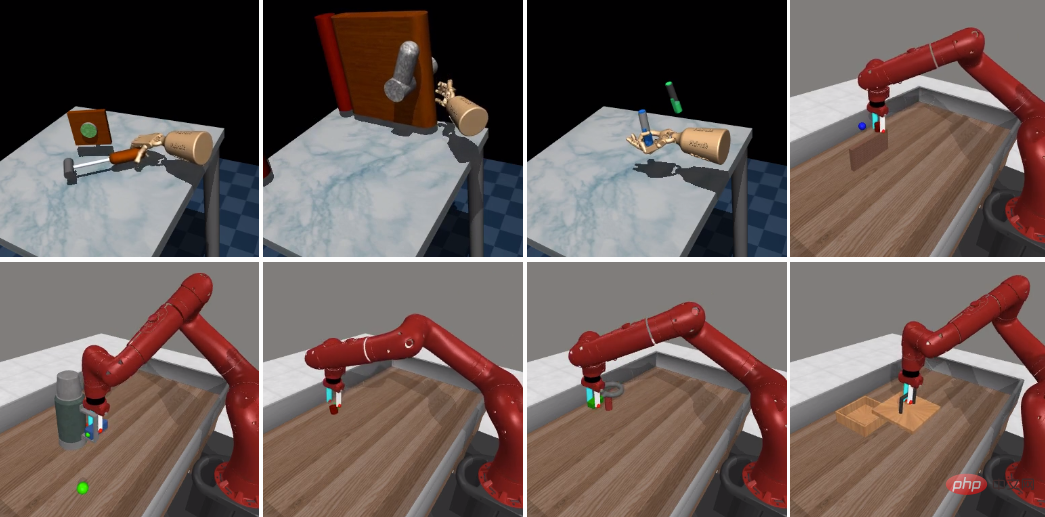

Er sagte, dass MoDem mit nur 5 Demonstrationen herausfordernde visuelle Bewegungssteuerungsaufgaben mit spärlichen Belohnungen und hochdimensionalen Aktionsräumen in 100.000 Interaktionsschritten lösen kann und damit bestehende Methoden weit übertrifft .

Wie gut ist es?

Sie fanden heraus, dass die Erfolgsquote von MoDem bei der Erledigung von Aufgaben mit geringer Belohnung 150 %–250 % höher war als bei früheren Methoden in Regimen mit wenig Daten.

Lecun leitete diese Forschung ebenfalls weiter und sagte, dass die Modellarchitektur von MoDem der von JEPA ähnelt und Vorhersagen im Darstellungsraum treffen kann, ohne dass ein Decoder erforderlich ist.

Der Herausgeber hat den Link unten gesetzt, interessierte Freunde können einen Blick darauf werfen~

Papierlink: https://arxiv.org/abs/2212.05698

.Github-Link: https://github.com/facebookresearch/modem.

Modellbasiertes RL hat das Potenzial, eine hohe Stichprobeneffizienz zu erreichen, indem gleichzeitig ein Weltmodell erlernt und der synthetische Einsatz für Planung und Richtlinienverbesserungen verwendet wird.

In der Praxis wird das effiziente Lernen von Proben in modellbasierter RL jedoch durch Explorationsherausforderungen behindert. Diese Forschung löst genau diese Hauptherausforderungen.

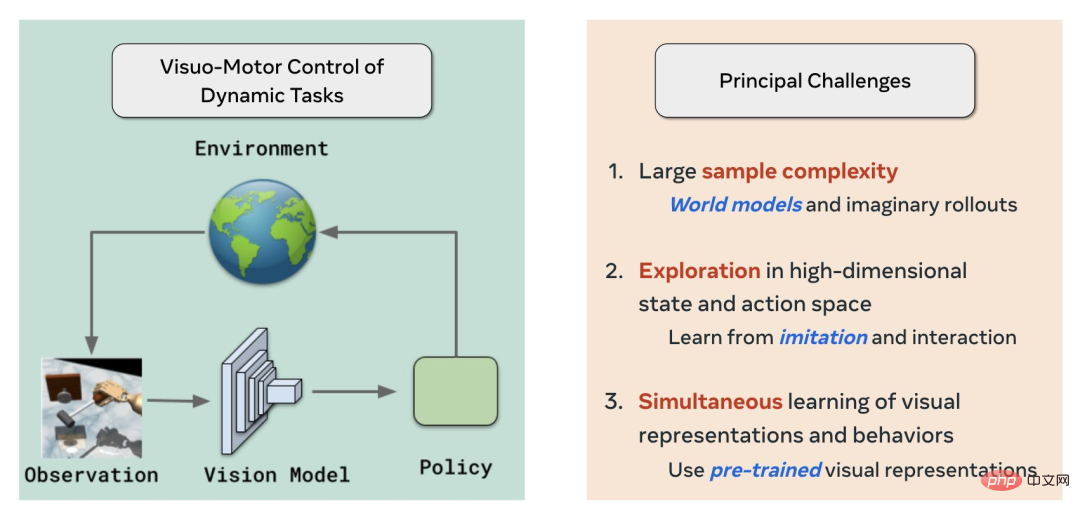

Zunächst löst MoDem drei Hauptherausforderungen im Bereich des visuellen Verstärkungslernens/-kontrolle durch die Verwendung von Weltmodell, Nachahmung + RL bzw. selbstüberwachtem visuellem Vortraining:

Große Stichprobenkomplexität)

Erkundung im hochdimensionalen Zustands- und Aktionsraum

- Simultanes Lernen visueller Darstellungen und Verhaltensweisen

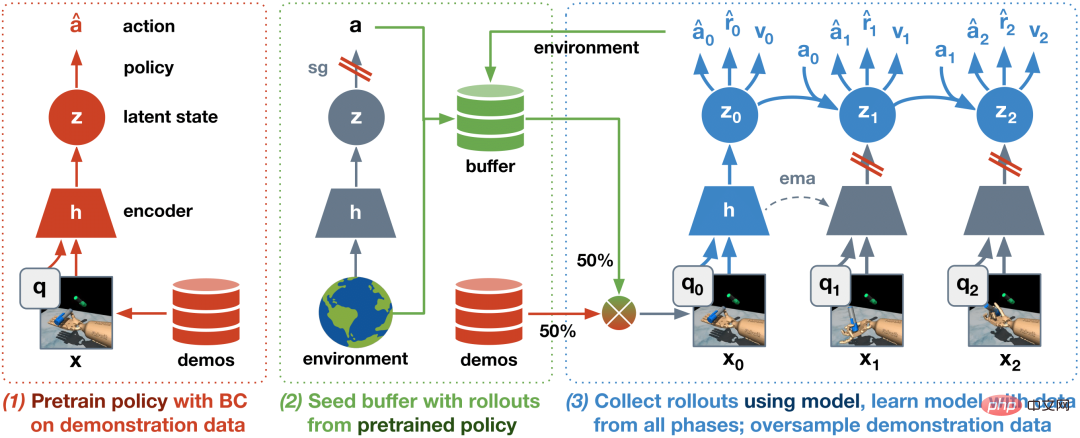

- Diesmal ähnelt die Modellarchitektur der JEPA von Yann LeCun und erfordert keinen Decoder.

Aravind Rajeswaran, der Autor, sagte, dass im Vergleich zu Dreamer, das einen Decoder für die Vorhersage auf Pixelebene erfordert und über eine umfangreiche Architektur verfügt, die decoderlose Architektur das direkte Einfügen von mit SSL vorab trainierten visuellen Darstellungen unterstützen kann.

Aravind Rajeswaran, der Autor, sagte, dass im Vergleich zu Dreamer, das einen Decoder für die Vorhersage auf Pixelebene erfordert und über eine umfangreiche Architektur verfügt, die decoderlose Architektur das direkte Einfügen von mit SSL vorab trainierten visuellen Darstellungen unterstützen kann.

Darüber hinaus schlugen sie basierend auf IL+RL einen dreistufigen Algorithmus vor:

- BC-Vortrainingsstrategie

- Vorabtraining des Weltmodells mithilfe eines Seed-Datensatzes mit Demonstrationen und Erkundungen. Diese Phase ist wichtig für die allgemeine Stabilität und Effizienz

- Feinabstimmung des Weltmodells durch Online-Interaktion

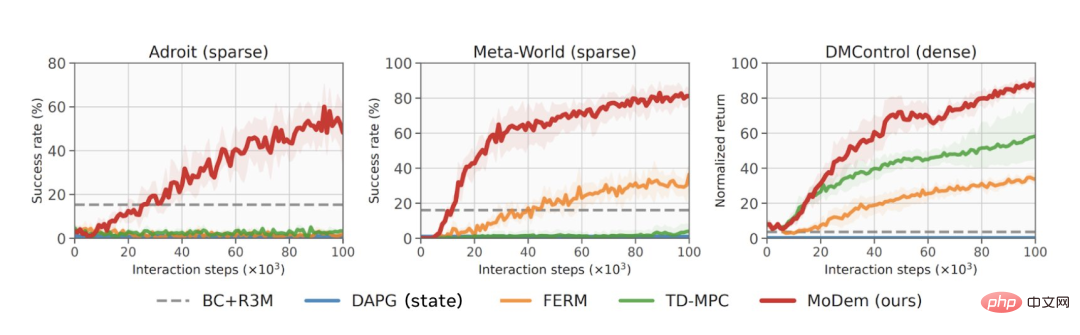

Die Ergebnisse zeigen, dass der generierte Algorithmus SOTA-Ergebnisse (State-Of-The-Art-Ergebnis) in 21 schwierigen visuellen Bewegungssteuerungsaufgaben erzielte, darunter Adroit Dexterous Operation, MetaWorld und DeepMind Control Suites.

Aus Datensicht schneidet MoDem bei verschiedenen Aufgaben weitaus besser ab als andere Modelle, und die Ergebnisse sind 150 bis 250 % höher als bei der vorherigen SOTA-Methode. Die roten Linien zeigen die Leistung von MoDem bei verschiedenen Aufgaben an Nutzen vorab trainierter visueller Darstellungen.

Schließlich ist die Verwendung der eingefrorenen R3M-Funktionalität dem direkten E2E-Ansatz weit überlegen. Das ist spannend und zeigt, dass visuelles Vortraining aus Videos Weltmodelle unterstützen kann.

Schließlich ist die Verwendung der eingefrorenen R3M-Funktionalität dem direkten E2E-Ansatz weit überlegen. Das ist spannend und zeigt, dass visuelles Vortraining aus Videos Weltmodelle unterstützen kann.

Aber der E2E mit starken Daten im August konkurriert mit dem eingefrorenen R3M, das können wir mit Vortraining besser machen.

Das obige ist der detaillierte Inhalt vonMeta führt das MoDem-Weltmodell ein: Lösung dreier großer Herausforderungen im visuellen Bereich, weitergeleitet von LeCun. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr