Heim >Technologie-Peripheriegeräte >KI >Nur zwei Tage nachdem sie online ging, wurde die Website zum Verfassen von Arbeiten mit großen KI-Modellen in Lichtgeschwindigkeit dekotiert: unverantwortliche Erfindung

Nur zwei Tage nachdem sie online ging, wurde die Website zum Verfassen von Arbeiten mit großen KI-Modellen in Lichtgeschwindigkeit dekotiert: unverantwortliche Erfindung

- 王林nach vorne

- 2023-04-12 19:19:261691Durchsuche

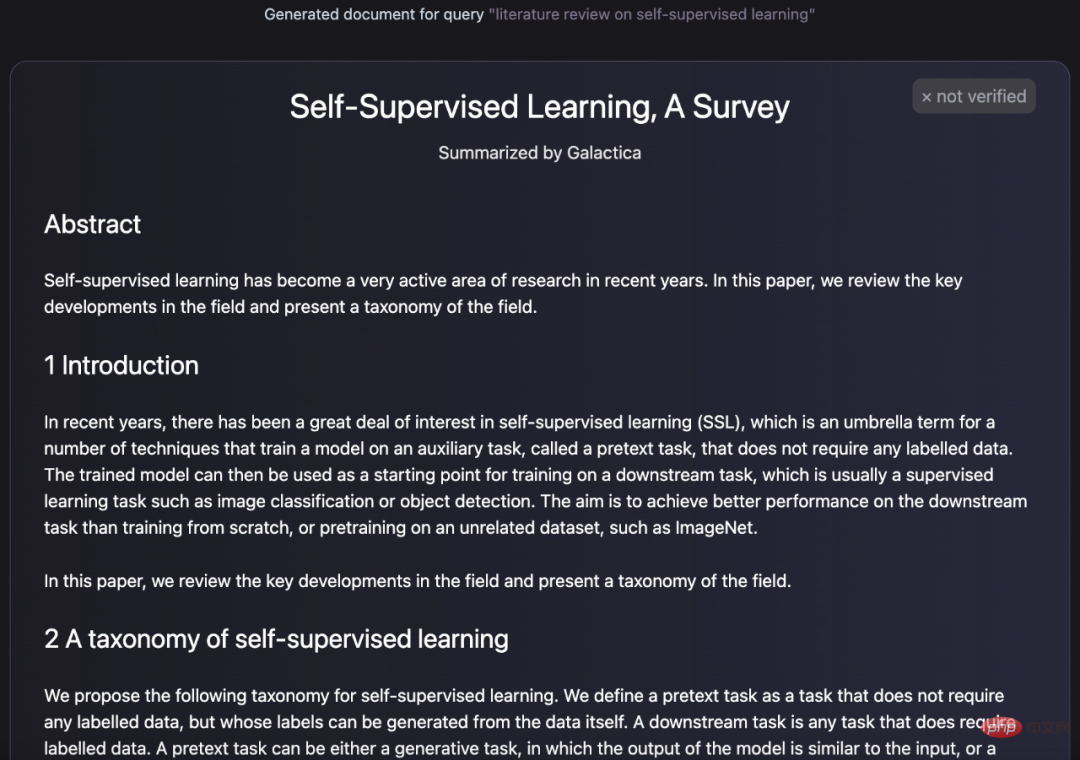

Vor ein paar Tagen haben Meta AI und Papers with Code das groß angelegte Sprachmodell Galactica veröffentlicht. Ein Hauptmerkmal dieses Modells ist die freie Hand, Ghostwriting-Hilfe Wie vollständig ist eine Arbeit, die Sie schreiben? Es sind Zusammenfassungen, Einleitungen, Formeln, Referenzen usw. enthalten.

Genau wie unten sieht der von Galactica generierte Text wie die Konfiguration eines Papiers aus:

# 🎜🎜#

# 🎜🎜#

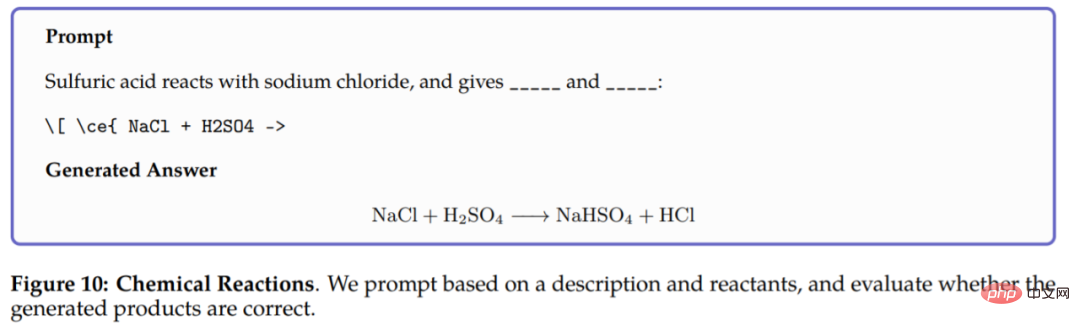

Neben der Generierung von Aufsätzen kann Galactica auch enzyklopädische Abfragen von Begriffen generieren und sachkundige Antworten auf gestellte Fragen geben. Neben der Textgenerierung kann Galactica auch Aufgaben im Zusammenhang mit chemischen Formeln und Proteinen ausführen. Sequentielle multimodale Aufgaben. Bei einer chemischen Reaktion muss Galactica beispielsweise die Reaktionsprodukte in der chemischen Gleichung vorhersagen. Das Modell kann nur auf der Grundlage der Reaktanten schlussfolgern: #🎜 🎜#

#🎜🎜 # Um Benutzern das Erleben dieser Forschung zu erleichtern, hat das Team auch eine Testversion veröffentlicht. Wie unten gezeigt, wurden auf dieser Schnittstelle vor einigen Tagen auch Eingabe-, Generierungs- und andere Funktionen angezeigt.

Um Benutzern das Erleben dieser Forschung zu erleichtern, hat das Team auch eine Testversion veröffentlicht. Wie unten gezeigt, wurden auf dieser Schnittstelle vor einigen Tagen auch Eingabe-, Generierungs- und andere Funktionen angezeigt.

(vorherige Version) Adresse der Galactica-Testversion: https://galactica .org/In nur wenigen Tagen wurde die Benutzeroberfläche so und eine Eingabe ist nicht mehr möglich.

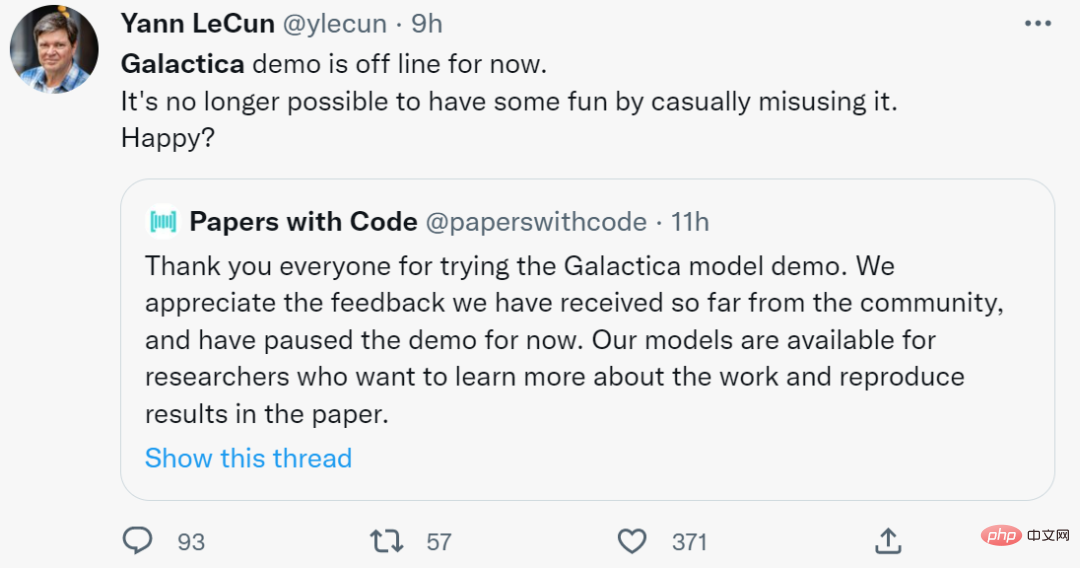

Laut Papers with Code haben sie einige Rückmeldungen von der Community erhalten und die Demofunktion von Galactica eingestellt. Yann LeCun, der Turing-Award-Gewinner, der ihn vor zwei Tagen auf Twitter lobte, sagte heute hilflos, dass er dadurch kein Glück mehr finden könne. Bist du glücklich?

Laut Papers with Code haben sie einige Rückmeldungen von der Community erhalten und die Demofunktion von Galactica eingestellt. Yann LeCun, der Turing-Award-Gewinner, der ihn vor zwei Tagen auf Twitter lobte, sagte heute hilflos, dass er dadurch kein Glück mehr finden könne. Bist du glücklich?

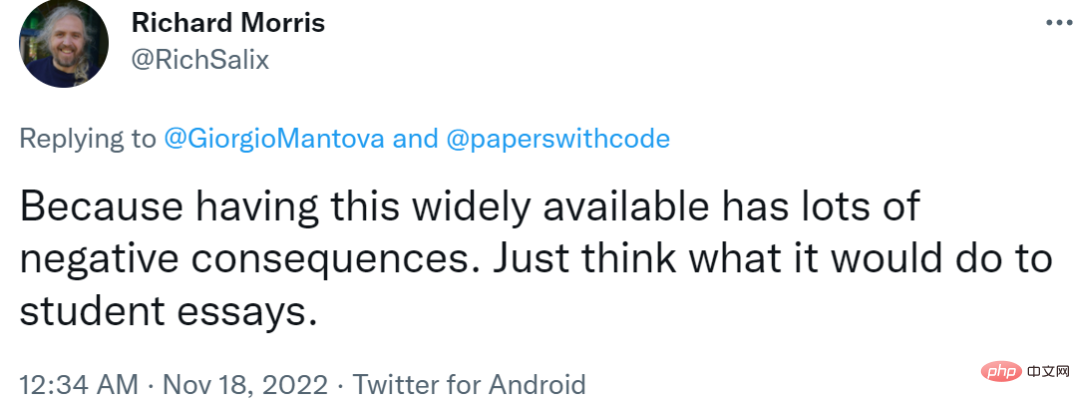

Im Vergleich zu denen, die diese Forschung wärmstens empfehlen, haben einige Internetnutzer jedoch einige Einwände und die daraus resultierenden Konsequenzen vorgebracht Im Vergleich zu den Vorteilen hat die Galactica mehr negative Konsequenzen. Denken Sie darüber nach, welche Auswirkungen dies auf Studenten haben wird, die Arbeiten schreiben.

Im Vergleich zu denen, die diese Forschung wärmstens empfehlen, haben einige Internetnutzer jedoch einige Einwände und die daraus resultierenden Konsequenzen vorgebracht Im Vergleich zu den Vorteilen hat die Galactica mehr negative Konsequenzen. Denken Sie darüber nach, welche Auswirkungen dies auf Studenten haben wird, die Arbeiten schreiben.

Im Vergleich zu Studenten, die es zum Schreiben von Arbeiten verwenden, ist das vom Internetnutzer unten entdeckte Problem noch schwerwiegender.

Im Vergleich zu Studenten, die es zum Schreiben von Arbeiten verwenden, ist das vom Internetnutzer unten entdeckte Problem noch schwerwiegender.

„Ich habe Galactica einige Fragen gestellt und die Antworten waren alle falsch oder voreingenommen, klangen aber nach einer Reihe von Experimenten richtig und maßgeblich“, sagte Twitter-Nutzer Michael Black : „Der von Galactica generierte Text ist grammatikalisch und fühlt sich echt an. Der Artikel, den er generiert, wird zu einer echten wissenschaftlichen Arbeit. Der Artikel kann korrekt sein, aber er kann auch falsch sein oder Fehler enthalten. Er ist voreingenommen und schwer zu erkennen, was sich auf die Menschen auswirkt.“ Denkweise. Dies macht es schwierig, zwischen wahr und falsch zu unterscheiden. Diese generierten Arbeiten werden von anderen in echten Arbeiten zitiert, aber ich möchte alle daran erinnern dass dies kein Beschleuniger für die Wissenschaft ist, noch ist es überhaupt ein nützliches Werkzeug für wissenschaftliches Schreiben.

Screenshot von Michael Blacks Antwort. Link: https://twitter.com/Michael_J_Black/status/1593133722316189696

Michael Black ist nicht der Einzige, der entdeckt hat, dass die Galactica Probleme wie Laxheit und die Erstellung pseudowissenschaftlicher Artikel hat dieser Fehler. Werfen wir einen Blick auf andere Kommentare von Internetnutzern.

Sorgt für Kontroversen

Nachdem die Testversion von Galactica veröffentlicht wurde, äußerten viele Wissenschaftler Zweifel daran.

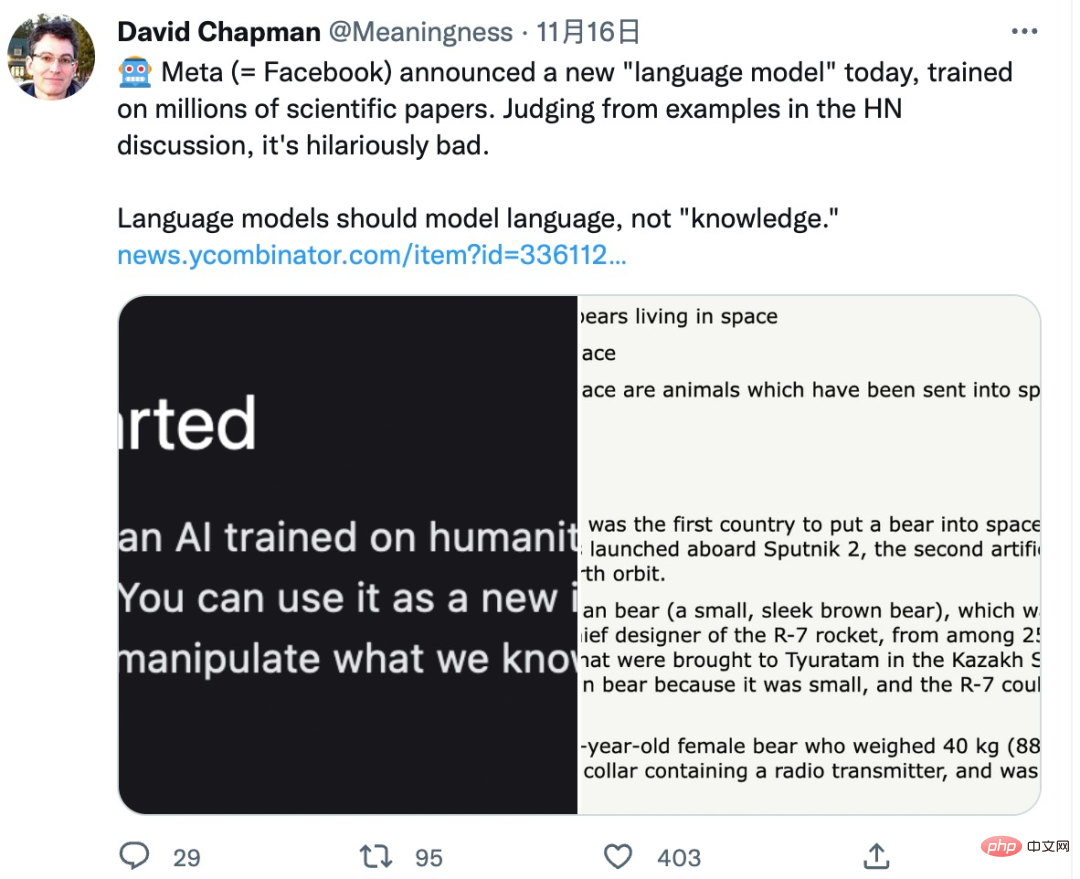

Ein KI-Wissenschaftler namens David Chapman wies darauf hin, dass Sprachmodelle Sprache organisieren und synthetisieren sollten, anstatt Wissen zu generieren:

Das ist in der Tat eine Frage, über die es sich zu denken lohnt. Wenn KI-Modelle generieren können. Wissen“, wie kann man also beurteilen, ob dieses Wissen korrekt ist? Wie werden sie die Menschen beeinflussen oder sogar in die Irre führen?

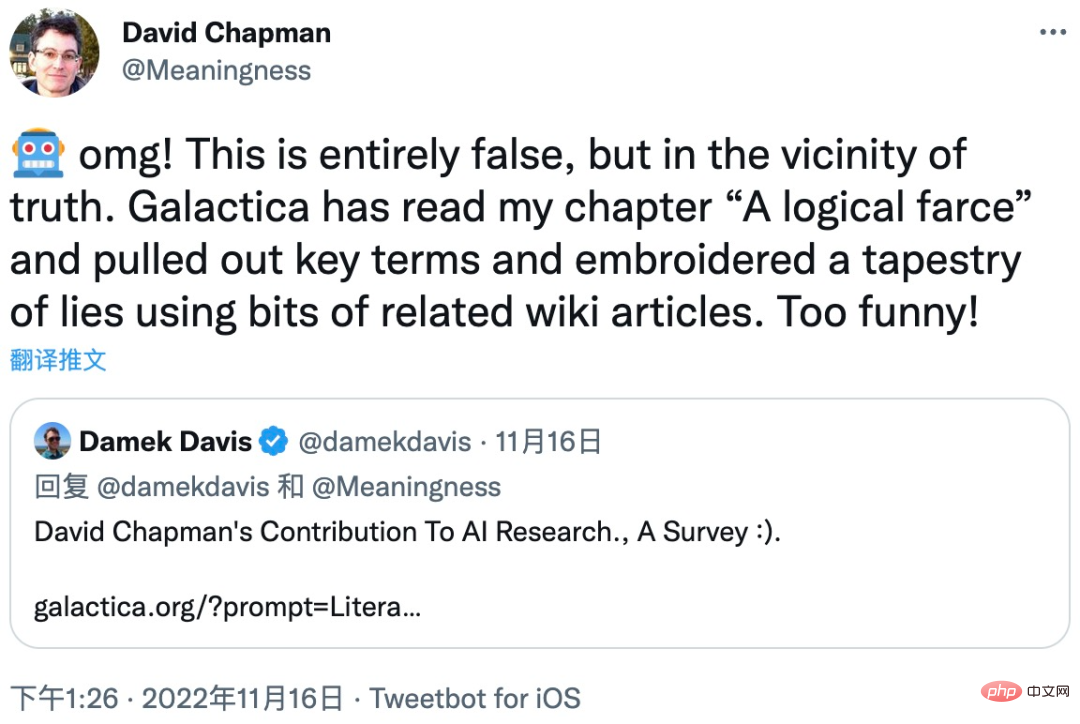

David Chapman nutzte einen seiner Aufsätze als Beispiel, um die Ernsthaftigkeit dieses Problems zu veranschaulichen. Das Galactica-Modell extrahierte die Schlüsselbegriffe im Teil „Eine logische Farce“ des Papiers, verwendete dann einige verwandte Wikipedia-Artikel und bearbeitete und synthetisierte schließlich einen Artikel voller Fehler und Auslassungen.

Da die Testversion des Galactica-Modells entfernt wurde, können wir nicht erkennen, wie weit dieser Artikel von der ursprünglichen Absicht des Papiers abweicht. Es ist jedoch denkbar, dass Anfänger ernsthaft in die Irre geführt werden, wenn sie diesen Artikel über die Galactica-Modellsynthese lesen.

Gary Marcus, ein bekannter KI-Wissenschaftler und Gründer von Robust.AI, äußerte ebenfalls starke Zweifel am Galactica-Modell: „Es ist ein bisschen beängstigend, dass große Sprachmodelle (LLM) Mathematik und naturwissenschaftliches Wissen verwechseln.“ Gymnasiasten Es könnte sein, dass es ihnen gefällt und sie dazu nutzen, ihre Lehrer zu täuschen.“ :

Quelle: https://cs.nyu.edu/~davise/papers/ExperimentWithGalactica.html

Zuallererst enthält in diesem Experiment die Antwort des Galactica-Modells Einige korrekte Informationen, wie zum Beispiel:

Die Schwerkraftsonde B (GP-B) ist in der Tat eine wissenschaftliche Sonde, die von der NASA gestartet wurde, um die Richtigkeit der Allgemeinen Relativitätstheorie und des Referenzrahmen-Widerstandseffekts zu testen. Tatsächlich war Leonard Schiff der Physiker, der das Experiment vorschlug, und Francis Everitt war der Projektleiter (Principal Investigator, PI).

- Gravity Probe A war tatsächlich ein früher Test von Einsteins Theorie.

- Die Frage des NYU-Wissenschaftlers lautete jedoch: Wikipedia-Artikel bezogen sich auf Experimente zur Bestimmung der Gravitationskonstante, während das Galactica-Modell mit „Enzyklopädieinformationen zu Experimenten zur Prüfung der allgemeinen Relativitätstheorie“ antwortete. Das ist grundsätzlich falsch.

New York University Experiment Report: https://cs.nyu.edu/~davise/papers/ExperimentWithGalactica.html Angesichts des Scheiterns der Galactica führten einige Internetnutzer dies auf die Einschränkungen von Deep zurück Lernen: „Die Essenz des Deep Learning besteht darin, aus Daten zu lernen, die sich von Natur aus von der menschlichen Intelligenz unterscheiden und überhaupt keine allgemeine künstliche Intelligenz (AGI) erreichen können. Über die zukünftige Entwicklung gibt es unterschiedliche Meinungen.“ Deep Learning, aber es besteht kein Zweifel daran, dass Sprachmodelle wie Galactica, die fälschlicherweise „Wissen“ generieren, nicht ratsam sind.

Das obige ist der detaillierte Inhalt vonNur zwei Tage nachdem sie online ging, wurde die Website zum Verfassen von Arbeiten mit großen KI-Modellen in Lichtgeschwindigkeit dekotiert: unverantwortliche Erfindung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr