Heim >Technologie-Peripheriegeräte >KI >Die Anzahl der Parameter beträgt 1/50, Meta veröffentlicht ein 11-Milliarden-Parametermodell und besiegt damit Google PaLM

Die Anzahl der Parameter beträgt 1/50, Meta veröffentlicht ein 11-Milliarden-Parametermodell und besiegt damit Google PaLM

- 王林nach vorne

- 2023-04-12 18:10:031219Durchsuche

Wir können große Sprachmodelle (LLMs) als Lernende mit kleinen Stichproben verstehen, die mit wenigen Beispielen oder sogar mit einfachen Anweisungen neue Aufgaben erlernen können, wobei das Modell die Anzahl der Parameter und die Größe skaliert Die Trainingsdaten sind der Schlüssel zur Generalisierungsfähigkeit des Modells. Diese Verbesserung bei LLMs ist auf größere Rechenleistung und Speicherkapazitäten zurückzuführen. Intuitiv führen verbesserte Inferenzfähigkeiten zu einer besseren Generalisierung und damit zu weniger Stichprobenlernen. Es ist jedoch unklar, inwieweit effektives Lernen kleiner Stichproben umfassende Kenntnisse der Modellparameter erfordert.

Bisher haben Retrieval-Enhancement-Modelle keine überzeugenden Lernfähigkeiten für kleine Stichproben gezeigt. In der Arbeit fragen Forscher von Meta AI Research und anderen Institutionen, ob das Lernen in kleinen Stichproben erfordert, dass das Modell eine große Menge an Informationen in seinen Parametern speichert, und ob die Speicherung von der Generalisierung entkoppelt werden kann. Sie schlugen Atlas vor, eine Art abrufgestütztes Sprachmodell, das über starke Lernfähigkeiten für kleine Stichproben verfügt, auch wenn die Anzahl der Parameter geringer ist als bei anderen aktuellen leistungsstarken Lernmodellen für kleine Stichproben.

Das Modell verwendet nichtparametrische Speicherung, das heißt, es werden neuronale Retriever verwendet, die auf großen externen nichtstatischen Wissensquellen basieren, um das parametrische Sprachmodell zu verbessern. Zusätzlich zu den Speicherfähigkeiten sind solche Architekturen aufgrund ihrer Vorteile in Bezug auf Anpassungsfähigkeit, Interpretierbarkeit und Effizienz attraktiv.

Papieradresse: https://arxiv.org /pdf/2208.03299.pdf

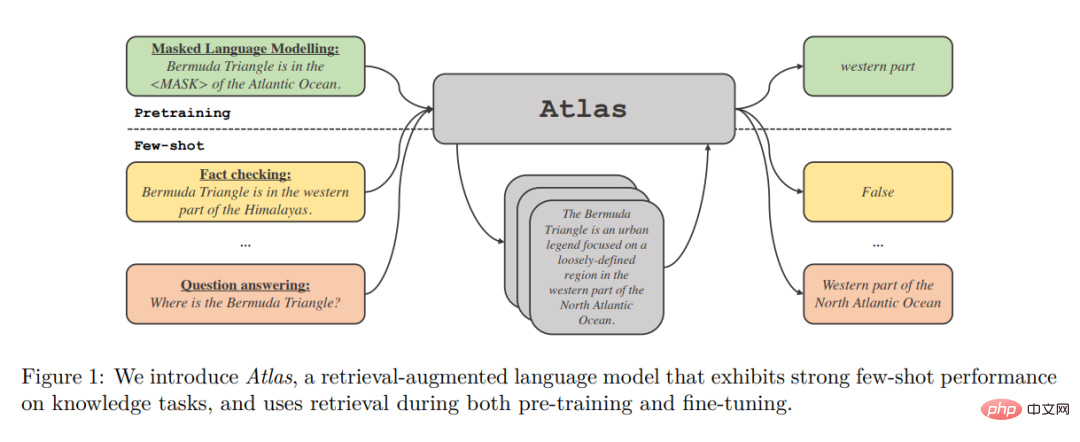

Atlas Retrieval of Related Documents ist ein universeller Dichte-Retriever, der auf der Contriever-Dual-Encoder-Architektur beim Abrufen von Dateien basiert Es basiert auf dem aktuellen Kontext, um verwandte Dokumente abzurufen. Die abgerufenen Dokumente werden zusammen mit dem aktuellen Kontext von einem Sequenz-zu-Sequenz-Modell verarbeitet, das die Fusion-in-Decoder-Architektur verwendet, um die entsprechende Ausgabe zu generieren.

Die Autoren untersuchten die Auswirkungen verschiedener Techniken auf die Leistung des Trainingsatlas an einem kleinen Beispieldatensatz für eine Reihe nachgelagerter Aufgaben, einschließlich der Beantwortung von Fragen und der Überprüfung von Fakten. Die Studie ergab, dass die gemeinsame Vortrainingskomponente für die Leistung bei kleinen Stichproben von entscheidender Bedeutung ist, und die Autoren bewerteten viele bestehende und neuartige Vortrainingsaufgaben und -schemata. Atlas weist sowohl in Umgebungen mit kleinen Stichproben als auch in ressourcenreichen Umgebungen eine starke nachgelagerte Leistung auf.

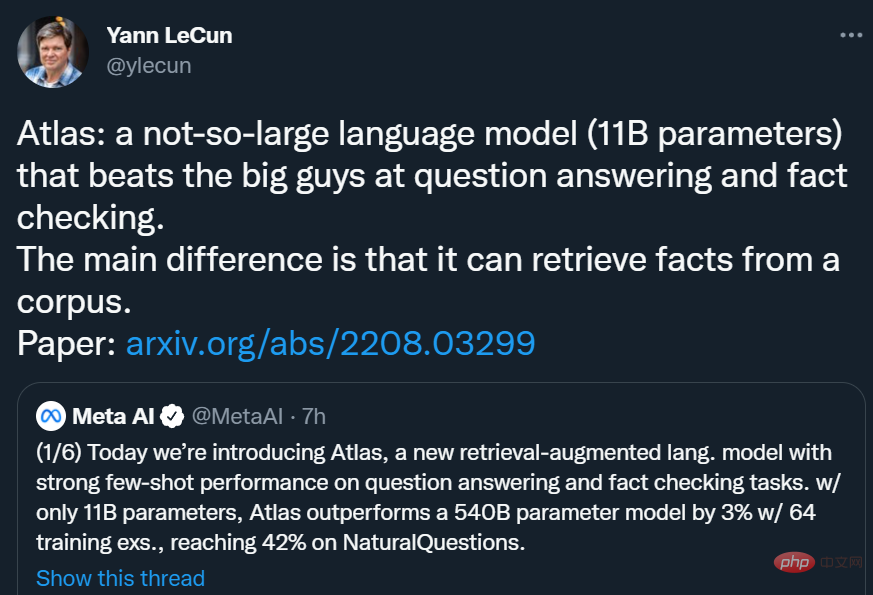

Mit nur 11B Parametern erreichte Atlas bei NaturalQuestions (NQ) unter Verwendung von 64 Trainingsbeispielen eine Genauigkeit von 42,4 %, was besser ist als das 540B-Parametermodell PaLM (39,6 %). fast 3 Prozentpunkte höher und erreicht eine Genauigkeit von 64,0 % in der Einstellung „Vollständiger Datensatz“.

Yann LeCun sagte: Atlas ist ein nicht allzu großes Sprachmodell ( 11B-Parameter), die „Großen“ bei Fragen und Antworten und Faktenchecks schlagen. Der Hauptunterschied von Atlas besteht darin, dass es Fakten aus einem Korpus abrufen kann.

Methodenübersicht

Atlas Folgen Sie dem Text zum Textrahmen. Das bedeutet, dass der allgemeine Rahmen aller Aufgaben so ist: Das System nimmt eine Textabfrage als Eingabe und generiert eine Textausgabe. Bei Frage-Antwort-Aufgaben entspricht beispielsweise die Anfrage einer Frage und das Modell muss eine Antwort generieren. Bei Klassifikationsaufgaben entspricht die Abfrage einer Texteingabe und das Modell generiert Klassenlabels, also die den Labels entsprechenden Wörter. Der KILT-Benchmark in Abbildung 2 enthält weitere Beispiele für nachgelagerte Aufgaben. Viele Aufgaben zur Verarbeitung natürlicher Sprache erfordern Kenntnisse, und Atlas zielt darauf ab, Standard-Text-zu-Text-Modelle durch Retrieval zu verbessern, da Retrieval für die Lernfähigkeit des Modells in Szenarien mit kleinen Stichproben von entscheidender Bedeutung sein kann. Das Atlas-Modell basiert auf zwei Untermodellen: Retriever- und Sprachmodellen. Bei der Ausführung einer Aufgabe, von der Beantwortung von Fragen bis zur Generierung von Wikipedia-Artikeln, ruft das Modell zunächst über einen Retriever die k relevantesten Dokumente aus einem großen Textkorpus ab. Diese Dokumente werden dann zusammen mit der Abfrage als Eingabe an das Sprachmodell übergeben, das eine Ausgabe generiert. Sowohl der Retriever als auch das Sprachmodell basieren auf vorab trainierten Transformatornetzwerken, die im Folgenden ausführlich beschrieben werden.

Abruf: Das Retriever-Modul von Atlas basiert auf Contriever, einer Informationsabruftechnologie, die auf kontinuierlicher Dichteeinbettung basiert. Contriever verwendet eine Dual-Encoder-Architektur, bei der Abfragen und Dokumente unabhängig voneinander durch Transformer-Encoder eingebettet werden. Auf die Ausgabe der letzten Ebene wird ein durchschnittliches Pooling angewendet, um eine Vektordarstellung jeder Abfrage oder jedes Dokuments zu erhalten. Durch die Berechnung des Skalarprodukts der gegenseitigen Einbettungen zwischen der Abfrage und jedem Dokument werden dann deren Ähnlichkeitswerte ermittelt. Das Contriever-Modell wird mithilfe des MoCo-Kontrastverlusts vorab trainiert und verwendet nur unbeaufsichtigte Daten. Einer der Vorteile von Density Retrievern besteht darin, dass sowohl Abfrage- als auch Dokumentencoder ohne Dokumentanmerkungen mithilfe von Standardtechniken wie Gradientenabstieg und Destillation trainiert werden können.

Sprachmodell: Als Sprachmodell verlässt sich Atlas auf die T5-Sequenz-zu-Sequenz-Architektur. Das Modell basiert außerdem auf Fusion-in-Decoder-Modifikationen des Sequenz-zu-Sequenz-Modells und verarbeitet jedes Dokument unabhängig im Encoder. Das Modell verkettet dann die Ausgaben der Encoder, die verschiedenen Dokumenten entsprechen, und führt eine Queraufmerksamkeit auf eine einzelne Sequenz im Decoder durch. Das Modell verbindet die Abfrage mit jedem Dokument im Encoder. Eine andere Möglichkeit, abgerufene Dokumente in einem Sprachmodell zu verarbeiten, besteht darin, die Abfrage und alle Dokumente zu verketten und diese lange Sequenz als Eingabe für das Modell zu verwenden. Diese Methode ist jedoch weniger skalierbar, das heißt, sie skaliert nicht mit zunehmender Anzahl von Dokumenten, da der Selbstaufmerksamkeitsmechanismus im Encoder zu einer Zeitkomplexität von O(n^2) führt (wobei n die Anzahl von Dokumenten ist). Dokumente).

Experimentelle Ergebnisse

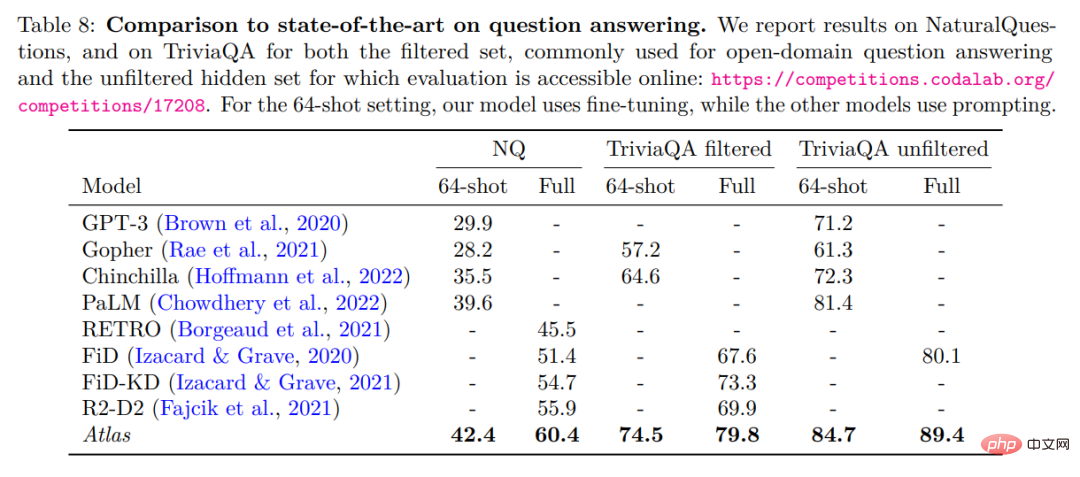

Die Autoren bewerten Atlas anhand von zwei Open-Domain-Fragen-Antwort-Benchmarks, NaturalQuestions und TriviaQA. Zum Vergleich mit früheren Arbeiten wurde ein kleiner Beispieldatensatz von 64 Beispielen und ein vollständiger Trainingssatz verwendet. Der detaillierte Vergleich ist in der folgenden Tabelle dargestellt.

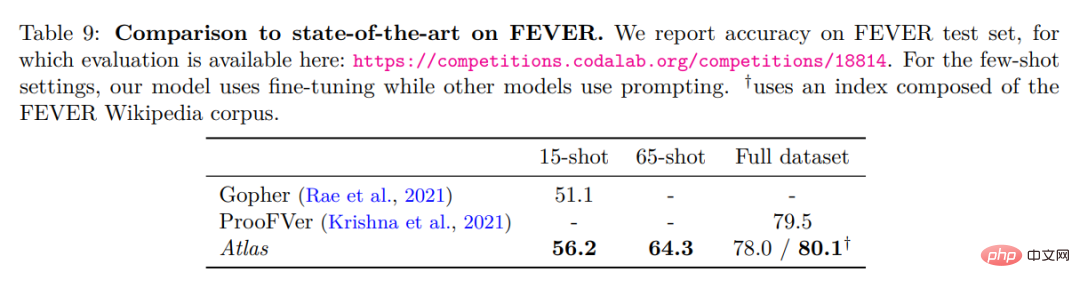

Beste Leistung bei 64-Schuss-Fragen und -Antworten von NaturalQuestions und TriviaQA. Insbesondere übertrifft es größere Modelle (PaLM) oder Modelle, die mehr Trainingsberechnungen erfordern (Chinchilla). Atlas kann auch bei Verwendung des gesamten Trainingssatzes optimale Ergebnisse erzielen, beispielsweise die Erhöhung der Genauigkeit von NaturalQuestions von 55,9 % auf 60,4 %. Dieses Ergebnis wurde unter den Standardeinstellungen von Atlas unter Verwendung eines Index bestehend aus CCNet und dem Wikipedia-Korpus vom Dezember 2021 ermittelt. Die folgende Tabelle zeigt die Testergebnisse zum Faktencheck-Datensatz FEVER.

Atlas Im 64-Schuss-Fall werden die Trainingsproben aus dem vollständigen Trainingssatz entnommen. Atlas erreichte eine Genauigkeit von 64,3 %. Im 15-Schuss-Fall werden 5 Proben gleichmäßig aus jeder Klasse entnommen. Im Vergleich zu den Gopher-Ergebnissen beträgt die Atlas-Genauigkeit 56,2 %, was 5,1 Prozentpunkte höher ist als bei Gopher. Das Atlas-Modell wurde auf den gesamten Trainingssatz abgestimmt und erreichte eine Genauigkeit von 78 %, was 1,5 % weniger als ProoFVer ist. ProoFVer verwendet eine spezielle Architektur, um Retriever mit Annotationen auf Satzebene zu trainieren und wird vom mit FEVER veröffentlichten Wikipedia-Korpus bereitgestellt, während Atlas aus CCNet und dem Wikipedia-Dump vom Dezember 2021 abruft. Bei einem Index, der aus dem FEVER-Wikipedia-Korpus besteht, erreichte Atlas einen optimalen Wert von 80,1 %.

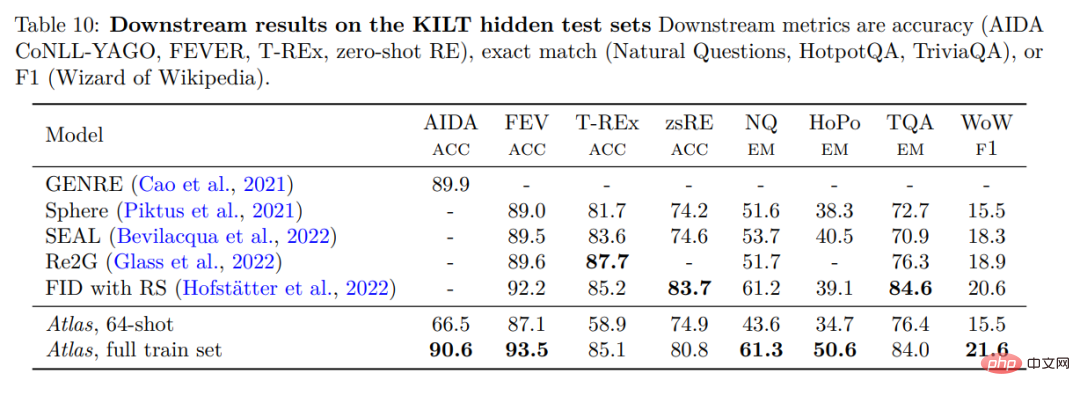

Um die Leistung von Atlas zu überprüfen, wurde Atlas anhand von KILT bewertet, einem Benchmark, der aus mehreren verschiedenen wissensintensiven Aufgaben besteht. Die folgende Tabelle zeigt die Ergebnisse des Testsatzes.

Atlas 64-shot übertrifft Zufallsalgorithmen in Experimenten bei weitem und liegt sogar auf Augenhöhe mit einigen fein abgestimmten Modellen auf der Bestenliste. Beispielsweise liegt Atlas 64-Schuss bei FEVER nur 2-2,5 Punkte hinter Sphere, SEAL und Re2G, während es bei Zero-Shot RE Sphere und SEAL übertrifft. Im gesamten Datensatz liegt die Leistung von Atlas in drei Datensätzen innerhalb von 3 % des besten Modells, in den verbleibenden fünf Datensätzen ist sie jedoch die beste.

Das obige ist der detaillierte Inhalt vonDie Anzahl der Parameter beträgt 1/50, Meta veröffentlicht ein 11-Milliarden-Parametermodell und besiegt damit Google PaLM. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr