Heim >Technologie-Peripheriegeräte >KI >Einheitliche visuelle KI-Funktionen! Automatisierte Bilderkennung und -segmentierung sowie kontrollierbare vinzentinische Bilder, erstellt von einem chinesischen Team

Einheitliche visuelle KI-Funktionen! Automatisierte Bilderkennung und -segmentierung sowie kontrollierbare vinzentinische Bilder, erstellt von einem chinesischen Team

- 王林nach vorne

- 2023-04-12 17:31:171171Durchsuche

Dieser Artikel wird mit Genehmigung von AI New Media Qubit (öffentliche Konto-ID: QbitAI) nachgedruckt. Bitte wenden Sie sich für einen Nachdruck an die Quelle.

Jetzt ist es wirklich an der Zeit, im KI-Kreis mit der Handgeschwindigkeit zu konkurrieren.

Nein, Metas SAM wurde erst vor ein paar Tagen auf den Markt gebracht und einheimische Programmierer sind gekommen, um die Verbesserungen zu überlagern und Zielerkennung, Segmentierung und Generierung wichtiger visueller KI-Funktionen in einem zu integrieren!

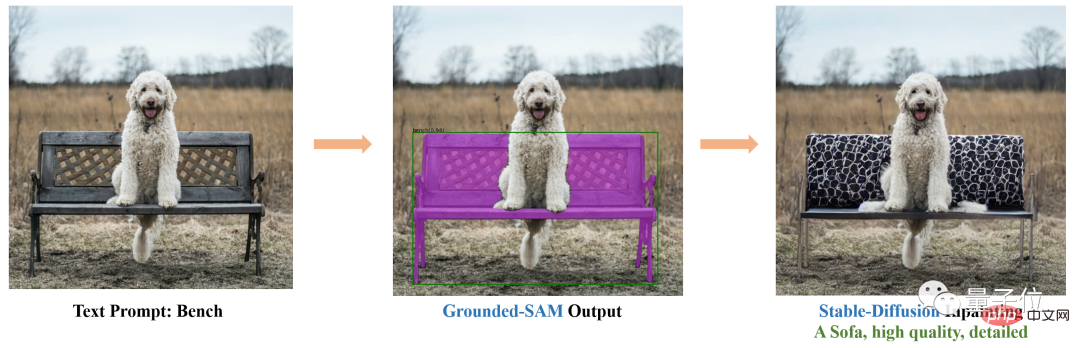

Zum Beispiel können Sie basierend auf Stable Diffusion und SAM den Stuhl auf dem Foto nahtlos durch ein Sofa ersetzen:

Auch das Ändern von Kleidung und Haarfarbe ist so einfach:

Sobald das Projekt abgeschlossen ist veröffentlicht wurde, riefen viele Leute aus: Die Handgeschwindigkeit ist zu hoch!

Jemand anderes sagte: Es gibt neue Hochzeitsfotos von Yui Aragaki und mir.

Das Obige ist der Effekt von Gounded-SAM. Das Projekt hat 1,8.000 Sterne auf GitHub erhalten.

Einfach ausgedrückt handelt es sich um eine Zero-Shot-Vision-Anwendung, die nur Bilder eingeben muss, um Bilder automatisch zu erkennen und zu segmentieren.

Diese Forschung stammt vom IDEA Research Institute (Guangdong-Hong Kong-Macao Greater Bay Area Digital Economy Research Institute), dessen Gründer und Vorsitzender Shen Xiangyang ist.

Keine zusätzliche Schulung erforderlich

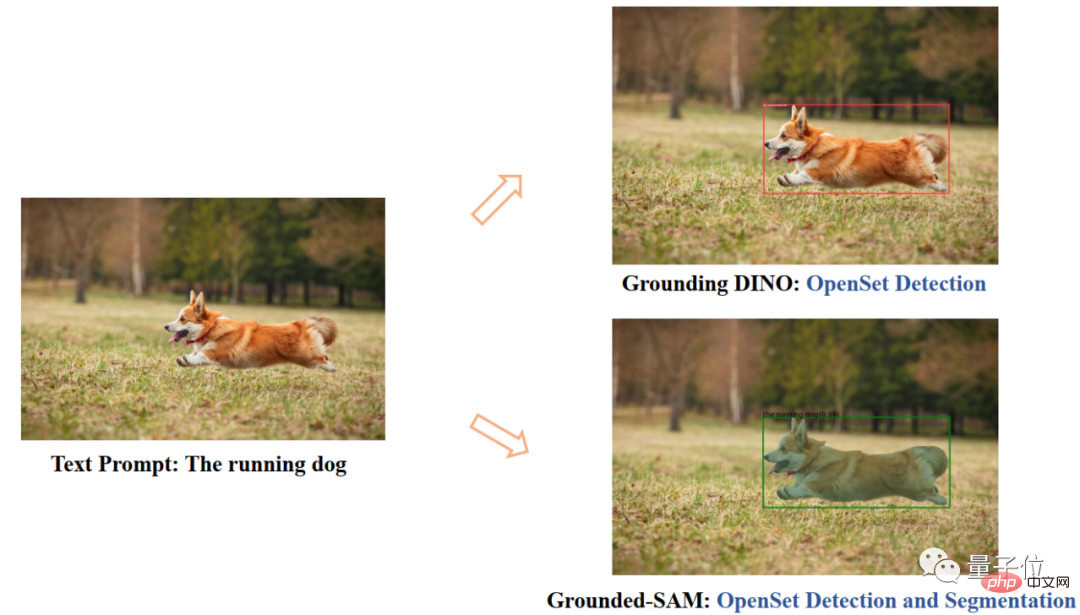

Grounded SAM besteht hauptsächlich aus zwei Modellen: Grounding DINO und SAM.

Unter diesen ist SAM (Segment Anything) ein Zero-Sample-Segmentierungsmodell, das Meta erst vor 4 Tagen eingeführt hat.

Es können Masken für alle Objekte in Bildern/Videos generiert werden, einschließlich Objekten und Bildern, die während des Trainingsprozesses nicht erschienen sind.

Indem SAM eine gültige Maske für jede Eingabeaufforderung zurückgibt, kann das Modell eine sinnvolle Maske unter allen Möglichkeiten ausgeben, selbst wenn die Eingabeaufforderung mehrdeutig ist oder auf mehrere Objekte verweist. Diese Aufgabe wird verwendet, um das Modell vorab zu trainieren und allgemeine nachgelagerte Segmentierungsaufgaben über Hinweise zu lösen.

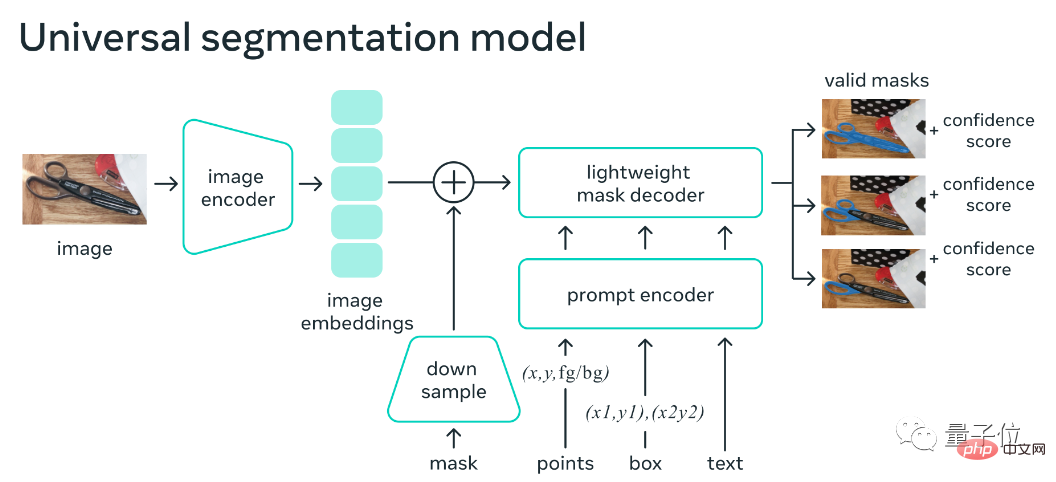

Das Modell-Framework besteht hauptsächlich aus einem Bild-Encoder, einem Hinweis-Encoder und einem schnellen Masken-Decoder. Nach der Berechnung der Bildeinbettung ist SAM in der Lage, innerhalb von 50 Millisekunden eine Segmentierung basierend auf einer beliebigen Eingabeaufforderung im Web zu generieren.

Die Erdung von DINO ist eine bestehende Errungenschaft dieses Forschungsteams.

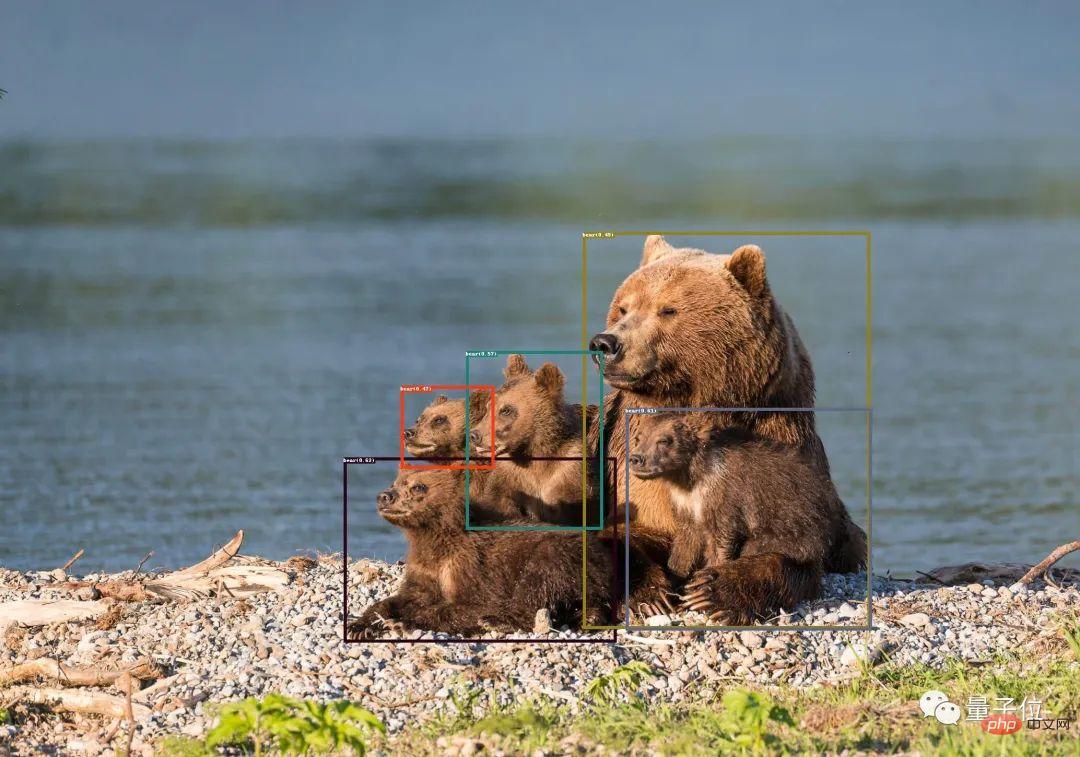

Dies ist ein Zero-Shot-Erkennungsmodell, das Objektboxen und Beschriftungen mit Textbeschreibungen generieren kann.

Nachdem Sie beides kombiniert haben, können Sie jedes Objekt im Bild anhand der Textbeschreibung finden und dann die leistungsstarken Segmentierungsfunktionen von SAM verwenden, um die Maske feinkörnig zu segmentieren.

Zusätzlich zu diesen Funktionen Sie überlagern auch die Fähigkeit der stabilen Diffusion, der eingangs gezeigten steuerbaren Bilderzeugung.

Es ist erwähnenswert, dass Stable Diffusion zuvor ähnliche Funktionen erreichen konnte. Löschen Sie einfach die Bildelemente, die Sie ersetzen möchten, und geben Sie die Textaufforderung ein.

Dieses Mal kann Grounded SAM den Schritt der manuellen Auswahl einsparen und ihn direkt über die Textbeschreibung steuern.

Darüber hinaus werden in Kombination mit BLIP (Bootstrapping Language-Image Pre-training) Bildtitel generiert, Beschriftungen extrahiert und anschließend Objektboxen und Masken generiert.

Derzeit sind weitere interessante Funktionen in der Entwicklung.

Zum Beispiel einige Erweiterungen der Charaktere: Änderung der Kleidung, Haarfarbe, Hautfarbe usw.

Die spezifische Verbrauchsmethode wurde auch auf GitHub angegeben. Das Projekt erfordert Python 3.8 oder höher, Pytorch 1.7 oder höher, Torchvision 0.8 oder höher und relevante Abhängigkeiten müssen installiert sein. Spezifische Inhalte finden Sie auf der GitHub-Projektseite.

Das Forschungsteam stammt vom IDEA Research Institute (Guangdong-Hong Kong-Macao Greater Bay Area Digital Economy Research Institute).

Öffentliche Informationen zeigen, dass das Institut eine internationale innovative Forschungseinrichtung für künstliche Intelligenz, digitale Wirtschaftsindustrie und Spitzentechnologie ist. Der ehemalige Chefwissenschaftler des Microsoft Asia Research Institute und der ehemalige Vizepräsident von Microsoft Global Intelligence Dr fungiert als Gründerperson und Vorsitzender.

Noch etwasFür die zukünftige Arbeit von Grounded SAM hat das Team mehrere Perspektiven:- Bilder automatisch generieren, um einen neuen Datensatz zu bilden

- Leistungsstarkes Basismodell mit Segmentierungs-Vorschulung

- Kooperieren mit (Chat- )GPT

- Bilden Sie eine Pipeline, die automatisch Bildbeschriftungen, Boxen und Masken generiert und neue Bilder generieren kann.

Das obige ist der detaillierte Inhalt vonEinheitliche visuelle KI-Funktionen! Automatisierte Bilderkennung und -segmentierung sowie kontrollierbare vinzentinische Bilder, erstellt von einem chinesischen Team. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr