Heim >Technologie-Peripheriegeräte >KI >Beiträge, die von den Gutachtern während der Blind-Review-Phase des ICLR hoch gelobt wurden: Wird es eine große Innovation in der Transformer-Architektur sein?

Beiträge, die von den Gutachtern während der Blind-Review-Phase des ICLR hoch gelobt wurden: Wird es eine große Innovation in der Transformer-Architektur sein?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 17:31:03930Durchsuche

Trotz vieler bemerkenswerter Erfolge waren die praktischen Fortschritte beim Training tiefer neuronaler Netze (DNNs) weitgehend unabhängig von der theoretischen Grundlage. Die meisten erfolgreichen modernen DNNs basieren auf spezifischen Anordnungen von Restverbindungen und Normalisierungsschichten, aber die allgemeinen Prinzipien für die Verwendung dieser Komponenten in neuen Architekturen sind noch unbekannt und ihre Rolle in bestehenden Architekturen ist noch nicht vollständig verstanden.

Restarchitekturen sind die beliebtesten und erfolgreichsten und wurden ursprünglich im Zusammenhang mit Faltungs-Neuronalen Netzen (CNN) entwickelt, aus denen später die allgegenwärtige Transformatorarchitektur aus Aufmerksamkeitsnetzen hervorging. Ein Grund für den Erfolg von Restarchitekturen ist die bessere Signalausbreitung im Vergleich zu gewöhnlichen DNNs, bei denen sich die Signalausbreitung auf die Übertragung geometrischer Informationen durch DNN-Schichten bezieht und durch eine Kernelfunktion dargestellt wird.

In letzter Zeit ist die Verwendung von Signalausbreitungsprinzipien zum Trainieren tieferer DNNs ohne die Beteiligung von Restverbindungen und/oder Normalisierungsschichten in Restarchitekturen zu einem Bereich von Gemeinschaftsinteresse geworden. Dafür gibt es zwei Gründe: Erstens validiert es die Signalausbreitungshypothese hinsichtlich der Wirksamkeit von Restarchitekturen und verdeutlicht so das Verständnis der DNN-Interpretierbarkeit. Zweitens ermöglicht dies möglicherweise allgemeine Prinzipien und Methoden für die DNN-Trainingsfähigkeit, die über das Restparadigma hinausgehen.

Für CNNs zeigt die Arbeit von Xiao et al. (2018), dass eine verbesserte Signalausbreitung durch bessere Initialisierung gewöhnliche tiefe Netzwerke effizient trainieren kann, wenn auch mit einer erheblichen Geschwindigkeitsreduzierung im Vergleich zu Restnetzwerken. Die Arbeit von Martens et al. (2021) schlug Deep Kernel Shaping (DKS) vor, das die Aktivierungsfunktionstransformation zur Steuerung der Signalausbreitung verwendet und starke Optimierer zweiter Ordnung wie K-FAC verwendet, um das Training gewöhnlicher Netzwerke und Restnetzwerke zu implementieren auf ImageNet. Die Geschwindigkeiten sind gleich. Die Arbeit von Zhang et al. (2022) erweitert DKS auf eine größere Klasse von Aktivierungsfunktionen und erreicht nahezu Gleichheit bei der Generalisierung.

Die bei der Signalausbreitung zu analysierende Schlüsselgröße ist der Initialisierungszeitkern des DNN, oder genauer gesagt, der ungefähre Kernel unter der unendlichen Breitengrenze. Für mehrschichtige Perzeptrone (MLPs) und CNNs mit Delta-Initialisierung kann der Kernel als einfache Schichtrekursion geschrieben werden, die nur 2D-Funktionen enthält, um eine einfache Analyse zu ermöglichen. Die Kernel-Evolution von Cross-Layer-Transformatoren ist komplexer, daher sind bestehende Methoden wie DKS nicht für Transformatoren oder Architekturen mit Selbstaufmerksamkeitsschichten geeignet.

In MLP wird die Signalausbreitung anhand des Verhaltens von (eindimensionalen) Kerneln beurteilt, während die Signalausbreitung in Transformatoren anhand der Entwicklung von (hochdimensionalen) Kernelmatrizen in den Netzwerkschichten beurteilt werden kann.

Diese Forschung muss eine Situation vermeiden, in der diagonale Elemente mit zunehmender Tiefe schnell wachsen oder schrumpfen, was mit unkontrollierten Aktivierungsnormen zusammenhängt und zu Sättigungsverlust oder numerischen Problemen führen kann. Für die Trainierbarkeit tiefer Transformatoren ist es notwendig, einen Rangkollaps zu vermeiden, und ob tiefe, residuenfreie Transformatoren trainiert werden können, bleibt eine offene Frage.

Dieses Papier aus der Blind-Review-Phase von ICLR 2023 löst dieses Problem und zeigt zum ersten Mal, dass es möglich ist, Tiefentransformatoren ohne verbleibende Verbindungen oder Normalisierungsschichten erfolgreich zu trainieren. Zu diesem Zweck untersuchen sie Probleme der Signalausbreitung und des Rangkollaps in tiefen, rückstandsfreien Transformatoren und leiten drei Methoden ab, um diese zu verhindern. Konkret verwendet der Ansatz eine Kombination aus Parameterinitialisierung, Bias-Matrizen und ortsabhängiger Neuskalierung und hebt verschiedene Komplexitäten hervor, die für die Signalausbreitung in Transformatoren spezifisch sind, einschließlich Interaktionen mit Positionskodierung und kausaler Maskierung. Die Forscher haben empirisch gezeigt, dass ihre Methode tief trainierbare, residuenfreie Transformatoren erzeugen kann.

Im experimentellen Teil zeigten die Forscher anhand der WikiText-103- und C4-Datensätze, dass mit ihrer Hauptmethode, Exponential Signal Preserving Attention (E-SPA), die Trainingszeit um etwa das Fünffache verlängert werden kann Verlust des Standardtransformators vergleichbar mit dem des Resttransformators im Papier. Darüber hinaus zeigten die Forscher durch die Kombination dieser Methode mit Restverbindungen, dass Transformatoren ohne Normalisierungsschichten Trainingsgeschwindigkeiten erreichen können, die mit Standardtransformatoren vergleichbar sind.

Papieradresse: https://openreview.net/pdf?id=NPrsUQgMjKK

Für dieses Papier glaubt Google AI-Chefingenieur Rohan Anil, dass es einen Fortschritt für die Transformer-Architektur darstellt Ein großer Schritt oder eine grundlegende Verbesserung.

Konstruieren eines tiefen Transformers, der ohne Abkürzungen trainierbar ist

Bisher basiert die einzige Strategie zur Korrektur des Zusammenbruchs des Transformer-Rangs auf Restverbindungen, wodurch die inhärenten Trainierbarkeitsprobleme von Selbstaufmerksamkeitsschichten übersprungen werden. Im Gegensatz dazu befasst sich diese Studie direkt mit dieser Frage. Verstehen Sie zunächst die Signalausbreitung durch Aufmerksamkeitsschichten besser und ändern Sie sie dann basierend auf den Erkenntnissen, um eine originalgetreue Signalübertragung in Tiefentransformatoren zu erreichen, die mit oder ohne Restverbindungen trainiert werden können.

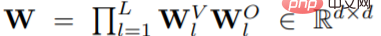

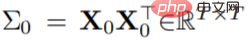

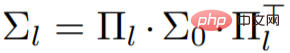

Konkret führte die Studie zunächst eine einfache Einstellung eines Deep-Vanilla-Transformators mit nur Aufmerksamkeit durch und ging dann davon aus, dass der Transformator eine Einzelkopf-Einstellung (h = 1) oder eine Mehrkopf-Einstellung hat, wobei die Aufmerksamkeitsmatrix A ändert sich nicht zwischen den Köpfen. Wenn der Block l ≤ L bei der Initialisierung eine Aufmerksamkeitsmatrix A_l hat, ist die Darstellung des letzten Blocks

und kann während der Initialisierung orthogonal sein.

Unter den oben genannten Annahmen kann, wenn  zur Darstellung der positionübergreifenden Eingabekernmatrix verwendet wird, nach einiger Vereinfachungsverarbeitung die folgende Formel erhalten werden:

zur Darstellung der positionübergreifenden Eingabekernmatrix verwendet wird, nach einiger Vereinfachungsverarbeitung die folgende Formel erhalten werden:

Aus dieser vereinfachten Formel (Tiefe). (nur Aufmerksamkeitstransformator-Kernelmatrix) können drei Anforderungen für (A_l)_l bestimmt werden:

Aus dieser vereinfachten Formel (Tiefe). (nur Aufmerksamkeitstransformator-Kernelmatrix) können drei Anforderungen für (A_l)_l bestimmt werden:

muss in jedem Block gut funktionieren und degenerierte Situationen wie Rangkollaps und explodierende/verschwindende Diagonalwerte vermeiden;

muss in jedem Block gut funktionieren und degenerierte Situationen wie Rangkollaps und explodierende/verschwindende Diagonalwerte vermeiden;

A_l muss elementweise nicht negativ sein ∀l;

A_l sollte unteres Dreieck ∀l sein, um mit der Kausalmaskenaufmerksamkeit kompatibel zu sein.

-

In den nächsten Abschnitten 3.1 und 3.2 konzentriert sich die Forschung auf die Suche nach einer Aufmerksamkeitsmatrix, die die oben genannten Anforderungen erfüllt, und schlägt drei Methoden vor: E-SPA, U-SPA und Value-Skipinit, wobei jede Methode die verwendete Aufmerksamkeitsmatrix verwendet Die Steuerung des Transformators ermöglicht eine originalgetreue Signalausbreitung auch in großen Tiefen. Darüber hinaus zeigt Abschnitt 3.3, wie man die Softmax-Aufmerksamkeit ändert, um diese Aufmerksamkeitsmatrizen zu implementieren.

In den nächsten Abschnitten 3.1 und 3.2 konzentriert sich die Forschung auf die Suche nach einer Aufmerksamkeitsmatrix, die die oben genannten Anforderungen erfüllt, und schlägt drei Methoden vor: E-SPA, U-SPA und Value-Skipinit, wobei jede Methode die verwendete Aufmerksamkeitsmatrix verwendet Die Steuerung des Transformators ermöglicht eine originalgetreue Signalausbreitung auch in großen Tiefen. Darüber hinaus zeigt Abschnitt 3.3, wie man die Softmax-Aufmerksamkeit ändert, um diese Aufmerksamkeitsmatrizen zu implementieren.

- In der folgenden Abbildung wurden die beiden vorgeschlagenen SPA-Systeme U-SPA und E-SPA überprüft. Die Ergebnisse zeigen, dass das Phänomen der reinen Rangaufmerksamkeit bei Vanilla-Transformatoren erfolgreich vermieden werden kann .

Experimente

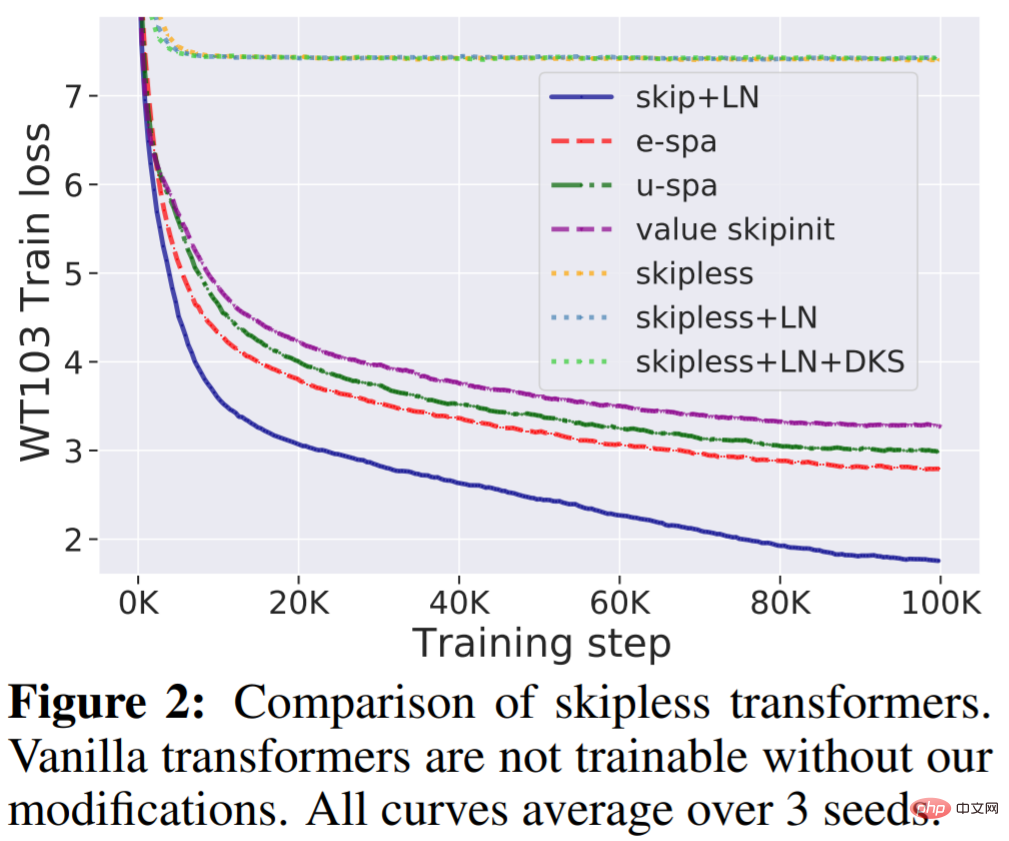

WikiText-103 Basislinie: Erstens bestätigt diese Studie, dass Standard-Tiefentransformatoren ohne Restverbindungen nicht trainierbar sind, selbst wenn sie über Normalisierungsschichten (LN) und transformierte Aktivierungen verfügen, aber unsere Methode kann diese Frage lösen. Wie in Abbildung 2 dargestellt, ist deutlich zu erkennen, dass das Entfernen der Restverbindung vom Standardtransformator ihn untrainierbar macht und sich der Trainingsverlust bei etwa 7,5 stabilisiert. Wie in Abbildung 1 dargestellt, leidet der Standardtransformator unter einem Rangzusammenbruch.

Andererseits übertrifft die in dieser Studie vorgeschlagene E-SPA-Methode U-SPA und Value-Skipinit. Der Standardtransformator mit Rest und LN behält jedoch immer noch den Trainingsgeschwindigkeitsvorteil im Vergleich zu unserer Methode ohne Reste bei.

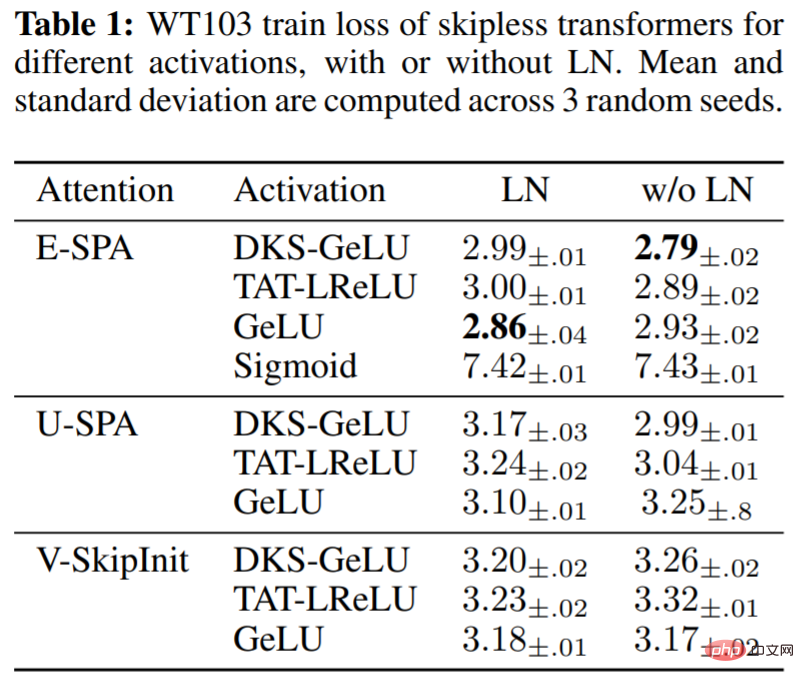

In Tabelle 1 bewertet die Studie die Auswirkungen verschiedener Aktivierungsfunktionen im MLP-Block unter Verwendung der vorgeschlagenen Methode sowie die Verwendung von LN im rückstandsfreien Transformator. Es ist ersichtlich, dass unsere Methode bei Tiefe 36 eine gute Trainingsleistung für eine Reihe von Aktivierungen erzielt: DKS-transformiertes GeLU, TAT-transformiertes Leaky ReLU und untransformiertes GeLU, aber nicht untransformiertes Sigmoid. Es wurde auch experimentell festgestellt, dass die Layer-Normalisierung für die Trainingsgeschwindigkeit relativ unwichtig ist und sogar schädlich für die transformierte Aktivierung sein kann, wenn SPA verwendet wird, das bereits über integrierte Mechanismen zur Steuerung der Aktivierungsspezifikationen verfügt.

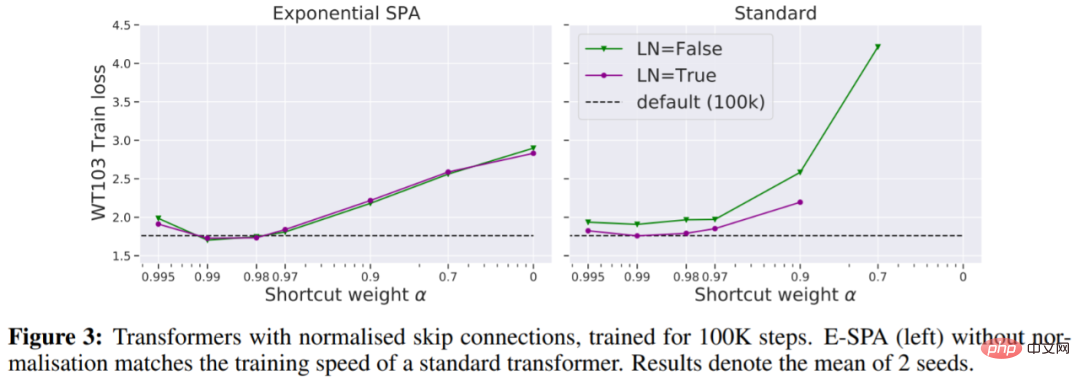

In Abbildung 3 sehen wir, dass eine Möglichkeit, den standardmäßigen Transformator-Trainingsverlust anzupassen, ohne dass weitere Iterationen erforderlich sind, darin besteht, eine normalisierte Restverbindung zu verwenden.

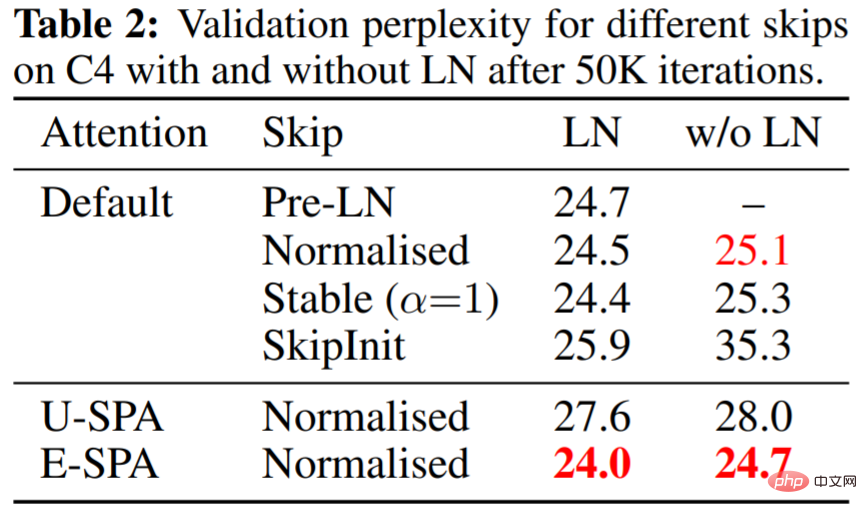

Tabelle 2 zeigt, dass E-SPA mit normalisierten Residuen und LN den standardmäßigen PreLN-Transformator übertrifft.

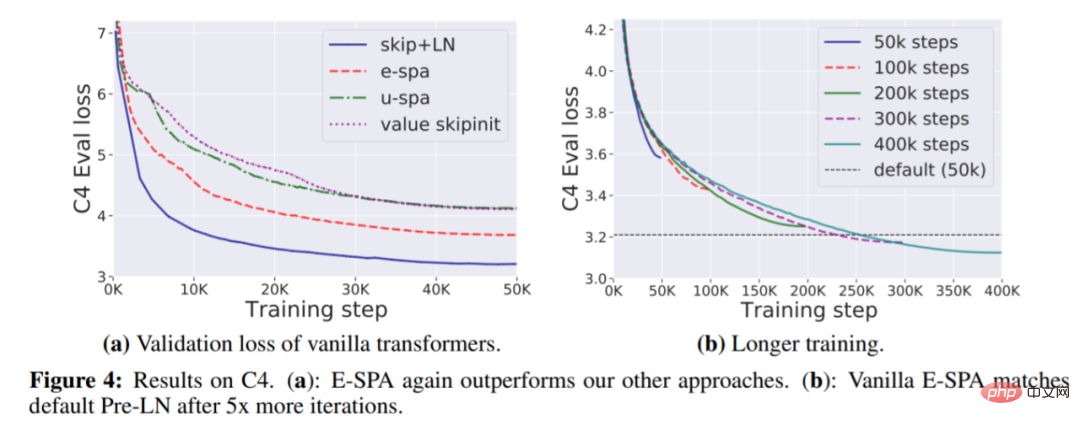

Abbildung 4(a) unten zeigt, dass E-SPA wiederum andere Methoden übertrifft; 4(b) zeigt, dass die Trainingsverlustlücke durch einfaches Erhöhen der Trainingszeit beseitigt werden kann.

Das obige ist der detaillierte Inhalt vonBeiträge, die von den Gutachtern während der Blind-Review-Phase des ICLR hoch gelobt wurden: Wird es eine große Innovation in der Transformer-Architektur sein?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr

In den nächsten Abschnitten 3.1 und 3.2 konzentriert sich die Forschung auf die Suche nach einer Aufmerksamkeitsmatrix, die die oben genannten Anforderungen erfüllt, und schlägt drei Methoden vor: E-SPA, U-SPA und Value-Skipinit, wobei jede Methode die verwendete Aufmerksamkeitsmatrix verwendet Die Steuerung des Transformators ermöglicht eine originalgetreue Signalausbreitung auch in großen Tiefen. Darüber hinaus zeigt Abschnitt 3.3, wie man die Softmax-Aufmerksamkeit ändert, um diese Aufmerksamkeitsmatrizen zu implementieren.

In den nächsten Abschnitten 3.1 und 3.2 konzentriert sich die Forschung auf die Suche nach einer Aufmerksamkeitsmatrix, die die oben genannten Anforderungen erfüllt, und schlägt drei Methoden vor: E-SPA, U-SPA und Value-Skipinit, wobei jede Methode die verwendete Aufmerksamkeitsmatrix verwendet Die Steuerung des Transformators ermöglicht eine originalgetreue Signalausbreitung auch in großen Tiefen. Darüber hinaus zeigt Abschnitt 3.3, wie man die Softmax-Aufmerksamkeit ändert, um diese Aufmerksamkeitsmatrizen zu implementieren.