Heim >Technologie-Peripheriegeräte >KI >Wie kann die Speicher- und Übertragungseffizienz verbessert werden? Parameterintensives Maskennetzwerk hat erhebliche Auswirkungen

Wie kann die Speicher- und Übertragungseffizienz verbessert werden? Parameterintensives Maskennetzwerk hat erhebliche Auswirkungen

- 王林nach vorne

- 2023-04-12 17:10:031317Durchsuche

Um komplexere Aufgaben zu bewältigen, hat der Umfang neuronaler Netze in den letzten Jahren zugenommen, und die effiziente Speicherung und Übertragung neuronaler Netze ist sehr wichtig geworden. Andererseits haben zufällige, spärliche neuronale Netze kürzlich mit dem Vorschlag der Lottery Ticket Hypothesis (LTH) ein großes Potenzial gezeigt, wie dieses Potenzial zur Verbesserung der Speicher- und Übertragungseffizienz des Netzwerks genutzt werden kann.

Forscher der Northeastern University und des Rochester Institute of Technology schlugen Parameter-Efficient Masking Networks (PEMN) vor. Die Autoren untersuchen zunächst die Darstellungsmöglichkeiten von Zufallsnetzwerken, die durch eine begrenzte Anzahl von Zufallszahlen generiert werden. Experimente zeigen, dass das Netzwerk auch dann, wenn es aus einer begrenzten Anzahl von Zufallszahlen generiert wird, durch die Wahl verschiedener Subnetzwerkstrukturen immer noch über gute Darstellungsmöglichkeiten verfügt.

Durch dieses explorative Experiment schlug der Autor natürlich vor, eine begrenzte Anzahl von Zufallszahlen als Prototyp zu verwenden und mit einer Reihe von Masken zu kombinieren, um ein neuronales Netzwerk auszudrücken. Da eine begrenzte Anzahl von Zufallszahlen und Binärmasken nur sehr wenig Speicherplatz beanspruchen, nutzt der Autor dies, um eine neue Idee für die Netzwerkkomprimierung vorzuschlagen. Der Artikel wurde für NeurIPS 2022 angenommen. Der Code ist Open Source.

- Papieradresse: https://arxiv.org/abs/2210.06699

- Papiercode: https://github.com/yueb17/PEMN

1. Verwandte Forschung

MIT-Forscher schlugen die Lotterieschein-Hypothese (ICLR'19) vor: In einem zufällig initialisierten Netzwerk gibt es ein Lotterie-Subnetzwerk (Gewinnschein), das allein durch Training gute Ergebnisse erzielt. Die Lotterielos-Hypothese untersucht die Trainierbarkeit stochastischer spärlicher Netzwerke. Uber-Forscher schlugen Supermask (NeurIPS’19) vor: In einem zufällig initialisierten Netzwerk gibt es ein Subnetzwerk, das ohne Training direkt für Inferenzen verwendet werden kann. Supermask untersucht die Verwendbarkeit stochastischer spärlicher Netzwerke. Forscher der University of Washington schlugen Edge-Popup (CVPR’20) vor: Erlernen der Maske des Subnetzwerks durch Backpropagation, was die Benutzerfreundlichkeit von zufälligen Netzwerken mit geringer Dichte erheblich verbessert.

2. Forschungsmotivation/-prozess

Die oben genannte verwandte Forschung hat das Potenzial zufälliger spärlicher Netzwerke aus verschiedenen Blickwinkeln untersucht, wie z. B. Trainierbarkeit und Benutzerfreundlichkeit, wobei Benutzerfreundlichkeit auch als Darstellungsfähigkeit verstanden werden kann. Die Autoren interessieren sich in dieser Arbeit dafür, wie gut ein aus Zufallszahlen generiertes neuronales Netzwerk ohne Trainingsgewichte darstellen kann. Nach der Untersuchung dieses Problems schlugen die Autoren Parameter-Efficient Masking Networks (PEMN) vor. Natürlich verwendet der Autor PEMN, um eine neue Idee für die Netzwerkkomprimierung bereitzustellen und als Beispiel für die Erkundung möglicher Anwendungsszenarien von PEMN zu dienen.

3. Erforschen Sie die Darstellungsfähigkeit neuronaler Netze, die aus Zufallszahlen bestehen.

Bei einem Zufallsnetzwerk wählt der Autor den Edge-Popup-Algorithmus zur Auswahl von Subnetzen, um dessen Darstellungsfähigkeit zu untersuchen. Der Unterschied besteht darin, dass der Autor nicht das gesamte Netzwerk zufällig initialisiert, sondern drei Parameter-intensive Netzwerkgenerierungsstrategien vorschlägt, um mithilfe eines Prototyps ein zufälliges Netzwerk aufzubauen.

- Einschichtig: Wählen Sie das Gewicht der wiederholten Struktur im Netzwerk als Prototyp aus, um andere Netzwerkschichten mit derselben Struktur zu füllen.

- Max-Layer-Padding (MP): Wählen Sie die Netzwerkschicht mit der größten Anzahl an Parametern als Prototyp aus und kürzen Sie die entsprechenden Parametermengen, um andere Netzwerkschichten zu füllen.

- Random Vector Padding (RP): Wählen Sie einen zufälligen Vektor einer bestimmten Länge als Prototyp aus und kopieren Sie ihn, um das gesamte Netzwerk zu füllen.

Drei verschiedene Strategien zur Zufallsnetzwerkgenerierung reduzieren schrittweise die Anzahl eindeutiger Werte im Netzwerk. Wir wählen Subnetzwerke basierend auf den durch verschiedene Strategien erhaltenen Zufallsnetzwerken aus und erforschen so eine begrenzte Anzahl von Zufallszahlen von generierten Zufallsnetzwerken.

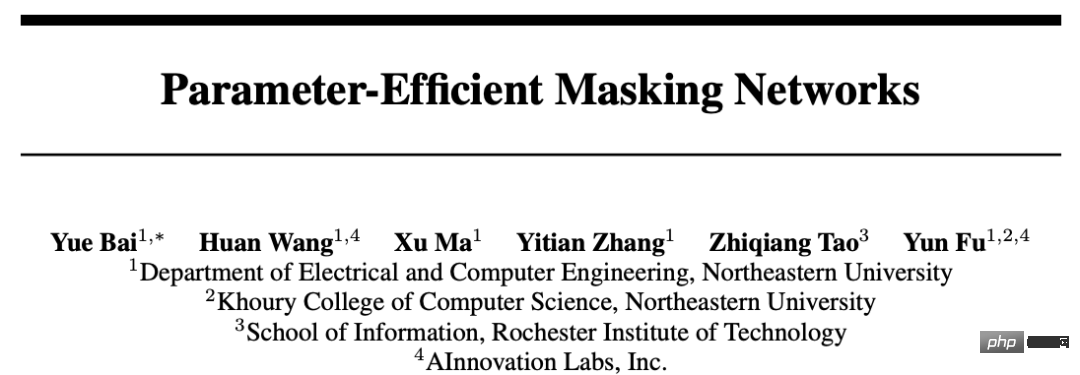

Die obige Abbildung zeigt die experimentellen Ergebnisse der CIFAR10-Bildklassifizierung mit ConvMixer und dem ViT-Netzwerk. Die Y-Achse ist die Genauigkeit und die X-Achse ist das zufällige Netzwerk, das mit verschiedenen Strategien erhalten wird. Als die

Anhand der experimentellen Ergebnisse haben wir beobachtet, dass das Zufallsnetzwerk selbst dann, wenn es nur eine sehr begrenzte Anzahl sich nicht wiederholender Zufallszahlen (wie PR_1e-3) aufweist, die Darstellungsfähigkeit des ausgewählten Subnetzwerks dennoch gut aufrechterhalten kann . Bisher hat der Autor die Darstellungsfähigkeit eines neuronalen Netzwerks, das aus einer begrenzten Anzahl von Zufallszahlen besteht, durch verschiedene Strategien zur Generierung von Zufallsnetzwerken untersucht und beobachtet, dass das entsprechende Zufallsnetzwerk auch dann noch darstellen kann, wenn die sich nicht wiederholenden Zufallszahlen sehr begrenzt sind die Daten gut.

Gleichzeitig schlug der Autor basierend auf diesen zufälligen Netzwerkgenerierungsstrategien und in Kombination mit der erhaltenen Subnetzwerkmaske einen neuen neuronalen Netzwerktyp namens Parameter-Efficient Masking Networks (PEMN) vor.

4. Eine neue Idee zur Netzwerkkomprimierung

Dieser Artikel wählt die neuronale Netzwerkkomprimierung als Beispiel, um die möglichen Anwendungen von PEMN zu erweitern. Insbesondere können die verschiedenen in diesem Artikel vorgeschlagenen Strategien zur Generierung zufälliger Netzwerke Prototypen effizient nutzen, um vollständige Zufallsnetzwerke darzustellen, insbesondere die feinkörnige RP-Strategie (Random Vector Padding).

Der Autor verwendet den Zufallsvektorprototyp in der RP-Strategie und einen entsprechenden Satz von Subnetzmasken, um ein Zufallsnetzwerk darzustellen. Der Prototyp muss im Gleitkommaformat gespeichert werden, während die Maske nur im Binärformat gespeichert werden muss. Da die Prototyplänge in RP sehr kurz sein kann (da eine begrenzte Anzahl sich nicht wiederholender Zufallszahlen immer noch über eine starke Darstellungsfähigkeit verfügt), wird der Overhead für die Darstellung eines neuronalen Netzwerks sehr gering, d. h. das Speichern eines Gleitkommazahlenformats mit eine begrenzte Länge. Ein Zufallsvektor und eine Reihe von Masken im Binärformat. Im Vergleich zu herkömmlichen spärlichen Netzwerken, die Gleitkommawerte von Subnetzwerken speichern, schlägt dieser Artikel eine neue Idee der Netzwerkkomprimierung vor, um neuronale Netzwerke effizient zu speichern und zu übertragen.

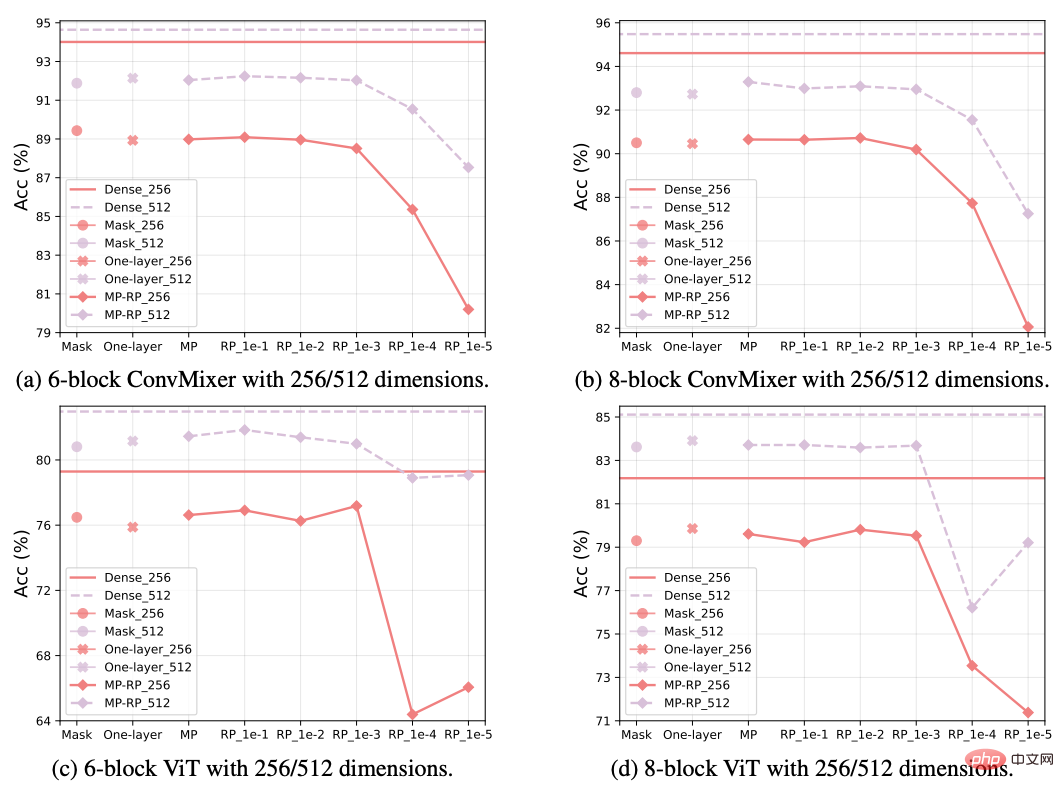

In der Abbildung oben verwendet der Autor PEMN, um das Netzwerk zu komprimieren und es mit der herkömmlichen Netzwerkbereinigungsmethode zu vergleichen. Das Experiment verwendet das ResNet-Netzwerk, um Bildklassifizierungsaufgaben für den CIFAR-Datensatz durchzuführen. Wir stellen fest, dass das neue Komprimierungsschema im Allgemeinen eine bessere Leistung erbringt als die herkömmliche Netzwerkbereinigung. Insbesondere bei sehr hohen Komprimierungsraten kann PEMN immer noch eine gute Genauigkeit beibehalten.

5. Fazit

Inspiriert durch das kürzlich gezeigte Potenzial von Zufallsnetzwerken schlägt dieser Artikel verschiedene parameterintensive Strategien zum Aufbau zufälliger neuronaler Netzwerke vor und untersucht dann die Methoden, die generiert werden, wenn nur begrenzte, sich nicht wiederholende Zufallszahlen vorhanden sind Es werden das Darstellungspotenzial zufälliger neuronaler Netze und Parametereffiziente Maskierungsnetze (PEMN) vorgeschlagen. Der Autor wendet PEMN auf Netzwerkkomprimierungsszenarien an, um sein Potenzial in praktischen Anwendungen zu erkunden, und liefert eine neue Idee für die Netzwerkkomprimierung. Die Autoren legen umfangreiche Experimente vor, die zeigen, dass ein Zufallsnetzwerk auch dann über gute Darstellungsmöglichkeiten durch die Auswahl von Subnetzwerken verfügt, wenn es nur eine sehr begrenzte Anzahl sich nicht wiederholender Zufallszahlen gibt. Darüber hinaus zeigen Experimente im Vergleich zu herkömmlichen Pruning-Algorithmen, dass die neu vorgeschlagene Methode bessere Netzwerkkomprimierungseffekte erzielen kann, was das Anwendungspotenzial von PEMN in diesem Szenario bestätigt.

Das obige ist der detaillierte Inhalt vonWie kann die Speicher- und Übertragungseffizienz verbessert werden? Parameterintensives Maskennetzwerk hat erhebliche Auswirkungen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr