Heim >Technologie-Peripheriegeräte >KI >Von BERT bis ChatGPT fasst eine hundertseitige Rezension die Entwicklungsgeschichte vorab trainierter großer Modelle zusammen

Von BERT bis ChatGPT fasst eine hundertseitige Rezension die Entwicklungsgeschichte vorab trainierter großer Modelle zusammen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 16:19:051499Durchsuche

Jeder Erfolg hat seine Spuren und ChatGPT ist keine Ausnahme.

Vor nicht allzu langer Zeit wurde der Turing-Award-Gewinner Yann LeCun aufgrund seiner harten Bewertung von ChatGPT auf die Hot-Search-Liste gesetzt.

Seiner Meinung nach „hat ChatGPT keine besondere Innovation, was die zugrunde liegende Technologie betrifft“ und es ist auch nicht „irgendetwas Revolutionäres“. Viele Forschungslabore verwenden dieselbe Technologie und erledigen die gleiche Arbeit. Darüber hinaus bestehen ChatGPT und das dahinter stehende GPT-3 in vielerlei Hinsicht aus mehreren Technologien, die über viele Jahre von mehreren Parteien entwickelt wurden und das Ergebnis jahrzehntelanger Beiträge verschiedener Personen sind. Daher glaubt LeCun, dass ChatGPT weniger ein wissenschaftlicher Durchbruch als vielmehr ein anständiges technisches Beispiel ist.

„Ob ChatGPT revolutionär ist“ ist ein kontroverses Thema. Es besteht jedoch kein Zweifel daran, dass es auf vielen zuvor gesammelten Technologien basiert. Beispielsweise wurde der Kerntransformator vor einigen Jahren von Google vorgeschlagen, und Transformer wurde von Bengios Arbeit zum Konzept der Aufmerksamkeit inspiriert. Wenn wir weiter zurückgehen, können wir auch an Forschungen aus noch früheren Jahrzehnten anknüpfen.

Natürlich wird die Öffentlichkeit dieses Schritt-für-Schritt-Gefühl möglicherweise nicht zu schätzen wissen. Schließlich wird nicht jeder die Zeitungen einzeln lesen. Für Techniker ist es jedoch immer noch sehr hilfreich, die Entwicklung dieser Technologien zu verstehen.

In einem kürzlich erschienenen Übersichtsartikel haben Forscher der Michigan State University, der Beijing Aeronautical University, der Lehigh University und anderen Institutionen sorgfältig Hunderte von Artikeln in diesem Bereich durchforstet und sich dabei hauptsächlich auf Text, Bilder und ein vorab trainiertes Basismodell konzentriert im Bereich des Graphenlernens, lesenswert. Philip S. ), Vizepräsident von Salesforce AI ResearchXiong Caimingdu ist einer der Autoren des Papiers. ... Auf ausländischen sozialen Plattformen hat DAIR.AI-Mitbegründer Elvis S. diese Rezension empfohlen und mehr als tausend Likes erhalten.

Einführung

Das vorab trainierte Basismodell (PFM) ist ein wichtiger Bestandteil der künstlichen Intelligenz im Big-Data-Zeitalter. Der Name „Basic Model“ stammt aus einer von Percy Liang, Li Feifei und anderen veröffentlichten Rezension „On the Opportunities and Risks of Foundation Models“, einem allgemeinen Begriff für einen Modelltyp und seine Funktionen. PFM wurde ausführlich in den Bereichen NLP, CV und Graph Learning untersucht. Sie zeigen ein großes Potenzial für das Lernen von Merkmalsdarstellungen bei verschiedenen Lernaufgaben, wie z. B. Textklassifizierung, Textgenerierung, Bildklassifizierung, Objekterkennung und Diagrammklassifizierung. Ganz gleich, ob es um das Training mehrerer Aufgaben mit großen Datenmengen oder die Feinabstimmung kleinerer Aufgaben geht, PFM weist eine überlegene Leistung auf, die einen schnellen Beginn der Datenverarbeitung ermöglicht.

PFM und Pre-Training

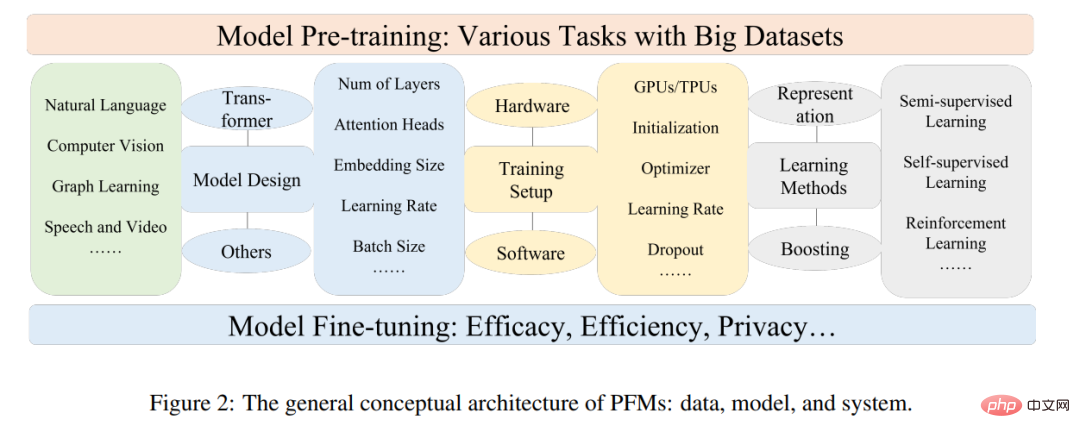

PFM basiert auf Pre-Training-Technologie, die darauf abzielt, eine große Menge an Daten und Aufgaben zu nutzen, um ein allgemeines Modell zu trainieren, das in verschiedenen nachgelagerten Prozessen leicht verfeinert werden kann Anwendungen.

Die Idee des Pre-Trainings entstand aus dem Transferlernen in Lebenslaufaufgaben. Nachdem man jedoch die Wirksamkeit dieser Technologie im CV-Bereich erkannt hatte, begann man, diese Technologie zu nutzen, um die Modellleistung in anderen Bereichen zu verbessern.

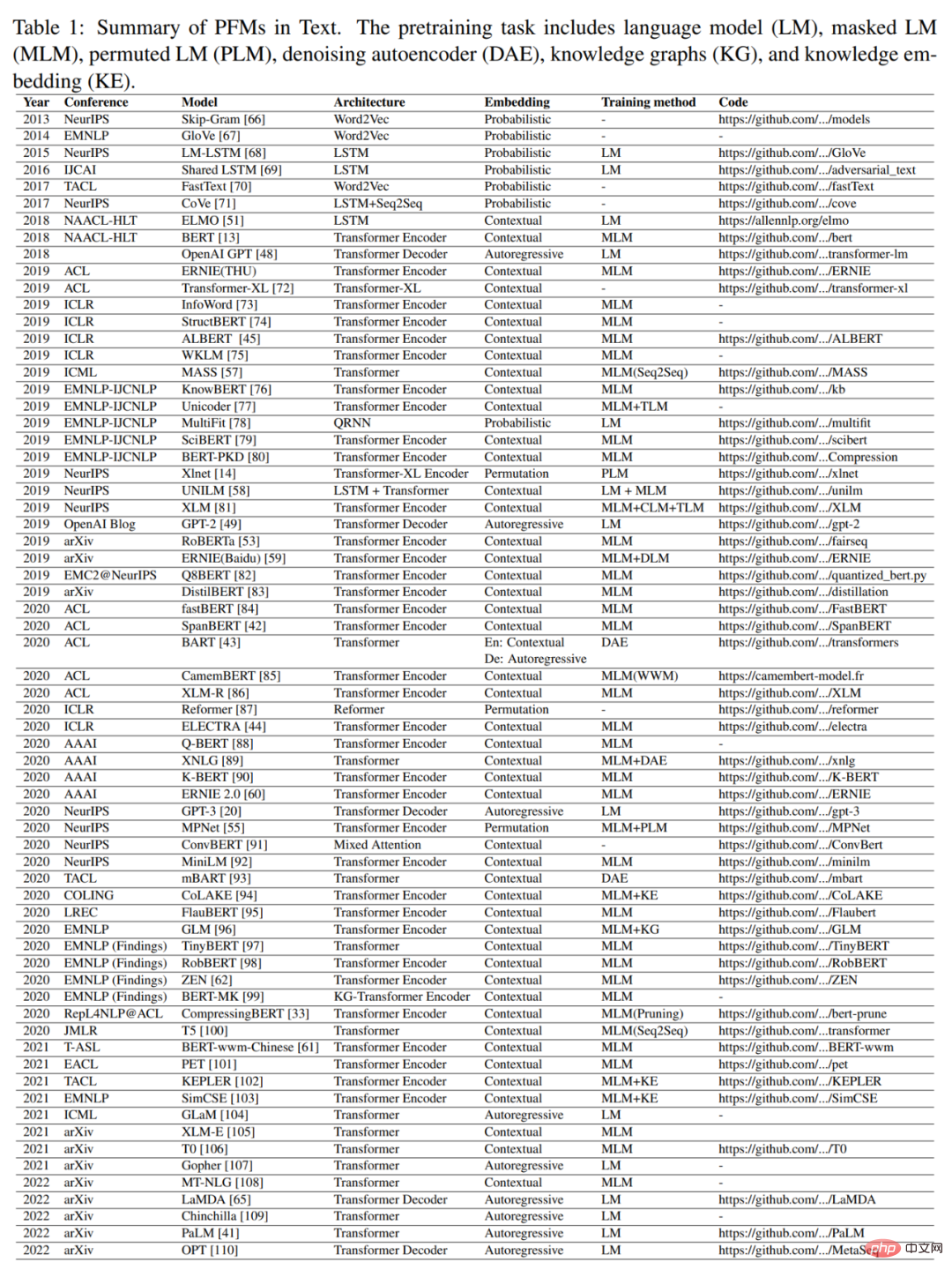

Wenn Pre-Training-Technologie im NLP-Bereich angewendet wird, kann ein gut trainiertes Sprachmodell umfangreiches Wissen erfassen, das für nachgelagerte Aufgaben von Vorteil ist, wie z. B. langfristige Abhängigkeiten, hierarchische Beziehungen usw. Darüber hinaus besteht der wesentliche Vorteil des Vortrainings im Bereich NLP darin, dass die Trainingsdaten aus jedem unbeschrifteten Textkorpus stammen können, d. h. es gibt eine nahezu unbegrenzte Menge an Trainingsdaten, die für den Vortrainingsprozess verwendet werden können . Das frühe Vortraining war eine statische Technik wie NNLM und Word2vec, aber statische Methoden lassen sich nur schwer an unterschiedliche semantische Umgebungen anpassen. Daher wurden dynamische Vortrainingstechniken wie BERT, XLNet usw. vorgeschlagen. Abbildung 1 zeigt die Geschichte und Entwicklung von PFM in den Bereichen NLP, CV und GL. PFM basiert auf Pre-Training-Techniken und nutzt große Korpora, um gängige semantische Darstellungen zu erlernen. Nach der Einführung dieser bahnbrechenden Arbeiten sind verschiedene PFMs entstanden und auf nachgelagerte Aufgaben und Anwendungen angewendet worden.

Das kürzlich beliebte ChatGPT ist ein typischer Fall einer PFM-Anwendung. Die Feinabstimmung basiert auf dem generativen vorab trainierten Transformatormodell GPT-3.5, das mit einer großen Menge dieses Papiers und Codes trainiert wurde. Darüber hinaus wendet ChatGPT Verstärkungslernen aus menschlichem Feedback (RLHF) an, das sich als vielversprechende Möglichkeit erwiesen hat, groß angelegte LMs an menschlichen Absichten auszurichten. Die hervorragende Leistung von ChatGPT kann zu Veränderungen im Trainingsparadigma jeder Art von PFM führen, wie z. B. der Anwendung von Instruction Alignment-Technologie, Reinforcement Learning, Prompt Tuning und Denkkette, und so zu einer allgemeinen künstlichen Intelligenz führen.

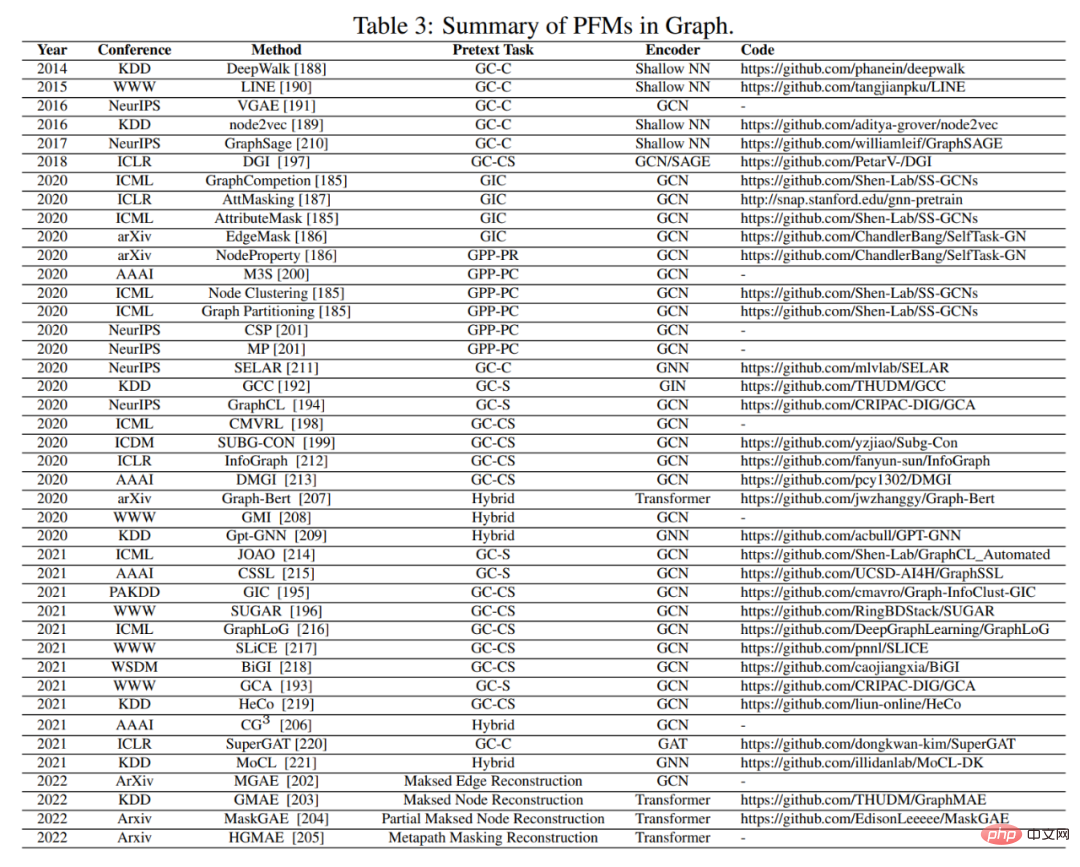

Dieser Artikel konzentriert sich auf PFM in den Bereichen Text, Bild und Grafik, eine relativ ausgereifte Forschungsklassifizierungsmethode. Bei Text handelt es sich um ein Allzweck-LM, mit dem das nächste Wort oder Zeichen in einer Sequenz vorhergesagt wird. PFM kann beispielsweise in maschineller Übersetzung, Frage-Antwort-Systemen, Themenmodellierung, Stimmungsanalyse usw. verwendet werden. Bei Bildern ähnelt es dem PFM für Text, wobei riesige Datensätze verwendet werden, um ein großes Modell zu trainieren, das für viele Lebenslaufaufgaben geeignet ist. Für Diagramme werden ähnliche vorab trainierte Ideen verwendet, um PFMs zu erhalten, die in vielen nachgelagerten Aufgaben verwendet werden. Zusätzlich zu PFMs für bestimmte Datendomänen werden in diesem Artikel auch einige andere erweiterte PFMs besprochen und näher erläutert, z. B. PFMs für Sprach-, Video- und domänenübergreifende Daten sowie multimodale PFMs. Darüber hinaus entsteht eine große Konvergenz von PFMs, die multimodale Aufgaben bewältigen können, das sogenannte einheitliche PFM. Die Autoren definieren zunächst das Konzept des einheitlichen PFM und überprüfen dann aktuelle Forschungsergebnisse zu einheitlichen PFMs, die SOTA erreicht haben (wie OFA, UNIFIED-IO, FLAVA, BEiT-3 usw.).

Basierend auf den Merkmalen des bestehenden PFM in den oben genannten drei Bereichen kam der Autor zu dem Schluss, dass PFM die folgenden zwei Hauptvorteile hat. Erstens erfordert das Modell nur geringfügige Feinabstimmungen, um die Leistung bei nachgelagerten Aufgaben zu verbessern. Zweitens wurde PFM hinsichtlich der Qualität unter die Lupe genommen. Anstatt ein Modell von Grund auf zu erstellen, um ein ähnliches Problem zu lösen, können wir PFM auf aufgabenrelevante Datensätze anwenden. Die breiten Perspektiven von PFM haben eine Vielzahl verwandter Arbeiten inspiriert, die sich auf Themen wie Modelleffizienz, Sicherheit und Komprimierung konzentrieren.

Beitrag und Struktur des Papiers

Vor der Veröffentlichung dieses Artikels gab es mehrere Rezensionen, in denen vorab trainierte Modelle in bestimmten Bereichen wie Textgenerierung, visueller Transformator und Objekterkennung überprüft wurden.

„Zu Chancen und Risiken von Stiftungsmodellen“ fasst die Chancen und Risiken von Stiftungsmodellen zusammen. Die vorhandenen Arbeiten ermöglichen jedoch keinen umfassenden Überblick über PFM in verschiedenen Bereichen (z. B. Lebenslauf, NLP, GL, Sprache, Video) in Bezug auf verschiedene Aspekte, wie z. B. Aufgaben vor dem Training, Effizienz, Effektivität und Datenschutz. In dieser Rezension erläutern die Autoren die Entwicklung von PFM im NLP-Bereich und wie die Vorschulung auf die CV- und GL-Bereiche übertragen und übernommen wurde.

Im Vergleich zu anderen Rezensionen bietet dieser Artikel keine umfassende Einführung und Analyse des bestehenden PFM in allen drei Bereichen. Anders als bei der Überprüfung früherer vorab trainierter Modelle fassen die Autoren bestehende Modelle, von traditionellen Modellen bis hin zu PFM, sowie die neuesten Arbeiten in drei Bereichen zusammen. Traditionelle Modelle betonen das Lernen statischer Merkmale. Dynamic PFM bietet eine Einführung in die Struktur, die Mainstream-Forschung ist.

Der Autor stellt außerdem einige andere Forschungsergebnisse zu PFM vor, darunter andere fortschrittliche und einheitliche PFM, Modelleffizienz und -komprimierung, Sicherheit und Datenschutz. Abschließend fassen die Autoren zukünftige Forschungsherausforderungen und offene Fragen in verschiedenen Bereichen zusammen. Sie bieten außerdem eine umfassende Einführung in relevante Bewertungsmetriken und Datensätze in den Anhängen F und G.

Zusammenfassend sind die Hauptbeiträge dieses Artikels wie folgt:

- Eine detaillierte und aktuelle Übersicht über die Entwicklung von PFM in NLP, CV und GL. In der Rezension diskutieren und geben die Autoren Einblicke in die Design- und Vortrainingsmethoden des allgemeinen PFM in diesen drei Hauptanwendungsbereichen.

- fasst die Entwicklung von PFM in anderen Multimediabereichen wie Sprache und Video zusammen. Darüber hinaus diskutieren die Autoren aktuelle Themen zu PFM, darunter einheitliches PFM, Modelleffizienz und -komprimierung sowie Sicherheit und Datenschutz.

- Durch einen Überblick über verschiedene PFM-Modi in unterschiedlichen Aufgaben diskutieren die Autoren die wichtigsten Herausforderungen und Chancen für die zukünftige Forschung zu sehr großen Modellen im Big-Data-Zeitalter, die eine neue Generation PFM-basierter kollaborativer und interaktiver Intelligenz leiten .

Der Hauptinhalt jedes Kapitels ist wie folgt:

Kapitel 2 des Papiers stellt die allgemeine konzeptionelle Architektur von PFM vor.

Kapitel 3, 4 und 5 fassen bestehende PFM in den Bereichen NLP, CV und GL zusammen.

In den Kapiteln 6 und 7 werden weitere aktuelle Forschungsergebnisse im Bereich PFM vorgestellt, darunter hochmodernes und einheitliches PFM, Modelleffizienz und -komprimierung sowie Sicherheit und Datenschutz.

Kapitel 8 fasst die wichtigsten Herausforderungen von PFM zusammen. Kapitel 9 fasst den vollständigen Text zusammen.

Das obige ist der detaillierte Inhalt vonVon BERT bis ChatGPT fasst eine hundertseitige Rezension die Entwicklungsgeschichte vorab trainierter großer Modelle zusammen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr