Heim >Technologie-Peripheriegeräte >KI >KI-Lesegehirn explodiert! Scannen Sie Gehirnbilder und Stable Diffusion reproduziert Bilder realistisch

KI-Lesegehirn explodiert! Scannen Sie Gehirnbilder und Stable Diffusion reproduziert Bilder realistisch

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 15:52:031790Durchsuche

Auch ohne die Magie von Hogwarts können Sie immer noch sehen, was andere denken!

Die Methode ist sehr einfach und basiert auf stabiler Diffusion zur Visualisierung von Gehirnbildern.

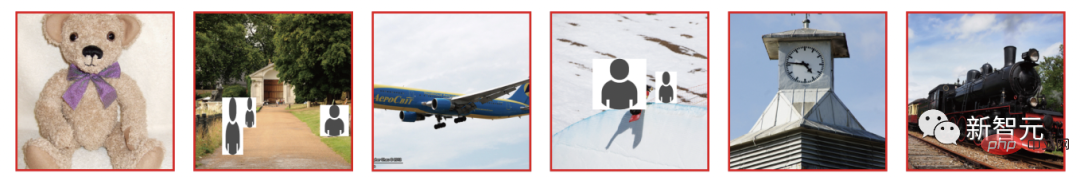

Zum Beispiel sehen die Bären, Flugzeuge und Züge, die Sie sehen, so aus.

Wenn die KI das Gehirnsignal sieht, wird das folgende Bild erzeugt, das zeigt, dass alle notwendigen Punkte vorhanden sind.

Diese KI-Technologie zum Lesen von Gehirnen wurde gerade von CVPR 2023 akzeptiert und beschert Fans einen sofortigen „intrakraniellen Orgasmus“.

Es ist so wild! Vergessen Sie das Anstoßen von Projekten, jetzt müssen Sie nur noch Ihr Gehirn nutzen, um über diese Bilder „zu denken“.

Stellen Sie sich vor, Sie würden stabile Diffusion verwenden, um visuelle Bilder aus fMRT-Daten zu rekonstruieren, was in Zukunft die Entwicklung nicht-invasiver Gehirn-Computer-Schnittstellen bedeuten könnte.

Lassen Sie die KI die menschliche Sprache direkt überspringen und wahrnehmen, was im menschlichen Gehirn denkt.

Bis dahin wird auch der von Musk entwickelte Neuralink diese KI-Obergrenze einholen.

Keine Feinabstimmung erforderlich, verwenden Sie KI, um direkt zu reproduzieren, was Sie denken.

Wie realisiert KI also das Gehirnlesen?

Die neuesten Forschungsergebnisse stammen von einem Forschungsteam der Universität Osaka in Japan.

Papieradresse: https://www.php.cn/link/0424d20160a6a558e5bf86a7bc9b67f0

Osaka University Graduate School of Frontier Biosciences und CiNet of. Japan NICT-Forscher basieren auf der potenziellen Verbreitung von Modell (LDM), genauer gesagt, um das visuelle Erlebnis aus fMRT-Daten über stabile Diffusion zu rekonstruieren.

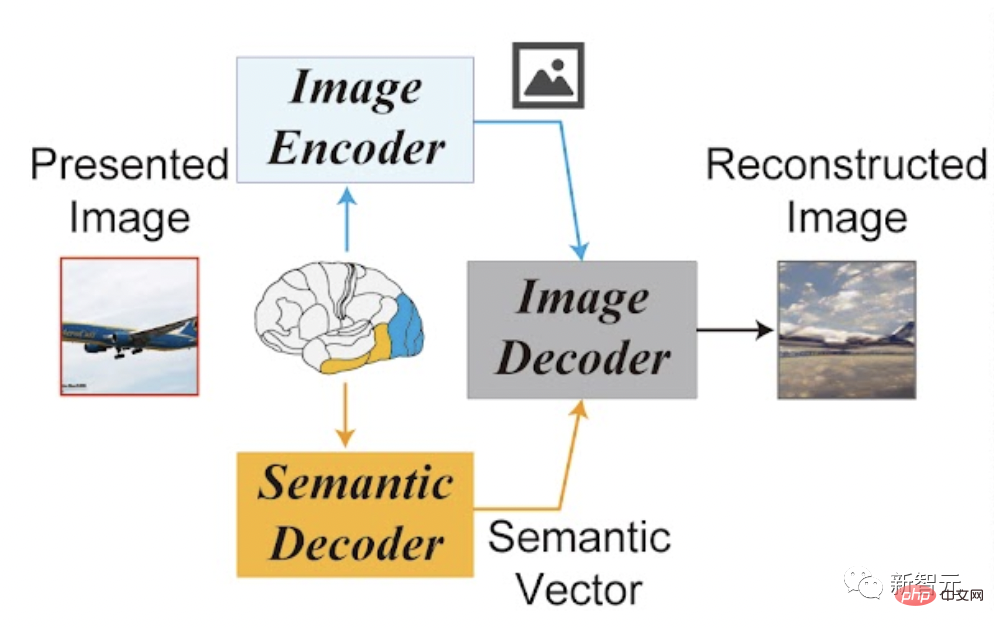

Der Rahmen des gesamten Betriebsprozesses ist ebenfalls sehr einfach: 1 Bild-Encoder, 1 Bild-Decoder und 1 semantischer Decoder.

Dadurch entfällt für das Team die Notwendigkeit, komplexe KI-Modelle zu trainieren und zu optimieren.

Alles, was trainiert werden muss, ist ein einfaches lineares Modell, das fMRT-Signale von unteren und oberen visuellen Gehirnbereichen auf eine einzelne stabile Diffusionskomponente abbildet.

Konkret kartierten die Forscher Gehirnregionen als Eingabe für Bild- und Text-Encoder. Die unteren Gehirnbereiche werden Bild-Encodern zugeordnet, und die oberen Gehirnbereiche werden Text-Encodern zugeordnet. Dadurch kann das System Bildkomposition und semantische Inhalte zur Rekonstruktion nutzen.

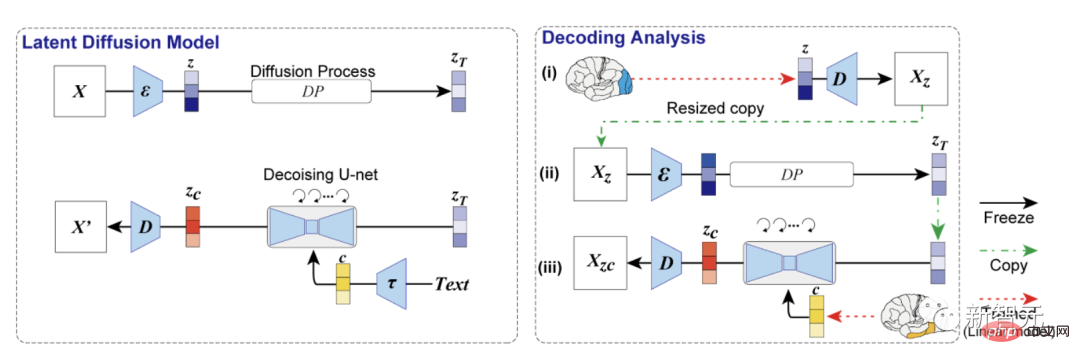

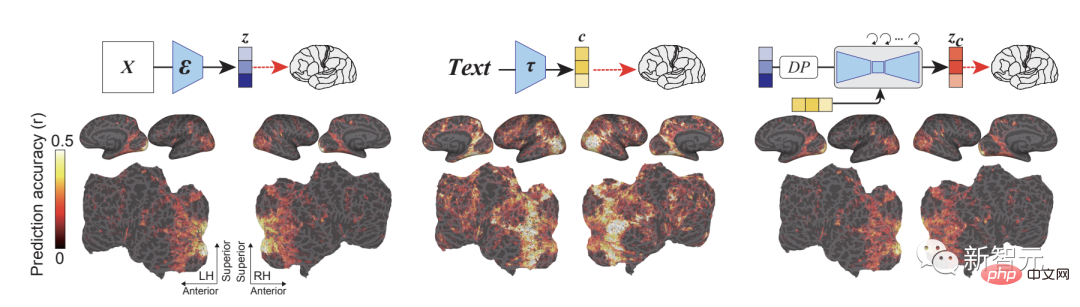

Die erste ist die Dekodierungsanalyse. Das in der Studie verwendete LDM-Modell besteht aus einem Bildkodierer ε, einem Bilddekodierer D und einem Textkodierer τ.

Die Forscher entschlüsselten die latente Darstellung des rekonstruierten Bildes z und des zugehörigen Textes c aus den fMRT-Signalen des frühen und oberen visuellen Kortex und verwendeten sie als Eingabe, um das reproduzierte Bild Xzc zu erzeugen durch den Autoencoder.

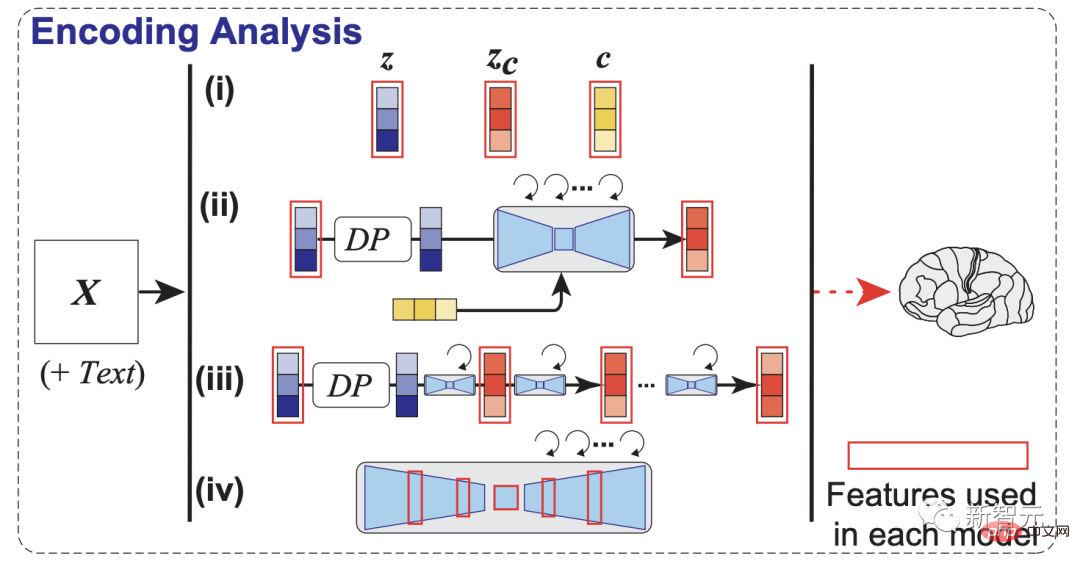

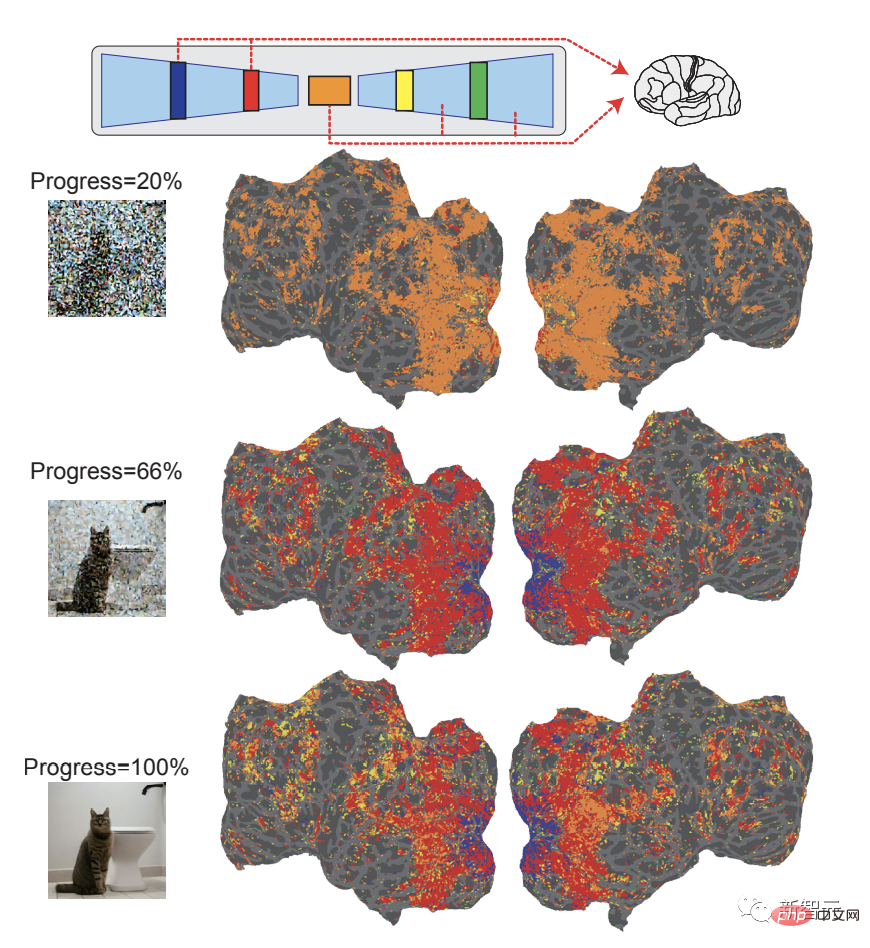

Als nächstes erstellten die Forscher auch ein Kodierungsmodell zur Kodierung der Daten LDM Die fMRT-Signale verschiedener Komponenten sollen das Innenleben von LDM erforschen. Die Forscher verwendeten fMRT-Bilder aus dem Natural Scene Dataset (NSD), führten Experimente durch und testeten, ob sie mithilfe der stabilen Diffusion rekonstruieren können, was Probanden sehen.

Es ist ersichtlich, dass das Codierungsmodell und LDM mit der Genauigkeit der latenten Bildvorhersage zusammenhängen und das letzte Modell die höchste Vorhersagegenauigkeit im visuellen Kortex erzeugt Rückseite des Gehirns.

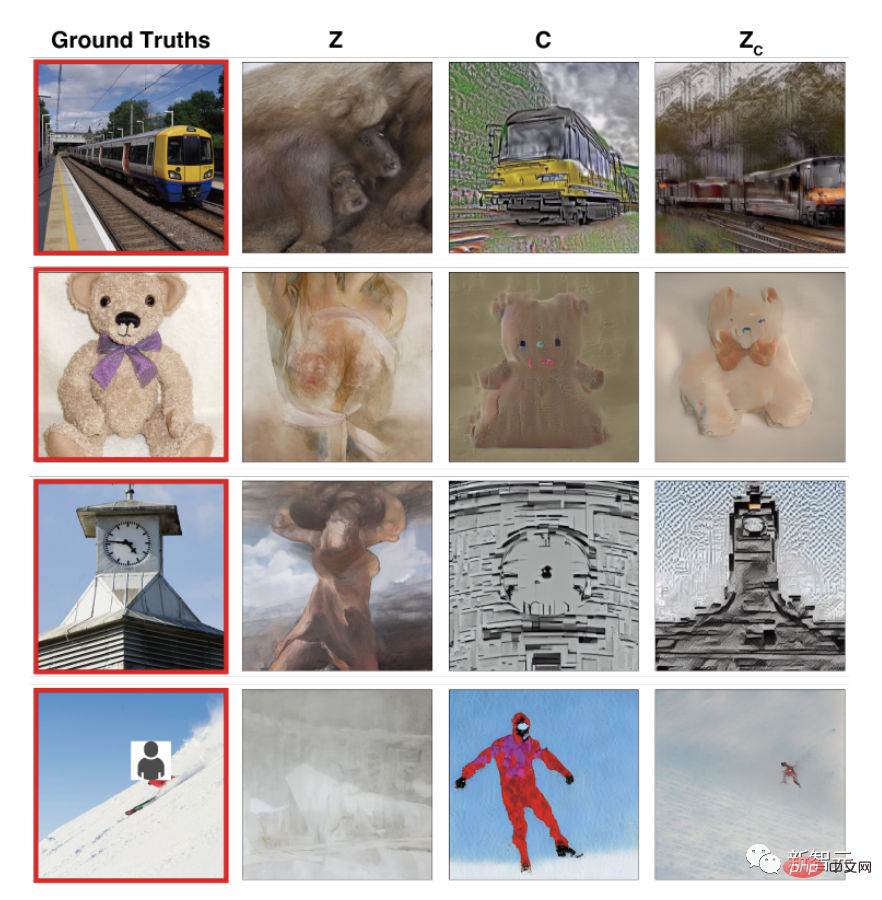

Die visuellen Rekonstruktionsergebnisse eines Subjekts zeigen, dass nur z-rekonstruiert wurde Das Bild stimmt optisch mit dem Originalbild überein, erfasst jedoch nicht den semantischen Inhalt.

Während das nur mit c rekonstruierte Bild eine bessere semantische Treue, aber eine schlechte visuelle Konsistenz aufweist, kann das mit zc rekonstruierte Bild gleichzeitig eine hohe semantische Treue und eine hohe Auflösung aufweisen .

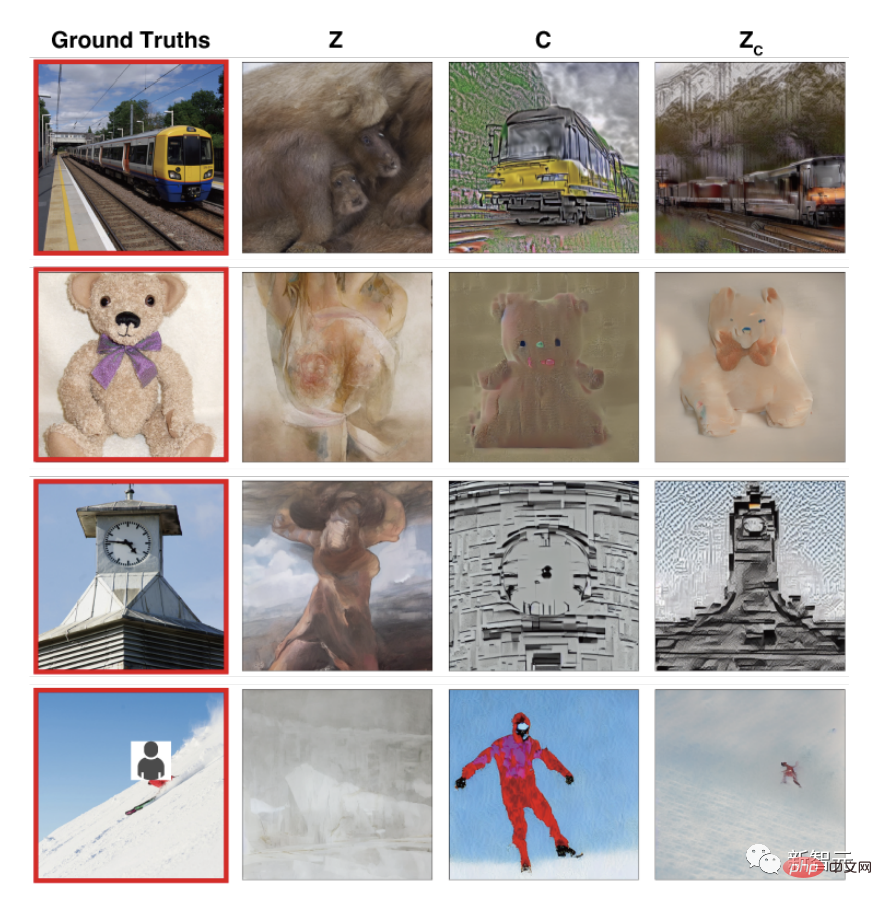

Rekonstruktionsergebnisse aller Probanden auf demselben Bild zeigen, dass die Rekonstruktion Der Effekt ist bei verschiedenen Probanden stabil und relativ genau.

Die Unterschiede in bestimmten Details können auf Unterschiede in der individuellen Wahrnehmungserfahrung oder Datenqualität zurückzuführen sein und nicht auf Fehler im Rekonstruktionsprozess.

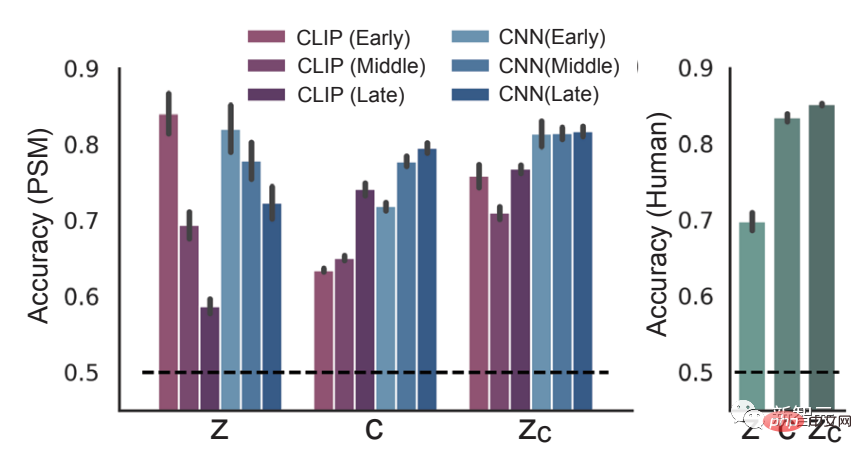

Abschließend werden die Ergebnisse der quantitativen Auswertung in Diagrammen dargestellt.

Verschiedene Ergebnisse zeigen, dass die in der Studie verwendete Methode nicht nur das visuelle Erscheinungsbild auf niedriger Ebene, sondern auch den semantischen Inhalt des ursprünglichen Reizes auf hoher Ebene erfassen kann .

Aus dieser Sicht zeigt das Experiment, dass die Kombination von Bildern und die Textdekodierung sorgt für eine genaue Rekonstruktion. Es gab Unterschiede in der Genauigkeit zwischen den Probanden, aber diese Unterschiede hingen mit der Qualität der fMRT-Bilder zusammen, sagten die Forscher. Nach Angaben des Teams ist die Qualität der Rekonstruktion mit aktuellen SOTA-Methoden vergleichbar, erfordert jedoch kein Training des darin verwendeten KI-Modells.

Gleichzeitig verwendete das Team auch Modelle, die aus fMRT-Daten abgeleitet wurden, um die verschiedenen Bausteine der stabilen Diffusion zu untersuchen, beispielsweise wie der semantische Inhalt in der inversen Diffusion ist Welcher Prozess wurde in U-Net generiert oder welcher Prozess findet in U-Net statt?

In den frühen Phasen des Entrauschungsprozesses erzeugt die Engpassschicht (orange) von U-Net die höchste Vorhersageleistung (Blau) führt eine Vorhersage der frühen Aktivität des visuellen Kortex durch und die Engpassschicht wandert in den visuellen Kortex auf hoher Ebene.

Das bedeutet, dass zu Beginn des Diffusionsprozesses die Bildinformationen in der Engpassschicht komprimiert werden und zusammen mit der Entrauschung die Trennung zwischen den U-Net-Schichten auftritt Im visuellen Kortex.

Darüber hinaus arbeitet das Team an einer quantitativen Erklärung von Bildtransformationen in verschiedenen Diffusionsstadien. Damit wollen die Forscher zu einem besseren Verständnis von Diffusionsmodellen aus biologischer Sicht beitragen, die weit verbreitet sind, deren Verständnis jedoch noch begrenzt ist.

Bilder des menschlichen Gehirns wurden bereits von der KI entschlüsselt?

Seit Jahren nutzen Forscher Modelle der künstlichen Intelligenz, um Informationen aus dem menschlichen Gehirn zu entschlüsseln.

Der Kern der meisten Methoden besteht darin, vorab aufgezeichnete fMRT-Bilder als Eingabe für ein generatives KI-Modell aus Text oder Bildern zu verwenden.

So demonstrierte beispielsweise Anfang 2018 ein Forscherteam aus Japan, wie ein neuronales Netzwerk Bilder aus fMRT-Aufnahmen rekonstruieren kann.

Im Jahr 2019 rekonstruierte eine Gruppe Bilder von Affenneuronen, und Metas Forschungsgruppe unter der Leitung von Jean-Remi King veröffentlichte neue Arbeiten wie die Ableitung von Text aus fMRT-Daten.

Im Oktober 2022 zeigte ein Team der University of Texas in Austin, dass ein GPT-Modell aus fMRT-Scans Text ableiten kann, der den semantischen Inhalt dessen beschreibt, was eine Person in einem Video sah.

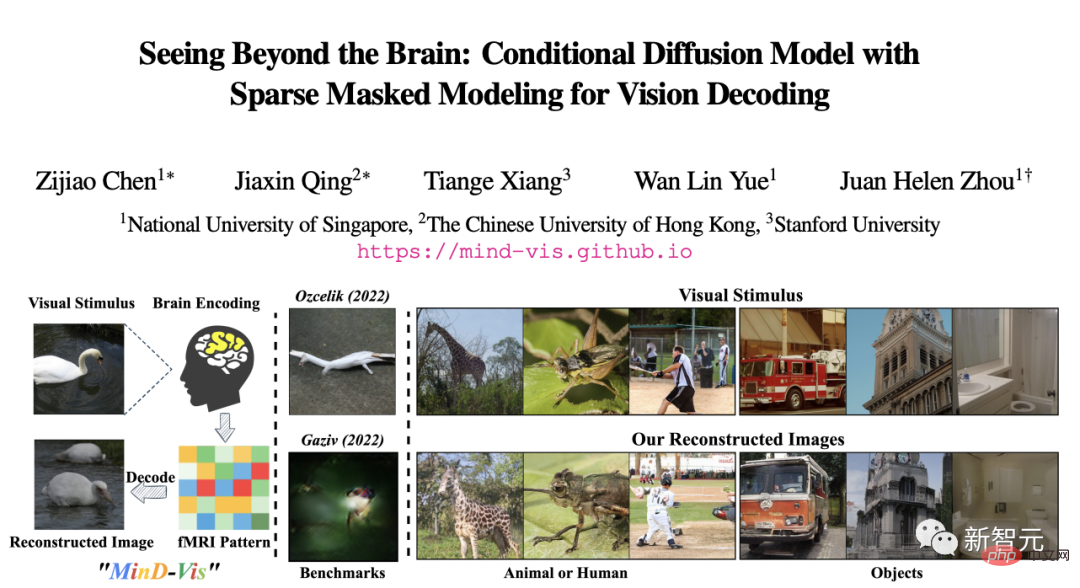

Im November 2022 verwendeten Forscher der National University of Singapore, der Chinese University of Hong Kong und der Stanford University das MinD-Vis-Diffusionsmodell, um Bilder aus fMRT-Scans mit deutlich höherer Genauigkeit als die damals verfügbaren Methoden zu rekonstruieren.

Einige Internetnutzer haben darauf hingewiesen, dass es „die Generierung von Bildern auf der Grundlage von Gehirnwellen seit mindestens 2008 gibt, was irgendwie impliziert, dass Stable Diffusion die Gedanken von Menschen lesen kann. Das ist einfach lächerlich.“ „

In diesem von der University of California, Berkeley in Nature veröffentlichten Artikel heißt es, dass die Aktivität menschlicher Gehirnwellen mithilfe eines visuellen Decoders in Bilder umgewandelt werden kann.

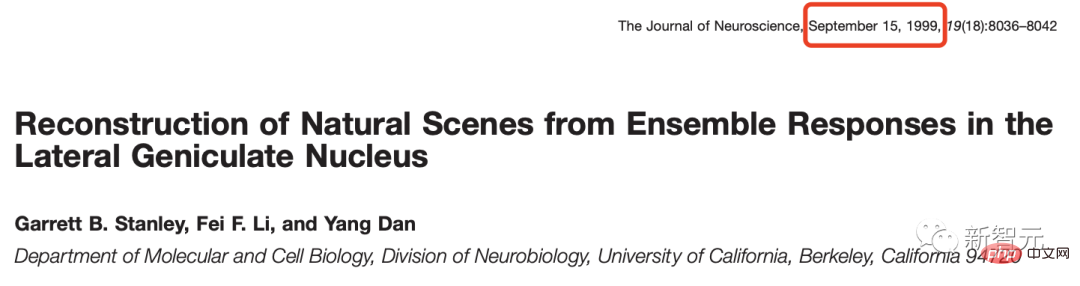

Um die Geschichte nachzuvollziehen, zitierten einige Leute direkt eine Studie von Stanford Li Feifei aus dem Jahr 1999 über die Rekonstruktion von Bildern aus der Großhirnrinde.

Li Feifei hat es ebenfalls kommentiert und weitergeleitet und gesagt, dass sie zu diesem Zeitpunkt noch Universitätspraktikantin war.

Ebenfalls im Jahr 2011 verwendete eine Studie der UC Berkeley funktionelle Magnetresonanztomographie (fMRT) und Computermodelle, um zunächst das „dynamische visuelle Bild“ des Gehirns zu rekonstruieren.

Das heißt, sie haben Clips nachgebildet, die die Leute gesehen haben.

Aber im Vergleich zu den neuesten Forschungsergebnissen ist diese Rekonstruktion überhaupt nicht „hochauflösend“ und fast nicht wiederzuerkennen.

Vorstellung an den Autor

Yu Takagi

Yu Takagi ist Assistenzprofessor an der Universität Osaka. Seine Forschungsinteressen liegen an der Schnittstelle zwischen Computational Neuroscience und künstlicher Intelligenz.

Während seiner Doktorarbeit untersuchte er Techniken zur Vorhersage verschiedener individueller Unterschiede in der funktionellen Konnektivität des gesamten Gehirns mithilfe der funktionellen Magnetresonanztomographie (fMRT) im ATR Brain Information Communication Research Laboratory.

Kürzlich hat er Techniken des maschinellen Lernens eingesetzt, um dynamische Berechnungen bei komplexen Entscheidungsaufgaben am Oxford Centre for Human Brain Activity der Universität Oxford und am Institut für Psychologie der Universität Tokio zu verstehen.

Shinji Nishimoto

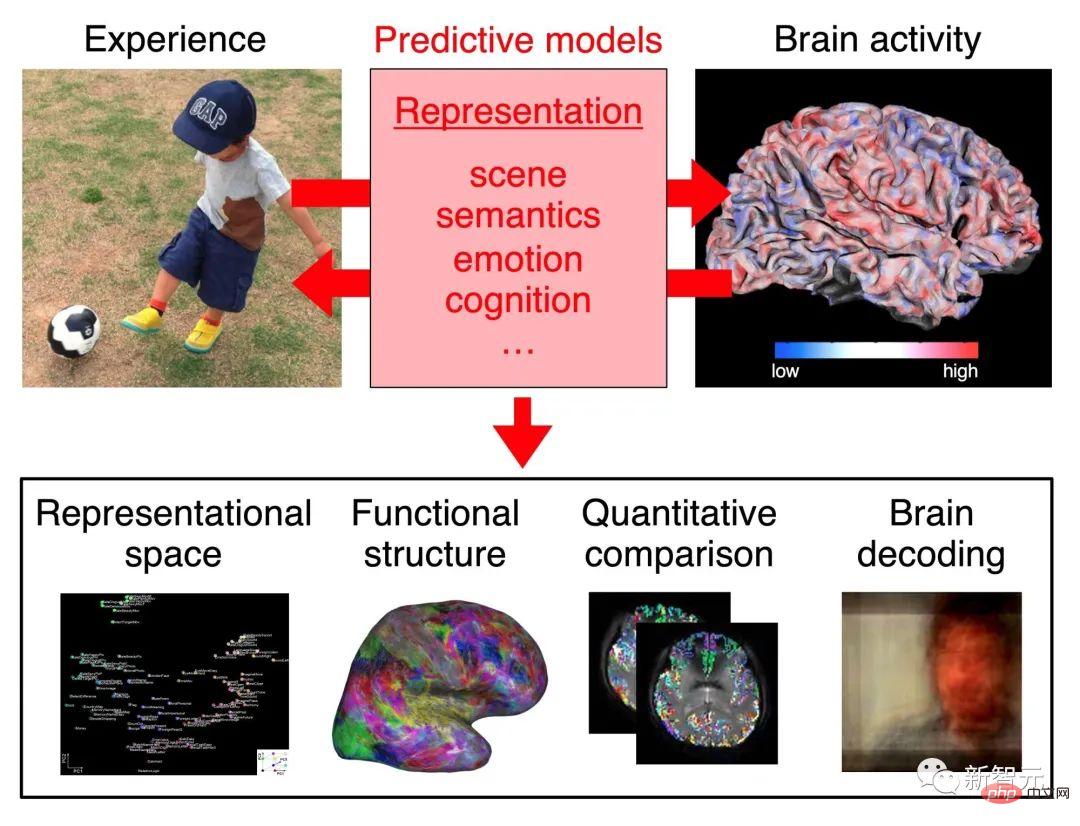

Shinji Nishimoto ist Professor an der Universität Osaka. Sein Forschungsschwerpunkt liegt auf dem quantitativen Verständnis der visuellen und kognitiven Verarbeitung im Gehirn.

Genauer gesagt liegt der Forschungsschwerpunkt des Teams von Professor Nishimoto auf dem Verständnis der neuronalen Verarbeitung und Darstellung durch die Erstellung prädiktiver Modelle der Gehirnaktivität, die unter natürlichen Wahrnehmungs- und kognitiven Bedingungen hervorgerufen wird.

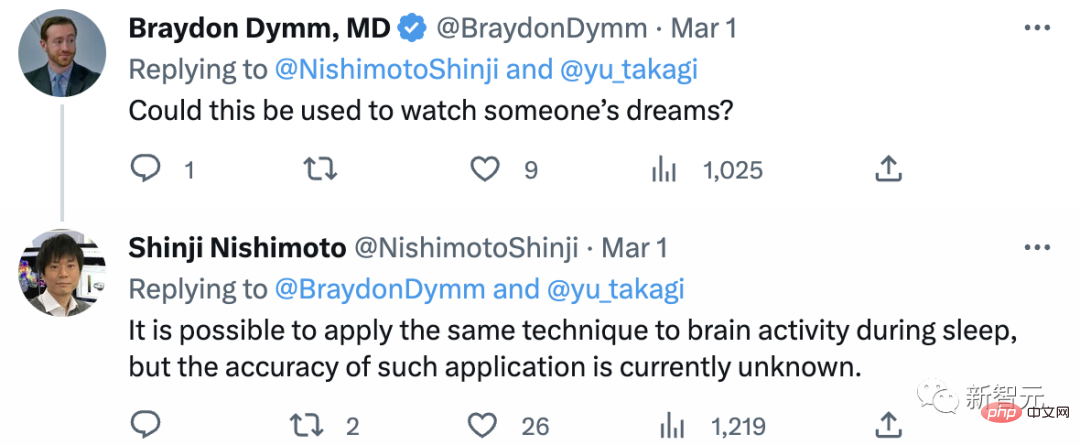

Einige Internetnutzer fragten den Autor, ob diese Forschung zur Interpretation von Träumen verwendet werden kann?

„Es ist möglich, die gleiche Technologie auf die Gehirnaktivität im Schlaf anzuwenden, aber die Genauigkeit einer solchen Anwendung ist derzeit unklar.“

Nachdem ich diese Studie gesehen habe: Photo Legilimency ist jetzt verfügbar .

Referenz:

https://www.php.cn/link/0424d20160a6a558e5bf86a7bc9b67f0

https://www . php.cn/link/02d72b702eed900577b953ef7a9c1182

Das obige ist der detaillierte Inhalt vonKI-Lesegehirn explodiert! Scannen Sie Gehirnbilder und Stable Diffusion reproduziert Bilder realistisch. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr