Heim >Technologie-Peripheriegeräte >KI >Mit nur 3 Beispielen und einem Satz kann KI fotorealistische Bilder anpassen. Google spielt mit einem völlig neuen Diffusionsmodell.

Mit nur 3 Beispielen und einem Satz kann KI fotorealistische Bilder anpassen. Google spielt mit einem völlig neuen Diffusionsmodell.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 15:46:07917Durchsuche

In letzter Zeit sind Text-zu-Bild-Modelle zu einer beliebten Forschungsrichtung geworden. Unabhängig davon, ob es sich um große Naturlandschaften oder neuartige Szenenbilder handelt, können sie mithilfe einfacher Textbeschreibungen automatisch generiert werden.

Unter anderem ist das Rendern wilder und imaginärer Szenen eine herausfordernde Aufgabe, bei der Instanzen bestimmter Themen (Objekte, Tiere usw.) in neuen Szenen so zusammengesetzt werden müssen, dass sie sich natürlich und nahtlos in die Szene einfügen.

Einige groß angelegte Text-zu-Bild-Modelle erreichen eine qualitativ hochwertige und vielfältige Bildsynthese basierend auf in natürlicher Sprache geschriebenen Textansagen. Der Hauptvorteil dieser Modelle sind die starken semantischen Priorisierungen, die aus einer großen Anzahl von Bild-Text-Beschreibungspaaren gelernt werden, beispielsweise die Zuordnung des Wortes „Hund“ zu verschiedenen Instanzen von Hunden, die in unterschiedlichen Posen im Bild erscheinen können.

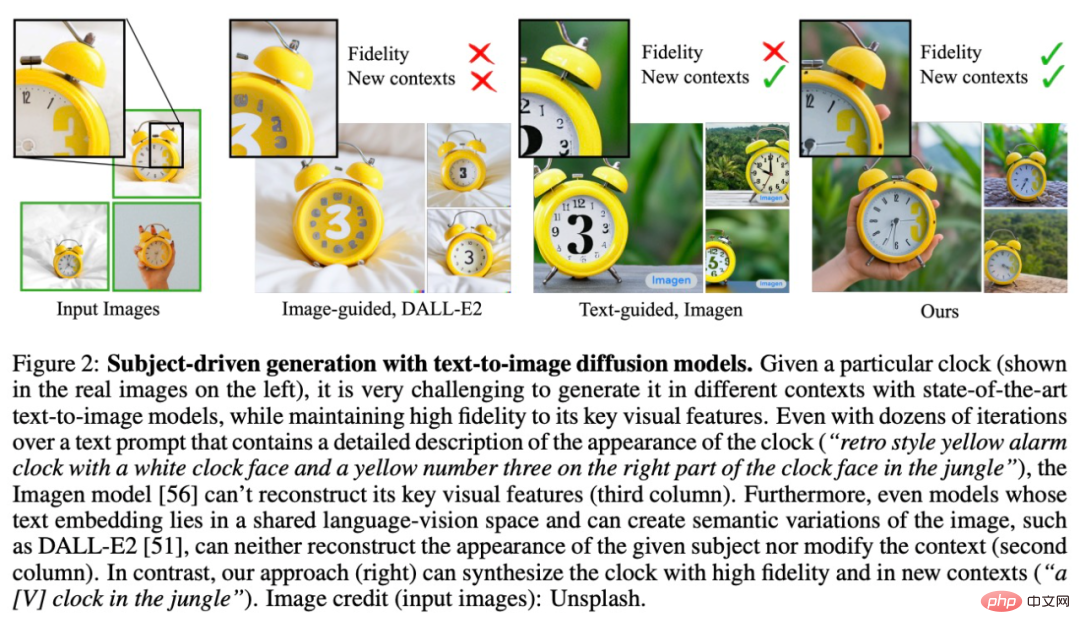

Während die Synthesefähigkeiten dieser Modelle beispiellos sind, fehlt ihnen die Fähigkeit, ein bestimmtes Referenzmotiv zu imitieren und neue Bilder mit demselben Motiv, aber unterschiedlichen Instanzen in unterschiedlichen Szenen zu synthetisieren. Es ist ersichtlich, dass die Ausdrucksfähigkeit des Ausgabebereichs vorhandener Modelle begrenzt ist.

Um dieses Problem zu lösen, haben Forscher von Google und der Boston University ein „personalisiertes“ Text-zu-Bild-Diffusionsmodell DreamBooth vorgeschlagen, das sich an die spezifischen Bilderzeugungsbedürfnisse der Benutzer anpassen kann.

Papieradresse: https://arxiv.org/pdf/2208.12242.pdf

Projektadresse: https://github.com/XavierXiao/Dreambooth-Stable-Diffusion

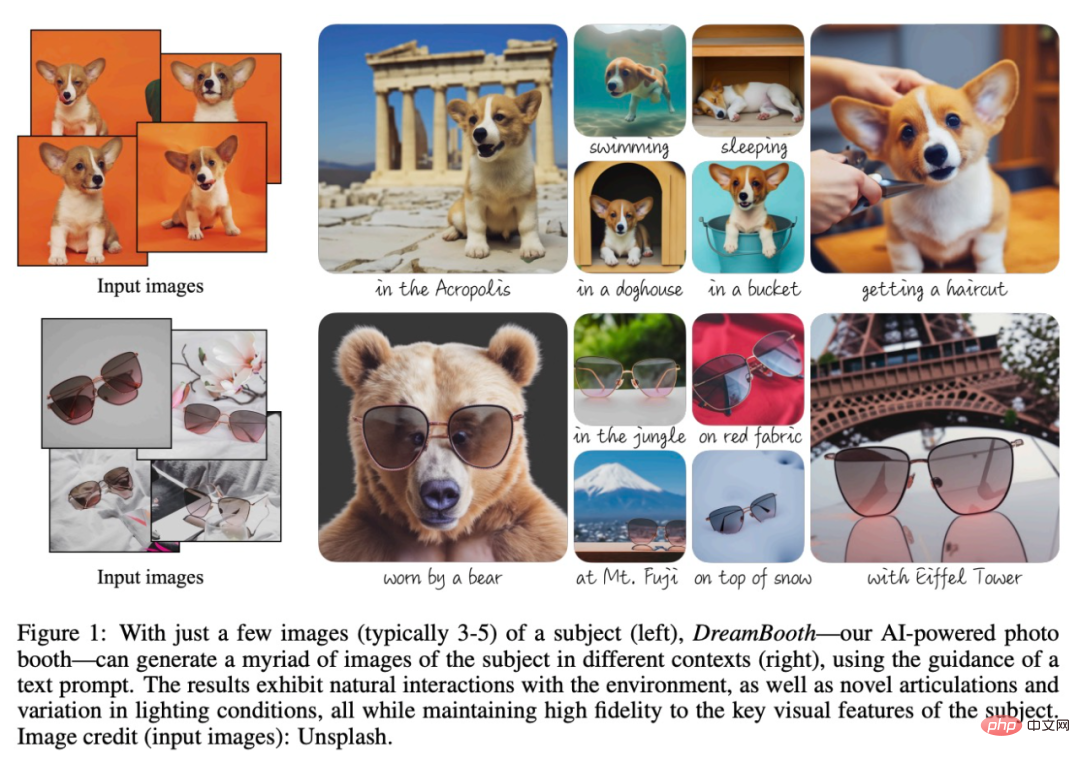

Ziel der Forschung ist es, das sprachlich-visuelle Wörterbuch des Modells so zu erweitern, dass es neues Vokabular an spezifische Themen bindet, die der Benutzer generieren möchte. Sobald das neue Wörterbuch in das Modell eingebettet ist, kann es diese Wörter verwenden, um neuartige und realistische Bilder zu bestimmten Themen zu synthetisieren und sie gleichzeitig in verschiedenen Szenen zu kontextualisieren, wobei wichtige Erkennungsmerkmale erhalten bleiben, wie in Abbildung 1 unten dargestellt.

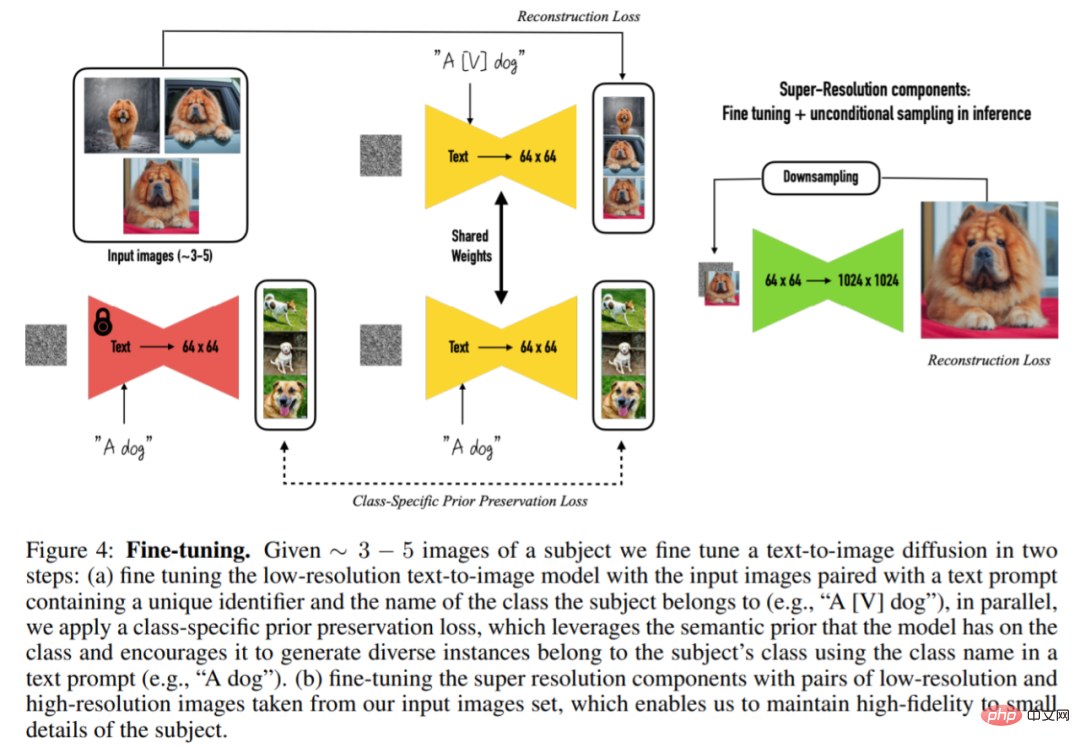

Konkret wurden im Rahmen der Studie Bilder eines bestimmten Subjekts in den Ausgabebereich des Modells implantiert, sodass sie mithilfe einer eindeutigen Kennung synthetisiert werden konnten. Zu diesem Zweck schlägt die Studie eine Methode zur Darstellung eines bestimmten Themas mit einem seltenen Token-Identifikator vor und optimiert ein vorab trainiertes, diffusionsbasiertes Text-zu-Bild-Framework, das in zwei Schritten arbeitet und aus Textbildern eine niedrige Auflösung generiert , und wenden Sie dann ein Super-Resolution (SR)-Diffusionsmodell an.

Zunächst verfeinerte die Studie ein Text-zu-Bild-Modell mit niedriger Auflösung mithilfe von Eingabebildern und Texthinweisen, die eindeutige Identifikatoren enthielten (mit Subjektklassennamen wie „A [V] Hund“). Um zu verhindern, dass das Modell Klassennamen zu stark an bestimmte Instanzen anpasst und semantische Abweichungen verursacht, schlägt diese Studie einen selbstgenerierten, klassenspezifischen vorherigen Erhaltungsverlust vor, der die vorherige Semantik der im Modell eingebetteten Klassen ausnutzt, um das Modell zur Generierung verschiedener Instanzen von zu ermutigen die gleiche Klasse unter einem bestimmten Thema.

Im zweiten Schritt verwendet die Studie niedrigaufgelöste und hochauflösende Versionen des Eingabebildes, um die Superauflösungskomponente zu verfeinern. Dadurch kann das Modell kleine, aber wichtige Details im Motiv der Szene mit hoher Genauigkeit beibehalten.

Werfen wir einen Blick auf die spezifischen Methoden, die in dieser Studie vorgeschlagen werden.

Einführung in die Methode

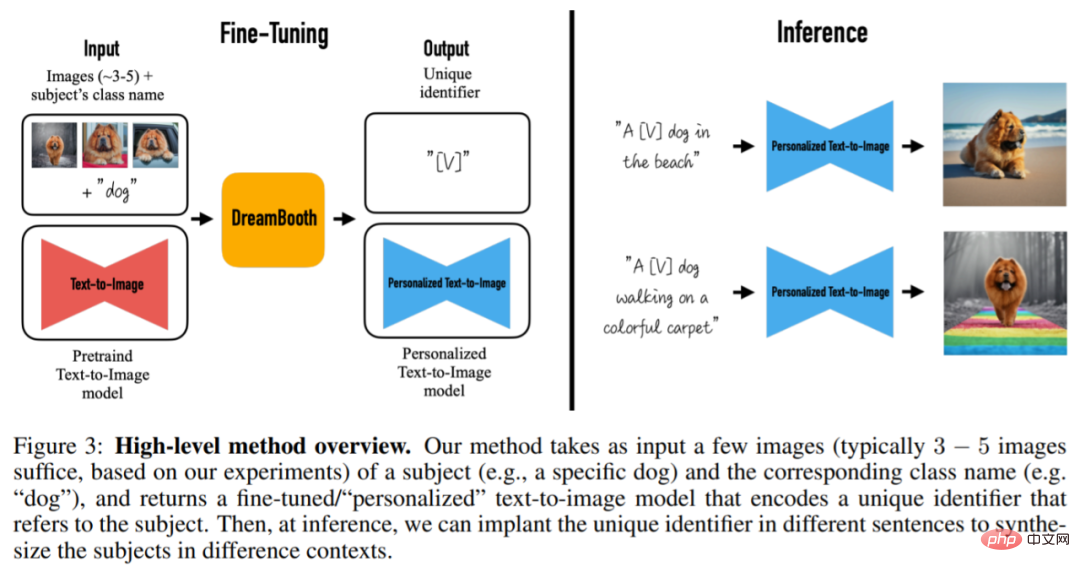

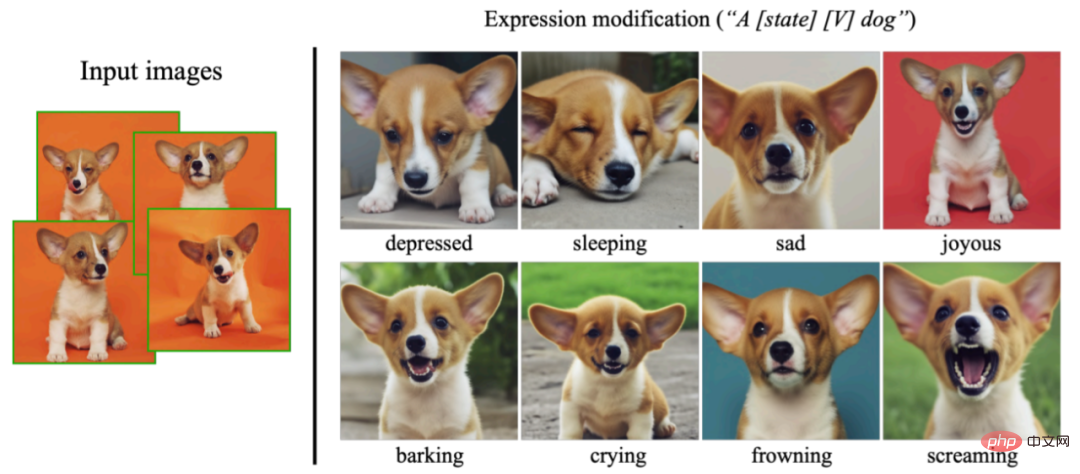

Anhand von 3-5 aufgenommenen Bildern ohne Textbeschreibungen zielt dieser Artikel darauf ab, neue Bilder mit hoher Detailtreue und durch Texthinweise gesteuerten Änderungen zu generieren. Die Studie erlegt den Eingabebildern keine Beschränkungen auf und die Motivbilder können unterschiedliche Kontexte haben. Die Methode ist in Abbildung 3 dargestellt. Das Ausgabebild kann das Originalbild ändern, z. B. die Position des Motivs, die Eigenschaften des Motivs wie Farbe und Form ändern und die Haltung, den Ausdruck, das Material und andere semantische Modifikationen des Motivs modifizieren.

Genauer gesagt nimmt diese Methode als Eingabe einige Bilder (normalerweise 3–5 Bilder) eines Motivs (z. B. eines bestimmten Hundes) und den entsprechenden Klassennamen (z. B. die Hundekategorie) und gibt ein fein abgestimmtes Ergebnis zurück / Personalisiertes Text-zu-Bild-Modell, das eine eindeutige Kennung kodiert, die sich auf ein Thema bezieht. Während des Schlussfolgerns können dann eindeutige Bezeichner in verschiedene Sätze eingebettet werden, um Themen in unterschiedlichen Kontexten zu synthetisieren.

Die erste Aufgabe der Forschung besteht darin, Themeninstanzen in die Ausgabedomäne des Modells zu implantieren und die Themen mit eindeutigen Bezeichnern zu verknüpfen. In dieser Studie werden Methoden zum Entwerfen von Identifikatoren sowie eine neue Methode zur Überwachung des Modellfeinabstimmungsprozesses vorgeschlagen.

Um das Problem der Bildüberanpassung und der Sprachdrift zu lösen, schlägt diese Studie auch einen Verlust (Prior-Preservation Loss) vor, um die Modellüberanpassung zu lindern, indem das Diffusionsmodell dazu ermutigt wird, kontinuierlich verschiedene Instanzen derselben Klasse wie das Subjekt zu generieren Probleme wie Integration und Sprachdrift.

Um Bilddetails zu erhalten, ergab die Studie, dass die Superauflösungskomponente (SR) des Modells feinabgestimmt werden sollte. Dieser Artikel wurde auf der Grundlage des vorab trainierten Imagen-Modells fertiggestellt. Der spezifische Prozess ist in Abbildung 4 dargestellt. Bei 3–5 Bildern desselben Themas wird das Text-zu-Bild-Diffusionsmodell dann in zwei Schritten verfeinert: Thema

Effektanzeige

Das Folgende ist eine stabile Diffusionsimplementierung von Dreambooth (siehe Projektlink). Qualitative Ergebnisse: Die Trainingsbilder stammen aus der Bibliothek „Textual Inversion“:

Nach Abschluss des Trainings lauten die vom Modell generierten Containerfotos unter der Eingabeaufforderung „Foto eines SKS-Containers“ wie folgt:

Fügen Sie bei der Eingabeaufforderung eine Position „Foto eines Sks-Containers am Strand“ hinzu, und der Container erscheint am Strand.

Der grüne Container hat eine zu einfache Farbe Wenn Sie etwas Rot hinzufügen möchten, geben Sie die Eingabeaufforderung „Foto eines roten SKS-Behälters“ ein. Sie können es erhalten:

Im Folgenden sind einige Ergebnisse aufgeführt, die in der Arbeit gezeigt werden. Erstellen Sie künstlerische Bilder über Hunde in verschiedenen Künstlerstilen:

Diese Forschung kann auch verschiedene Ausdrücke synthetisieren, die nicht im Eingabebild erscheinen, was die Extrapolationsfähigkeit des Modells demonstriert:

Weitere Einzelheiten finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonMit nur 3 Beispielen und einem Satz kann KI fotorealistische Bilder anpassen. Google spielt mit einem völlig neuen Diffusionsmodell.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr