Heim >Technologie-Peripheriegeräte >KI >VideoMAE: Ein neues Paradigma für einfaches und effizientes selbstüberwachtes Vortraining per Video

VideoMAE: Ein neues Paradigma für einfaches und effizientes selbstüberwachtes Vortraining per Video

- 王林nach vorne

- 2023-04-12 15:28:081425Durchsuche

Papierlink: https://arxiv.org/abs/2203.12602

Der Code und die vorab trainierten Gewichte wurden als Open Source auf Github bereitgestellt: https://github.com/MCG-NJU/VideoMAE#🎜🎜 ##🎜🎜 #

Inhalt1. Forschungsmotivation4. VideoMAE-Implementierungsdetails#🎜🎜 #5. Ablationsexperiment7. Hauptergebnisse9. Zusammenfassung

#🎜 🎜#Hintergrundeinführung

Video Selbstüberwachtes Lernen: Ohne die Verwendung von Etiketteninformationen lernen wir räumlich-zeitliche Darstellungsinformationen aus Videodaten, indem wir selbstüberwachte Agentenaufgaben entwerfen. Bestehende selbstüberwachte Pre-Training-Algorithmen für Videos werden hauptsächlich in zwei Kategorien unterteilt: (1) Selbstüberwachte Methoden, die auf kontrastivem Lernen basieren, wie CoCLR, CVRL usw. (2) Selbstüberwachte Methoden basierend auf zeitreihenbezogenen Agentenaufgaben, wie DPC, SpeedNet, Pace usw.

Aktionserkennung: Klassifizieren Sie das gegebene zugeschnittene Video (zugeschnittenes Video) und identifizieren Sie die Aktionen der Charaktere in diesem Video. Die aktuellen Mainstream-Methoden sind 2D-basiert (TSN, TSM, TDN usw.), 3D-basiert (I3D, SlowFast usw.) und Transformer-basiert (TimeSformer, ViViT, MViT, VideoSwin usw.). Als grundlegende Aufgabe im Videobereich wird die Aktionserkennung häufig als Backbone-Netzwerk (Backbone) für verschiedene nachgelagerte Aufgaben im Videobereich (z. B. zeitliche Verhaltenserkennung, räumlich-zeitliche Aktionserkennung) verwendet, um raumzeitliche Merkmale auf der gesamten Videoebene zu extrahieren auf Videoclip-Ebene.

Forschungsmotivation

Seit Ende 2020 das visuelle Selbstaufmerksamkeitsmodell (Vision Transformer) vorgeschlagen wurde, ist Transformer weit verbreitet im Bereich Computer Vision und trug dazu bei, die Leistung bei einer Reihe von Computer Vision-Aufgaben zu verbessern.

Vision Transformer muss jedoch große beschriftete Datensätze für das Training nutzen. Ursprünglich erzielte der ursprüngliche ViT (Vanilla Vision Transformer) durch überwachtes Vortraining mit Hunderten Millionen beschrifteten Bildern eine gute Leistung. Aktuelle Videotransformatoren basieren normalerweise auf Vision Transformer-Modellen, die auf Bilddaten trainiert wurden (z. B. TimeSformer, ViViT usw.) und basieren auf vorab trainierten Modellen großer Bilddaten (z. B. ImageNet-1K, ImageNet-21K, JFT). 300M usw.). TimeSformer und ViViT haben beide versucht, das Video Transformer-Modell im Videodatensatz von Grund auf zu trainieren, konnten jedoch keine zufriedenstellenden Ergebnisse erzielen. Daher ist es immer noch ein dringendes Problem, das gelöst werden muss, wie Video Transformer, insbesondere das ursprüngliche ViT (Vanilla Vision Transformer), direkt auf Videodatensätzen effektiv trainiert werden kann, ohne andere vorab trainierte Modelle oder zusätzliche Bilddaten zu verwenden. Es ist zu beachten, dass vorhandene Videodatensätze im Vergleich zu Bilddatensätzen relativ klein sind. Beispielsweise umfasst der weit verbreitete Kinectics-400-Datensatz nur mehr als 200.000 Trainingsbeispiele. Die Anzahl der Beispiele beträgt etwa 1/50 des ImageNet-21K-Datensatzes und 1/1500 des JFT-300M-Datensatzes Lücke von mehreren Größenordnungen. Gleichzeitig ist der Rechenaufwand für das Training eines Videomodells im Vergleich zum Training eines Bildmodells auch viel höher. Dies erhöht die Schwierigkeit, Video Transformer anhand von Videodatensätzen zu trainieren, weiter.

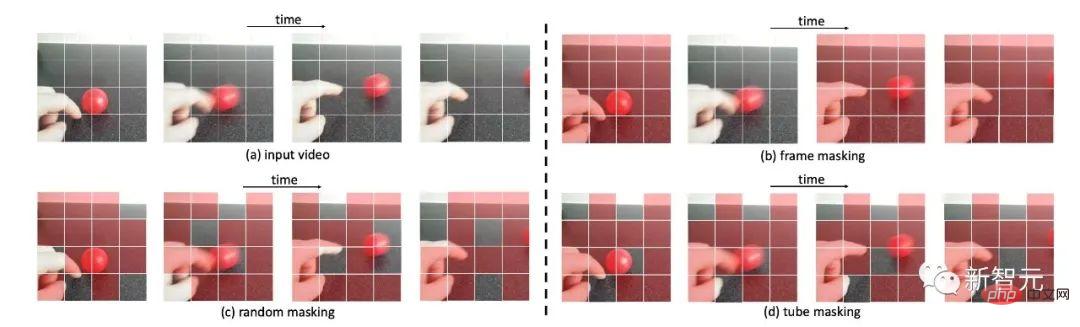

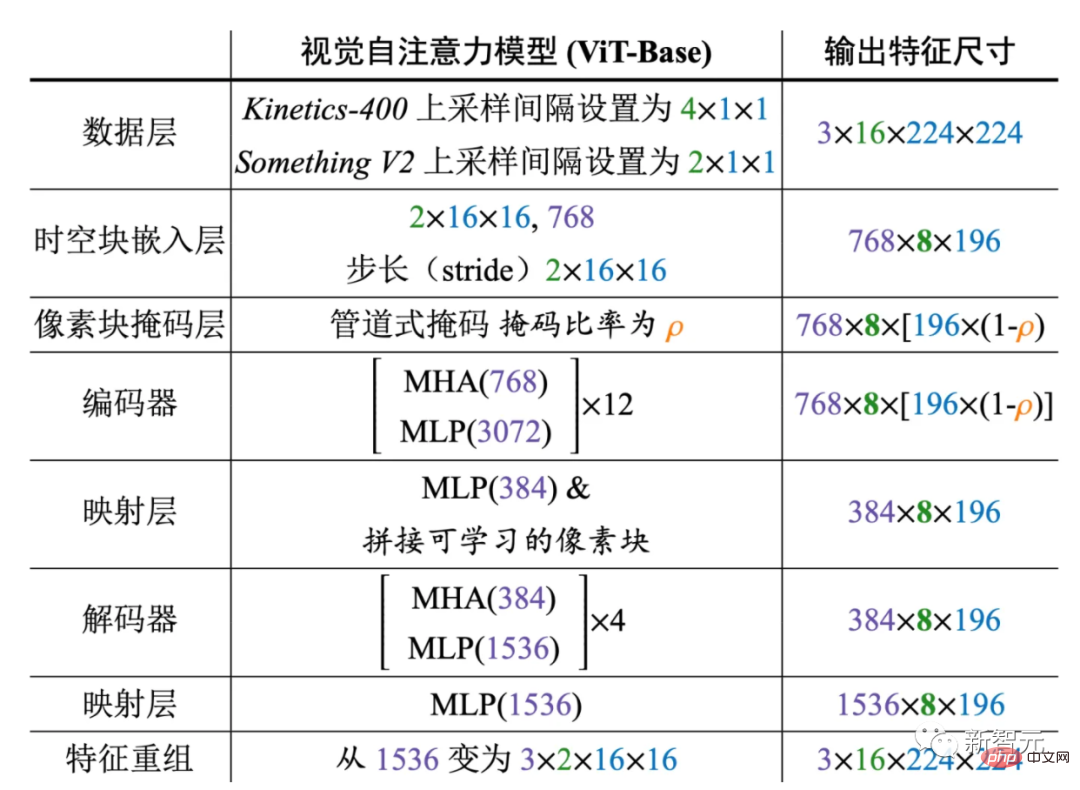

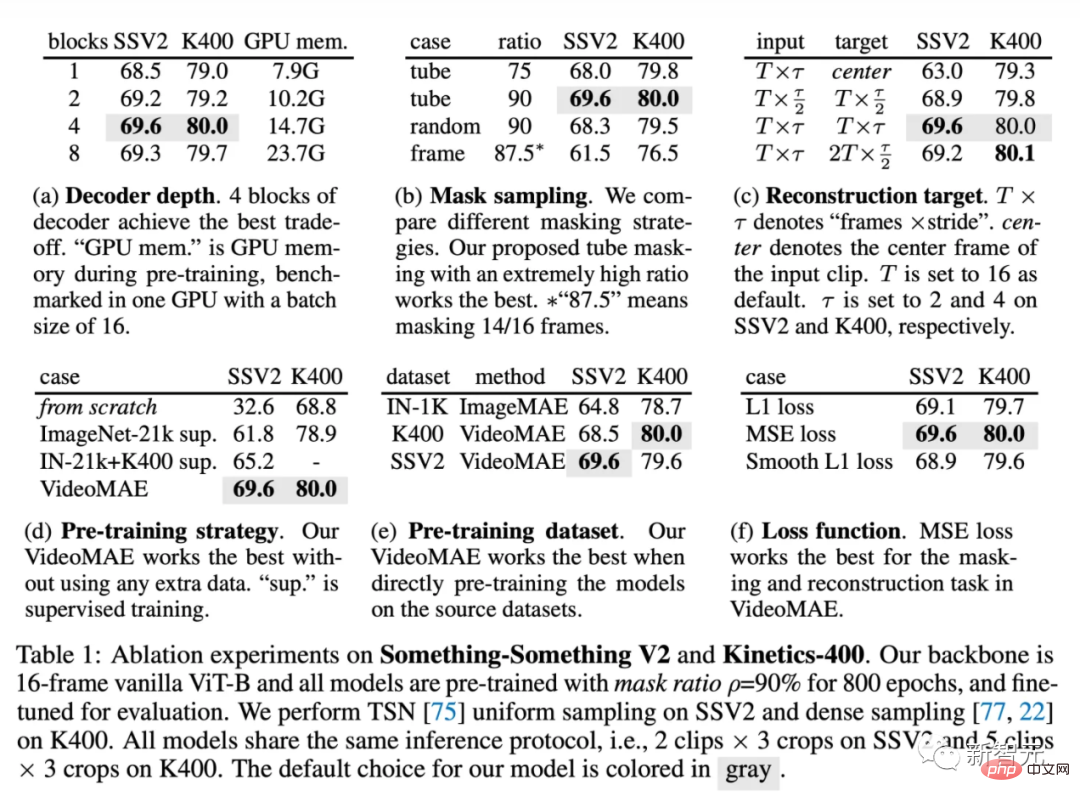

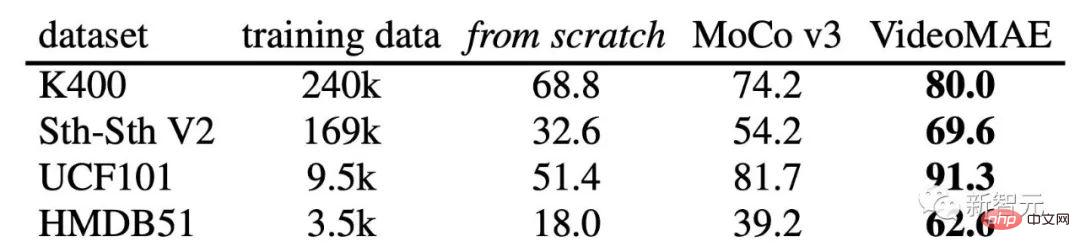

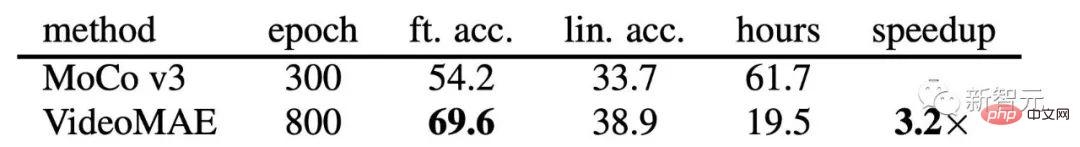

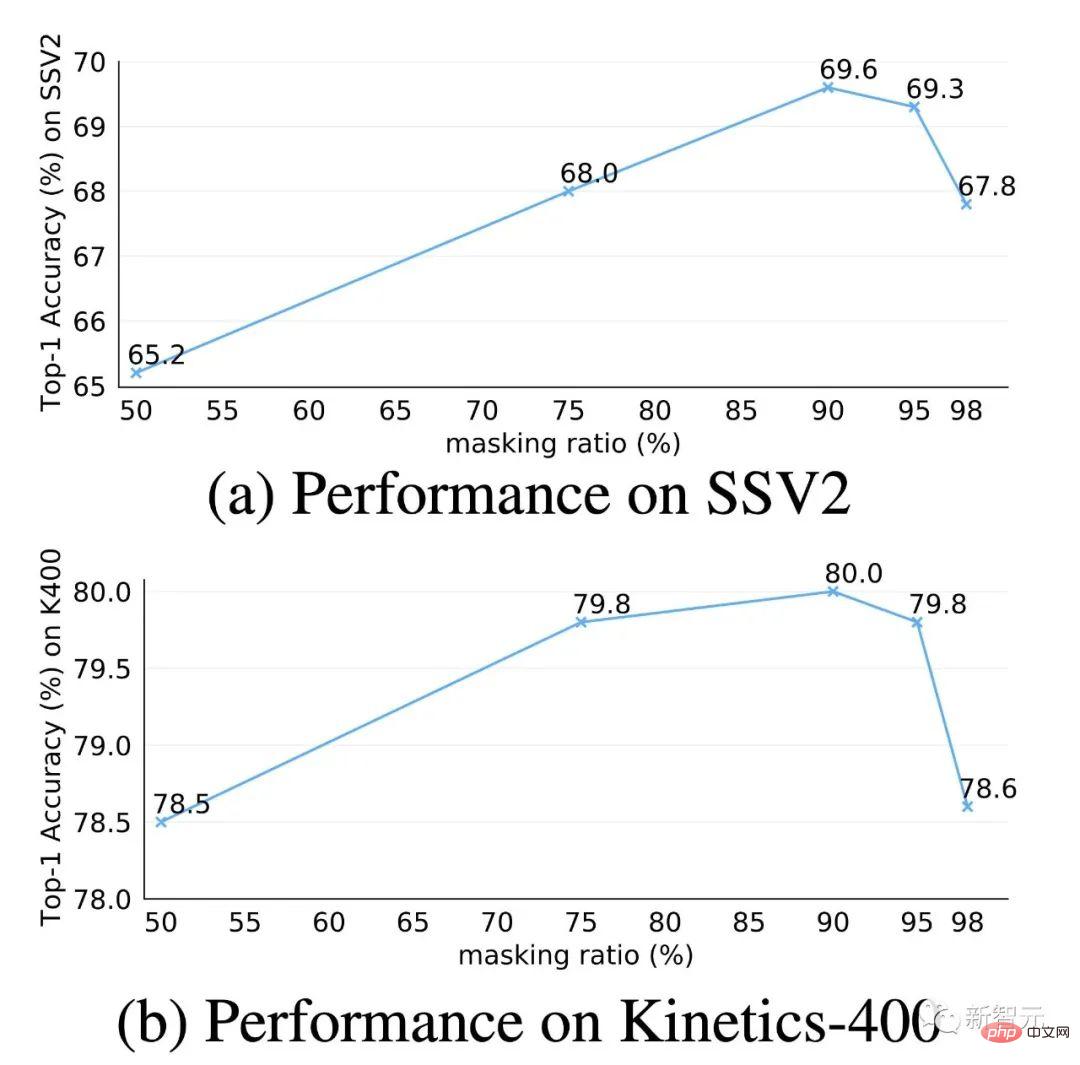

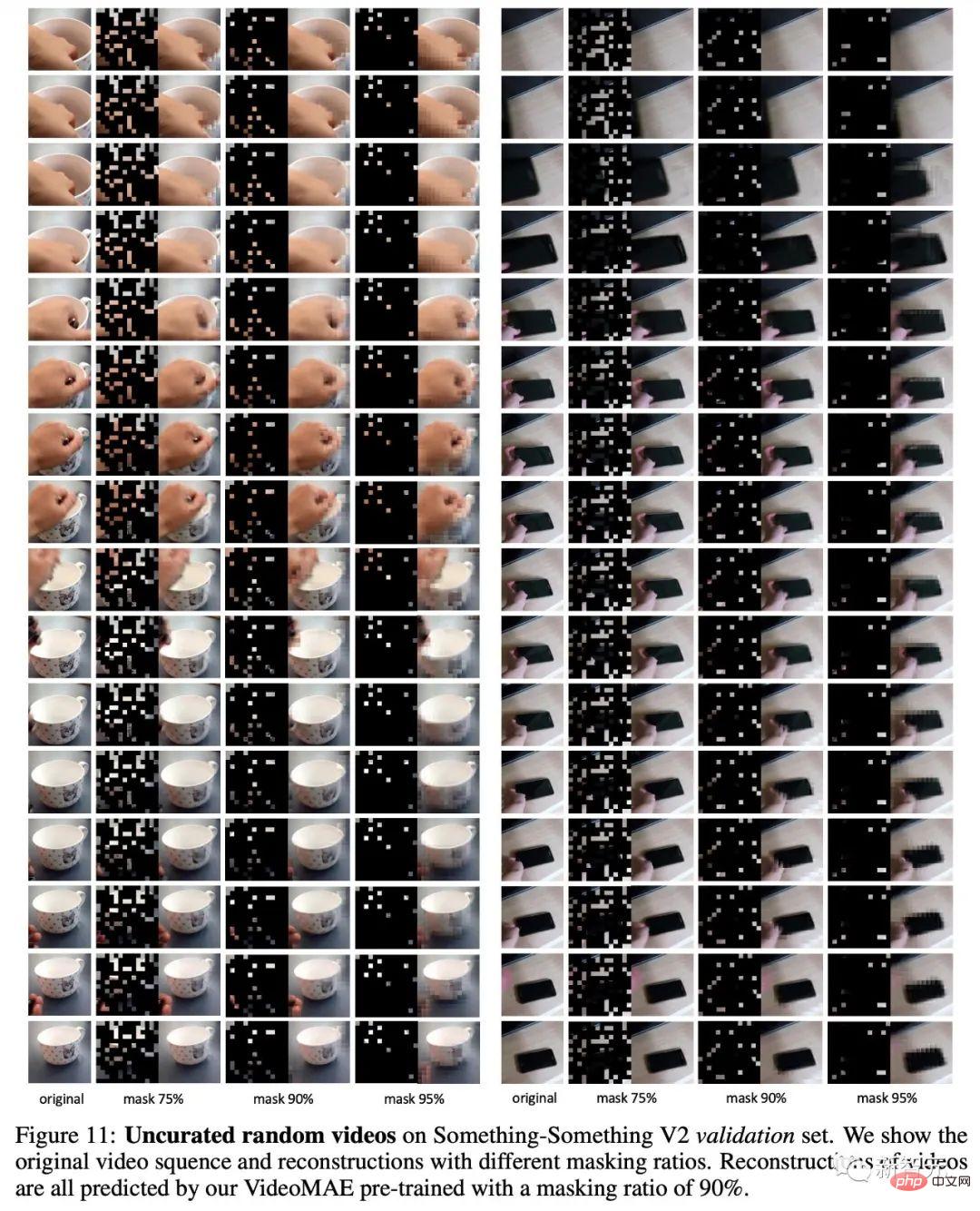

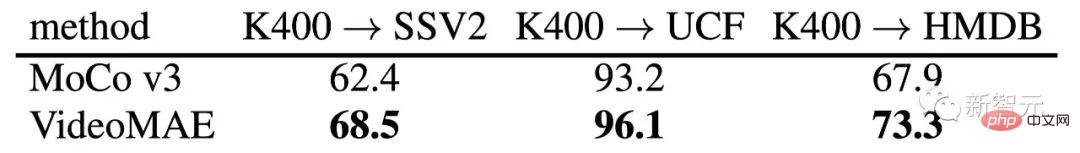

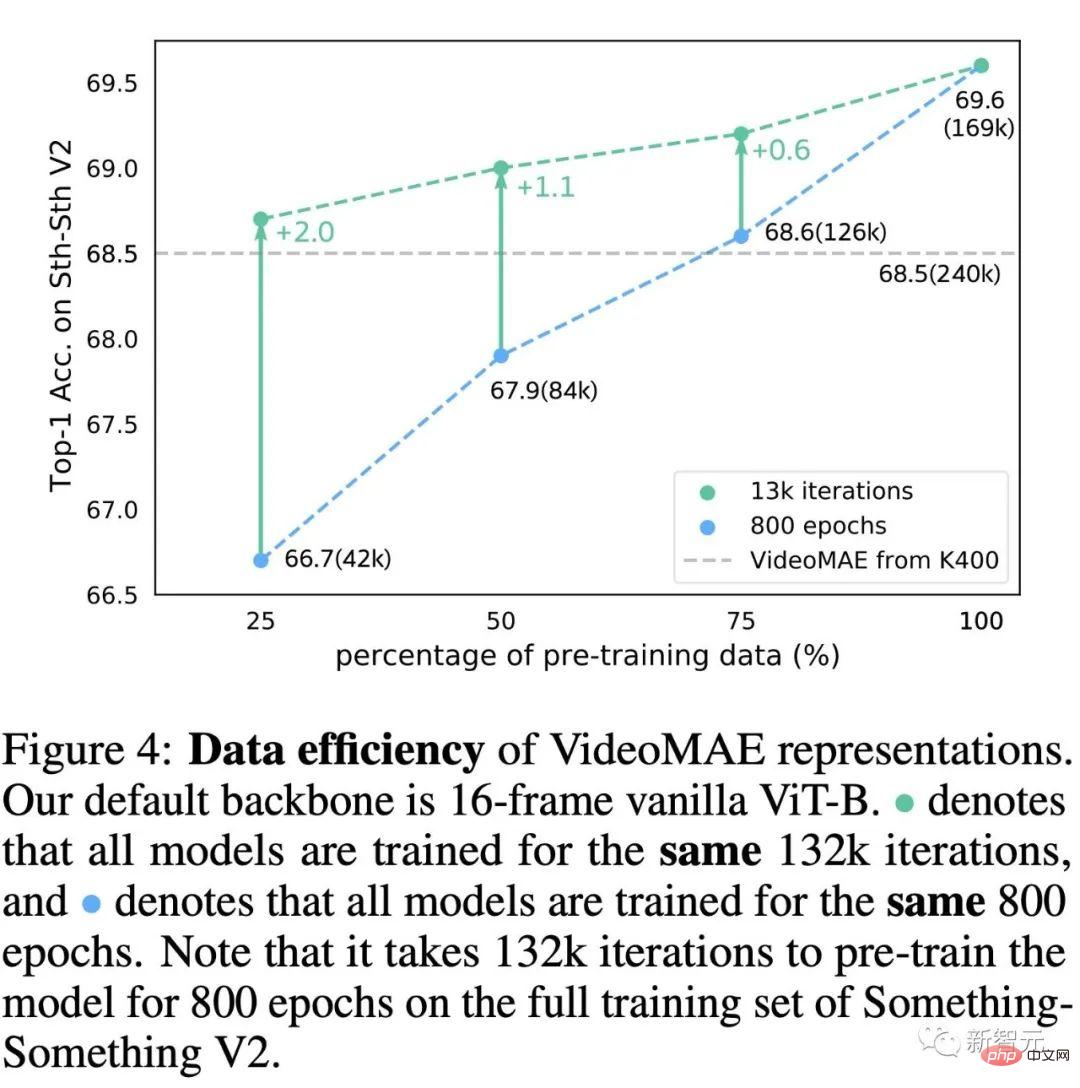

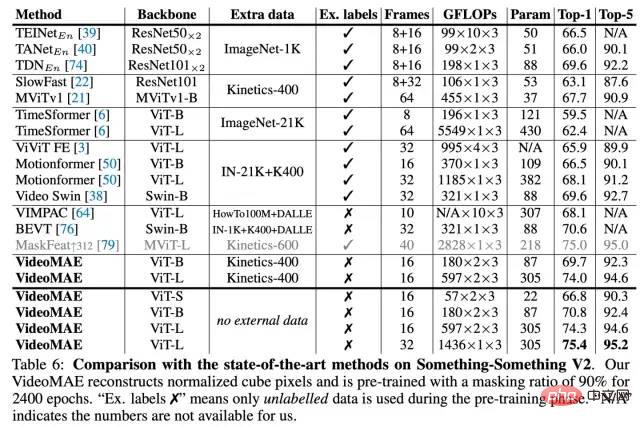

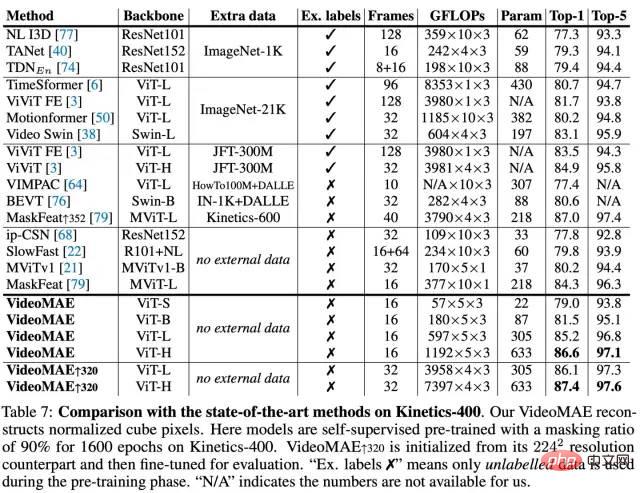

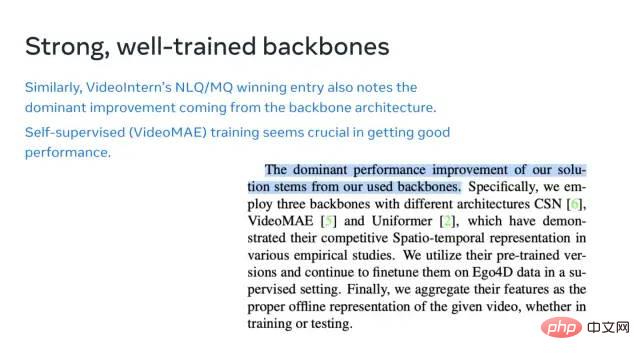

In letzter Zeit wird das selbstüberwachte Trainingsparadigma der „Maskierung und Rekonstruktion“ häufig in der Verarbeitung natürlicher Sprache (BERT) und im Bildverständnis (BEiT) eingesetzt. MAE). Daher versuchen wir, dieses selbstüberwachte Paradigma zu verwenden, um Video Transformer anhand von Videodatensätzen zu trainieren, und schlagen einen selbstüberwachten Video-Pre-Training-Algorithmus VideoMAE (Video Masked Autoencoder) vor. Das von VideoMAE vorab trainierte ViT-Modell kann bei größeren Videodatensätzen wie Kinetics-400 und Something-Something V2 sowie bei relativ kleinen Videodatensätzen wie UCF101 und HMDB51 deutlich bessere Ergebnisse erzielen als andere Methoden.MAE verwendet eine asymmetrische Encoder-Decoder-Architektur, um selbstüberwachte Vortrainingsaufgaben der Maskierung und Rekonstruktion durchzuführen. Ein Eingabebild mit einer Auflösung von 224 x 224 wird zunächst in nicht überlappende visuelle Pixelblöcke (Tokens) der Größe 16 × 16 unterteilt. Jeder Pixelblock (Token) wird durch einen Blockeinbettungsvorgang (Tokeneinbettung) in ein hochdimensionales Merkmal umgewandelt. MAE verwendet ein höheres Maskierungsverhältnis (75 %), um einige Pixelblöcke (Tokens) zufällig auszublenden. Nach dem Maskierungsvorgang werden die verbleibenden Pixelblöcke zur Merkmalsextraktion an den Encoder gesendet. Unmittelbar danach werden die vom Encoder extrahierten Feature-Blöcke mit einem anderen Teil voreingestellter lernbarer Pixelblöcke (lernbare Token) gespleißt, um Features zu bilden, die so groß sind wie die ursprüngliche Eingabebildgröße. Schließlich wird ein leichter Decoder verwendet, um das Originalbild basierend auf diesen Merkmalen zu rekonstruieren (im eigentlichen Experimentprozess ist das Rekonstruktionsziel der normalisierte Pixelblock (normalisiertes Token). Verglichen mit dem Bild Daten, Videodaten enthalten mehr Frames und umfangreichere Bewegungsinformationen. In diesem Abschnitt werden zunächst die Eigenschaften verschiedener Maskierungsstrategien für Daten analysiert Die in diesen Bildrahmen enthaltenen Informationen ändern sich im Laufe der Zeit sehr langsam. Es ist ersichtlich, dass die Farbbildrahmen stark redundant sind. Diese Redundanz kann bei der Implementierung von MAE zu zwei Problemen führen . Erstens, wenn die dichte Bildrate des Originalvideos (z. B. 30 FPS) für das Vortraining verwendet wird, ist die Trainingseffizienz sehr gering, da das Netzwerk bei dieser Einstellung den statischen Darstellungsfunktionen mehr Aufmerksamkeit schenkt Zweitens führt die zeitliche Redundanz im Video zu einer erheblichen Verwässerung der Bewegungseigenschaften. Daher ist die Rekonstruktion der maskierten Pixelblöcke bei normalen Maskierungsraten relativ einfach Diese Probleme betreffen Backbone als Encoder. Das Video wird durch die Entwicklung statischer Bilder erzeugt Daher besteht auch eine semantische Korrespondenz zwischen Videobildern. Ohne eine gezielte Maskierungsstrategie kann diese zeitliche Korrelation das Risiko eines „Informationsverlusts“ während des Rekonstruktionsprozesses erhöhen. Insbesondere, wie in der Abbildung gezeigt, wenn eine globale Zufallsmaske verwendet wird Es wird ein zufälliger Maskenbildrahmen verwendet. Das Netzwerk kann die zeitliche Korrelation im Video verwenden, um eine Pixelblockrekonstruktion durch „Kopieren und Einfügen“ der nicht verdeckten Pixelblöcke an den entsprechenden zeitlichen Positionen in benachbarten Bildern durchzuführen. In diesem Fall kann die Proxy-Aufgabe dies tun Bis zu einem gewissen Grad kann dies auch dazu führen, dass VideoMAE nur niedrigere semantische zeitliche Korrespondenzfunktionen erlernt, anstatt abstrakte semantische Informationen auf hoher Ebene, wie z. B. räumlich-zeitliche Argumentationsfunktionen für Videoinhalte Es muss eine neue Maskierungsstrategie entwickelt werden, damit das Netzwerk die räumlich-zeitliche Merkmalsdarstellung im Video besser lernen kann Gesamtrahmen von VideoMAE . Gemäß der vorherigen Analyse der zeitlichen Redundanz, die in dichten kontinuierlichen Bildern in Videos vorhanden ist, haben wir uns für eine Sampling-Strategie mit zeitlichen Intervallen in VideoMAE entschieden, um einen effizienteren selbstüberwachten Vorhersagezug für Videos zu ermöglichen. Konkret wird zunächst ein Videosegment, das aus $t$ aufeinanderfolgenden Frames besteht, zufällig aus dem Originalvideo ausgewählt. Die Videoclips werden dann durch zeitlich beabstandetes Sampling in Frames komprimiert, die jeweils Vor der Eingabe in den Encoder werden die abgetasteten Videoclips in Pixelblöcken in Form einer räumlich-zeitlichen Verbindung eingebettet. Insbesondere werden visuelle Pixel der Größe Um das durch zeitliche Redundanz und zeitliche Korrelation in Videodaten verursachte „Informationsleck“-Problem zu lösen, wählt diese Methode eine Pipeline-Maskierungsstrategie, die in der Überwachung verwendet wird Vortrainingsprozess. Die Pipeline-Maskierungsstrategie kann natürlich die Maskierungsmethode eines einzelnen Frame-Farbbilds auf die gesamte Videosequenz erweitern, d. h. visuelle Pixelblöcke an derselben räumlichen Position in verschiedenen Frames werden maskiert. Insbesondere kann die Pipeline-Maskierungsstrategie als ausgedrückt werden. Unterschiedliche Zeiten haben denselben Wert. Mit dieser Maskierungsstrategie werden Token an derselben räumlichen Position immer maskiert. Daher kann das Netzwerk bei einigen visuellen Pixelfeldern (z. B. dem Pixelfeld, das den Finger in Zeile 4 des Beispielbilds mit unterschiedlichen Maskierungsstrategien enthält) den entsprechenden Teil in anderen Frames nicht finden. Dieses Design trägt dazu bei, das Risiko eines „Informationslecks“ während des Rekonstruktionsprozesses zu verringern, indem es VideoMAE ermöglicht, das maskierte Token zu rekonstruieren, indem es semantische Informationen auf hoher Ebene aus dem Originalvideoclip extrahiert. Im Vergleich zu Bilddaten weisen Videodaten eine stärkere Redundanz auf und die Informationsdichte von Videodaten ist viel geringer als die von Bildern. Diese Funktion ermöglicht es VideoMAE, extrem hohe Maskenraten (z. B. 90 % bis 95 %) für das Vortraining zu verwenden. Es ist erwähnenswert, dass die Standardmaskierungsrate von MAE 75 % beträgt. Experimentelle Ergebnisse zeigen, dass die Verwendung einer extrem hohen Maskenrate nicht nur das Vortraining beschleunigen kann (nur 5 bis 10 % der visuellen Pixelblöcke werden in den Encoder eingegeben), sondern auch die Darstellungsfähigkeit des Modells und die Wirkung im Downstream verbessern kann Aufgaben. Wie im vorherigen Artikel erwähnt, verwendet VideoMAE eine extrem hohe Maskierungsrate und behält nur sehr Wenige Token dienen als Eingabe für den Encoder. Um die räumlich-zeitlichen Merkmale dieses Teils des nicht verschlossenen Tokens besser zu extrahieren, entschied sich VideoMAE dafür, das ursprüngliche ViT als Backbone zu verwenden und gleichzeitig die räumlich-zeitliche gemeinsame Selbstaufmerksamkeit in der Aufmerksamkeitsschicht zu verwenden (d. h. ohne das Modell zu ändern). Struktur des ursprünglichen ViT). Daher können alle nicht verschlossenen Token in der Selbstaufmerksamkeitsschicht miteinander interagieren. Die rechnerische Komplexität des räumlich-zeitlichen gemeinsamen Selbstaufmerksamkeitsmechanismus auf Spezifische Designdetails des VideoMAE-Frameworks# 🎜🎜# Die obige Abbildung zeigt das spezifische Architekturdesign des von VideoMAE verwendeten Encoders und Decoders (am Beispiel von ViT-B). Wir bewerten VideoMAE anhand von vier Downstream-Video-Aktionserkennungsdatensätzen und einem Aktionserkennungsdatensatz. Diese Datensätze konzentrieren sich auf verschiedene Aspekte der Bewegungsinformationen in Videos. Kinetics-400 ist ein umfangreicher YouTube-Videodatensatz mit etwa 300.000 zugeschnittenen Videoclips, die 400 verschiedene Aktionskategorien abdecken. Der Kinetics-400-Datensatz enthält hauptsächlich Aktivitäten im täglichen Leben, und einige Kategorien korrelieren stark mit interaktiven Objekten oder Szeneninformationen. Die Videos im Datensatz „Something-Something V2“ enthalten hauptsächlich verschiedene Objekte, die dieselben Aktionen ausführen. Daher konzentriert sich die Aktionserkennung in diesem Datensatz mehr auf Bewegungsattribute als auf Objekt- oder Szeneninformationen. Der Trainingssatz enthält etwa 170.000 Videoclips und der Validierungssatz enthält etwa 25.000 Videoclips. UCF101 und HMDB51 sind zwei relativ kleine Datensätze zur Videoaktionserkennung. Der Trainingssatz von UCF101 enthält etwa 9500 Videos und der Trainingssatz von HMDB51 enthält etwa 3500 Videos. Während des Experiments verwendeten wir zunächst VideoMAE für das selbstüberwachte Vortraining des Netzwerks auf dem Trainingssatz, führten dann eine überwachte Feinabstimmung des Encoders (ViT) auf dem Trainingssatz durch und bewerteten schließlich die Leistung des Modells auf dem Trainingssatz Validierungssatz. Für den Aktionserkennungsdatensatz AVA laden wir zunächst das auf dem Kinetics-400-Datensatz trainierte Modell und führen eine überwachte Feinabstimmung des Encoders (ViT) durch. In diesem Abschnitt werden Ablationsexperimente auf VideoMAE an den Datensätzen Something-Something V2 und Kinetics-400 durchgeführt. Das Ablationsexperiment verwendet standardmäßig das ursprüngliche ViT-Modell mit 16 Eingaberahmen. Gleichzeitig wurden bei der Auswertung nach der Feinabstimmung 2 Videoclips und 3 Ausschnitte zum Testen auf Something-Something V2 und 5 Videoclips und 3 Ausschnitte zum Testen auf Kinetics-400 ausgewählt. Leicht Der Decoder ist eine Schlüsselkomponente bei oMAE. Experimentelle Ergebnisse mit Decodern unterschiedlicher Tiefe sind in Tabelle (a) aufgeführt. Im Gegensatz zu MAE können tiefere Decoder in VideoMAE eine bessere Leistung erzielen, während flachere Decoder die GPU-Speichernutzung effektiv reduzieren können. Die Anzahl der Decoder-Layer ist standardmäßig auf 4 eingestellt. Gemäß dem empirischen Design von MAE wird die Kanalbreite des Decoders in VideoMAE auf die Hälfte der Kanalbreite des Encoders eingestellt (wenn beispielsweise ViT-B als Encoder verwendet wird, wird die Kanalbreite des Decoders auf 384 eingestellt). ). Vergleichen Sie verschiedene Maskierungsstrategien mit der Pipeline-Maskierungsstrategie unter Verwendung eines Maskierungsverhältnisses von 75 %. Wie in Tabelle (b) gezeigt, ist die Leistung der globalen Zufallsmaskierung und der Zufallsmaskierungsbildrahmen schlechter als die der Pipeline-Maskierungsstrategie. Dies kann auf die Tatsache zurückzuführen sein, dass die Pipeline-Maskierungsstrategie die Timing-Redundanz und Timing-Korrelation in den Videodaten bis zu einem gewissen Grad mildern kann. Wenn das Maskenverhältnis auf 90 % erhöht wird, kann die Leistung von VideoMAE bei Something-Something weiter von 68,0 % auf 69,6 % verbessert werden. Das Design der Maskenstrategie und des Maskenverhältnisses in VideoMAE kann die Maskierung und Rekonstruktion zu einer anspruchsvolleren Proxy-Aufgabe machen und das Modell dazu zwingen, räumlich-zeitliche Merkmale auf höherer Ebene zu lernen. Das Rekonstruktionsziel in VideoMAE wird hier verglichen und die Ergebnisse sind in Tabelle (c) aufgeführt. Erstens wird die Leistung von VideoMAE bei nachgelagerten Aufgaben erheblich verringert, wenn nur das mittlere Bild im Videoclip als Rekonstruktionsziel verwendet wird. Gleichzeitig reagiert VideoMAE auch sehr empfindlich auf das Abtastintervall. Wenn Sie sich für die Rekonstruktion eines dichter gepackten Videoclips entscheiden, fallen die Ergebnisse deutlich schlechter aus als beim standardmäßig zeitlich heruntergesampelten Videoclip. Schließlich haben wir auch versucht, die dichteren Frames im Videoclip aus dem zeitlich heruntergesampelten Videoclip zu rekonstruieren, aber diese Einstellung erfordert die Dekodierung von mehr Frames, was das Training langsamer und nicht sehr effektiv macht. Die Strategien vor dem Training in VideoMAE werden hier verglichen und die Ergebnisse sind in Tabelle (d) aufgeführt. Ähnlich wie bei den experimentellen Schlussfolgerungen früherer Methoden (TimeSformer, ViViT) kann das Training von ViT von Grund auf auf Something-Something V2, einem Datensatz, der empfindlicher auf Bewegungsinformationen reagiert, keine zufriedenstellenden Ergebnisse erzielen. Wenn das vorab trainierte ViT-Modell für den großen Bilddatensatz (ImageNet-21K) als Initialisierung verwendet wird, kann eine bessere Genauigkeit erzielt werden, die von 32,6 % auf 61,8 % verbessert werden kann. Die Verwendung von Modellen, die auf ImageNet-21K und Kinetics-400 vorab trainiert wurden, verbesserte die Genauigkeit weiter auf 65,2 %. ViT, das mit VideoMAE aus dem Videodatensatz selbst vorab trainiert wird, kann letztendlich die beste Leistung von 69,6 % erreichen, ohne zusätzliche Daten zu verwenden. Ähnliche Schlussfolgerungen wurden für Kinetics-400 gezogen. Der Datensatz vor dem Training in VideoMAE wird hier verglichen und die Ergebnisse sind in Tabelle (e) aufgeführt. Erstens wird ViT gemäß den Einstellungen von MAE selbstüberwacht und auf ImageNet-1K für 1600 Epochen vorab trainiert. Die 2D-Blockeinbettungsschicht wird dann mithilfe von Strategien in I3D zu einer 3D-raumzeitlichen Blockeinbettungsschicht erweitert, und das Modell wird anhand des Videodatensatzes feinabgestimmt. Dieses Trainingsparadigma kann Modelle übertreffen, die von Grund auf unter Aufsicht trainiert wurden. Als nächstes wurde die Leistung des MAE-vorab trainierten Modells mit dem VideoMAE-vorab trainierten ViT-Modell auf Kinetics-400 verglichen. Es kann festgestellt werden, dass VideoMAE eine bessere Leistung als MAE erzielen kann. Beide vorab trainierten Modelle erzielten jedoch keine bessere Leistung als VideoMAE, das nur selbstüberwacht und vorab auf dem Datensatz „Something-Something V2“ trainiert wurde. Es kann analysiert werden, dass der Domänenunterschied zwischen dem Datensatz vor dem Training und dem Zieldatensatz ein wichtiges Problem sein kann. Die Auswirkung der gesamten Vortrainingsrunden in VideoMAE In Ablationsexperimenten ist die Gesamtzahl der VideoMAE-Vortrainingsrunden standardmäßig auf 800 eingestellt . Wir versuchen, eine eingehende Untersuchung der Epochen vor dem Training anhand der Datensätze Kinetics-400 und Something-Something V2 durchzuführen. Den Ergebnissen in der Abbildung zufolge führt die Verwendung längerer Epochen vor dem Training zu konsistenten Gewinnen bei beiden Datensätzen. Leistungsvergleich von VideoMAE und MoCov3 auf verschiedenen Downstream-Video-Aktionserkennungsdatensätzen Viele frühere Arbeiten haben umfangreiche Untersuchungen zum selbstüberwachten Vortraining per Video durchgeführt, aber diese Methoden verwenden hauptsächlich Faltungs-Neuronale Netze als Rückgrat, und es gibt nur wenige Methoden, um den ViT-basierten Trainingsmechanismus zu untersuchen. Um die Wirksamkeit von ViT-basiertem VideoMAE für das selbstüberwachte Vortraining per Video zu überprüfen, haben wir daher zwei ViT-basierte Trainingsmethoden verglichen: (1) überwachtes Training des Modells von Grund auf, (2) Verwendung einer kontrastiven Lernmethode (MoCo v3) Führen Sie ein selbstüberwachtes Vortraining durch. Den experimentellen Ergebnissen zufolge ist VideoMAE deutlich besser als die beiden anderen Trainingsmethoden. Beispielsweise ist VideoMAE beim Kinetics-400-Datensatz, der die größte Datenmenge aufweist, etwa 10 % genauer als ein Training von Grund auf und etwa 6 % höher als die Ergebnisse des MoCo v3-Vortrainings. Die hervorragende Leistung von VideoMAE zeigt, dass das selbstüberwachte Paradigma der Maskierung und Rekonstruktion einen effizienten Vortrainingsmechanismus für ViT bietet. Gleichzeitig ist zu beachten, dass der Leistungsunterschied zwischen VideoMAE und den beiden anderen Trainingsmethoden immer größer wird, wenn der Trainingssatz kleiner wird. Es ist erwähnenswert, dass das auf VideoMAE basierende vorab trainierte Modell dennoch eine sehr zufriedenstellende Genauigkeit erreichen kann, obwohl der HMDB51-Datensatz nur etwa 3500 Videoclips enthält. Dieses neue Ergebnis zeigt, dass VideoMAE ein dateneffizienter Lerner ist. Dies unterscheidet sich vom kontrastiven Lernen, das für das Vortraining eine große Datenmenge erfordert. Die dateneffizienten Funktionen von VideoMAE sind besonders wichtig in Szenarien, in denen die Videodaten begrenzt sind. Effizienzanalyse von VideoMAE und MoCov3 am Something-SomethingV2-Datensatz Wir haben außerdem die Recheneffizienz der Verwendung von VideoMAE für das Vortraining und der Verwendung von MoCo v3 für das Vortraining weiter verglichen. Aufgrund der äußerst anspruchsvollen Proxy-Aufgabe der Maskierung und Rekonstruktion kann das Netzwerk in jeder Iteration nur 10 % der Eingabedaten beobachten (90 % der Token sind maskiert), sodass VideoMAE mehr Trainingsrunden erfordert. Ein sehr hoher Anteil der Token ist verdeckt. Dieses Design spart erheblich den Rechenaufwand und die Zeit für das Vortraining. Das VideoMAE-Vortraining für 800 Runden dauert nur 19,5 Stunden, während das MoCo v3-Vortraining für 300 Runden 61,7 Stunden dauert. Der Einfluss des Maskierungsverhältnisses in VideoMAE Eine extrem hohe Maskierungsrate ist eines der Kerndesigns in VideoMAE. Wir führen eine eingehende Untersuchung dieses Designs anhand der Datensätze Kinetics-400 und Something-Something V2 durch. Den Ergebnissen in der Abbildung zufolge zeigt das Netzwerk bei einem sehr hohen Maskenverhältnis, sogar 95 %, immer noch eine hervorragende Leistung bei diesen beiden wichtigen Datensätzen für nachgelagerte Videoaktionserkennungsaufgaben. Dieses Phänomen unterscheidet sich erheblich von BERT bei der Verarbeitung natürlicher Sprache und MAE für Bilder. Das Vorhandensein zeitlicher Redundanz und zeitlicher Korrelation in Videodaten ermöglicht VideoMAE den Betrieb mit extrem hohen Maskenverhältnissen im Vergleich zu Bilddaten und natürlicher Sprache. Wir visualisieren auch das Rekonstruktionsbeispiel des vorab trainierten VideoMAE. Aus der Abbildung geht hervor, dass VideoMAE auch bei extrem hohen Maskenraten zufriedenstellende Rekonstruktionsergebnisse liefern kann. Das bedeutet, dass VideoMAE raumzeitliche Merkmale in Videos lernen und extrahieren kann. Leistungsvergleich der Funktionsübertragungsfunktionen zwischen VideoMAE und MoCov3 bei kleineren Datensätzen Um die von VideoMAE erlernten Funktionen weiter zu untersuchen, werden in diesem Abschnitt die Generalisierungs- und Übertragungsfähigkeiten von vorab trainiertem VideoMAE bewertet. Die obige Tabelle zeigt den Übertragungseffekt von VideoMAE, vorab trainiert am Kinetics-400-Datensatz, auf die Datensätze Something-Something V2, UCF101 und HMDB51. Gleichzeitig zeigt die Tabelle auch die Migrationsfähigkeit des mit MoCo v3 vorab trainierten Modells. Den Ergebnissen in der Tabelle zufolge sind die Übertragungs- und Generalisierungsfähigkeiten des mit VideoMAE vorab trainierten Modells besser als die des auf MoCo v3 vorab trainierten Modells. Dies zeigt, dass VideoMAE mehr übertragbare Funktionsdarstellungen lernen kann. Auf dem Kinetics-400-Datensatz vorab trainiertes VideoMAE bietet eine bessere Leistung als direkt auf den UCF101- und HMDB51-Datensätzen vorab trainiertes VideoMAE. Aber das auf dem Kinetics-400-Datensatz vorab trainierte Modell lässt sich schlecht auf den Something-Something V2-Datensatz übertragen. Um die Gründe für diese Inkonsistenz weiter zu untersuchen, haben wir einen Test mit dem Something-Something V2-Datensatz durchgeführt Experimente zur Reduzierung der Anzahl von Pre-Training-Videos. Der Erkundungsprozess umfasst zwei Experimente: (1) Verwendung der gleichen Anzahl von Trainingsrunden (Epoche) für das Vortraining, (2) Verwendung der gleichen Anzahl von Iterationen (Iteration) für das Vortraining. Anhand der Ergebnisse in der Abbildung können wir erkennen, dass die Verwendung weiterer Trainingsiterationen auch die Leistung des Modells verbessern kann, wenn die Anzahl der Proben vor dem Training reduziert wird. Selbst wenn nur 42.000 vorab trainierte Videos verwendet werden, kann VideoMAE, das direkt auf dem Something-Something V2-Datensatz trainiert wurde, immer noch eine bessere Genauigkeit (68,7) erreichen als der vorab trainierte Kinetics-400-Datensatz mit 240.000 Videodaten. Diese Feststellung bedeutet, dass Domänenunterschiede ein weiterer wichtiger Faktor sind, auf den beim selbstüberwachten Vortraining per Video geachtet werden muss. Wenn es Domänenunterschiede zwischen dem Vortrainingsdatensatz und dem Zieldatensatz gibt, ist die Qualität der Vortrainingsdaten wichtiger als die Menge der Daten. Gleichzeitig bestätigt dieser Befund auch indirekt, dass VideoMAE ein dateneffizienter Lerner für das selbstüberwachte Vortraining per Video ist. Experimentelle Ergebnisse des Something-Something V2-Datensatzes # ?? ?? 🎜## 🎜🎜# Ohne die Verwendung zusätzlicher Daten erreichte die Top-1-Genauigkeit von VideoMAE für Something-Something V2 und Kinetics-400 75,4 % bzw. 87,4 %. Es ist zu beachten, dass die aktuellen hochmodernen Methoden für den Something-Something V2-Datensatz stark auf der Initialisierung von Modellen basieren, die auf externen Datensätzen vorab trainiert wurden. Im Gegensatz dazu ist VideoMAE in der Lage, die bisher beste Methode bei der Genauigkeit um etwa 5 % deutlich zu übertreffen, ohne dass externe Daten verwendet werden. VideoMAE kann auch beim Kinetics-400-Datensatz eine hervorragende Leistung erzielen. Bei begrenzten Videodaten (z. B. enthält der UCF101-Datensatz nur weniger als 10.000 Trainingsvideos und HMDB51 nur etwa 3500 Trainingsvideos) muss VideoMAE keine zusätzlichen Bild- und Videodaten verwenden und kann auch in verwendet werden Diese übertreffen die bisherigen besten Methoden für kleine Videodatensätze bei weitem. Experimentelle Ergebnisse des AVA v2.2-Datensatzes #🎜 🎜# Zusätzlich zur herkömmlichen Aktionsklassifizierungsaufgabe haben wir die Darstellungsfähigkeit des VideoMAE-Modells anhand der anspruchsvolleren Verständnisaufgabe der Videoaktionserkennung weiter überprüft. Für Experimente haben wir den Datensatz AVA v2.2 ausgewählt. Im Experiment wird zunächst das vorab trainierte Modell des Kinetics-400-Datensatzes geladen und anschließend ViT auf überwachte Weise feinabgestimmt. Aus der Tabelle geht hervor, dass das von VideoMAE vorab trainierte ViT-Modell sehr gute Ergebnisse für den AVA v2.2-Datensatz erzielen kann. Wenn das selbstüberwachte, vorab trainierte ViT-Modell weiter überwacht und auf Kinetics-400 verfeinert wird, kann es bei der Aktionserkennungsaufgabe eine bessere Leistung erbringen (3 mAP-6mAP-Verbesserung). Dies zeigt auch, dass die Leistung des selbstüberwachten vorab trainierten VideoMAE-Modells weiter verbessert werden kann, indem eine überwachte Feinabstimmung des Upstream-Datensatzes durchgeführt und dann zu Downstream-Aufgaben migriert wird. Wir haben das Modell und den Code von VideoMAE im April dieses Jahres als Open-Source-Lösung bereitgestellt und von der Community weiterhin Aufmerksamkeit und Anerkennung erhalten. Laut der Paper with Code-Liste belegt VideoMAE seit einem halben Jahr (von Ende März 2022 bis 2022) den Spitzenplatz auf den Listen Something-Something V2[1] und AVA 2.2[2]. die Gegenwart). Ohne die Nutzung externer Daten sind die Ergebnisse von VideoMAE für die Datensätze Kinetics-400[3], UCF101[4] und HMDB51[5] ebenfalls die bisher besten. https://huggingface.co/docs/transformers/main/en/model_doc/videomae Vor ein paar Monaten wurde das Modell von VideoMAE in das offizielle Lager von Hugging Face's Transformers aufgenommen. Es ist das erste Videoverständnismodell, das in diesem Repository enthalten ist! In gewisser Weise spiegelt es auch die Anerkennung unserer Arbeit durch die Community wider! Wir hoffen, dass unsere Arbeit eine einfache und effiziente Basismethode für das Transformer-basierte Video-Vortraining bereitstellen und auch nachfolgende Transformer-basierte Videoverständnismethoden inspirieren kann. https://github.com/open-mmlab/mmaction2/tree/dev-1.x/configs/recognition/videomae Das aktuelle Video Understanding Warehouse MMAction2 unterstützt auch die Inferenz des VideoMAE-Modells . Auf dem gerade zu Ende gegangenen 2. Internationalen Ego4D-Workshop des ECCV 2022 hat sich VideoMAE schnell zu einem leistungsstarken Werkzeug entwickelt, das jedem hilft, das Spiel zu spielen. Das Shanghai Artificial Intelligence Laboratory gewann Meisterschaften in mehreren Teilstrecken dieser Ego4D Challenge. Unter ihnen dient VideoMAE als wichtiges Rückgrat und stellt leistungsstarke Videofunktionen für ihre Lösung bereit. Es ist erwähnenswert, dass aus dem ersten Bild oben hervorgeht, dass die Wirkung von VideoMAE (ViT-L), die nur auf Kinetics-400 vorab trainiert wurde, bereits die des IG-65M-Videodatensatzes (ungefähr Kinetics-400) übertreffen kann Beispieldaten 300 Mal) auf vorab trainiertem ir-CSN-152. Dies bestätigt auch die leistungsstarke Darstellungsfähigkeit des vorab trainierten VideoMAE-Modells. Die Hauptbeiträge unserer Arbeit umfassen die folgenden drei Aspekte: • Wir sind die ersten, die VideoMAE vorschlagen, ein selbstüberwachtes Pre-Training-Framework per Video, das auf ViT-Maskierung und -Rekonstruktion basiert. Selbst mit selbstüberwachtem Vortraining an kleineren Videodatensätzen kann VideoMAE immer noch eine hervorragende Leistung erzielen. Um das durch zeitliche Redundanz und zeitliche Korrelation verursachte Problem des „Informationsverlusts“ zu lösen, schlagen wir eine Röhrenmaskierung mit einer extrem hohen Maskierungsrate vor. Experimente zeigen, dass dieses Design der Schlüssel zur ultimativen Fähigkeit von VideoMAE ist, SOTA-Effekte zu erzielen. Gleichzeitig wird aufgrund der asymmetrischen Encoder-Decoder-Architektur von VideoMAE der Rechenverbrauch des Vortrainingsprozesses erheblich reduziert, was die Zeit des Vortrainingsprozesses erheblich spart. • VideoMAE hat die Erfahrung im NLP- und Bildbereich auf natürliche, aber wertvolle Weise erfolgreich auf den Bereich des Videoverständnisses ausgeweitet und bestätigt, dass einfache Proxy-Aufgaben, die auf Maskierung und Rekonstruktion basieren, zur Selbstüberwachung verwendet werden können Videovorhersagetraining bietet eine einfache, aber äußerst effektive Lösung. Nach der Verwendung von VideoMAE für das selbstüberwachte Vortraining ist die Leistung des ViT-Modells bei nachgelagerten Aufgaben im Bereich des Videoverständnisses (z. B. Aktionserkennung, Aktionserkennung) deutlich besser als beim Training von Grund auf (Train from Scratch) oder beim kontrastiven Lernen Methoden (kontrastives Lernen). • Es gibt zwei interessante Erkenntnisse während des Experiments, die bei früheren Forschungsarbeiten im Bereich NLP und Bildverständnis möglicherweise übersehen wurden: (1) VideoMAE ist eine Art Daten Effizienter Lernender. Selbst auf dem HMDB51-Videodatensatz von nur etwa 3.000 Videos ist VideoMAE in der Lage, ein selbstüberwachtes Vortraining durchzuführen und bei nachgelagerten Klassifizierungsaufgaben Ergebnisse zu erzielen, die andere Methoden weit übertreffen. (2) Wenn beim selbstüberwachten Video-Vortraining eine offensichtliche Domänenlücke zwischen dem Datensatz vor dem Training und dem Datensatz mit nachgelagerten Aufgaben besteht, ist die Qualität der Videodaten möglicherweise wichtiger als die Quantität. Einführung in die Methode

Übersicht über MAE

Videodateneigenschaften

Zeitliche Korrelation

Zeitliche KorrelationZeitliches Downsampling

Pixel enthalten. In den spezifischen experimentellen Einstellungen sind die Abtastintervalle für die Datensätze Kinetics-400 und Something-Something V2 auf 4 bzw. 2 eingestellt.

Pixel enthalten. In den spezifischen experimentellen Einstellungen sind die Abtastintervalle für die Datensätze Kinetics-400 und Something-Something V2 auf 4 bzw. 2 eingestellt. Räumlich-zeitliche Blockeinbettung

in einem Videoclip der Größe

in einem Videoclip der Größe  als ein visueller Pixelblock betrachtet. Daher können

als ein visueller Pixelblock betrachtet. Daher können  visuelle Pixelblöcke erhalten werden, nachdem der abgetastete Videoclip die Raum-Zeit-Blockeinbettungsschicht (Würfeleinbettung) durchlaufen hat. Dabei werden auch die Kanalabmessungen des visuellen Pixelblocks abgebildet. Dieses Design kann die räumlich-zeitliche Dimension der Eingabedaten reduzieren und trägt auch dazu bei, die räumlich-zeitliche Redundanz von Videodaten bis zu einem gewissen Grad zu verringern.

visuelle Pixelblöcke erhalten werden, nachdem der abgetastete Videoclip die Raum-Zeit-Blockeinbettungsschicht (Würfeleinbettung) durchlaufen hat. Dabei werden auch die Kanalabmessungen des visuellen Pixelblocks abgebildet. Dieses Design kann die räumlich-zeitliche Dimension der Eingabedaten reduzieren und trägt auch dazu bei, die räumlich-zeitliche Redundanz von Videodaten bis zu einem gewissen Grad zu verringern. Pipeline-Maskierungsstrategie mit extrem hohem Maskierungsverhältnis

Raum-Zeit-gemeinsamer Selbstaufmerksamkeitsmechanismus

ist der rechnerische Engpass des Netzwerks. Im vorherigen Artikel wurde für VideoMAE eine Strategie mit extrem hohem Maskenverhältnis verwendet , und nur ein unmaskiertes Token (z. B. 10 %) wird in den Encoder eingegeben. Dieses Design kann das Problem des

ist der rechnerische Engpass des Netzwerks. Im vorherigen Artikel wurde für VideoMAE eine Strategie mit extrem hohem Maskenverhältnis verwendet , und nur ein unmaskiertes Token (z. B. 10 %) wird in den Encoder eingegeben. Dieses Design kann das Problem des  -Niveaus bis zu einem gewissen Grad wirksam lindern.

-Niveaus bis zu einem gewissen Grad wirksam lindern. VideoMAE-Implementierungsdetails

Decoder-Design

Maskierungsstrategien

Rekonstruktionsziel

Strategie vor dem Training

Datensatz vor dem Training

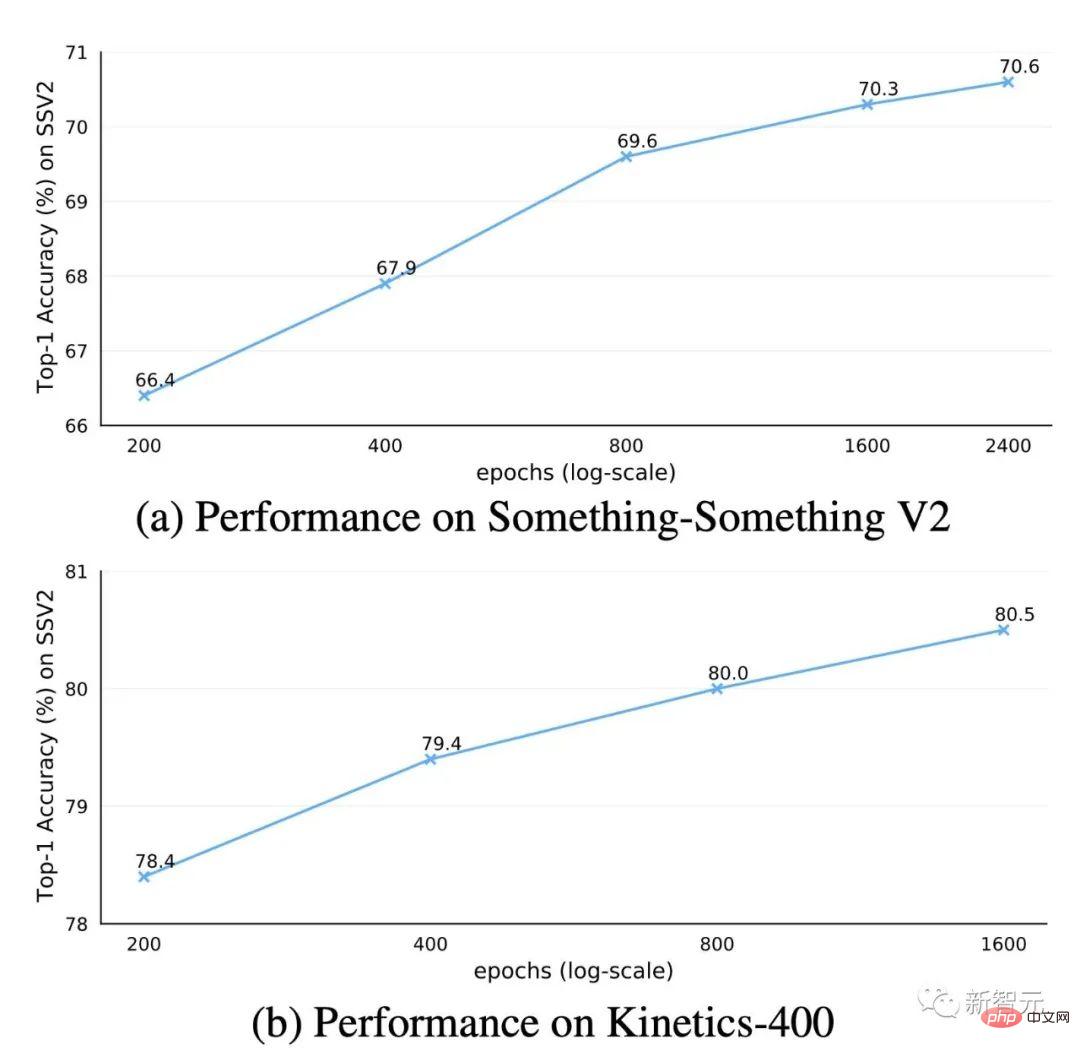

Vortrainingsrunden

Wichtige Funktionen von VideoMAE

VideoMAE ist ein dateneffizienter Lerner

Extrem hohe Maskierungsrate

Generalisierungs- und Übertragungsfunktionen: Qualität und Quantität der Daten

Hauptergebnisse

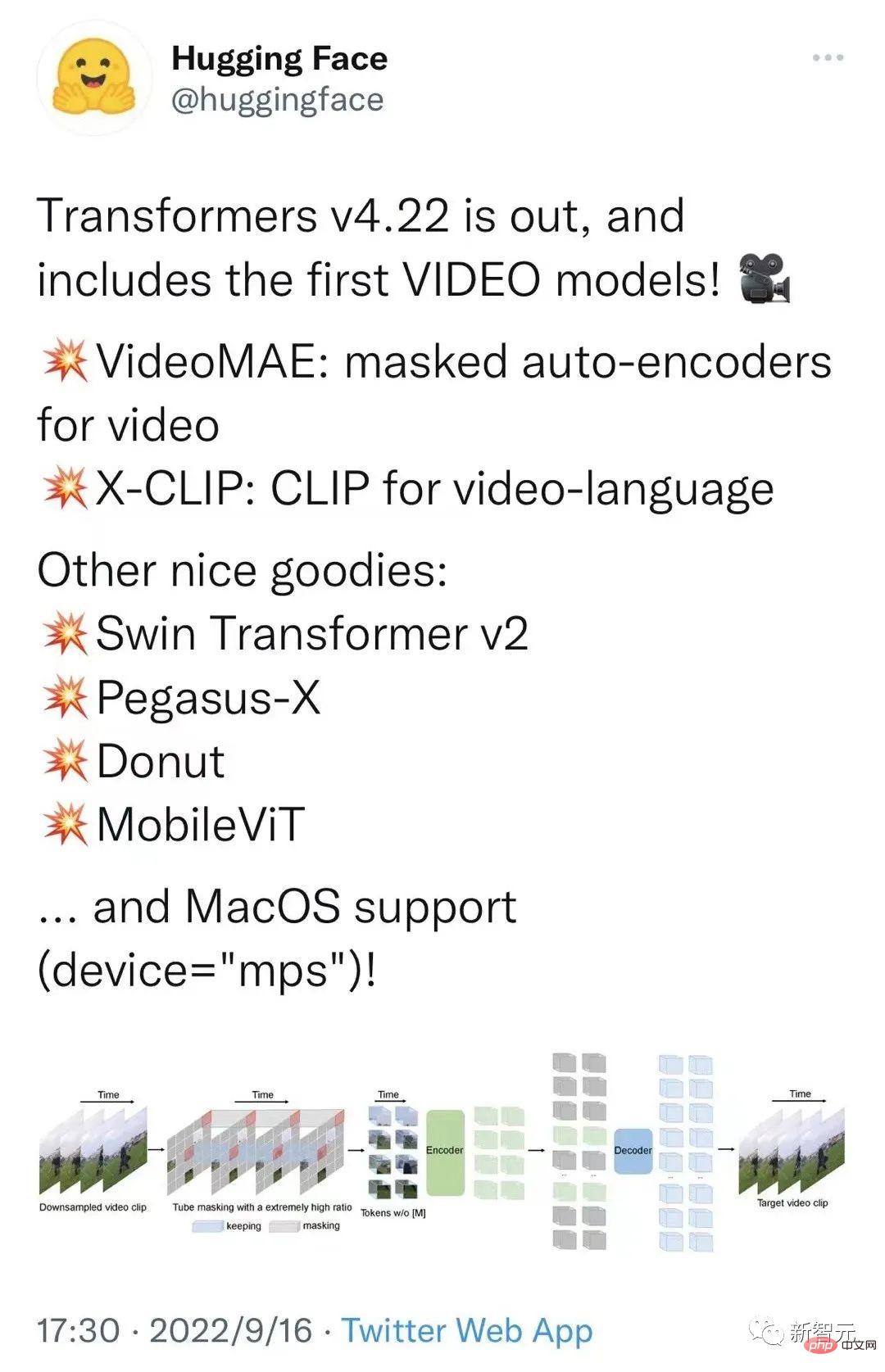

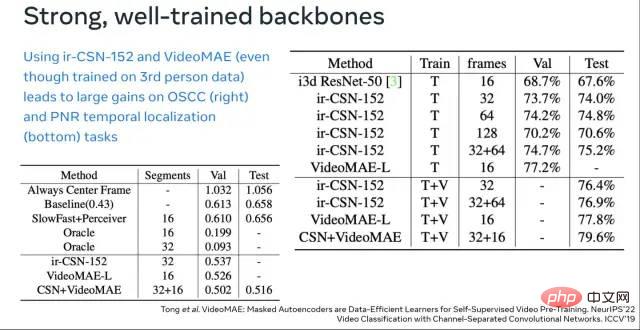

Auswirkungen auf die Community

Zusammenfassung

Das obige ist der detaillierte Inhalt vonVideoMAE: Ein neues Paradigma für einfaches und effizientes selbstüberwachtes Vortraining per Video. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr