Heim >Technologie-Peripheriegeräte >KI >GPT-3 und Stable Diffusion arbeiten zusammen, um dem Modell zu helfen, die Bildretuscheanforderungen von Partei A zu verstehen

GPT-3 und Stable Diffusion arbeiten zusammen, um dem Modell zu helfen, die Bildretuscheanforderungen von Partei A zu verstehen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 14:55:031266Durchsuche

Nach der Popularität des Diffusionsmodells haben sich viele Menschen darauf konzentriert, effektivere Eingabeaufforderungen zu verwenden, um die gewünschten Bilder zu generieren. In den kontinuierlichen Versuchen einiger KI-Malmodelle haben die Leute sogar das Schlüsselwort „Erfahrung“ zusammengefasst, um KI-Bilder gut zeichnen zu lassen:

Mit anderen Worten: Wenn Sie die richtigen KI-Fähigkeiten beherrschen, wird die Qualität der Zeichnungen verbessert Der Effekt wird sehr offensichtlich sein (siehe: „Wie zeichnet man „Alpaca Playing Basketball“? Jemand hat 13 US-Dollar ausgegeben, um DALL·E 2 zu zwingen, seine wahren Fähigkeiten zu zeigen“).

Darüber hinaus arbeiten einige Forscher in eine andere Richtung: wie man ein Gemälde mit nur wenigen Worten in das verändert, was wir wollen.

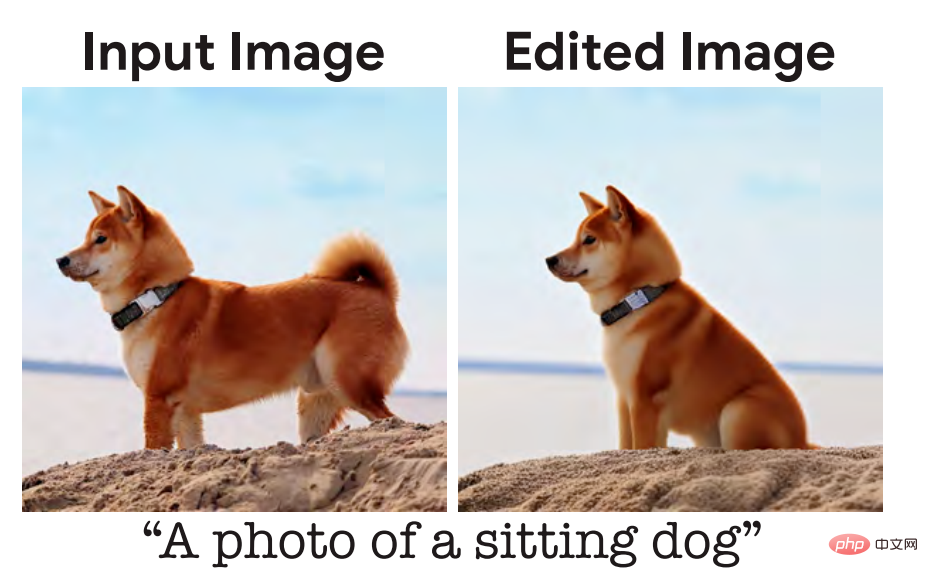

Vor einiger Zeit haben wir über eine Studievon Google Research und anderen Institutionen berichtet. Sagen Sie einfach, wie ein Bild aussehen soll, und es wird im Grunde Ihren Anforderungen entsprechen und fotorealistische Bilder erzeugen, wie zum Beispiel das Sitzen eines Welpen:

Hier sind die Eingaben für das Modell. Die Beschreibung lautet „a „Hund setzt sich hin“, aber entsprechend den täglichen Kommunikationsgewohnheiten der Menschen sollte die natürlichste Beschreibung „Lass diesen Hund sich setzen“ lauten. Einige Forscher sind der Ansicht, dass dies ein Problem ist, das optimiert werden sollte und das Modell besser den menschlichen Sprachgewohnheiten entsprechen sollte.

Kürzlich hat ein Forschungsteam der UC Berkeley eine neue Methode zum Bearbeiten von Bildern basierend auf menschlichen Anweisungen vorgeschlagen, InstructPix2Pix: Anhand eines Eingabebilds und einer Textbeschreibung, die dem Modell sagt, was zu tun ist, kann das Modell den Beschreibungsanweisungen folgen Bearbeiten Sie das Bild.

Papieradresse: https://arxiv.org/pdf/2211.09800.pdf

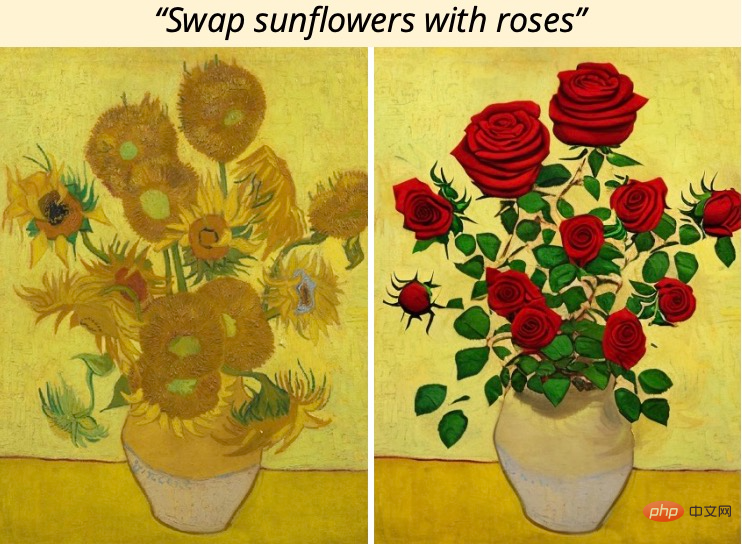

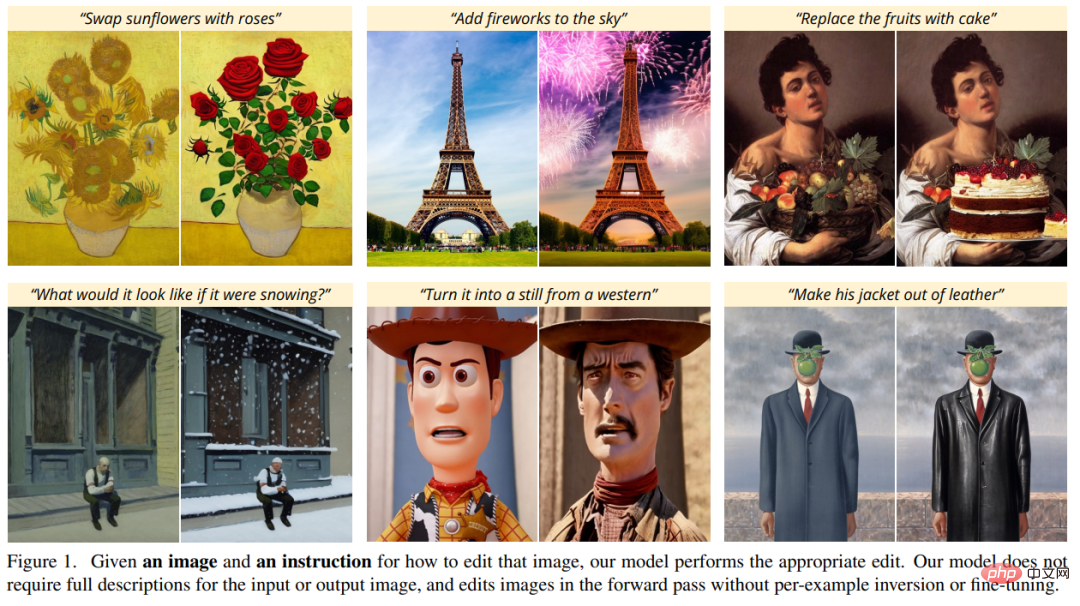

Um beispielsweise die Sonnenblumen im Gemälde durch Rosen zu ersetzen, müssen Sie nur direkt „Put“ sagen „zum Modell Sonnenblumen durch Rosen ersetzt“:

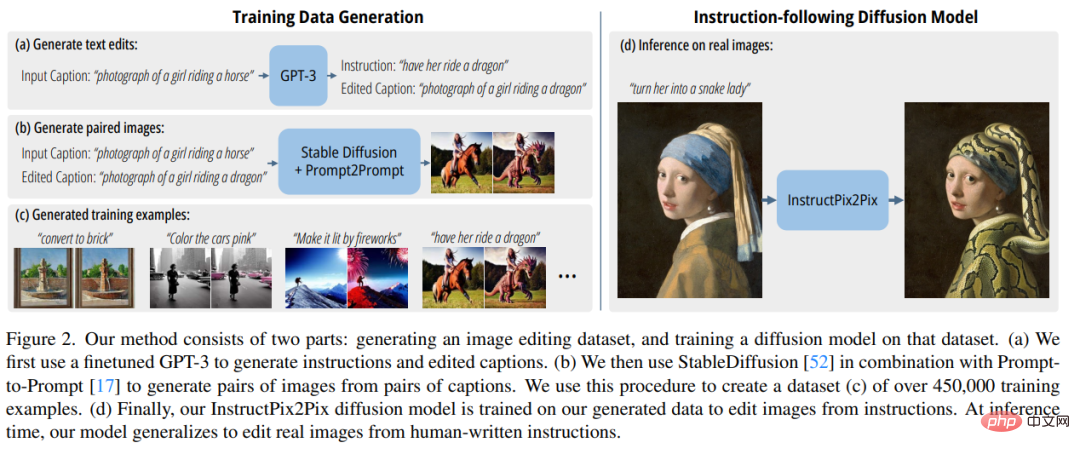

Um Trainingsdaten zu erhalten, kombinierte die Studie zwei groß angelegte vorab trainierte Modelle – Sprachmodell (GPT-3) und Text-zu-Bild-Generierung Modell (Stabile Diffusion) zum Generieren eines großen paarweisen Trainingsdatensatzes von Bildbearbeitungsbeispielen. Die Forscher trainierten ein neues Modell, InstructPix2Pix, auf diesem großen Datensatz und verallgemeinerten es zum Zeitpunkt der Inferenz auf reale Bilder und vom Benutzer geschriebene Anweisungen.

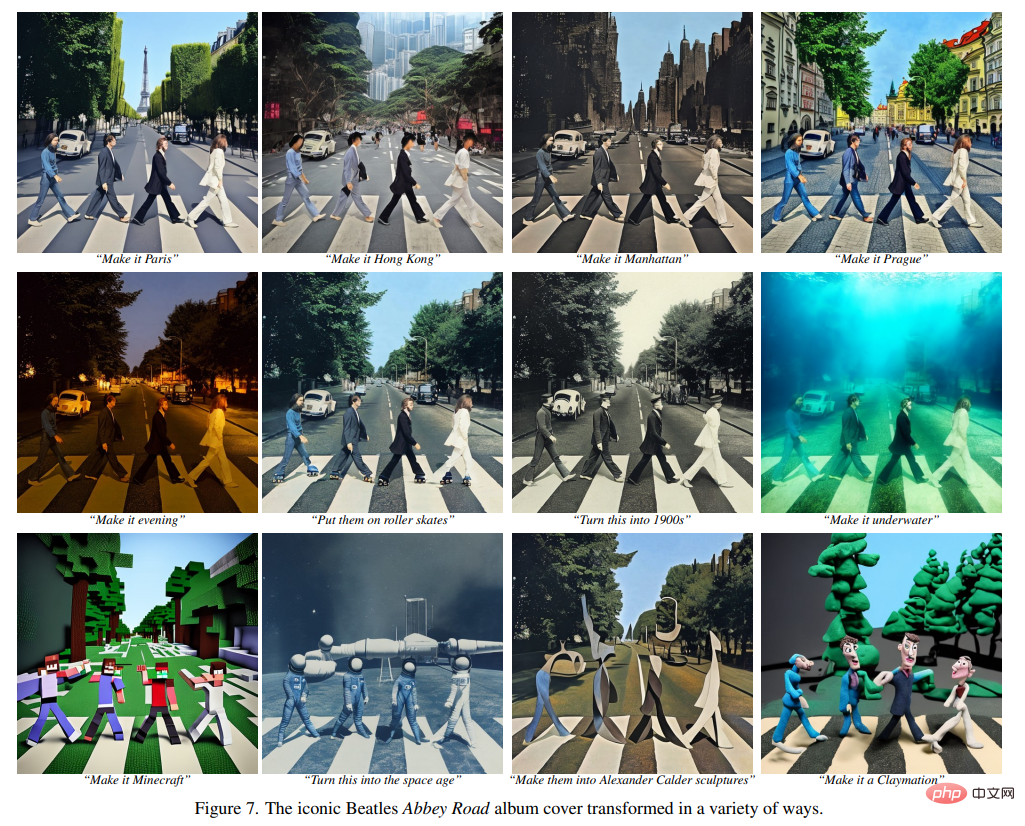

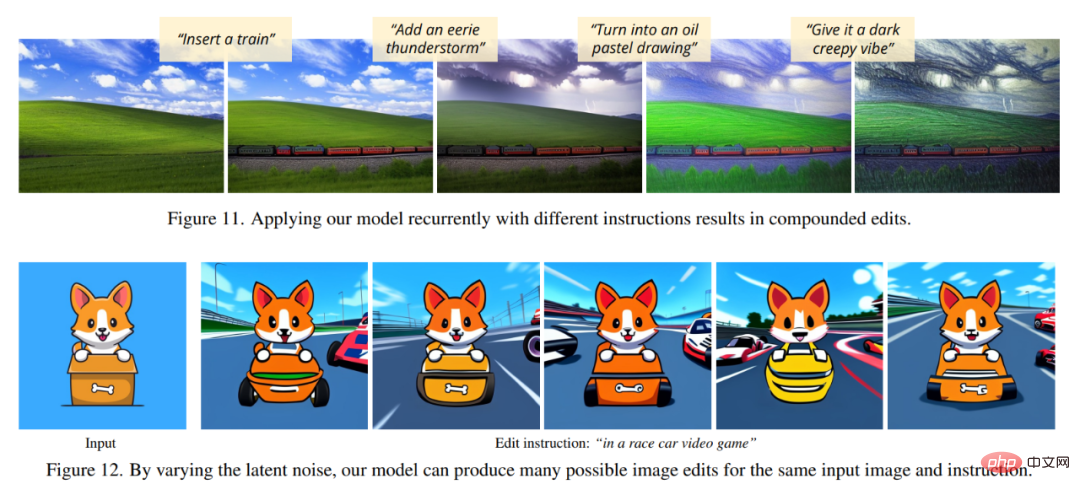

InstructPix2Pix ist ein bedingtes Diffusionsmodell, das ein bearbeitetes Bild generiert, wenn ein Eingabebild und eine Textanweisung zum Bearbeiten des Bildes vorliegen. Das Modell führt die Bildbearbeitung direkt im Vorwärtsdurchlauf durch und erfordert keine zusätzlichen Beispielbilder, keine vollständigen Beschreibungen der Eingabe-/Ausgabebilder oder eine Feinabstimmung der einzelnen Beispiele, sodass das Modell Bilder schnell in nur wenigen Sekunden bearbeiten kann.

Obwohl InstructPix2Pix vollständig an synthetischen Beispielen trainiert wird (d. h. von GPT-3 generierte Textbeschreibungen und von Stable Diffusion generierte Bilder), erreicht das Modell eine Zero-Shot-Verallgemeinerung auf beliebige reale Bilder und von Menschen geschriebenen Text. Das Modell unterstützt die intuitive Bildbearbeitung, einschließlich des Ersetzens von Objekten, des Änderns von Bildstilen und mehr.

Methodenübersicht

Die Forscher behandelten die anweisungsbasierte Bildbearbeitung als überwachtes Lernproblem: Zuerst generierten sie einen gepaarten Trainingsdatensatz mit Textbearbeitungsanweisungen und Bildern vor und nach der Bearbeitung (Abbildung 2a-c) und dann eine Bildbearbeitung Das Diffusionsmodell wurde auf diesem generierten Datensatz trainiert (Abb. 2d). Obwohl das Modell anhand generierter Bilder und Bearbeitungsanweisungen trainiert wurde, ist es dennoch in der Lage, reale Bilder mithilfe beliebiger, von Menschen geschriebener Anweisungen zu bearbeiten. Abbildung 2 unten gibt einen Überblick über die Methode.

Generieren Sie einen multimodalen Trainingsdatensatz

In der Datensatzgenerierungsphase kombinierten die Forscher ein großes Sprachmodell (GPT-3) und ein Text-zu-Bild-Modell ( Mit der Fähigkeit zur stabilen Diffusion (Stable Diffusion) wurde ein multimodaler Trainingsdatensatz generiert, der Textbearbeitungsanweisungen und entsprechende Bilder vor und nach der Bearbeitung enthält. Dieser Prozess besteht aus den folgenden Schritten:

- Feinabstimmung von GPT-3, um eine Sammlung von Textbearbeitungsinhalten zu generieren: Generieren Sie anhand einer Eingabeaufforderung, die ein Bild beschreibt, eine Textanweisung, die die vorzunehmende Änderung beschreibt, und eine Eingabeaufforderung, die das beschreibt geändertes Bild (Abbildung 2a);

- verwendet ein Text-zu-Bild-Modell, um zwei Textaufforderungen (d. h. vor und nach der Bearbeitung) in ein Paar entsprechender Bilder umzuwandeln (Abbildung 2b). Die Forscher nutzten die generierten Trainingsdaten, um ein bedingtes Diffusionsmodell basierend auf dem Stable Diffusion-Modell zu trainieren, das Bilder basierend auf schriftlichen Anweisungen bearbeiten kann.

Das Diffusionsmodell lernt, Datenproben durch eine Reihe von Entrauschungs-Autoencodern zu generieren, die den Anteil der Datenverteilung schätzen (in Richtung von Daten mit hoher Dichte zeigend). Die latente Diffusion verbessert die Effizienz und Qualität von Diffusionsmodellen, indem sie im latenten Raum eines vorab trainierten Variations-Autoencoders mit einem Encoder und einem Decoder

arbeitet. Für ein Bild Wir lernen ein Netzwerk

kennen, das das Rauschen vorhersagt, das einem verrauschten latenten z_t hinzugefügt wird, wenn ein Bildkonditionierungs-C_I und ein Textanweisungskonditionierungs-C_T gegeben sind. Die Forscher minimierten das folgende latente Diffusionsziel: Zuvor haben Studien (Wang et al.) gezeigt, dass bei Bildübersetzungsaufgaben, insbesondere wenn gepaarte Trainingsdaten begrenzt sind, die Feinabstimmung großer Bilddiffusionsmodelle das Training übertrifft sie von Grund auf. Daher verwenden die Autoren in neuen Forschungsarbeiten vorab trainierte Stable-Diffusion-Checkpoints, um die Gewichte des Modells zu initialisieren, und nutzen dabei die leistungsstarken Funktionen zur Text-zu-Bild-Generierung.

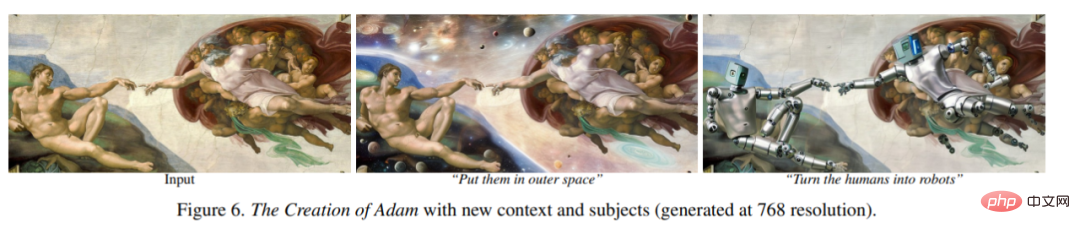

Um die Bildkonditionierung zu unterstützen, fügten die Forscher der ersten Faltungsschicht einen zusätzlichen Eingabekanal hinzu, der z_t und verbindet. Alle verfügbaren Gewichte des Diffusionsmodells werden vom vorab trainierten Prüfpunkt initialisiert, während Gewichte, die auf neu hinzugefügten Eingabekanälen wirken, auf Null initialisiert werden. Der Autor verwendet hier denselben Textkonditionierungsmechanismus, der ursprünglich für die Bildunterschrift verwendet wurde, ohne die Textbearbeitungsanweisung c_T als Eingabe zu verwenden. Experimentelle ErgebnisseIn den folgenden Abbildungen zeigen die Autoren die Bildbearbeitungsergebnisse ihres neuen Modells. Diese Ergebnisse beziehen sich auf einen anderen Satz echter Fotos und Kunstwerke. Das neue Modell führt viele anspruchsvolle Bearbeitungen erfolgreich durch, darunter das Ersetzen von Objekten, das Ändern von Jahreszeiten und Wetter, das Ersetzen von Hintergründen, das Ändern von Materialeigenschaften, das Konvertieren von Kunstmedien und mehr.

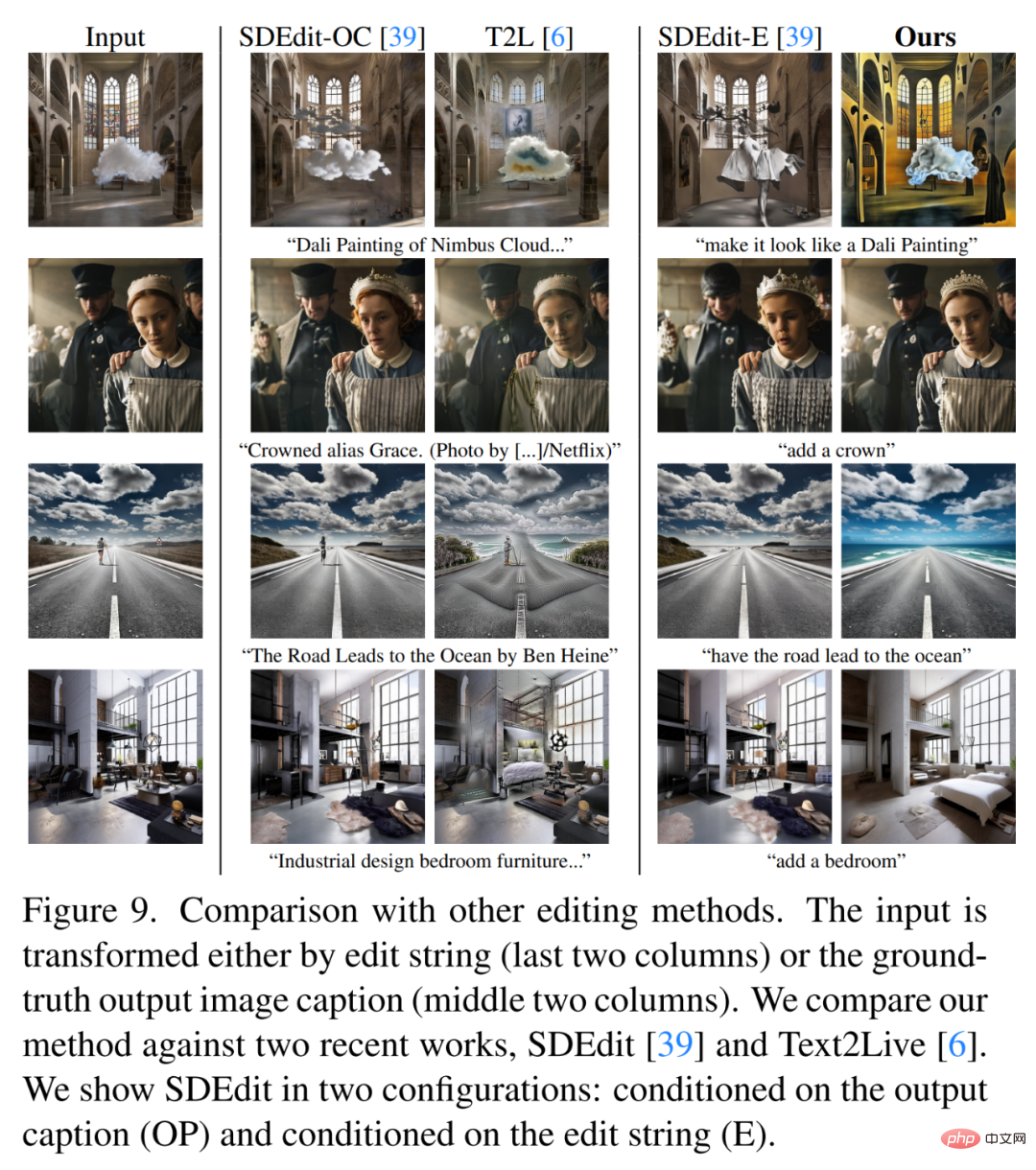

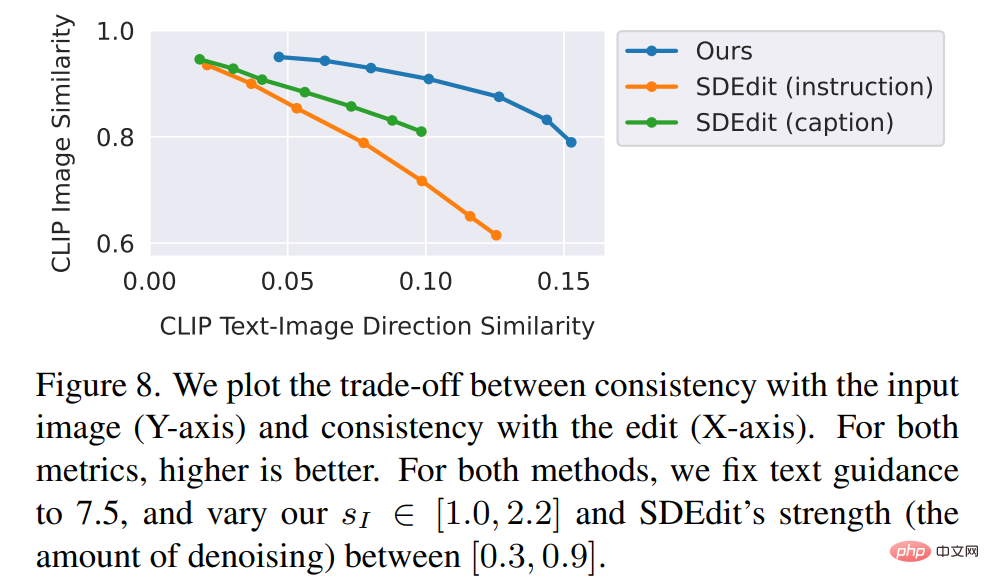

Die Forscher verglichen die neue Methode mit einigen neueren Technologien wie SDEdit, Text2Live usw. Das neue Modell folgt Anweisungen zum Bearbeiten von Bildern, während andere Methoden, einschließlich Basismethoden, Beschreibungen von Bildern oder Bearbeitungsebenen erfordern. Daher liefert der Autor beim Vergleich für letztere „bearbeitete“ Textanmerkungen anstelle von Bearbeitungsanweisungen. Die Autoren vergleichen die neue Methode auch quantitativ mit SDEdit und verwenden dabei zwei Metriken, die die Bildkonsistenz und die Bearbeitungsqualität messen. Abschließend zeigen die Autoren, wie sich die Größe und Qualität der generierten Trainingsdaten auf die Ablationsergebnisse in der Modellleistung auswirkt.

Das obige ist der detaillierte Inhalt vonGPT-3 und Stable Diffusion arbeiten zusammen, um dem Modell zu helfen, die Bildretuscheanforderungen von Partei A zu verstehen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr