Heim >Technologie-Peripheriegeräte >KI >Eine Textzeile, um eine 3D-Gesichtsveränderung zu erreichen! UC Berkeley schlägt „Chat-NeRF' vor, um die Wiedergabe auf Blockbuster-Niveau in nur einem Satz abzuschließen

Eine Textzeile, um eine 3D-Gesichtsveränderung zu erreichen! UC Berkeley schlägt „Chat-NeRF' vor, um die Wiedergabe auf Blockbuster-Niveau in nur einem Satz abzuschließen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 14:37:031032Durchsuche

Dank der Entwicklung der neuronalen 3D-Rekonstruktionstechnologie war die Erfassung von Feature-Darstellungen realer 3D-Szenen noch nie so einfach.

Allerdings gab es noch nie eine darüber hinausgehende einfache und effektive Lösung für die 3D-Szenenbearbeitung.

Kürzlich haben Forscher der UC Berkeley eine Methode zum Bearbeiten von NeRF-Szenen mithilfe von Textanweisungen vorgeschlagen – Instruct-NeRF2NeRF basierend auf der vorherigen Arbeit InstructPix2Pix.

Papieradresse: https://arxiv.org/abs/2303.12789

Mit Instruct-NeRF2NeRF können wir große Szenen aus der realen Welt mit nur einem Satz bearbeiten es ist realer und zielgerichteter als frühere Arbeiten.

Wenn Sie beispielsweise möchten, dass er einen Bart hat, erscheint ein Bartbüschel auf seinem Gesicht!

Oder ändern Sie einfach Ihren Kopf und werden Sie in Sekundenschnelle Einstein.

Da das Modell außerdem den Datensatz kontinuierlich mit neu bearbeiteten Bildern aktualisieren kann, wird sich der Rekonstruktionseffekt der Szene allmählich verbessern.

NeRF + InstructPix2Pix = Instruct-NeRF2NeRF

Konkret erhalten Menschen ein Eingabebild und schriftliche Anweisungen, die dem Modell sagen, was zu tun ist, und das Modell folgt dann diesen Anweisungen, um das Bild zu bearbeiten.

Die Implementierungsschritte sind wie folgt:

- Rendern Sie ein Bild von der Szene in der Trainingsperspektive.

- Verwenden Sie das InstructPix2Pix-Modell, um dieses Bild basierend auf globalen Textanweisungen zu bearbeiten.

- Ersetzen Sie die Originalbilder im Trainingsdatensatz durch die bearbeiteten Bilder.

- Das NeRF-Modell trainiert wie gewohnt weiter.

Implementierungsmethode

Im Vergleich zur herkömmlichen dreidimensionalen Bearbeitung ist NeRF2NeRF eine neue dreidimensionale Szenenbearbeitungsmethode. Ihr größtes Highlight ist die Verwendung der „iterativen Datensatzaktualisierung“. Technologie.

Obwohl die Bearbeitung an einer 3D-Szene erfolgt, verwendet die Arbeit ein 2D- statt eines 3D-Diffusionsmodells, um Form- und Erscheinungsprioritäten zu extrahieren, da die zum Trainieren des generativen 3D-Modells verwendeten Daten sehr begrenzt sind.

Bei diesem 2D-Diffusionsmodell handelt es sich um das kürzlich vom Forschungsteam entwickelte 2D-Bildbearbeitungsmodell, das auf Anweisungstexten basiert und das bearbeitete Bild ausgeben kann.

Dieses 2D-Modell führt jedoch zu ungleichmäßigen Änderungen in verschiedenen Winkeln der Szene. Daher wurde die „iterative Datensatzaktualisierung“ eingeführt, die den „Eingabebilddatensatz“ von NeRF abwechselnd ändert und die grundlegende 3D-Darstellung aktualisiert.

Das bedeutet, dass das textgesteuerte Diffusionsmodell (InstructPix2Pix) gemäß den Anweisungen neue Bildvariationen generiert und diese neuen Bilder als Eingabe für das NeRF-Modelltraining verwendet. Daher wird die rekonstruierte 3D-Szene auf einer neuen textgesteuerten Bearbeitung basieren.

In den ersten Iterationen gelingt es InstructPix2Pix oft nicht, eine konsistente Bearbeitung über verschiedene Betrachtungswinkel hinweg durchzuführen. Während des Prozesses des erneuten Renderns und Aktualisierens von NeRF werden sie jedoch zu einer global konsistenten Szene konvergieren.

Zusammenfassend lässt sich sagen, dass die NeRF2NeRF-Methode die Bearbeitungseffizienz von 3D-Szenen verbessert, indem Bildinhalte iterativ aktualisiert und diese aktualisierten Inhalte in die 3D-Szene integriert werden, während gleichzeitig die Kohärenz und der Realismus der Szene erhalten bleiben.

Man kann sagen, dass diese Arbeit des UC Berkeley-Forschungsteams eine erweiterte Version des vorherigen InstructPix2Pix ist Mit der „iterativen Datensatzaktualisierung“ können Sie weiterhin 3D-Szenen mit Ein-Klick-Bearbeitung genießen!

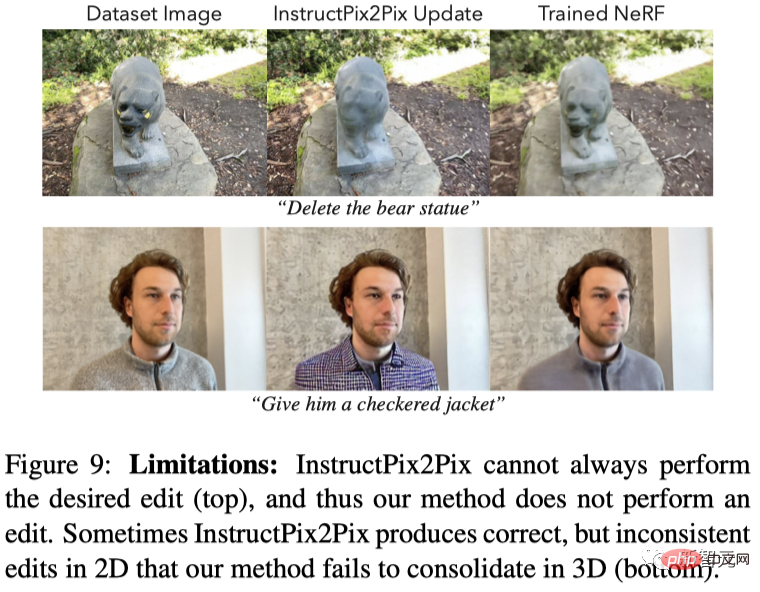

Es gibt immer noch Einschränkungen, aber die Mängel sind nicht verborgen

Da Instruct-NeRF2NeRF jedoch auf dem vorherigen InstructPix2Pix basiert, erbt es viele der Einschränkungen des letzteren, wie zum Beispiel die Unfähigkeit, groß angelegte räumliche Operationen durchzuführen.

Darüber hinaus kann Instruct-NeRF2NeRF wie DreamFusion das Diffusionsmodell jeweils nur für eine Ansicht verwenden, sodass möglicherweise ähnliche Artefaktprobleme auftreten.

Das folgende Bild zeigt zwei Arten von Fehlerfällen:

(1) Pix2Pix kann nicht verwendet werden Die 2D-Bearbeitung wird in 2D durchgeführt, sodass NeRF2NeRF auch in 3D fehlschlägt. Daher schlägt auch NeRF2NeRF fehl.

Ein weiteres Beispiel ist der „Panda“ unten, der nicht nur sehr gut aussieht heftig (Die Prototyp-Statue ist sehr wild), und die Farbe des Fells ist etwas seltsam, und die Augen sind offensichtlich „aus der Form“, wenn sie sich auf dem Bildschirm bewegen.

Ein weiteres Beispiel ist der „Panda“ unten, der nicht nur sehr gut aussieht heftig (Die Prototyp-Statue ist sehr wild), und die Farbe des Fells ist etwas seltsam, und die Augen sind offensichtlich „aus der Form“, wenn sie sich auf dem Bildschirm bewegen.

Da ChatGPT, Diffusion und NeRFs ins Rampenlicht gerückt wurden, kann man sagen, dass dieser Artikel vollständig ist Spielen Sie zu den drei Der Vorteil hat sich von „KI-Zeichnung in einem Satz“ zu „KI-3D-Szenenbearbeitung in einem Satz“ weiterentwickelt.

Obwohl die Methode einige Einschränkungen aufweist, hat sie dennoch ihre Mängel und bietet eine einfache und praktikable Lösung für die 3D-Feature-Bearbeitung, die voraussichtlich ein Meilenstein in der Entwicklung werden wird von NeRF.

Bearbeiten von 3D-Szenen in einem Satz

Werfen wir abschließend einen Blick auf die vom Autor veröffentlichten Effekte.Es ist nicht schwer zu erkennen, dass dieses Ein-Klick-Artefakt für die PS-3D-Szenenbearbeitung in Bezug auf Befehlsverständnis und Bildrealismus eher den Erwartungen entspricht in Zukunft verwendet werden Es ist zum „neuen Favoriten“ unter Wissenschaftlern und Internetnutzern geworden und hat nach ChatGPT ein Chat-NeRFs erstellt. Sie können sogar den Umgebungshintergrund, die Eigenschaften der vier Jahreszeiten und das Wetter des Bildes nach Belieben ändern, und das neue Bild entspricht vollständig der Logik der Realität.

Originalbild:

Herbst: # 🎜🎜#

Schneetag: #🎜 🎜#

Wüste:

Referenz: https://www.php.cn/link/ebeb300882677f350ea818c8f333f5b9

Das obige ist der detaillierte Inhalt vonEine Textzeile, um eine 3D-Gesichtsveränderung zu erreichen! UC Berkeley schlägt „Chat-NeRF' vor, um die Wiedergabe auf Blockbuster-Niveau in nur einem Satz abzuschließen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr