Heim >Technologie-Peripheriegeräte >KI >Blick auf die Vergangenheit und Zukunft des multimodalen Lernens aus audiovisueller Perspektive

Blick auf die Vergangenheit und Zukunft des multimodalen Lernens aus audiovisueller Perspektive

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 13:58:161686Durchsuche

Sehen und Hören sind entscheidend für die menschliche Kommunikation und das Szenenverständnis. Um die menschlichen Wahrnehmungsfähigkeiten nachzuahmen, hat sich das audiovisuelle Lernen zur Erforschung audiovisueller Modalitäten in den letzten Jahren zu einem boomenden Bereich entwickelt. Dieser Artikel ist eine Rezension des neuesten audiovisuellen Lernens „Lernen im audiovisuellen Kontext: Eine Überprüfung, Analyse und Interpretation einer „neuen Perspektive“.

Diese Rezension analysiert zunächst die kognitionswissenschaftlichen Grundlagen audiovisueller Modalitäten und führt dann eine systematische Analyse und Zusammenfassung der jüngsten Arbeiten zum audiovisuellen Lernen durch (fast dreihundert verwandte Dokumente). Um abschließend einen Überblick über den aktuellen Bereich des visuell-visuellen Lernens zu geben, untersucht dieser Aufsatz die Fortschritte des visuell-visuellen Lernens in den letzten Jahren aus der Perspektive des visuell-visuellen Szenenverständnisses und untersucht mögliche Entwicklungsrichtungen in diesem Bereich.

arXiv-Link: https://arxiv.org/abs/2208.09579

Projekt-Homepage: https://gewu-lab.github.io/audio-visual-learning/

awesome-list-Link: https://gewu-lab.github.io/awesome-audiovisual-learning/

1 Einführung

Visuelle und auditive Informationen sind für den Menschen die wichtigsten Informationsquellen die Außenwelt wahrnehmen. Informationsquelle. Durch die Integration heterogener multimodaler Informationen erhält das menschliche Gehirn eine umfassende Wahrnehmung der Umgebung. Beispielsweise können wir in einer Cocktailparty-Szene mit mehreren Sprechern Änderungen in der Lippenform nutzen, um die empfangene Rede des gewünschten Sprechers zu verbessern. Daher ist visuelles und akustisches Lernen für die Erforschung menschenähnlicher maschineller Wahrnehmungsfähigkeiten unverzichtbar. Im Vergleich zu anderen Modalitäten ist die audiovisuelle Modalität aufgrund ihrer Eigenschaften einzigartig:

1) Kognitive Basis. Als die beiden am häufigsten untersuchten Sinne ist die Integration von Sehen und Hören im gesamten menschlichen Nervensystem zu finden. Einerseits liefert die Bedeutung dieser beiden Sinne für die menschliche Wahrnehmung eine kognitive Grundlage für die maschinelle Wahrnehmungsforschung auf der Grundlage audiovisueller Daten. Andererseits kann die Interaktion und Integration von Sehen und Hören im Nervensystem als Grundlage dienen Grundlage zur Förderung des visuell-visuellen Lernens.

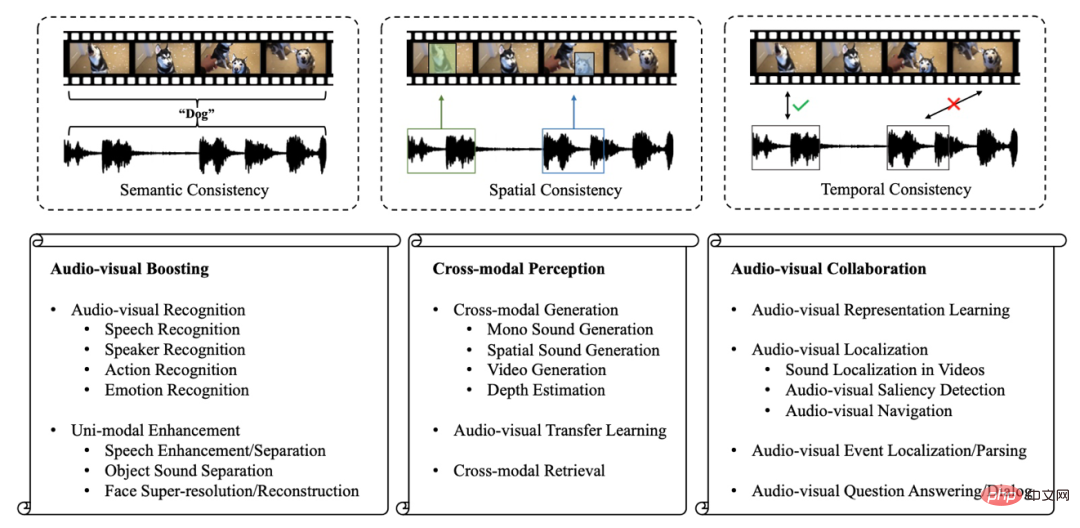

2) Mehrfachkonsistenz. In unserem täglichen Leben sind Sehen und Hören eng miteinander verbunden. Wie in Abbildung 1 gezeigt, ermöglichen uns sowohl das Bellen eines Hundes als auch sein Aussehen, ihn mit dem Konzept „Hund“ zu assoziieren (Semantische Konsistenz). Gleichzeitig können wir mit Hilfe von gehörten Geräuschen oder Bildern den genauen räumlichen Standort des Hundes bestimmen (Räumliche Konsistenz). Und wenn wir einen Hund bellen hören, können wir den Hund meist gleichzeitig visuell sehen (Zeitliche Konsistenz). Multiple Zusammenhänge zwischen Sehen und Hören sind die Grundlage der Forschung zum audiovisuellen Lernen.

3) Umfangreiche Datenunterstützung. Die rasante Entwicklung mobiler Endgeräte und des Internets hat dazu geführt, dass immer mehr Menschen Videos auf öffentlichen Plattformen teilen, was die Kosten für das Sammeln von Videos gesenkt hat. Diese umfangreichen öffentlichen Videos beseitigen die Hürden bei der Datenerfassung und bieten Datenunterstützung für audiovisuelles Lernen.

Diese Eigenschaften der audiovisuellen Modalität führten natürlich zur Geburt des Bereichs des audiovisuellen Lernens. In den letzten Jahren hat sich dieses Gebiet stark weiterentwickelt, und Forscher geben sich nicht mehr damit zufrieden, einfach zusätzliche Modalitäten in die ursprünglichen einmodalen Aufgaben einzuführen, und haben begonnen, neue Probleme und Herausforderungen zu erforschen und zu lösen.

Bestehende audiovisuelle Lernberufe sind jedoch häufig aufgabenorientiert. In diesen Arbeiten konzentrieren sie sich auf spezifische audiovisuelle Aufgaben. Es mangelt noch immer an umfassenden Arbeiten, die die Entwicklung des Bereichs audiovisuelles Lernen systematisch überprüfen und analysieren. Daher fasst dieser Artikel den aktuellen Bereich des audiovisuellen Lernens zusammen und geht anschließend weiter auf seine möglichen Entwicklungsrichtungen ein.

Aufgrund des engen Zusammenhangs zwischen visuellem und akustischem Lernen und der menschlichen Wahrnehmungsfähigkeit fasst dieser Artikel zunächst die kognitiven Grundlagen visueller und auditiver Modalitäten zusammen und fasst dann auf dieser Grundlage die bestehende Forschung zum visuellen und akustischen Lernen zusammen. In drei Kategorien unterteilt:

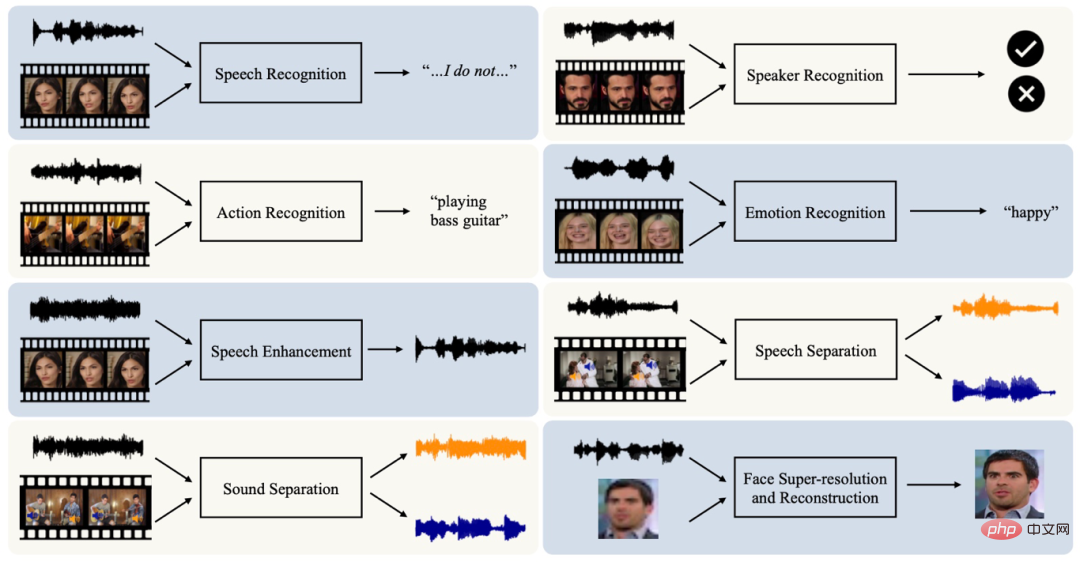

1) Audiovisuelle Verstärkung. Visuelle und Audiodaten haben jeweils eine lange Forschungsgeschichte und breite Anwendung. Obwohl diese einmodalen Methoden recht effektive Ergebnisse erzielt haben, nutzen sie nur Teilinformationen der interessierenden Dinge, die Leistung einmodaler Methoden ist begrenzt und sie sind anfällig für einmodales Rauschen. Daher führen Forscher zusätzliche Modalitäten in diese Audio- oder visuellen Aufgaben ein, was nicht nur den Modelleffekt durch die Integration komplementärer Informationen verbessert, sondern auch die Robustheit des Modells fördert.

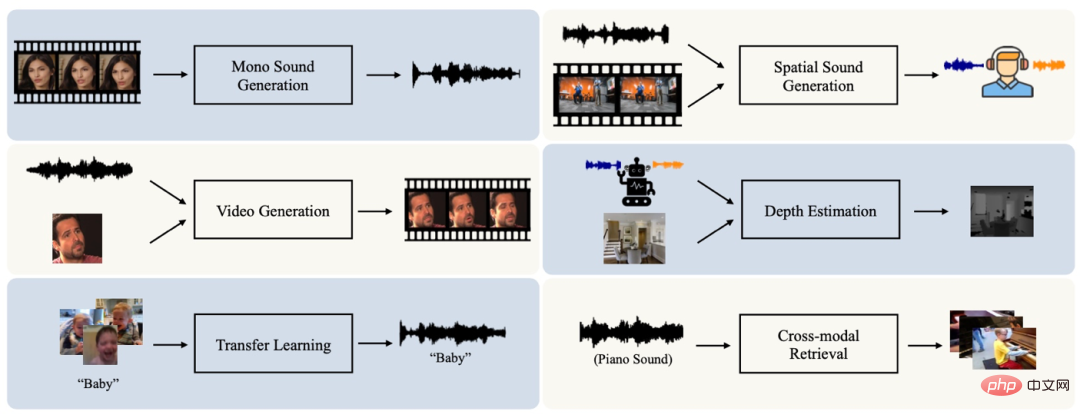

2) Cross-modale Wahrnehmung. Menschen können verwandte Bilder assoziieren, wenn sie Geräusche hören, und können auch an passende Geräusche denken, wenn sie Bilder sehen. Dies liegt daran, dass visuelle und akustische Informationen konsistent sind. Diese Konsistenz bietet der Maschine eine Grundlage, um modalübergreifendes Wissen zu übertragen oder entsprechende Daten einer anderen Modalität basierend auf Informationen einer Modalität zu generieren. Daher haben sich viele Studien der Erforschung modalübergreifender Wahrnehmungsfähigkeiten gewidmet und dabei bemerkenswerte Ergebnisse erzielt.

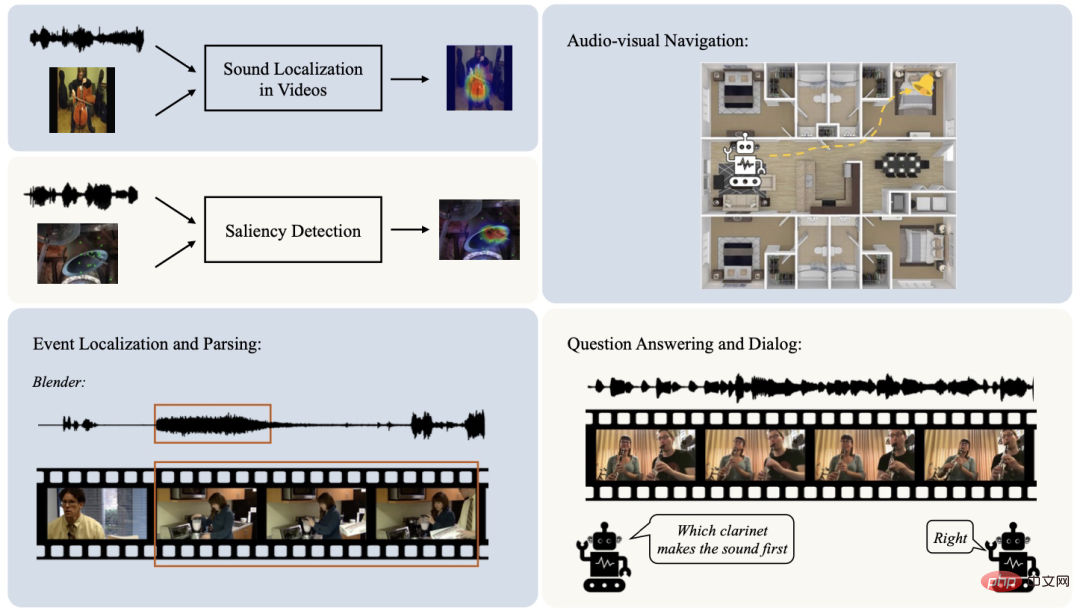

3) Audiovisuelle Zusammenarbeit. Zusätzlich zur Fusion von Signalen verschiedener Modalitäten gibt es Interaktionen auf höherer Ebene zwischen Modalitäten in den kortikalen Bereichen des menschlichen Gehirns, um ein tieferes Szenenverständnis zu erreichen. Daher erfordern menschenähnliche Wahrnehmungsfähigkeiten die Erforschung der Zusammenarbeit zwischen Audio- und Videomodalitäten. Um dieses Ziel zu erreichen, haben viele Studien in den letzten Jahren anspruchsvollere Probleme beim Szenenverständnis vorgeschlagen, die große Aufmerksamkeit erregt haben.

Abbildung 1: Überblick über den Bereich visuell-visuelle Konsistenz und visuell-visuelles Lernen # 🎜🎜## 🎜🎜#

Die Konsistenz von Semantik, Raum und Timing zwischen Audio- und Videomodalitäten ermöglicht die Machbarkeit der oben genannten Audio- und Videoforschung. Daher analysiert dieser Artikel nach einer Zusammenfassung der jüngsten audiovisuellen Forschung die vielfältigen Kohärenzen audiovisueller Medien. Darüber hinaus beleuchtet dieser Artikel noch einmal die Fortschritte im Bereich des audiovisuellen Lernens aus einer neuen Perspektive des Verständnisses audiovisueller Szenen.2

Grundlagen der visuellen und akustischen Wahrnehmung

Sehen und Hören sind die beiden Kernsinne der menschlichen Szene Verständnis . Dieses Kapitel fasst die neuronalen Bahnen der visuellen und auditiven Sinne und die Integration visueller und akustischer Modalitäten in der kognitiven Neurowissenschaft zusammen und legt damit den Grundstein für die anschließende Diskussion der Forschung im Bereich des visuellen und akustischen Lernens.2.1 Neuronale Bahnen des Sehens und Hörens

Das Sehen ist der am häufigsten untersuchte Sinn, und manche glauben sogar, dass er die menschliche Wahrnehmung dominiert. Dementsprechend sind auch die Nervenbahnen des Sehens relativ komplex. Von Objekten reflektiertes Licht enthält visuelle Informationen, die zahlreiche Photorezeptoren (ca. 260 Millionen) in der Netzhaut aktivieren. Der Output der Photorezeptoren wird an Ganglienzellen (ca. 2 Millionen) weitergeleitet. Dieser Prozess komprimiert visuelle Informationen. Nach der Verarbeitung durch Zellen im Nucleus geniculatum lateralis gelangen die visuellen Informationen schließlich in die sehbezogenen Bereiche der Großhirnrinde. Der visuelle Kortex ist eine funktionell unterschiedliche Ansammlung von Regionen, deren visuelle Neuronen Präferenzen haben. Beispielsweise reagieren Neuronen in V4 und V5 empfindlich auf Farbe bzw. Bewegung.Neben dem Sehen ist auch das Hören ein wichtiger Sinn zur Beobachtung der Umgebung. Es erinnert den Menschen nicht nur daran, Risiken zu vermeiden (z. B. ergreift der Mensch proaktive Maßnahmen, wenn er den Schrei wilder Tiere hört), sondern ist auch die Grundlage für die Kommunikation der Menschen untereinander. Schallwellen werden am Trommelfell in neuronale Signale umgewandelt. Die akustischen Informationen werden dann zum Colliculus inferior und den Cochleakernen des Hirnstamms weitergeleitet. Nach der Verarbeitung durch den Nucleus geniculatum medialis des Thalamus werden die Geräusche schließlich im primären auditorischen Kortex kodiert. Das Gehirn nimmt akustische Informationen auf und verwendet die darin enthaltenen akustischen Hinweise, wie z. B. Frequenz und Klangfarbe, um die Identität der Schallquelle zu bestimmen. Gleichzeitig geben die Intensität zwischen den beiden Ohren und der zeitliche Unterschied zwischen den Hörvorgängen Hinweise auf den Ort des Schalls, der als binauraler Effekt bezeichnet wird. In der Praxis kann die menschliche Wahrnehmung mehrere Sinne kombinieren, insbesondere Hören und Sehen, was als Mehrkanalwahrnehmung bezeichnet wird.

2.2 Audiovisuelle Integration in der kognitiven Neurowissenschaft

Jeder Sinn liefert einzigartige Informationen über die Umgebung. Obwohl die von den verschiedenen Sinnen empfangenen Informationen unterschiedlich sind, ist die resultierende Darstellung der Umgebung eine einheitliche Erfahrung und keine separaten Empfindungen.Ein repräsentatives Beispiel ist der McGurk-Effekt: Visuelle Signale und akustische Signale mit unterschiedlicher Semantik erhalten einzelne semantische Informationen. Diese Phänomene weisen darauf hin, dass in der menschlichen Wahrnehmung häufig Signale mehrerer Sinne integriert sind. Unter anderem kombiniert die Schnittstelle zwischen auditorischen und visuellen Nervenbahnen Informationen von zwei wichtigen menschlichen Sinnen und fördert so die Sensibilität und Genauigkeit der Wahrnehmung. Beispielsweise können visuelle Informationen im Zusammenhang mit Geräuschen die Sucheffizienz des Hörraums verbessern. Diese Wahrnehmungsphänomene, die mehrere Sinnesinformationen kombinieren, haben die Aufmerksamkeit der Menschen auf dem Gebiet der kognitiven Neurowissenschaften auf sich gezogen. Eine gut untersuchte Mehrkanal-Sensorregion im menschlichen Nervensystem ist der Colliculus superior. Viele Neuronen im Colliculus superior haben multisensorische Eigenschaften und können durch Informationen aus dem Sehen, Hören und sogar durch Berührung aktiviert werden. Diese multisensorische Reaktion ist oft stärker als eine einzelne Reaktion. Der Sulcus temporalis superior im Kortex ist eine weitere repräsentative Region. Basierend auf Studien an Affen wurde beobachtet, dass es mehrere Sinne anspricht, darunter Sehen, Hören und somatosensorische. Weitere Hirnregionen, darunter der Parietallappen, der Frontallappen und der Hippocampus, weisen ähnliche Phänomene der Mehrkanalwahrnehmung auf. Basierend auf der Forschung zu Mehrkanal-Wahrnehmungsphänomenen können wir mehrere wichtige Erkenntnisse beobachten: 1) Multimodale Verbesserung. Wie oben erwähnt, können viele Neuronen auf die fusionierten Signale mehrerer Sinne reagieren. Wenn die Stimulation eines einzelnen Sinnes schwach ist, ist diese verstärkte Reaktion zuverlässiger als eine Reaktion mit einer einzigen Modalität. 2) Crossmodale Plastizität. Dieses Phänomen bedeutet, dass der Verlust eines Sinnes die Entwicklung des entsprechenden kortikalen Bereichs beeinträchtigen kann. Beispielsweise ist es möglich, dass der auditorische Cortex gehörloser Menschen durch visuelle Stimulation aktiviert wird. 3) Multimodale Zusammenarbeit. Signale verschiedener Sinne werden in kortikalen Bereichen komplexer integriert. Forscher haben herausgefunden, dass es Module in der Großhirnrinde gibt, die in der Lage sind, multisensorische Informationen auf kollaborative Weise zu integrieren, um Bewusstsein und Kognition zu stärken. Inspiriert durch die menschliche Erkenntnis haben Forscher in den letzten Jahren begonnen, zu untersuchen, wie man menschenähnliche visuelle und akustische Wahrnehmungsfähigkeiten erreichen kann. . Obwohl jede Modalität selbst relativ ausreichend Informationen zu Lernmöglichkeiten hat, und zwar dort Es gibt bereits viele Aufgaben, die auf monomodalen Daten basieren, aber monomodale Daten liefern nur lokale Informationen und reagieren empfindlich auf monomodales Rauschen (z. B. werden visuelle Informationen durch Faktoren wie Beleuchtung, Betrachtungswinkel usw. beeinflusst). Inspiriert durch das Phänomen der multimodalen Verbesserung der menschlichen Kognition fügen einige Forscher daher zusätzliche visuelle (oder akustische) Daten in die ursprüngliche einmodale Aufgabe ein, um die Aufgabenleistung zu verbessern. Wir unterteilen verwandte Aufgaben in zwei Teile: Identifizierung und Verbesserung. Singlemodale Erkennungsaufgaben wurden in der Vergangenheit ausführlich untersucht, beispielsweise die audiobasierte Spracherkennung und die visionsbasierte Aktionserkennung. Allerdings erfassen monomodale Daten nur einen Teil der Informationen von Dingen und sind anfällig für monomodales Rauschen. Daher hat die Aufgabe der audiovisuellen Erkennung, die multimodale Daten integriert, um die Fähigkeiten und Robustheit des Modells zu fördern, in den letzten Jahren Aufmerksamkeit erregt und viele Aspekte wie Spracherkennung, Sprechererkennung, Aktionserkennung und Emotionserkennung abgedeckt. Die Konsistenz von Audio- und Videomodalitäten bietet nicht nur die Grundlage für multimodale Erkennungsaufgaben, sondern ermöglicht es auch, mit deren Hilfe das Signal einer anderen Modalität zu verstärken einer Modalität. Beispielsweise werden mehrere Sprecher visuell getrennt, sodass visuelle Informationen über die Sprecher zur Unterstützung der Sprachtrennung verwendet werden können. Darüber hinaus können Audioinformationen Identitätsinformationen wie Geschlecht und Alter liefern, um verdeckte oder fehlende Gesichtsinformationen des Sprechers zu rekonstruieren. Diese Phänomene haben Forscher dazu inspiriert, Informationen aus anderen Modalitäten zur Rauschunterdrückung oder -verstärkung zu nutzen, wie etwa Sprachverstärkung, Schallquellentrennung und Gesichts-Superrekonstruktion. Abbildung 2: Aufgabe zur Video- und Audioverbesserung #🎜 🎜 # Das Phänomen der kreuzmodalen Plastizität in der kognitiven Neurowissenschaft und die Konsistenz zwischen Audio- und Videomodalitäten Dies hat die Forschung zur modalübergreifenden Wahrnehmung gefördert, die darauf abzielt, Zusammenhänge zwischen Audio- und visuellen Modalitäten zu erlernen und herzustellen, was zu Aufgaben wie der modalübergreifenden Generierung, Übertragung und dem Abruf führt. Menschen haben die Fähigkeit, die einer anderen Modalität entsprechenden Informationen unter Anleitung einer bekannten Modalität vorherzusagen. Ohne einen Ton zu hören, können wir beispielsweise grob auf das schließen, was die Person sagt, indem wir einfach die visuellen Informationen der Lippenbewegungen sehen. Die semantische, räumliche und zeitliche Konsistenz zwischen Audio und Bild bietet Maschinen die Möglichkeit, über menschenähnliche, modalübergreifende Generierungsfähigkeiten zu verfügen. Aufgaben zur modalübergreifenden Generierung decken derzeit viele Aspekte ab, darunter die Generierung von Einzelkanal-Audio, Stereogenerierung, Video-/Bildgenerierung und Tiefenschätzung. Zusätzlich zur modalübergreifenden Generierung zeigt die semantische Konsistenz zwischen Audio und Video, dass beim Lernen in einer Modalität erwartet wird, dass Semantik aus einer anderen Modalität Informationshilfe erhält. Dies ist auch das Ziel der audiovisuellen Übertragungsaufgabe. Darüber hinaus fördert die semantische Konsistenz von Audio und Video auch die Entwicklung modalübergreifender Informationsabrufaufgaben. Abbildung 3: Cross-modal wahrnehmungsbezogene Aufgaben 🎜🎜##🎜 🎜#5 AV-KOOPERATION Zu Beginn der audiovisuellen Zusammenarbeit ist die Frage, wie Darstellungen aus audiovisuellen Modalitäten ohne menschliche Anmerkungen effektiv extrahiert werden können, ein wichtiges Thema. Denn qualitativ hochwertige Darstellungen können zu einer Vielzahl nachgelagerter Aufgaben beitragen. Bei audiovisuellen Daten stellt die semantische, räumliche und zeitliche Konsistenz zwischen ihnen ein natürliches Signal für das selbstüberwachte Erlernen der audiovisuellen Darstellung dar. Neben dem Repräsentationslernen konzentriert sich die Zusammenarbeit zwischen Audio- und Videomodalitäten hauptsächlich auf das Szenenverständnis. Einige Forscher konzentrieren sich auf die Analyse und Lokalisierung visueller und akustischer Komponenten in der Szene, einschließlich der Lokalisierung von Schallquellen, der Erkennung visueller und akustischer Ausprägungen, der visuellen und akustischen Navigation usw. Solche Aufgaben stellen feinkörnige Verbindungen zwischen visuellen und akustischen Modalitäten her. Darüber hinaus gehen wir bei vielen audiovisuellen Aufgaben häufig davon aus, dass der audiovisuelle Inhalt im gesamten Video immer zeitlich übereinstimmt, d. h. Das Bild und Ton sind in jedem Moment des Videos konsistent. Tatsächlich kann diese Annahme jedoch nicht immer bestätigt werden. Beispielsweise nimmt die Kamera im Beispiel „Basketball spielen“ manchmal Szenen wie den Zuschauerraum auf, die nichts mit der Bezeichnung „Basketball spielen“ zu tun haben. Daher werden Aufgaben wie die Lokalisierung und Analyse visueller und akustischer Ereignisse vorgeschlagen, um die visuellen und akustischen Komponenten in der Szene in einer zeitlichen Abfolge weiter herauszulösen. Der Mensch ist in der Lage, in audiovisuellen Szenen weitere Rückschlüsse zu ziehen, die über die Wahrnehmung hinausgehen. Obwohl die oben genannten Aufgaben der audiovisuellen Zusammenarbeit nach und nach ein detailliertes Verständnis der audiovisuellen Szene erreicht haben, wurde keine inferenzielle Analyse der audiovisuellen Komponenten durchgeführt. Mit der Entwicklung des Bereichs des visuell-visuellen Lernens haben einige Forscher kürzlich damit begonnen, dem visuell-visuellen Denken mehr Aufmerksamkeit zu schenken, beispielsweise der visuell-visuellen Beantwortung von Fragen und Dialogaufgaben. Diese Aufgaben zielen darauf ab, modalübergreifende raumzeitliche Überlegungen zu audiovisuellen Szenen anzustellen, szenenbezogene Fragen zu beantworten oder Dialoge über beobachtete audiovisuelle Szenen zu generieren.

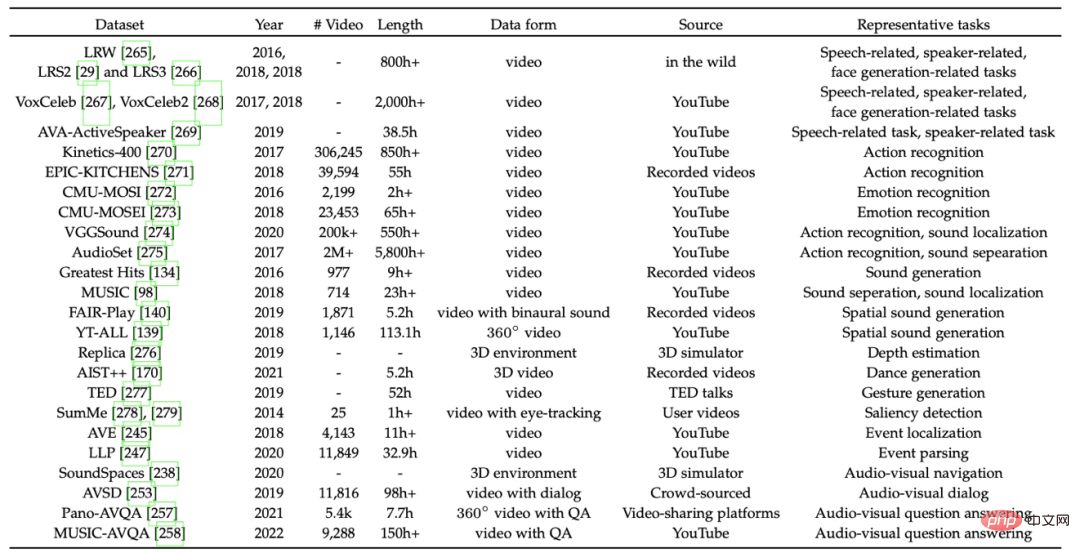

#🎜 🎜#6 Repräsentativer Datensatz 7 Trends und neue Perspektiven Erstens zeigen visuelle und akustische Modalitäten die interessierende Sache aus verschiedenen Perspektiven. Daher gilt die Semantik audiovisueller Daten als semantisch konsistent. Beim visuell-visuellen Lernen spielt die semantische Konsistenz bei den meisten Aufgaben eine wichtige Rolle. Diese Konsistenz ermöglicht es beispielsweise, visuelle und akustische Informationen zu kombinieren, um eine bessere visuelle und akustische Erkennung und eine Verbesserung einzelner Modalitäten zu erreichen. Darüber hinaus spielt die semantische Konsistenz zwischen audiovisuellen Modalitäten auch eine wichtige Rolle beim modalübergreifenden Abruf- und Transferlernen. Zweitens können sowohl Bild als auch Ton dabei helfen, den genauen räumlichen Standort des klingenden Objekts zu bestimmen. Auch diese räumliche Korrespondenz hat ein breites Anwendungsspektrum. Beispielsweise wird diese Konsistenz bei Schallquellenlokalisierungsaufgaben verwendet, um anhand von Eingabeaudio die visuelle Position eines schallemittierenden Objekts zu bestimmen. Im Stereo-Fall können visuelle Tiefeninformationen auf der Grundlage von binauralem Audio geschätzt werden, oder Stereo-Audio kann unter Verwendung visueller Informationen als Hilfsmittel generiert werden. Schließlich sind visuelle Inhalte und die von ihnen erzeugten Töne oft zeitlich konsistent. Diese Konsistenz wird auch in den meisten audiovisuellen Lernforschungen umfassend ausgenutzt, beispielsweise bei der Zusammenführung oder Vorhersage multimodaler Informationen bei audiovisuellen Erkennungs- oder Generierungsaufgaben. In der Praxis sind diese unterschiedlichen audiovisuellen Zusammenhänge nicht isoliert, sondern treten oft gemeinsam in audiovisuellen Szenen auf. Daher werden sie häufig gemeinsam für verwandte Aufgaben eingesetzt. Eine Kombination aus semantischer und zeitlicher Konsistenz ist der häufigste Fall. In einfachen Szenarien gelten Audio- und Videoclips mit demselben Zeitstempel sowohl semantisch als auch zeitlich als konsistent. Diese starke Annahme kann jedoch fehlschlagen, wenn beispielsweise das Videobild und der Hintergrundton mit demselben Zeitstempel nicht semantisch konsistent sind. Diese Fehlalarme beeinträchtigen das Training. Vor kurzem haben Forscher begonnen, sich auf diese Situationen zu konzentrieren, um die Qualität des Szenenverständnisses zu verbessern. Darüber hinaus ist auch die Kombination von semantischer und räumlicher Konsistenz üblich. Beispielsweise beruht die erfolgreiche Lokalisierung von Tonquellen in Videos auf semantischer Konsistenz, um den entsprechenden visuellen räumlichen Ort basierend auf dem Eingabeton zu erkunden. Darüber hinaus erzeugt das Stimmziel in den frühen Phasen der audiovisuellen Navigationsaufgabe einen gleichmäßigen, sich wiederholenden Ton. Obwohl die räumliche Konsistenz gewährleistet ist, ist der semantische Inhalt in Bild und Ton unkorreliert. Anschließend wird die semantische Konsistenz von Lauten und Äußerungsorten eingeführt, um die Qualität der audiovisuellen Navigation zu verbessern. Generell bietet die semantische, räumliche und zeitliche Konsistenz der visuellen und akustischen Modalitäten eine solide Unterstützung für die Forschung zum visuellen und akustischen Lernen. Die Analyse und Nutzung dieser Konsistenzen verbessert nicht nur die Leistung bestehender audiovisueller Aufgaben, sondern trägt auch zu einem besseren Verständnis audiovisueller Szenen bei. Dieser Artikel fasst die kognitiven Grundlagen audiovisueller Modalitäten zusammen und analysiert das Phänomen der menschlichen Mehrkanalwahrnehmung. Auf dieser Grundlage wird die aktuelle audiovisuelle Lernforschung in drei Teile unterteilt Kategorien: Audiovisuelle Verstärkung, Cross-modale Wahrnehmung und audiovisuelle Zusammenarbeit. Um die aktuelle Entwicklung im Bereich des audiovisuellen Lernens aus einer eher makroökonomischen Perspektive zu betrachten, schlägt der Artikel außerdem eine neue Perspektive auf das Verständnis audiovisueller Szenen vor: 1) Grundlegendes Szenenverständnis. Aufgaben zur audiovisuellen Verbesserung und modalübergreifenden Wahrnehmung konzentrieren sich oft auf die Fusion oder Vorhersage konsistenter audiovisueller Informationen. Der Kern dieser Aufgaben ist das grundlegende Verständnis audiovisueller Szenen (z. B. Aktionsklassifizierung von Eingabevideos) oder die Vorhersage modalübergreifender Informationen (z. B. Generieren entsprechender Audiodaten basierend auf stummen Videos). Allerdings in natürlicher Form Szenen Videos enthalten oft verschiedene visuelle und akustische Komponenten, die über den Rahmen dieser grundlegenden Szenenverständnisaufgaben hinausgehen. 2) Feinkörniges Szenenverständnis. Wie oben erwähnt, enthalten audiovisuelle Szenen normalerweise reichhaltige Komponenten unterschiedlicher Modalitäten. Daher haben Forscher einige Aufgaben zum Ablösen von Zielkomponenten vorgeschlagen. Beispielsweise zielt eine Schallquellenlokalisierungsaufgabe darauf ab, den sichtbaren Bereich zu markieren, in dem sich ein schallerzeugendes Zielobjekt befindet. Die Aufgabe zur Lokalisierung und Analyse audiovisueller Ereignisse bestimmt das hörbare oder sichtbare Zielereignis in Zeitreihen. Diese Aufgaben trennen die audiovisuellen Komponenten und entkoppeln die audiovisuellen Szenen, was zu einem detaillierteren Verständnis der Szenen im Vergleich zur vorherigen Stufe führt. 3) Kausales Szenenverständnis. In audiovisuellen Szenen können Menschen nicht nur interessante Dinge um sich herum wahrnehmen, sondern auch auf die Interaktionen zwischen ihnen schließen. Das Ziel des Szenenverständnisses in dieser Phase liegt näher am Streben nach einer menschenähnlichen Wahrnehmung. Derzeit werden nur wenige Missionen erforscht. Audiovisuelle Fragebeantwortungs- und Dialogaufgaben sind repräsentative Werke. Bei diesen Aufgaben wird versucht, die Verbindung von visuellen und akustischen Komponenten in Videos zu untersuchen und raumzeitliche Überlegungen anzustellen. Im Allgemeinen ist die Erforschung dieser drei Phasen unausgewogen. Vom grundlegenden Szenenverständnis zum kausalen Interaktionsszenenverständnis nimmt die Vielfalt und der Reichtum der damit verbundenen Forschung allmählich ab. Insbesondere steckt das Verständnis der kausalen Interaktionsszene noch in den Kinderschuhen. Dies weist auf einige mögliche Entwicklungsrichtungen für audiovisuelles Lernen hin: 1) Aufgabenintegration. Die meisten Forschungen im audiovisuellen Bereich sind aufgabenorientiert. Diese einzelnen Aufgaben simulieren und erlernen nur spezifische Aspekte der audiovisuellen Szene. Das Verstehen und Wahrnehmen audiovisueller Szenen erfolgt jedoch nicht isoliert. Beispielsweise betonen Schallquellen-Lokalisierungsaufgaben klangbezogene Objekte im Sehvermögen, während Ereignislokalisierungs- und Analyseaufgaben Zielereignisse zeitlich identifizieren. Es wird erwartet, dass die beiden Aufgaben integriert werden, um ein verfeinertes Verständnis audiovisueller Szenen zu erleichtern. Die Integration mehrerer audiovisueller Lernaufgaben ist eine Richtung, die es wert ist, in Zukunft erkundet zu werden. 2) Tieferes Verständnis kausaler Interaktionsszenarien. Derzeit ist die Vielfalt der Forschung zum Szenenverständnis, bei dem es um logisches Denken geht, noch begrenzt. Bestehende Aufgaben, darunter audiovisuelle Fragenbeantwortung und Dialog, konzentrieren sich meist auf die Durchführung von Dialogen auf der Grundlage von Ereignissen in Videos. Tiefgreifendere Arten von Schlussfolgerungen, wie etwa die Vorhersage akustischer oder visueller Ereignisse, die als Nächstes auftreten könnten, basierend auf einer Vorschauszene, verdienen in der Zukunft weitere Forschung. Um den Inhalt des Artikels besser darzustellen, ist diese Rezension außerdem mit einer laufend aktualisierten Projekthomepage ausgestattet, die den Lesern die Ziele und Entwicklung verschiedener Bild- und Tonaufgaben in Bildern, Videos und anderen Formen anzeigt Schnelles Verständnis des visuellen und akustischen Lernfeldes.

3 Visuelle und Videoverbesserung

4 kreuzmodale Wahrnehmung

Das menschliche Gehirn integriert die empfangenen audiovisuellen Informationen, damit sie einander ergänzen und das Verständnis verbessern der Szene. Daher ist es für Maschinen notwendig, eine menschenähnliche Wahrnehmung zu erreichen, indem sie die audiovisuelle Zusammenarbeit erforschen, anstatt nur multimodale Informationen zu fusionieren oder vorherzusagen. Zu diesem Zweck haben Forscher eine Vielzahl neuer Herausforderungen im Bereich des visuellen und akustischen Lernens eingeführt, darunter die Analyse visueller und akustischer Komponenten sowie visuelles und akustisches Denken.

Abbildung 4: Aufgaben im Zusammenhang mit Video- und Audio-Zusammenarbeit

Abbildung 4: Aufgaben im Zusammenhang mit Video- und Audio-Zusammenarbeit In diesem Abschnitt werden einige repräsentative Datensätze im Bereich des audiovisuellen Lernens besprochen.

Obwohl audiovisuelle Modalitäten heterogene Datenformen aufweisen, deckt ihre interne Konsistenz semantische, räumliche und zeitliche Aspekte ab und legt damit den Grundstein für die audiovisuelle Forschung.

7.2 Eine neue Perspektive auf das Szenenverständnis

Das obige ist der detaillierte Inhalt vonBlick auf die Vergangenheit und Zukunft des multimodalen Lernens aus audiovisueller Perspektive. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr