Heim >Technologie-Peripheriegeräte >KI >Enthüllen Sie das Geheimnis hinter dem himmelhohen Preis und der Superkalkulation von ChatGPT! Zehntausende Nvidia A100 kosten Microsoft Hunderte Millionen Dollar

Enthüllen Sie das Geheimnis hinter dem himmelhohen Preis und der Superkalkulation von ChatGPT! Zehntausende Nvidia A100 kosten Microsoft Hunderte Millionen Dollar

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 12:40:021116Durchsuche

ChatGPT kann heute zum weltweit beliebten Topmodell werden und ist aufgrund der dahinter stehenden Super-Rechenleistung unverzichtbar.

Daten zeigen, dass der gesamte Rechenleistungsverbrauch von ChatGPT etwa 3640 PF-Tage beträgt (d. h. wenn eine Billiarde Mal pro Sekunde berechnet wird, dauert die Berechnung 3640 Tage).

Also, wie wurde der von Microsoft speziell für OpenAI gebaute Supercomputer geboren?

Am Montag veröffentlichte Microsoft in seinem offiziellen Blog zwei Artikel hintereinander und entschlüsselte persönlich diesen ultrateuren Supercomputer und das große Upgrade von Azure – das Hinzufügen von Tausenden der leistungsstärksten H100-Grafikkarten von NVIDIA und der schnelleren InfiniBand-Netzwerkverbindungstechnologie.

Auf dieser Grundlage hat Microsoft auch offiziell die neueste virtuelle Maschine ND H100 v5 angekündigt. Die spezifischen Spezifikationen lauten wie folgt:

- 8 NVIDIA H100 Tensor Core GPUs sind über NVSwitch und NVLink 4.0 der nächsten Generation miteinander verbunden Jede GPU verfügt über 400 Gbit/s NVIDIA Quantum-2 CX7 InfiniBand mit 3,2 Tbit/s nicht blockierendem Fat-Tree-Netzwerk pro VM.

- NVSwitch und NVLink 4.0 zwischen den 8 lokalen GPUs pro VM. Mit 3,6 TB/s bidirektionaler Bandbreite

- Skalierbare Intel Macht

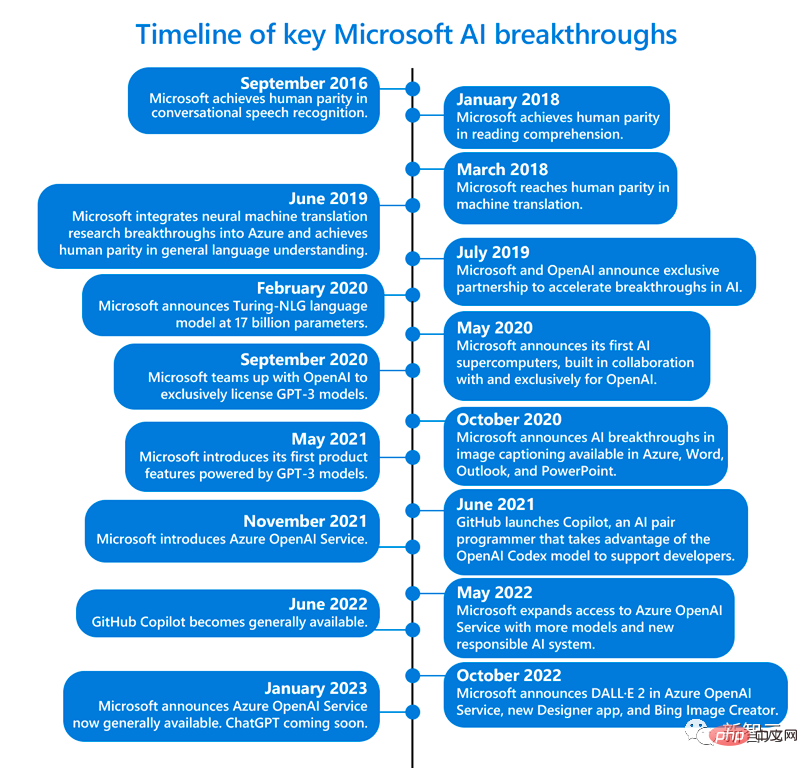

- Vor etwa fünf Jahren schlug OpenAI Microsoft eine mutige Idee vor – den Aufbau eines künstlichen Intelligenzsystems, das die Art und Weise, wie Menschen mit Computern interagieren, für immer verändern könnte.

- Damals hätte niemand gedacht, dass dies bedeuten würde, dass KI reine Sprache verwenden könnte, um jedes von Menschen beschriebene Bild zu erstellen, und dass Menschen Chatbots verwenden könnten, um Gedichte, Liedtexte, Papiere, E-Mails, Menüs zu schreiben ... …

- Um dieses System aufzubauen, benötigt OpenAI viel Rechenleistung – die Art, die wirklich extrem große Berechnungen unterstützen kann.

Schließlich gab es zu diesem Zeitpunkt keine Hardware, die die Anforderungen von OpenAI erfüllen konnte, und es war nicht sicher, ob der Bau eines so riesigen Supercomputers im Azure-Clouddienst das System direkt zum Absturz bringen würde.

Dann begann für Microsoft eine schwierige Phase der Erkundung.

Nidhi Chappell (links), Produktleiterin für Azure High Performance Computing und Künstliche Intelligenz bei Microsoft, und Phil Waymouth (rechts), Senior Director für strategische Partnerschaften bei Microsoft

Um einen Supercomputer zu bauen Zur Unterstützung des OpenAI-Projekts wurden Hunderte Millionen Dollar ausgegeben, um Zehntausende Nvidia-A100-Chips auf der Azure-Cloud-Computing-Plattform miteinander zu verbinden und Server-Racks zu modernisieren.

Darüber hinaus ist Microsoft sehr engagiert, um diese Supercomputing-Plattform für OpenAI anzupassen, und hat den Bedürfnissen von OpenAI große Aufmerksamkeit geschenkt und sich beim Training von KI über die wichtigsten Bedürfnisse auf dem Laufenden gehalten.

Wie viel kostet so ein großes Projekt? Scott Guthrie, Executive Vice President für Cloud Computing und künstliche Intelligenz bei Microsoft, wollte den genauen Betrag nicht bekannt geben, sagte aber, es handele sich „wahrscheinlich um mehr als“ ein paar hundert Millionen Dollar. Die Probleme von OpenAI

Phil Waymouth, der für strategische Partnerschaften zuständige Microsoft-Manager, wies darauf hin, dass der Umfang der Cloud-Computing-Infrastruktur, die für OpenAI-Schulungsmodelle erforderlich ist, in der Branche beispiellos ist.

Exponentiell wachsende Netzwerk-GPU-Clustergrößen, die über das hinausgehen, was irgendjemand in der Branche jemals versucht hat aufzubauen.

Der Grund, warum Microsoft entschlossen ist, mit OpenAI zusammenzuarbeiten, liegt darin, dass das Unternehmen fest davon überzeugt ist, dass dieses beispiellose Ausmaß an Infrastruktur die Geschichte verändern, neue KI und eine neue Programmierplattform schaffen und Kunden Produkte und Dienste bieten wird, die tatsächlich in Mode sind ihren Interessen dienen.

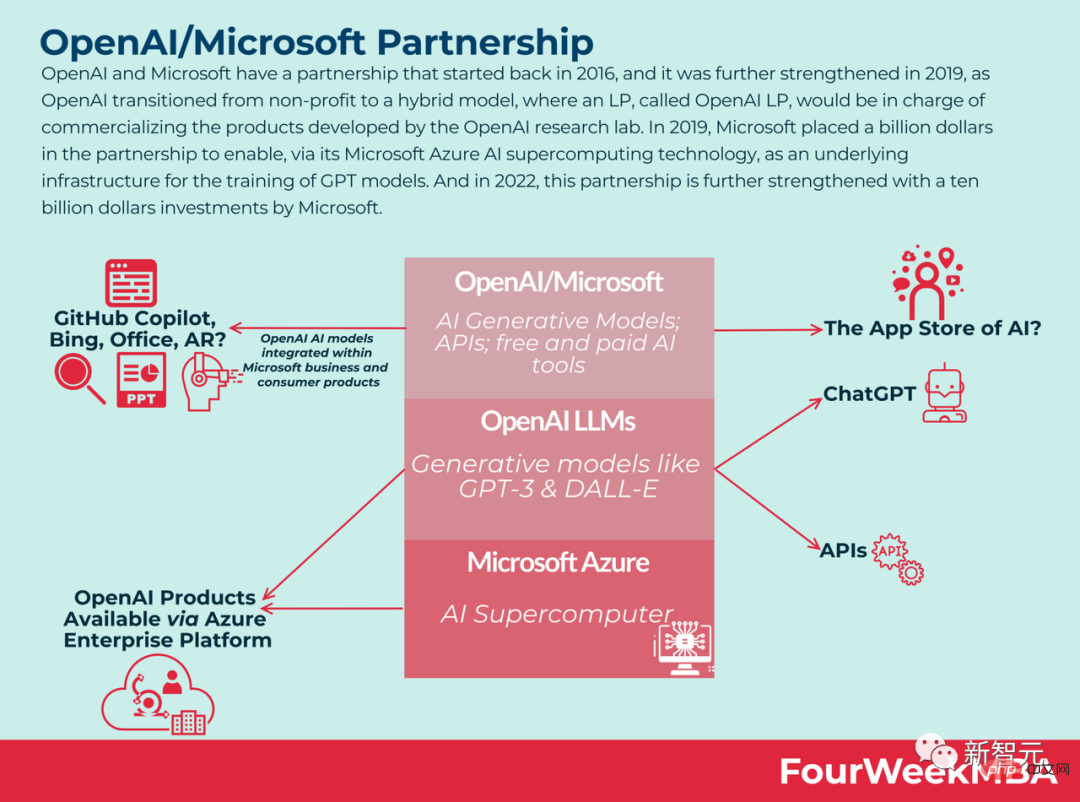

Jetzt scheint es, dass diese Hunderte Millionen Dollar offensichtlich nicht verschwendet wurden – die Wette war richtig. Auf diesem Supercomputer werden die Modelle, die OpenAI trainieren kann, immer leistungsfähiger, und er hat die erstaunlichen Funktionen von KI-Tools freigeschaltet und damit fast die vierte industrielle Revolution der Menschheit eingeleitet, und ChatGPT war geboren. . Microsoft war sehr zufrieden und investierte Anfang Januar weitere 10 Milliarden US-Dollar in OpenAI. Man kann sagen, dass sich Microsofts Ehrgeiz, die Grenzen des KI-Supercomputings zu durchbrechen, ausgezahlt hat. Dahinter spiegelt sich der Wandel von der Laborforschung hin zur KI-Industrialisierung wider. Derzeit nimmt Microsofts Office-Software-Imperium Gestalt an. Die ChatGPT-Version von Bing kann uns bei der Suche nach Urlaubsvereinbarungen helfen. Der Chatbot in Viva Sales kann Vermarktern beim Schreiben von E-Mails helfen Der Azure OpenAI-Dienst ermöglicht uns den Zugriff auf das große Sprachmodell von OpenAI und den Zugriff auf die Unternehmensfunktionen von Azure. Tatsächlich hat Microsoft im November letzten Jahres offiziell kündigte an, mit Nvidia zusammenzuarbeiten, um „einen der leistungsstärksten KI-Supercomputer der Welt“ zu bauen, um die enorme Rechenlast zu bewältigen, die zum Trainieren und Skalieren von KI erforderlich ist. Dieser Supercomputer basiert auf der Azure-Cloud-Infrastruktur von Microsoft und nutzt Zehntausende Nvidia H100- und A100-Tensor-Core-GPUs sowie seine Quantum-2 InfiniBand-Netzwerkplattform. Nvidia sagte in einer Erklärung, dass der Supercomputer zur Untersuchung und Beschleunigung generativer KI-Modelle wie DALL-E und Stable Diffusion verwendet werden könne.

Da KI-Forscher beginnen, leistungsstärkere GPUs zu verwenden, um komplexere KI-Arbeitslasten zu bewältigen, erkennen sie, dass das Potenzial größer ist für KI-Modelle, die Nuancen so gut verstehen, dass sie viele verschiedene Sprachaufgaben gleichzeitig bewältigen können. Einfach ausgedrückt: Je größer das Modell, desto mehr Daten haben Sie, desto länger können Sie es trainieren, desto besser ist die Genauigkeit des Modells. Aber diese größeren Modelle werden bald an die Grenzen der vorhandenen Rechenressourcen stoßen. Und Microsoft weiß, wie der von OpenAI benötigte Supercomputer aussieht und wie groß er sein muss. Das bedeutet natürlich nicht einfach, ein paar GPUs zu kaufen und sie miteinander zu verbinden, und dann können sie mit der Zusammenarbeit beginnen. „Wir müssen es größeren Modellen ermöglichen, länger zu trainieren, was bedeutet, dass Sie nicht nur über die größte Infrastruktur verfügen müssen, sondern auch dafür sorgen müssen, dass sie langfristig zuverlässig läuft“, sagte Microsoft Alistair Speirs, globaler Infrastrukturdirektor von Azure. Diese Maschinen und Chips. Beispiele hierfür sind die Nutzung von Außenluft in kühleren Klimazonen und High-Tech-Verdunstungskühler in heißeren Klimazonen. Da außerdem alle Maschinen gleichzeitig gestartet werden, muss Microsoft auch die Platzierung dieser und die Stromversorgung berücksichtigen. Es ist so, als würde man in der Küche gleichzeitig die Mikrowelle, den Toaster und den Staubsauger einschalten, allerdings in der Rechenzentrumsversion. Groß angelegtes KI-Training Die Herausforderung besteht darin, Zehntausende nebeneinander angeordneter GPUs aufzubauen, zu betreiben und zu warten, die in einem InfiniBand-Netzwerk mit hohem Durchsatz und geringer Latenz miteinander verbunden sind. Diese Größenordnung hat den Testumfang der GPU- und Netzwerkgeräteanbieter bei weitem übertroffen und ist völliges Neuland. Niemand weiß, ob die Hardware in diesem Ausmaß kaputt gehen wird.

Nidhi Chappell, Leiterin für Hochleistungsrechnen und Produkte für künstliche Intelligenz bei Microsoft Azure, erklärte, dass während des Trainingsprozesses von LLM die beteiligten Großberechnungen normalerweise auf Tausende von GPUs in einem Cluster aufgeteilt werden. In einer Phase namens allreduce tauschen GPUs Informationen über die von ihnen geleistete Arbeit aus. Zu diesem Zeitpunkt muss die Beschleunigung über das InfiniBand-Netzwerk erfolgen, damit die GPU die Berechnung abschließen kann, bevor der nächste Berechnungsblock beginnt. Nidhi Chappell sagte, dass, da diese Bemühungen Tausende von GPUs umfassen, zusätzlich zur Gewährleistung der Zuverlässigkeit der Infrastruktur viele, viele Optimierungen auf Systemebene erforderlich sind, um die beste Leistung zu erzielen, und das über viele Generationen hinweg aus Erfahrung. Die sogenannte Optimierung auf Systemebene umfasst Software, die GPU- und Netzwerkgeräte effektiv nutzen kann. In den letzten Jahren hat Microsoft diese Technologie entwickelt, um die Fähigkeit zum Trainieren von Modellen mit zig Billionen Parametern zu erhöhen und gleichzeitig die Schulungskosten sowie den Ressourcenbedarf und die Zeit für die Bereitstellung dieser Modelle zu senken. Waymouth wies darauf hin, dass Microsoft und seine Partner auch schrittweise die Kapazität von GPU-Clustern erhöht, InfiniBand-Netzwerke entwickelt und geprüft haben, wie weit sie die Rechenzentrumsinfrastruktur vorantreiben können, die erforderlich ist, um GPU-Cluster am Laufen zu halten, einschließlich Kühlsystemen und unterbrechungsfreier Stromversorgung Versorgungssystem und Notstromgenerator. Eric Boyd, Corporate Vice President der Microsoft AI Platform, sagte, dass diese Art von Supercomputing-Leistung, die für das Training großer Sprachmodelle und die nächste Welle von KI-Innovationen optimiert ist, bereits direkt in den Azure-Clouddiensten verfügbar ist. Und Microsoft hat durch die Zusammenarbeit mit OpenAI viel Erfahrung gesammelt. Wenn andere Partner kommen und die gleiche Infrastruktur wünschen, kann Microsoft diese auch bereitstellen. Mittlerweile decken die Azure-Rechenzentren von Microsoft mehr als 60 Regionen auf der ganzen Welt ab. Neue virtuelle Maschine: ND H100 v5 Auf der oben genannten Infrastruktur hat Microsoft weiterhin Verbesserungen vorgenommen. Heute hat Microsoft offiziell neue, massiv skalierbare virtuelle Maschinen angekündigt, die die neueste NVIDIA H100 Tensor Core GPU und das NVIDIA Quantum-2 InfiniBand-Netzwerk integrieren. Mit virtuellen Maschinen kann Microsoft seinen Kunden eine Infrastruktur bereitstellen, die sich an den Umfang jeder KI-Aufgabe anpassen lässt. Laut Microsoft bietet die neue virtuelle Maschine ND H100 v5 von Azure Entwicklern eine überragende Leistung beim Aufrufen Tausender GPUs. Referenz: https://www.php.cn/link/a7bf3f5462cc82062e41b3a2262e1a21

hat sich mit Nvidia zusammengetan

Das obige ist der detaillierte Inhalt vonEnthüllen Sie das Geheimnis hinter dem himmelhohen Preis und der Superkalkulation von ChatGPT! Zehntausende Nvidia A100 kosten Microsoft Hunderte Millionen Dollar. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr