Heim >Technologie-Peripheriegeräte >KI >Riesige Unterschiede innerhalb von NLPern! Drei Top-Universitäten in den Vereinigten Staaten haben einen Umfragebericht veröffentlicht: 62 % der Praktiker sind sich einig, dass der Winter kommt

Riesige Unterschiede innerhalb von NLPern! Drei Top-Universitäten in den Vereinigten Staaten haben einen Umfragebericht veröffentlicht: 62 % der Praktiker sind sich einig, dass der Winter kommt

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 11:40:061001Durchsuche

Natural Language Understanding (NLP) gilt als das Kronjuwel der künstlichen Intelligenz. Mit der Unterstützung groß angelegter Sprachmodelle haben Menschen endlich die Möglichkeit, Computer Sprache verstehen zu lassen.

Aber dieses „Verständnis“ muss immer noch in Anführungszeichen gesetzt werden, obwohl das Modell den Menschen in einigen Bereichen wie Schreiben, Textklassifizierung usw. unterstützen kann Es ist noch weit davon entfernt, wirklich menschliche Sprachintelligenz zu erreichen.

Von Mai bis Juni dieses Jahres haben 11 Forscher der University of Washington, der New York University und der Johns Hopkins University einen Fragebogen in der NLP-Forschungsgemeinschaft gestartet, um umfassend Meinungen zu kontroversen Themen im Bereich NLP einzuholen, einschließlich des Einflusses von die Branche in diesem Bereich, die Größe der Branche, Bedenken hinsichtlich der Risiken der künstlichen allgemeinen Intelligenz (AGI), ob Sprachmodelle Sprache verstehen, zukünftige Forschungsrichtungen und ethische Fragen usw.

Umfrage-Homepage: https://nlpsurvey.net/

Berichtsadresse: https://nlpsurvey.net/nlp-metasurvey-results.pdf

Frageformat wie:

Kann das Sprachmodell verstehen? die Sprache? Kann es in Zukunft durchgeführt werden?

Sind traditionelle Modell-Benchmarking-Paradigmen noch verfügbar?

Welches Vorhersagemodell ist für die Entwicklung und Veröffentlichung durch Forscher ethisch vertretbar?

Wird der nächste wirkungsvollste Fortschritt aus der Industrie oder der Wissenschaft kommen?

Den Umfrageergebnissen zufolge sind die Ansichten der Befragten zu diesen Themen fast halb so groß. Zusätzlich zur Beantwortung der Frage forderten die Forscher die Befragten auch auf, die Verteilung der Antworten auf die Frage vorherzusagen, um falsche soziologische Überzeugungen (falsche soziologische Überzeugungen) zu entdecken, bei denen die Vorhersagen der Gemeinschaft nicht mit der Realität übereinstimmen. Die experimentellen Ergebnisse waren wie erwartet: NLP-Praktiker Es ist eine Divergenz zwischen der Idee und dem aktuellen Stand des gesamten Fachgebiets entstanden. Unter anderem lässt sich auch erkennen, dass die Community den Nutzen von Benchmarks und die Fähigkeit von NLP-Modellen zur Lösung realer Probleme stark überschätzt und die Bedeutung von Sprachstruktur, induktiver Voreingenommenheit und interdisziplinärer Wissenschaft unterschätzt. Insgesamt haben 480 Personen den Fragebogen ausgefüllt, von denen 327 (68 %) zwischen 2019 und 2022 mindestens zwei ACL-Veröffentlichungen mitverfasst haben und zur Zielgruppe der Umfrage gehören. Nach Angaben von ACL Anthology erfüllten 6.323 Personen die Bedingungen, was bedeutet, dass etwa 5 % der erfahrenen NLP-Praktiker an der Umfrage teilnahmen.

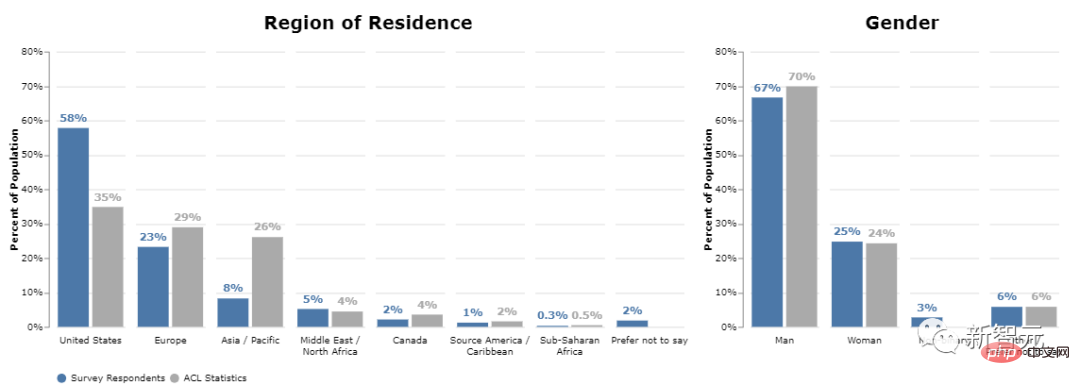

Unterteilt nach geografischem Standort stammen 58 % aus den Vereinigten Staaten (35 % mehr als der statistische ACL-Wert), 23 % aus Europa und 8 % aus Asien (viel weniger als der statistische ACL-Wert von 26 %). Unter ihnen machen NLP-Forscher aus China 3 % aus (der statistische ACL-Wert beträgt 9 %).

Aktueller Status des Feldes

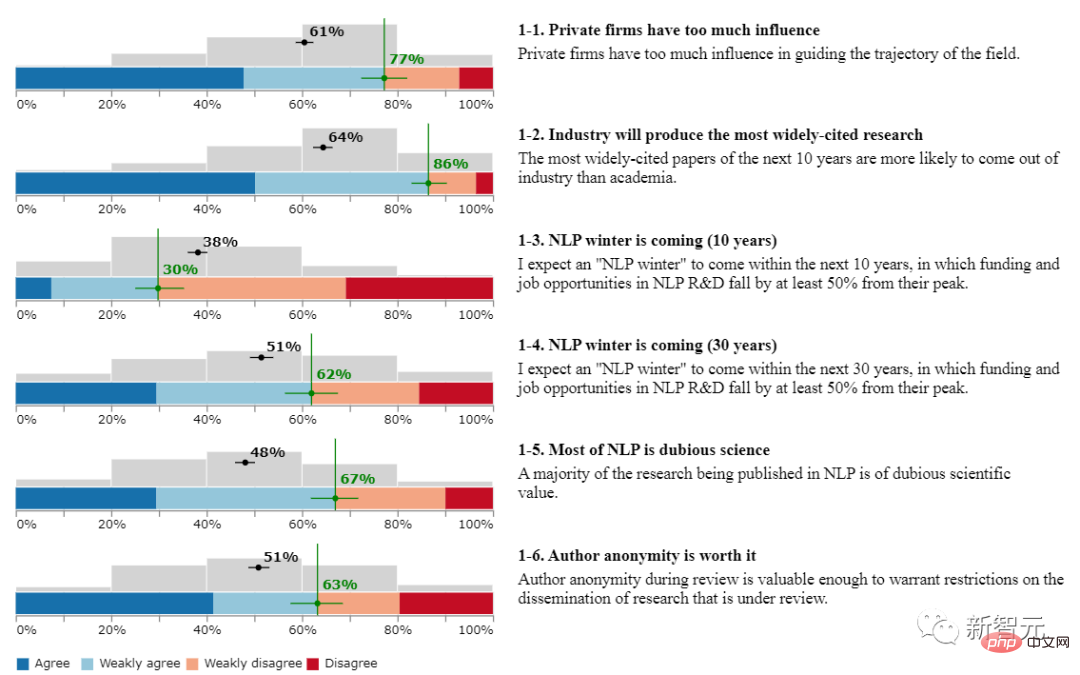

Dieser Teil enthält sechs Fragen, die Benutzer mit „stimme zu“, „stimme eher zu“, „stimme nicht ganz zu“ und „stimme nicht zu“ beantworten müssen.

1. Haben private Unternehmen zu viel Einfluss?

77 % der Befragten stimmen zu.

2. Wird die Branche die am häufigsten zitierten Forschungsergebnisse liefern?

86 % der Befragten stimmen darin überein, dass Beiträge, die in den nächsten zehn Jahren häufig zitiert werden, eher aus der Industrie als aus der Wissenschaft stammen.

Viele Befragte glauben jedoch, dass die Anzahl der Zitate eines Werks seinen Wert oder seine Bedeutung nicht gut widerspiegelt und dass die anhaltende Dominanz der Branche in diesem Bereich negative Auswirkungen haben wird, etwa in Basissystemen wie z GPT -3 und die absolute Führung von PaLM.

Und unter den Befragten im akademischen Bereich sind etwa 82 % der Meinung, dass die Industrie zu viel Einfluss hat, während nur 58 % der Befragten in der Industrie dieser Meinung sind.

3. Kommt NLP innerhalb von zehn Jahren in den kalten Winter?

Nur 30 % der Befragten stimmten zu, dass Investitionen und Beschäftigungsmöglichkeiten in der NLP-Forschung und -Entwicklung im Vergleich zur Spitzenzeit um mindestens 50 % zurückgehen werden.

Obwohl 30 % keine große Zahl sind, spiegelt sie auch wider, dass dieser Teil der NLP-Forscher glaubt, dass dieser Bereich in naher Zukunft große Veränderungen erfahren wird, zumindest werden die Investmentfonds zurückgehen. Es kann viele Gründe für Pessimismus geben, wie zum Beispiel die Stagnation der Innovation aufgrund des übermäßigen Einflusses der Industrie, die Monopolisierung der Industrie mit einer kleinen Anzahl gut ausgestatteter Labore, das Verschwinden der Grenzen zwischen NLP und anderen KI-Teilbereichen usw . .

4. Kommt NLP in dreißig Jahren in den kalten Winter?

62 % der Befragten stimmten zu, dass sich das NLP-Feld auf lange Sicht „auflösen“ oder sogar abkühlen könnte.

5. Die meisten der im Bereich NLP veröffentlichten Arbeiten sind von fragwürdigem wissenschaftlichem Wert (zweifelhaft)?

67 % der Befragten stimmen zu.

6. Ist es für Autoren wichtig, anonym zu rezensieren?

63 % der Befragten stimmten zu. Die Anonymität des Autors während der Begutachtung ist wertvoll genug, um Einschränkungen bei der Verbreitung der begutachteten Forschungsergebnisse zu rechtfertigen.

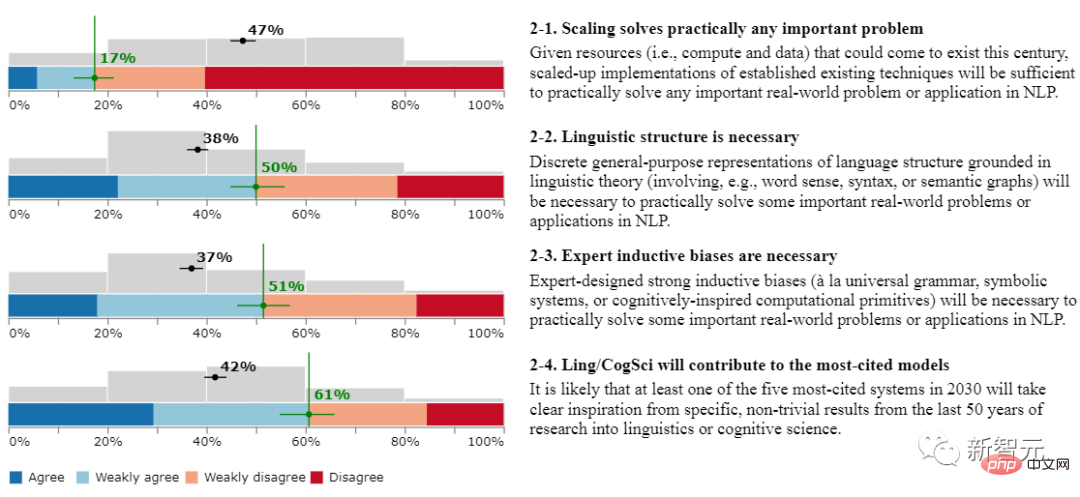

Skalierung, Induktionsverzerrung und verwandte Bereiche

Dieser Abschnitt enthält vier Fragen.

1. Kann Waage fast alle Schlüsselprobleme lösen?

Nur 17 % der Befragten stimmten zu, dass bei Nutzung aller Rechen- und Datenressourcen des 21. Jahrhunderts die groß angelegte Implementierung vorhandener Technologie ausreichen würde, um tatsächlich jedes wichtige reale Problem oder jede NLP-Anwendung zu lösen.

2. Ist es notwendig, sprachliche Strukturen einzuführen?

50 % der Befragten stimmen zu, dass diskrete universelle Darstellungen von Sprachstrukturen auf der Grundlage linguistischer Theorie (z. B. unter Einbeziehung von Wortbedeutung, Syntax oder semantischen Diagrammen) für die tatsächliche Lösung einiger wichtiger realer Probleme oder Anwendungen im NLP nützlich sind.

3. Ist die induktive Voreingenommenheit von Experten notwendig?

51 % der Befragten stimmten zu, dass starke induktive Vorurteile, die von Experten entwickelt wurden (z. B. universelle Grammatiken, symbolische Systeme oder kognitiv inspirierte Computerprimitive), notwendig sind, um einige wichtige reale Probleme oder Anwendungen im NLP tatsächlich zu lösen.

4. Werden Ling/CogSci zum am häufigsten zitierten Modell beitragen?

61 % der Befragten stimmen zu, dass es wahrscheinlich ist, dass mindestens eines der fünf am häufigsten genannten Systeme im Jahr 2030 auf konkreten, nicht trivialen Ergebnissen der linguistischen oder kognitionswissenschaftlichen Forschung der letzten 50 Jahre basieren wird. Klare Inspiration.

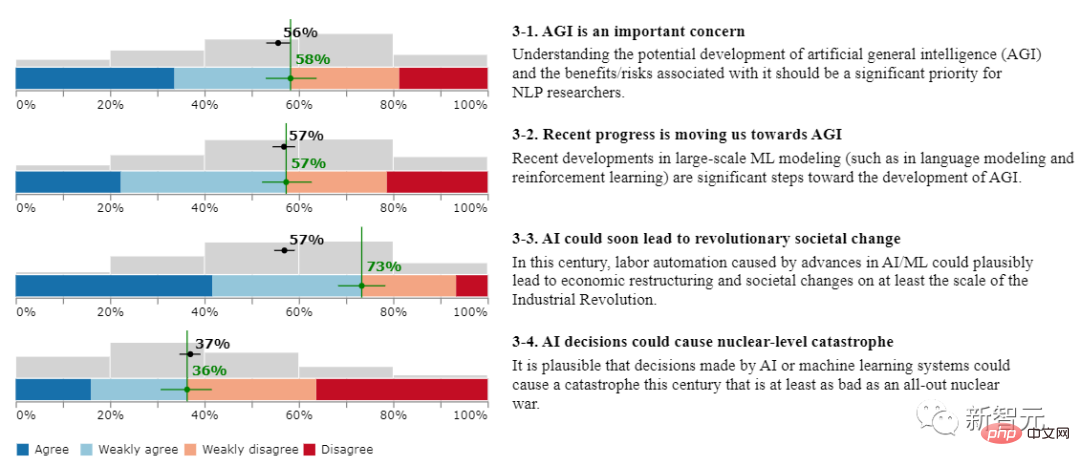

AGI und große Risiken

1 Ist AGI ein wichtiges Anliegen?

58 % der Befragten stimmten zu, dass das Verständnis der potenziellen Entwicklung der künstlichen allgemeinen Intelligenz (AGI) und der damit verbundenen Vorteile/Risiken eine wichtige Priorität für NLP-Forscher sein sollte.

2. Führen uns die jüngsten Entwicklungen in Richtung AGI?

57 % der Befragten stimmen zu, dass die jüngsten Entwicklungen in der groß angelegten ML-Modellierung (wie Sprachmodellierung und Reinforcement Learning) wichtige Schritte in Richtung AGI sind.

3. Künstliche Intelligenz könnte bald zu revolutionären gesellschaftlichen Veränderungen führen?

73 % der Befragten stimmten zu, dass die durch Fortschritte bei KI/ML verursachte Automatisierung der Arbeit in diesem Jahrhundert wahrscheinlich zu wirtschaftlichen Umstrukturierungen und sozialen Veränderungen in einem Ausmaß führen wird, das mindestens dem der industriellen Revolution entspricht.

4. Könnte die Entscheidungsfindung der künstlichen Intelligenz zu einer Katastrophe auf Atombombenniveau führen?

36 % der Befragten stimmten zu, dass Entscheidungen, die durch künstliche Intelligenz oder maschinelle Lernsysteme getroffen werden, in diesem Jahrhundert eine Katastrophe verursachen könnten, die mindestens so schwerwiegend ist wie ein ausgewachsener Atomkrieg.

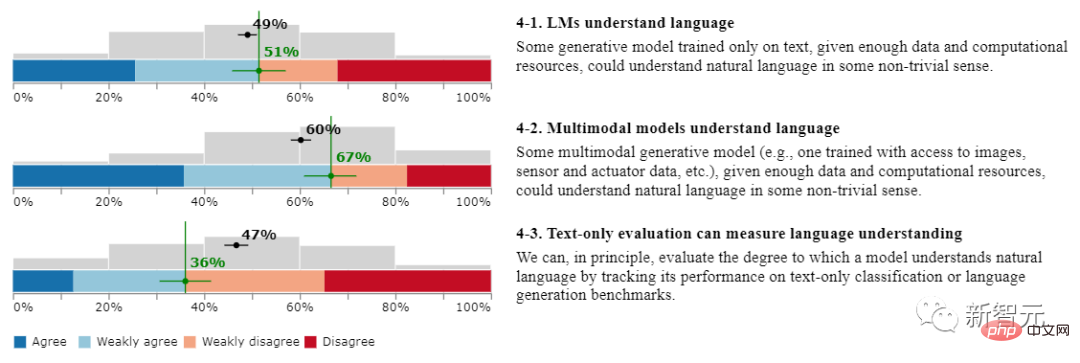

Sprachverständnis

1 Kann das Sprachmodell die Sprache verstehen?

51 % der Befragten stimmen zu. Einige generative Modelle, die nur auf Text trainiert werden, können natürliche Sprache gewissermaßen verstehen, wenn sie über genügend Daten und Rechenressourcen verfügen.

2 Können multimodale Modelle Sprache verstehen?

67 % der Befragten stimmen zu. Bei multimodalen generativen Modellen, beispielsweise solchen, die darauf trainiert sind, auf Bilder, Sensor- und Aktordaten usw. zuzugreifen, kann natürliche Sprache verstanden werden, sofern ausreichende Daten- und Rechenressourcen vorhanden sind.

3. Kann die Klartextbewertung die Sprachverständnisfähigkeit des Modells messen?

36 % der Befragten stimmten zu. Im Prinzip können wir bewerten, wie gut ein Modell natürliche Sprache versteht, indem wir seine Leistung anhand von Benchmarks zur Klartextklassifizierung oder zur Sprachgenerierung verfolgen.

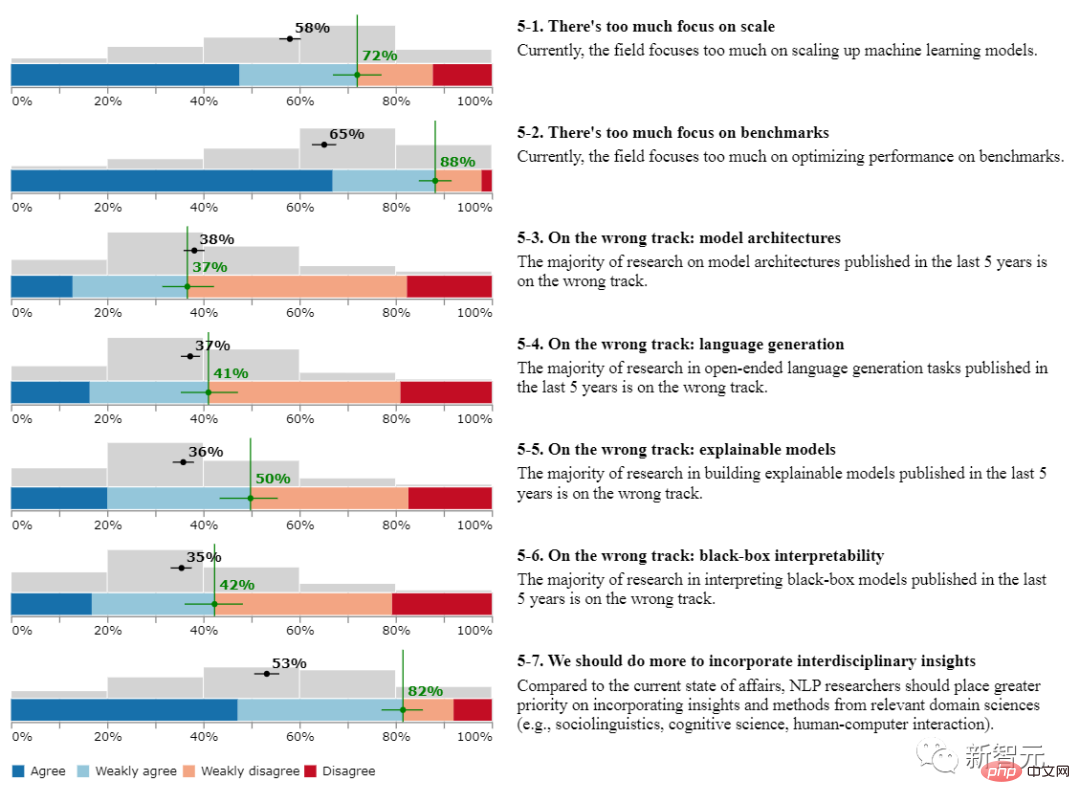

Zukünftige Forschungsrichtungen von NLP

1 Schenken Praktiker zu viel Aufmerksamkeit dem Maßstab von Sprachmodellen?

72 % der Befragten stimmen zu. Derzeit konzentriert sich das Fachgebiet zu sehr auf die Skalierung von Modellen für maschinelles Lernen.

2. Dem Benchmark-Datensatz zu viel Aufmerksamkeit schenken?

88 % der Befragten stimmen zu, dass sich aktuelle NLP-Modelle zu sehr auf die Optimierung der Leistung anhand von Benchmarks konzentrieren.

3. Geht die „Modellarchitektur“ in die falsche Richtung?

37 % der Befragten stimmen zu. Die meisten in den letzten fünf Jahren veröffentlichten Forschungsergebnisse zur Modellarchitektur sind auf dem falschen Weg.

4. Geht „Sprachgenerierung“ in die falsche Richtung?

41 % der Befragten stimmen zu, dass die meisten in den letzten 5 Jahren veröffentlichten Forschungsarbeiten zu Aufgaben zur Generierung offener Sprachen auf dem falschen Weg sind.

5. Geht die „Forschung zu interpretierbaren Modellen“ in die falsche Richtung?

50 % der Befragten stimmen zu, dass die meisten in den letzten 5 Jahren veröffentlichten Forschungsergebnisse zum Aufbau interpretierbarer Modelle auf dem falschen Weg sind.

6. Geht die „Black-Box-Interpretierbarkeit“ in die falsche Richtung?

42 % der Befragten stimmen zu, dass die meisten in den letzten 5 Jahren veröffentlichten Forschungsergebnisse zur Interpretation von Black-Box-Modellen auf dem falschen Weg sind.

7. Sollten wir mehr tun, um interdisziplinäre Erkenntnisse aufzunehmen?

82 % der Befragten stimmten zu, dass NLP-Forscher im Vergleich zur aktuellen Situation der Einbeziehung von Erkenntnissen und Methoden aus verwandten Wissenschaftsbereichen (wie Soziolinguistik, Kognitionswissenschaft, Mensch-Computer-Interaktion) größere Priorität einräumen sollten.

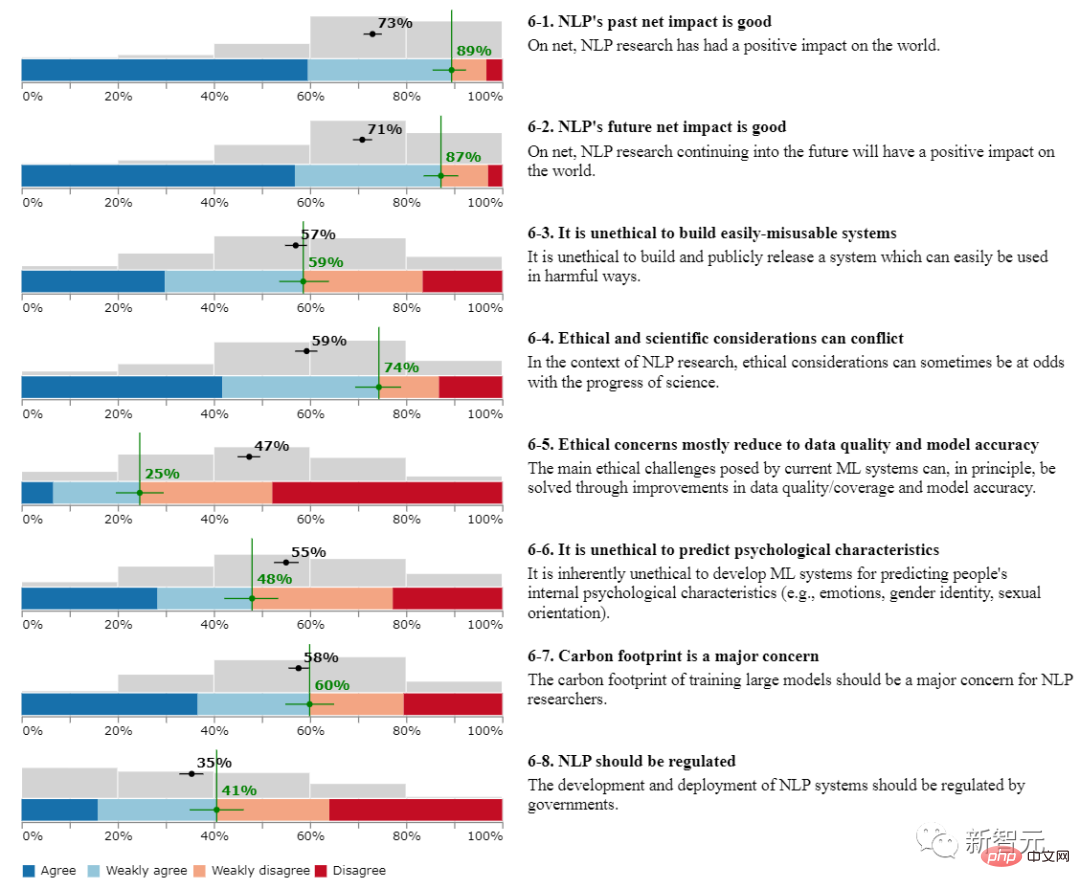

KI-Ethik

1. War der Einfluss von NLP in der Vergangenheit positiv?

89 % der Befragten stimmten zu, dass die NLP-Forschung im Allgemeinen einen positiven Einfluss auf die Welt hatte.

2. Wird die zukünftige Wirkung von NLP positiv sein?

87 % der Befragten waren sich einig, dass die NLP-Forschung in Zukunft generell einen positiven Einfluss auf die Welt haben wird.

3. Ist es unethisch, ein System aufzubauen, das leicht missbraucht werden kann?

59 % der Befragten stimmen zu.

4. Ethik und Wissenschaft können im Widerspruch stehen?

74 % der Befragten stimmten zu, dass im Kontext der NLP-Forschung ethische Überlegungen manchmal im Widerspruch zum wissenschaftlichen Fortschritt stehen.

5. Werden ethische Probleme hauptsächlich auf die Datenqualität und die Modellgenauigkeit zurückgeführt?

25 % der Befragten stimmten zu, dass die wichtigsten ethischen Probleme, die aktuelle maschinelle Lernsysteme aufwerfen, grundsätzlich durch eine Verbesserung der Datenqualität/-abdeckung und der Modellgenauigkeit gelöst werden können.

6. Ist es unethisch, psychologische Eigenschaften vorherzusagen?

48 % der Befragten stimmten zu, dass die Entwicklung maschineller Lernsysteme zur Vorhersage der internen psychologischen Merkmale von Menschen (wie Emotionen, Geschlechtsidentität, sexuelle Orientierung) von Natur aus unethisch ist.

7. Ist der CO2-Fußabdruck ein wichtiger Gesichtspunkt?

60 % der Befragten stimmten zu, dass der CO2-Fußabdruck beim Training großer Modelle ein Hauptanliegen für NLP-Forscher sein sollte.

8. Sollte NLP reguliert werden?

41 % der Befragten stimmen zu, dass die Entwicklung und der Einsatz von NLP-Systemen von der Regierung reguliert werden sollten.

Das obige ist der detaillierte Inhalt vonRiesige Unterschiede innerhalb von NLPern! Drei Top-Universitäten in den Vereinigten Staaten haben einen Umfragebericht veröffentlicht: 62 % der Praktiker sind sich einig, dass der Winter kommt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr