Heim >Technologie-Peripheriegeräte >KI >Wie ist das von OpenAI vorgeschlagene neue Mooresche Gesetz zu verstehen? Chinas verborgener Rechenleistungsriese hat etwas zu sagen

Wie ist das von OpenAI vorgeschlagene neue Mooresche Gesetz zu verstehen? Chinas verborgener Rechenleistungsriese hat etwas zu sagen

- 王林nach vorne

- 2023-04-12 11:34:071431Durchsuche

Dieser Artikel wird mit Genehmigung von AI New Media Qubit (öffentliche Konto-ID: QbitAI) nachgedruckt. Bitte wenden Sie sich für einen Nachdruck an die Quelle.

ChatGPT ist auf der ganzen Welt beliebt und alles, was damit zusammenhängt, steht im Vordergrund.

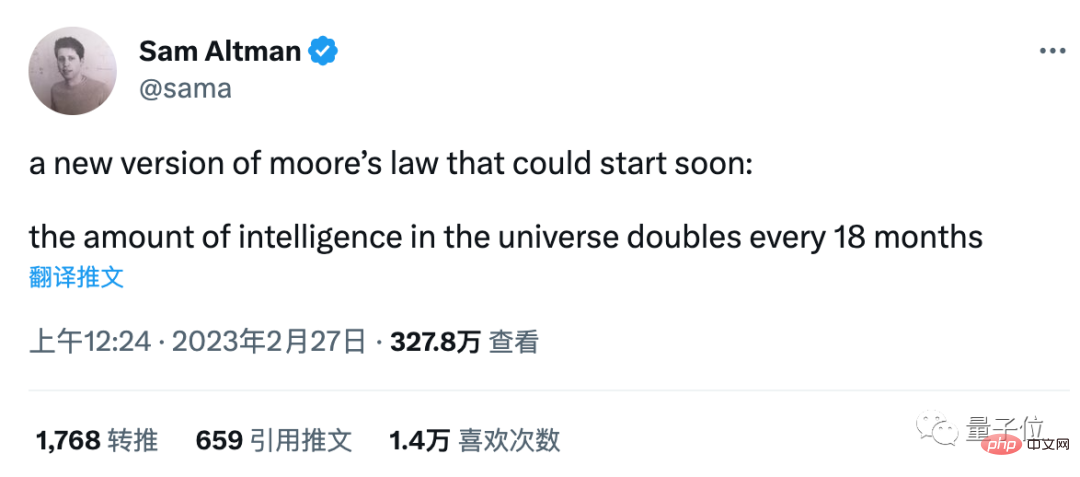

Die scheinbar beiläufigen Worte von OpenAI-CEO Sam Altman sind zum Mittelpunkt hitziger Diskussionen geworden:

Eine neue Version des Mooreschen Gesetzes erscheint bald, Die Intelligenz im Universum verdoppelt sich alle 18 Monate .

Einige Leute spekulieren, dass es sich möglicherweise auf die Parameter des neuronalen Netzwerks bezieht, aber es stimmt nicht mit den Daten der letzten Jahre überein.

Manche Menschen verstehen, dass es sich dabei um die Fähigkeit aller intelligenten Agenten, einschließlich Menschen und KI, handelt, aber die Messung dieses Indikators ist zu einem Problem geworden.

Es gibt auch viele Wissenschaftler und Internetnutzer, die diesem Urteil nicht zustimmen. Der IBM-Wissenschaftler Grady Booch sagte, dies sei Unsinn, und es wurde zum heißesten Kommentar Nummer eins.

Auf diese Diskussionen antwortete Altman einfach: „Noch nicht.“

Aber egal was passiert, hinter der rasanten Entwicklung der KI ist die Rechenleistung ein klarer und messbarer Indikator und eine wesentliche Voraussetzung.

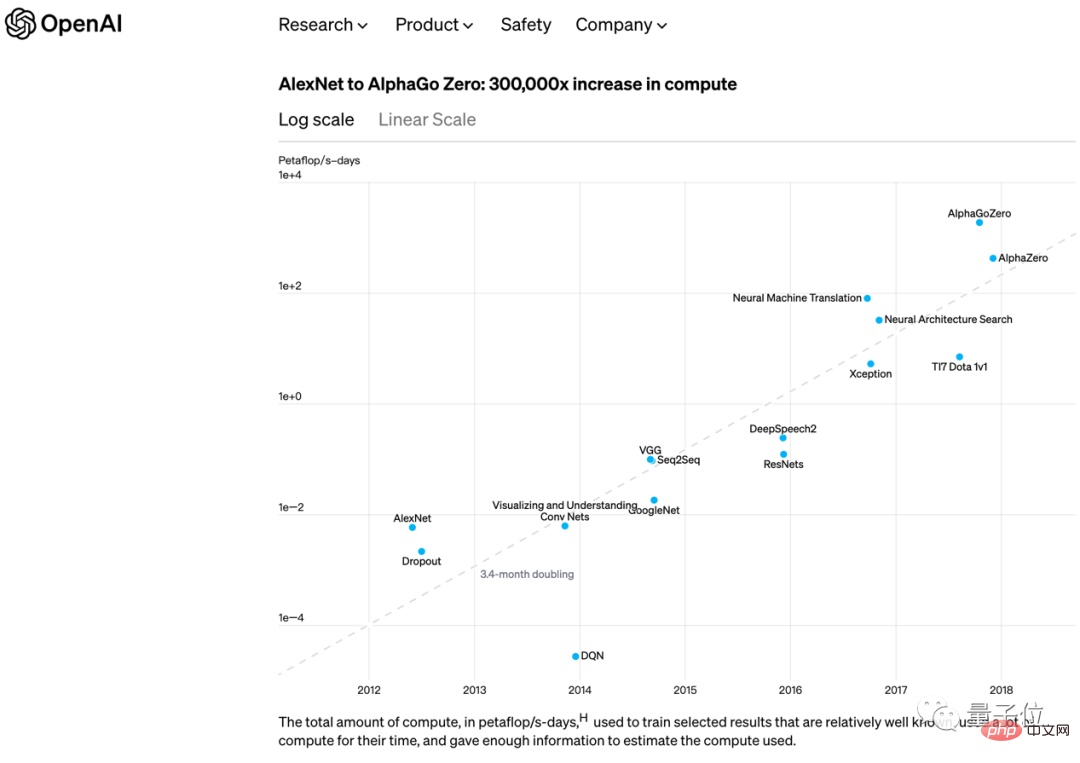

Bereits im Jahr 2018 veröffentlichte OpenAI auch eine weitere Meinung, die dem Mooreschen Gesetz ähnelt:

Von AlexNet im Jahr 2012 bis AlphaGo Zero Ende 2017, Die Rechenleistung, die zum Trainieren des größten KI-Modells alle 3,4 Monate erforderlich ist, verdoppelt sich .

Nicht lange danach verkürzte das GPT-3, das sie selbst herausbrachten, diese Zahl auf Verdoppelung in 2 Monaten.

In der ChatGPT-Ära muss nicht nur die Rechenleistung für das KI-Training berücksichtigt werden. Mit 100 Millionen monatlich aktiven Benutzern weltweit und dem Zugriff auf Produkte wie die Bing-Suche von Microsoft ist auch die Rechenleistung für KI-Inferenzen eine wichtige Unterstützung.

Der direkteste Anbieter von Rechenleistung für ChatGPT ist die Microsoft Azure Cloud, die seit der ersten Investition von 1 Milliarde US-Dollar im Jahr 2019 der exklusive Cloud-Anbieter von OpenAI ist.

Mit der jüngsten Zusatzinvestition von 10 Milliarden US-Dollar haben beide Parteien diesen Punkt in ihrer Stellungnahme noch einmal betont.

Exklusive Lieferung bedeutet, dass die Entwicklungsinfrastruktur von OpenAI vollständig auf der Azure-Cloud basiert und die von der Azure-Cloud bereitgestellte Toolkette nutzt.

Es bedeutet auch, dass sich die aufstrebende Armee von KI-Unternehmern nur dann für die Azure-Cloud entscheiden kann, wenn sie ChatGPT nutzen möchte.

Entsprechend wird Google AI durch seine eigene Google Cloud unterstützt, und Amazon, die Nummer eins in der Cloud-Computing-Branche, wandte sich ebenfalls dringend an HuggingFace, um bei der Bereitstellung des Open-Source-Großmodells Bloom mitzuarbeiten.

...

Und Cloud Computing ist nicht die Quelle der Rechenleistung. Gerade als ChatGPT boomt, sind auf der Angebotsseite der Rechenleistung eine Reihe von Unternehmen mit herausragender Leistung aufgetaucht.

Einige Spieler fallen Ihnen vielleicht sofort ein, aber es gibt auch einige Spieler, die möglicherweise unerwartet sind, weil sie in anderen Unternehmen zuvor zu bekannt waren.

Unter ihnen ist ein Spieler aus China.

Das neue Mooresche Gesetz kann nicht von der Rechenleistung getrennt werden

Als die letzte Welle von KI-Anwendungen, dargestellt durch Bilderkennungs- und Empfehlungsalgorithmen, implementiert wurde, um die Entwicklung der digitalen Wirtschaft voranzutreiben, entwickelte sich die Rechenleistung von einem technischen Begriff zu einem wirtschaftlichen Begriff , und sei von der Industrie genutzt worden, betonten die akademischen Kreise immer wieder.

Als diese Welle der generativen KI weltweite Begeisterung entfachte, wurde die Rechenleistung erneut verbessert, um für die Arbeit und das Leben der einfachen Leute relevant zu sein, und wurde von der Öffentlichkeit wahrgenommen.

Wie viel kostet ChatGPT?

SemiAnalysis, eine Informationsorganisation der Halbleiterindustrie, hat eine Schätzung vorgenommen: Gemessen an der GPU werden etwa 3.617 Nvidia HGX A100-Server benötigt, was 28.936 A100s entspricht, gemessen an den Mitteln, die Kosten für jede Benutzerfrage betragen 0,36 Cent, Es kann an einem Tag abgeschlossen werden. Es kostet 690.000 US-Dollar.

Die Schlussfolgerung lautet: Wenn ChatGPT den gesamten Datenverkehr der Google-Suchen tragen würde, wären insgesamt 4,1 Millionen NVIDIA A100-GPUs erforderlich.

Natürlich ist NVIDIA der bekannteste Profiteur der Popularität von ChatGPT. NVIDIA macht derzeit etwa 75 % bis 80 % des KI-Chip-Marktes aus. Mit der Unterstützung dieser Welle der Begeisterung kommen bei ChatGPT Goldmünzen an Laut aktuellem Finanzbericht liegt der Aktienkurs von NVIDIA bei . Im Jahr 2023 wird er um 45 % steigen.

CEO Huang Renxun gab in der Telefonkonferenz auch die neueste Erklärung ab:

„Generative KI hat globalen Unternehmen ein Gefühl der strategischen Dringlichkeit gegeben, künstliche Intelligenz zu entwickeln und einzusetzen.“

Und das ist laut Citibank It erst der Anfang Es wird prognostiziert, dass der GPU-Umsatz von Nvidia in den nächsten 12 Monaten 3 bis 11 Milliarden US-Dollar erreichen wird.

Neben NVIDIA ist TSMC auf Chipherstellungsebene der vor der GPU verfolgte ChatGPT-Bonusgewinner.

Kürzlich wurde berichtet, dass Nvidia, AMD und Apple kürzlich Notbestellungen für TSMC aufgegeben haben, in der Hoffnung, zukünftige Produktionskapazitäten zu nutzen.

Zuvor war TSMCs Hauptumsatzträger viele Jahre lang das Smartphone-Geschäft, doch im Jahr 2022 hat das Hochleistungs-Computing-Geschäft das Unternehmen unter dem doppelten Einfluss der düsteren Smartphone-Verkäufe und des Ausbruchs der künstlichen Intelligenz zum dritten Mal in Folge überholt -Vielleicht ist dies auch ein Wendepunkt in der Zeit.

Noch wichtiger ist, dass TSMC diese Änderung tatsächlich deutlich gemacht hat. In jüngsten öffentlichen Stellungnahmen hat TSMC optimistische Erwartungen für das kommende Jahr geäußert, und auch der Ausdruck ist sehr interessant: Obwohl die globale Halbleiterindustrie vor einer Rezession steht, wird für die Gesamtjahresleistung immer noch ein leichtes Wachstum erwartet.

Natürlich wird die Leistung von TSMC bei einem einfacheren und groberen Schluss tatsächlich nicht schlecht sein, denn die Rolle der Industriekette und das Verhältnis zwischen Angebot und Nachfrage sind vorhanden.

Werden die von ChatGPT eingebrachten Rechenleistungsdividenden auf der Grundlage dieses Angebots und dieser Nachfrage auch an Cloud-Computing- und Cloud-Service-Hersteller gehen?

Ja, nicht ganz.

Angesichts der Beliebtheit von ChatGPT deuten viele Analysen auf Cloud Computing hin, aber einige Analysten konzentrieren sich schnell auf die Zwischenverbindung – die Zwischenverbindung von der GPU zu den Cloud-Computing-Diensten – den Server.

Damit Chips wirklich eine Rolle spielen, können sie Server nicht umgehen: Wie die Chips mit hoher Geschwindigkeit miteinander verbunden sind, wie das gesamte Gehäuse den Energieverbrauch und die Wärmeableitung steuert und wie sich das Systemdesign an unterschiedliche Arbeitslasten anpasst, alles beeinflusst die endgültige Leistung und Effizienz.

Gartner prognostiziert, dass der globale Servermarkt bis 2025 135 Milliarden US-Dollar erreichen wird, wobei KI-Server und KI-Cloud-Dienste explodieren werden.

Und in diesem Link, in Richtung KI-Server, sind die am Anfang des Artikels erwähnten Rechenleistungsteilnehmer aus China versteckt.

Lenovo.

Vielleicht kannten Sie die Lenovo Group früher eher vom PC, aber das Wesentliche am PC ist auch die persönliche Rechenleistung.

Lenovo hat einen solchen Weg vom PC zum Hochleistungsrechnen bis hin zur umfassenderen Computerinfrastruktur durchlaufen.

Dies wird durch die intuitivsten Finanzberichtsdaten belegt. Laut dem von der Lenovo Group veröffentlichten Finanzbericht für das dritte Quartal (Oktober-Dezember 2022) verzeichnete ihr Infrastrukturlösungsgeschäft ISG (Infrastructure Solutions Group) einen Umsatzanstieg von 48 % und einen Anstieg des Betriebsgewinns um 156 %.

Dies steht in scharfem Kontrast zu den von DigiTimes im gleichen Zeitraum verzeichneten weltweiten Serverauslieferungen, die im Jahresvergleich um 7,1 % und im Monatsvergleich um 4,3 % zurückgingen.

Lenovo Group ISG bietet Infrastrukturleistungen und Lösungen mit Rechenleistung als Kernstück. Server sind eines der wichtigsten Unternehmen.

Und es wird direkter auf das Servergeschäft aufgeschlüsselt. Der Umsatz ist in diesem Quartal im Vergleich zum Vorjahr um 35 % gestiegen und hat sich zum drittgrößten Serveranbieter der Welt entwickelt – die Rechenleistungsdividende von GhatGPT ist unverzichtbar.

Aber die plötzliche Beliebtheit von ChatGPT hat die verborgene Rolle der Lenovo Group als Gewinner der Rechenleistung nur in den Vordergrund gerückt.

Wie wird Lenovo zum „unsichtbaren“ Champion der Rechenleistung?

Yang Yuanqing, Vorsitzender und CEO der Lenovo Group, sagte, dass die für ChatGPT erforderliche universelle Rechenleistungsinfrastruktur zufällig die seit vielen Jahren eingesetzte Stärke von Lenovo sei.

Lenovo hat den Bedarf an Computerausrüstung bereits vorhergesehen und eine neue IT-Architektur mit „End-Edge-Cloud-Netzwerk-Intelligence“ vorgeschlagen.

Letztes Jahr hat Lenovo die universelle Rechenleistung weiter vorgeschlagen. Das heißt, mit dem explosionsartigen Wachstum der Daten sind wir in eine neue Ära der Digitalisierung und Intelligenz eingetreten. Die Nachfrage nach „Einzelkampf“-Geräten ist weit davon entfernt, die Anforderungen der Datenverarbeitung zu erfüllen Die Nachfrage erfordert eine neue IT-Architektur mit „End-Edge-Cloud-Netzwerk-Intelligenz“, um Benutzern allgegenwärtige, universelle Rechenleistung bereitzustellen. Es ist ersichtlich, dass Lenovo keine „Wasserquelle“ zur Erzeugung von Rechenleistung sein möchte, sondern ein „Wasserlieferant“ – die Integration von Chips in Server, die Rechenleistung effizient freigeben können und von denen weniger wahrgenommen werden die Außenwelt.

In dieser Rolle und Positionierung ist die Lenovo Group sehr „stark“ – der Kern dieser Stärke liegt in zwei Aspekten.

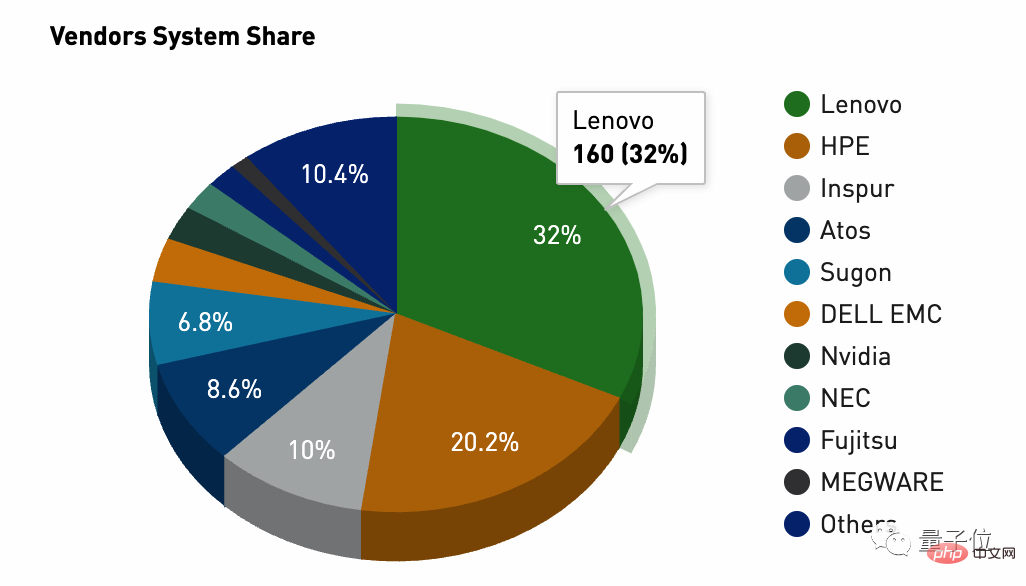

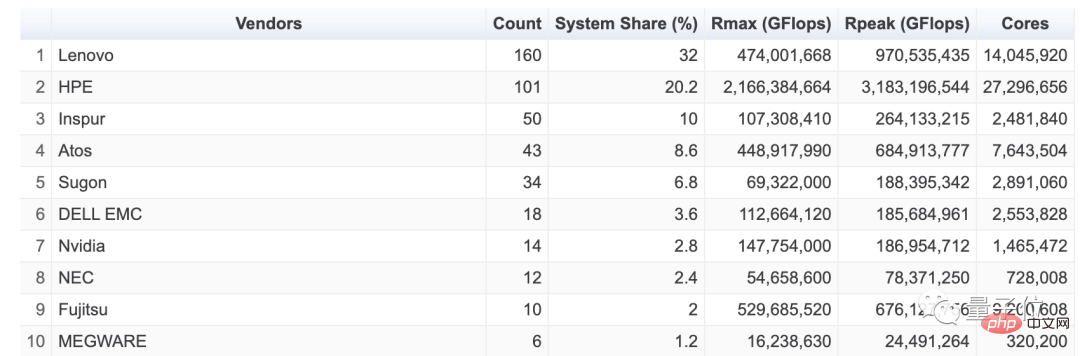

Das erste ist die Leistung des Serverprodukts; das zweite ist die Mengenskala. In diesem Bereich ist die globale High-Performance-Computing-Liste TOP500 die beste Referenz zur Beobachtung der Server-Rechenleistung. Wenn Sie die neueste Ausgabe der globalen High-Performance-Computing-Liste TOP500 (November 2022) öffnen, können Sie das oben Gesagte erkennen Stärke der Lenovo-Gruppe. Der Marktanteil beträgt 32 % und liegt mit einem Angebot von 160 Einheiten weltweit an erster Stelle und liegt sogar mit fast 12 Prozentpunkten vor der zweitplatzierten Hewlett-Packard-Gruppe.

Darüber hinaus zeichnet sich die Rechenleistungsversorgung der Lenovo Group auch durch Universalität und Vielfalt in der Kundenzusammensetzung aus.

Auf eine Frage von Nihon Keizai Shimbun antwortete Kirk Skaugen, Executive Vice President der Lenovo Group, im Versailles-Stil: 8 der zehn größten Public-Cloud-Anbieter der Welt sind Kunden der Lenovo Group.

Mit anderen Worten: Lenovo-Server werden von Kunden auf der ganzen Welt anerkannt, was für inländische Serverhersteller nicht einfach ist.

Außenstehende spekulieren, dass zu diesen Kunden auch die zweitplatzierte Microsoft Azure-Cloud im Cloud-Bereich zählt – die Beschleunigungs-Engine hinter ChatGPT und der „Finanzier-Vater“.

Als Microsoft viel in die Unterstützung von OpenAI investierte, gab es Kommentare, dass der kluge Microsoft-CEO Nadella nicht nur das Eigenkapital von OpenAI in die Unterstützung investieren würde Das strategische Layout des KI-Forschungsinstituts hat Kunden und Wachstum in die eigene Azure-Cloud gebracht. Es ist, als würde man zwei Fliegen mit einer Klappe schlagen.

Ich hätte einfach nicht erwartet, dass sich die verrückte OpenAI mit großen Modellen wirklich einen Namen gemacht hat. Mit einer zufälligen Innovation von ChatGPT hat sie die globale Technologie Internet wirklich in Schwung gebracht und alle Spieler in die Aufregung großer Modelle und generativer KI gestürzt.

Microsoft war nicht nur der Erste, der davon profitierte, es drängte auch seinen alten Rivalen Google in die Enge und rüttelte damit Googles Such-Cashcow auf. Nadella schätzt, dass seine Träume in letzter Zeit süß waren.

Die Vorteile der Lenovo Group, die eine enge Partnerschaft mit Microsoft unterhält und 2022 den Microsoft Device Partner Award gewonnen hat, spiegeln sich direkt in ihren Finanzergebnissen wider.

Darüber hinaus können wir aufgrund dieser Beziehung auch verstehen, warum Microsoft-CEO Nadella auf der Innovations- und Technologiekonferenz der Lenovo Group 2021 auftrat. Allerdings war die damalige Ankündigung zu „Branchensprache“ und muss mit dem heutigen ChatGPT-Bonus kombiniert werden Um es wirklich zu verstehen, lautete die damalige Ankündigung so: Künftig werden die beiden Parteien eine vertiefte Zusammenarbeit in den drei Bereichen PC, Cloud Computing und Edge Computing sowie Dienstleistungen durchführen.

Aber selbst wenn die Lenovo Group der Rechenleistungsanbieter für den ChatGPT-Boom wird, bedeutet das, dass diese Aussicht nachhaltig ist? Schließlich haben die Fälle von Microsoft und ChatGPT ihre eigenen Besonderheiten, und die Lenovo-Gruppe hinter den Kulissen hat das Glück, die Süße gekostet zu haben.

Aber gemessen an der Entwicklungsrichtung des von ChatGPT etablierten großen Modells wird sich dieser Trend fortsetzen und auch die Seite der Rechenleistungsversorgung wird Richtungsänderungen erfahren.

Laut einer aktuellen Schlussfolgerung von „Financial Eleven“, die auf den Meinungen vieler Infrastrukturexperten basiert, wird die KI-Rechenleistung einen erheblichen Einfluss auf das Finanzmodell des Cloud Computing haben, und dahinter steckt die Logik des exponentiellen Wachstums im Stile des Mooreschen Gesetzes:

Erstens werden der KI-Rechenleistungsverbrauch und die Wachstumsrate weitaus höher sein als der allgemeine Rechenleistungsverbrauch. Daten der Akademie für Informations- und Kommunikationstechnologie aus dem Jahr 2022 zeigen, dass Chinas allgemeine Rechenleistung im Jahr 2021 95 EFlops erreichen wird, mit einer Wachstumsrate von 24 % und einem Anteil von 47 %. Der Umfang der intelligenten Rechenleistung liegt bei 104EFlops, mit einer Wachstumsrate von 85 % und einem Anteil von über 50 %. Dies bedeutet, dass intelligente Rechenleistung zu einem neuen Wachstumspunkt für Cloud Computing wird.

Zweitens ist der Preis für intelligente Rechenleistung höher als der für allgemeine Rechenleistung. Der Preis für allgemeine Rechenleistung sinkt ständig, und aufgrund der relativen Knappheit von KI-Rechenleistung wird der Preis derzeit in die Höhe getrieben. Theoretisch ist die Bruttogewinnspanne der KI-Rechenleistung, die groß angelegte Operationen ermöglicht, mehr als 10 % höher als die der allgemeinen Rechenleistung.

Drittens kann der Einsatz von KI-Rechenleistung + großen Modellen in vertikalen Industrien die Entstehung neuer Anwendungsmodelle ermöglichen. Beispielsweise müssen Unternehmen in den Bereichen Finanzen, autonomes Fahren, medizinische Forschung und Entwicklung sowie intelligente Fertigungsszenarien normalerweise die Open-Source-Plattform für große KI-Modelle des Unternehmens erwerben und kleine Modelle optimieren, die für ihr eigenes Unternehmen geeignet sind. Diese Art von PaaS-basiertem KI-Dienst kann mehr als 60 % des Bruttogewinns erwirtschaften. Dies ist derzeit der beste Weg, den Einsatz von KI-Rechenleistung/KI-Modellen zu vertiefen.

Diese Richtungsänderung der KI-Rechenleistung kann spezifischere Auswirkungen auf den chinesischen Markt haben:

Derzeit ist unbestreitbar, dass zwischen der KI-Rechenleistung und den großen Modellen chinesischer Cloud-Anbieter und Microsoft eine große Lücke besteht. . Der Grund dafür ist, dass es Lücken in der Rechenleistungsskala, der Datenskala und der Modellgenauigkeit gibt. Nehmen wir als Beispiel die Größe der Rechenleistung: Der intelligente Computercluster, der ChatGPT unterstützt, erfordert mindestens Zehntausende NVIDIA GPU A100-Grafikkarten. Eine vollständige Modellschulung kostet mehr als 12 Millionen US-Dollar.

Der intelligente Computercluster hinter ChatGPT kostet allein für den Kauf von GPU-Grafikkarten mehr als 1 Milliarde Yuan. Derzeit gibt es nicht mehr als drei inländische Unternehmen, die eine ähnliche Infrastruktur unterstützen können. Die Rechenzentren chinesischer Cloud-Anbieter sind meist nur mit Tausenden von GPU-Grafikkarten ausgestattet. Der Grund dafür ist, dass die Kosten für den Kauf einer Nvidia-GPU der Spitzenklasse bis zu 80.000 Yuan betragen. Ein Server benötigt normalerweise 4 bis 8 GPUs, und die Kosten für einen GPU-Server übersteigen normalerweise 400.000 Yuan. Der durchschnittliche inländische Serverpreis beträgt 40.000 bis 50.000 Yuan. Das bedeutet, dass die Kosten eines GPU-Servers mehr als das Zehnfache der Kosten eines gewöhnlichen Servers betragen.

Daher lässt sich aus dieser Welle großer modellgetriebener technologischer Veränderungen grundsätzlich die Herausforderungen und Chancen für chinesische Anbieter von Computer- und Stromversorgungssystemen ableiten.

Zunächst muss es über eine vollständige, ausgereifte und stabile intelligente Computing-Cluster-Infrastruktur verfügen.

Zweitens müssen verwandte Produkte neben umfassender Leistung auch Energieeffizienzvorteile aufweisen – Umweltschutz und Kosteneinsparung.

Nachdem wir diese beiden Schlussfolgerungen geklärt haben, können wir wahrscheinlich verstehen, warum die Lenovo Group als versteckter Gewinner hinter dem ChatGPT-Bonus weiterhin nachhaltige Aussichten auf Rechenleistung haben wird.

Wenn die Rechenleistung das neue Mooresche Gesetz einleitete, kann das Problem des Energieverbrauchs nicht ignoriert werden. Der Hauptverantwortliche der Hochtechnologieabteilung der Nationalen Entwicklungs- und Reformkommission sagte im Jahr 2021, dass dies der Fall sei Der Stromverbrauch der Rechenzentren meines Landes beträgt etwa 2 % des gesamten Stromverbrauchs der Gesellschaft.

Um es intuitiver auszudrücken: „Der jährliche Stromverbrauch übersteigt das 2,5-fache des vom Drei-Schluchten-Damm erzeugten Stroms. Das Mooresche Gesetz ist ein exponentielles Wachstum, und der vom Drei-Schluchten-Damm erzeugte Strom kann nicht.“ exponentiell wachsen.

Die Lenovo Group hat die führende „Poseidon“-Warmwasser-Wasserkühlungstechnologie entwickelt, die 50 °C warmes Wasser zur Wärmeabfuhr verwendet durch Strömungszirkulation, wodurch Kältemaschinen und Wärmetauscher überflüssig werden, Abwärme auch zum Heizen von Gebäuden nutzen kann, jährliche Stromrechnungseinsparungen und Emissionsreduzierungen von mehr als 42 %

Im neuesten globalen HPC Green500 auf der Liste hat das von der Lenovo Group gelieferte Henri-System eine zertifizierte Leistung von 6,5091 Milliarden Gleitkommaoperationen pro Watt Stromverbrauch. Es erfüllt nicht nur nationale und internationale Anforderungen, sondern ist sogar das energiereichste System der Welt -sparendes Hochleistungsrechnersystem.

Tatsächlich ist Lenovo nicht mehr das reine Computerunternehmen in Ihrem Stereotyp . Insgesamt hat die Lenovo-Gruppe als Ganzes mit dem explosionsartigen Wachstum des Computing-Infrastrukturgeschäfts ihre Transformation schrittweise abgeschlossen: Der Anteil des Gesamtumsatzes mit anderen Geschäftsbereichen als Personalcomputern hat 40 % überschritten.

ChatGPT, große Modelle oder sogar KI, die Rechenleistungsdividende, die als erste im technologischen Innovationszyklus ansteigt, erfrischt die Lenovo Group, oder genauer gesagt, liefert Rechenleistung Der versteckte Champion hinter den Kulissen wird nach vorne geschoben.

Das obige ist der detaillierte Inhalt vonWie ist das von OpenAI vorgeschlagene neue Mooresche Gesetz zu verstehen? Chinas verborgener Rechenleistungsriese hat etwas zu sagen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr