Heim >Technologie-Peripheriegeräte >KI >Vom Gehirn inspirierte KI-Modelle: Aktivierungslernen, herausfordernde Backpropagation

Vom Gehirn inspirierte KI-Modelle: Aktivierungslernen, herausfordernde Backpropagation

- 王林nach vorne

- 2023-04-12 11:10:161283Durchsuche

Die Back-Propagation-Technologie ist der Kern des Deep Learning und treibt den Erfolg der KI in vielen Bereichen wie Sehen, Sprache, Verarbeitung natürlicher Sprache, Spielen und biologischen Vorhersagen voran. Der Funktionsmechanismus der Rückausbreitung besteht darin, den Gradienten des Vorhersagefehlers zum Verbindungsgewicht des neuronalen Netzwerks in umgekehrter Weise zu berechnen und den Vorhersagefehler durch Feinabstimmung des Gewichts jeder Schicht zu reduzieren. Obwohl Backpropagation sehr effizient ist und der Schlüssel zum aktuellen Erfolg der künstlichen Intelligenz ist, glaubt eine beträchtliche Anzahl von Forschern nicht, dass die Lernmethode der Backpropagation mit der Funktionsweise des Gehirns vereinbar ist.

Mit der Entwicklung der Deep-Learning-Technologie hat jeder nach und nach einige Nachteile der Backpropagation erkannt, z. B. eine übermäßige Abhängigkeit von Etikettendaten und Rechenleistung, eine Reihe kontroverser Sicherheitsprobleme und kann nur für bestimmte Aufgaben verwendet werden usw , und es löste auch einige Bedenken hinsichtlich der Entwicklung großer Modelle aus.

Hinton, einer der Autoren der Backpropagation und Pionier des Deep Learning, hat beispielsweise mehrfach erklärt: „Wenn Sie wesentliche Fortschritte erzielen wollen, müssen Sie die Backpropagation aufgeben und bei Null anfangen [2]“, „ Mein aktueller Glaube ist, dass Backpropagation, also die Art und Weise, wie aktuelles Deep Learning funktioniert, völlig anders ist als das, was das Gehirn tut. Das Gehirn erhält Gradienten auf unterschiedliche Weise [3]“, „Ich glaube, dass das Gehirn viele lokale kleine Zielfunktionen nutzt.“ . Es handelt sich nicht um eine durchgängige Systemkette, die die Zielfunktion durch Training optimiert [3]“.

LeCun, der auch Turing-Award-Gewinner ist, sagte: „Das aktuelle Deep-Learning-Modell mag ein integraler Bestandteil zukünftiger intelligenter Systeme sein, aber ich denke, ihm fehlen die notwendigen Teile. Ich denke, sie sind notwendig, aber nicht genug.“ [ 4]". Sein alter Rivale, der New York University-Professor Gary Marcus, sagte, dasselbe sei bereits zuvor gesagt worden: „Wenn wir allgemeine künstliche Intelligenz erreichen wollen, muss Deep Learning durch andere Technologien ergänzt werden [4]“.

1 Die Inspiration des Gehirns

Wie fängt man bei Null an? Die Entwicklung der Technologie der künstlichen Intelligenz ist zweifellos untrennbar mit dem Verständnis der Inspiration des Gehirns verbunden. Obwohl wir noch weit davon entfernt sind, den Funktionsmechanismus des Gehirns vollständig zu verstehen – sein Kern besteht darin, wie man die Verbindungsgewichte zwischen Neuronen auf der Grundlage externer Informationen anpasst –, können wir dennoch ein vorläufiges Verständnis des Gehirns erlangen, das uns zum Entwurf neuer Modelle inspirieren kann .

Zuallererst ist der Lernprozess des Gehirns untrennbar mit der Hebb-Regel verbunden, das heißt, das Verbindungsgewicht zwischen gleichzeitig aktivierten Neuronen wird gestärkt. Dies kann als die wichtigste Grundregel der Neurowissenschaften bezeichnet werden Regel, die durch eine Vielzahl biologischer Experimente bestätigt wurde.

Zweitens basiert das Lernen im Gehirn hauptsächlich auf unüberwachtem Lernen, das aus einer kleinen Anzahl von Proben reichhaltige lokale Darstellungen und Assoziationen zwischen Darstellungen erhalten kann. Feedbacksignale spielen ebenfalls eine wichtige Rolle im Lernprozess. Darüber hinaus ist das Gehirn ein lernendes System, das allgemeine Aufgaben unterstützt. Die vom Gehirn gelernten Funktionen sollten relativ zu bestimmten Aufgaben sein. Ein vernünftiges Ziel besteht darin, dass das Gehirn die statistische Verteilung verschiedener Eingabesignale und die Unterschiede zwischen verschiedenen lernen kann Inhalte. Verbindungen zwischen.

Kürzlich hat Zhou Hongchao, ein Forscher an der Shandong-Universität, einen Artikel über arXiv mit dem Titel „Aktivierungslernen durch lokale Wettbewerbe“ eingereicht, in dem er ein vom Gehirn inspiriertes KI-Modell namens „Aktivierungslernen“ (Aktivierungslernen) vorschlägt. Sein Kern besteht darin, ein mehrschichtiges neuronales Netzwerk aufzubauen, sodass die Aktivierungsintensität der Netzwerkausgabe die relative Wahrscheinlichkeit der Eingabe widerspiegeln kann.

Dieses Modell verzichtet vollständig auf die Backpropagation-Methode, beginnt jedoch mit der Verbesserung der grundlegenden Hebbian-Regeln (eine Methode, die näher am Gehirn liegt), um einen neuen Satz neuronaler Netzwerktrainings- und Inferenzmethoden zu etablieren bessere Leistung als Backpropagation in kleinen Lernexperimenten und kann auch als Generierungsmodell für Bilder verwendet werden. Die Arbeit legt nahe, dass das Potenzial biologisch inspirierter Lernmethoden möglicherweise weit unterschätzt wird.

2

Lernregeln für den lokalen WettbewerbHebräisches Lernen war schon immer vor dem Aufkommen von Backpropagation Eine Kernrichtung der Lernforschung neuronaler Netze hat eine Reihe von Arbeiten zu Lernsystemen inspiriert, wurde jedoch letztendlich nicht zu einer weit verbreiteten Methode.

Ein möglicher Grund ist, dass die Menschen einige Mechanismen in der Hebb-Regel nicht vollständig verstehen, insbesondere den Konkurrenzmechanismus zwischen Neuronen, und dass Konkurrenz eine Rolle im Prozess des Lernens neuronaler Netzwerkmerkmale und der Gewichtsanpassung spielt sehr wichtige Rolle.

Ein intuitives Verständnis ist, dass, wenn jedes Neuron sein Bestes versucht, um die Aktivierung zu konkurrieren, gleichzeitig eine Art Hemmung besteht, die durch es repräsentierten Merkmale unterschiedlich zu machen Neuronen so unterschiedlich wie möglich, dann tendiert das Neuronennetzwerk dazu, die nützlichsten Informationen an die nächste Schicht zu übertragen (ist es ähnlich wie in der Sozioökonomie? Wenn jedes Individuum in einer großen sozialen Gruppe den Nutzen maximiert und die Gruppe zu einem bestimmten Zeitpunkt groß genug ist Unter den Einschränkungen der Regeln wird tendenziell das Gesamteinkommen der gesamten Gruppe maximiert. Zu diesem Zeitpunkt zeigt jeder Einzelne unterschiedliche Verhaltensweisen.

Tatsächlich gibt es im Gehirn eine große Anzahl hemmender Neuronen, und Konkurrenz und Hemmung zwischen Neuronen spielen eine wichtige Rolle im Lernprozess des Gehirns. Rumelhart, der Erstautor der Backpropagation (die höchste Auszeichnung auf dem Gebiet der Kognitionswissenschaft ist der Rumelhart Award), ist der Befürworter dieser Idee. Gleichzeitig mit seinem Vorschlag für die Backpropagation (1985) schlug er auch eine Methode namens kompetitives Lernen vor. Der Kern des Modells [5] besteht darin, die Neuronen in jeder Schicht in mehrere Cluster aufzuteilen (genannt Winner-Take-All) und durch die Hebbian-Regel zu trainieren. Im Vergleich dazu hat Backpropagation jedoch in praktischen Anwendungen eine bessere Effizienz des Netzwerktrainings gezeigt und seitdem die Aufmerksamkeit der meisten KI-Forscher auf sich gezogen, was die Entstehung und den Erfolg von Deep Learning fördert.

Aber es gibt immer noch einige Forscher, die an das Potenzial biologisch inspirierter Lernmethoden glauben. Im Jahr 2019 haben Krotov und Hopfield (ja, die Antragsteller des Hopfield-Netzwerks) demonstriert Eine gewinnende Die Winner-Take-All-Regel kann in Kombination mit Hebbian-Lernen eine Leistung erzielen, die mit der Backpropagation vergleichbar ist [6]. Aber auch die Winner-Take-All-Regel, die nur die Aktivierung eines Neurons zulässt, schränkt die Lern- und Ausdrucksmöglichkeiten neuronaler Netze in gewissem Maße ein.

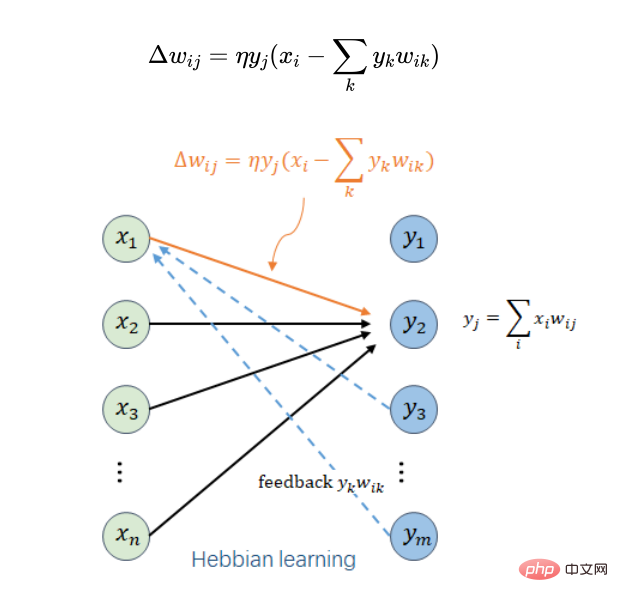

Der Forscher in dieser Arbeit führte den Wettbewerbsmechanismus direkt in die hebräische Lernregel ein und erhielt eine prägnante lokale Lernregel:

# 🎜🎜 #

Hier wird angenommen, dass Neuron i die Eingabe von Neuron j in der darüber liegenden Schicht ist,  das Verbindungsgewicht zwischen Neuron i und Neuron j ist,

das Verbindungsgewicht zwischen Neuron i und Neuron j ist,  der Anpassungsbetrag dieses Gewichts unter einem bestimmten Trainingsmuster ist ,

der Anpassungsbetrag dieses Gewichts unter einem bestimmten Trainingsmuster ist ,  ist die Ausgabe von Neuron i und eine Eingabe für Neuron j,

ist die Ausgabe von Neuron i und eine Eingabe für Neuron j,  ist die gewichtete Gesamteingabe von Neuron j (oder die Ausgabe von Neuron j),

ist die gewichtete Gesamteingabe von Neuron j (oder die Ausgabe von Neuron j),  ist eine kleinere Lernrate,

ist eine kleinere Lernrate,  Alle Neuronen in derselben Schicht wie Neuron j werden durchlaufen. Wenn man nur

Alle Neuronen in derselben Schicht wie Neuron j werden durchlaufen. Wenn man nur  berücksichtigt, ist es die ursprünglichste hebräische Regel. Ein Schlüssel hierzu ist die Einführung eines Ausgabe-Feedback-Elements aus derselben Ebene

berücksichtigt, ist es die ursprünglichste hebräische Regel. Ein Schlüssel hierzu ist die Einführung eines Ausgabe-Feedback-Elements aus derselben Ebene . Es spielt zwei Rollen: Die erste besteht darin, sicherzustellen, dass alle Gewichte nicht unendlich zunehmen und der Lernprozess konvergent ist. Die zweite besteht darin, Konkurrenz zwischen Neuron j und anderen Neuronen in dieser Schicht einzuführen, um die Merkmalsvielfalt zu verbessern.

. Es spielt zwei Rollen: Die erste besteht darin, sicherzustellen, dass alle Gewichte nicht unendlich zunehmen und der Lernprozess konvergent ist. Die zweite besteht darin, Konkurrenz zwischen Neuron j und anderen Neuronen in dieser Schicht einzuführen, um die Merkmalsvielfalt zu verbessern.

Durch die Durchführung einer mathematischen Analyse der oben genannten lokalen Lernregeln (vorausgesetzt, die Lernrate ist klein genug und die Anzahl der Lernschritte groß genug) können einige interessante Schlussfolgerungen gezogen werden.

(1) Angesichts der  jeder Schicht kann die Eingabe

jeder Schicht kann die Eingabe  durch

durch  rekonstruiert werden, um den Rekonstruktionsfehler so klein wie möglich zu machen. Diese Fähigkeit zur schichtweisen Rekonstruktion kann die Sicherheit des Modells vor gegnerischen Angriffen verbessern und verhindern, dass einige Objektbilder durch gegnerisches Rauschen als andere Objekte erkannt werden.

rekonstruiert werden, um den Rekonstruktionsfehler so klein wie möglich zu machen. Diese Fähigkeit zur schichtweisen Rekonstruktion kann die Sicherheit des Modells vor gegnerischen Angriffen verbessern und verhindern, dass einige Objektbilder durch gegnerisches Rauschen als andere Objekte erkannt werden.

(2) Jede auf lokalen Lernregeln basierende Merkmalsextraktion weist eine gewisse Ähnlichkeit mit der Hauptkomponentenanalyse (PCA) auf. Ihr Rekonstruktionsverlust ist derselbe, der Unterschied zu PCA besteht jedoch darin, dass er durch lokale Lernregeln ermittelt wird . Die einzelnen Komponenten müssen nicht orthogonal sein. Dies ist eine sehr vernünftige Sache, da die Hauptkomponentenanalyse darin besteht, die Hauptinformationen jeder Schicht zu extrahieren. Wenn jedoch die den Hauptkomponenten entsprechenden Neuronen ausfallen, wirkt sich dies auf die Leistung des gesamten Netzwerks aus, und lokale Lernregeln lösen dieses Problem robust . Sexuelle Probleme.

(3) Die Summe der Quadrate der Verbindungsgewichte jeder Schicht übersteigt tendenziell nicht die Anzahl der Neuronen in dieser Schicht, wodurch die Konvergenz des Netzwerklernprozesses sichergestellt wird.

(4) Die Ausgabeintensität jeder Schicht (die Summe der Quadrate der Ausgabe) ist tendenziell nicht höher als die Eingabeintensität der Schicht (die Summe der Quadrate der Eingabe) und für annähernd typische Eingaben Die Ausgabeintensität ist im Allgemeinen höher, sodass die Eingabewahrscheinlichkeit durch die Ausgabeintensität angenähert werden kann. Diese Schlussfolgerung ist ein sehr kritischer Punkt für das vorgeschlagene Aktivierungslernmodell.

3 Aktivierungslernen

Basierend auf den oben genannten lokalen Lernregeln kann ein mehrschichtiges neuronales Netzwerk Schicht für Schicht von unten nach unten trainiert werden oben. Implementieren Sie die automatische unbeaufsichtigte Feature-Extraktion. Das trainierte Netzwerk kann als Pre-Training-Modell für verschiedene überwachte Lernaufgaben wie Erkennung, Übersetzung usw. verwendet werden, um die Genauigkeit von Lernaufgaben zu verbessern. Verschiedene überwachte Lernaufgaben basieren hier immer noch auf dem Back-Propagation-Modelltraining, und das unbeaufsichtigte Vortrainingsmodell wird verfeinert.

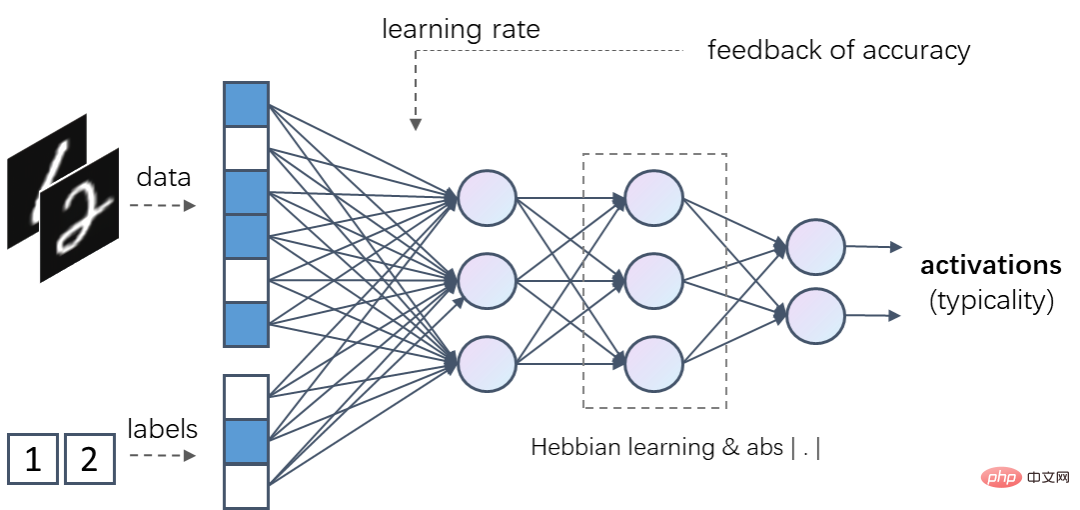

Aber was noch interessanter ist, ist, dass basierend auf den oben genannten lokalen Lernregeln ein neues KI-Modell erstellt werden kann, das überhaupt keine Backpropagation verwendet, genannt Aktivierungslernen (Aktivierung). Lernen) besteht sein Kern darin, die Ausgabestärke des gesamten Netzwerks (Summe der Quadrate der Ausgabe) zu ermöglichen, die relative Wahrscheinlichkeit der Eingabestichprobe durch lokales unbeaufsichtigtes Training abzuschätzen, d. h. je häufiger die Eingabestichprobe gesehen wird stärker ist normalerweise die Ausgangsstärke.

Beim Aktivierungslernen werden Eingabeproben nach der Normalisierung in ein mehrschichtiges neuronales Netzwerk eingespeist. Jede Schicht enthält lineare Transformationen, die durch lokale Lernregeln trainiert werden können. Die nichtlineare Aktivierungsfunktion jeder Schicht muss sicherstellen, dass die Eingabestärke (Summe der Quadrate) und die Ausgabestärke unverändert bleiben. Als Aktivierung kann beispielsweise die Absolutwertfunktion  verwendet werden Funktion zum Erstellen der Ausgabe des Netzwerks Die Intensität wird beim Durchlaufen der Aktivierungsfunktion nicht abgeschwächt oder erhöht. Letztendlich kann die Ausgabeintensität des gesamten Netzwerks die relative Wahrscheinlichkeit der Eingabeprobe widerspiegeln.

verwendet werden Funktion zum Erstellen der Ausgabe des Netzwerks Die Intensität wird beim Durchlaufen der Aktivierungsfunktion nicht abgeschwächt oder erhöht. Letztendlich kann die Ausgabeintensität des gesamten Netzwerks die relative Wahrscheinlichkeit der Eingabeprobe widerspiegeln.

Wenn der lokalen Lernregel eine nichtlineare Aktivierungsfunktion hinzugefügt wird, bedeutet  die Ausgabe von Neuron j Dann erfordert die Aktivierungsfunktion keine konstante Eingangs- und Ausgangsintensität, und andere nichtlineare Funktionen wie RELU können als Aktivierungsfunktion verwendet werden. Der Inferenzprozess des Aktivierungslernens besteht darin, den fehlenden Teil basierend auf dem bekannten Teil der Eingabe abzuleiten, sodass die endgültige Ausgabestärke des Netzwerks maximal ist.

die Ausgabe von Neuron j Dann erfordert die Aktivierungsfunktion keine konstante Eingangs- und Ausgangsintensität, und andere nichtlineare Funktionen wie RELU können als Aktivierungsfunktion verwendet werden. Der Inferenzprozess des Aktivierungslernens besteht darin, den fehlenden Teil basierend auf dem bekannten Teil der Eingabe abzuleiten, sodass die endgültige Ausgabestärke des Netzwerks maximal ist.

Aktivierungslernnetzwerke können beispielsweise Daten und Labels (z. B. One-Hot-Codierung) gleichzeitig als Eingabe verwenden. Wenn für ein so trainiertes Netzwerk Daten und eine korrekte Beschriftung eingegeben werden, ist die Ausgabeaktivierungsintensität normalerweise höher als die Ausgabeaktivierungsintensität dieser Daten und einer falschen Beschriftung.

Ein solches Aktivierungslernmodell kann sowohl als diskriminatives Modell als auch als generatives Modell verwendet werden. Bei der Verwendung als diskriminierendes Modell werden fehlende Kategorien aus den gegebenen Daten abgeleitet; bei der Verwendung als generatives Modell werden die Schlüsse aus den gegebenen Kategorien in Kombination mit einem gewissen Maß an Zufälligkeit gezogen. Darüber hinaus haben Experimente herausgefunden, dass der Lerneffekt des Diskriminanzmodells verbessert werden kann, wenn Informationen zur Erkennungsrückmeldung eingeführt werden, beispielsweise indem falsch erkannten Proben eine höhere globale Lernrate zugewiesen wird. Nr Bilder) Die obigen Experimente zeigen, dass die Genauigkeit der Backpropagation höher ist als die Genauigkeit des Aktivierungslernens, wenn genügend Trainingsbeispiele vorhanden sind. Beispielsweise kann bei 60.000 Trainingsbeispielen, basierend auf einem neuronalen Netzwerk ähnlicher Komplexität, durch Backpropagation eine Fehlerrate von etwa 1,62 % erreicht werden, während Aktivierungslernen nur eine Fehlerrate von etwa 3,37 % erreichen kann (bei Rückmeldung aus der Erkennung). Ergebnisse werden eingeführt Um das Lernen zu aktivieren, kann die Fehlerquote auf 2,28 % gesenkt werden.

Aber wenn die Anzahl der Trainingsbeispiele abnimmt, kann das Aktivierungslernen eine bessere Leistung zeigen. Beispielsweise ist die Fehlerrate des Aktivierungslernens bei 6.000 Trainingsbeispielen bereits niedriger als die Fehlerrate der Backpropagation; bei 600 Trainingsbeispielen beträgt die Erkennungsfehlerrate der Backpropagation sogar 25,5 %. aber die Fehlerrate des Aktivierungslernens Die Fehlerrate beträgt nur 9,74 %, was ebenfalls deutlich niedriger ist als bei der Methode, bei der ein unbeaufsichtigtes vorab trainiertes Modell kombiniert wird (die Fehlerrate beträgt etwa 20,3 %).

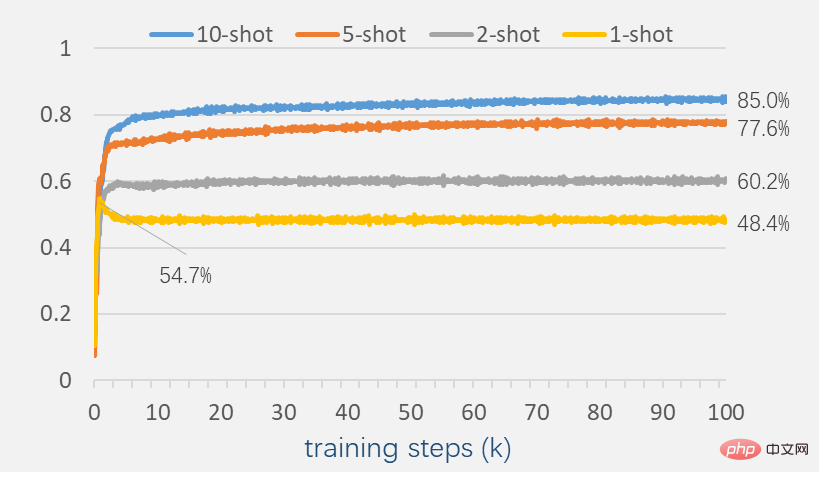

Um die Leistung des Aktivierungslernens mit wenigen Stichproben zu untersuchen, reduzieren Sie die Anzahl der Stichproben weiterhin auf wenige Stichproben. Zu diesem Zeitpunkt weist das Aktivierungslernen noch eine gewisse Erkennungsfähigkeit auf.

Bei 2 Proben in jeder Kategorie erreicht die Erkennungsgenauigkeit 60,2 %, bei 10 Proben in jeder Kategorie kann die Erkennungsgenauigkeit 85,0 % erreichen. Ein bemerkenswertes Phänomen besteht darin, dass die Testgenauigkeit während des gesamten Trainingsprozesses nicht abnimmt, wenn für jede Kategorie mindestens zwei Stichproben vorhanden sind. Dies unterscheidet sich von vielen Modellen, die auf Backpropagation basieren. Einerseits spiegelt es wider, dass Aktivierungslernen möglicherweise eine bessere Generalisierungsfähigkeit aufweist.

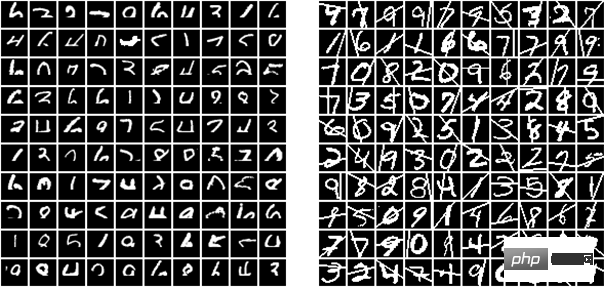

Versuchen Sie bei einem trainierten Aktivierungs-Lernnetzwerk, dem zu erkennenden Bild bestimmte Störungen hinzuzufügen. Decken Sie, wie im Bild unten gezeigt, einen bestimmten Teil der Bildpixel ab oder fügen Sie einige zufällige Linien hinzu. Das Modell ist während des Trainingsprozesses nicht auf diese gestörten Bilder gestoßen, aber das Aktivierungslernen zeigt immer noch eine gewisse Erkennungsfähigkeit. Wenn beispielsweise 1/3 des Bildes abgedeckt ist (unterer Teil), kann durch Aktivierungslernen eine Erkennungsfehlerrate von etwa 7,5 % erreicht werden.

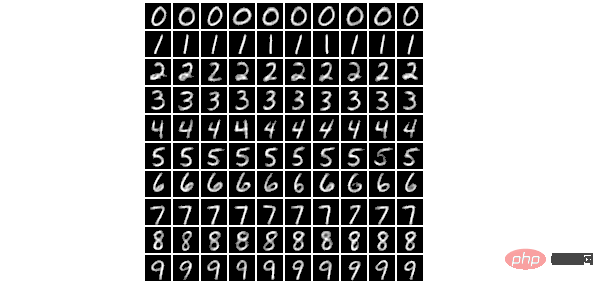

Das gleiche trainierte Aktivierungs-Lernnetzwerk kann auch für die Bildgenerierung verwendet werden. Bei gegebener Kategorie kann durch Gradientenabstieg oder Iteration ein lokal optimal generiertes Bild erhalten werden, um die Ausgabeaktivierungsstärke des gesamten Netzwerks zu maximieren. Im Prozess der Bilderzeugung kann die Ausgabe einiger Neuronen auf der Grundlage von Zufallsrauschen gesteuert werden, wodurch die Zufälligkeit der erzeugten Bilder verbessert wird. Das Bild unten ist ein zufällig generiertes Bild, das auf dem Aktivierungslernnetzwerk basiert.

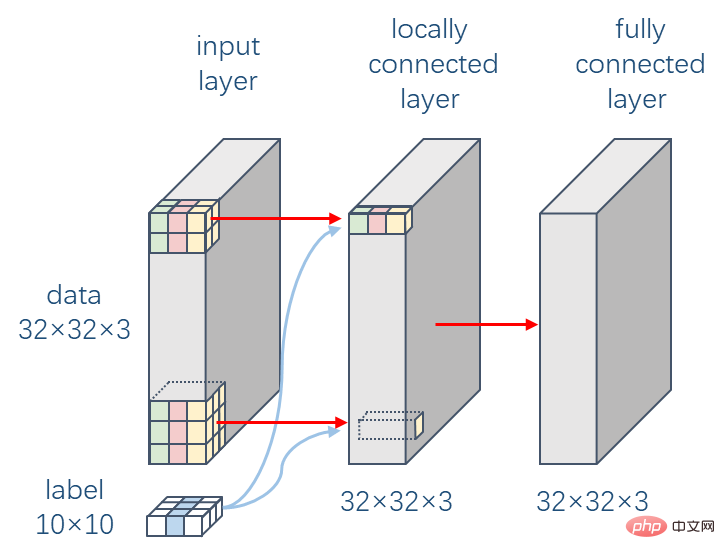

In der visuellen Wahrnehmungsschicht des Gehirns verfügen Neuronen über begrenzte Empfangsfelder, das heißt, Neuronen können nur innerhalb eines bestimmten räumlichen Bereichs Eingaben von anderen Neuronen empfangen. Dies inspirierte den Vorschlag eines Faltungs-Neuronalen Netzwerks (CNN), das bei einer Vielzahl visueller Aufgaben weit verbreitet ist. Der Funktionsmechanismus der Faltungsschicht unterscheidet sich immer noch stark vom menschlichen visuellen System. Ein wesentlicher Unterschied besteht darin, dass die Faltungsschicht Parameter gemeinsam nutzt, dh die Gewichtsparameter sind an jeder zweidimensionalen Position gleich, aber das ist schwer vorstellbar dass das menschliche visuelle System Es wird eine solche gemeinsame Nutzung von Parametern im visuellen System geben. Das folgende Experiment untersucht den Einfluss lokaler Verbindungen auf das Aktivierungslernen basierend auf dem CIFAR-10-Datensatz (bunte 10 Kategorien von Objektbildern).

Das hier experimentierte neuronale Netzwerk besteht aus zwei Schichten. Die erste Schicht ist eine lokale Verbindungsschicht. Sie hat die gleiche Verbindungsstruktur wie die Faltungskerngröße 9, aber jede Position hat ihren eigenen Gewichtsparameter ; Die zweite Ebene ist eine vollständig verbundene Ebene, und die Anzahl der Knoten in jeder Ebene beträgt ,  und stimmt mit der Dimension des Eingabebildes überein.

und stimmt mit der Dimension des Eingabebildes überein.

Experimente zeigen, dass lokale Verbindungen den Lernprozess stabiler machen und die Lernleistung bis zu einem gewissen Grad verbessern können. Basierend auf diesem zweischichtigen neuronalen Netzwerk und kombiniert mit dem Feedback aus den Erkennungsergebnissen kann durch Aktivierungslernen eine Fehlerrate von 41,59 % auf CIFAR-10 erreicht werden.

Der bisherige Maßstab für biologisch inspirierte Modelle wurde von Krotov und Hopfield festgelegt, die eine Fehlerquote von 49,25 % meldeten. Sie verwendeten ein zweischichtiges neuronales Netzwerk, wobei die erste Schicht 2.000 Knoten enthielt und unbeaufsichtigt durch biologisch inspirierte Methoden trainiert wurde, während die zweite Ausgabeschicht durch Backpropagation überwacht wurde. Zum Vergleich: Das gleiche Netzwerk kann eine Fehlerrate von 44,74 % erreichen, wenn es vollständig durch Backpropagation trainiert wird, während das Aktivierungslernen überhaupt keine Backpropagation verwendet und bessere Ergebnisse erzielt. Wenn Datenerweiterung einschließlich zufälligem Zuschneiden verwendet wird und die Anzahl der Knoten in der ersten Ebene auf  erhöht wird, kann die Erkennungsfehlerrate des Aktivierungslernens auf 37,52 % reduziert werden.

erhöht wird, kann die Erkennungsfehlerrate des Aktivierungslernens auf 37,52 % reduziert werden.

5 Auf dem Weg zu allgemeinen Aufgaben

Warum die überwiegende Mehrheit der Deep-Learning-Modelle nur auf bestimmte Aufgaben angewendet werden kann Aufgaben Aufgabe? Ein Grund dafür ist, dass wir die Stichproben künstlich in Daten und Beschriftungen unterteilen und die Daten als Eingabe des Modells und die Beschriftungen als Ausgabeüberwachungsinformationen verwenden. Dadurch neigt das Modell eher dazu, nur die Merkmale beizubehalten, die für die Vorhersage nützlicher sind Etiketten, während einige Funktionen ignoriert werden, die für andere Aufgaben nützlich sind. Aktivierungslernen verwendet alle sichtbaren Informationen als Eingabe und kann die Wahrscheinlichkeit und statistische Verteilung von Trainingsstichproben sowie die Korrelation zwischen den einzelnen Teilen lernen. Diese Informationen können für alle zugehörigen Lernaufgaben verwendet werden, sodass Aktivierungslernen als Modell für allgemeine Aufgaben betrachtet werden kann. .

Wenn wir ein Objekt sehen und andere uns sagen, was es ist, ist es für uns tatsächlich schwierig zu definieren, dass das Gehirn das Tonsignal definitiv als Signal verwenden wird Ausgabeetikett. Wenn wir visuelle Signale als Eingabe verwenden, sollte dieses Lernen zumindest zweiseitig sein, das heißt, wenn wir dieses Objekt sehen, werden wir darüber nachdenken, was es ist, und wenn uns gegeben wird, was es ist, werden wir auch darüber nachdenken, was es ist Objekt aussieht.

Aktivierungslernen kann auch für multimodales Lernen eingesetzt werden. Wenn beispielsweise ein bestimmtes Trainingsbeispiel Bild- und Textmodalitäten enthält, kann es eine Verbindung zwischen Bildern und Text herstellen. Wenn ein bestimmtes Trainingsbeispiel Text- und Tonmodalitäten enthält, kann es eine Verbindung zwischen Text und Ton herstellen. Aktivierungslernen hat das Potenzial, zu einem assoziativen Gedächtnismodell zu werden, das Assoziationen zwischen verschiedenen Arten verwandter Inhalte herstellt und verwandte Inhalte durch Weitergabe abfragt oder aktiviert. Es wird allgemein angenommen, dass diese assoziative Gedächtnisfähigkeit eine sehr wichtige Rolle für die menschliche Intelligenz spielt. Allerdings müssen hier noch das Problem des lokalen Eingabedatentrainings und das Problem des katastrophalen Vergessens gelöst werden.

Die Forschung zum Aktivierungslernen ist nicht nur ein neues KI-Modell, sondern hat auch noch andere Werte. Beispielsweise kann es das On-Chip-Training (On-Chip-Training) von neuronalen Netzwerksystemen basierend auf physikalischen Implementierungen wie optischen neuronalen Netzwerken und neuronalen Memristornetzwerken einfacher unterstützen, wodurch eine Verschlechterung der Rechengenauigkeit des gesamten Systems vermieden wird Genauigkeit grundlegender physikalischer Komponenten oder Programmierrauschen. Es kann auch mit biologischen Experimenten kombiniert werden, um uns zu einem besseren Verständnis des Arbeitsmechanismus des Gehirns zu inspirieren, beispielsweise um herauszufinden, ob es eine bestimmte biologische Erklärung für lokale Trainingsregeln gibt. Der Forscher Zhou Hongchao sagte: „Ich glaube, dass die meisten komplexen Systeme von einfachen mathematischen Regeln dominiert werden und dass das Gehirn ein so wunderbares System ist; letztendlich ist es unser Ziel, intelligentere Maschinen zu entwickeln.“

Das obige ist der detaillierte Inhalt vonVom Gehirn inspirierte KI-Modelle: Aktivierungslernen, herausfordernde Backpropagation. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr