Heim >Technologie-Peripheriegeräte >KI >ChiQA – ein Bildfrage- und Antwortdatensatz basierend auf 200.000 echten Benutzerfragen

ChiQA – ein Bildfrage- und Antwortdatensatz basierend auf 200.000 echten Benutzerfragen

- PHPznach vorne

- 2023-04-12 10:43:021188Durchsuche

In den letzten Jahren ist die visuelle Fragebeantwortungsaufgabe (Visual Question Answering) mit der starken Entwicklung der Fragebeantwortungstechnologie und der multimodalen Verständnistechnologie immer beliebter geworden. Umfangreiche Datensätze zur visuellen Beantwortung von Fragen wie VQA, CLEVER und Visual-7W wurden nacheinander veröffentlicht, was die iterative Entwicklung visueller Aufgaben zur Beantwortung von Fragen erheblich gefördert hat. Allerdings handelt es sich bei den meisten aktuellen visuellen Fragebeantwortungsdaten um künstlich synthetisierte Fragen, wie zum Beispiel „Welche Farbe hat ihre Augen?“, die vom Annotator nach dem Betrachten des Bildes fiktiv gestaltet werden. Manuell generierte Daten sind relativ einfach, von geringer Qualität und sogar voreingenommen. Daher schlagen wir in dieser Arbeit einen groß angelegten chinesischen Bildfrage- und Antwortdatensatz vor: ChiQA, der auf echten Fragen von Benutzern im QQ-Browser basiert.

ChiQA enthält über 40.000 echte Benutzeranfragen und über 200.000 Frage-Bild-Paare. Die Daten und einige Basismodelle wurden auf GitHub veröffentlicht. Relevante Forschungsergebnisse wurden in den Langartikel CIKM2022 aufgenommen.

Papieradresse: https://arxiv.org/abs/2208.03030

Github-Adresse: https://github.com/benywon/ChiQA

Vergleich von Einzelmodalität Frage- und Antwortaufgabe

Drei herausragende Merkmale von ChiQA

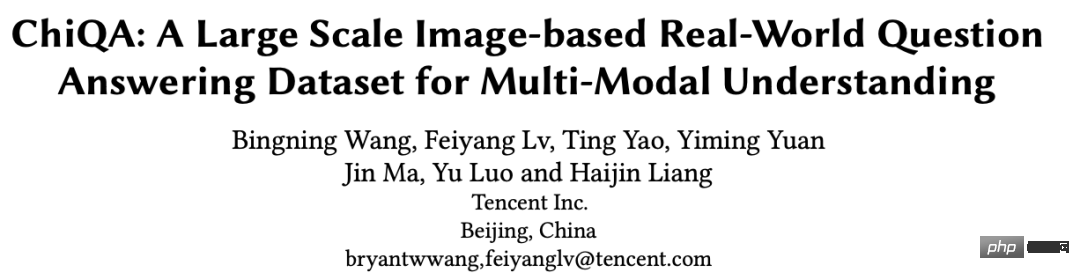

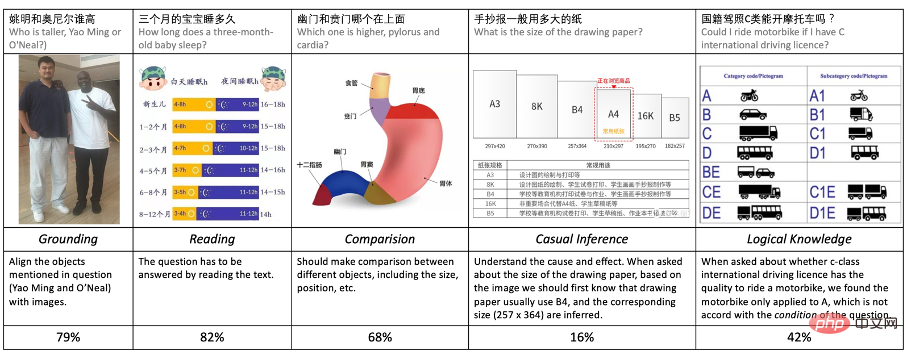

Fragenbeantwortung ist eine der sehr wichtigen Aufgaben in der künstlichen Intelligenz und der intelligenten Sprachverarbeitung. In den letzten Jahren haben sich Frage- und Antwortaufgaben mit der Veröffentlichung großer Datensätze (wie SQuAD, NaturalQuestions) und der Einführung großer vorab trainierter Sprachmodelle (wie BERT, GPT) rasant weiterentwickelt. Allerdings sind die meisten aktuellen Fragebeantwortungsaufgaben unimodal, d. h. alle Fragen, Ressourcen und Antworten basieren auf Text. Aus der Perspektive kognitiver Intelligenz und praktischer Anwendungen können multimodale Ressourcen wie Bilder jedoch häufig umfassendere Informationen und Antworten liefern. Zum Beispiel für eine Frage: Welche Abmessungen hat das iPhone13? Eine Größenvergleichstabelle für verschiedene iPhone13-Modelle wäre klarer und intuitiver. Es gibt auch einige Beispiele, wie in der folgenden Abbildung dargestellt:

Abbildung 1: Einige Beispiele, die sich für die Verwendung von Bildern zur Beantwortung von Benutzerfragen eignen

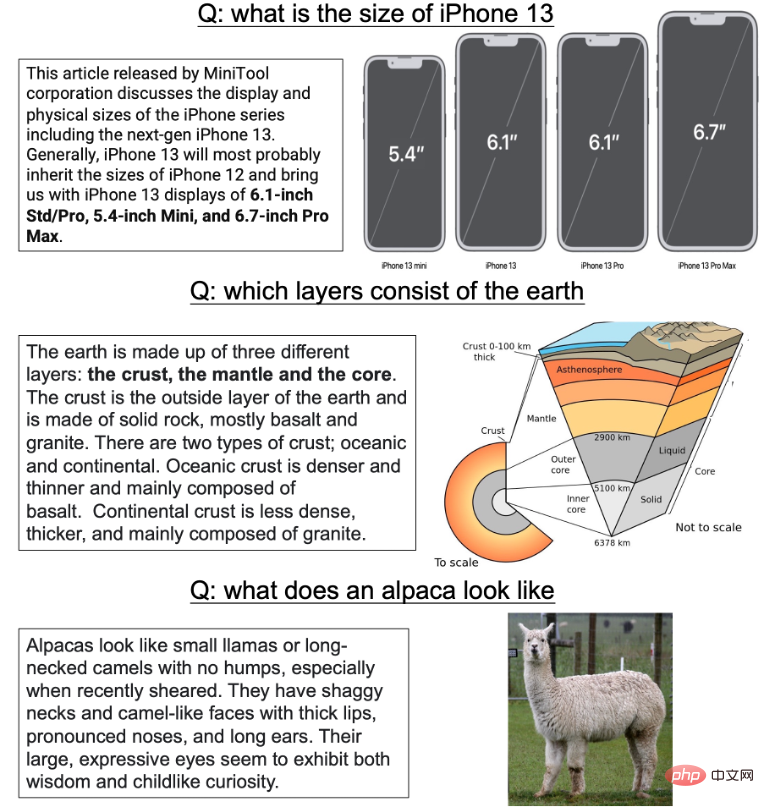

In den letzten Jahren wurden Frage- und Antwortdaten und Aufgaben für mehrere Personen erstellt -Modales Verständnis wurde sukzessive entwickelt und vorgeschlagen. Wie VQA1.0 und 2.0, CLEVR, GQA usw. In den meisten Bildfrage- und Antwortdatensätzen stellt das System den Annotatoren einige künstlich generierte oder reale Bilder zur Verfügung, und die Annotatoren müssen einige Fragen manuell schreiben, die auf bestimmte Attribute oder Entitäten abzielen. Dieser Datenerfassungsprozess weist jedoch zwangsläufig viele Mängel auf:

1) Alle Fragen sind bildabhängig, das heißt, der Annotator stellt Fragen, nachdem er das Bild gesehen hat. Im Prozess der groß angelegten Datenkonstruktion mangelt es künstlich generierten Fragen häufig an Diversität und sie sind aufgrund der subjektiven Faktoren der Annotatoren oft voreingenommen. Auf dieser Art von Daten trainierte Modelle, die sich zuerst die Ressourcen ansehen und dann Fragen stellen, können oft leicht sehr gute Ergebnisse erzielen, indem sie sich die Fragen ansehen, ohne auf die Hintergrundressourcen zu schauen Die Antwort ist oft eine einfache Entität, Beziehung oder einfache Beschreibung eines bestimmten Bereichs. Für tatsächliche Frage- und Antwortaufgaben mit Bildern sind jedoch viele Textantworten unnötig. Beispielsweise ist es sehr überflüssig, auf die Frage „Wie sieht ein Alpaka aus?“ eine ausführliche Antwort zu geben. Zweitens führt diese Art der kurzen Entitätsbeschreibung häufig dazu, dass Annotatoren nur auf lokale Beziehungen achten und einigen Informationen zur tatsächlichen Gesamtstruktur wenig Aufmerksamkeit schenken.

3) Schließlich konzentrieren sich die meisten früheren Ressourcen eher auf Englisch Sehr wenige Bildfrage- und Antwortdaten im chinesischen Bereich.

In dieser Arbeit schlagen wir als Reaktion auf die oben genannten Probleme einen groß angelegten Datensatz zur Beantwortung chinesischer Bildfragen vor – ChiQA (Chinese Image Question Answering). Wir begannen mit den tatsächlichen Suchbegriffen des Benutzers im mobilen QQ-Browser, riefen mehrere verwandte Bilder über eine bestimmte API ab und übergaben die Bilder dann an professionell geschulte Annotatoren zur dreistufigen Annotation, um anzuzeigen, ob das Bild die Frage perfekt beantworten kann (2 Punkte). ), teilweise beantwortet (1 Punkt) und nicht in der Lage, die Frage des Benutzers zu beantworten (0 Punkte). Für ChiQA gibt es drei bemerkenswerte Merkmale:

- Echte Fragen, echte Bilder: Die Bilder in ChiQA stammen aus zufälligen Benutzeranfragen. Bei diesen Abfragen handelt es sich um zufällige Benutzerabfragen in der offenen Domäne. Diese Abfragen sind sehr vielfältig und die Domänenverteilung der Abfragen ist sehr breit. Eine solche zufällige Diversitätsabfrage stellt sicher, dass die Fragen in unseren Daten nicht verzerrt sind.

- Beantwortbarkeit: Bei Frage-und-Antwort-Aufgaben ist die Beantwortbarkeit ein sehr wichtiger Aspekt. Bei ChiQA verlangen wir nicht, dass der Annotator die endgültige Antwort gibt: Dies führt oft zu zusätzlichen Voreingenommenheiten, wie zum Beispiel dem gesunden Menschenverstand des Annotators. Stattdessen konzentrieren wir uns auf die Beantwortbarkeit, also darauf, ob das Bild die Frage beantworten kann. Diese Beantwortbarkeit ermöglicht es ChiQA-Annotatoren, sowohl die Abfrage als auch das Bild zu verstehen.

- Unvoreingenommenheit: Da es auch bei zufälligen Abfragen das Gesetz von 28 gibt, treten häufig Probleme mit einigen hochfrequenten oder einzelnen Fragen auf Dieses einfache Muster wird die Daten dominieren und eine Tendenz zu einem echten modalübergreifenden Verständnis der Daten erzeugen. Daher haben wir im Datenerfassungsprozess einen zweistufigen aktiven Lernprozess eingeführt. Nachdem die zufällige Abfrageanmerkung in der ersten Phase abgeschlossen war, haben wir ein einfaches Modell trainiert und dieses Modell dann verwendet, um einige „schwierigere“ Modelle auszuwählen Der Datenreichtum und die Komplexität der Annotationsdaten der zweiten Stufe sind relativ höher.

Abbildung 2: Vergleich zwischen ChiQA und einigen anderen Bild-Frage- und Antwortdaten in der Branche

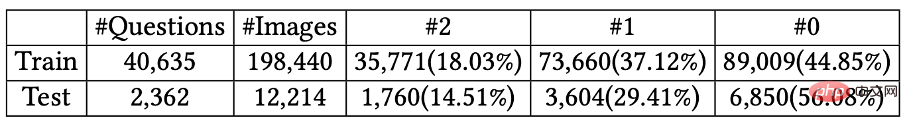

Am Ende haben wir mehr als 40.000 Fragen gesammelt, jede Frage hat etwa 5 verwandte Bilder Das heißt, die Gesamtzahl der Fragen übersteigt 200.000 Bildpaare. Zu jeder Frage gehören mehrere Bilder, und wir bewerten jedes Bild auf einer dreistufigen Skala von 2-1-0.

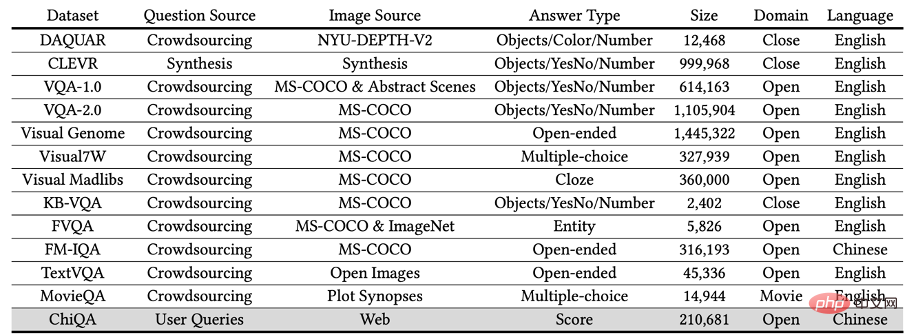

Einige Beispiele in ChiQA sind in der folgenden Abbildung dargestellt:

Abbildung 3: Beispiele einiger Proben in ChiQA.

Datenerfassung: Alle Fragen stammen aus echten Benutzeranfragen

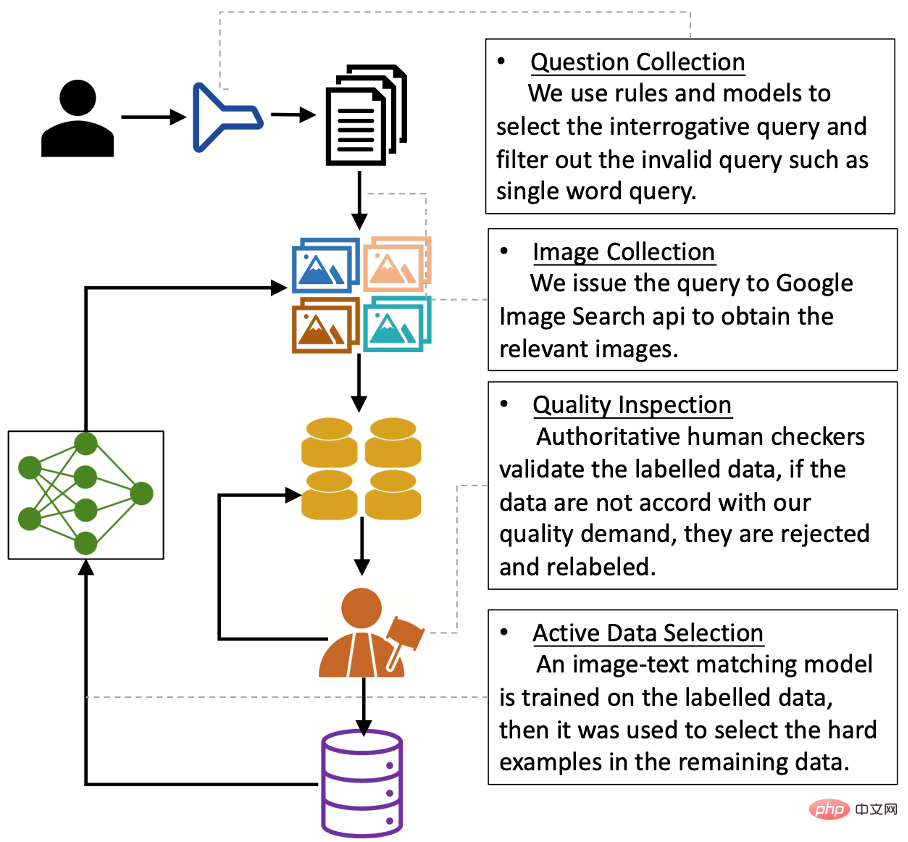

Der gesamte Datenerfassungsprozess kann in vier Schritte unterteilt werden: 4: Datenerfassungsprozess

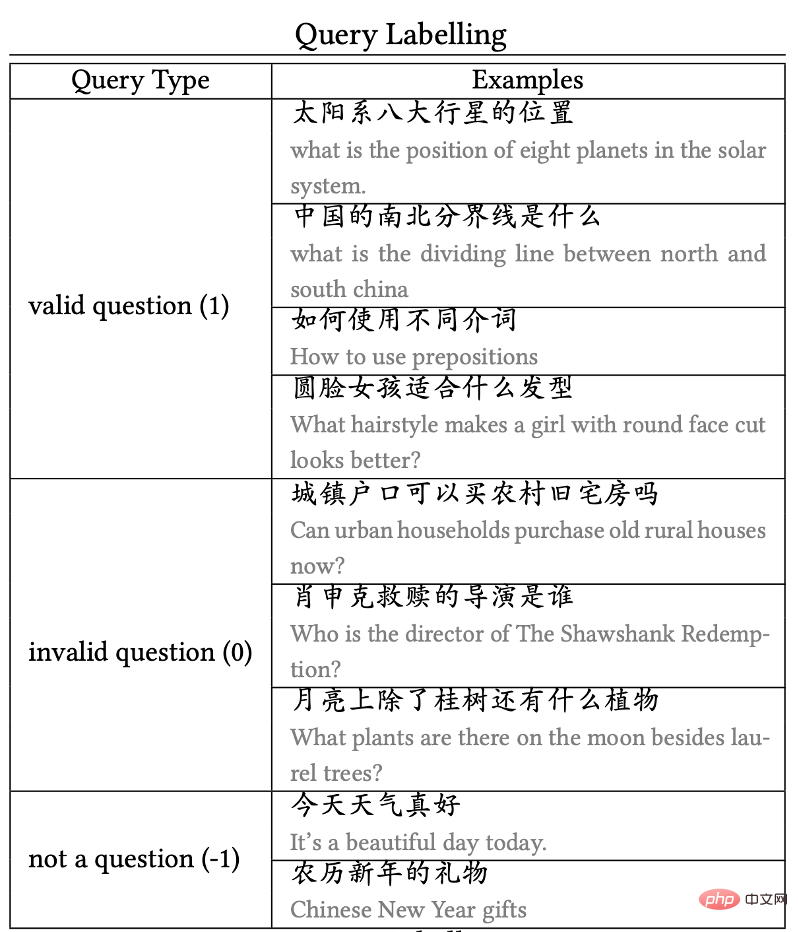

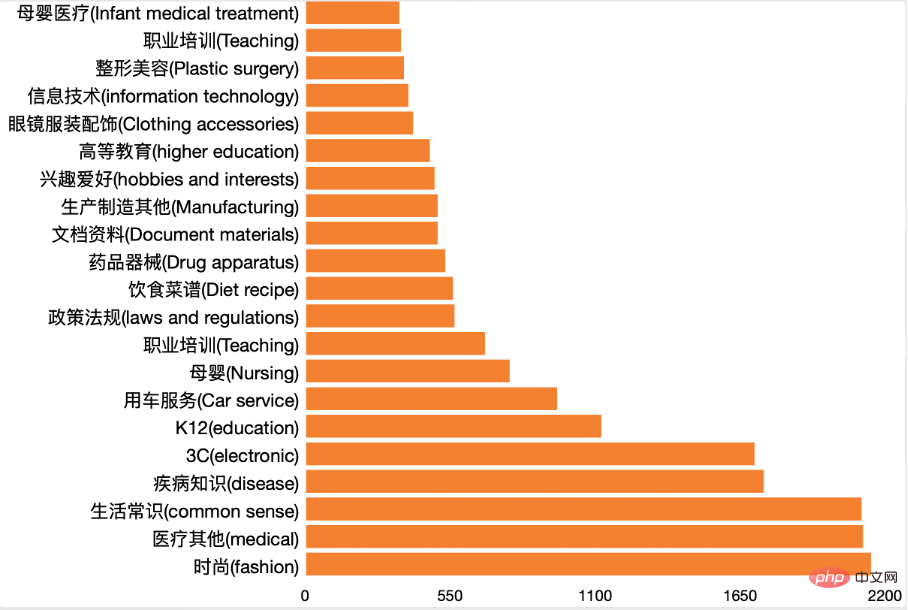

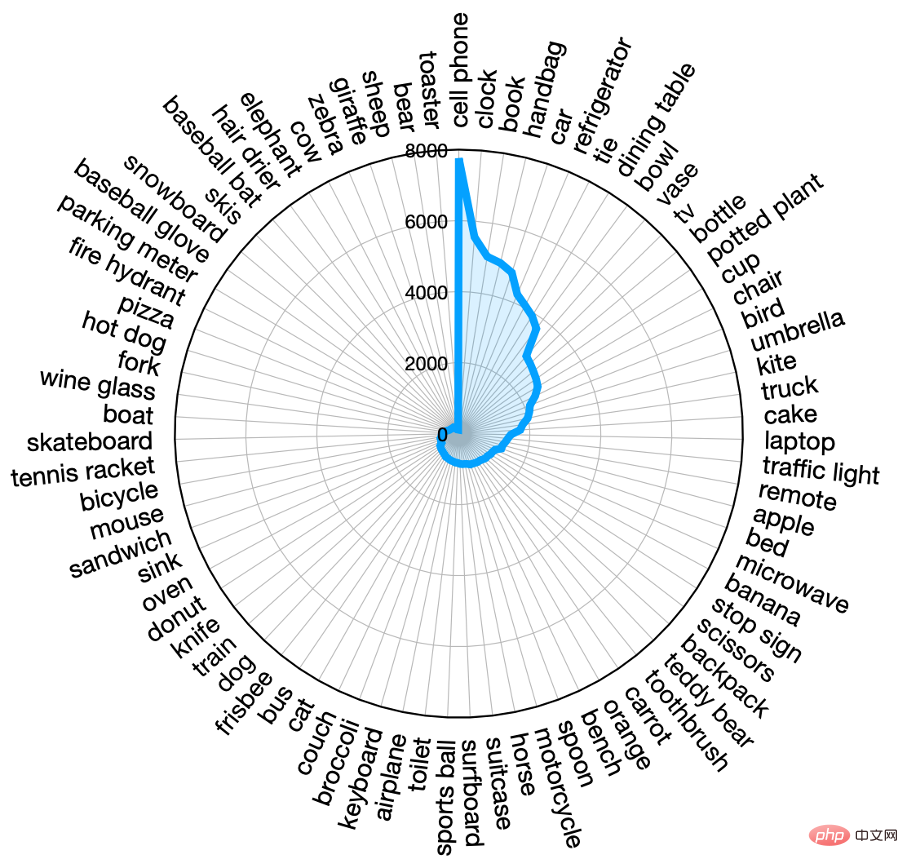

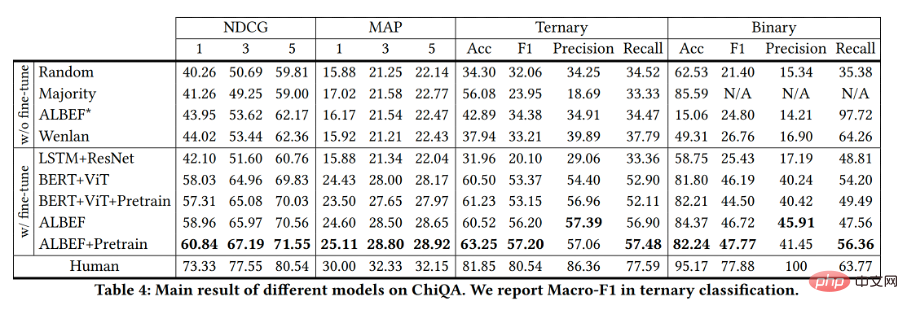

Also müssen wir zunächst Abfragen mit Frage- und Antwortabsicht herausfiltern. In dieser Arbeit verwenden wir eine intern entwickelte schwache Überwachungsmethode, um einen binären Klassifikator zu trainieren, um zu bestimmen, ob eine Abfrage eine Frage-Antwort-Absicht hat. Die menschliche Auswertung dieses Absichtsmodells konnte eine Präzision von 90 % und eine Erinnerung von 80 % erreichen. Wir nutzten dieses Modell zur Stichprobe von Benutzeranfragen und erhielten etwa 75.000 Benutzeranfragen, bei denen das Modell die Frage-und-Antwort-Absicht feststellte und die in die nächste Runde kamen. Nachdem wir die Fragen erhalten haben, senden wir diese an die von Google bereitgestellte offene API (Google Images API – SerpApi) zum entsprechenden Bildabruf. Die Google API gibt für jede Abfrage die 100 relevantesten Bilder zurück. Um die Qualität der endgültigen Daten sicherzustellen, haben wir Abfragen entfernt, deren Länge oder Breite weniger als 200 Pixel betrug, sowie Bilder, die zu lang oder zu breit waren. Nachdem wir das Originalbild erhalten haben, nehmen wir die 5 besten gefilterten Bilder und bitten den Annotator, diese Abfrage und die entsprechenden 5 Bilder zu kommentieren. Wir haben speziell für diese Aufgabe eine Anmerkungsschnittstelle entwickelt, wie in der folgenden Abbildung dargestellt. Abbildung 5: ChiQA-Annotationsschnittstelle Danke an Ben The Die Arbeit konzentriert sich hauptsächlich auf Bildfragen und -antworten, aber tatsächlich haben viele häufige Benutzerfragen nichts mit Bildfragen und -antworten zu tun (oder sind mit Bildern schwer zu beantworten). Daher bitten wir den Annotator zunächst, zu markieren, ob diese Frage als Bildfrage und Antwortfrage angesehen werden kann. Zum Beispiel: Wenn eine Frage „der Unterschied zwischen xxx und xxx“ lautet, wird diese Frage als Frage mit der Absicht einer Bildfrage und -antwort betrachtet. Einige Beispiele für Abfrageanmerkungen sind in Abbildung 6 dargestellt:

Abbildung 6: Beispiele für Abfrageanmerkungen 2) Bildanmerkungen für Gültig im Vorgänger Bei der Schrittabfrage beschriften wir die fünf Kandidatenabfragen. Der Anmerkungsstandard ist eine dreistufige 0-1-2-Anmerkung, wobei: Eine Bewertung von 0 bedeutet, dass das Bild überhaupt nicht zur Beantwortung dieser Frage verwendet werden kann, und eine Bewertung von 2 bedeutet, dass das Bild von ist hochwertig und kann diese Frage völlig unabhängig beantworten. Das Bild mit der Punktzahl 1 liegt irgendwo zwischen den beiden, was bedeutet, dass das Bild mit der Anfrage zusammenhängt, aber nicht direkt beantwortet werden kann. Der Benutzer benötigt möglicherweise weitere Fragen oder Begründungen, um die endgültige Antwort zu erhalten. Einige Beispiele für 0 Punkte, 1 Punkt und 2 Punkte sind unten aufgeführt: Abbildung 7: Für die Frage „Wie verwende ich verschiedene Präpositionen“, Beispiele für Bildanmerkungen und Bewertung 3) Qualitätskontrolle

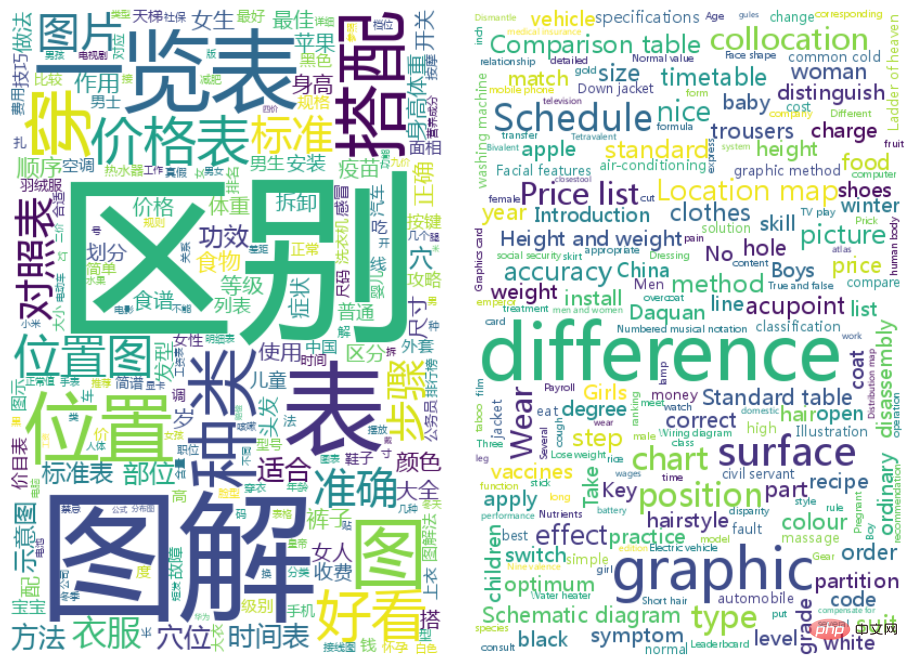

Wir wenden während des gesamten Etikettierungsprozesses ein strenges Qualitätskontrollsystem an. Konkret werden wir zunächst drei Qualitätsteams einladen, Testannotationen durchzuführen, und dann das Team mit der besten Annotationsqualität auswählen, um alle verbleibenden Daten zu annotieren. Zweitens werden wir während des Annotationsprozesses die annotierten Daten in Stapel aufteilen. Für jeden Datenstapel werden wir ein Fünftel der Daten zur manuellen Überprüfung abtasten. Wenn die Erfolgsquote der Daten weniger als 90 % beträgt, dann ist dies der Fall Batch Die Daten werden zurückgegeben und neu gekennzeichnet, bis die Datengenauigkeit 90 % erreicht. Nach der Datenerfassung haben wir festgestellt, dass, wenn die Daten zufällig ausgewählt und gekennzeichnet werden, Dann gibt es oft einige einfache Muster in den Daten. Das Vorhandensein einer großen Anzahl solcher einfacher Muster in den Daten kann das endgültige Modell verzerren. Deshalb entwerfen wir einen aktiven Lernannotationsprozess. Insbesondere werden wir Annotatoren zunächst bitten, einen Datenstapel zu kommentieren. Nachdem die Annotation dieses Datenstapels abgeschlossen ist, werden wir diesen Datenstapel verwenden, um ein Transmembran-Text-Bild-Matching-Modell zu trainieren. Nachdem das Modell trainiert wurde, beginnen wir mit der Verwendung dieses Modells zur „Auswahl“ neuer Stichproben: Wenn das Modell hinsichtlich der Vorhersage dieser neuen Stichprobe sehr unsicher ist (dh die Entropie der endgültigen Klassifizierungsvorhersage ist besonders groß), dann werden wir Denken Sie, dass diese Stichprobe für das Modell relativ schwierig ist. Daher besteht eine höhere Wahrscheinlichkeit, sie bis zur Mitte der nächsten Runde beizubehalten geringere Wahrscheinlichkeit bis zur nächsten Runde. Wir haben festgestellt, dass der aktive Lerndatenauswahlprozess den Datensatz tatsächlich unvoreingenommener macht. Wir haben festgestellt, dass die gekennzeichneten Daten aus der ersten Stufe einige nicht wahrnehmbare Verzerrungen enthielten. Beispielsweise werden Fragen, die das Wort „Tipps“ enthalten, als gültige Fragen markiert, aber fast alle entsprechenden Bilder werden als unbeantwortbar markiert (d. h. 0 Punkte). Daher ist es wahrscheinlich, dass das Modell die endgültige Frage direkt auf der Grundlage der Fragen vorhersagt Abfrage, ohne das Bildergebnis anzusehen. Dieser aktive Lernprozess verringert die Wahrscheinlichkeit, dass diese hochvertrauliche und voreingenommene Abkürzung in der nächsten Runde schwer auszuwählen ist, wodurch die Wirkung dieses Modells verringert wird. Wir haben zufällig 2500 Datenelemente aus den Annotationsdaten herausgefiltert und verschiedene Annotatoren gebeten, sie neu zu kennzeichnen. Wenn das Anmerkungsergebnis mit dem vorherigen Ergebnis übereinstimmt, werden die Daten als Testsatz beibehalten. Wenn sie unterschiedlich sind, bitten wir einen „Experten“, der die Aufgabe sehr gut kennt, die Daten erneut zu kommentieren und schließlich 2362 Tests zu erhalten Daten und mehr als 40.000 Trainingsdaten. Die statistischen Informationen des Trainingssatzes und des Testsatzes sind in der folgenden Abbildung dargestellt: Abbildung 8: Statistische ChiQA-Informationen zum Trainingssatz und Testsatz Nachdem wir die Daten markiert haben, haben wir durchgeführte ChiQA. Führen Sie Statistiken und Analysen der Daten durch. 1) Analyse häufiger Wörter abfragen: Wir verwenden Stottern Die Wortsegmentierung unterteilt die Abfrage und zeigt die Wörter in der Abfrage im Wolkendiagramm unten nach Häufigkeit an: Sie können sehen, dass die häufigsten Abfragen in ChiQA Unterschiede, Illustrationen, Standorte usw. sind. Dies steht im Einklang mit unserer Intuition, denn diese Wörter sind in der Tat sehr geeignete Fragen, die mit Bildern beantwortet werden können. Wir verwenden ein internes Feld. Der Klassifizierungsklassifizierer wird verwendet, um alle Abfragen zu klassifizieren. Das Endergebnis ist wie folgt: #🎜🎜 # kann angezeigt werden. Unsere Daten enthalten Daten aus vielen Feldern, und kein Feld verfügt über die absolute Mehrheit der Daten. Dadurch wird sichergestellt, dass unsere Datenverteilung gleichmäßig ist. Zweitens zählen wir auch die Fragewörter in der Frage und die Ergebnisse sind wie in der folgenden Abbildung dargestellt: #🎜🎜 # kann gesehen werden In ChiQA machen „Welche-Typ“- und „Wie-Typ“-Fragen die Mehrheit aus, während auch andere Fragen einen beträchtlichen Anteil ausmachen. 3) Bildanalyse Zusätzlich zu den Fragen haben wir auch die Bilder in ChiQA analysiert. Da die meisten Bilder sprachunabhängig sind, verwenden wir ein Zielerkennungsmodell DETR, das in der Branche als hervorragende Leistung anerkannt ist, um Entitäten im Bild zu ermitteln. DETR kann Entitäten im Bild durch Standard-MS-COCO definierte Entitäten zuordnen, z. B. „Person“, „Hund“ usw. Wir durchsuchen Entitäten für jedes Bild in ChiQA und zeigen die Verteilung der Entitäten mit der höchsten Häufigkeit in der folgenden Abbildung an: Es ist ersichtlich, dass mehr als 30 Entitäten mindestens 1000 Mal in ChiQA vorkommen, was zeigt, dass ChiQA vorhanden ist Bilddaten, die sehr gleichmäßig verteilt sind und die meisten Bereiche abdecken. Die am häufigsten vorkommenden Entitäten sind „Personen“, „Mobiltelefone“, „Autos“ usw. Dies ähnelt der Verteilung der Fragen. 4) Argumentationsfähigkeiten Um die Daten besser analysieren zu können, haben wir auch die in den ChiQA-Daten erforderlichen Argumentationsfähigkeiten analysiert. Konzentriert sich auf die Analyse von 5 Fähigkeiten, die Argumentation erfordern: Wir haben zufällig Stichproben durchgeführt 200 ChiQA-Daten und beschriftet sie gemäß den oben genannten 5 Standards, wobei einige Daten möglicherweise mehr als eine Argumentationsfähigkeit erfordern. Das Ergebnis ist unten dargestellt. Es ist ersichtlich, dass zusätzlich zu Grouding mehr als 80 % der ChiQA-Daten ein tiefgreifendes Verständnis der Text- und Kontrastbeziehungen in Bildern erfordern. Dies unterscheidet sich stark von den meisten früheren VQA-Daten. Zweitens gibt es eine ganze Reihe von Fragen, die Logik und Vergleich erfordern, was darauf hindeutet, dass die Daten in ChiQA ziemlich schwierig sind. Wir glauben, dass die Analyse der Denkfähigkeiten in ChiQA uns helfen kann, diese Daten besser zu verstehen und eine a priori-Anleitung für den späteren Modellentwurf bereitzustellen. Im ChiQA-Datensatz hat der Annotations-Score drei Ebenen: 0, 1, 2, daher testen wir im Experiment die Modellranking-Indikatoren und die allgemeinen Klassifizierungsindikatoren. Unterteilt in drei Kategorien: Basismodell Wir haben mit mehreren häufig verwendeten Modellen im ChiQA-Datensatz experimentiert. Im Anschluss an die vorherige Arbeit zum Bild-Text-Abgleich kodieren wir zunächst das Bild und den Text mithilfe von Encodern, führen dann eine modalübergreifende Fusion ihrer Darstellungen durch und verwenden schließlich eine Vorhersageebene, um die Übereinstimmungsbewertung zu erhalten. In den unten aufgeführten Modellen bedeutet das Hinzufügen von ♣, dass das Modell vorab trainiert wurde, und das Hinzufügen von ♦ bedeutet, dass es nicht vorab trainiert wurde. Das Ergebnis ist: Die Indikatoren des oben genannten Modells auf dem Testsatz sind in der Abbildung dargestellt. Wir können sehen, dass die direkte Anwendung bisheriger hochmoderner modalübergreifender Methoden schlecht abschneidet und die Metriken nur geringfügig besser sind als bei Zufallsbewertungsmodellen. Dies bedeutet, dass ChiQA-Daten schwierig sind und Modelle, die nur schwach überwachtes kontrastives Lernen in großem Maßstab verwenden, wie ALBEF*, Wenlan, möglicherweise nicht in der Lage sind, die feinkörnigen Informationen zu unterscheiden, die für die visuelle Beantwortung von Fragen erforderlich sind. Darüber hinaus zeigt die schlechte Leistung dieser Modelle, dass sich der ChiQA-Datensatz von früheren schwach überwachten Bild-Text-Matching-Daten unterscheidet, da sich der schwach überwachte Bild-Text-Matching auf die Korrelation konzentriert, während die ChiQA-Daten auch die Beantwortung von Bildern erfordern. Schließlich hat das auf ChiQA verfeinerte Modell große Fortschritte gegenüber der Basislinie gemacht, ist aber immer noch weit von der menschlichen Leistung entfernt, sodass das Modell im ChiQA-Datensatz besser ist Es gibt noch viel Raum für Verbesserungen. Mit der Entwicklung des Internets haben Benutzer einen höheren Bedarf an Fragen und Antworten, und das System muss diese bereitstellen intuitivere und bequemere Antworten. Insbesondere in den letzten Jahren sind Multimedia-Inhalte immer häufiger geworden und immer mehr auf Bildern und Videos basierende Frage-und-Antwort-Inhalte wurden der Öffentlichkeit zugänglich gemacht. Das QQ Browser Lab Lizhi-Team war das erste in der Branche, das im April dieses Jahres ein Bild-Frage-Antwort-Projekt gestartet hat. Wenn ein Benutzer beispielsweise nach dem Unterschied zwischen Kiwis und Kiwis sucht, werden die Ergebnisse intuitiv im Vordergrund angezeigt des Nutzers in Form von Bildern. Wie im Bild unten gezeigt: Derzeit ist diese Art von Problem, das direkt durch Bilder gelöst werden kann, gelöst gute Ergebnisse, nachdem es online ging. Wir haben beobachtet, dass sich das Benutzerverhalten (wie CTR, Wortersetzungsrate usw.) im Vergleich zu herkömmlichen Ergebnissen erheblich verbessert hat, was darauf hindeutet, dass die aktuellen „neuen Fragen und Antworten“ auf der Grundlage von Bildern usw. ein Produktgeschäft sind, das noch besser werden kann Benutzerbedürfnisse erfüllen. Vorstellung des Autorenteams Das Team des QQ Browser Search Technology Center ist für die Suchtechnologieforschung und -entwicklung der Tencent PCG-Informationsplattform und -Servicelinie verantwortlich. Es stützt sich auf die Content-Ökologie von Tencent und treibt Produktinnovationen durch Benutzerforschung voran und stellt Benutzern Grafiken, Informationen, Romane usw. zur Verfügung. Lange und kurze Videos sowie Dienstleistungen und andere vielfältige Informationsbedürfnisse werden erfüllt. In Bezug auf Algorithmen, basierend auf natürlicher Sprachverarbeitung, Deep Learning, multimodalem Verständnis und Generierung, Wissensberechnung und -anwendung und anderen Technologien, bauen wir Inhaltsverständnis, Korrelation und Sortierung, multimodale Suche, intelligente Frage und Antwort, multi- Sprachübersetzung, empfohlene Suche und andere technische Richtungen, Erforschung und Anwendung der fortschrittlichen Technologien der Branche, um ein besseres Benutzersucherlebnis in Bezug auf die Technik zu schaffen, ein mittelstufiges industrialisiertes System für Suchtechnologie aufzubauen und eine hohe Leistung und Hochverfügbarkeit zu verbessern; Das kostengünstige Abrufsystem im Wert von mehreren zehn Milliarden Euro bietet Tencent mit PCG grundlegende Suchmaschinendienste für die Suchszenarien verschiedener Content-Unternehmen. Es unterstützt derzeit mehrere PCG-Produktlinien wie QQ Browser, Tencent Video, Tencent News und Tencent Weishi. Bilderfassungs- und Anmerkungsprozess und -erfahrung

Aktive Lerndatenanmerkung

Machen Sie die Ergebnisse unvoreingenommener

Annotation des Testsatzes

Inferenz und Analyse von Daten

#🎜🎜

#🎜🎜

Experimentelle Bewertungsindikatoren

#🎜🎜 #

#🎜🎜 #

Das obige ist der detaillierte Inhalt vonChiQA – ein Bildfrage- und Antwortdatensatz basierend auf 200.000 echten Benutzerfragen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr