Heim >Technologie-Peripheriegeräte >KI >Andere bringen immer noch „große Modell'-Satelliten auf den Markt, aber Microsoft hat den Entwicklern bereits beigebracht, wie man sie nutzt

Andere bringen immer noch „große Modell'-Satelliten auf den Markt, aber Microsoft hat den Entwicklern bereits beigebracht, wie man sie nutzt

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 09:55:15821Durchsuche

Der Frühlings- und Sommerwechsel ist die Jahreszeit, in der die weltweit führenden Technologieunternehmen jährliche Veranstaltungen veranstalten. Vor zwei Wochen war es Google, und diese Woche ist endlich Microsoft an der Reihe. In nur 43 Minuten hielt Satya Nadella, Chairman und CEO von Microsoft, die Grundsatzrede auf der diesjährigen Build 2022-Konferenz. Als würde er über Allegro sprechen, veröffentlichte er mehr als 50 neue Produkte, Technologien und Projektfortschritte von Microsoft in zehn Hauptbereichen wie Entwicklerprozess, Cloud Computing, Microservices, Kommerzialisierung großer KI-Modelle, Low Code und industrielles Metaversum.

Zu den bemerkenswertesten Neuerscheinungen gehören:

- OpenAI Services, ein großer Modelldienst, der mithilfe der OpenAI-Technologie erfolgreich kommerzialisiert wurde;

- eine Low-Code/No-Code-Entwicklungsplattform, die auf maschinellen Lernalgorithmen basiert, Der GitHub Copilot AI-Code-Assistent ist offiziell für die Öffentlichkeit zugänglich Echtzeit-Kollaborationsplattform „Miniprogramm“ usw.

- Von den zahlreichen Neuerscheinungen sind die meisten auf die folgenden drei Schlüsselaspekte zurückzuführen:

- Durch KI und KI-Toolunterstützung können Entwickler und Geschäftsanwender von der Last von Tools wie dem GitHub Copilot-Codegenerierungstool befreit werden , geräteübergreifende synchronisierte Entwicklungsumgebung, virtuelle Maschine Dev Box usw.); Reduzieren Sie Entwicklungsbarrieren zwischen mehreren Computerplattformen (Chiparchitektur, Betriebssystem usw.) und stellen Sie Entwicklern vollständig „integrierte KI-Anwendungen“ zur Verfügung als ARM-Architekturentwicklungs- und Testprototyp Project Volterra, Azure Cloud Computing Machine Learning Service usw.

- Verwenden Sie KI-gesteuerte Automatisierungstechnologie, um die Büroeffizienz weiter zu verbessern, wie z. B. das Low-Code-Web-App-Generierungstool Power Pages, Kundenservice-Verbraucher Tool zur Erstellung von Konversationszusammenfassungen, Textzusammenfassung usw.

Aus diesen Perspektiven lässt sich erkennen, dass der Mitbegründer und ehemalige CEO Ballmer immer noch daran festhält, „Entwickler! Entwickler!“ zu rufen. Nur wenn Entwickler weiterhin den Aufbau von Microsoft-geführten Unternehmensdiensten und dem Cloud-Computing-Ökosystem unterstützen und sich daran beteiligen, kann dieses Unternehmen weiterhin Fuß fassen und nicht zum nächsten

- HP

- /Yahoo werden.

- Lassen Sie uns von Silicon Stars herausfinden, welche wichtigen Entwicklertools Microsoft heute veröffentlicht hat.

- Lassen Sie große Modelle kommerzialisieren und zu einem Werkzeug für Entwickler werden

Als OpenAI zuvor GPT-3 auf den Markt brachte, erhielten viele Drittentwickler Testgenehmigungen und erstellten viele sehr kreative Demos. Allerdings verfügt niemand über „erweiterte“ Berechtigungen als Microsoft. Microsoft sieht in GPT-3 große Kommerzialisierungsaussichten sowie die zahlreichen Bemühungen von OpenAI in groß angelegten/sehr großen generativen Sprachen und multimodalen Modellen. Im Jahr 2019 haben OpenAI und Microsoft eine strategische Partnerschaft geschlossen. Natürlich befürchte ich, dass nur Microsoft, das sich mit den Büro- und Unternehmensmärkten bestens auskennt, diese Technologien wirklich und effizient in einen Motor verwandeln kann, der das Geschäftswachstum vorantreibt. Auf der heutigen Build-Konferenz haben wir gesehen, dass die Zusammenarbeit zwischen Microsoft und OpenAI endlich Früchte getragen hat: Microsofts Cloud-Computing-Plattform Azure hat OpenAI Services offiziell eingeführt (Vorschauversion). Entwickler können sich für eine Testversion dieses Dienstes in einer Vielzahl verschiedener Versionen bewerben Darunter werden große Modelle der Codegenerierung und Sprachgenerierung angewendet, die von OpenAI entwickelt wurden. Um es in einem Satz zusammenzufassen: Alle Anwendungen können von großen KI-Modellen unterstützt werden.

Azure OpenAI ServicesNehmen Sie die Online-Gebrauchtwagen-Verkaufsplattform CarMax als Beispiel: Beim Gebrauchtwagenkauf sind Verbraucher immer mit einer „Informationsüberflutung“ konfrontiert, der Blick auf Hunderte technische Details und Kommentare zum Fahrzeug bereitet ihnen Kopfzerbrechen für Laien. Das Unternehmen CarMax nutzt Azure OpenAI Services und nutzt dabei die leistungsstarken „Leseverständnis“-Funktionen von GPT-3 und die unternehmensweiten Servicefunktionen der Azure-Cloud-Computing-Plattform, um verfeinerte Informationen über Fahrzeuge zu generieren. Jetzt können CarMax-Benutzer den vom Modell zusammengefassten „Absatz“ verwenden, um die tatsächlichen Fahrzeugbedingungen zu verstehen, z. B. wie viele Personen untergebracht werden können, Raumgröße und -komfort, Kraftstoffverbrauch usw. OpenAI Services reduzieren effektiv den psychologischen Druck von CarMax-Benutzern während des Autokaufprozesses, reduzieren Transaktionsreibungen und erhöhen die Wahrscheinlichkeit, eine Transaktion abzuschließen.Schematische Darstellung von Carmax mit Azure OpenAI Services. Animationsquelle: Microsoft

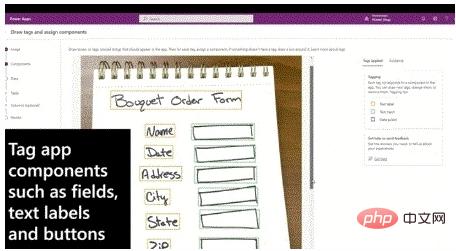

Eine weitere erwähnenswerte Sache: Express Design, eine Low/No-Code-Entwicklungsfunktion. Mit dieser Technologie können Sie einen Designentwurf in nur wenigen Sekunden direkt in eine funktionierende Anwendungsoberfläche oder sogar eine vollständige Anwendung umwandeln.

Express Design ist eine der Funktionen von Microsofts Low-Code-Entwicklungstool Power Apps. Es unterstützt eine Vielzahl von Dateiformaten, darunter Figma-Dateien, PDF, PPT und andere Dokumentformate und sogar handgezeichnete Entwürfe. Dahinter stecken auch Sprachgenerierung und multimodale Modelle, die von Microsoft selbst und Partnern wie OpenAI entwickelt wurden.

Benutzer von Power Apps-Entwicklern können noch heute mit der Nutzung der Express Design-Funktionen beginnen.

Express Design kann Designentwürfe in nur wenigen Sekunden direkt in nutzbare Anwendungsprototypschnittstellen umwandeln. Quelle der Animation: Microsoft

Wie bereits erwähnt, haben wir in der Vergangenheit zwar viele interessante und vielversprechende Demos gesehen, aber die tatsächliche Anwendung großer Modelle war schon immer ein Problem für Forschungs- und Entwicklungseinrichtungen.

Kombinieren Sie ultragroße Modelle mit der Azure-Cloud-Computing-Plattform, um eine groß angelegte automatisierte Erstellung von Code und Inhalten zu erreichen – das ist auch die Bedeutung des von Microsoft in diesem Jahr vorgeschlagenen „Model as Platforms“-Konzepts.

Man kann sagen, dass die verschiedenen OpenAI-Demos vor zwei Jahren es uns ermöglicht haben, das Potenzial extrem großer Parameter-Sprachgenerierungsmodelle zu erkennen. Was Microsoft heute tut, besteht nicht nur darin, große Modelle in die Hände von Entwicklern zu legen, sondern, was noch wichtiger ist, ihnen beizubringen, wie sie das Potenzial großer Modelle weiter ausschöpfen können. Die Kommerzialisierung großer Modelle ist nicht so einfach wie das Öffnen einer API. Schließlich ist es immer noch eine brandneue Sache. Wenn Sie ihm das Fischen beibringen, müssen Sie ihm das Fischen beibringen.

Durch technische Dienste und Funktionen wie Azure OpenAI Services und Express Design ist Microsoft der Erste geworden, der den großen Modellkrabben gefressen hat.

Videokonferenzen zum „Teilen von Bildern“ sind Hightech geworden!

Seit Ausbruch der Epidemie sollte sich jeder an Heim-/Fernarbeit und Videokonferenzen gewöhnt haben. Ich glaube, dass viele Leute beim Erklären von Folien in Besprechungen häufig die Funktion zum Teilen des Bildschirms verwenden.

Nach Angaben des Teams-Teams der Office-Collaboration-Software von Microsoft arbeiten jedoch viele Branchenunternehmen mittlerweile remote und müssen komplexere Kollaborationsaufgaben an einer Vielzahl von Softwarelösungen erledigen. Solche Anforderungen können nicht „passiv“ geteilt werden. Die Bildschirmfunktion ist vorhanden zufriedenstellend.

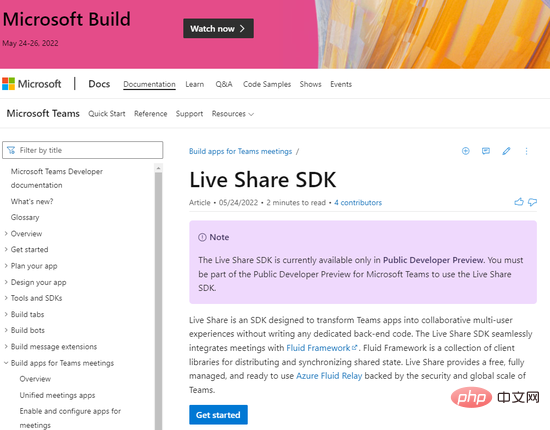

Zu diesem Zweck hat Teams dieses Jahr die Live-Share-Funktion eingeführt.

Live Share ist kein Ersatz für die Bildschirmfreigabe, kann aber als „erweiterte“ Version der Bildschirmfreigabefunktion angesehen werden. Konkret fügt Live Share eine Drittanbieter-Anwendungsschnittstelle in die Videokonferenz ein – ein bisschen wie ein Remote-Desktop, der nicht nur das Ansehen, sondern auch die Interaktion aller Teilnehmer ermöglicht.

Nehmen Sie als Beispiel die 3D-Modellierungssoftware Hexagon im Bild unten: Sie können in einer Teams-Videokonferenz einen Live-Share-Bildschirm initiieren und andere Teilnehmer können das 3D-Modell aus ihrem eigenen Blickwinkel bearbeiten und betrachten. Diese intuitivere Zusammenarbeit ermöglicht es den Teilnehmern, intuitiver am Brainstorming teilzunehmen.

Teams‘ neu eingeführte Echtzeit-Zusammenarbeitsfunktion Live Share ermöglicht die Einbettung komplexer, interaktiver Programme von Drittanbietern in Besprechungen und erweitert so die Bedienbarkeit der Bildschirmfreigabe in Videokonferenzen erheblich. Quelle der Animation: Microsoft

Take the Einfachstes Szenario:

Ein Anwendungsentwicklungsteam demonstriert ein rundes Produkt. Sie möchten sehen, wie sich das Klicken auf das Anwendungsmenü und das Ziehen des Symbols auswirkt es für Sie;

Mit Live Share können Sie jetzt auf Ihrem eigenen Bildschirm arbeiten und jeder Teilnehmer kann gleichzeitig verschiedene Vorgänge ausführen, ohne den für andere sichtbaren Bildschirm zu beeinträchtigen. Auf diese Weise erhielten nicht nur alle ein tieferes Verständnis für den Inhalt der Präsentation, sondern es verkürzte sich auch die Besprechungszeit erheblich.

(In der Sprache der Entwickler: Live Share ist so, als würde man den Inhalt der Demonstration in eine virtualisierte Instanz verwandeln. Jeder Teilnehmer kann seine eigene Instanz erhalten.)

Die Live Share-Funktion basiert auf der Entwicklung von Microsoft. End-Framework Foundation Framework müssen Drittanbieter-Anwendungsentwickler lediglich das neu eingeführte Live ShareSDK von Microsoft in ihre Produkte integrieren, damit ihre Anwendungen diese Funktion unterstützen können.

Über Live Share können Funktionen implementiert werden, darunter grundlegende Schnittstelleninteraktionen, Synchronisierung von Audio- und Videoinhalten, Mehrbenutzerbearbeitung usw. sowie die Planung von Poker (Agile Poker) usw. Zu den Partnern für das Feature gehören der Video-Collaboration-Dienst Frame.io, das Designunternehmen Hexagon, das Beratungsunternehmen Accenture, der Planungs-Pokerdienst Parabol und andere.

Es ist zu erwarten, dass mit der Live Share-Funktion mehr Entwickler und Teams mit intensiver Zusammenarbeit Teams bevorzugen werden, wenn sie Lösungen für Bürokollaboration und Videokonferenzen auswählen.

Für neue Plattform-/plattformübergreifende Entwickler ein offenes Hardware-Ökosystem bereitstellen

Als Open Source vor mehr als zehn Jahren diskutiert wurde, befürchte ich, dass nur wenige Leute Microsoft als positiven Fall heranziehen würden . Doch seit 2015 ist Microsoft einer der aktivsten und wichtigsten Mitwirkenden im ökologischen Bereich der offenen Technologie geworden, angefangen bei Open Source .NET über die Unterstützung der Entwicklung mehrerer Betriebssysteme/Sprachen bis hin zur strategischen Übernahme und technischen Unterstützung von GitHub. Als berechtigtes Interesse an der Wintel-Allianz scheut Microsoft den Niedergang der x86-Computerplattform nicht. In den letzten Jahren hat sich Microsoft bei der Unterstützung der Multiplattform-Entwicklung bewährt. Auf dieser Build-Konferenz hat das Unternehmen einen weiteren wichtigen Schritt zur Unterstützung des offenen Hardware-Ökosystems unternommen. Heute hat Microsoft das Project Volterra, ein ARM-Architektur-Entwicklerkit, gestartet:

#🎜 🎜# „Wir glauben, dass die Windows-Hardware offen ist „Das Ökosystem kann Entwicklern mehr Flexibilität und Auswahl bieten und ihnen dabei helfen, Produkte zu entwickeln, die eine Vielzahl von Szenarien unterstützen können“, sagte Microsoft. Project Volterra ist ein solches Produkt, das auf der Unterstützung von ARM-Architekturentwicklern basiert.

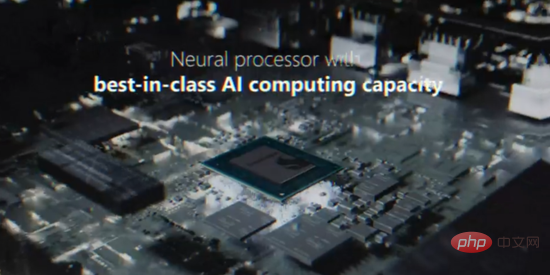

Das Projekt Volterra nutzt die Snapdragon NPU-Rechenplattform und verfügt über eine integrierte neuronale Recheneinheit (NPU), die Qualcomm in den letzten Jahren gefördert hat und mit der Inferenzen und einige Trainingsarbeiten an Modellen für maschinelles Lernen mit geringerer Leistung durchgeführt werden können Stromverbrauch. Dieser Entwicklerprototyp führt Windows auf ARM aus und ist für Entwickler geeignet, deren primäre Arbeitsumgebung Windows oder das Windows-Subsystem für Linux ist.

Project Volterra integriert mehrere E/A-Schnittstellen, und Microsoft behauptet, dass diese Entwicklungsmaschine ein stapelbares Design annimmt, was zu bedeuten scheint, dass sie gestapelt werden kann Mehrere Maschinen zur Implementierung eines Workload-Musters ähnlich dem Parallel Computing:

Die Versuche von Devices, Windows auf ARM zu installieren, haben nichts erreicht, womit man sich rühmen könnte, und einige Versuche sind sogar kläglich gescheitert, wie zum Beispiel Surface RT in den letzten Jahren und Surface RT in den letzten beiden Jahre. Neo/Duo Dual-Screen-Gerät.

Die Versuche von Devices, Windows auf ARM zu installieren, haben nichts erreicht, womit man sich rühmen könnte, und einige Versuche sind sogar kläglich gescheitert, wie zum Beispiel Surface RT in den letzten Jahren und Surface RT in den letzten beiden Jahre. Neo/Duo Dual-Screen-Gerät.

Neben Project Volterra kündigte Microsoft auch an, dass es eine End-to-End-Implementierung von ARM implementieren wird Architektur auf der gesamten Windows-Plattform. Unterstützung, Bereitstellung einer Reihe nativer ARM-Toolketten, einschließlich, aber nicht beschränkt auf Visual Studio/VSCode, Visual C++, NET Framework usw.

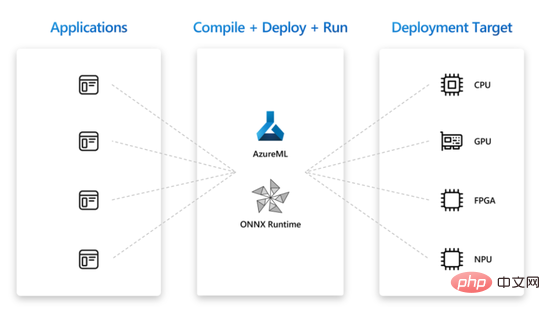

Basierend auf der starken Unterstützung der ARM/Snapdragon NPU-Computing-Plattform plant Microsoft derzeit einen großen Plan: Hybrid Loop. Hybrid Loop ist ein plattformübergreifendes KI-Entwicklungsmodell. Sein ultimatives Ziel besteht darin, jedes neuronale Netzwerkmodell mit Hilfe von Azure ML und ONNX Runtime (kompatibel mit mehreren neuronalen Netzwerk-Frameworks) nutzbar zu machen und auf einer Vielzahl gängiger Computer-Hardwareplattformen wie CPU, GPU, NPU, FPGA usw. bereitgestellt. Das Projekt Volterra ist ein Versuch dieses großartigen Plans.

Das Projekt Volterra ist ein Versuch dieses großartigen Plans.

Die oben genannten neuen Produkte und Technologien sind unserer Meinung nach besonders erwähnenswert auf der diesjährigen Build-Konferenz. Wie am Anfang des Artikels erwähnt, wurden in der diesjährigen Keynote-Rede in 43 Minuten mehr als 50 neue Gadgets in 10 Hauptkategorien vorgestellt. Wenn Sie mehr über alle Projekte erfahren möchten, können Sie die offizielle Website von Microsoft besuchen.

Aber ich möchte noch eine letzte Sache hinzufügen: Eines der Features der diesjährigen Build Developer Conference ist „kein Futures-Verkauf“. Der überwiegende Teil der diesmal über 50 Neuerscheinungen wird nach der Konferenz in unterschiedlichem Umfang für Entwickler und die Öffentlichkeit zugänglich sein.

Aber ich möchte noch eine letzte Sache hinzufügen: Eines der Features der diesjährigen Build Developer Conference ist „kein Futures-Verkauf“. Der überwiegende Teil der diesmal über 50 Neuerscheinungen wird nach der Konferenz in unterschiedlichem Umfang für Entwickler und die Öffentlichkeit zugänglich sein.

Sie können sich die Videoaufzeichnungen der Keynote-Rede und der Untersitzung der Build-Konferenz auf der offiziellen Website von Microsoft ansehen und sich über weitere Technologien und Produktveröffentlichungen informieren, die in diesem Artikel nicht erwähnt werden.

Das obige ist der detaillierte Inhalt vonAndere bringen immer noch „große Modell'-Satelliten auf den Markt, aber Microsoft hat den Entwicklern bereits beigebracht, wie man sie nutzt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr