Heim >Technologie-Peripheriegeräte >KI >Physisches Deep Learning mit biologisch inspirierten Trainingsmethoden: Ein Gradienten-freier Ansatz für physische Hardware

Physisches Deep Learning mit biologisch inspirierten Trainingsmethoden: Ein Gradienten-freier Ansatz für physische Hardware

- PHPznach vorne

- 2023-04-12 09:04:02917Durchsuche

Die wachsende Nachfrage nach künstlicher Intelligenz hat die Forschung zu unkonventionellem Computing auf Basis physischer Geräte vorangetrieben. Während solche Computergeräte die vom Gehirn inspirierte analoge Informationsverarbeitung nachahmen, stützt sich der Lernprozess immer noch auf Methoden, die für die numerische Verarbeitung optimiert sind, wie z. B. Backpropagation, die für die physische Implementierung nicht geeignet sind.

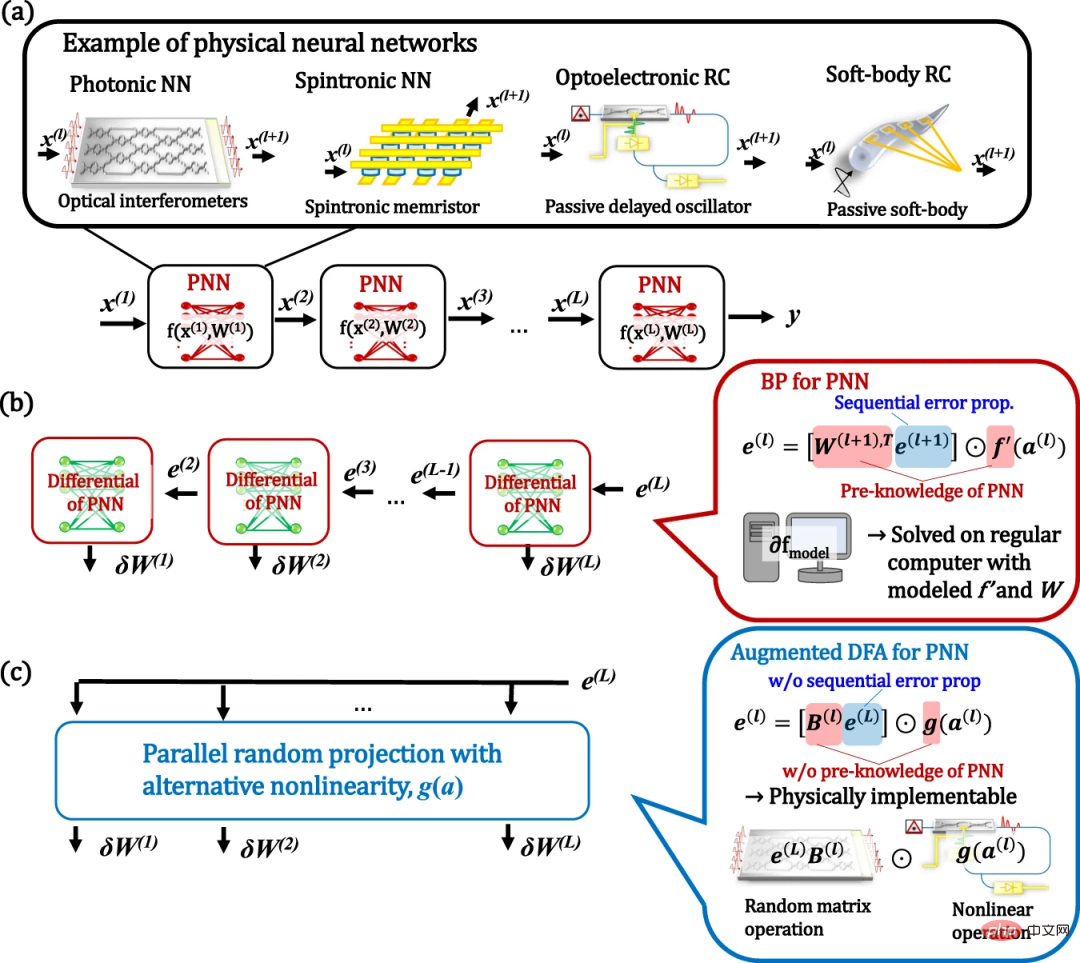

Hier demonstriert ein Forscherteam der japanischen NTT Device Technology Labs und der Universität Tokio die Physik, indem es einen biologisch inspirierten Trainingsalgorithmus namens Direct Feedback Alignment (DFA) Deep Learning erweitert. Anders als der ursprüngliche Algorithmus basiert die vorgeschlagene Methode auf Zufallsprojektionen mit alternativen nichtlinearen Aktivierungen. Daher können physikalische neuronale Netze ohne Kenntnis des physikalischen Systems und seiner Gradienten trainiert werden. Darüber hinaus kann die Berechnung dieses Trainings auf skalierbarer physischer Hardware simuliert werden.

Forscher demonstrierten den Proof-of-Concept mithilfe eines optoelektronischen rekurrenten neuronalen Netzwerks namens Deep Reservoir Computer. Das Potenzial für beschleunigtes Rechnen mit wettbewerbsfähiger Leistung bei Benchmarks wird demonstriert. Die Ergebnisse liefern praktische Lösungen für das Training und die Beschleunigung des neuromorphen Rechnens.

Die Forschung trug den Titel „Physisches Deep Learning mit biologisch inspirierter Trainingsmethode: Gradientenfreier Ansatz für physische Hardware“ und wurde am 26. Dezember 2022 in „Nature Communications“ veröffentlicht.

Physical Deep Learning

Die rekordverdächtige Leistung des auf künstlichen neuronalen Netzwerken (ANN) basierenden maschinellen Lernens in der Bildverarbeitung, Spracherkennung, Spielen usw. hat seine herausragenden Fähigkeiten erfolgreich unter Beweis gestellt. Obwohl diese Algorithmen der Funktionsweise des menschlichen Gehirns ähneln, werden sie im Wesentlichen auf Softwareebene mithilfe traditioneller Von-Neumann-Rechnerhardware implementiert. Solche auf digitalen Computern basierenden künstlichen neuronalen Netze haben jedoch Probleme hinsichtlich des Energieverbrauchs und der Verarbeitungsgeschwindigkeit. Diese Probleme motivieren den Einsatz alternativer physikalischer Plattformen für die Implementierung künstlicher neuronaler Netze.

Interessanterweise können sogar passive physikalische Dynamiken als Rechenressourcen in zufällig verbundenen KNNs verwendet werden. Bekannt als „Physical Reservoir Computer“ (RC) oder „Extreme Learning Machine“ (ELM), erweitert die einfache Implementierung dieses Frameworks die Auswahl der realisierbaren Materialien und deren Anwendungsbereich erheblich. Solche physikalisch implementierten neuronalen Netze (PNNs) sind in der Lage, aufgabenspezifische Rechenlast auf physikalische Systeme auszulagern.

Der Aufbau tieferer physischer Netzwerke ist eine vielversprechende Richtung zur weiteren Verbesserung der Leistung, da sie die Netzwerkausdrucksfähigkeiten exponentiell erweitern können. Dies motiviert zu Vorschlägen für tiefe PNNs, die verschiedene physische Plattformen nutzen. Ihr Training basiert im Wesentlichen auf einer Methode namens Backpropagation (BP), die bei softwarebasierten KNNs große Erfolge erzielt hat. In den folgenden Aspekten ist BP jedoch nicht für PNN geeignet. Erstens bleibt die physische Implementierung von BP-Operationen komplex und nicht skalierbar. Zweitens erfordert BP ein genaues Verständnis des gesamten physikalischen Systems. Wenn wir BP auf RC anwenden, untergraben diese Anforderungen außerdem die einzigartigen Eigenschaften des physikalischen RC, nämlich dass wir physikalische stochastische Black-Box-Netzwerke genau verstehen und simulieren müssen.

Wie BP in PNN wurde auch die Rationalität von BP im Gehirn immer wieder auf die Schwierigkeit hingewiesen, BP in biologischen neuronalen Netzen zu betreiben. Diese Überlegungen haben zur Entwicklung biologisch fundierter Trainingsalgorithmen geführt.

Eine vielversprechende Richtung in naher Zukunft ist Direct Feedback Alignment (DFA). In diesem Algorithmus wird eine feste zufällige lineare Transformation des endgültigen Fehlersignals der Ausgangsschicht verwendet, um das umgekehrte Fehlersignal zu ersetzen. Daher erfordert diese Methode keine schichtweise Ausbreitung von Fehlersignalen oder Kenntnisse über Gewichte. Darüber hinaus soll DFA auf moderne große Netzwerkmodelle skalierbar sein. Der Erfolg dieses biologisch motivierten Trainings legt nahe, dass es einen geeigneteren Weg gibt, PNN zu trainieren als BP. Allerdings benötigt DFA für das Training immer noch die Ableitung f'(a) der nichtlinearen Funktion f(x), was die Anwendung der DFA-Methode in physikalischen Systemen behindert. Daher ist eine größere Skalierung von DFA für PNN-Anwendungen wichtig.

DFA und seine Erweiterung des physikalischen Deep Learning

Hier demonstrieren Forscher physikalisches Deep Learning durch die Verbesserung des DFA-Algorithmus. Im erweiterten DFA ersetzen wir die Ableitung der physikalischen nichtlinearen Aktivierung f'(a) im Standard-DFA durch ein beliebiges nichtlineares g(a) und zeigen, dass die Leistung gegenüber der Wahl von g(a) robust ist. Aufgrund dieser Verbesserung ist es nicht mehr notwendig, f'(a) genau zu modellieren. Da die vorgeschlagene Methode auf parallelen stochastischen Projektionen mit beliebigen nichtlinearen Aktivierungen basiert, können die Trainingsberechnungen auf physikalischen Systemen auf die gleiche Weise durchgeführt werden wie physikalische ELM- oder RC-Konzepte. Dies ermöglicht eine physische Beschleunigung der Schlussfolgerung und des Trainings.

Abbildung: Konzept von PNN und dessen Training durch BP und Augmented DFA. (Quelle: Papier)

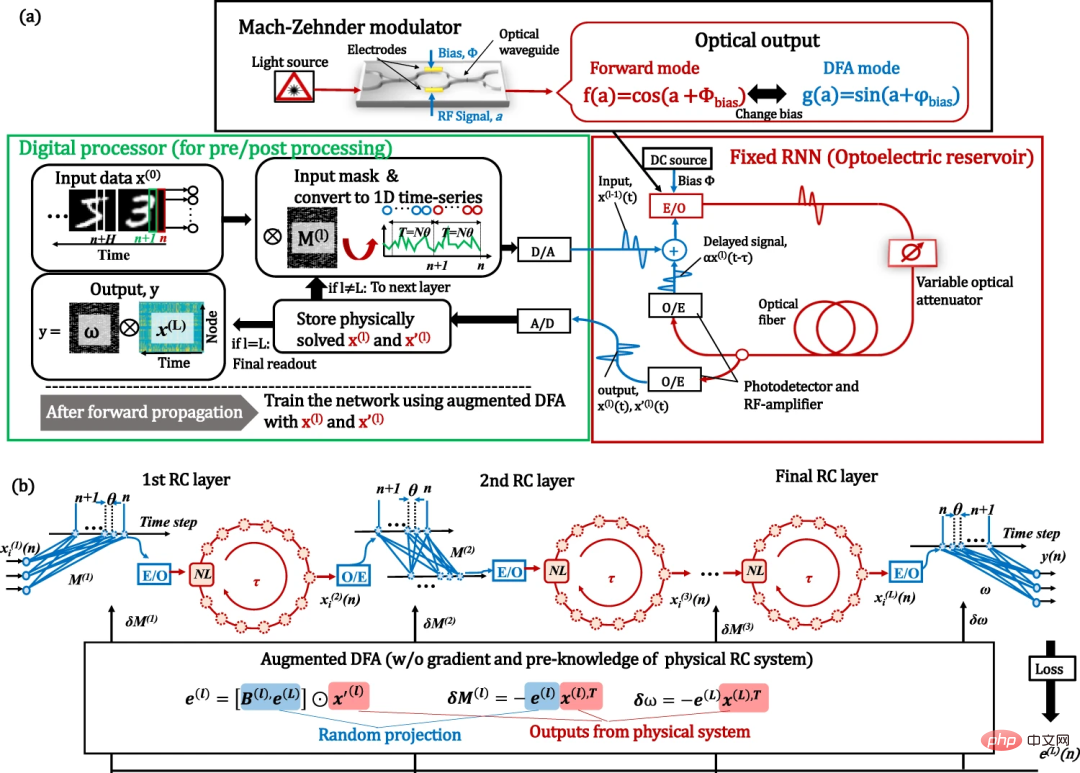

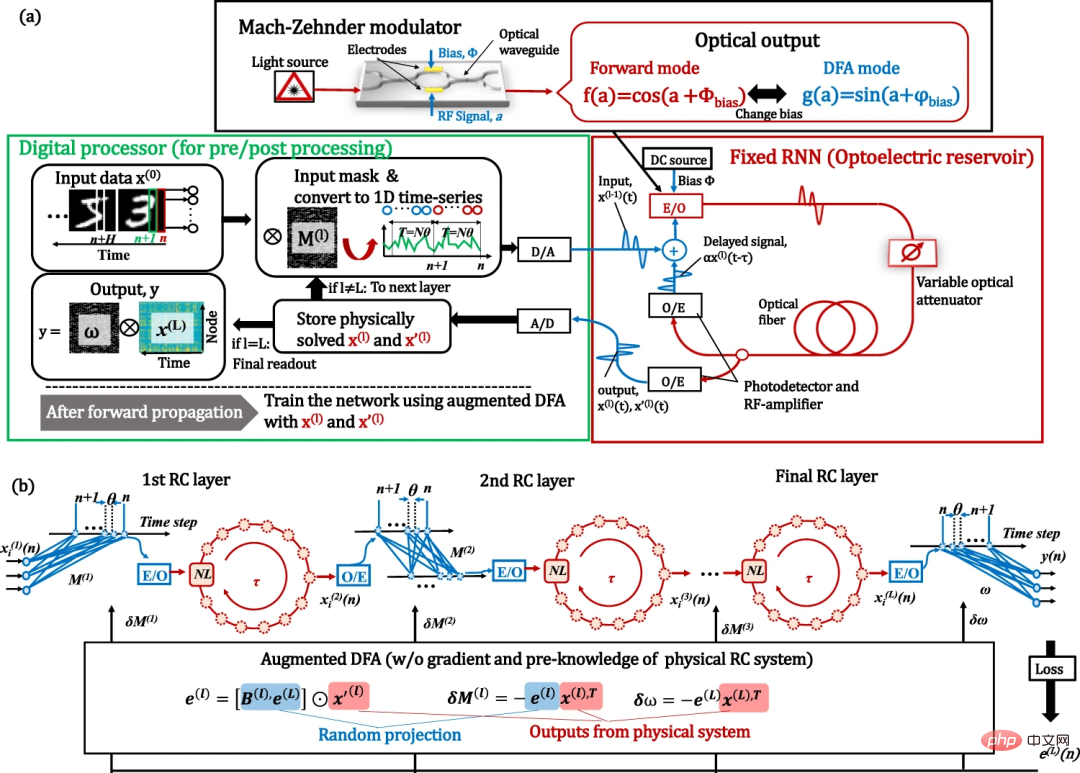

Um den Proof of Concept zu demonstrieren, bauten die Forscher einen FPGA-unterstützten optoelektronischen Deep-Physics-RC als Werkbank. Obwohl Benchtop einfach zu verwenden ist und nur mit Aktualisierungen auf Softwareebene auf eine Vielzahl physischer Plattformen angewendet werden kann, erreicht es eine Leistung, die mit großen und komplexen Systemen auf dem neuesten Stand der Technik vergleichbar ist.

Abbildung: Optoelektronisches Tiefen-RC-System mit erweitertem DFA-Training. (Quelle: Papier)

Darüber hinaus wurde die gesamte Bearbeitungszeit, einschließlich der Zeit der digitalen Verarbeitung, verglichen und die Möglichkeit einer körperlichen Beschleunigung des Trainingsprozesses festgestellt.

Abbildung: Leistung des optoelektronischen Deep-RC-Systems. (Quelle: Paper)

Das Verarbeitungszeitbudget der RC-Bank setzt sich wie folgt zusammen: FPGA-Verarbeitung (Datenübertragung, Speicherzuweisung und DAC/ADC) ~92 % digitale Verarbeitung für Vorverarbeitung/Nachbearbeitung; Verarbeitung. Daher wird die Verarbeitungszeit derzeit von numerischen Berechnungen auf FPGAs und CPUs dominiert. Dies liegt daran, dass die optoelektronische Bank ein Reservoir mit nur einer nichtlinearen Verzögerungsleitung implementiert; diese Einschränkungen könnten durch den Einsatz vollständig paralleler und rein optischer Rechenhardware gelockert werden. Wie man sehen kann, zeigt die Berechnung auf CPU und GPU einen Trend von O(N^2) für die Anzahl der Knoten, während auf dem Tisch O(N) angezeigt wird, was auf den Datenübertragungsengpass zurückzuführen ist.

Physische Beschleunigung außerhalb der CPU wird bei N ~5.000 bzw. ~12.000 für den BP- und den erweiterten DFA-Algorithmus beobachtet. Hinsichtlich der Rechengeschwindigkeit wurde jedoch aufgrund ihrer Speicherbeschränkungen keine direkte Wirksamkeit gegenüber GPUs beobachtet. Durch Extrapolation des GPU-Trends kann bei N ~80.000 eine physikalische Beschleunigung gegenüber der GPU beobachtet werden. Unseres Wissens ist dies der erste Vergleich des gesamten Trainingsprozesses und die erste Demonstration der Beschleunigung des körperlichen Trainings mithilfe von PNNs.

Um die Anwendbarkeit der vorgeschlagenen Methode auf andere Systeme zu untersuchen, wurden numerische Simulationen mit dem umfassend untersuchten photonischen neuronalen Netzwerk durchgeführt. Darüber hinaus hat sich die experimentell nachgewiesene verzögerungsbasierte RC als gut geeignet für verschiedene physikalische Systeme erwiesen. Was die Skalierbarkeit physischer Systeme betrifft, ist das Hauptproblem beim Aufbau tiefer Netzwerke ihr inhärentes Rauschen. Die Auswirkungen von Lärm werden durch numerische Simulationen untersucht. Das System erwies sich als robust gegenüber Rauschen.

Skalierbarkeit und Einschränkungen des vorgeschlagenen Ansatzes

Hier wird die Skalierbarkeit des DFA-basierten Ansatzes auf modernere Modelle betrachtet. Eines der am häufigsten verwendeten Modelle für praktisches Deep Learning ist das Deep Connected Convolutional Neural Network (CNN). Es wurde jedoch berichtet, dass der DFA-Algorithmus schwierig auf Standard-CNNs anzuwenden ist. Daher kann es schwierig sein, die vorgeschlagene Methode auf einfache Weise auf Faltungs-PNNs anzuwenden.

Die Anwendbarkeit auf SNN ist auch ein wichtiges Thema im Hinblick auf die Implementierung der Simulationshardware. Es wurde über die Anwendbarkeit von DFA-basiertem Training auf SNN berichtet, was bedeutet, dass das in dieser Studie vorgeschlagene verbesserte DFA das Training erleichtern kann.

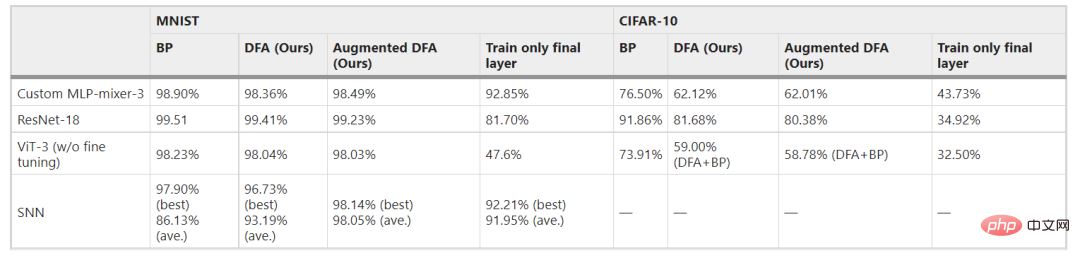

Während DFA-basierte Algorithmen das Potenzial haben, auf praktischere Modelle als einfaches MLP oder RC erweitert zu werden, bleibt die Wirksamkeit der Anwendung von DFA-basiertem Training auf solche Netzwerke unbekannt. Als zusätzliche Arbeit zu dieser Studie wird hier die Skalierbarkeit von DFA-basiertem Training (DFA selbst und erweitertes DFA) auf die oben genannten Modelle (MLP-Mixer, Vision Transformer (ViT), ResNet und SNN) untersucht. Auch für explorative Praxismodelle erwies sich das DFA-basierte Training als wirksam. Obwohl die erreichbare Genauigkeit des DFA-basierten Trainings wesentlich geringer ist als die des BP-Trainings, können einige Anpassungen des Modells und/oder des Algorithmus die Leistung verbessern. Bemerkenswert ist, dass die Genauigkeit von DFA und erweiterter DFA für alle untersuchten experimentellen Einstellungen vergleichbar war, was darauf hindeutet, dass weitere Verbesserungen von DFA selbst direkt zur Verbesserung von erweiterter DFA beitragen werden. Die Ergebnisse zeigen, dass die Methode über einfache MLP- oder RC-Modelle hinaus auf zukünftige Implementierungen praktischer PNN-Modelle ausgeweitet werden kann.

Tabelle 1: Anwendbarkeit von erweiterter DFA auf reale Netzwerkmodelle. (Quelle: Papier)

BP vs. DFA in physischer Hardware

Im Allgemeinen ist BP sehr schwierig auf physischer Hardware zu implementieren, da dafür alle Informationen im Diagramm berechnet werden müssen. Daher wurde das Training auf physischer Hardware immer durch Computersimulationen durchgeführt, was hohe Rechenkosten verursacht. Darüber hinaus führen Unterschiede zwischen Modell und tatsächlichem System zu einer verringerten Genauigkeit. Im Gegensatz dazu erfordert erweiterte DFA keine genauen Vorkenntnisse über das physikalische System. Daher sind DFA-basierte Methoden in tiefen PNN hinsichtlich der Genauigkeit effektiver als BP-basierte Methoden. Darüber hinaus kann physische Hardware zur Beschleunigung von Berechnungen eingesetzt werden.

Darüber hinaus erfordert das DFA-Training keine sequentielle Fehlerausbreitung, die Schicht für Schicht berechnet wird, was bedeutet, dass das Training jeder Schicht parallel durchgeführt werden kann. Daher kann eine optimiertere und parallelere DFA-Implementierung zu deutlicheren Geschwindigkeitssteigerungen führen. Diese einzigartigen Eigenschaften belegen die Wirksamkeit DFA-basierter Methoden, insbesondere für neuronale Netze, die auf physischer Hardware basieren. Andererseits ist die Genauigkeit des verbesserten DFA-trainierten Modells immer noch schlechter als die des BP-trainierten Modells. Die weitere Verbesserung der Genauigkeit des DFA-basierten Trainings bleibt zukünftige Arbeit.

Weitere physikalische Beschleunigung

Die physikalische Implementierung demonstriert die Beschleunigung der RC-Schleifenverarbeitung mit großen Knotenzahlen. Die Vorteile sind jedoch noch begrenzt und weitere Verbesserungen sind erforderlich. Die Verarbeitungszeit des aktuellen Prototyps wird als Datenübertragung und Speicherzuweisung zum FPGA ausgedrückt. Daher führt die Integration aller Prozesse in ein FPGA zu einer erheblichen Leistungssteigerung auf Kosten der experimentellen Flexibilität. Darüber hinaus werden luftgestützte optische Verfahren in Zukunft die Übertragungskosten deutlich senken. Die groß angelegte optische Integration und die On-Chip-Integration werden die Leistung des optischen Rechnens selbst weiter verbessern.

Das obige ist der detaillierte Inhalt vonPhysisches Deep Learning mit biologisch inspirierten Trainingsmethoden: Ein Gradienten-freier Ansatz für physische Hardware. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr