Heim >Technologie-Peripheriegeräte >KI >Natur: Sind größere KI-Modelle besser?

Natur: Sind größere KI-Modelle besser?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 09:01:021745Durchsuche

Generative KI-Modelle werden heutzutage immer größer. Bedeutet größer also besser?

Nein. Nun schlagen einige Wissenschaftler schlankere, energieeffizientere Systeme vor.

Artikeladresse: https://www.nature.com/articles/d41586-023-00641-w

Kann das Sprachmodell der Mathematik nicht herausfinden

Der jüngste Liebling der ChatGPT aus der Technologiebranche ist angesichts der Tatsache, dass die Leistung bei mathematischen Fragen, deren Beantwortung eine Begründung erfordert, tendenziell schlecht.

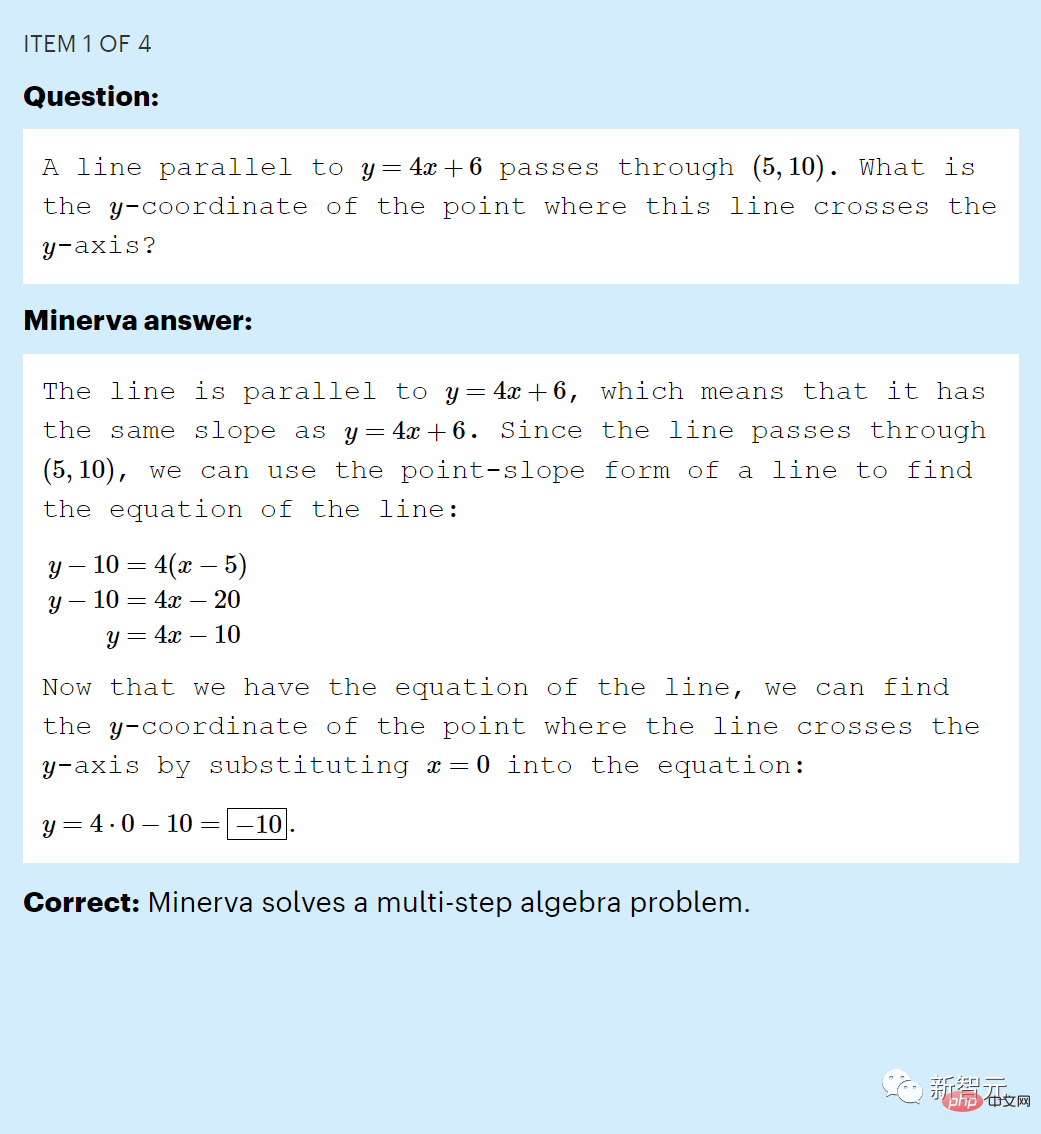

Zum Beispiel wird diese Frage „Eine gerade Linie parallel zu y = 4 x + 6 geht durch (5, 10). Was ist die y-Koordinate des Schnittpunkts dieser Linie und der y-Achse?“ oft nicht beantwortet korrekt.

In einem frühen Test der Denkfähigkeit erreichte ChatGPT bei der Beantwortung einer Stichprobe des MATH-Datensatzes auf Mittelschulniveau nur 26 (%).

Das haben wir natürlich erwartet. Angesichts des Eingabetextes generiert ChatGPT nur neuen Text basierend auf den statistischen Regeln von Wörtern, Symbolen und Sätzen im Trainingsdatensatz.

Natürlich ist es für ein Sprachmodell unmöglich, durch einfaches Erlernen eines Sprachmodells zu lernen, mathematisches Denken zu imitieren.

Aber tatsächlich hatte das von Google erstellte große Sprachmodell namens Minerva bereits im Juni 2022 diesen „Fluch“ gebrochen.

Minerva erreichte bei den Fragen im MATH-Datensatz (2) 50 %, ein Ergebnis, das die Forscher schockierte.

Minerva hat eine Mathematikaufgabe der Mittelschule im Datensatz „MATH“ richtig beantwortet

Sébastien Bubeck, Experte für maschinelles Lernen bei Microsoft Research, sagte, dass die Leute in der Branche schockiert seien und darüber gesprochen hätten.

Der Vorteil von Minerva ist natürlich, dass es auf mathematische Texte trainiert wird.

Aber Googles Untersuchungen legen einen weiteren wichtigen Grund für die gute Leistung des Modells nahe – seine schiere Größe. Es ist ungefähr dreimal so groß wie ChatGPT.

Die Ergebnisse von Minerva deuten auf etwas hin, was einige Forscher schon lange vermutet haben: Das Training größerer LLMs und die Bereitstellung von mehr Daten können sie in die Lage versetzen, Aufgaben zu lösen, die sonst Rückschlüsse allein durch Mustererkennung erfordern würden.

Wenn das der Fall ist, könnten Forscher sagen, dass diese „Größer ist besser“-Strategie einen Weg zu leistungsstarker künstlicher Intelligenz ebnen könnte.

Aber dieses Argument ist offensichtlich fragwürdig.

LLM macht immer noch offensichtliche Fehler, und einige Wissenschaftler glauben, dass größere Modelle nur besser darin werden, Anfragen innerhalb des relevanten Bereichs der Trainingsdaten zu beantworten, und nicht die Fähigkeit erlangen, völlig neue Fragen zu beantworten.

Diese Debatte über die Grenzen der künstlichen Intelligenz ist derzeit in vollem Gange.

Kommerzielle Unternehmen haben erkannt, dass sie mit größeren KI-Modellen bessere Ergebnisse erzielen können, und führen daher immer größere LLMs ein, deren Schulung und Betrieb jeweils Millionen von Dollar kosten.

Aber diese Modelle haben große Nachteile. Abgesehen davon, dass ihre Ergebnisse misstrauisch sein können und dadurch die Verbreitung von Fehlinformationen befeuern, sind sie einfach zu teuer und verbrauchen viel Energie.

Rezensenten glauben, dass große LLMs niemals in der Lage sein werden, die Fähigkeiten nachzuahmen oder zu erwerben, die es ihnen ermöglichen, Inferenzfragen konsistent zu beantworten.

Stattdessen sagen einige Wissenschaftler, dass Fortschritte mit kleinerer, energieeffizienterer KI erzielt werden, eine Ansicht, die teilweise von der Art und Weise inspiriert ist, wie das Gehirn lernt und Verbindungen herstellt.

Ist ein größeres Modell besser?

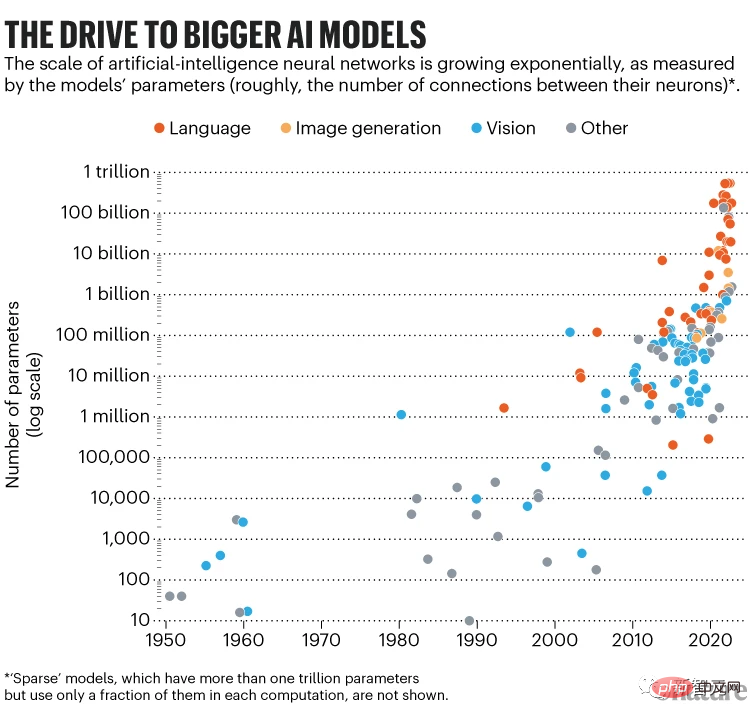

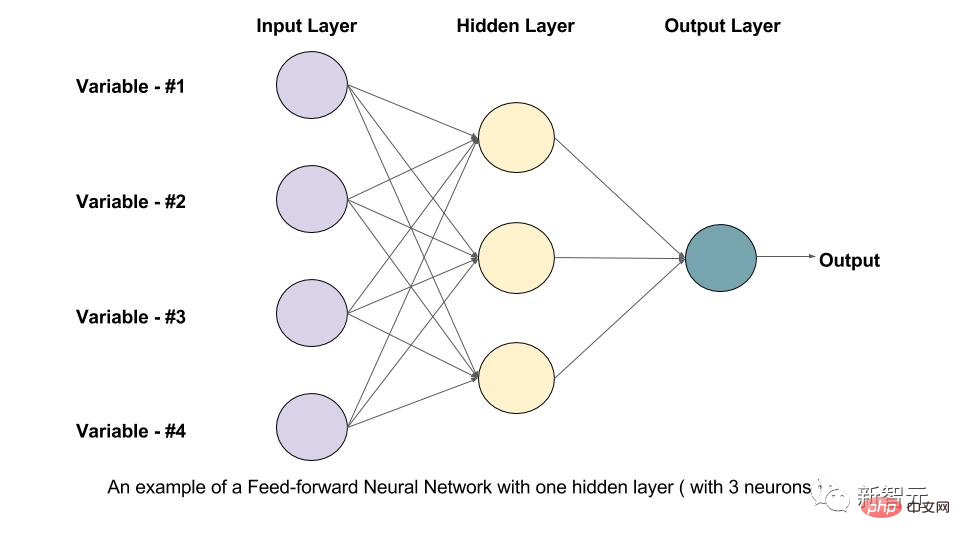

Große Sprachmodelle wie ChatGPT und Minerva sind riesige Netzwerke hierarchisch angeordneter Recheneinheiten (auch künstliche Neuronen genannt).

Die Größe eines LLM wird daran gemessen, wie viele Parameter es hat, und die Anzahl der Parameter beschreibt die einstellbaren Werte der Verbindungsstärke zwischen Neuronen.

Um ein solches Netzwerk zu trainieren, müssen Sie es bitten, den maskierten Teil eines bekannten Satzes vorherzusagen und diese Parameter anzupassen, damit der Algorithmus beim nächsten Mal besser abschneidet.

Wiederholen Sie diesen Vorgang für Milliarden von Menschen geschriebener Sätze, und das neuronale Netzwerk lernt interne Darstellungen, die die Art und Weise nachahmen, wie Menschen Sprache schreiben.

Zu diesem Zeitpunkt gilt das LLM als vortrainiert: Seine Parameter erfassen die statistische Struktur der geschriebenen Sprache, die es während des Trainings gesehen hat, einschließlich aller Fakten, Vorurteile und Fehler im Text. Anschließend kann auf der Grundlage spezieller Daten eine „Feinabstimmung“ vorgenommen werden.

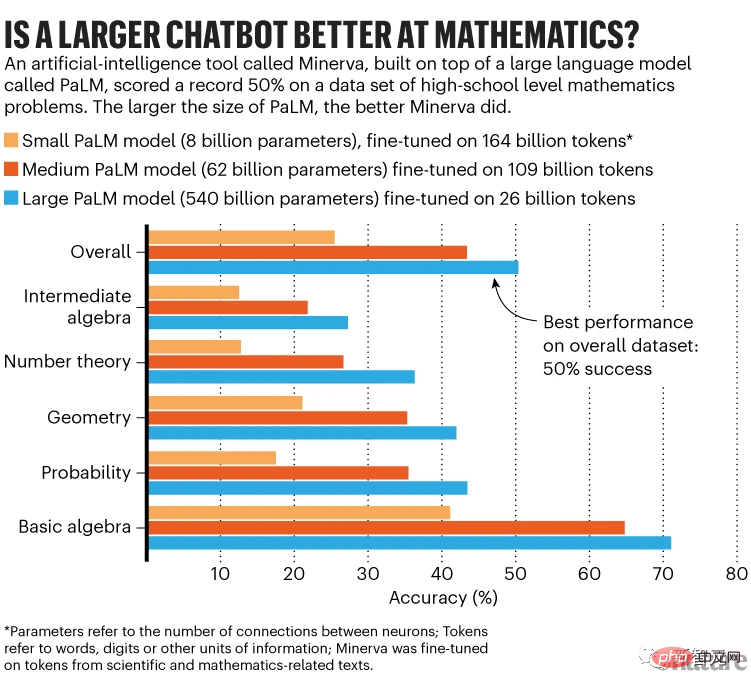

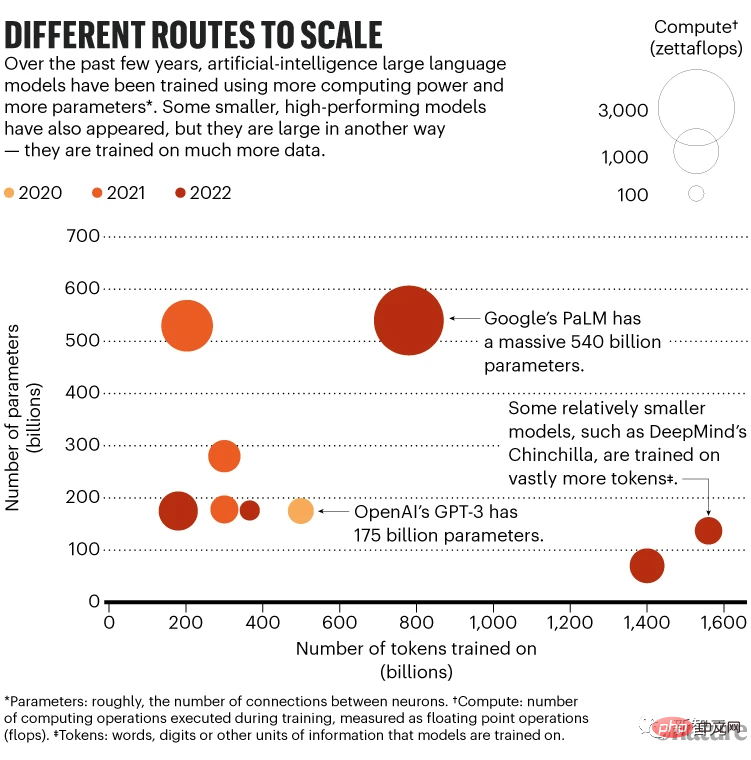

Um beispielsweise Minerva zu erstellen, begannen die Forscher mit dem Pathways Language Model (PaLM) von Google, das 540 Milliarden Parameter hat und anhand eines Datensatzes von 780 Milliarden Token vorab trainiert wurde.

Token kann ein Wort, eine Zahl oder eine Informationseinheit sein; im Fall von PaLM werden Token aus englischen und mehrsprachigen Webdokumenten, Büchern und Code gesammelt. Minerva ist das Ergebnis der Feinabstimmung von Dutzenden Milliarden Token aus wissenschaftlichen Arbeiten und mathematischen Webseiten durch PaLM.

Minerva kann Fragen beantworten wie „Was ist das größte Vielfache von 30, das kleiner als 520 ist?“

LLM scheint in Schritten zu denken, aber alles, was es tut, ist, das Problem in eine Sequenz von Tokens umzuwandeln, einen statistisch sinnvollen nächsten Token zu generieren, ihn an die ursprüngliche Sequenz anzuhängen, einen weiteren Token zu generieren usw. Dieser Vorgang wird als Argumentation bezeichnet.

Google-Forscher haben Minerva mithilfe des zugrunde liegenden vorab trainierten PaLM-Modells mit 8 Milliarden, 62 Milliarden und 540 Milliarden Parametern in drei Größen verfeinert. Die Leistung von Minerva verbessert sich mit zunehmender Größe.

Im gesamten MATH-Datensatz beträgt die Genauigkeit des kleinsten Modells 25 %, das mittlere Modell erreicht 43 % und das größte Modell überschreitet die 50 %-Marke.

Das größte Modell verwendete auch die Daten mit der geringsten Feinabstimmung – es wurde nur auf 26 Milliarden Token feinabgestimmt, während das kleinste Modell auf 164 Milliarden Token feinabgestimmt wurde.

Aber die Feinabstimmung des größten Modells dauerte einen Monat, und die Rechenleistung der speziellen Hardware war achtmal so hoch wie die des kleinsten Modells, dessen Feinabstimmung nur zwei Wochen dauerte.

Idealerweise sollten die größten Modelle auf mehr Token abgestimmt werden. Ethan Dyer, Mitglied des Minerva-Teams bei Google Research, sagte, dies hätte zu einer besseren Leistung führen können. Das Team hielt es jedoch nicht für machbar, die Kosten zu berechnen.

Skalierungseffekt

Die größten Minerva-Modelle schneiden am besten ab, was im Einklang mit der Forschung zu Skalierungsgesetzen steht – Gesetzen, die bestimmen, wie sich die Leistung mit zunehmender Modellgröße verbessert.

Eine Studie aus dem Jahr 2020 zeigte, dass Modelle eine bessere Leistung erbringen, wenn ihnen eines von drei Dingen gegeben wird: mehr Parameter, mehr Trainingsdaten oder mehr „Berechnungen“ (die Anzahl der während des Trainings durchgeführten Rechenoperationen).

Die Leistung skaliert nach einem Potenzgesetz, das heißt, sie verbessert sich mit zunehmender Anzahl von Parametern.

Dennoch wissen Forscher nicht, warum. „Diese Gesetze sind rein empirischer Natur“, sagt Irina Rish, Informatikerin am Mila-Quebec Institute for Artificial Intelligence der Universität Montreal in Kanada.

Um optimale Ergebnisse zu erzielen, deuten Untersuchungen aus dem Jahr 2020 darauf hin, dass sich die Modellgröße verfünffachen sollte, wenn sich die Trainingsdaten verdoppeln. Dies wurde gegenüber der Arbeit des letzten Jahres leicht geändert.

Im März dieses Jahres war DeepMind davon überzeugt, dass es am besten ist, sowohl die Modellgröße als auch die Trainingsdaten zu erweitern, und dass kleinere Modelle, die mit mehr Daten trainiert wurden, eine bessere Leistung erbringen als größere Modelle, die mit weniger Daten trainiert wurden.

Zum Beispiel hat das Chinchilla-Modell von DeepMind 70 Milliarden Parameter und wird auf 1,4 Billionen Token trainiert, während das Gopher-Modell mit 280 Milliarden Parametern auf 300 Milliarden Token trainiert wird. In späteren Bewertungen übertraf Chinchilla Gopher.

Im Februar bauten Meta-Wissenschaftler auf der Grundlage dieses Konzepts ein kleines Parametermodell namens LLaMA auf, das auf bis zu 1,4 Billionen Token trainiert wurde.

Forscher sagen, dass die 13-Milliarden-Parameter-Version von LLaMA besser ist als ChatGPTs Vorgänger GPT-3 (175 Milliarden Parameter), während die 65-Milliarden-Parameter-Version wettbewerbsfähiger als Chinchilla oder sogar PaLM ist.

Letzten Oktober berichteten Ethan Caballero von der McGill University in Montreal, Rish und andere, dass sie einen komplexeren Zusammenhang zwischen Skalierung und Leistung entdeckt hatten – in einigen Fällen können mehrere Potenzgesetze steuern, wie die Leistung mit einer Änderung der Modellgröße skaliert.

In einem hypothetischen Szenario der Anpassung einer allgemeinen Gleichung verbessert sich beispielsweise die Leistung zunächst allmählich und dann mit der Größe des Modells schneller. Mit zunehmender Anzahl von Parametern nimmt die Leistung jedoch leicht ab und steigt dann wieder an. Die Merkmale dieser komplexen Beziehung hängen von den Details jedes Modells und davon ab, wie es trainiert wurde.

Letztendlich hoffen die Forscher, im Voraus vorhersagen zu können, wann ein bestimmtes LLM skaliert werden wird.

Eine separate theoretische Entdeckung unterstützt auch das Streben nach größeren Modellen – das „Robustheitsgesetz“ des maschinellen Lernens, das 2021 von Bubeck und Kollegen vorgeschlagen wurde.

Ein Modell ist robust, wenn seine Antworten trotz kleiner Störungen in seiner Eingabe konsistent bleiben.

Und Bubeck und Kollegen haben mathematisch nachgewiesen, dass eine Erhöhung der Anzahl der Parameter in einem Modell die Robustheit und damit die Generalisierungsfähigkeit erhöht.

Bubeck sagte, dass eine regelmäßige Beweisskalierung notwendig, aber für eine Verallgemeinerung nicht ausreichend sei. Dennoch wurde es als Rechtfertigung für den Wechsel zu einem größeren Modell herangezogen. „Ich denke, das ist eine vernünftige Sache.“

Minerva nutzt auch eine Schlüsselinnovation namens Thought Chain Prompts. Der Benutzer stellt der Frage einen Text voran, der mehrere Beispiele des Problems und der Lösung sowie eine Begründung enthält, die zur Antwort führt (dies ist eine klassische Gedankenkette).

Während der Argumentation greift LLM Hinweise aus diesem Kontext auf und liefert eine Schritt-für-Schritt-Antwort, die wie Argumentation aussieht.

Dies erfordert keine Aktualisierung der Parameter des Modells und erfordert daher nicht die zusätzliche Rechenleistung, die für die Feinabstimmung erforderlich ist.

Die Fähigkeit, auf Eingabeaufforderungen der Gedankenkette zu reagieren, gibt es nur im LLM mit über 100 Milliarden Parametern.

Blaise Agüera y Arcas von Google Research sagte, dass diese Erkenntnisse dabei helfen, größere Modelle auf der Grundlage empirischer Skalierungsgesetze zu verbessern. „Größere Modelle werden besser.“

Berechtigte Sorge

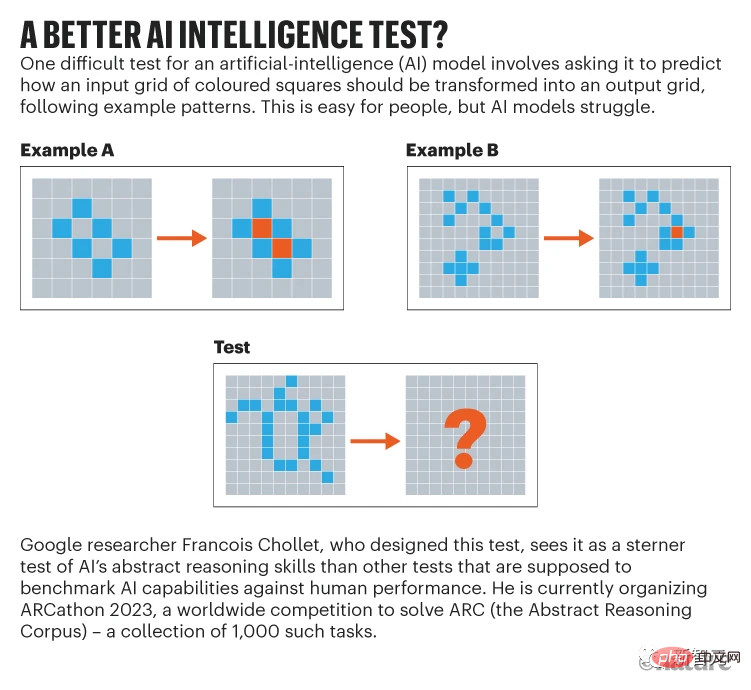

François Chollet, ein KI-Forscher bei Google, ist einer der Skeptiker, die glauben, dass LLMs, egal wie groß sie werden, nie gut genug sein werden (oder das Denken nachahmen), um neue Probleme zuverlässig zu lösen.

Er sagte, dass LLM offenbar nur durch die Verwendung von Vorlagen argumentiert, auf die es zuvor gestoßen ist, entweder in den Trainingsdaten oder in den Eingabeaufforderungen. „Es kann nicht sofort etwas verstehen, was es noch nicht gesehen hat.“

Vielleicht ist das Beste, was LLM tun kann, so viele Trainingsdaten zu absorbieren, dass die statistischen Muster der Sprache selbst es ihnen ermöglichen, etwas zu verwenden, das dem Sehen sehr nahe kommt , um die Frage zu beantworten.

Allerdings glaubt Agüera y Arcas, dass LLMs offenbar einige Fähigkeiten erwerben, für die sie nicht speziell ausgebildet wurden, was überraschend ist.

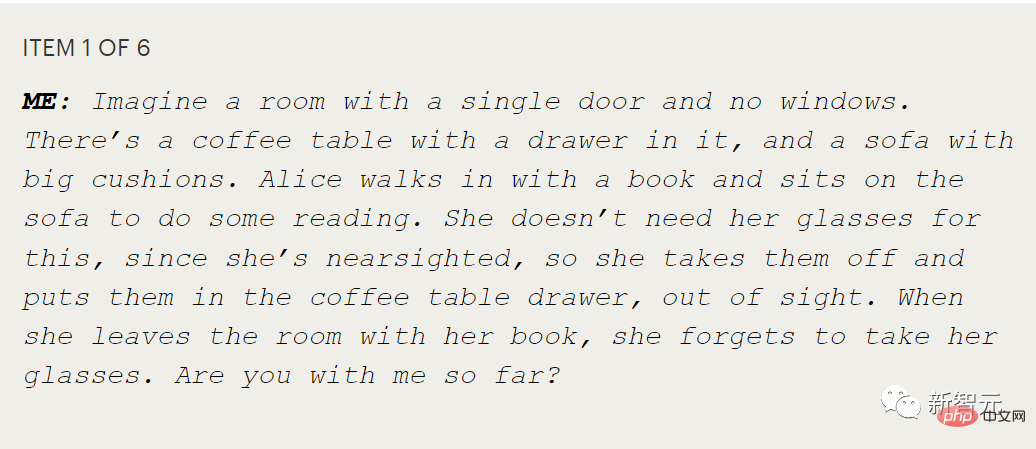

Vor allem Tests, die zeigen, ob eine Person über die sogenannte Theorie des Geistes verfügt, also die Fähigkeit, die mentalen Zustände anderer zu theoretisieren oder zu messen.

Zum Beispiel legt Alice ihre Brille in eine Schublade und Bob versteckt sie dann unter einem Kissen, ohne dass Alice es merkt. Wo würde Alice zuerst hingehen, um ihre Brille zu finden?

Wenn man einem Kind diese Frage stellt, soll man testen, ob es versteht, dass Alice ihre eigenen Überzeugungen hat, die möglicherweise nicht mit dem übereinstimmen, was das Kind weiß.

Agüera y Arcas Bei seinen Tests von LaMDA, einem weiteren LLM von Google, stellte er fest, dass LaMDA in dieser Art längerer Konversation richtig reagierte.

Für ihn zeigt dies, dass LLM die Fähigkeit besitzt, die Absichten anderer intern zu simulieren.

Agüera y Arcas sagte: „Diese Modelle, die nichts anderes tun, als Sequenzen vorherzusagen, haben eine Reihe außergewöhnlicher Fähigkeiten entwickelt, einschließlich der Theorie des Geistes.“

Aber er gibt zu, dass diese Modelle fehleranfällig sind, und er ist sich nicht sicher Das allein kann sich ändern. Reicht der Maßstab für eine zuverlässige Schlussfolgerung aus, obwohl dies notwendig erscheint?

Blaise Agüera y Arcas von Google Research hat über sein Gespräch mit LaMDA gebloggt Die beiden Gesprächspartner in der Geschichte „Wissen“ und „Nicht wissen“ sind eindeutig eine Parodie auf die Theorie des Geistes

Doch selbst wenn LLM die Antwort richtig verstanden hat, geht es nicht ums Verstehen

„Wenn du Wenn man ein wenig hineinschaut, sieht man sofort, dass ChatGPT kein Modell dafür hat, wovon es spricht. Es ist, als würde man sich ein Puppenspiel ansehen und glauben, dass die Puppen leben. Bislang macht LLM immer noch lächerliche Fehler die Menschen niemals schaffen würden, sagt Melanie Mitchell. Sie studiert konzeptionelle Abstraktion und Analogie in Systemen der künstlichen Intelligenz am Santa Fe Institute.

Dies wirft Bedenken auf, ob es sicher ist, LLM ohne Leitplanken in die Gesellschaft einzuführen.

Mitchell fügte hinzu, dass ein Problem bei der Frage, ob LLM wirklich neue, ungesehene Probleme lösen kann, darin besteht, dass wir diese Fähigkeit nicht vollständig testen können.

„Unsere aktuellen Benchmarks reichen nicht aus“, sagte sie. „Sie erforschen Dinge nicht systematisch. Wir wissen noch nicht, wie man das macht.“

Probleme aufgrund der Skalierung

Aber das Problem besteht darin, dass die Datensätze, die Rechenleistung und die Kosten, die mit dem Training großer Sprachmodelle verbunden sind, ihre Entwicklung einschränken. Derzeit ist dies nur Unternehmen mit extrem großen Rechenressourcen möglich.

In der Folge haben Regierungen verschiedener Länder begonnen einzugreifen, in der Hoffnung, ihre Vorteile in diesem Bereich auszubauen.

Im Juni letzten Jahres investierte ein internationales Team aus etwa 1.000 akademischen Freiwilligen mit finanzieller Unterstützung der französischen Regierung, Hugging Face und anderen Institutionen Rechenzeit im Wert von 7 Millionen US-Dollar, um das BLOOM-Modell mit 176 Milliarden Parametern zu trainieren.

Im November hat das US-Energieministerium auch sein eigenes Supercomputing für ein großes Forschungsmodellprojekt lizenziert. Es heißt, dass das Team plant, ein 70-Milliarden-Parameter-Modell ähnlich wie Chinchilla zu trainieren.

Aber egal, wer das Training durchführt, der Stromverbrauch von LLM ist nicht zu unterschätzen.Google gab an, dass das Training von PaLM über einen Zeitraum von etwa zwei Monaten etwa 3,4 Gigawattstunden in Anspruch nahm, was dem Energieverbrauch von etwa 300 US-Haushalten in einem Jahr entspricht.

Obwohl Google behauptet, dass 89 % seines Verbrauchs aus sauberer Energie besteht, zeigt eine Umfrage in der gesamten Branche, dass die meisten Schulungen Stromnetze nutzen, die hauptsächlich mit fossilen Brennstoffen betrieben werden.

Kleiner und intelligenter?

Aus dieser Perspektive müssen Forscher dringend den Energieverbrauch von LLM reduzieren – um neuronale Netze kleiner, effizienter und vielleicht intelligenter zu machen.

Zusätzlich zu den Energiekosten für das LLM-Training (obwohl es erheblich, aber auch einmalig ist) steigt der Energieaufwand für die Inferenz mit zunehmender Benutzerzahl. Beispielsweise beantwortete das BLOOM-Modell in den 18 Tagen, in denen es auf der Google Cloud Platform bereitgestellt wurde, insgesamt 230.768 Anfragen mit einer durchschnittlichen Leistung von 1.664 Watt.

Im Vergleich dazu ist unser eigenes Gehirn viel komplexer und größer als jedes LLM, mit 86 Milliarden Neuronen und etwa 100 Billionen synaptischen Verbindungen, aber nur etwa 20 bis 50 Watt Leistung.

Einige Forscher hoffen daher, durch die Nachahmung des Gehirns die Vision verwirklichen zu können, Modelle kleiner, intelligenter und effizienter zu machen.

Im Wesentlichen ist LLM ein „Feedforward“-Netzwerk, was bedeutet, dass Informationen in eine Richtung fließen: von der Eingabe über die Schichten des LLM bis zur Ausgabe.

Aber das Gehirn ist nicht so. Beispielsweise verfügen Neuronen im menschlichen visuellen System zusätzlich zur Weiterleitung empfangener Informationen an das Gehirn auch über Rückkopplungsverbindungen, die die Übertragung von Informationen in die entgegengesetzte Richtung zwischen Neuronen ermöglichen. Es können zehnmal so viele Rückkopplungsverbindungen vorhanden sein wie Feedforward-Verbindungen.

In künstlichen neuronalen Netzen umfassen Recurrent Neural Networks (RNN) auch sowohl Feedforward- als auch Feedback-Verbindungen. Im Gegensatz zu LLMs, die nur über Feedforward-Netzwerke verfügen, können RNNs Muster in Daten im Zeitverlauf erkennen. Allerdings sind RNNs schwer zu trainieren und langsam, was es schwierig macht, sie auf die Größe von LLMs zu skalieren.

Derzeit haben einige Studien mit kleinen Datensätzen gezeigt, dass RNNs mit Spiking-Neuronen Standard-RNNs übertreffen können und theoretisch drei Größenordnungen recheneffizienter sind.

Solange solche Spike-Netzwerke jedoch in der Software simuliert werden, können sie keine wirklichen Effizienzsteigerungen erzielen (da die Hardware, die sie simuliert, immer noch Energie verbraucht).

Mittlerweile experimentieren Forscher mit verschiedenen Methoden, um bestehende LLMs energieeffizienter zu machen.

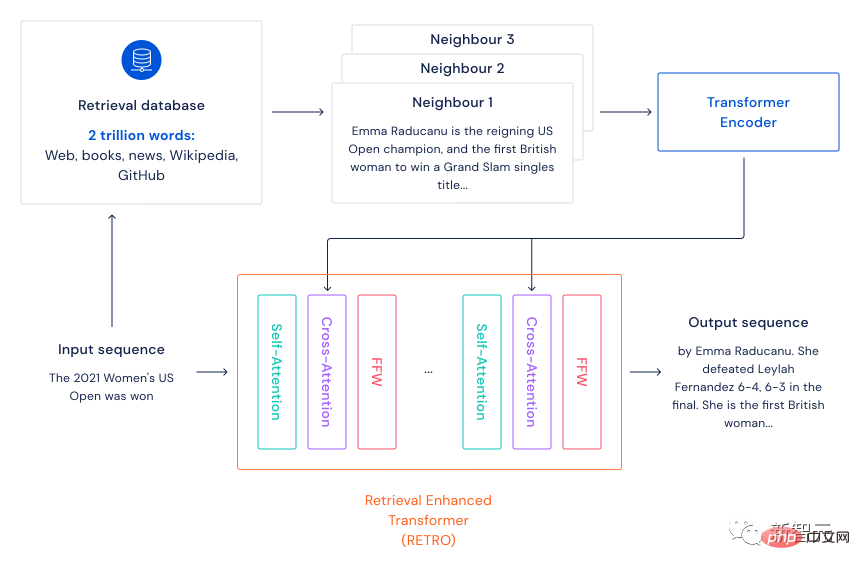

Im Dezember 2021 schlug DeepMind das abrufbasierte Sprachmodell-Framework Retro vor.

Retro imitiert hauptsächlich den Mechanismus des Gehirns, beim Lernen nicht nur aktuelles Wissen zu nutzen, sondern auch Erinnerungen abzurufen. Sein Rahmen besteht darin, zunächst einen großen Textdatensatz vorzubereiten (der als Gedächtnis des Gehirns fungiert) und dann den kNN-Algorithmus zu verwenden, um die n nächsten Nachbarsätze des Eingabesatzes zu finden (Abrufspeicher).

Nach der Codierung des Eingabesatzes und des abgerufenen Satzes durch Transformer wird dann Cross-Attention durchgeführt, sodass das Modell gleichzeitig die Informationen im Eingabesatz und die Speicherinformationen verwenden kann, um verschiedene NLP-Aufgaben auszuführen.

In der Vergangenheit diente die große Anzahl von Parametern des Modells hauptsächlich dazu, die Informationen in den Trainingsdaten zu bewahren. Wenn dieses auf Abruf basierende Framework verwendet wird, kann die Anzahl der Parameter des Modells mehr Textinformationen enthalten Da es besonders groß ist, beschleunigt es natürlich den Betrieb des Modells, ohne zu viel Leistung zu verlieren.

Diese Methode kann auch beim Modelltraining Stromkosten sparen. Den umweltfreundlichen Mädchen gefiel es, nachdem sie es gesehen hatten!

Experimentelle Ergebnisse zeigen, dass ein großes Sprachmodell mit 7,5 Milliarden Parametern plus einer Datenbank mit 2 Billionen Token ein Modell mit 25-mal mehr Parametern übertreffen kann. Die Forscher schreiben, dass dies ein „effizienterer Ansatz als die Skalierung von Rohparametern ist, da wir versuchen, leistungsfähigere Sprachmodelle zu erstellen.“

Im selben Monat schlugen Forscher bei Google eine weitere Möglichkeit vor, die Energieeffizienz im großen Maßstab zu verbessern.

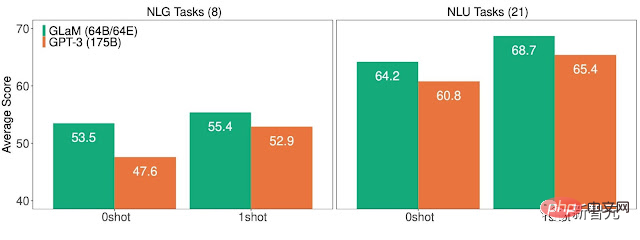

Dieses spärliche allgemeine Sprachmodell GLaM mit 1,2 Billionen Parametern verfügt intern über 64 kleinere neuronale Netze.

Während des Inferenzprozesses verwendet das Modell nur zwei Netzwerke, um die Aufgabe abzuschließen. Mit anderen Worten: Von mehr als einer Billion Parametern werden nur etwa 8 % genutzt.

Google sagte, dass GLaM die gleichen Rechenressourcen nutzt, die für das Training von GPT-3 erforderlich sind, aber aufgrund von Verbesserungen bei der Trainingssoftware und -hardware beträgt der Energieverbrauch nur 1/3 des letzteren. Die für die Inferenz erforderlichen Rechenressourcen sind halb so hoch wie die von GPT-3. Darüber hinaus schneidet GLaM besser ab als GPT-3, wenn es mit der gleichen Datenmenge trainiert wird.

Für weitere Verbesserungen scheinen jedoch selbst diese energieeffizienteren LLMs dazu bestimmt zu sein, größer zu werden und mehr Daten und Berechnungen zu verbrauchen.

Referenz:

https://www.nature.com/articles/d41586-023-00641-w

Das obige ist der detaillierte Inhalt vonNatur: Sind größere KI-Modelle besser?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr