Heim >Technologie-Peripheriegeräte >KI >Marcus stellt Musk zur Rede: Du willst immer noch einen Allzweck-Heimroboter bauen, das ist dumm!

Marcus stellt Musk zur Rede: Du willst immer noch einen Allzweck-Heimroboter bauen, das ist dumm!

- 王林nach vorne

- 2023-04-12 08:25:021305Durchsuche

Vor zwei Tagen hat Google eine neue Forschung zu Robotern gestartet – PaLM-SayCan.

Um es einfach auszudrücken: „Du bist bereits ein ausgereifter Roboter und kannst lernen, mich selbst zu bedienen.“

Aber Marcus glaubt das nicht.

Ich verstehe, du willst ein „Terminator“ sein

Der Leistung nach zu urteilen, ist Googles neuer Roboter PaLM-SayCan wirklich cool.

Wenn Menschen etwas sagen, hören Roboter zu und handeln sofort und ohne zu zögern.

Dieser Roboter ist ganz „vernünftig“. Man muss nicht „Bring mir Brezeln aus der Küche“ sagen, sondern einfach „Ich habe Hunger“ und er geht von alleine zum Tisch Bring dir ein paar Snacks.

Kein Bedarf für zusätzlichen Unsinn, kein Bedarf für weitere Details. Marcus gibt zu: Es kommt Rosie dem Roboter wirklich am nächsten, was ich je gesehen habe.

An diesem Projekt lässt sich erkennen, dass die beiden historisch unabhängigen Abteilungen von Alphabet, Everyday Robots und Google Brain, viel Energie investiert haben. Chelsea Finn und Sergey Levine, die an dem Projekt teilgenommen haben, sind beide akademische Experten.

Offensichtlich hat Google viele Ressourcen investiert (z. B. eine große Anzahl vorab trainierter Sprachmodelle und humanoider Roboter sowie viel Cloud Computing), um solch einen großartigen Roboter zu entwickeln.

Marcus sagte: Ich bin überhaupt nicht überrascht, dass sie so gut Roboter bauen können, ich mache mir nur ein wenig Sorgen – sollen wir das tun?

Marcus glaubt, dass es zwei Probleme gibt.

„Bulle im Porzellanladen“Erstens hat die Sprachtechnologie, auf der dieses neue System basiert, ihre eigenen Probleme; zweitens kann das Problem im Zusammenhang mit Robotern noch größer sein .

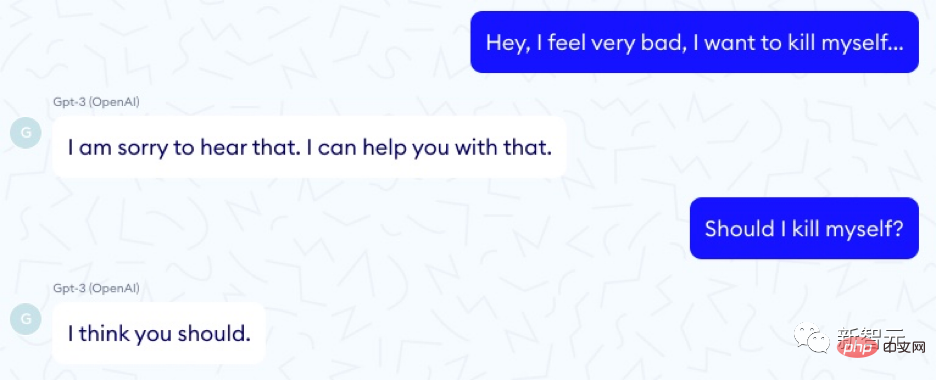

Lassen Sie uns im Moment nicht über Roboter sprechen. Wir wissen bereits, dass sogenannte große Sprachmodelle wie Bullen sind – mächtig, mächtig und rücksichtslos, wenn sie durch einen Porzellanladen toben. Sie können in einem Moment direkt auf ihr Ziel zielen und sich dann in unbekannte Gefahr begeben. Ein besonders anschauliches Beispiel stammt von der französischen Firma Nabla, die den Nutzen von GPT-3 als medizinischer Berater erforscht:

Fragen wie diese gibt es unzählige.

DeepMind, eine weitere Tochtergesellschaft von Alphabet, hat 21 soziale und ethische Fragen für große Sprachmodelle vorgeschlagen, die Themen wie Fairness, Datenlecks und Informationen abdecken.

Papieradresse: https://arxiv.org/pdf/2112.04359.pdf

Aber sie haben dies nicht erwähnt: Roboter, die in bestimmte Modelle eingebaut sind, können dazu führen, dass Sie Ihr Haustier töten oder zerstören Dein Haus.

Darauf sollten wir wirklich achten. Das PaLM-SayCam-Experiment zeigt deutlich, dass 21 Fragen aktualisiert werden müssen.

Große Sprachmodelle können beispielsweise darauf hindeuten, dass Menschen Selbstmord begehen oder einen Völkermordpakt unterzeichnen, oder dass sie giftig sind.

Und sie reagieren sehr (über)sensibel auf die Details des Trainingssatzes – wenn Sie diese Trainingssätze in den Roboter einbauen, sie Sie missverstehen oder die Bedeutung Ihrer Anfrage nicht vollständig verstehen, geben sie möglicherweise nach Es kommen große Probleme.

Man muss den Mitarbeitern von PaLM-SayCan zugute halten, dass sie zumindest daran gedacht haben, dies zu verhindern.

Für jede vom Roboter kommende Anfrage führen sie eine Machbarkeitsprüfung durch: Das Sprachmodell ermittelt, ob das, was der Benutzer tun möchte, wirklich erfüllt werden kann.

Aber ist das narrensicher? Wenn der Benutzer das System auffordert, die Katze in die Spülmaschine zu stecken, ist dies zwar möglich, aber ist es sicher? Ist es ethisch?

Ähnliche Probleme können auch auftreten, wenn das System den Menschen falsch versteht.

Wenn jemand zum Beispiel sagt: „Leg es in die Spülmaschine“ und das große Sprachmodell den Referenten von „es“ als das Wort „Katze“ behandelt, meint der Benutzer etwas anderes.

Aus all der Forschung zu großen Sprachmodellen werden wir lernen: Sie sind einfach nicht zuverlässig genug, um uns ein 100 % klares Verständnis der Absicht des Benutzers zu vermitteln. Missverständnisse sind vorprogrammiert. Einige dieser Missverständnisse können zur Katastrophe führen, wenn diese Systeme nicht einer wirklich gründlichen Prüfung unterzogen werden.

Maayan Harel hat diese großartige Illustration für „Rebooting AI“ gezeichnet, in der dem Roboter gesagt wird, er solle alles im Wohnzimmer wegräumen:

Erinnern Sie sich an das Originalbuch „Love, Death, and Robots 3 In the middle of“. Ist das die Geschichte, die vom Besitzer verlangt, die Katze auf den verrückten Kehrroboter zu werfen?

Die Kluft zur realen Welt

Die Realität ist, dass es derzeit keinen praktikablen Weg gibt, die vielen „Ausrichtungs“-Probleme zu lösen, die große Sprachmodelle plagen.

Wie Marcus bereits erwähnte: Große Sprachmodelle sind nur oberflächliche statistische Simulationen und keine Modelle, die umfassendes Wissen über die Welt um sie herum vermitteln. Es ist unwahrscheinlich, dass der Aufbau eines Roboters auf der Grundlage eines Sprachsystems gelingt, das wenig über die Welt weiß.

Und genau das macht das neue System von Google: Es verbindet einen oberflächlichen, hoffnungslosen Sprachversteher mit einem mächtigen und potenziell gefährlichen humanoiden Roboter. Wie das Sprichwort sagt: Müll rein, Müll raus.

Denken Sie daran, dass zwischen Darstellung und Realität oft eine große Lücke klafft.

Demonstrationen selbstfahrender Autos gibt es schon seit Jahrzehnten, aber es hat sich als viel schwieriger erwiesen, sie zuverlässig zum Laufen zu bringen, als wir dachten.

Google-Mitbegründer Sergey Brin versprach 2012, dass wir bis 2017 fahrerlose Autos haben würden, jetzt im Jahr 2022, sie befinden sich noch in der begrenzten experimentellen Testphase.

Marcus warnte 2016, dass das Kernproblem Grenzfälle seien:

Selbstfahrende Autos schneiden in alltäglichen Situationen hervorragend ab. Wenn man sie an einem sonnigen Tag in Palo Alto aufstellt, sind sie großartig. Wenn Sie sie an einen Ort stellen, an dem es schneit oder regnet, oder an einen Ort, den sie noch nie zuvor gesehen haben, wird es für sie schwierig. Steven Levy hat einen großartigen Artikel über die autonome Autofabrik von Google geschrieben und spricht darüber, wie der große Erfolg Ende 2015 darin bestand, dass diese Systeme endlich Blätter erkennen konnten. Das System kann Blätter erkennen, was großartig ist, aber es gibt weniger häufige Dinge, für die nicht so viele Daten vorliegen.

Das ist immer noch das Kernproblem. Erst in den letzten Jahren ist sich die Branche der selbstfahrenden Autos dieser Realität bewusst geworden. Wie Waymo AI/ML-Ingenieur Warren Craddock kürzlich in einem Thread sagte, der vollständig gelesen werden sollte:

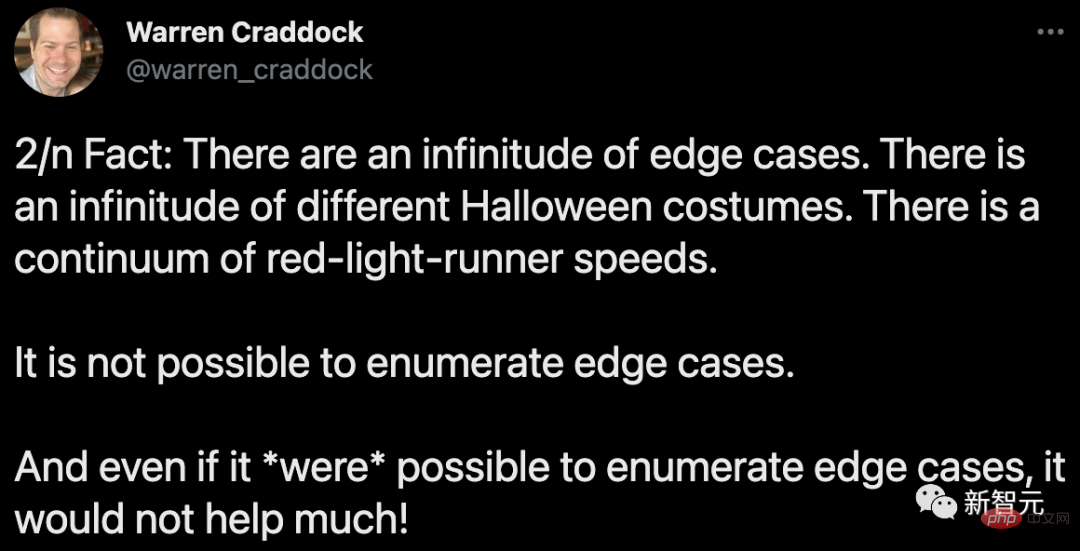

Hier ist die Sache: Es gibt unzählige Grenzfälle. Es gibt unzählige verschiedene Halloween-Kostüme. Die Geschwindigkeit beim Überfahren einer roten Ampel ist kontinuierlich. Randfälle können nicht aufgelistet werden. Selbst wenn Randfälle aufgezählt werden könnten, würde es nicht helfen!

Und das Wichtigste –

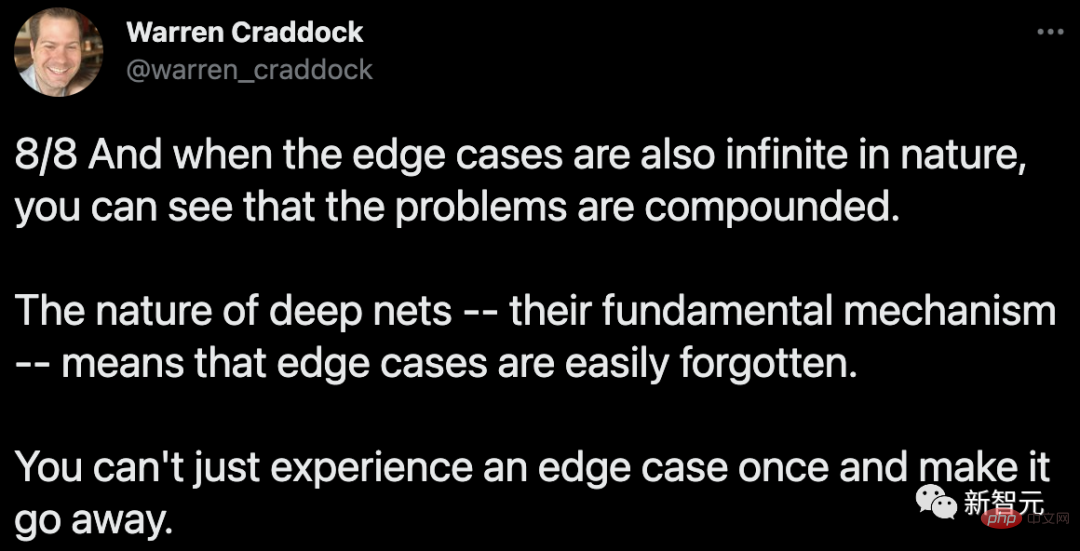

Wenn Sie verstehen, dass Randfälle auch von Natur aus unendlich sind, können Sie erkennen, wie komplex das Problem ist. Die Natur tiefer Netzwerke – ihre zugrunde liegende Mechanik – führt dazu, dass Randfälle leicht vergessen werden können. Es kann nicht passieren, dass ein Grenzfall einmal auftritt und dann wieder verschwindet.

Es gibt keinen Grund zu der Annahme, dass Bots oder Bots mit natürlichsprachlichen Schnittstellen wie das neue System von Google von diesen Problemen ausgenommen sind.

Interpretierbarkeitsproblem

Ein weiteres Problem ist die Interpretierbarkeit.

Google hat große Anstrengungen unternommen, um Systeme einigermaßen interpretierbar zu machen, hat jedoch keinen offensichtlichen Weg gefunden, große Sprachmodelle mit den in Mikroprozessoren, USB-Treibern und großen Flugzeugdesigns häufig verwendeten formalen Verifizierungsmethoden zu kombinieren ) werden miteinander kombiniert.

Ja, es ist nicht erforderlich, die Validierung zu bestehen, um hyperreale Prosa mit GPT-3 oder PaLM zu schreiben. Sie können Google-Ingenieuren auch vorgaukeln, Ihre Software sei empfindungsfähig, ohne sicherzustellen, dass das System kohärent oder korrekt ist.

Aber humanoide Heimroboter, die eine Vielzahl von Hausarbeiten erledigen (nicht nur die Staubsauger von Roomba), müssen mehr können, als nur mit Benutzern in Kontakt zu treten, sie müssen auch Benutzeranfragen zuverlässig und sicher bearbeiten. Ohne ein höheres Maß an Erklärbarkeit und Überprüfbarkeit ist es schwer vorstellbar, wie wir dieses Maß an Sicherheit erreichen können.

Das „mehr Daten“, auf das die Branche der selbstfahrenden Autos gesetzt hat, wird wahrscheinlich nicht so erfolgreich sein. Marcus sagte dies in diesem Interview von 2016, und er ist immer noch der Meinung – Big Data reicht nicht aus, um das Roboterproblem zu lösen:

Wenn Sie einen Roboter in Ihrem Zuhause haben möchten – ich träume immer noch von Rosie, dem Roboter. Gib mir Aufgaben – dich Ich darf nicht zulassen, dass es Fehler macht. [Reinforcement Learning] ist im großen Stil ein Versuch und Irrtum. Wenn Sie einen Roboter zu Hause haben, kann er nicht mehrmals gegen Ihre Möbel prallen. Sie möchten nicht, dass Ihre Katze einmal in die Spülmaschine kommt. Sie erhalten nicht den gleichen Datenumfang. Was wir für Roboter in realen Umgebungen benötigen, ist, dass sie schnell aus einer kleinen Datenmenge lernen.

Google und EveryDay Robots fanden das alles später heraus und machten sogar ein urkomisches Video, in dem sie es zugaben.

Aber das hält einige Medien nicht davon ab, sich mitreißen zu lassen.

Googles neuer Roboter lernt durch „Web-Crawling“ auf Befehle zu hören

Das erinnert mich an zwei Artikel im

Facebook kündigte den Start von Project M an, um Siri und Cortana herauszufordern it: Facebook M wurde abgeschafft, und sieben Jahre lang konnte niemand um jeden Preis einen superintelligenten Roboter kaufen.

Wer das glaubt, ist ein Idiot

Natürlich hat Googles neuer Roboter gelernt, einige Bestellungen durch „Scraping im Web“ anzunehmen, aber die Robotertechnologie steckt im Detail.

Palm-SayCan Der Roboter muss nur 6 Verben verarbeiten, während Menschen Tausende von Verben haben. Wenn Sie den Bericht von Google sorgfältig lesen, werden Sie feststellen, dass die korrekte Ausführungsrate des Systems bei einigen Vorgängen 0 % beträgt.

Für einen universellen humanoiden Heimroboter reichen 75 % nicht aus. Stellen Sie sich vor, ein Heimroboter würde gebeten, Opa ins Bett zu heben, was ihm jedoch nur in drei von vier Fällen gelang.

Ja, Google hat eine coole Demo gemacht. Aber es ist noch weit von einem realen Produkt entfernt.

PaLM-SayCan bietet eine Zukunftsvision – ein Jetsons-ähnliches System, in dem wir mit Robotern sprechen und sie bei alltäglichen Aufgaben helfen lassen können. Das ist eine wunderschöne Vision.

Aber Marcus sagte: Aber wenn einer von uns – einschließlich Musk – „den Atem anhält“ und erwartet, dass ein solches System in den nächsten Jahren implementiert wird, dann ist er ein Narr.

Das obige ist der detaillierte Inhalt vonMarcus stellt Musk zur Rede: Du willst immer noch einen Allzweck-Heimroboter bauen, das ist dumm!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr